Hola Habr!

Este año, cuando escribimos el documento final sobre el trabajo de la compañía para el año, decidimos negarnos a volver a contar las noticias, y aunque no pudimos deshacernos por completo de los recuerdos de lo que sucedió, nos gustaría compartir con ustedes lo que logramos hacer: juntar pensamientos y dirigir nuestros ojos a a donde sin duda nos encontraremos en un futuro muy cercano, en la actualidad.

Sin más preámbulos, hallazgos clave del año pasado:

- La duración promedio de los ataques DDoS se redujo a 2.5 horas;

- El año 2018 mostró la presencia de potencia informática capaz de generar ataques con una intensidad de cientos de gigabits por segundo dentro de un país o región, lo que nos lleva al borde de la "teoría cuántica de la relatividad del ancho de banda" ;

- La intensidad de los ataques DDoS continúa creciendo;

- Junto con el aumento simultáneo en la proporción de ataques usando HTTPS (SSL);

- Las computadoras personales están muertas: la mayor parte del tráfico moderno se genera en dispositivos móviles, lo que representa un desafío para los organizadores de DDoS y el próximo desafío para las compañías de seguridad de red;

- BGP finalmente se convirtió en un vector de ataque, 2 años después de lo que esperábamos;

- La manipulación de DNS sigue siendo el vector de ataque más disruptivo;

- Esperamos nuevos amplificadores en el futuro, como memcached y CoAP;

- No hay más "refugios seguros" en Internet y todas las industrias son igualmente vulnerables a los ataques cibernéticos de cualquier tipo.

Debajo del corte, hemos recopilado las partes más interesantes del informe en un solo lugar, puede encontrar la versión completa

aquí . Que tengas una buena lectura.

Retrospectiva

La criptografía ha dejado de ser interesante para el atacante.

La criptografía ha dejado de ser interesante para el atacante.En 2018, nuestra compañía "notó" dos ataques récord en su propia red. Los ataques de amplificación de memoria caché, que describimos en detalle a fines de febrero de 2018, afectaron el sistema de pago Qiwi de 500 Gb / s, pero fueron neutralizados con éxito por la red de filtrado. A finales de octubre, vimos otro ataque histórico: la amplificación de DNS con fuentes localizadas dentro de un solo país, pero de un poder sin precedentes.

La amplificación de DNS ha sido y sigue siendo uno de los vectores de ataque DDoS de nivel de enlace más famosos y aún plantea dos preguntas agudas. En el caso de un ataque con una intensidad de cientos de gigabits por segundo, existe una probabilidad considerable de sobrecargar la conexión a un proveedor superior. ¿Cómo lidiar con eso? Obviamente, es necesario distribuir dicha carga en tantos canales como sea posible, lo que nos lleva al segundo problema: la demora adicional de la red como resultado de cambios en las rutas de tráfico a sus lugares de procesamiento. Afortunadamente, también logramos el segundo ataque gracias a las opciones flexibles de equilibrio de carga dentro de la red Qrator.

Así es como el equilibrio nos ha mostrado su valor más alto: dado que gestionamos cualquier red BGP de difusión, nuestro radar modela la distribución del tráfico a través de la red después de cambiar el modelo de equilibrio. BGP es un protocolo de vector de distancia y entendemos bien los estados, porque el gráfico de distancia permanece casi estático. Al analizar estas distancias teniendo en cuenta el LCP y la ruta múltiple de igual costo, podemos evaluar previamente AS_path del punto A al punto B con un alto grado de precisión.

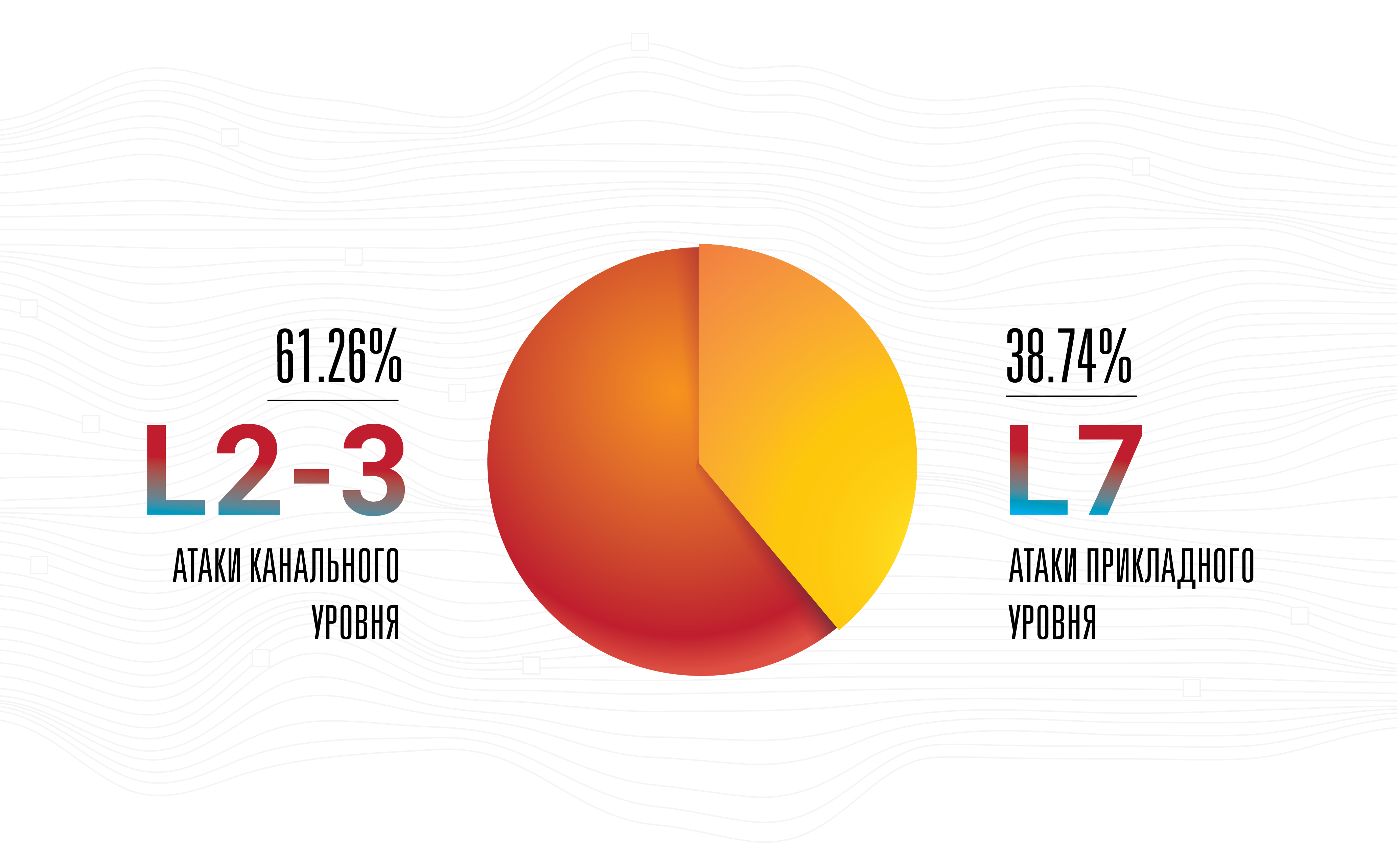

Esto no significa que la amplificación sea la amenaza más grave: no, los ataques a nivel de aplicación siguen siendo los más exitosos, invisibles y efectivos, ya que la mayoría de ellos se realizan a baja intensidad de la banda utilizada.

Esta es la razón principal por la cual nuestra empresa mejora sin compromiso las conexiones con los operadores en los puntos de presencia, al tiempo que aumenta su número. Tal paso es lógico para cualquier operador de red en la actualidad, siempre que el negocio esté creciendo. Pero seguimos creyendo que la mayoría de los atacantes primero recolectan una botnet y solo después de eso comienza a elegir de la lista más amplia de amplificadores disponibles que pueden ser golpeados de todas las armas posibles a la velocidad máxima de recarga. Tales ataques híbridos han tenido lugar durante mucho tiempo, pero solo recientemente su intensidad, tanto en términos de la cantidad de paquetes por segundo como del ancho de banda de red involucrado, comenzó a crecer.

Los ataques con intensidades superiores a 100 Gbit / s ahora son claramente visibles en las estadísticas: esto ya no es ruido

Los ataques con intensidades superiores a 100 Gbit / s ahora son claramente visibles en las estadísticas: esto ya no es ruidoLas botnets se desarrollaron significativamente en 2018, y sus propietarios crearon una nueva actividad:

clickfraud . Con la mejora de las tecnologías de aprendizaje automático y la puesta en manos de navegadores sin cabeza que funcionan sin una GUI, el clickfraud se ha vuelto mucho más fácil y económico, en solo dos años.

Hoy, el sitio web promedio recibe del 50% al 65% del tráfico de los dispositivos móviles, sus navegadores y aplicaciones. Para algunos servicios de red, este recurso compartido puede alcanzar hasta el 90% o incluso el 100%, mientras que los sitios web exclusivamente "de escritorio" prácticamente ya no existen, a menos que estén dentro de entornos corporativos, o en forma de casos altamente especializados.

Las computadoras personales, de hecho, desaparecieron de la cima del panorama de la red en 2019, haciendo algunas técnicas exitosas en el pasado, como el seguimiento de la posición del mouse, completamente inoperantes para filtrar el tráfico y proteger contra los robots. De hecho, no solo las computadoras personales, sino la mayoría de las laptops y cajas todo en uno rara vez son la fuente de una parte importante de las visitas a la página, mientras que se convierten fácilmente en un arma. En un momento, una simple denegación de acceso a cualquier cosa que representara incorrectamente un navegador móvil hasta hace poco era suficiente para neutralizar los ataques de botnets casi por completo, nivelando el efecto negativo de las métricas comerciales clave a cero.

Los creadores y administradores de botnets ya están acostumbrados a implementar prácticas que imitan el comportamiento de los visitantes de páginas reales en su propio código malicioso, al igual que los propietarios de páginas web están acostumbrados al hecho de que los navegadores en las computadoras personales son importantes. Ambos se modifican, mientras que el primero es más rápido que el segundo.

Ya hemos dicho que nada ha cambiado en 2018, pero el progreso y los cambios en sí mismos han experimentado una evolución significativa. Uno de los ejemplos más llamativos es el aprendizaje automático, donde las mejoras y el progreso han sido claramente visibles, especialmente en el campo de las redes competitivas generativas. Lento pero seguro, ML está llegando al mercado de masas. El aprendizaje automático ya se ha vuelto bastante asequible y, como lo ha demostrado la frontera de 2018-2019, ya no es una industria limitada a los académicos.

Aunque esperábamos la aparición de los primeros ataques DDoS basados en ML a principios de 2019, esto no ha sucedido hasta ahora. Sin embargo, esto no cambia nuestras expectativas, sino que solo las alimenta, especialmente dado el costo cada vez menor de administrar redes neuronales y la precisión cada vez mayor de sus análisis.

Por otro lado, si consideramos el estado actual de la industria de los "individuos humanos automatizados", queda claro que la implementación de una red neuronal en este diseño es una idea potencialmente innovadora. Dicha red puede aprender del comportamiento de personas reales en el contexto de la gestión de páginas web. Tal cosa se llamará "experiencia de usuario de inteligencia artificial" y, por supuesto, una red similar armada con un navegador web puede expandir el arsenal de ambos lados: atacar y defender.

La capacitación de una red neuronal es un proceso costoso, pero distribuir y externalizar dicho sistema podría ser barato, eficiente y potencialmente incluso gratuito, en el caso de que el código malicioso esté oculto dentro de aplicaciones pirateadas, extensiones y mucho más. Potencialmente, tal cambio podría cambiar a toda la industria de la misma manera que las redes competitivas generativas transformaron nuestra comprensión de la "realidad visual" y la "autenticidad".

Dada la carrera en curso entre los motores de búsqueda, principalmente Google y todos los que intentan aplicar ingeniería inversa, las cosas pueden llegar tan lejos como cosas fantásticas, como imitar a una persona específica por un bot. Normalmente sentado en una computadora vulnerable. Las versiones del proyecto Captcha y ReCaptcha pueden servir como un ejemplo de cuán rápida y fuertemente el lado atacante desarrolla y mejora sus propias herramientas y técnicas de ataque.

Después de memcached, se habló mucho sobre la probabilidad (o improbabilidad) de una clase de arma completamente nueva para DDoS: una vulnerabilidad, un bot, un servicio configurado incorrectamente u otra cosa que enviaría sin cesar datos para un objetivo específico elegido por el atacante. Un comando del atacante provoca un flujo continuo de tráfico, como cualquiera de las inundaciones, o el envío de syslog. Por el momento, esta es una teoría. Todavía no podemos decir si existen tales servidores, dispositivos, pero si la respuesta a esta pregunta es sí, será una subestimación de la situación decir que tal cosa puede convertirse en armas increíblemente peligrosas en manos malvadas.

En 2018, también vimos un creciente interés en lo que se llama "gobernanza de Internet" y servicios relacionados de estados y organizaciones sin fines de lucro de todo el mundo. Somos neutrales con respecto a tal desarrollo de eventos hasta el momento en que comienza la represión de las libertades civiles e individuales fundamentales, lo que esperamos no ocurra en los países desarrollados.

Finalmente, después de años de recopilar y analizar el tráfico de ataques en todo el mundo, Qrator Labs está listo para implementar el bloqueo en la primera solicitud de red. Los modelos que utilizamos para predecir el comportamiento malicioso nos permiten determinar con precisión la legitimidad del usuario para cada página en particular. Continuamos insistiendo en nuestra propia filosofía de inicio de sesión sin barreras para el usuario y una experiencia de usuario inextricable, sin controles de JavaScript o captcha, que a partir de 2019 comenzará a funcionar aún más rápido, proporcionando el más alto nivel de accesibilidad a los servicios protegidos.

La intensidad máxima de la banda de ataque continúa aumentando constantemente.

La intensidad máxima de la banda de ataque continúa aumentando constantemente.Mellanox

Nuestra compañía seleccionó los interruptores 100G Mellanox como resultado de pruebas internas realizadas durante varios años. Todavía seleccionamos el equipo que mejor cumple nuestros requisitos más bien específicos en ciertas condiciones de la mejor manera. Por ejemplo, un interruptor no debe dejar caer paquetes pequeños a una velocidad de línea: la velocidad máxima, incluso la degradación mínima, es inaceptable. Además, los interruptores Mellanox tienen un buen precio. Sin embargo, esto no es todo: la imparcialidad del precio se confirma por la forma en que un proveedor en particular responde a sus solicitudes.

Los conmutadores Mellanox se ejecutan en Switchdev, que convierte sus puertos en interfaces simples dentro de Linux. Al ser parte del núcleo principal de Linux, Switchdev proporciona una forma conveniente de administrar el dispositivo utilizando interfaces claras y familiares, bajo una API, que es absolutamente familiar para cualquier programador, desarrollador e ingeniero de redes moderno. Cualquier programa que use la API de red Linux estándar se puede ejecutar en un conmutador. Se puede acceder fácilmente a toda la supervisión y gestión de la actividad de la red creada para servidores Linux, incluidas las posibles soluciones patentadas. Para ilustrar los cambios que se han producido con el desarrollo activo de Switchdev, observamos que la modificación de las tablas de enrutamiento se ha vuelto muchas veces más rápida y más conveniente con Switchdev. Hasta el nivel del chip de red, todo el código es visible y transparente, lo que le permite aprender y realizar modificaciones hasta que necesite saber cómo está construido el chip o, al menos, la interfaz externa.

El dispositivo Mellanox que ejecuta Switchdev resultó ser la combinación largamente esperada que hemos estado esperando durante tanto tiempo, pero aún mejor: la empresa fabricante cumplió con todas las expectativas y requisitos, no solo en materia de soporte completo para un sistema operativo gratuito listo para usar.

Al probar el equipo antes de ponerlo en funcionamiento, descubrimos que parte del tráfico redirigido se pierde. Nuestra investigación mostró que esto se debió al hecho de que el tráfico a una de las interfaces se envió utilizando un procesador de control que no podía hacer frente a su alto volumen. Sin embargo, al no poder determinar la causa exacta de este comportamiento, sugerimos que esto se debió al procesamiento de redireccionamientos ICMP. Mellanox confirmó la fuente del problema y, por lo tanto, solicitamos hacer algo con este comportamiento del dispositivo, a lo que la compañía respondió instantáneamente al proporcionar una solución de trabajo en poco tiempo.

¡Buen trabajo, Mellanox!

Protocolos y código abierto

DNS-over-HTTPS es una tecnología más completa que DNS-over-TLS. Observamos cómo prospera el primero, mientras que el segundo se olvida lentamente. Este ejemplo es bueno porque en este caso particular, "complejidad" significa "eficiencia", ya que el tráfico DoH es indistinguible de cualquier otro HTTPS. Ya hemos visto lo mismo con la integración de datos RPKI, que inicialmente se posicionó como una solución anticonceptiva y, como resultado, no le sucedió nada bueno. Después de un tiempo, RPKI reapareció en la escena como una herramienta poderosa contra anomalías como fugas de ruta y configuraciones de enrutamiento incorrectas. Y ahora el ruido se transformó en una señal, y RPKI comenzó a recibir soporte en los puntos de intercambio de tráfico más grandes, lo cual es una gran noticia.

Llegado y TLS 1.3. Qrator Labs, como toda la industria de TI, ha monitoreado de cerca el proceso de desarrollo de un nuevo estándar de cifrado en cada etapa, desde el borrador inicial en el IETF hasta un protocolo comprensible y manejable que estamos listos para admitir a partir de 2019. El mercado reaccionó de manera similar, prometiendo la implementación más rápida de un protocolo de seguridad confiable. Es posible que no todos los fabricantes de soluciones de neutralización DDoS puedan adaptarse a la realidad cambiada con la misma rapidez, porque debido a la complejidad técnica de soportar el protocolo, puede haber retrasos explicables en el hardware.

También estamos siguiendo el desarrollo continuo de HTTP / 2. Por el momento, no admitimos la nueva versión del protocolo HTTP, principalmente debido a la imperfección de la base de código actual. Los errores y vulnerabilidades todavía se encuentran con demasiada frecuencia en el nuevo código; Como proveedor de soluciones de seguridad, todavía no estamos listos para admitir este protocolo bajo el SLA, con el cual nuestros consumidores estuvieron de acuerdo.

En 2018, a menudo nos hicimos la pregunta: "¿Por qué la gente quiere tanto HTTP / 2?", Que fue la causa de numerosos debates feroces. La gente todavía está inclinada a pensar en las cosas con el prefijo "2" como versiones "mejores" de cualquier cosa, lo que es especialmente cierto específicamente en el caso de algunos aspectos de la implementación de este protocolo. Sin embargo, DoH recomienda usar HTTP / 2, y es muy posible que un alto grado de aceptación en el mercado de ambos protocolos nazca de esta sinergia.

Una de las preocupaciones al considerar el desarrollo de protocolos de próxima generación y sus capacidades planificadas es el hecho de que muy a menudo los desarrollos no van más allá del nivel puramente académico, sin mencionar la consideración de los casos extremos de los creadores de protocolos, como la neutralización de los ataques DDoS. Quizás esta sea la razón por la cual las empresas dedicadas a la seguridad informática y de la información están poniendo poco esfuerzo en desarrollar tales estándares.

La Sección 4.4 del borrador del IETF, titulada “Capacidad de administración de QUIC”, que forma parte del futuro paquete de protocolos QUIC, es simplemente un ejemplo ideal de este enfoque: establece que “las prácticas actuales en la detección y neutralización [ataques DDoS] implican principalmente la medición pasiva utilizando datos de la capa de red ". Este último rara vez se usa en la práctica, excepto quizás para las redes de proveedores de Internet y no es un "caso común" en la práctica. Sin embargo, en el trabajo de investigación académica, los "casos generales" se forman de esta manera, como resultado de lo cual los estándares finales del protocolo simplemente no son aplicables en la producción, después de realizar manipulaciones tan simples antes de la puesta en marcha como pruebas bajo carga y simulación de ataques a nivel de aplicación en la aplicación, utilizando. Teniendo en cuenta el proceso continuo de introducción de TLS en la infraestructura global de Internet, la afirmación de cualquier monitoreo pasivo generalmente se cuestiona seriamente. Construir una investigación académica correcta es otra prueba para los proveedores de soluciones de seguridad en 2019.

Al mismo tiempo, Switchdev cumplió plenamente con las expectativas establecidas hace un año. Esperamos que el trabajo continuo en Switchdev conduzca a la comunidad y al fruto común del trabajo a excelentes resultados en el futuro cercano.

Un mayor desarrollo e implementación de Linux XDP ayudará a la industria a lograr una alta eficiencia de procesamiento de paquetes de red. El envío de algunos patrones de filtrado de tráfico ilegítimo desde el procesador central al procesador de red, y en algunos casos incluso al conmutador, ya parece prometedor y nuestra compañía continúa su propia investigación y desarrollo en esta área.

Inmersión profunda con bots

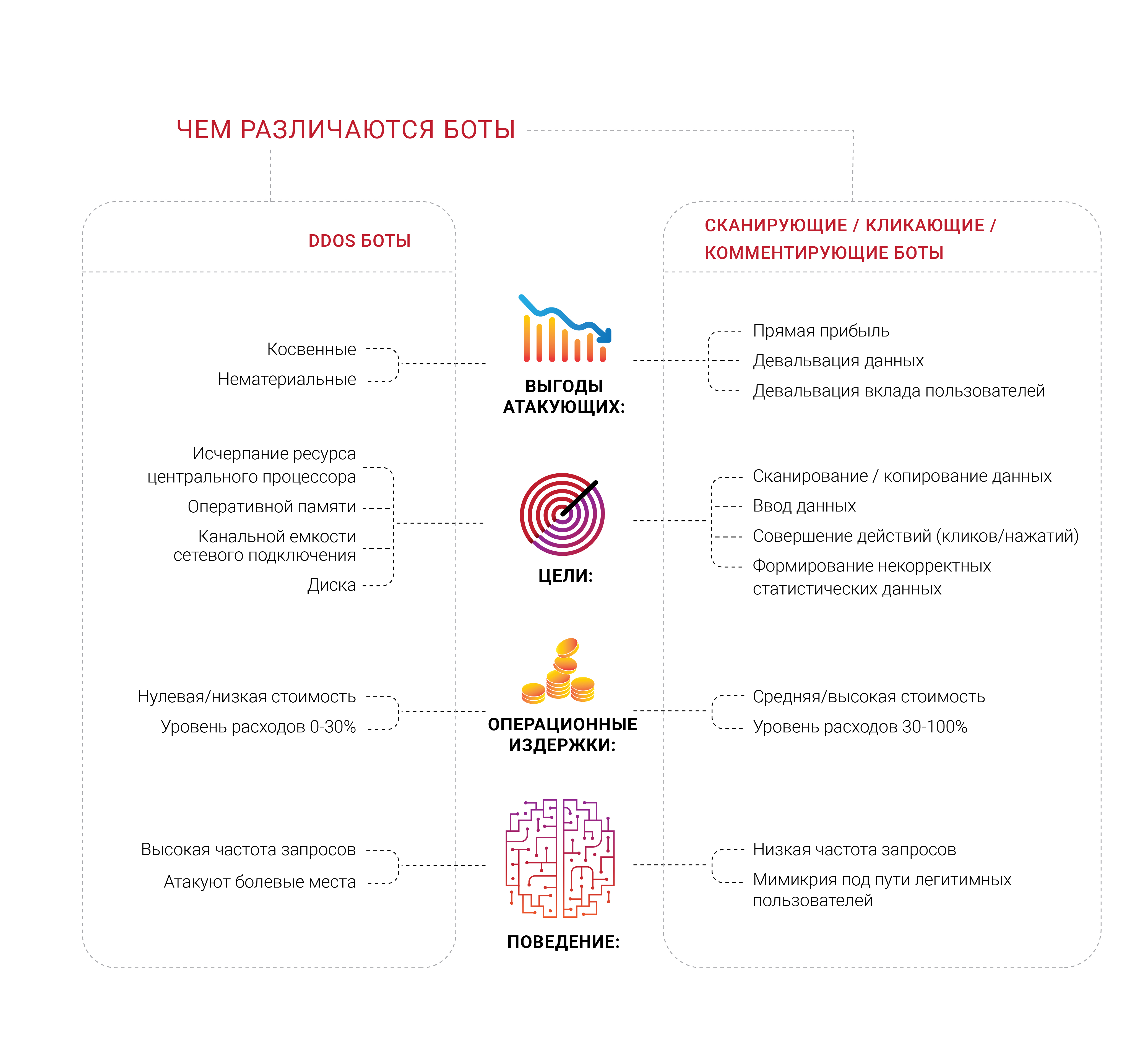

Muchas empresas están ansiosas por obtener protección contra los bots y, como era de esperar, vimos una gran cantidad de diversos grupos de profesionales trabajando en diversas áreas de este problema en 2018. Lo que nos parece particularmente interesante es que la mayoría de las empresas que generan tal demanda nunca han experimentado un ataque DDoS dirigido, al menos típico, destinado a agotar recursos finitos, como memoria, un procesador o un canal de conexión de red. Temen a los bots, pero no pueden distinguirlos de los usuarios legítimos ni determinar qué están haciendo exactamente. La mayoría de las fuentes de tales apelaciones quieren deshacerse de la sensación de que las personas no vivas acuden a sus páginas.

El problema de los escáneres de bot y muchas otras subespecies es un componente económico muy importante. Si el 30% del tráfico es ilegítimo y proviene de fuentes no deseadas, entonces el 30% de los costos de soportar dicho tráfico se tiran a la basura, de acuerdo con la lógica de los gastos. Hoy, uno puede considerar esto como un inevitable "impuesto de Internet" en los negocios. Es casi imposible reducir este número a cero, pero los dueños de negocios quieren ver este porcentaje lo más bajo posible.

La identificación se está convirtiendo en un problema y un desafío extremadamente graves en la Internet moderna, ya que los bots más avanzados ni siquiera intentan retratar a una persona: lo manejan y están en el mismo espacio con él, de manera similar a los parásitos. Hemos estado repitiendo durante mucho tiempo que cualquier información que esté disponible públicamente, sin autenticación y autorización, está allí y, en última instancia, terminará su existencia en forma de dominio público; nadie puede evitar esto.

Teniendo en cuenta este problema, nos centramos en cuestiones de identificación y gestión de bots. Sin embargo, en nuestra opinión, una amplia gama de trabajos es mucho más interesante: vivimos en una era en la que ya es imposible descubrir por qué un cliente en particular solicita algo del servidor. Leyó todo correctamente; al final, cualquier empresa quiere saber que el consumidor ha venido a comprar, porque este es el objetivo de su negocio y existencia. Por lo tanto, algunas compañías quieren profundizar en quién y qué está solicitando a sus servidores: ¿hay una persona real detrás de la solicitud?No es sorprendente, al final, que a menudo los dueños de negocios descubran que una parte significativa del tráfico a su sitio web es generada por robots, y no por ningún comprador.Los seres humanos automatizados, que ya hemos mencionado en un contexto diferente, pueden dirigirse a recursos de red mucho más específicos utilizando cosas casi imperceptibles, como las extensiones del navegador. Ya sabemos que existen tantas extensiones que son difíciles de llamar "maliciosas" con el único fin de recopilar y analizar el comportamiento de un usuario real. Pero hay cosas completamente diferentes: donde la automatización no puede pasar el límite establecido frente a ella, aparecen personas con modificaciones en el navegador y realizan las mismas acciones simples, tal vez solo un poco más caras para los organizadores. Además, una serie de tareas, como la manipulación de anuncios y el fraude de clics, se realizan de manera mucho más eficiente con una persona real frente a la pantalla. Solo imagina lo que podría pasarSi alguien encuentra una buena manera de fortalecerlo con el aprendizaje automático, en la parte correcta de la cadena.Los analizadores y escáneres, que forman parte del problema de bot más amplio, llegaron a nuestro horizonte solo en 2018 y, en primer lugar, gracias a nuestros consumidores que nos informaron sobre su propia experiencia y nos brindaron la oportunidad de estudiar y analizar más profundamente lo que estaba sucediendo en sus recursos de red. Es posible que tales bots ni siquiera sean visibles a nivel de métricas estándar, como el ancho de banda promedio de red utilizado o la utilización de la CPU del servidor. Por el momento, Qrator Labs está probando una variedad de enfoques, pero una cosa está clara: nuestros consumidores quieren que los robots maliciosos en su opinión sean bloqueados en la primera solicitud al servidor.Durante la epidemia de análisis que observamos en Rusia y la CEI durante la segunda mitad de 2018, se hizo evidente que los bots habían avanzado mucho en problemas de cifrado. Una solicitud por minuto es de intensidad bastante normal para el bot, lo cual es muy difícil de notar sin analizar las solicitudes y el tráfico de respuesta saliente. En nuestra humilde opinión, solo el consumidor tiene derecho a decidir qué hacer con cualquier fuente indeseable de solicitudes después de analizar y marcar el tráfico. Bloquear, omitir o engañar, no para que nosotros decidamos. Sin embargo, las soluciones puramente automáticas, o como los llamamos "bots", tienen ciertas dificultades para interactuar. Si está seguro de que fue el bot el que generó la solicitud no deseada y bastante específica, lo primero que la mayoría quiere hacer es bloquearlo sin responder desde el servidor. Sin embargo, llegamos a la conclusión de que dicho enfoque no tiene sentido, ya que brinda demasiados comentarios tanto al bot como a su creador y lo alienta a buscar una solución alternativa. Si los bots no intentan dejar el servicio fuera de servicio, en general, le aconsejamos que no predique este enfoque; como resultado de jugar al gato y al ratón, un atacante razonablemente determinado casi siempre lo esquivará en la búsqueda de un objetivo, sea lo que sea.Esta es la razón por la cual Qrator Labs adoptó el enfoque de etiquetado de malware, así como todo el tráfico en general, para proporcionar al propietario de la aplicación los máximos datos y oportunidades para tomar una decisión informada, considerando las posibles consecuencias para los usuarios y los objetivos comerciales. Un buen ejemplo que ilustra las posibles consecuencias son los bloqueadores de anuncios. La mayor parte de la publicidad moderna en Internet se presenta en forma de scripts, bloqueando los cuales no tiene que bloquear el anuncio en sí, y no, por ejemplo, una comprobación de JavaScript del servicio de protección DDoS. Es fácil imaginar hacia dónde puede conducir este camino, lo que finalmente resulta en una disminución de las ganancias de los negocios en Internet.Cuando los atacantes son bloqueados y se obtiene la retroalimentación que necesitan, nada les impide adaptarse, aprender y atacar nuevamente. Nuestras tecnologías se basan en una filosofía simple de que no es necesario proporcionar retroalimentación a los robots: debe bloquearlos u omitirlos, pero simplemente detectarlos y marcarlos. Después de que se realiza tal marca y estamos seguros de su precisión, es correcto hacer la siguiente pregunta: "¿Qué necesitan?" y "¿Por qué están interesados en esto?" ¿Quizás sea suficiente cambiar ligeramente el contenido de la página web para que ninguna persona viva sienta la diferencia, pero la realidad del bot se pondrá de cabeza? Si se trata de analizadores, es posible que un cierto porcentaje de los datos resulte ser incorrecto y falso, pero en cualquier caso eliminará la protección de la búsqueda de cero o uno binario y le dará algolo que realmente se necesita es tiempo.Al analizar este problema a lo largo de 2018, llamamos ataques similares a los descritos como ataques a las métricas empresariales. El sitio web, la aplicación y el servidor pueden funcionar bien, y ningún usuario se quejará, pero aún siente algo ... como una caída en el CPA de los anuncios que toma para colocar en la plataforma programática, empujando a los anunciantes hacia él, Ni siquiera tus competidores.Reducir la recompensa de un atacante es la única forma de contrarrestarlo. Un intento de detener los bots no traerá nada más que el tiempo y el dinero gastado. Si algo hace clic en lo que le beneficia, cancele estos clics; si se analiza, puede incluir una capa de información "falsa" a través de la cual un usuario ordinario y curioso pasa fácilmente en busca de información correcta y confiable.

Sin embargo, las soluciones puramente automáticas, o como los llamamos "bots", tienen ciertas dificultades para interactuar. Si está seguro de que fue el bot el que generó la solicitud no deseada y bastante específica, lo primero que la mayoría quiere hacer es bloquearlo sin responder desde el servidor. Sin embargo, llegamos a la conclusión de que dicho enfoque no tiene sentido, ya que brinda demasiados comentarios tanto al bot como a su creador y lo alienta a buscar una solución alternativa. Si los bots no intentan dejar el servicio fuera de servicio, en general, le aconsejamos que no predique este enfoque; como resultado de jugar al gato y al ratón, un atacante razonablemente determinado casi siempre lo esquivará en la búsqueda de un objetivo, sea lo que sea.Esta es la razón por la cual Qrator Labs adoptó el enfoque de etiquetado de malware, así como todo el tráfico en general, para proporcionar al propietario de la aplicación los máximos datos y oportunidades para tomar una decisión informada, considerando las posibles consecuencias para los usuarios y los objetivos comerciales. Un buen ejemplo que ilustra las posibles consecuencias son los bloqueadores de anuncios. La mayor parte de la publicidad moderna en Internet se presenta en forma de scripts, bloqueando los cuales no tiene que bloquear el anuncio en sí, y no, por ejemplo, una comprobación de JavaScript del servicio de protección DDoS. Es fácil imaginar hacia dónde puede conducir este camino, lo que finalmente resulta en una disminución de las ganancias de los negocios en Internet.Cuando los atacantes son bloqueados y se obtiene la retroalimentación que necesitan, nada les impide adaptarse, aprender y atacar nuevamente. Nuestras tecnologías se basan en una filosofía simple de que no es necesario proporcionar retroalimentación a los robots: debe bloquearlos u omitirlos, pero simplemente detectarlos y marcarlos. Después de que se realiza tal marca y estamos seguros de su precisión, es correcto hacer la siguiente pregunta: "¿Qué necesitan?" y "¿Por qué están interesados en esto?" ¿Quizás sea suficiente cambiar ligeramente el contenido de la página web para que ninguna persona viva sienta la diferencia, pero la realidad del bot se pondrá de cabeza? Si se trata de analizadores, es posible que un cierto porcentaje de los datos resulte ser incorrecto y falso, pero en cualquier caso eliminará la protección de la búsqueda de cero o uno binario y le dará algolo que realmente se necesita es tiempo.Al analizar este problema a lo largo de 2018, llamamos ataques similares a los descritos como ataques a las métricas empresariales. El sitio web, la aplicación y el servidor pueden funcionar bien, y ningún usuario se quejará, pero aún siente algo ... como una caída en el CPA de los anuncios que toma para colocar en la plataforma programática, empujando a los anunciantes hacia él, Ni siquiera tus competidores.Reducir la recompensa de un atacante es la única forma de contrarrestarlo. Un intento de detener los bots no traerá nada más que el tiempo y el dinero gastado. Si algo hace clic en lo que le beneficia, cancele estos clics; si se analiza, puede incluir una capa de información "falsa" a través de la cual un usuario ordinario y curioso pasa fácilmente en busca de información correcta y confiable.Clickhouse

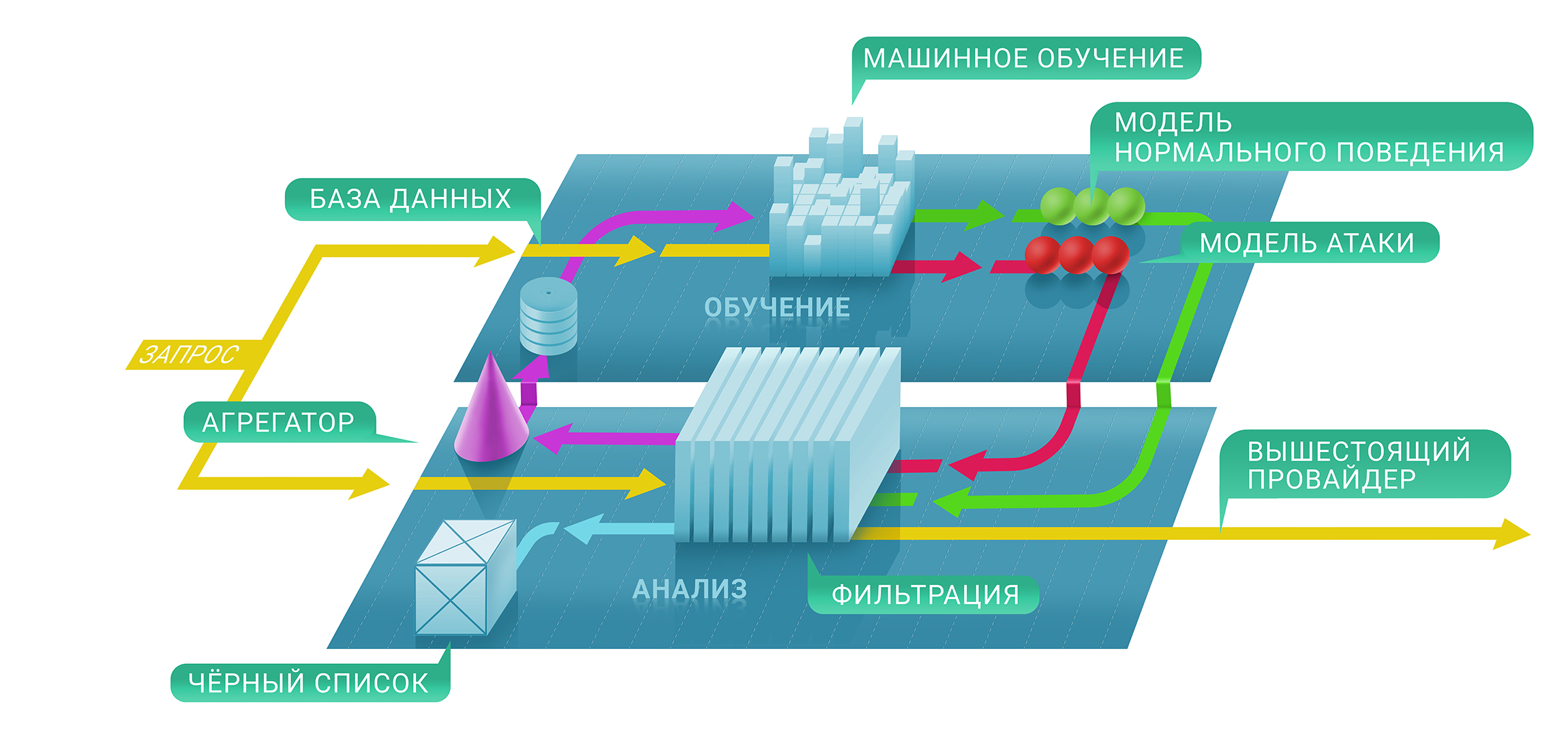

En un nivel superior, el servicio de filtrado de Qrator consta de dos niveles: en el primero, evaluamos de inmediato si una solicitud en particular es maliciosa utilizando cheques con y sin estado, y en el segundo, decidimos si mantener la fuente en la lista negra y por cuánto tiempo . La lista negra resultante se puede representar como una tabla única de direcciones IP.En la primera etapa de este proceso, utilizamos técnicas de aprendizaje automático para comprender mejor los niveles naturales y las características del tráfico para cada recurso individualmente, ya que cada parámetro de protección de cada servicio individual se configura individualmente en función de las métricas que recopilamos.Aquí es donde entra Clickhouse. Para comprender mejor por qué se bloqueó la comunicación de una determinada dirección IP con el recurso, necesitamos rastrear todo el proceso de aprendizaje automático hasta la base de datos de Clickhouse. Funciona muy rápidamente con grandes cantidades de datos (imagine un ataque DDoS de 500 Gbit / s y dura varias horas de tiempo puro fuera de las pausas) y los almacena en una forma conveniente para el marco de aprendizaje automático utilizado en Qrator Labs. Más registros y más tráfico guardado de ataques DDoS conducen a resultados precisos de nuestros modelos, que ayudan a ajustar el servicio de filtrado en tiempo real, bajo los ataques más serios.Usamos Clickhouse DB para almacenar todos los registros de tráfico de ataque ilegítimo y patrones de comportamiento de bot. Elegimos esta solución especializada debido al alto potencial para almacenar conjuntos de datos masivos en el estilo de una base de datos clásica para el procesamiento posterior. El análisis de estos datos también se utiliza para crear patrones de ataques DDoS, lo que ayuda al aprendizaje automático a mejorar constantemente nuestros algoritmos de filtrado de tráfico.Una ventaja significativa de Clickhouse, en comparación con otras bases de datos, es que no necesita leer una variable de datos de cadena completa: puede tomar un segmento mucho más pequeño y estrictamente necesario si almacena todo de acuerdo con las recomendaciones. Y funciona, rápido!

En un nivel superior, el servicio de filtrado de Qrator consta de dos niveles: en el primero, evaluamos de inmediato si una solicitud en particular es maliciosa utilizando cheques con y sin estado, y en el segundo, decidimos si mantener la fuente en la lista negra y por cuánto tiempo . La lista negra resultante se puede representar como una tabla única de direcciones IP.En la primera etapa de este proceso, utilizamos técnicas de aprendizaje automático para comprender mejor los niveles naturales y las características del tráfico para cada recurso individualmente, ya que cada parámetro de protección de cada servicio individual se configura individualmente en función de las métricas que recopilamos.Aquí es donde entra Clickhouse. Para comprender mejor por qué se bloqueó la comunicación de una determinada dirección IP con el recurso, necesitamos rastrear todo el proceso de aprendizaje automático hasta la base de datos de Clickhouse. Funciona muy rápidamente con grandes cantidades de datos (imagine un ataque DDoS de 500 Gbit / s y dura varias horas de tiempo puro fuera de las pausas) y los almacena en una forma conveniente para el marco de aprendizaje automático utilizado en Qrator Labs. Más registros y más tráfico guardado de ataques DDoS conducen a resultados precisos de nuestros modelos, que ayudan a ajustar el servicio de filtrado en tiempo real, bajo los ataques más serios.Usamos Clickhouse DB para almacenar todos los registros de tráfico de ataque ilegítimo y patrones de comportamiento de bot. Elegimos esta solución especializada debido al alto potencial para almacenar conjuntos de datos masivos en el estilo de una base de datos clásica para el procesamiento posterior. El análisis de estos datos también se utiliza para crear patrones de ataques DDoS, lo que ayuda al aprendizaje automático a mejorar constantemente nuestros algoritmos de filtrado de tráfico.Una ventaja significativa de Clickhouse, en comparación con otras bases de datos, es que no necesita leer una variable de datos de cadena completa: puede tomar un segmento mucho más pequeño y estrictamente necesario si almacena todo de acuerdo con las recomendaciones. Y funciona, rápido!Conclusión

Durante mucho tiempo, hemos estado viviendo en un mundo de ataques multifactoriales que explotan las capacidades de ataque de varios protocolos a la vez para sacar al objetivo de un estado saludable.

La higiene digital y las medidas de seguridad relevantes deberían, y de hecho, cubrir aproximadamente el 99% de los riesgos existentes que un usuario común puede enfrentar, excepto, tal vez, por ataques altamente especializados en objetivos específicos.

Por otro lado, en Internet moderno hay tiburones que pueden morder la accesibilidad de estados enteros. Esto no se aplica a BGP, donde es posible pagar solo algunos puntos en cualquier mapa que un atacante quiera dibujar.

El nivel de conocimiento con respecto a la seguridad de la red continúa creciendo. Sin embargo, si observa los números asociados con el número de amplificadores en las redes o busca la posibilidad de solicitudes falsas, el número de servicios y servidores vulnerables no disminuye. La tasa diaria a la que los jóvenes adquieren conocimientos sobre habilidades de programación y gestión de redes informáticas no corresponde al tiempo requerido para adquirir experiencia relevante en la vida real. La confianza de que no surgen nuevas vulnerabilidades con los nuevos productos lleva mucho tiempo, y lo más importante, duele.

Uno de los descubrimientos más sorprendentes del año pasado fue que la mayoría de las personas esperan significativamente más de las nuevas tecnologías de lo que pueden proporcionar. Este no fue siempre el caso, pero en este momento estamos presenciando una tendencia creciente de las personas a "exigir más" independientemente de las capacidades del software y, especialmente, del hardware. Esto nos lleva a un mundo de campañas de marketing bastante perversas. Pero las personas, sin embargo, continúan "comprando promesas" y las empresas, a su vez, se sienten obligadas a cumplirlas.

Quizás esta sea la esencia del progreso y la evolución. Ahora muchos están molestos por el hecho de no obtener una "garantía" y aquello por lo que se pagaron los fondos. Debido a la imposibilidad de comprar "completamente" un dispositivo del fabricante, muchos de los problemas actuales están creciendo, pero el costo de los servicios "gratuitos" puede resultar fabuloso si considera el costo acumulativo de los datos recibidos de un usuario por una gran red social que no requiere pago.

El consumismo nos dice que si realmente queremos algo, en última instancia, pagaremos con nuestras propias vidas. ¿Realmente necesitamos productos y servicios similares que se mejoren solo para ofrecernos "ofertas mejoradas" basadas en los datos que hemos recopilado sobre nosotros, nos guste o no? Sin embargo, este parece ser el futuro cercano, como nos han demostrado recientemente los casos con Equifax y Cambridge Analytica. No es sorprendente si hay una "gran explosión" por delante del uso de datos personales y de otro tipo relacionados con la vida individual de todos.

Después de diez años de trabajo, no hemos cambiado los fundamentos clave sobre la arquitectura de Internet. Esta es la razón por la cual continuamos desarrollando la red de filtrado de difusión ilimitada BGP con la capacidad de procesar el tráfico encriptado de esta forma, evitando captcha y otros obstáculos inesperados para un usuario legítimo.

Al observar lo que sigue sucediendo a los expertos en el campo de la ciberseguridad, así como a las empresas en este campo, una vez más queremos repetir lo obvio: un enfoque ingenuo, simple y rápido no es aplicable.

Por lo tanto, Qrator Labs no tiene cientos o incluso docenas de puntos de presencia comparables a los CDN. Al administrar menos centros de filtrado, cada uno de los cuales está conectado a proveedores de servicios de Internet de una clase no inferior al Nivel 1, logramos una descentralización real. Por la misma razón, no estamos tratando de construir nuestro propio firewall, que es una tarea de un nivel completamente diferente al que estamos trabajando: conectividad.

Con el paso de los años, dijimos que al final, ni la verificación de captcha ni javascript funcionarán, y aquí estamos en 2019, cuando las redes neuronales se volvieron altamente efectivas para resolver la primera, y la segunda nunca planteó un problema para el atacante con el cerebro.

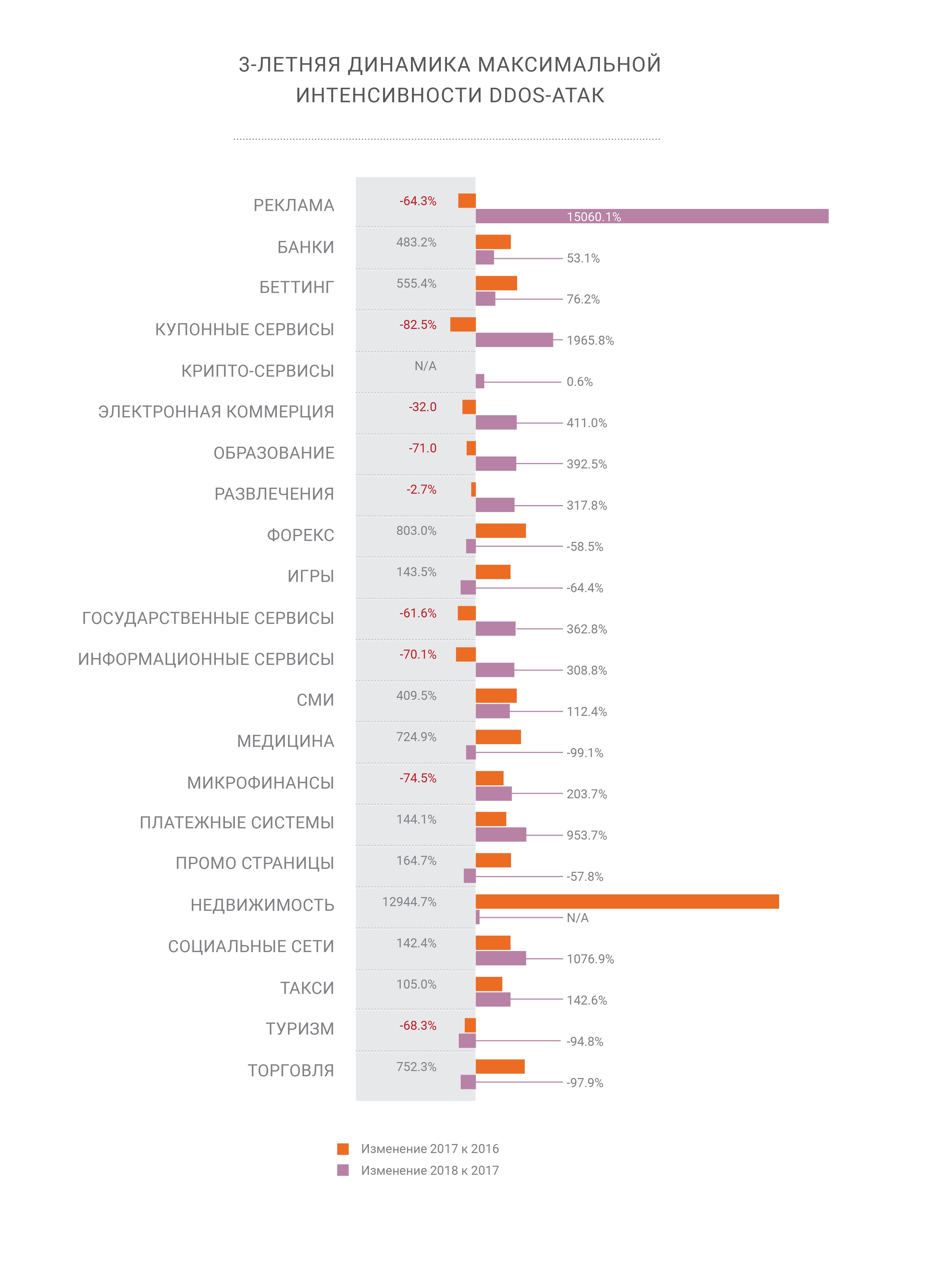

Me gustaría señalar un cambio más interesante en el límite de tiempo: los ataques DDoS han sido durante mucho tiempo un problema grave solo para un número limitado de sectores empresariales, generalmente aquellos en los que el dinero se balancea en la superficie: comercio electrónico, comercio e intercambio, banca y sistemas de pago. Pero con el continuo desarrollo de Internet, estamos viendo ataques DDoS de mayor intensidad y frecuencia en absolutamente todas las partes de Internet. La era DDoS comenzó con un cierto umbral para el ancho de banda de los enrutadores domésticos, y no es sorprendente que con la llegada de un microchip en cada cosa física alrededor del paisaje de ataque comenzó a cambiar rápidamente.

Cualquiera que espere el final de esta tendencia probablemente se equivoque. Así como estamos equivocados, después de haber escrito tantas predicciones. Nadie puede decir con certeza cómo exactamente Internet se desarrollará y difundirá su propia influencia en los próximos años, pero mirando hacia atrás a lo que vimos, una cosa está clara: todo se multiplicará. En 2020, el número de dispositivos conectados a la red debería superar los 30 mil millones, sin mencionar el simple hecho de que los robots han generado mucho más tráfico que los humanos. Muy pronto tendremos que decidir qué hacer con toda esta "inteligencia", artificial o no, ya que todavía existimos en un mundo donde el individuo humano es responsable de sus acciones, correctas o incorrectas.

2018 fue un año de oportunidades para el lado oscuro. Vimos un aumento en los ataques, al mismo tiempo que los complicamos y aumentamos tanto el volumen en términos de red como la frecuencia. Los villanos obtuvieron herramientas poderosas y pasaron mucho tiempo estudiándolas, mientras que los buenos no hicieron nada más que observar su progreso. Esperamos sinceramente que este año al menos algo cambie, al menos en los lugares más dolorosos.

→

Enlace a la versión completa del informe en ruso.