Las redes neuronales son conocidas por su incomprensibilidad: la computadora puede dar una buena respuesta, pero no puede explicar qué la llevó a esta conclusión. Bin Kim está desarrollando un "traductor humano" para que si la inteligencia artificial se descompone, podamos entenderlo.

Bean Kim, investigadora de Google Brain, está desarrollando una forma de cuestionar un sistema de aprendizaje automático sobre sus decisiones.

Bean Kim, investigadora de Google Brain, está desarrollando una forma de cuestionar un sistema de aprendizaje automático sobre sus decisiones.Si el médico le dice que necesita cirugía, querrá averiguar por qué, y esperará que su explicación le parezca significativa, incluso si no ha recibido capacitación como médico. Been Kim, investigador de Google Brain, cree que deberíamos poder esperar lo mismo de la inteligencia artificial (IA). Ella es especialista en aprendizaje automático "interpretado" (MO), y quiere crear una IA que pueda explicar sus acciones a cualquiera.

Desde hace diez años, la tecnología de las redes neuronales detrás de la IA comenzó a extenderse cada vez más, fue capaz de transformar todos los procesos, desde ordenar el correo electrónico hasta encontrar nuevos medicamentos, gracias a su capacidad de aprender de los datos y buscar patrones en ellos. Pero esta habilidad tiene una trampa inexplicable: la propia complejidad que permite a las redes neuronales modernas con capacitación en profundidad aprender con éxito cómo conducir un automóvil y reconocer el fraude con un seguro hace que sea casi imposible para los expertos comprender los principios de su trabajo. Si una red neuronal está capacitada para buscar pacientes con riesgo de cáncer de hígado o esquizofrenia, y un sistema llamado

Deep Patient se lanzó en el Hospital Mount Sinai en Nueva York en 2015, entonces no hay forma de averiguar cuáles los datos presentan la red neuronal "presta atención". Este "conocimiento" se extiende sobre muchas capas de neuronas artificiales, cada una de las cuales tiene conexiones con cientos o miles de otras neuronas.

A medida que más y más industrias intentan automatizar o mejorar sus procesos de toma de decisiones utilizando IA, este problema de "caja negra" parece ser menos una falla tecnológica y más una falla fundamental. Un proyecto de DARPA llamado XAI (abreviatura de "IA explicable", IA explicable) está explorando activamente este problema, y la interpretabilidad se está moviendo desde las primeras líneas de investigación en el campo de MO más cerca de su centro. "La IA está en un momento crítico cuando nosotros, la humanidad, estamos tratando de averiguar si esta tecnología es adecuada para nosotros", dice Kim. "Si no resolvemos el problema de la interpretabilidad, creo que no podremos seguir adelante con esta tecnología, y tal vez simplemente lo rechacemos".

Kim y sus colegas de Google Brain desarrollaron recientemente el sistema Pruebas con vectores de activación de conceptos (TCAV), que ella describe como un traductor humano que permite al usuario hacer una pregunta al recuadro negro de IA sobre cuánto estuvo involucrado cierto concepto de alto nivel en la toma de decisiones. Por ejemplo, si el sistema MO está capacitado para encontrar imágenes de cebra, una persona podría pedirle a TCAV que describa cuánto aporta el concepto de "franjas" al proceso de toma de decisiones.

El TCAV se probó inicialmente en modelos entrenados para reconocer imágenes, pero también funciona con modelos diseñados para el procesamiento de texto o ciertas tareas de visualización de datos, por ejemplo, gráficos EEG. "Es generalizado y simple: se puede conectar a muchos modelos diferentes", dice Kim.

Quanta habló con Kim sobre lo que significa la interpretabilidad, quién la necesita y por qué es importante.

Usted en su carrera se ha centrado en la "interpretabilidad" para el MO. Pero, ¿qué significa exactamente este término?

Usted en su carrera se ha centrado en la "interpretabilidad" para el MO. Pero, ¿qué significa exactamente este término?La interpretabilidad tiene dos ramas. Una es la interpretabilidad para la ciencia: si considera la red neuronal como un objeto de estudio, puede realizar experimentos científicos sobre ella para comprender realmente todos los entresijos del modelo, las razones de su reacción, etc.

La segunda rama, en la que concentro principalmente mis esfuerzos, es la interpretabilidad para crear una IA capaz de responder preguntas. No es necesario que comprenda cada pequeño detalle del modelo. Pero nuestro objetivo es comprender lo suficiente para que esta herramienta pueda usarse de manera segura.

Pero, ¿cómo se puede creer en un sistema, si no se comprende completamente cómo funciona?Te daré una analogía. Supongamos que en mi patio hay un árbol que quiero cortar. Tengo una motosierra para esto. No entiendo exactamente cómo funciona una motosierra. Pero las instrucciones dicen: "Algo que debe manejarse con cuidado para no cortarse". Al recibir instrucciones, es mejor que use una motosierra en lugar de una sierra manual; esta última es más fácil de entender, pero tendría que verla durante cinco horas.

Entiende lo que significa "cortar", incluso si no sabe todo sobre el mecanismo que lo hace posible.Si El propósito de la segunda rama de la interpretabilidad es el siguiente: ¿podemos entender la herramienta lo suficiente como para ser seguro de usar? Y podemos crear esta comprensión confirmando que el conocimiento humano útil se refleja en el instrumento.

¿Pero cómo la "reflexión del conocimiento humano" hace que la caja negra de IA sea más comprensible?Aquí hay otro ejemplo. Si el médico utiliza el modelo MO para hacer un diagnóstico de cáncer, deberá saber que el modelo no selecciona simplemente una correlación aleatoria en los datos que no necesitamos. Una forma de verificar esto es confirmar que el modelo MO hace aproximadamente lo mismo que haría el médico. Es decir, para mostrar que el conocimiento diagnóstico del médico se refleja en el modelo.

Por ejemplo, si un médico busca una instancia celular adecuada para el diagnóstico de cáncer, buscará algo llamado "glándula fusionada". También tendrá en cuenta indicadores como la edad del paciente y si ha recibido quimioterapia en el pasado. Estos factores o conceptos serán tomados en cuenta por un médico que intente diagnosticar el cáncer. Si podemos demostrar que el modelo MO también llama la atención sobre ellos, entonces el modelo será más comprensible, ya que reflejará el conocimiento humano de los médicos.

De esto trata TCAV: ¿qué conceptos de alto nivel utiliza el modelo MO para la toma de decisiones?Si Antes de esto, los métodos de interpretación explicaban solo lo que hace la red neuronal en términos de "características de entrada". ¿Qué significa esto? Si tiene una imagen, cada uno de sus píxeles será una función de entrada.

Yang Lekun (pionero del aprendizaje profundo, director de investigación de IA en Facebook), dijo que considera que estos modelos son súper interpretables, ya que puede observar cada nodo de la red neuronal y ver los valores numéricos para cada una de las características de entrada. Para las computadoras, esto puede ser adecuado, pero la gente piensa de manera diferente. No te estoy diciendo "Mira los píxeles de 100 a 200, sus valores RGB son 0.2 y 0.3". Yo digo: "Esta es una imagen de un perro muy peludo". Las personas se comunican de esta manera, a través de conceptos.

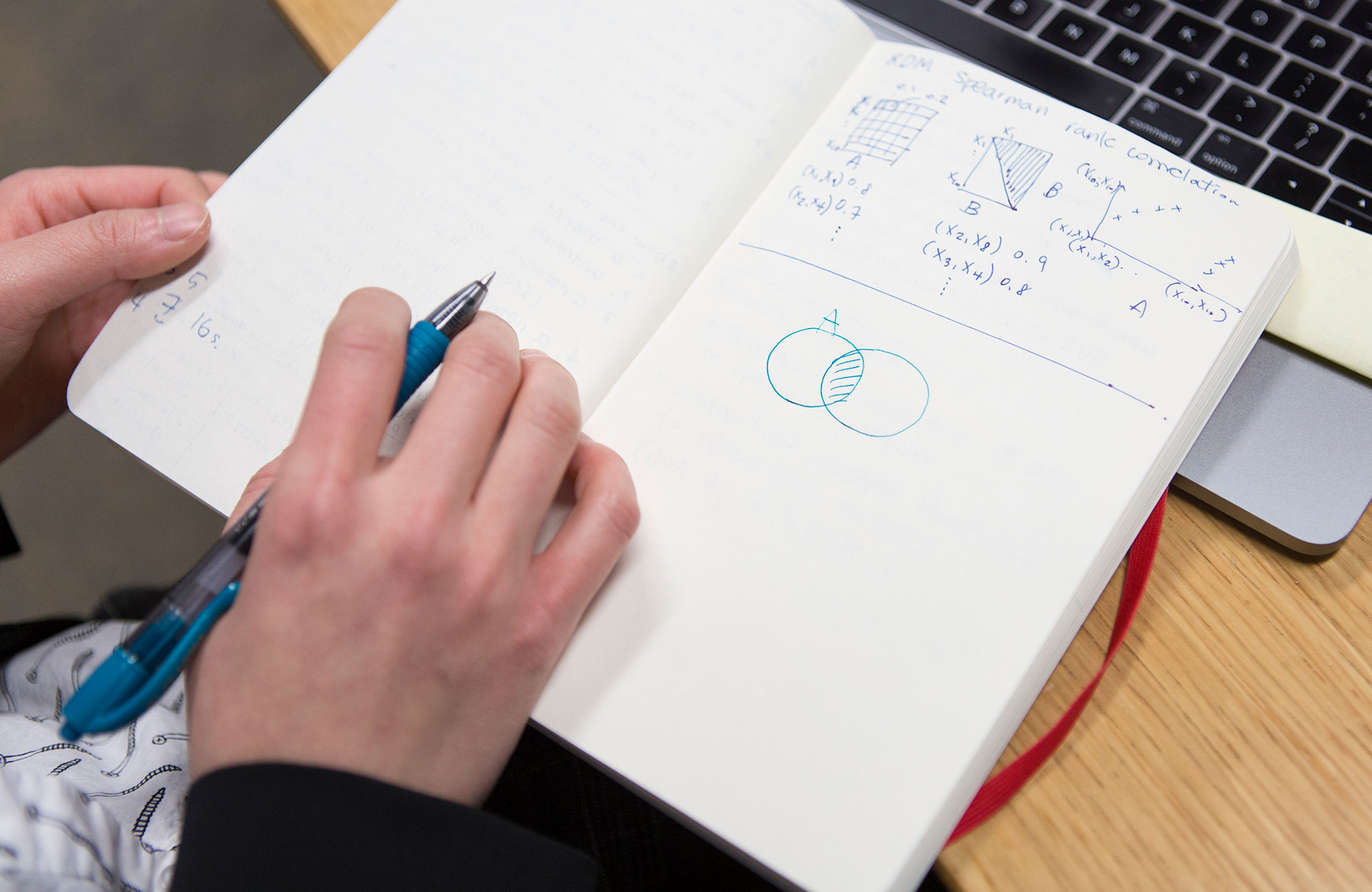

¿Cómo se traduce TCAV entre las características y los conceptos de entrada?Volvamos al ejemplo de un médico que usa el modelo MO, que ya ha sido entrenado para clasificar imágenes de muestras de células según el cáncer. Usted, como médico, necesita descubrir qué tan importante fue el concepto de "glándulas fusionadas" para que el modelo haga predicciones positivas para el cáncer. Primero, recopila, digamos, 20 imágenes que muestran ejemplos de glándulas fusionadas. Luego conecta estos ejemplos etiquetados al modelo.

Entonces, TCAV dentro de sí mismo lleva a cabo el llamado "Control de sensibilidad". Cuando agregamos estas imágenes etiquetadas de las glándulas fusionadas, ¿cuánto aumenta la probabilidad de una predicción positiva de cáncer? La respuesta se puede estimar por un número de 0 a 1. Y estos serán sus puntos en TCAV. Si la probabilidad aumentaba, este concepto era importante para el modelo. Si no, este concepto no es importante.

"Concepto" es un término vago. ¿Hay algún concepto que no funcione con TCAV?Si no puede describir un concepto usando un subconjunto de su conjunto de datos, entonces no funcionará. Si su modelo MO está entrenado en imágenes, entonces el concepto debe expresarse visualmente. Si, por ejemplo, quiero expresar visualmente el concepto de amor, será bastante difícil de hacer.

También verificamos cuidadosamente el concepto. Tenemos un procedimiento de verificación estadística que rechaza el vector de concepto si tiene un efecto equivalente al azar en el modelo. Si su concepto no pasa esta prueba, entonces TCAV le dirá: "No sé, este concepto no parece algo importante para el modelo".

¿El proyecto TCAV está más centrado en generar confianza en IA que en generalizar su comprensión?

¿El proyecto TCAV está más centrado en generar confianza en IA que en generalizar su comprensión?No, y explicaré por qué, ya que esta diferencia es muy sutil.

De muchos estudios en el campo de la ciencia cognitiva y la psicología, sabemos que las personas son muy confiables. Esto significa que es muy fácil engañar a una persona obligándola a creer en algo. El objetivo de la interpretabilidad de MO es lo contrario. Consiste en informar a una persona que no es seguro usar un sistema en particular. El objetivo es descubrir la verdad. Por lo tanto, "confianza" no es la palabra correcta.

Entonces, ¿el objetivo de la interpretabilidad es descubrir posibles fallas en el razonamiento de IA?Si exactamente.

¿Cómo puede ella revelar los defectos?El TCAV se puede usar para hacerle una pregunta al modelo sobre conceptos que no están relacionados con el campo de investigación. Volviendo al ejemplo de los médicos que usan IA para predecir la probabilidad de cáncer. Los médicos pueden pensar de repente: “Aparentemente, la máquina ofrece predicciones positivas de la presencia de cáncer para muchas imágenes en las que el color se desplaza ligeramente al azul. Creemos que este factor no debe tenerse en cuenta ". Y si obtienen una alta puntuación TCAV para azul, significa que encontraron un problema en su modelo MO.

TCAV está diseñado para colgarse en sistemas de IA existentes que no se pueden interpretar. ¿Por qué no hacer inmediatamente sistemas interpretados en lugar de cajas negras?Existe una rama del estudio de la interpretabilidad, que se centra en la creación de modelos inicialmente interpretados que reflejan el razonamiento de una persona. Pero creo que sí: ahora ya estamos llenos de modelos de IA listos para usar que ya se utilizan para resolver problemas importantes, y al crearlos, inicialmente no pensamos en la interpretabilidad. Muy fácil de comer. ¡Muchos de ellos trabajan en Google! Puede decir: "La interpretabilidad es tan útil que nos permite crear otro modelo para que reemplace el que tiene". Pues buena suerte.

¿Y luego qué hacer? Todavía tenemos que pasar por este momento crucial para decidir si esta tecnología nos es útil o no. Por lo tanto, estoy trabajando en métodos de interpretabilidad posteriores al entrenamiento. Si alguien le dio un modelo y usted no puede cambiarlo, ¿cómo aborda la tarea de generar explicaciones de su comportamiento para que pueda usarlo de manera segura? Esto es exactamente lo que hace TCAV.

TCAV permite a las personas preguntar a AI sobre la importancia de ciertos conceptos. Pero, ¿qué sucede si no sabemos qué preguntar? ¿Qué sucede si queremos que la IA simplemente explique?

TCAV permite a las personas preguntar a AI sobre la importancia de ciertos conceptos. Pero, ¿qué sucede si no sabemos qué preguntar? ¿Qué sucede si queremos que la IA simplemente explique?En este momento estamos trabajando en un proyecto que puede encontrar automáticamente conceptos para usted. Lo llamamos DTCAV, el TCAV de apertura. Pero creo que el principal problema de interpretabilidad es que las personas participan en este proceso y que permitimos que las personas y las máquinas se comuniquen.

En muchos casos, cuando se trabaja con aplicaciones de las que depende mucho, los expertos en un campo en particular ya tienen una lista de conceptos que son importantes para ellos. En Google Brain nos enfrentamos constantemente a esto en las aplicaciones médicas de la IA. No necesitan un conjunto de conceptos; quieren proporcionar modelos conceptuales que les resulten interesantes. Estamos trabajando con un médico que trata la retinopatía diabética, la enfermedad ocular, y cuando le contamos sobre el TCAV, estaba muy feliz porque ya tenía muchas hipótesis sobre lo que el modelo puede hacer, y ahora puede verificar todas las preguntas que surgieron. Esta es una gran ventaja, y una forma muy centrada en el usuario para implementar el aprendizaje automático colaborativo.

Crees que sin interpretabilidad, la humanidad simplemente puede abandonar la tecnología de IA. Teniendo en cuenta las oportunidades que tiene, ¿realmente evalúa esa opción como real?Si Esto es exactamente lo que sucedió con los sistemas expertos. En la década de 1980, determinamos que son más baratos que las personas para resolver algunos problemas. ¿Y quién usa sistemas expertos hoy? Nadie Y después de eso llegó el invierno con IA.

Hasta ahora, esto no parece probable, se está invirtiendo tanta publicidad y dinero en IA. Pero a la larga, creo que la humanidad puede decidir, tal vez por miedo, tal vez por falta de evidencia, que esta tecnología no nos conviene. Es posible