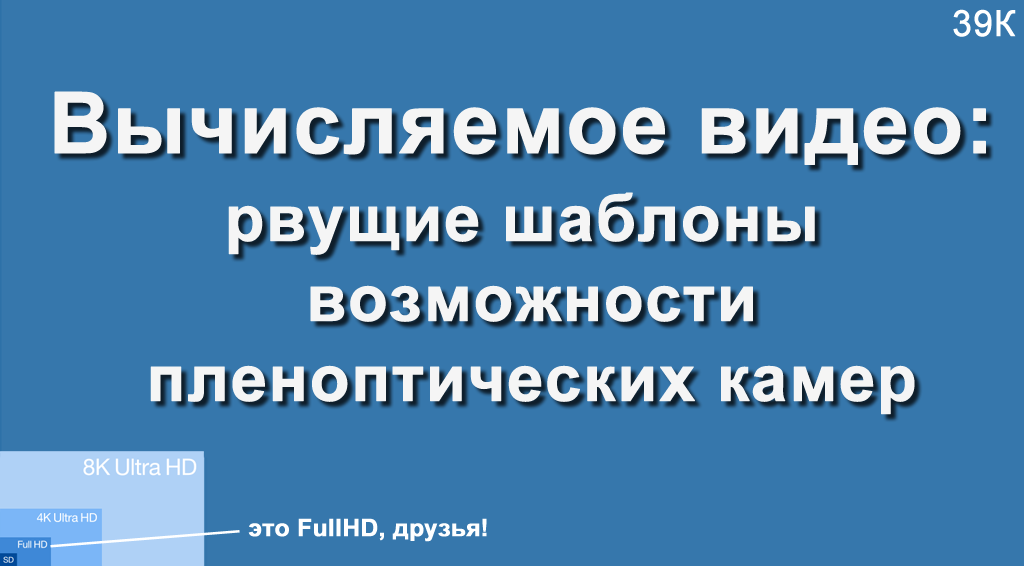

Hace algún tiempo, el autor tuvo la oportunidad de dar una conferencia en VGIK, y había mucha gente de la cámara en la audiencia. Se le preguntó a la audiencia: "¿Con qué resolución máxima disparó?", Y resultó que alrededor de un tercer disparo 4K u 8 megapíxeles, el resto, no más de 2K o 2 megapíxeles. Fue un reto! Tenía que contar sobre la cámara con una resolución de 755 megapíxeles (resolución bruta, para ser precisos, ya que tiene un 4K final) y qué posibilidades encantadoras ofrece esto para el disparo profesional.

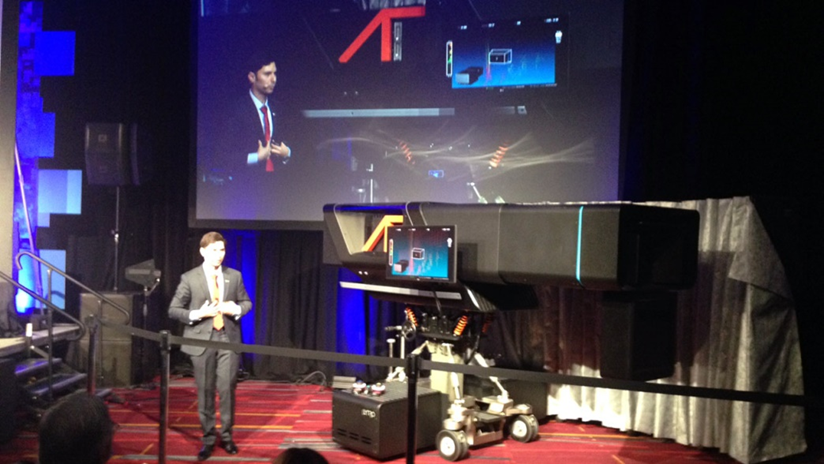

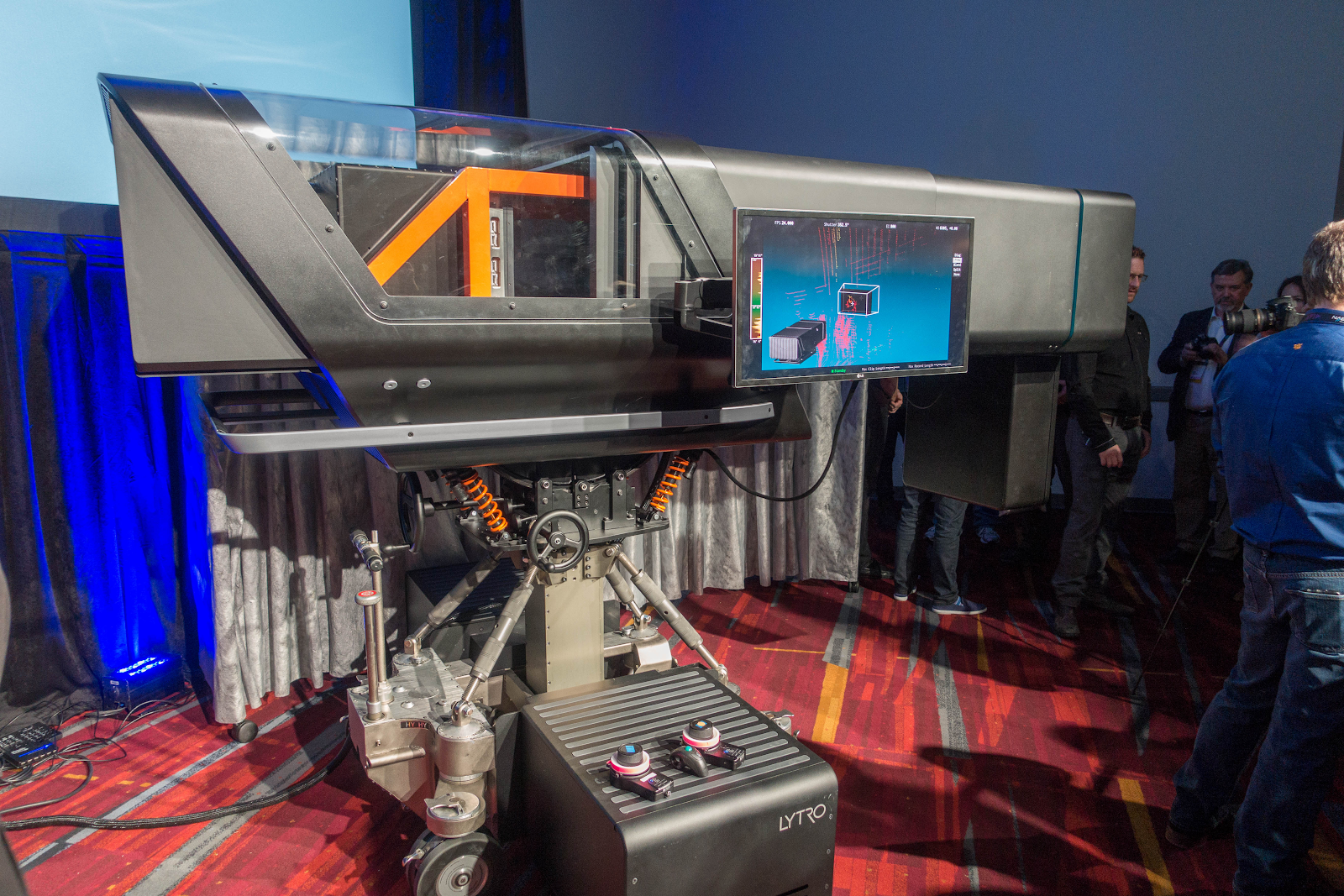

La cámara en sí se ve así (una especie de pequeño elefante):

Además, abriré un terrible secreto, para tomar esta foto buscábamos un mejor ángulo y una persona más grande. Por casualidad sentí esta cámara en vivo, diré que se ve

mucho más grande. La imagen a continuación con Yon Karafin, con quienes tenemos aproximadamente la misma altura, refleja con mayor precisión la escala del desastre:

A quién le importa en principio las capacidades del video calculado sobre el que rara vez escriben: ¡toda la verdad está por debajo! )

Las discusiones sobre las posibilidades de los pleópticos me recuerdan las discusiones sobre el primer avión:

Lo que dijo la gente:

-

Es muy caro ...-

SI!-

Es completamente poco práctico y ahora no da resultado ...-

SI!-

Es peligroso usar ...-

Maldita sea, ¡SÍ!- ¡

Se ve miserable!-

Maldita sea, sí, pero vuela, ya ves, LE-TA-ET!

Después de 50 años, estos experimentos dieron lugar a una forma fundamentalmente nueva, conveniente y bastante segura de moverse a través de los océanos (y no solo).

La situación es la misma aquí. Absolutamente lo mismo! Ahora requiere costos irrazonables, es muy inconveniente de usar y parece miserable, ¡pero realmente VUELA! Y para estar al tanto de los principios y las perspectivas emergentes, ¡es simplemente más que inspirador (al menos su humilde servidor)!

El monstruo de la foto de arriba recuerda a las primeras cámaras, que también eran grandes, con una lente enorme y giraban en un marco especial:

Fuente: rodaje televisivo de los Juegos Olímpicos en 1936 en los albores de la televisión.

Fuente: rodaje televisivo de los Juegos Olímpicos en 1936 en los albores de la televisión.Aquí se ve mucho, también una lente enorme (porque tampoco hay suficiente luz), una cámara pesada con una suspensión especial, tamaños enormes:

Fuente: Lytro a punto de cambiar para siempre el cine

Fuente: Lytro a punto de cambiar para siempre el cineDe lo interesante: la "maleta" a continuación es un sistema de refrigeración líquida, en caso de falla de la cual la cámara no puede tomar más fotos.

El gran rectángulo debajo de la lente (claramente visible en la primera foto de arriba) no es la luz de fondo, sino el lidar, un buscador láser que proporciona una escena tridimensional frente a la cámara.

Un torniquete negro grueso en la parte inferior izquierda en el fondo es un paquete de cables de fibra óptica de aproximadamente 4 centímetros de diámetro, a través del cual la cámara envía un flujo monstruoso de información a un almacenamiento especial.

Aquellos en el tema ya han reconocido

Lytro Cinema , de los cuales se crearon 3 piezas. El primero, que generalmente aparece en todas las imágenes, es fácil de reconocer con un

lidar debajo de la lente. Después de 1,5 años, se creó una segunda cámara con problemas estructurales corregidos del primero y los dos lidares (y, por desgracia, casi nadie escribe al respecto). Además, el progreso en el desarrollo, por ejemplo, de los lidares en 1.5 años fue tan grande que dos lidares de la segunda cámara dieron 10 veces más puntos que un lidar de la primera. Se suponía que la tercera cámara tenía aproximadamente las mismas características de resolución (para satisfacer los requisitos de los cineastas), pero tenía la mitad del tamaño (lo cual es crítico para el uso práctico). Pero ... pero más sobre eso más tarde.

En cualquier caso, reconociendo en todos los sentidos el papel sobresaliente que jugó Lytro en la popularización de la tecnología de

disparo pleóptico , me gustaría señalar que la luz no convergió en él. En el

Instituto Fraunhofer se fabricó una cámara similar,

Raytrix , un productor de cámaras pleópticas, existe de manera segura, y nuevamente no se me permitió fotografiar Lytro Cinema, porque tenía mucho miedo de varias compañías chinas que trabajaban activamente en esta dirección (no pude encontrar información fresca sobre ellas).

Por lo tanto, anotemos los puntos de todas las ventajas que los pleópticos brindan, y sobre los cuales casi no escriben. Pero precisamente por eso está garantizado para tener éxito.

En lugar de presentar

Solo en Habré y solo Lytro se menciona

en aproximadamente 300 páginas , por lo tanto, seremos cortos.

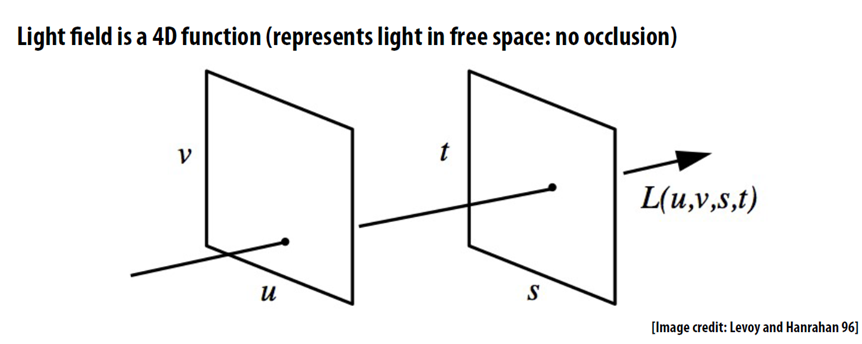

El concepto clave para el disparo plenoóptico es el campo de luz, es decir, no fijamos el color del píxel en cada punto, sino una matriz bidimensional de píxeles, que convierte un cuadro bidimensional miserable en un cuadro normal de cuatro dimensiones (generalmente con muy poca resolución en t y s hasta ahora):

En la

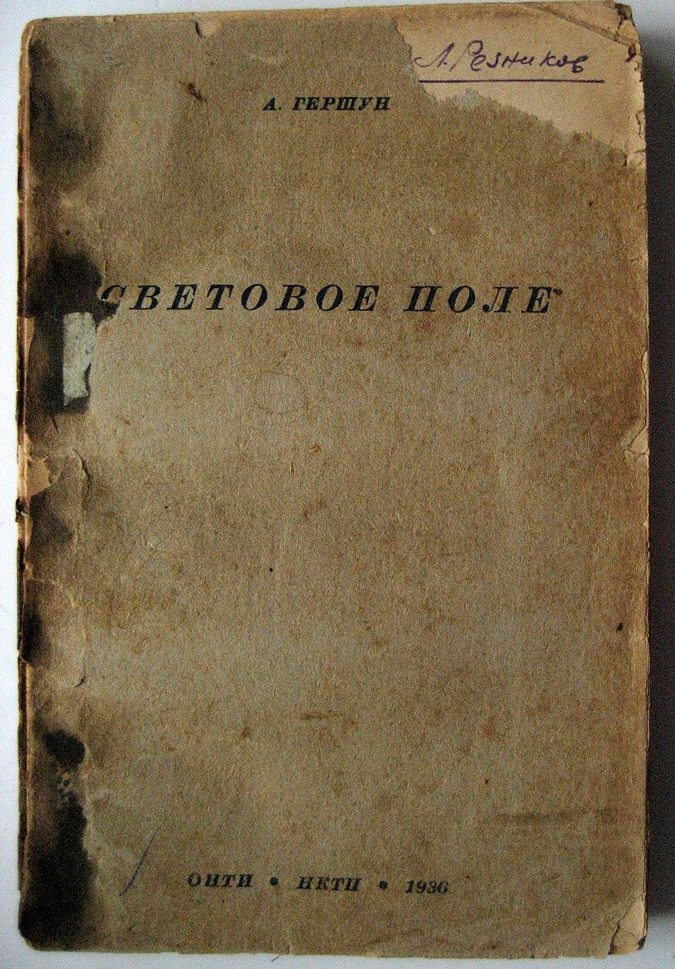

Wikipedia en inglés , y

luego en el ruso en artículos sobre el campo de luz, se dice que "la frase" campo de luz "fue utilizada

por A. Gershun en ... 1936". Para ser justos, notamos que esto no fue por

casualidad una "frase usada", sino el nombre de un

pequeño libro de 178 páginas , que se llamó "Campo de luz":

E incluso en ese momento, estas obras se aplicaron bastante en la naturaleza y el autor 6 años después, en el apogeo de la guerra en 1942, recibió el Premio Stalin de segundo grado por el método de apagón.

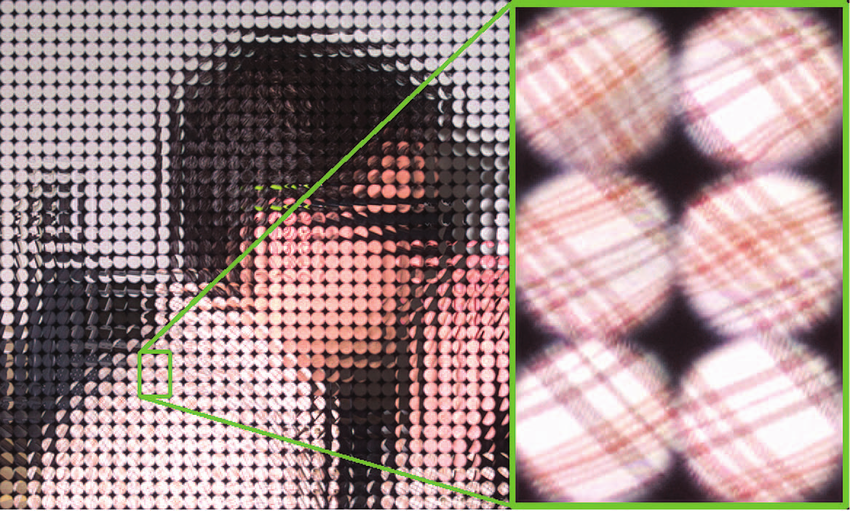

En la práctica, disparar un cuadro de cuatro dimensiones del campo de luz proporciona una gran variedad de microlentes ubicadas frente al sensor de la cámara:

Fuente: plenoptic.inf® (puede hacer clic y ver en resolución completa)

Fuente: plenoptic.inf® (puede hacer clic y ver en resolución completa)En realidad, es precisamente porque tenemos un conjunto de microlentes con una pequeña distancia entre ellos lo que permitió crear Lytro Cinema, cuyo sensor se ensambló a partir de un conjunto de sensores cuyos límites caen en el borde de las lentes. Se requirió enfriamiento líquido para enfriar un macizo muy caliente.

Fuente: Uso de cámaras plenopticas enfocadas para capturar imágenes ricas

Fuente: Uso de cámaras plenopticas enfocadas para capturar imágenes ricasComo resultado, tenemos la posibilidad más famosa de cámaras pleópticas, de las cuales solo los perezosos no escribieron, para cambiar la distancia de enfoque después de la toma (estas lindas aves no esperarían para enfocar):

Fuente: Lytro

Fuente: LytroY poco se ha escrito sobre cómo se ven los pleópticos en una resolución adecuada para una película (se abre por clic):

Fuente: Mira Lytro Change Cinematography Forever

Fuente: Mira Lytro Change Cinematography ForeverAbro otro secreto: el foco calculado es la punta del iceberg de los pleópticos. Y el 90% de las oportunidades que quedan por debajo del nivel de interés de los periodistas en mi opinión son aún más interesantes. Muchos de ellos son dignos de artículos separados, pero al menos corrijamos la injusticia y al menos los llamemos. Vamos!

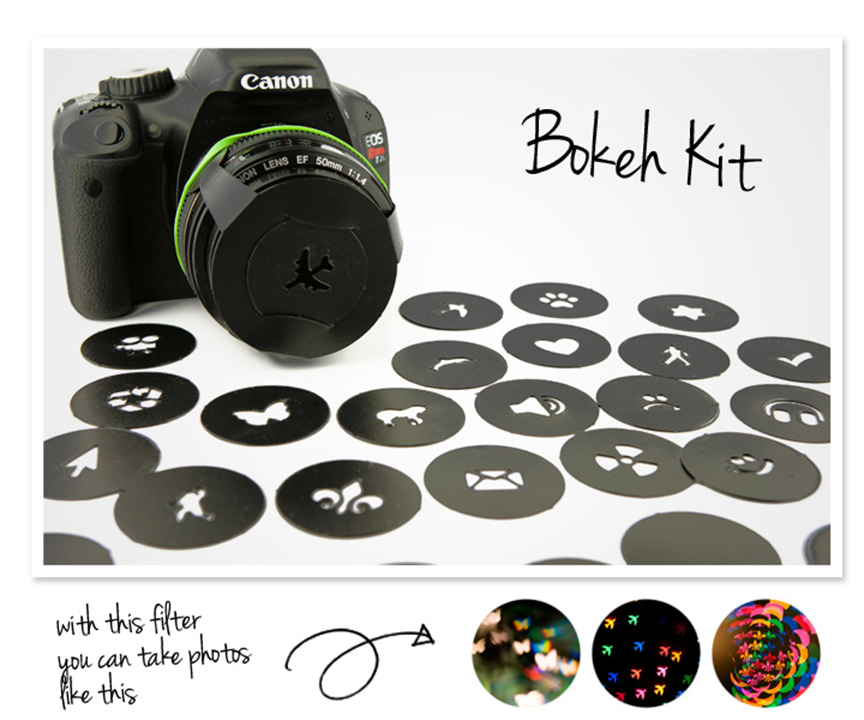

Forma de apertura calculada

Como estamos hablando de desenfoque, vale la pena mencionar el llamado

efecto bokeh , en el que el resplandor no es necesariamente redondo.

Para los fotógrafos,

se lanza el llamado

Kit Bokeh , que le permite obtener reflejos de varias formas:

Esto le permite obtener imágenes bonitas, y la foto a continuación muestra claramente que los destellos en forma de corazones incluso tienen piedras en primer plano, solo los corazones son más pequeños. Y está claro que tratar de desenfocar naturalmente de manera similar en Photoshop es extremadamente difícil, al menos es recomendable usar un mapa de profundidad:

Al mismo tiempo, para los pleópticos "calcular" una apertura diferente es una tarea relativamente fácil:

Entonces! Calculamos la distancia de enfoque, calculamos la forma de la apertura, fuimos más allá, ¡es más interesante allí!

Estéreo Computado

Una característica muy útil del sensor pleóptico, sobre la que casi nadie menciona, pero que ya le da una segunda vida, es la capacidad de calcular una imagen desde diferentes puntos. La ubicación del punto está realmente determinada por el tamaño de la lente. Si la lente es pequeña, el marco puede moverse ligeramente hacia la izquierda y hacia la derecha, como en este ejemplo (que esta foto estéreo es visible si mira el cofre del pájaro más cercano):

Fuente: Lytro

Fuente: LytroSi la lente es grande, como, por ejemplo, Lytro Cinema, el punto de disparo se puede desplazar 10 centímetros. Permíteme recordarte que entre nuestros ojos tenemos unos 6.5 centímetros, es decir, con una distancia máxima de 10 cm, puedes disparar tanto el plano general (y será "tridimensional" como si lo miras con los ojos) y de cerca (con cualquier paralaje sin molestias). De hecho, esto significa que podemos grabar video estéreo completo con una lente. Además, no solo será estéreo, sino estéreo con una calidad perfecta y eso suena fantástico hoy en día, con una distancia variable entre los ejes ópticos de las cámaras virtuales DESPUÉS del disparo. Tanto eso como otro: oportunidades absolutamente impensables que pueden cambiar radicalmente una situación con la grabación estéreo en el futuro.

Dado que el futuro está de alguna manera en los disparos tridimensionales, detengámonos en estos dos puntos con más detalle. No es ningún secreto que hoy en día la mayoría de las películas en 3D, especialmente los éxitos de taquilla, no se eliminan, sino que se convierten a 3D. Esto se hace porque al disparar, surge una larga lista de problemas (a continuación se incluye parte de la lista):

- Los fotogramas se pueden rotar, desplazar verticalmente o agrandar uno en relación con el otro (no digas que esto se arregla fácilmente, mira con qué frecuencia esos fotogramas entran en los estrenos de películas; esto es un horror silencioso ... y un dolor de cabeza). Entonces, el estéreo plenoóptico está PERFECTAMENTE alineado, incluso si el operador decidió hacer un acercamiento (debido a la mecánica de las dos cámaras, es extremadamente difícil hacer que la aproximación sea estrictamente sincrónica).

- Los marcos pueden variar en color , especialmente si el disparo requiere una pequeña distancia entre los ejes ópticos de las cámaras y tiene que usar un divisor de haz (había una publicación detallada sobre esto). Resulta que, en una situación en la que al disparar cualquier objeto de bengala (el automóvil en el fondo en un día soleado), estamos condenados al entretenimiento en la postproducción con la gran mayoría de las cámaras, con el pleóptico tendremos una imagen PERFECTA con cualquier resplandor. Esta es una fiesta!

- Los marcos pueden variar en nitidez ; de nuevo, un problema notable en los divisores de haz, que está completamente ausente en los pleópticos. Con qué nitidez se necesita, con esto calcularemos, absolutamente PERFECTO desde los ángulos.

- Los marcos pueden flotar en el tiempo . Los colegas que trabajaron con el material de Stalingrado hablaron sobre la discrepancia entre las marcas de tiempo de las pistas en 4 cuadros, razón por la cual el cracker sigue siendo relevante. Encontramos más de 500 escenas con diferencias de tiempo en 105 películas. La diferencia horaria, desafortunadamente, es difícil de detectar, especialmente en escenas con cámara lenta, y al mismo tiempo es el artefacto más doloroso según nuestras mediciones. En el caso de los pleópticos, tendremos una sincronización de tiempo PERFECTA.

- Otro dolor de cabeza al disparar en 3D son los paralaje demasiado grandes que causan molestias al ver en una pantalla grande, cuando los ojos pueden divergir hacia los lados para buscar objetos "más allá del infinito" o converger demasiado para algunos objetos en primer plano. El cálculo correcto de paralaje es un tema difícil por separado que los operadores deben tener un buen dominio, y un objeto que accidentalmente entra en el marco puede arruinar la toma, haciéndolo incómodo. Con los pleópticos, nosotros mismos elegimos el paralaje DESPUÉS del disparo, por lo que cualquier escena se puede calcular con paralaje PERFECTO, además, la misma escena ya filmada se puede calcular fácilmente para pantallas grandes y pantallas pequeñas. Este es el llamado cambio de paralaje, que generalmente es extremadamente difícil y costoso sin pérdida de calidad, especialmente si tenía objetos translúcidos o bordes en primer plano.

En general, la capacidad de CALCULAR el estéreo perfecto es la base real de la próxima ola de popularidad en 3D, ya que en los últimos 100 años se han distinguido 5 ondas de este tipo. Y, a juzgar por el progreso en la proyección láser y el pleóptico, un máximo de 10 años (cuando caducan las patentes principales de Lytro o un poco antes en China) nos esperan un nuevo hierro y un nuevo nivel de películas 3D de calidad.

Entonces! Obtuvieron el estéreo calculado perfecto de una lente (algo imposible para la mayoría, por cierto). Y no solo lo entendieron, sino que también contaron la paralaje después del hecho, incluso si el objeto está desenfocado en primer plano. ¡Vamos más profundo!

Punto de disparo calculado

Cambiar el punto de disparo tiene una aplicación en video 2D ordinario.

Si estaba en el set o al menos vio fotografías, probablemente prestó atención a los rieles en los que viaja la cámara. A menudo, para una escena, debe colocarlos en varias direcciones, lo que lleva un tiempo notable. Los rieles aseguran el buen funcionamiento de la cámara. Sí, por supuesto, hay una

cámara estable , pero en muchos casos los rieles, por desgracia, no tienen alternativa.

La capacidad de cambiar el punto de disparo en Lytro se utilizó para demostrar que hay suficientes ruedas. De hecho, cuando la cámara se mueve, formamos un "tubo" virtual con un diámetro de 10 cm en el espacio, dentro del cual podemos cambiar el punto de disparo. Y esta tubería le permite compensar pequeñas fluctuaciones. Esto se muestra bien en este video:

Además, a veces necesita resolver el problema inverso, es decir, agregar oscilaciones durante el movimiento. Por ejemplo, no hubo suficiente dinámica y el director decidió hacer una explosión. No es largo aplicar un sonido, pero es aconsejable sacudir la cámara sincrónicamente, y es mejor no solo mover la imagen plana, será visible, sino sacudirla "honestamente". Con los pleópticos, el punto de disparo se puede sacudir completamente "honestamente", con un cambio en el punto de disparo, ángulo, desenfoque de movimiento, etc. Habrá una completa ilusión de que la cámara se sacudió violentamente, que suavemente y con seguridad montó sobre ruedas. De acuerdo, ¡una oportunidad increíble! La próxima generación de steadicam mostrará milagros.

Por supuesto, para que esto se convierta en realidad, debe esperar hasta que el tamaño de la cámara pleóptica se reduzca a uno razonable. Pero considerando cuánto dinero se está invirtiendo en miniaturización y aumentando la resolución de los sensores para teléfonos inteligentes y tabletas, parece que la espera no es tan larga. ¡Y será posible crear una nueva cámara pleóptica! Cada año se hace más y más fácil.

Entonces! Se calculó el punto de disparo y, si es necesario, se movió, estabilizando o desestabilizando la cámara. ¡Vamos más allá!

Iluminación computarizada

Como estamos hablando de una explosión cerca ...

A veces se hace necesario cambiar la iluminación del sujeto, por ejemplo, agregar un flash de manera realista. Los estudios de posproducción saben bien qué problema tan difícil es este, incluso si la ropa de nuestro personaje es relativamente simple.

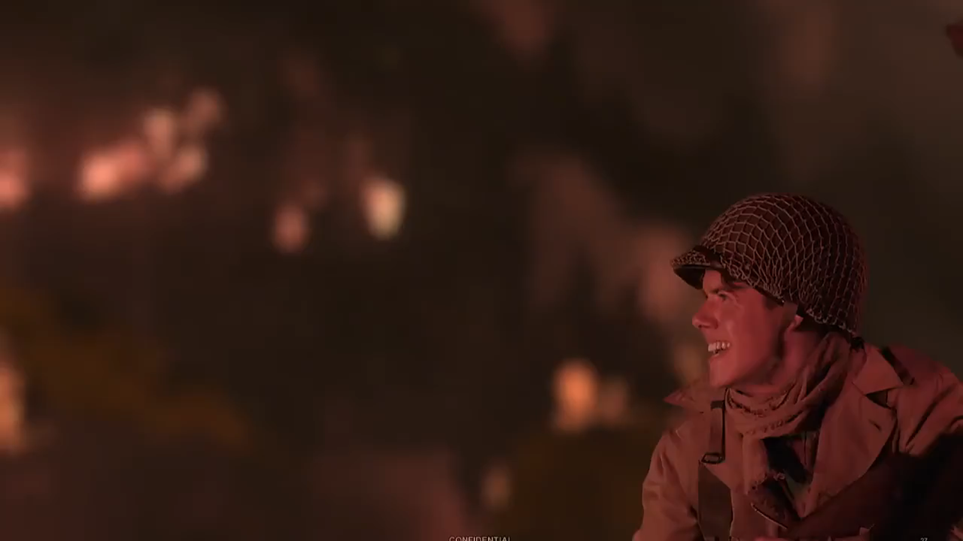

Aquí hay un ejemplo de un video con una superposición de flash, teniendo en cuenta la ropa, sus sombras, etc. (se abre por clic):

Fuente: Entrevista con Yon Karafin

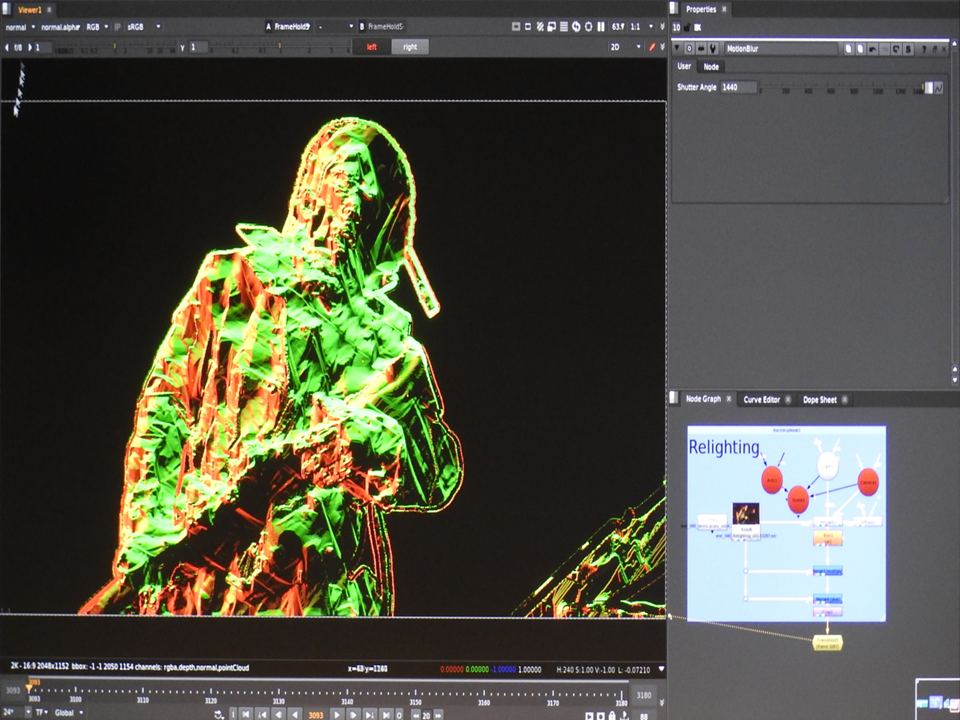

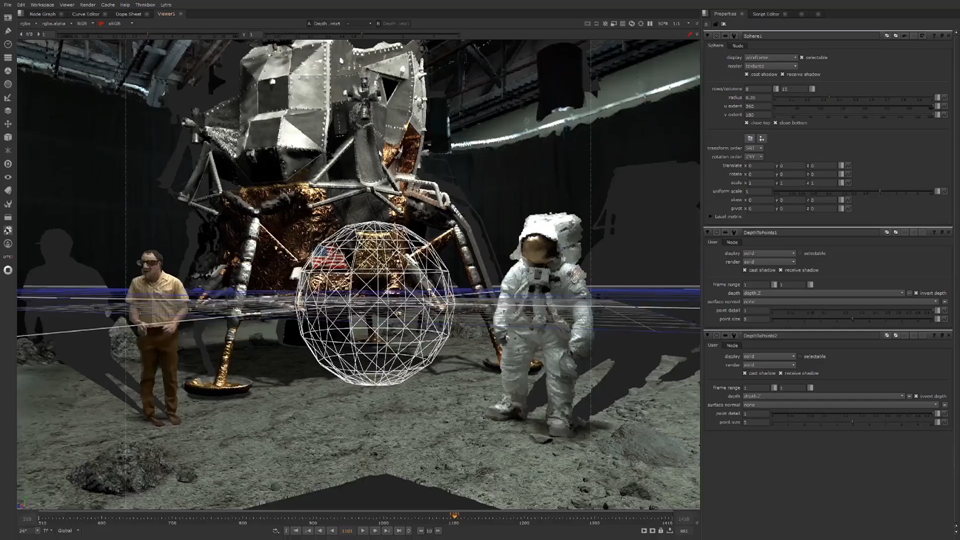

Fuente: Entrevista con Yon KarafinDebajo del capó, parece un complemento para Nuke, que funciona con un modelo tridimensional completo del actor y le da una nueva luz, teniendo en cuenta el mapa normal, los materiales, el desenfoque de movimiento, etc.

Fuente: Lytro Materials

Fuente: Lytro MaterialsEntonces! Se calculó la nueva iluminación del objeto ya capturado. ¡Vamos más allá!

Resolución calculada

Aquellos que experimentaron con el primer Lytro a menudo notaron: sí, el juguete es genial, pero la resolución es completamente insuficiente para la fotografía normal.

En

nuestro último artículo sobre Habr, se describió cómo pequeños cambios en el punto de disparo pueden ayudar a aumentar significativamente la resolución. Pregunta: ¿Son estos algoritmos aplicables a los pleópticos? Respuesta: sí! Además, los algoritmos de Super Resolución son más fáciles de trabajar en imágenes pleópticas, ya que hay un mapa de profundidad, todos los píxeles se toman al mismo tiempo y los cambios se conocen con bastante precisión. Es decir, la situación de los pleópticos es simplemente mágica en comparación con las condiciones bajo las cuales los algoritmos de Super Resolución funcionan en 2D ordinario. El resultado es correspondiente:

Fuente: Restauración de cuadros pleópticos ingenuos, inteligentes y de súper resolución del Informe técnico de Adobe "Superresolución con cámara plenoptic 2.0"

Fuente: Restauración de cuadros pleópticos ingenuos, inteligentes y de súper resolución del Informe técnico de Adobe "Superresolución con cámara plenoptic 2.0"El único problema importante (¡realmente grande!) Es la cantidad de datos y la cantidad de cálculo que se requiere. Sin embargo, hoy en día es completamente realista cargar una granja de cómputo por la noche y obtener el doble de resolución mañana donde sea necesario.

Entonces, descubrí la resolución calculada. ¡Vamos más allá!

Ambiente Computado

Una tarea separada que surge en la etapa de postproducción, especialmente si se trata de algún tipo de proyecto fantástico o de fantasía, es pegar cuidadosamente los objetos capturados en una escena tridimensional. A nivel mundial no hay un gran problema. Hoy en día, la norma es el escaneo tridimensional del área de tiro y todo lo que queda es combinar cuidadosamente el modelo de disparo y la escena tridimensional para que no haya clásicos del género cuando las piernas de los actores a veces caen un poco en el piso desigual pintado (esta jamba no es muy visible en la pantalla pequeña, pero se puede ver claramente en el cine, especialmente en algún lugar de IMAX).

No sin humor, para un ejemplo del funcionamiento de la cámara, se utilizó la escena del disparo del alunizaje (las "sombras tridimensionales" son claramente visibles en lugares que la cámara no ve):

Fuente: Luna | Lytro | VR Playhouse | Postproducción Lightfield

Fuente: Luna | Lytro | VR Playhouse | Postproducción LightfieldDado que, por definición, un video de múltiples ángulos se graba en una cámara pleóptica, construir un mapa de profundidad no es un gran problema. Y si la cámara se combina con el LIDAR, filmamos inmediatamente una escena tridimensional, lo que simplifica categóricamente la combinación de disparos reales y gráficos en la siguiente etapa.

Entonces, contamos la escena tridimensional alrededor (combinando datos LIDAR y datos de pleópticos). Ahora, lo has adivinado, ¡la representación del reconocimiento lunar será aún mejor! Adelante

Clave de croma calculada

¡Pero eso no es todo!

La tecnología habitual de un set de filmación moderno son

las pantallas verdes , cuando en lugares donde se supone que el fondo de una computadora se coloca sobre escudos de madera contrachapada verde o se tiran pancartas verdes. Esto se hace para que no haya problemas en los bordes translúcidos cuando cambia el fondo.

Y dado que en 4K al mover objetos, la mayoría de nuestros bordes se vuelven translúcidos: la relevancia de las pantallas verdes (o azules, dependiendo del color de la ropa de los actores) es extremadamente alta.Esto es extremadamente inusual para los cineastas, pero como nosotros mismos podemos cambiar la nitidez de los objetos, tenemos la oportunidad de procesar cuadros con diferentes profundidades de campo y, como resultado, leer el mapa de translucidez de los bordes y el color exacto del objeto capturado. Esto le permite disparar sin el uso de pantallas verdes, incluida una imagen bastante compleja, y luego restaurar el mapa de transparencia: Fuente: entrevista con Yon KarafinLytro grabó especialmente un video en el que se usan escaleras en el fondo (ya que debealgo no encaja en el marco: ¡esta es la ley inquebrantable de la filmación!), y el confeti borroso cae en primer plano (lo que convierte inmediatamente la limpieza de los hombres con escaleras en un desafío para los niños), pero en el marco estos objetos distantes se recortan de manera relativamente fácil y todavía tenemos ordenado primer plano, incluso con un mapa de bordes translúcidos (se selecciona un fondo contra el cual es fácil evaluar la calidad del confeti que no lo enmascara): un

Fuente: entrevista con Yon KarafinLytro grabó especialmente un video en el que se usan escaleras en el fondo (ya que debealgo no encaja en el marco: ¡esta es la ley inquebrantable de la filmación!), y el confeti borroso cae en primer plano (lo que convierte inmediatamente la limpieza de los hombres con escaleras en un desafío para los niños), pero en el marco estos objetos distantes se recortan de manera relativamente fácil y todavía tenemos ordenado primer plano, incluso con un mapa de bordes translúcidos (se selecciona un fondo contra el cual es fácil evaluar la calidad del confeti que no lo enmascara): un lector competente preguntará, ¿qué pasa con el movimiento o el mismo cabello? Y tendrá toda la razón. Sus dificultades, por supuesto, aún permanecen (y muchas). Otra cosa es que conociendo el fondo con precisión y teniendo la capacidad de mover ligeramente el objeto delante del fondo, tenemos oportunidades completamente nuevas para construir automáticamente y mejor un mapa de transparencia .En realidad, en virtud de los últimos tres puntos, es posible predecir el éxito futuro de las cámaras pleópticas en series de disparos como "Juegos del Trono", cuando se puede poner en marcha una gran cantidad de efectos especiales. Lo que significa una reducción significativa en su costo. Ahí no es tan simple, pero las posibilidades de calcular mapas de transparencia debido al reenfoque y la capacidad de cambiar el punto de disparo son un orden de magnitud mayor que las de las cámaras 2D convencionales. Y las herramientas se apretarán.Entonces, descubrimos el mapa de transparencia calculado sin pantallas verdes y seguimos adelante.

lector competente preguntará, ¿qué pasa con el movimiento o el mismo cabello? Y tendrá toda la razón. Sus dificultades, por supuesto, aún permanecen (y muchas). Otra cosa es que conociendo el fondo con precisión y teniendo la capacidad de mover ligeramente el objeto delante del fondo, tenemos oportunidades completamente nuevas para construir automáticamente y mejor un mapa de transparencia .En realidad, en virtud de los últimos tres puntos, es posible predecir el éxito futuro de las cámaras pleópticas en series de disparos como "Juegos del Trono", cuando se puede poner en marcha una gran cantidad de efectos especiales. Lo que significa una reducción significativa en su costo. Ahí no es tan simple, pero las posibilidades de calcular mapas de transparencia debido al reenfoque y la capacidad de cambiar el punto de disparo son un orden de magnitud mayor que las de las cámaras 2D convencionales. Y las herramientas se apretarán.Entonces, descubrimos el mapa de transparencia calculado sin pantallas verdes y seguimos adelante.Exposición calculada

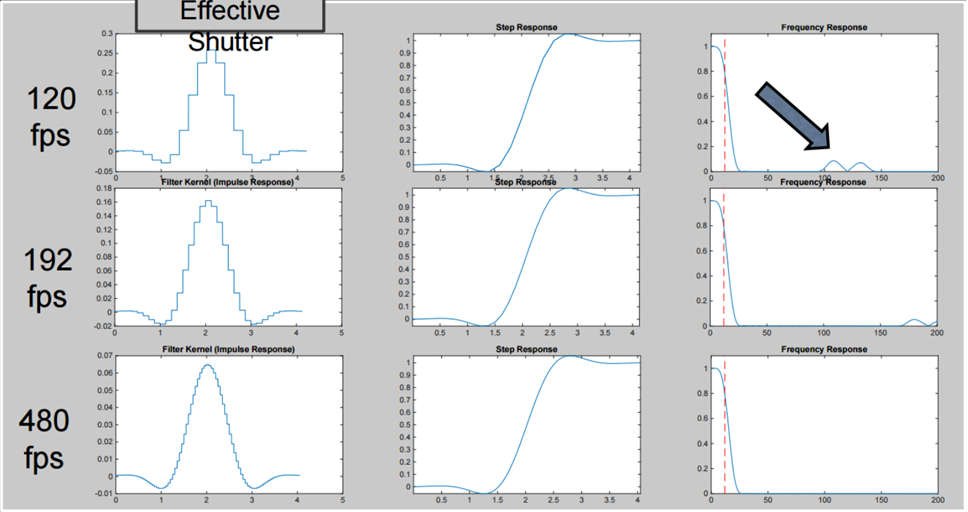

Un tema importante separado es la exposición calculada o el obturador calculado. Este tema no está directamente relacionado con los pleópticos, pero en condiciones modernas, cuando la diagonal, el contraste y la resolución de la pantalla crecen juntos y rápidamente, se vuelve cada vez más relevante. El problema es el efecto estroboscópico, que es típico del movimiento rápido de objetos en el cuadro durante el disparo "normal".Para reducir drásticamente este efecto al hacer que el movimiento sea "suave" y calcular el obturador "ideal", puede grabar un video con una velocidad de cuadro más alta y luego contarlo a una frecuencia más baja usando varias funciones de conversión, que incluyen no solo sumar cuadros, sino también restar (Lytro Cinema tenía 300 fps para dejar en claro cómo interpretar estos gráficos): Esto hace posible "grabar" un video con un obturador que es físicamente extremadamente difícil, si no imposible de crear, pero que proporciona extrema "suavidad" y "placer" de los objetos en movimiento en la escena sin el efecto estroboscópico de las ramas, las ruedas y otros objetos que se mueven rápidamente ( especialmente preste atención a los discos de las ruedas, y cuánto se ha vuelto más visible el automóvil detrás de los obstáculos):

Esto hace posible "grabar" un video con un obturador que es físicamente extremadamente difícil, si no imposible de crear, pero que proporciona extrema "suavidad" y "placer" de los objetos en movimiento en la escena sin el efecto estroboscópico de las ramas, las ruedas y otros objetos que se mueven rápidamente ( especialmente preste atención a los discos de las ruedas, y cuánto se ha vuelto más visible el automóvil detrás de los obstáculos): Fuente: https://vimeo.com/114743605O aquí hay dos disparos más, el movimiento de la cámara en el que será mucho más agradable de percibir a simple vista, especialmente en la pantalla grande:

Fuente: https://vimeo.com/114743605O aquí hay dos disparos más, el movimiento de la cámara en el que será mucho más agradable de percibir a simple vista, especialmente en la pantalla grande: Fuente: https: / /vimeo.com/114743605 Uf, calculamos la exposición. ¡Sigamos adelante!

Fuente: https: / /vimeo.com/114743605 Uf, calculamos la exposición. ¡Sigamos adelante!Cámara Plenoptic en teléfono inteligente hoy

Por lo general, cuando se trata de los pleópticos hoy en día, hay conversaciones típicas en el estilo de

"El jefe se ha ido: se retira el yeso, ¡el cliente se va!" Lytro compró Google a bajo precio el año pasado, los experimentos de Pelican Imaging no entraron en producción en masa y, en general, todo siguió siendo una teoría hermosa ...

Fuente: Pelican Imaging: Módulos de cámara plenoptica para teléfonos inteligentes por 20 dólares

Fuente: Pelican Imaging: Módulos de cámara plenoptica para teléfonos inteligentes por 20 dólares¡Ahí tienes! Los rumores sobre la muerte de los pleópticos son muy exagerados. Muy fuerte!

Por el contrario, en este momento los sensores pleópticos se producen y utilizan en una escala que

nunca antes había estado en la historia.

La notoria compañía de Google sin mucha fanfarria lanzó Google Pixel 2 y Google Pixel 3 con sensores pleópticos. Si miras el teléfono, puedes ver claramente que la cámara tiene una cámara:

Sin embargo, al mismo tiempo, el teléfono difumina muy bien el fondo, en general, no es peor que sus colegas de "dos ojos", "tres ojos" y "cuatro ojos" (de acuerdo, la siguiente foto se beneficia especialmente de este efecto):

Fuente: AI Google Blog (puede hacer clic y ver un tamaño más grande, principalmente en los bordes del objeto en primer plano)

Fuente: AI Google Blog (puede hacer clic y ver un tamaño más grande, principalmente en los bordes del objeto en primer plano)¿Cómo hacen eso?

Se está utilizando una fuente de milagros mágicos, ineludibles en los últimos tiempos: ¿magia infantil de redes neuronales?

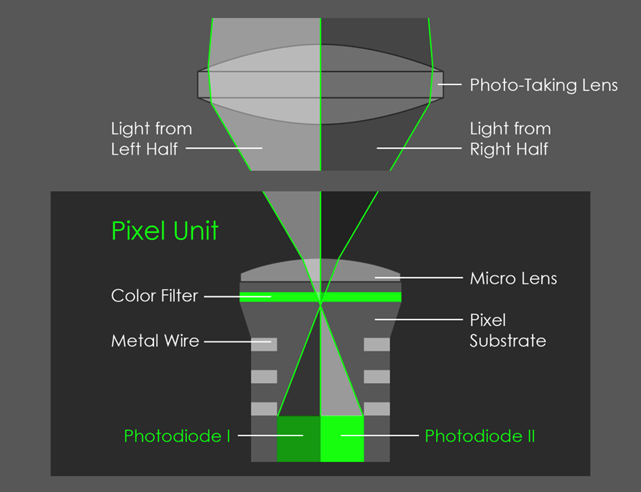

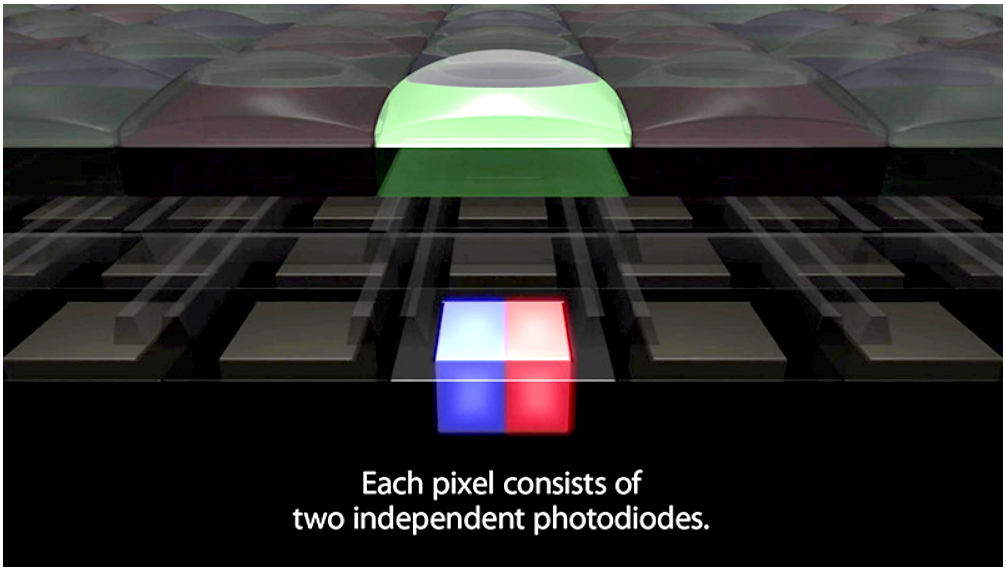

Las redes neuronales, especialmente en Pixel 3, también se usan activamente en esta tarea, pero más sobre eso más adelante. Y el secreto de la calidad del efecto es que el sensor del teléfono inteligente es plenoéptico, aunque la lente cubre solo dos píxeles, como se muestra en la imagen:

Fuente: AI Google Blog

Fuente: AI Google BlogComo resultado, obtenemos una imagen micro-estéreo, aquí se ve un cambio muy leve en el movimiento (la imagen derecha está animada y se mueve hacia arriba y hacia abajo, porque el teléfono se mantuvo así cuando se disparaba):

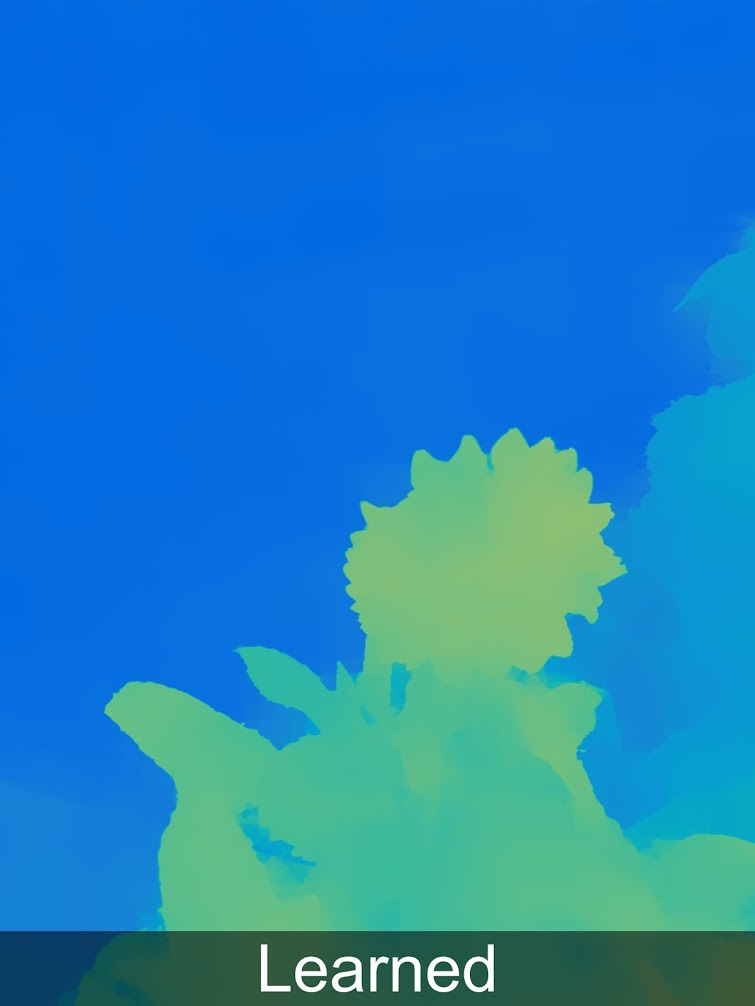

Pero incluso este cambio extremadamente pequeño es suficiente para construir un mapa de profundidad para la foto que se está tomando (sobre el uso de cambios de subpíxeles

en un artículo anterior ):

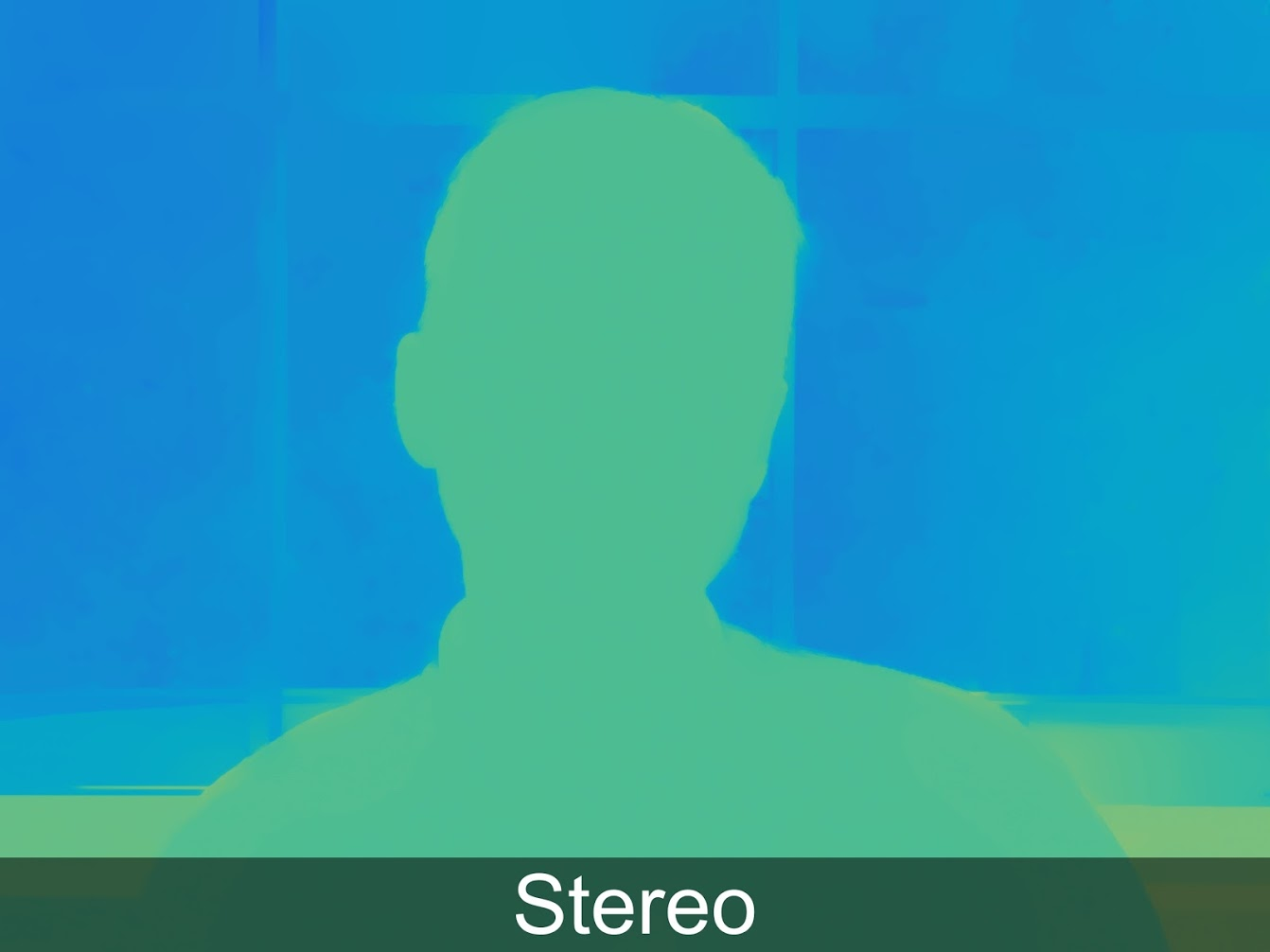

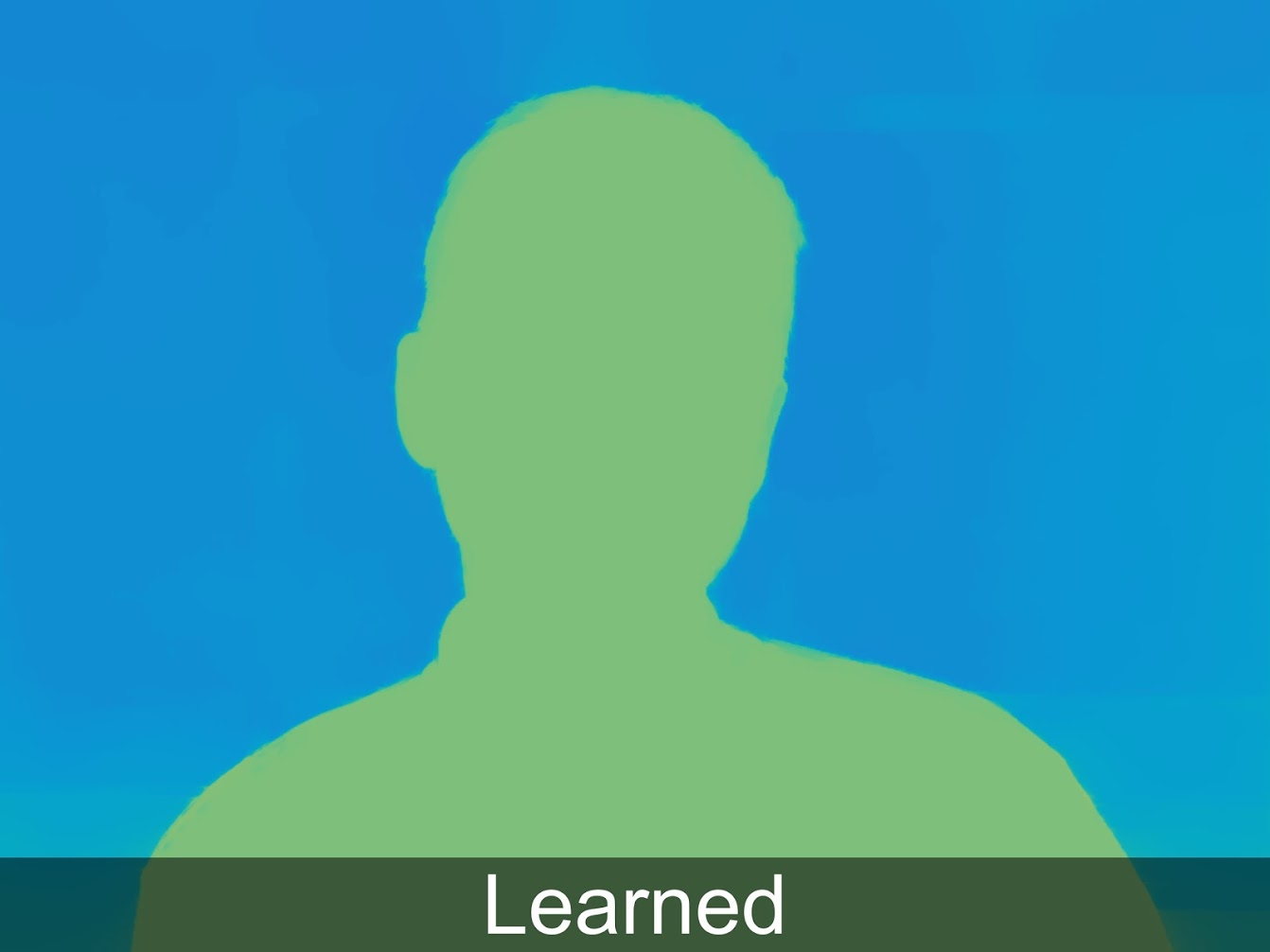

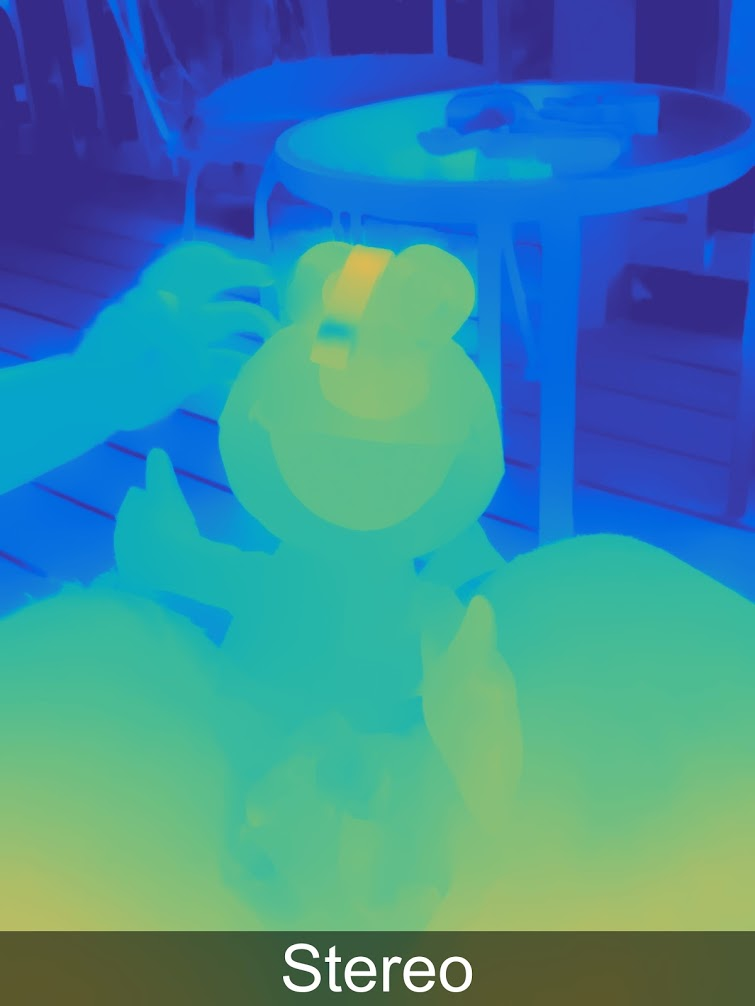

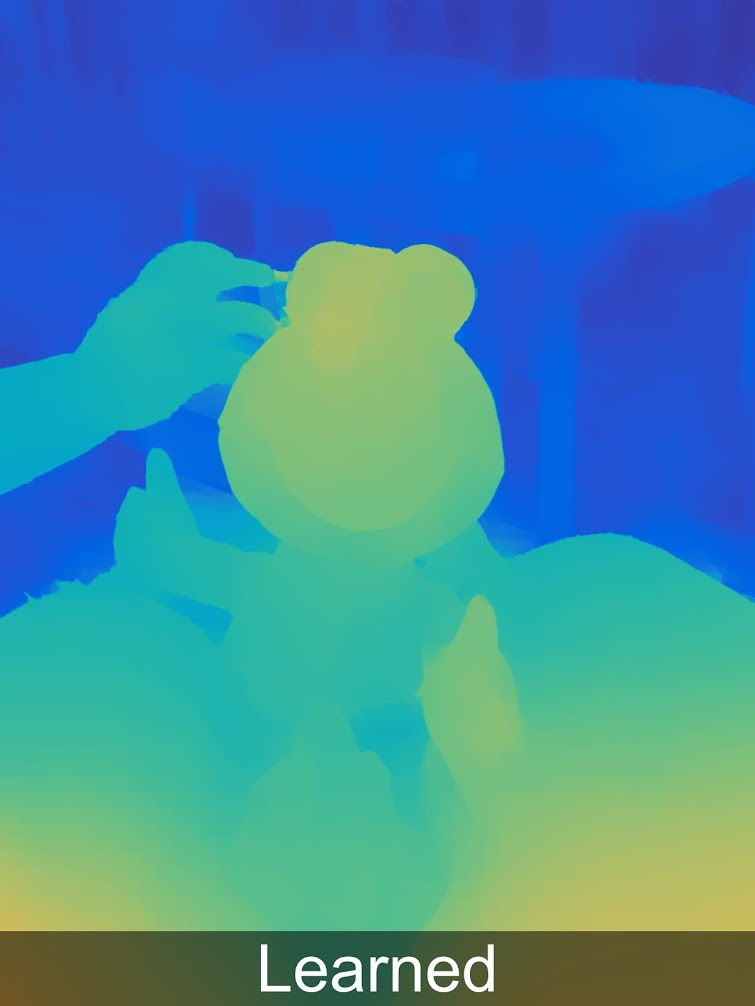

Al mismo tiempo, con el uso del aprendizaje automático, los resultados se pueden mejorar significativamente y esto ya está implementado en Pixel 3. En el siguiente ejemplo, Aprendido significa Estéreo + Aprendido, más sobre esto, con suerte, habrá una publicación separada:

Para aquellos a quienes les gusta mirar la profundidad en resolución completa, hay más ejemplos

en una galería especial .

Se ve claramente que no todo es perfecto, y tenemos artefactos típicos que son típicos para construir un mapa de profundidad desde estéreo (que, por cierto, también están disponibles en los colegas de dos ojos de Pixel), y un poco de paralaje afecta. Pero ya está claro que la calidad de la profundidad es suficiente para segmentar con confianza la imagen por profundidad e imponer aún más efectos diferentes, agregar objetos con más confianza a la escena, etc. Los resultados de la profundidad MEDIDA son un orden de magnitud mejor que los resultados basados en varios supuestos (redes neuronales arbitrarias).

¡Felicitaciones a todos los que han leído hasta este momento! ¡Vives durante el lanzamiento de cámaras pleópticas en un producto exitoso del mercado masivo, incluso si ni siquiera lo sabes!

La historia no termina ahí, por supuesto:

- En primer lugar, es interesante que los pleópticos fueran "casi gratis", ya que en las cámaras de teléfonos inteligentes modernas con una miniaturización del sensor y un aumento de la resolución, hay una falta catastrófica de flujo luminoso, por lo que cada píxel está cubierto con una microlente. Es decir, dicho sensor no cuesta más (¡esto es muy importante!), Aunque estamos sacrificando algo una resolución que acabamos de aumentar debido a otra tecnología . Como resultado de la aplicación de dos tecnologías, el resultado se vuelve mejor en 2D (menos ruido, mayor resolución, HDR) y al mismo tiempo se complementa con la profundidad medida, es decir, se convierte en 3D. El precio de la emisión es un aumento dramático en el número de cálculos por fotograma. Pero para las fotos esto ya es posible hoy y ya funciona en teléfonos inteligentes reales.

- En segundo lugar, en una conferencia, un empleado de Google dijo que estaban pensando en cubrir 4 píxeles con una lente, después de lo cual la calidad del mapa de profundidad será dramáticamente más alta, ya que habrá 2 pares estéreo con una base estéreo 1.4 veces más grande (dos diagonales), esto mejorará dramáticamente la calidad del mapa de profundidad, incluyendo muchos artefactos estéreo en las fronteras. Los competidores pueden lograr esta calidad solo colocando al menos 3 cámaras seguidas. Tal aumento en la calidad es importante para AR.

- En tercer lugar, Google ya no está solo, aquí hay un ejemplo de una descripción de una tecnología similar en el Vivo V11 Pro, ya ves, acabas de ver una imagen similar:

Fuente: ¿Qué es la tecnología Dual Pixel?

Fuente: ¿Qué es la tecnología Dual Pixel?Plenoptics también se utiliza en el enfoque automático de cámaras profesionales, por ejemplo, con

Canon (google

DPAF - Dual Pixel Auto Focus). ¿Quién hubiera pensado que una broma teórica de hace 30 años, la capacidad de disparar estéreo con una lente, sería la primera aplicación masiva de los pleópticos ...

En general, ¡el tema fue para los productos!

Ella ya está volando! Ya ves,

LE-TA-ET!

Para resumir

Filmoptica en el cine

Arriba, examinamos dos casos de uso de pleópticos: en la producción de películas y en los teléfonos inteligentes. Esta no es una lista completa, por ejemplo, los pleópticos son muy relevantes en

microscopía : puede hacer

micrografías estéreo calculadas con una gran profundidad de campo "honesta"; los pleópticos son relevantes para las cámaras industriales, especialmente si necesita tomar fotos de objetos multinivel translúcidos, etc. Pero al respecto de alguna otra manera.

Recordemos que para su uso en la producción de películas son relevantes:

- Distancia de enfoque calculada

- Bokeh calculado

- Resolución calculada

- Estéreo perfecto calculado

- Punto de disparo calculado

- Iluminación computarizada

- Ambiente Computado

- Pantalla verde calculada

- Obturador calculado

En los próximos años, con la miniaturización y una mayor resolución de los sensores, se puede desarrollar tecnología para crear una cámara de cine práctica y fundamentalmente nueva que le permite eliminar material para aplicar efectos especiales más rápido (sin una pantalla verde) y con menos tomas (más puntos son más fáciles de arreglar). Las nuevas características son tan interesantes que, para cuando el sensor plenoóptico con una resolución de película adecuada se puede compactar, estas cámaras están condenadas al éxito.

¿Cuándo puede aparecer una cámara así?Una respuesta cautelosa es en los próximos 10 años.

¿De qué depende el término?De muchos factores. Buena pregunta: ¿cuál será la situación con la capacidad de licenciar las patentes de Lytro que ahora posee Google? Esto puede ser crítico. Afortunadamente, las claves expirarán en 10 años (aquí no recordamos cortésmente a los colegas chinos de Lytro que pueden acelerar el proceso). Además, el trabajo con cantidades colosales de datos generados por la cámara pleóptica debe simplificarse: con las nubes modernas, esto es cada vez más fácil. De las buenas noticias: en un momento gracias a Lytro, en un

programa de composición muy popular , que se utiliza en una gran cantidad de estudios para el procesamiento estéreo, se admitió el formato de datos pleópticos. Como dicen, Lytro murió, pero la oportunidad de escribir complementos para Nuke con soporte para video plenoptic permaneció con nosotros. Esto simplifica la "entrada" en este mercado con un producto profesional, ya que es importante que los estudios puedan trabajar inmediatamente con el formato de las nuevas cámaras de inmediato sin necesidad de capacitar al personal y en los mismos programas.

Plenoptika en teléfonos inteligentes

Si hablamos de teléfonos inteligentes, entonces todo se ve aún mejor. Lo más relevante para esta industria es la capacidad de la cámara pleóptica para medir la profundidad con un solo sensor (potencialmente rápido) y esta característica pronto será de gran demanda.

¿Cuándo puede aparecer una cámara así?Ya existe Y mañana, la tecnología será repetida por otros fabricantes. Además, el factor clave de la próxima etapa será

la realidad aumentada en teléfonos inteligentes y tabletas, que hoy carece de precisión y la capacidad de "ver" una escena tridimensional.

¿De qué depende el término?Es probable que la capacidad de medir la distancia con el sensor principal en tiempo real aparezca pronto con Google Pixel, ya que Google se ha estado desarrollando en esta dirección durante mucho tiempo (consulte

Proyecto Tango , que está cerrado, pero cuyo negocio sigue vivo). Y

ARCore se ve muy prometedor, así como el

ARKit de la competencia. Y el avance, como ahora supones, no tiene que esperar mucho, ya que el valor del píxel del sensor cae exponencialmente, llaman a la velocidad promedio 10 veces en 10 años, y necesitamos una caída de 2 veces. Entonces cuenta por ti mismo. No mañana, pero no por mucho tiempo.

En lugar de una conclusión

¿Recuerdas que al principio estábamos hablando de una conferencia en VGIK? Debo decir que no esperaba la reacción que se produjo al final. Para decirlo en una palabra, estaba de luto. Si en dos palabras, entonces luto universal. Y al principio no entendí cuál era el problema. El operador que apareció después de la conferencia me explicó muy bien la situación. Ni siquiera era que el arte de la cámara estaba disminuyendo. Aunque hubo un gran ejemplo: un fragmento de película durante unos 6 segundos, cuando una persona se acerca a la puerta del departamento, golpea, otra persona abre la puerta, saluda y se mueve un poco hacia adelante, mientras la cámara enfoca el pasillo, luego el marco de la puerta, luego enfoca instantáneamente en la persona que lo descubrió, y luego en la habitación. Y el operador necesita dominar la cámara a la perfección, de modo que con una

profundidad de campo poco profunda como la del cine, opere el zoom de manera magistral, recordando la luz de fondo, la composición del marco, el mareo al disparar con las manos y otras 1000 pequeñas cosas importantes. Entonces aquí. Ni siquiera es que esto sea cada vez más fácil. Esto es incluso bueno. Menos tomas se echarán a perder debido al hecho de que el operador en algún lugar no tuvo tiempo o se perdió. Contó cómo recientemente filmó una serie en 4K para el canal. Y el stock de resolución resultó ser grande. Como resultado, el director cortó los cuadros en la posproducción, y en algunos lugares solo se usaron fragmentos del cuadro para las interrupciones. Como resultado, la composición fue simplemente horrible y este operador quería eliminar su nombre de los créditos.

Las características descritas anteriormente de las cámaras para cineastas significan la transferencia de muchos efectos desde la etapa de filmación hasta la etapa de postproducción. Y habrá una gran tristeza si quienes procesan las escenas tomadas son analfabetos en materia de composición, control de distancia de enfoque, etc. Si saben leer y escribir, estas son nuevas oportunidades fantásticas.

Por lo tanto, nos deseamos a todos más competencia, ¡lo cual no siempre es fácil en este mundo que cambia rápidamente!Y Cartago ... ¡ todo el video será tridimensional para fines de siglo!Agradecimientos

Me gustaría agradecerle cordialmente:

- Laboratorio de Computación Gráfica VMK Universidad Estatal de Moscú MV Lomonosov por su contribución al desarrollo de gráficos por computadora en Rusia y no solo

- Nuestros colegas del grupo de videos, gracias a los cuales vieron este artículo,

- personalmente Konstantin Kozhemyakov, quien hizo mucho para hacer este artículo mejor y más visual,

- Jon Karafin cuando era jefe de video de campo de luz en Lytro, gracias a lo cual casi comenzamos a trabajar para mejorar su producto (y no comenzamos por razones ajenas a nuestro control o de nosotros),

- Lytro por su contribución a la popularización de los campos de luz y sus capacidades, Google, que atrapó la bandera que cae, y otras compañías que fabrican productos basados en esta interesante tecnología,

- y finalmente, muchas gracias a Sergey Lavrushkin, Roman Kazantsev, Ivan Molodetsky, Evgeny Kuptsov, Yegor Sklyarov, Evgeny Lyapustin y Denis Kondranin por una gran cantidad de comentarios y correcciones sensatas que hicieron que este texto fuera mucho mejor.