"Las computadoras de alta velocidad no pueden funcionar sin aire"

Hay un momento en la película Iron Man 2 cuando Tony Stark ve una vieja película de su difunto padre, donde dice: "Estoy limitado por la tecnología de mi tiempo, pero un día puedes resolverlo". Y luego cambiarás el mundo ". Es fantástico, pero la idea que expresa es bastante real. Las ideas de los ingenieros a menudo están muy adelantadas a su tiempo. Siempre ha habido dispositivos en Star Trek, pero el resto del mundo ha tenido que trabajar durante décadas para crear tabletas y libros electrónicos.

El concepto de refrigeración líquida encaja perfectamente en esta categoría. La idea en sí ha existido desde la década de 1960, pero se mantuvo radical en comparación con una opción mucho más barata y segura para la refrigeración por aire. Pasaron más de 40 años hasta que la refrigeración líquida comenzó a desarrollarse un poco en la década de 2000, e incluso entonces era principalmente una prerrogativa de los entusiastas de las PC que buscaban dispersar sus CPU más allá de los límites recomendados por Intel y AMD.

Hoy en día, los sistemas de refrigeración líquida están ganando popularidad. Tal sistema para PC se puede comprar por menos de $ 100, y la producción artesanal dirigida a aplicaciones industriales y centros de datos (como CoolIT, Asetek, Green Revolution Computing, Ebullient) ofrece refrigeración líquida () para servidores. Los ZhO se usan principalmente en supercomputadoras, informática de alta velocidad u otras situaciones en las que se requiere una gran cantidad de energía de la computadora, y los procesadores funcionan con casi el 100% de carga, pero estas opciones se están volviendo más comunes.

Hay dos tipos populares de ZhO: enfriamiento directo de chips e inmersión. Con enfriamiento directo, el radiador se conecta a la CPU, como un enfriador estándar, pero en lugar de eso, se conectan dos tubos. Uno viene con agua fría, un disipador térmico que absorbe el calor de la CPU, y el otro deja caliente. Luego se enfría y vuelve a la CPU en un circuito cerrado que se asemeja al flujo sanguíneo.

Durante el enfriamiento por inmersión, el equipo se llena con líquido que, obviamente, no debe conducir electricidad. Este enfoque es más similar a las piscinas de enfriamiento de los reactores nucleares. El enfriamiento sumergible sigue siendo una opción más avanzada y requiere refrigerantes más caros que una conexión directa, donde puede usar agua común. Además, siempre existe el riesgo de fugas. Por lo tanto, con mucho, la opción más popular es la conexión directa.

Como uno de los principales ejemplos, tome Alphabet. Cuando esta empresa matriz de Google presentó el AI TensorFlow 3.0 en mayo de 2018, el director Sundar Pichai dijo que estos chips eran tan potentes que "por primera vez, tuvimos que instalar refrigeración líquida en los centros de datos". Alphabet tuvo que pagar este precio por un aumento de ocho veces en la productividad.

Por otro lado, Skybox Datacenters anunció recientemente planes para crear una gran supercomputadora con 40,000 servidores de DownUnder GeoSolutions (DUG), diseñada para la exploración de petróleo y gas. Este proyecto producirá 250 petaflops de potencia informática, más que cualquier otro existente, y se espera que los servidores se enfríen por fluido cuando se sumerjan en tanques llenos de fluido dieléctrico.

En cualquier caso, "la refrigeración líquida es la refrigeración del futuro, y siempre lo será", dijo Craig Pennington, vicepresidente de diseño, operador del centro de datos de Equinix. "Parece obvio que este es el enfoque correcto, pero nadie lo ha aplicado".

¿Cómo ha pasado JO del arte esotérico a la vuelta de la informática a un método casi universalmente aceptado en los centros de datos modernos? Como todas las tecnologías, esto sucedió en parte como resultado de la evolución, prueba y error, y una gran cantidad de soluciones de ingeniería. Sin embargo, para ZhO, los centros de datos de hoy deberían agradecer a los primeros overclockers que son héroes anónimos de este método.

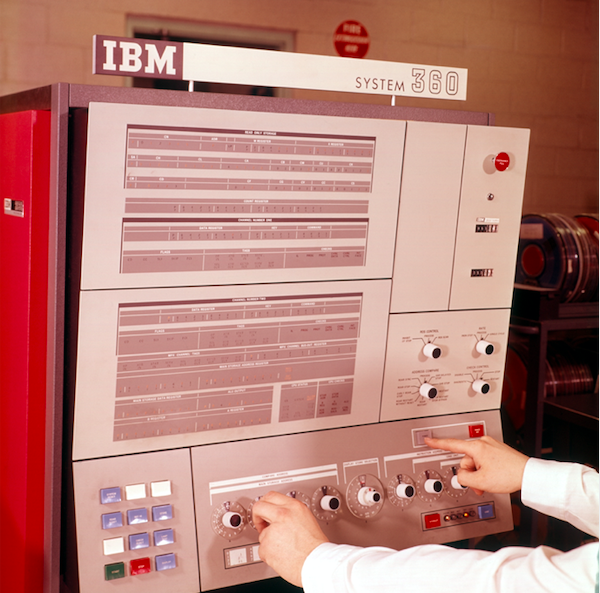

El panel de control del sistema de procesamiento de datos IBM System 360

El panel de control del sistema de procesamiento de datos IBM System 360¿Qué queremos decir con refrigeración líquida?

La refrigeración líquida se convirtió en una idea popular en 1964 cuando IBM estudió el tema de la refrigeración sumergible para el mainframe System 360. Era uno de los mainframes de la compañía; Las series 700 y 7000 existieron durante más de diez años, y System / 360 "comenzó la era de la compatibilidad con computadoras, permitiendo por primera vez que diferentes máquinas de la línea de productos trabajen juntas", según escriben en IBM. El concepto era simple: el agua enfriada tenía que fluir a través de un dispositivo que la enfriaba a una temperatura inferior a la temperatura ambiente, y luego el agua se alimentaba directamente al sistema. El circuito utilizado por IBM ahora se conoce como enfriamiento posterior cuando el disipador térmico está montado detrás de la unidad central. El dispositivo aspiraba aire caliente de la unidad central con ventiladores, y luego este aire se enfriaba con agua, al igual que un radiador enfría el motor de un automóvil.

Desde entonces, los ingenieros han perfeccionado este concepto básico y han surgido dos formas dominantes de FV: inmersión y contacto directo. La inmersión es lo que es; La electrónica está en un baño líquido que, por razones obvias, no puede ser agua. El líquido no debe conducir electricidad, es decir, ser un aislante (empresas como 3M incluso desarrollan específicamente líquidos para esto).

Pero el buceo tiene muchos problemas y desventajas. Solo se puede acceder al servidor ubicado en el líquido desde arriba. Por lo tanto, los puertos externos deben ubicarse allí. La ubicación del servidor de gabinetes de 1U en un bastidor no sería práctico, por lo que el servidor no puede colocarse secuencialmente. Un dieléctrico, y generalmente uno mineral, es pequeño, muy costoso y difícil de limpiar en caso de fuga. Se requerirán discos duros especiales, y la alteración del centro de datos requerirá importantes inversiones. Por lo tanto, como en el caso de la supercomputadora mencionada anteriormente, la inmersión se realiza mejor en un nuevo centro de datos, en lugar de rehacer el antiguo.

El contacto directo de JO, en cambio, es que el radiador (o intercambiador de calor) está en el chip, como un radiador normal. En lugar de un ventilador, usa dos tuberías de agua: una que trae agua fría para enfriar y la segunda que sopla agua caliente calentada por contacto con el radiador. Esta forma de ZhO se convirtió en la más popular, fue adoptada por fabricantes como HP Enterprise, Dell EMC e IBM, así como por fabricantes de gabinetes Chatsworth Systems y Schneider Electric.

El enfriamiento directo usa agua, pero es muy sensible a su calidad. No se debe usar agua del grifo sin filtrar. Solo mira tu grifo o ducha. Nadie necesita la acumulación de calcio en los servidores. Al menos el enfriamiento directo requiere agua destilada pura y, a veces, su mezcla con anticongelante. La fabricación de dicho refrigerante es una ciencia en sí misma.

Enlace de Intel

¿Cómo pasamos de los radiadores de IBM a los modernos y extravagantes sistemas de enfriamiento? De nuevo, gracias a los overclockers. A principios de siglo, la refrigeración líquida comenzó a ganar popularidad entre los overclockers de PC y los aficionados que ensamblaron sus computadoras que querían aumentar su velocidad más allá de los límites oficiales. Sin embargo, era un arte esotérico sin diseños estándar. Todos hicieron algo diferente. La persona que reunió todo esto tenía que ser tan

generosa que el ensamblaje de los productos de IKEA pareciera una completa tontería. La mayoría de los sistemas de enfriamiento ni siquiera encajaban en los gabinetes.

A principios de 2004, la situación comenzó a cambiar debido a cambios internos en las políticas de Intel. Un ingeniero del centro de diseño de Hillsboro, Oregon, donde se diseñan la mayoría de los chips de la compañía, a pesar de tener su sede en Santa Clara, California, ha estado trabajando en un proyecto especial de enfriamiento durante varios años. El proyecto le costó a la compañía $ 1 millón y tenía como objetivo crear un enfriador líquido para procesadores Intel. Desafortunadamente, Intel estaba a punto de cerrarlo.

El ingeniero esperaba un resultado diferente. Para salvar el proyecto, se le ocurrió esta idea en Falcon Northwest, una compañía con sede en Portland que construyó complementos de juegos para computadoras. "La razón fue porque la compañía pensó que el enfriamiento por líquido alentaba a las personas a hacer overclock y esta actividad estaba prohibida en ese momento", dijo Kelt Reeves, presidente de Falcon Northwest. Y en esta posición, Intel tenía su propia lógica. En ese momento, los minoristas sin principios de Asia estaban vendiendo PCs overclockeadas bajo la apariencia de otras más potentes, y con una refrigeración deficiente, y a los ojos del público, esto de alguna manera se convirtió en un problema de Intel. Por lo tanto, la compañía se opuso al overclocking.

Sin embargo, este ingeniero de Oregón creía que si lograba encontrar clientes y un mercado para ese refrigerador, Intel rendirá. (Además, el producto Intel resultante fue mucho mejor en calidad que lo que estaba disponible en el mercado, nos dijo Reeves). Por lo tanto, después de cierta persuasión interna y negociaciones entre las compañías, Intel permitió a Falcon vender sistemas de enfriamiento, en particular porque Intel ya los producía en miles. El único inconveniente fue que Falcon no podía mencionar que Intel estaba involucrado. Falcon estuvo de acuerdo, y pronto se convirtió en el primer fabricante en suministrar sistemas de PC todo en uno completamente sellados.

Reeves señaló que esta solución de ZhO de vanguardia no era particularmente fácil de usar. Falcon tuvo que cambiar la carcasa para que se ajustara al radiador e inventar una placa de enfriamiento para el agua. Pero con el tiempo, los fabricantes de refrigeradores, como ThermalTake y Corsair, aprendieron lo que Intel estaba haciendo y comenzaron a realizar mejoras consistentes. Desde entonces, han aparecido varios productos y fabricantes, por ejemplo, CoolIT y Asetek, que fabricaron específicamente ZhO para centros de datos. Algunos de sus productos, por ejemplo, tuberías que no se rompen, no se agrietan y no tienen fugas con una garantía de hasta siete años, finalmente se otorgaron bajo licencia a los fabricantes de sistemas de refrigeración para el usuario final, y dicho intercambio de tecnología en ambas direcciones se ha convertido en la norma.

Y a medida que este mercado crece en diferentes direcciones, incluso Intel finalmente cambió de opinión. Ahora anuncia capacidades de overclocking para los procesadores de las series K y X, y ni siquiera le importa vender refrigeradores regulares junto con la CPU superior para los jugadores.

"ZhO ya es una tecnología probada: todo el mundo lo está haciendo por parte del consumidor", dijo Reeves. Intel ha dejado de suministrar refrigeradores regulares con las CPU más potentes, porque necesitan JO; ya ha sido probado y se ha recibido una bendición de Intel. No creo que haya alguien que diga que las soluciones completas para esto no son lo suficientemente confiables ".

Enfriamiento por inmersión en el centro de datos. Las cajas están llenas de fluido dieléctrico que fluye a través de las tuberías.

Enfriamiento por inmersión en el centro de datos. Las cajas están llenas de fluido dieléctrico que fluye a través de las tuberías. Refrigeración líquida de Skybox Datacenters con inmersión. Los intercambiadores de calor se sumergen con equipos informáticos y el fluido dieléctrico no sale del tanque. Un circuito de agua pasa por las habitaciones y se acerca a cada intercambiador de calor.

Refrigeración líquida de Skybox Datacenters con inmersión. Los intercambiadores de calor se sumergen con equipos informáticos y el fluido dieléctrico no sale del tanque. Un circuito de agua pasa por las habitaciones y se acerca a cada intercambiador de calor.Hechos a favor de la practicidad del enfriamiento líquido.

Durante mucho tiempo, los centros de datos tradicionales proporcionaron un piso elevado con pequeñas aberturas a través de las cuales el aire frío se elevó, absorbido por los servidores. Esto se llamaba CRAC, o aire acondicionado de la sala de computadoras. El problema es que ahora no es suficiente soplar aire frío a través de las aberturas en el piso.

La razón principal del reciente auge del enfriamiento líquido es la necesidad. Los procesadores de hoy se calientan demasiado y los servidores están demasiado cerca para que el aire los enfríe eficientemente, incluso Google dice. La capacidad calorífica del agua es 3300 veces mayor que la del aire, y un sistema de enfriamiento de agua puede bombear 300 litros de agua por minuto, en comparación con 20 metros cúbicos de aire por minuto.

En pocas palabras, el agua puede enfriarse de manera mucho más eficiente y en un espacio mucho más pequeño. Por lo tanto, después de muchos años de intentar reducir el consumo de energía, los fabricantes de procesadores pueden dispersar la energía y torcer el voltaje para obtener el máximo rendimiento, sabiendo que la refrigeración líquida puede manejar esto.

"Se nos pide que enfríemos los chips cuyo consumo de energía pronto superará los 500 vatios", dijo Jeff Lyon, director de CoolIT. - Algunos procesadores que aún no han ingresado al mercado consumirán 300 vatios cada uno. Todo esto se está desarrollando a pedido de AI y machine learning. La velocidad de enfriamiento simplemente no es suficiente ".

Lyon dijo que CoolIT está considerando expandir el sistema de enfriamiento a conjuntos de chips, sistemas de control de potencia, chips de red y memoria. "No habrá nada radical al tratar con la memoria", agregó. - Hay opciones de RAM con empaque avanzado, que consumen 18 vatios por DIMM. Un DIMM típico consume 4-6 vatios. Entre los sistemas con una gran cantidad de memoria, encontramos servidores con 16 o incluso 24 DIMM instalados, lo que significa mucho calor ”.

Uno por uno, los fabricantes se enfrentan a tales solicitudes. Equinix observa cómo la densidad promedio crece de 5 kW a 7-8 kW, y ahora a 15-16 kW, con algunos equipos que ya muestran una densidad de 40 kW. “Entonces, la cantidad total de aire que necesita ser bombeada se vuelve demasiado grande. No sucederá instantáneamente, pero en los próximos años habrá una adopción fundamental de refrigeración líquida ”, dijo Pennington de Equinix.

Un poco sobre enfriamiento por inmersión

Green Revolution Cooling se centra en el enfriamiento por inmersión, y su director Peter Poulin dice que desde una perspectiva de eficiencia energética, el enfriamiento por inmersión es mejor que el enfriamiento directo por dos razones. Primero, los ventiladores se eliminan de todos los servidores. Solo esto reduce el consumo de energía en un 15% en promedio. Y un cliente de la compañía lo redujo en un 30%.

Hay otra ventaja indirecta para eliminar a los fanáticos: el silencio. A pesar del hecho de que a menudo se usan ventiladores muy pequeños en los servidores, los servidores son terriblemente ruidosos, y estar en el centro de datos es desagradable debido al calor y al ruido. La refrigeración líquida hace que estos lugares sean mucho más agradables para trabajar.

Otra ventaja es que se requiere muy poca energía para soportar el sistema de enfriamiento por inmersión. Solo hay tres partes móviles: una bomba para hacer circular un refrigerador, una bomba para moverla a una torre de enfriamiento y un ventilador de torre de enfriamiento. Después de reemplazar el aire refrigerado por líquido, el consumo de electricidad puede caer al 5% de lo que se gastó en aire acondicionado. "Se obtiene una gran reducción en el consumo de energía, lo que le permite hacer muchas otras cosas", dijo Poulnin. "Dependiendo del consumidor, el centro de datos puede ser más eficiente energéticamente o reducir las emisiones de carbono asociadas con la construcción de centros de datos".

Hechos a favor de la eficiencia energética del enfriamiento líquido

El consumo de energía ha sido durante mucho tiempo una preocupación para la industria del centro de datos (la Agencia de Protección Ambiental de EE. UU. Ha estado rastreando esta cifra durante al menos diez años). Los centros de datos actuales son grandes empresas que consumen aproximadamente el 2% de toda la electricidad global y liberan tanto CO2 como la industria de las aerolíneas. Por lo tanto, el interés en este tema no se desvanece. Afortunadamente, la refrigeración líquida reduce las facturas de electricidad.

Los primeros ahorros se deben a la desconexión del aire acondicionado en el centro de datos. El segundo es la eliminación de los fanáticos. Cada rack de servidores tiene muchos ventiladores que emiten aire, pero su número se puede reducir a un número pequeño o a cero, dependiendo de la densidad.

Y con la tecnología de "enfriamiento en seco", en la que no hay congelación, puede lograr ahorros aún mayores. Inicialmente, el enfriamiento conectado directamente condujo el agua a través de un refrigerador, que la enfrió a 15–25 grados Celsius. Pero al final, resultó que los refrigeradores líquidos, que pasaban agua a través de una larga secuencia de tuberías y ventiladores, tuberías frías calentadas por agua caliente y difusión térmica natural, también enfrían el agua a una temperatura suficiente.

"Debido a que este proceso es tan efectivo, no tiene que preocuparse por enfriar el agua a una temperatura baja", dice Pennington. - El agua tibia aún elimina efectivamente todo el calor de los servidores. No necesita un ciclo de compresión, solo puede usar enfriadores secos ".

Los enfriadores secos también ahorran agua. Un gran centro de datos que usa refrigeradores puede consumir millones de litros de agua por año, pero un centro de datos con enfriadores secos no consume agua. Esto ahorra energía y agua, lo que puede ser muy útil si el centro de datos se encuentra dentro de la ciudad.

"No consumimos mucha agua", dijo Pennington. - Si diseñas todo cuidadosamente, obtienes un sistema cerrado. El agua no se vierte y no se vierte, solo necesita agregar agua aproximadamente una vez al año para mantener los tanques llenos. No agrega agua constantemente a su automóvil, este es el caso con nosotros ".

La aceptación sigue a la efectividad

Un ejemplo del mundo real: Dell, al cambiar a refrigeración líquida, ha aumentado la eficiencia energética (

PUE ) en un 56%, según Brian Payne, vicepresidente de gestión de productos y marketing de PowerEdge Dell EMC.

PUE es la relación entre la energía que se debe gastar para enfriar el sistema y la energía necesaria para operar el sistema [de hecho, esta es la relación entre la energía total utilizada por el centro de datos y la energía gastada directamente en alimentar la infraestructura de TI / aprox. perev]. PUE de 3 significa que se gasta 2 veces más energía en enfriar un sistema que en energía del sistema, y PUE = 2 significa que tanto la energía como el enfriamiento se consumen por igual. PUE no puede ser igual a 1, ya que el enfriamiento es necesario, pero los operadores de centros de datos están obsesionados con tratar de acercar la cifra a 1.0 como sea posible.Además de mejorar PUE, el aumento de la potencia informática que reciben los clientes de Dell puede ser de hasta un 23%, y esto no sobrecarga el sistema más allá de toda medida. "En función de las inversiones en infraestructura necesarias, predecimos el rendimiento anual del sistema", dice Payne. - Lo compararía con la compra de un acondicionador de aire más eficiente en energía para el hogar. Invierte un poco, pero con el tiempo siente los beneficios de las facturas de electricidad ".Como un adherente completamente diferente del enfriamiento líquido, tome el centro de supercomputadoras en Ohio, OSC. Este clúster emplea 1800 nodos. Después de cambiar a JO, como dijo Doug Johnson, arquitecto jefe de sistemas, el centro alcanzó PUE = 1.5. OSC utiliza un circuito externo, por lo que el agua se elimina del edificio y se enfría a temperatura ambiente, que en promedio es de 30 ° C en verano y mucho menos en invierno. Las virutas alcanzan los 70 ° C, e incluso si el agua se calienta hasta 40 ° C, sigue siendo mucho más fría que las virutas y cumple su propósito.Como muchos de los primeros en adoptar la nueva tecnología, para OSC todo es nuevo. Hace cinco años, el centro no usaba ZhO en absoluto, y hoy ocupa el 25%. El centro espera que en tres años la barra crecerá al 75%, y después de unos años cambiarán completamente a ZhO. Pero incluso en el estado actual, según Johnson, enfriar el centro requiere cuatro veces menos energía que antes de la transición a ZhO, y en general, esta solución redujo el consumo total de energía en 2/3. "Creo que el porcentaje aumentará cuando comencemos a integrar la GPU en el sistema de enfriamiento".Desde el punto de vista del cliente, se necesita tiempo y energía para evaluar una nueva tecnología, por eso una gran empresa como Dell acordó trabajar con CoolIT para anunciar ZhO. No es sorprendente que, en primer lugar, entre las preocupaciones de los clientes siga existiendo la posibilidad de fugas. Sin embargo, a pesar de todas las fluctuaciones, resulta que en este momento tienen pocas opciones si quieren lograr el mejor rendimiento."Siempre ha habido miedo a las filtraciones", dice Lyon de CoolIT. - La situación ha cambiado, y ahora simplemente no hay otras opciones. Las computadoras de alta velocidad no pueden hacer exactamente eso ".