A veces se hace necesario organizar un almacenamiento tolerante a fallas de pequeños volúmenes de almacenamiento de hasta 20Tb, pero con funcionalidad Enterprise: All-Flash, caché SSD, MPIO, HA (Activ-Activ) y todo esto con un precio económico. Las soluciones de hardware listas para usar con estas funciones comienzan con cientos de terabytes y precios de 8 o más letreros en rublos. Tener un pequeño presupuesto de 6-7 personajes en el río. y la necesidad de un almacenamiento pequeño y rápido (pero confiable), desde 2009 se han probado y puesto en funcionamiento comercial dos versiones de sistemas de almacenamiento (lo común con estos sistemas es que son sistemas altamente confiables sin un solo punto de falla + puedes tocarlos antes de comprarlos o "prescindir de ellos" (GRATIS)).

A quién le interesa esta experiencia, a continuación se describirá lo siguiente:

- Experiencia de software StarWind Virtual SAN (VSAN) .

- Cómo hacer un pequeño almacenamiento empresarial.

- Historial de overclocking de IOPS (práctica).

- Hoja de trucos para la implementación y operación de sistemas de almacenamiento EMC ScaleIO (VxFlexOS) (en ausencia de soporte técnico por parte de los especialistas de "NOT Linux-guru") 1 parte.

1. Experiencia operativa StarWind Virtual SAN (VSAN) Software

StarWind Virtual SAN (VSAN) : en la solución Activ-Activ (replicación sincrónica en 3 servidores), en funcionamiento desde 2009-2016 en diferentes ediciones (Starwind ISCSI SAN HA-3) basada en servidores con matrices RAID de hardware.

Pros :

- Fácil y rápido, ni siquiera instalado por un profesional;

- MPIO sobre iSCSI Ethernet;

- HA (Activ-Activ);

- En los servidores nuevos (de garantía) (con discos nuevos), puede olvidarse de mantener el almacenamiento durante varios años (los usuarios ni siquiera notarán la falla de dos de los tres servidores);

- Volúmenes de caché de RAM y SSD;

- Rápido Sincronización rápida para interrupciones menores de la red.

Contras :

- Anteriormente, solo había una versión para la plataforma Windows;

- Con operación a largo plazo (más de 3 años): es difícil encontrar una unidad para reemplazar una fallida (fuera de producción) para reparar una matriz RAID (con discos heterogéneos, pueden ocurrir fallas de la matriz);

- Un aumento en el número de interfaces de red y las ranuras PCI ocupadas por ellas (adicionalmente para sincronización, tarjetas de red, conmutadores);

- Cuando se utiliza el "sistema de archivos de registro en diario" LSFS, el apagado prolongado del sistema, que puede ser perjudicial cuando el UPS se activa cuando se apaga la alimentación;

- Un tiempo muy largo de sincronización completa con un gran volumen.

Quizás problemas ya resueltos (ocurridos anteriormente durante la operación en nuestro centro de datos):

- Cuando la matriz RAID colapsa, el servidor permanece visible a través de la sincronización y el canal de datos, pero el disco en el servidor de Windows está desconectado, el registro de Starwind se infla y la memoria del servidor se consume, como resultado de la congelación del servidor. Posible tratamiento: asignación de un archivo de control y eliminación de mensajes no críticos de la configuración del registro.

- Si el conmutador o las interfaces de red fallan, una elección ambigua del servidor host (a veces sucedió, el sistema no pudo entender con quién sincronizar).

Noticias útiles (aún no probadas):

StarWind Virtual SAN para vSphere (solución hiperconvergente), le permite incrustar la virtualización de Vmware en un clúster sin vincular a los servidores de Windows (basados en máquinas virtuales Linux).

Resumen : Una solución tolerante a fallas si hay un programa de reemplazo de servidor de hardware normal al final de la garantía y el soporte técnico de StarWindSoftWare está disponible.

2. Cómo hacer un pequeño almacenamiento empresarial

Declaración del problema:Cree una red de almacenamiento de datos de pequeño volumen a prueba de fallas con un total de 4 TB-20TB, con operación garantizada a mediano plazo sin costos financieros adicionales significativos.

- El sistema debe ser tolerante a fallas (transfiera con calma la falla de al menos un conmutador, un servidor, discos y tarjetas de red en el servidor).

- Aproveche al máximo todos los recursos de la flota de servidores de hardware disponible (servidores y conmutadores de 3 a 10 años).

- Asegure el funcionamiento de volúmenes de diferentes niveles: All-Flash y HDD + caché SSD.

Datos de origen:- presupuesto limitado;

- equipo de generación hace 3-10 años;

- Especialistas: no Linux-Guru.

Cálculo de características.Para evitar cuellos de botella en el rendimiento cuando se usan discos SSD, que serán cortados por algo de la cadena del equipo: tarjetas de red, controlador RAID (HBA), expansor (cesta), discos.

Es necesario en el momento de la creación proporcionar, en función de sus características requeridas, una determinada configuración del equipo.

Por supuesto, puede ejecutar una configuración con SSD de almacenamiento en caché de disco duro SAS en redes de 1 Gb / sy controladores 3G, pero el resultado será 3-7 veces peor que en redes RAID de 6 Gb y 10 Gb / s (verificado por pruebas).

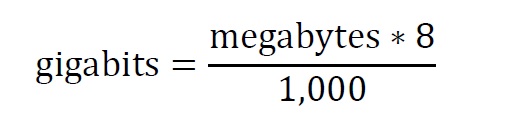

Las instrucciones de ajuste de VxFlexOS describen

instrucciones simples para calcular el ancho de banda necesario, basado en las estimaciones SSD -450 MB / C y HDD -100 MB / C, para la grabación secuencial (por ejemplo, cuando el servidor se reequilibra y se reconstruye).

Por ejemplo:

- (SSD caché + 3 HDD), obtenemos ((450 * 1) + (3 * 100)) * 8/1000 = 6GB

- (TODO FLASH SSD) + (caché SSD + 3 HDD) ((450 * 2) + (3 * 100)) * 8/1000 = 9.6 GB

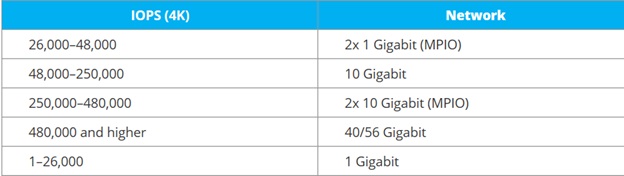

Para determinar el ancho de banda de la red por IOPS (carga estándar en servidores de bases de datos y servidores virtuales cargados), hay una

tabla indicativa de StariWindSoftware Configuración final

Configuración final :

- Software de almacenamiento, que puede no combinar discos en matrices RAID, sino transferirlos al almacenamiento en forma de discos separados (para que no haya problemas al reemplazar discos después de un cierto período de tiempo cuando fallan, simplemente selecciónelos por capacidad);

- Servidores de generación de procesadores e55xx-x56xx y superior, buses pci-express v 2.0 y superior, controladores Raid (HBA) 6G-12G con memoria, cestas de expansión para 6-16 discos;

- Interruptores SMB 10G Layer 2 (MARCO JUMBO, LACP).

Método de soluciónPor el momento, no se han encontrado opciones de presupuesto para un "almacenamiento de pequeña empresa empresarial" de un pequeño volumen con los requisitos anteriores.

Nos detuvimos en soluciones de software que le permiten aprovechar Enterprise Storage, con la opción de usar servidores existentes, que en este caso tienen derecho a morir de vejez sin comprometer el almacenamiento.

- Ceph: no hay suficientes especialistas en Linux;

- EMC ScaleIO, por un par de años de soporte técnico, puede sobrevivir con el personal existente.

- (como resultó, el conocimiento en Linux puede ser mínimo, más sobre eso más adelante en la hoja de trucos).

3. Historia del overclocking de IOPS (práctica presupuestaria)

Para acelerar las operaciones de lectura y escritura en los sistemas de almacenamiento, se utilizaron los siguientes dispositivos SSD:

3.1. Controladores con características de almacenamiento en caché SSD.

En 2010, aparecieron los controladores RAID con funciones de almacenamiento en caché Adaptec 5445 SSD con un disco

MaxIQ (para un resultado tangible, tenía que tener al menos el 10% del disco MaxIQ del volumen del volumen almacenado en caché), el resultado es insignificante * probado en uno mismo;

Más tarde, hubo controladores que pueden usar un disco SSD arbitrario para el almacenamiento en caché, tanto la serie Q de Adaptec como la

CacheCade LSI (pero las licencias están separadas allí);

3.2.

Almacenamiento en caché de software utilizando discos, como

Intel DC S3700 , que son vistos por el controlador y el expansor de los servidores de servidores HP, IBM, FUJI de marca (la mayoría de los servidores los reconocen con éxito, costosos para All-Flash, pero para el 10% en caché SSD es tolerable no liberarlos bajo socios de IBM, HP, FUJI y solo Intel). * Pero ahora hay opciones compatibles más baratas (ver párrafo 3.5.);

3.3. Se verifica el almacenamiento en caché del software utilizando el adaptador PCIe-M.2,

Synology M.2 M2D18 SSD , funciona en servidores normales (no solo en Synology), es útil cuando el controlador RAID y la cesta se niegan a ver los SSD que el fabricante no indicó en los compatibles (n HP D2700)? *;

3.4.

Unidades híbridas

Seagate EXOS 600Gb Seagate Exos 10E2400 (ST600MM0099) {SAS 12Gb / s, 10000rpm, 256Mb, 2.5 "}, * verificado reconocido por los servidores HP, IBM, FUJI (alternativa a las versiones 3.1.-3.3.);

3.5. Unidades SSD con un gran recurso y precio comparable con SAS de clase empresarial,

Crucial Micron 5200 MAX MTFDDAK480TDN-1AT1ZABYY, * verificado reconocido por los servidores HP, IBM, FUJI

(una alternativa para reemplazar discos HDD con aquellos compatibles con la cláusula 3.4 y con servidores SAS antiguos: SAS2.5 "600GB AL14SEB060N TOSHIBA * disco duro *,

C10K1800 0B31229 HGST, ST600MM0099 SEAGATE). Permite que un presupuesto cambie de HDD + SSD a volúmenes All-Flash.

4. Cheat sheet para la implementación y operación del almacenamiento EMC ScaleIO (VxFlexOS) 1 parte

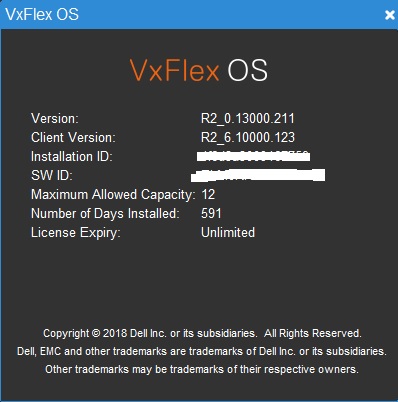

Almacenamiento EMC ScaleIO (VxFlexOS)Después de probar la solución antes de la compra, llegué a la conclusión de que para el funcionamiento normal del sistema se necesitan más de 3 nodos (la conmutación por error es inestable en 3), por ejemplo, tome una configuración de 8 servidores (sobrevivirá a la falla secuencial de 4 servidores sin perder volúmenes).

Pieza de hardware :

FUJI CX2550M1 (E5-2xxx) - 3 piezas (VmWare VSphere + ScaleIO servidor de virtualización del núcleo del clúster cliente SDC y servidor SDS);

+5 servidores de generación HP G6 (G7) o IBM M3 (e55xx-x56xx) - servidores ScaleIO SDS;

+ 2 conmutadores NetGear XS712T-100NES

Al ejecutar el almacenamiento en modo RFCache, pude overclockear a 44KIops usando Iometer

Configuración de almacenamiento:

Capacidad bruta de 12 TB (licencia mínima en el momento en que todavía se vendía como software)

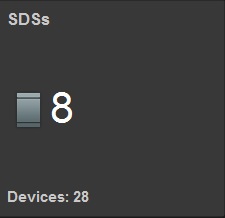

8 servidores SDS 28 unidades

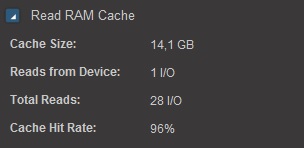

Leer RAM caché 14 Gb

Leer Flash Cashe 1.27 TB (RFCashe)

En la versión intermedia, donde solo 3 servidores de 2x10Gb tienen tarjetas de red, en los 2 x1Gb restantes.

Se ve claramente que incluso con el almacenamiento en caché SSD a 1 Gb en lugar de 10 Gb, hay una pérdida de ancho de banda SDS tres veces o más, con medios idénticos.

Sin almacenamiento en caché, si considera de acuerdo con estos

"estándares", entonces con 28 discos duros,

obtenemos 28X140 = 3920 IOPS, es decir para obtener 44,000 IOPS, necesitarías 11 veces más discos. Es económicamente más rentable para requisitos de pequeño volumen, no para aumentar el número de discos, sino para el caché SSD.

A la pregunta de por qué tales velocidades con un volumen pequeño, ¡responderé de inmediato!

Existen organizaciones tan pequeñas (como la nuestra) en las que hay una gran cantidad de documentos electrónicos que se procesan en el software durante mucho tiempo (cada registro controla el envío del software hasta 1 hora, incluso en este almacenamiento overclockeado). Todas las demás opciones ya se han aplicado anteriormente (aumento en RM-RAM, CPU i5, SSD, 1Gb-NET). Incluso el uso de solo paquetes SSD + SAS en el almacenamiento (sin ALL-Flash hasta ahora) permitió utilizar la mayoría de los recursos de los servidores de virtualización, transfiriendo máquinas virtuales cargadas a ScaleIO, duplicando la carga en los procesadores FUJI CX400M1 (anteriormente retenía el almacenamiento).