Estamos hablando de dos reglas que también comienzan a perder relevancia.

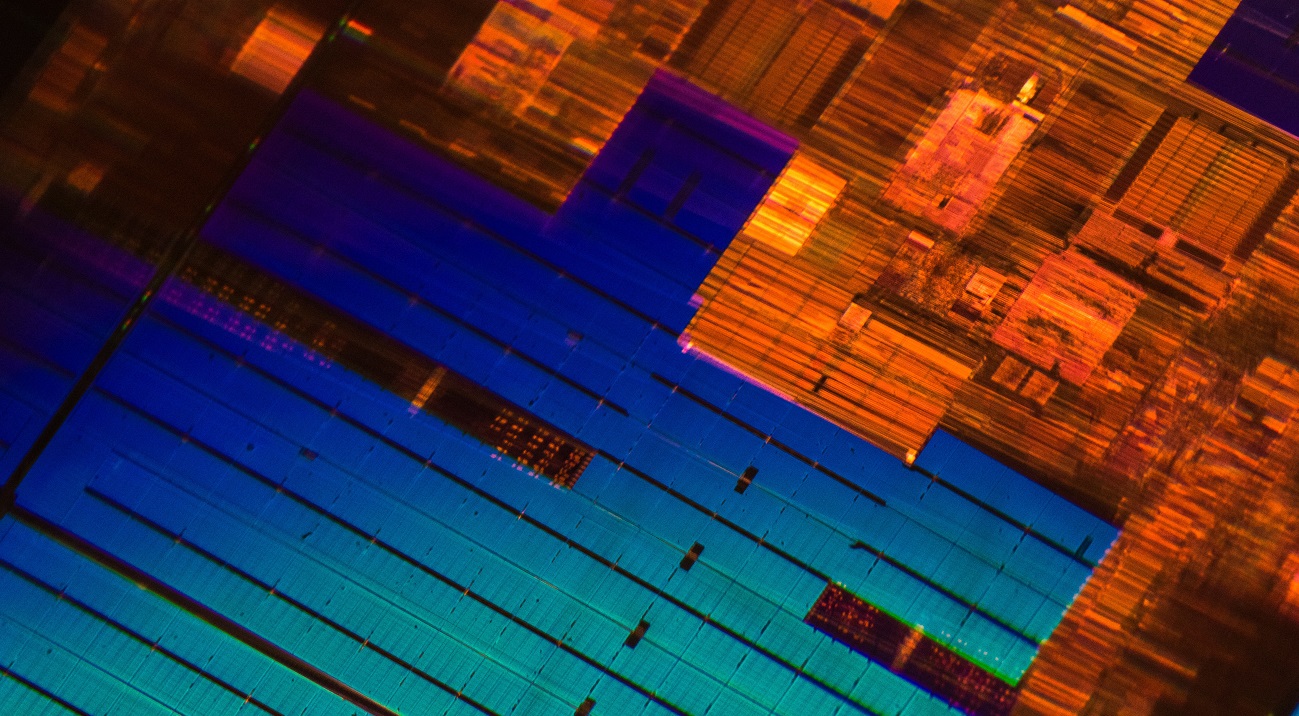

/ foto Laura Ockel Unsplash

/ foto Laura Ockel UnsplashLa Ley de Moore fue formulada hace más de cincuenta años. Durante todo este tiempo, en su mayor parte, se mantuvo justo. Incluso hoy, cuando se cambia de un proceso tecnológico a otro, la densidad de los transistores en un chip

aumenta aproximadamente dos veces . Pero hay un problema: la velocidad de desarrollo de nuevos procesos tecnológicos se está desacelerando.

Por ejemplo, Intel ha estado posponiendo la producción en masa de sus procesadores Ice Lake de 10 nanómetros durante mucho tiempo. Aunque el gigante de TI comenzará a enviar dispositivos el próximo mes, el anuncio de la arquitectura tuvo lugar hace unos

dos años y medio . También en agosto del año pasado, GlobalFoundries, un fabricante de circuitos integrados que trabajó con AMD,

dejó de desarrollar tecnología de proceso de 7 nm (

hablamos de las razones de esta decisión

en nuestro blog en Habr).

Periodistas y

ejecutivos de grandes compañías de TI han profetizado la muerte de la ley de Moore durante años. Incluso el mismo Gordon

declaró una vez que la regla que formuló dejaría de aplicarse. Sin embargo, la ley de Moore no es la única ley que pierde relevancia y sobre la cual los fabricantes de procesadores son iguales.

Ley de escala de Dennard

Fue formulado en 1974 por Robert Dennard, ingeniero y desarrollador de memoria dinámica DRAM, junto con colegas de IBM. La regla es la siguiente:

"Al reducir el tamaño del transistor y aumentar la velocidad del reloj del procesador, podemos aumentar fácilmente su rendimiento".

La regla de Dennard fijó la reducción en el ancho del conductor (tecnología de proceso) como el principal indicador de progreso en la industria de tecnología de microprocesador. Pero la ley de ampliación de Dennard dejó de aplicarse alrededor de 2006. El número de transistores en los chips continúa aumentando, pero este hecho

no da un aumento significativo en el rendimiento del dispositivo.

Por ejemplo, los representantes de TSMC (un fabricante de semiconductores) dicen que cambiar de tecnología de proceso de 7 nm a 5 nm

aumentará la velocidad del reloj del procesador en solo un 15%.

La razón de la desaceleración en el crecimiento de la frecuencia es la fuga de corrientes, que Dennard no tuvo en cuenta a fines de los años 70. Con una disminución en el tamaño del transistor y un aumento en la frecuencia, la corriente comienza a calentar el microcircuito más fuertemente, lo que puede dañarlo. Por lo tanto, los fabricantes tienen que equilibrar la potencia asignada por el procesador. Como resultado, desde 2006, la frecuencia de los chips de masa se ha establecido en alrededor de 4-5 GHz.

/ foto de Jason Leung Unsplash

/ foto de Jason Leung UnsplashHoy, los ingenieros están trabajando en nuevas tecnologías que resolverán el problema y aumentarán el rendimiento de los microchips. Por ejemplo, expertos de Australia están

desarrollando un transistor metal-aire, que tiene una frecuencia de varios cientos de gigahercios. El transistor consta de dos electrodos metálicos que actúan como drenaje y fuente y se encuentran a una distancia de 35 nm. Intercambian electrones entre sí debido al fenómeno de

emisión de

campo .

Según los desarrolladores, su dispositivo le permitirá dejar de "perseguir" la reducción de los procesos tecnológicos y concentrarse en la construcción de estructuras 3D de alto rendimiento con una gran cantidad de transistores en un chip.

Regla Kumi

Fue

formulado en 2011 por el profesor de Stanford Jonathan Koomey. Junto con colegas de Microsoft, Intel y la Universidad Carnegie Mellon,

analizó información sobre el consumo de energía de los sistemas informáticos a partir de la computadora ENIAC, construida en 1946. Como resultado, Kumi llegó a la siguiente conclusión:

"El volumen de cálculos por kilovatio de energía bajo carga estática se duplica cada año y medio".

Al mismo tiempo, señaló que el consumo de energía de las computadoras en los últimos años también ha aumentado.

En 2015, Kumi

volvió a su trabajo y complementó el estudio con nuevos datos. Descubrió que la tendencia que describió se había ralentizado. El rendimiento promedio de los chips por kilovatio de energía comenzó a duplicarse aproximadamente cada tres años. La tendencia ha cambiado debido a las dificultades asociadas con el enfriamiento de los chips (

página 4 ), ya que con la disminución del tamaño de los transistores se hace más difícil eliminar el calor.

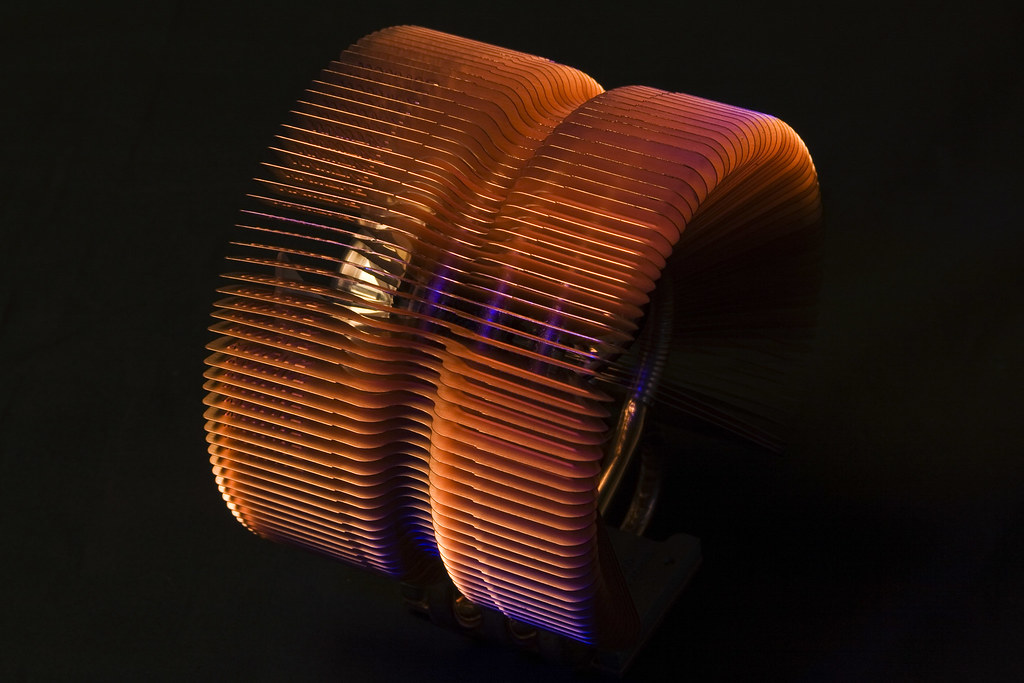

/ foto Derek Thomas CC BY-ND

/ foto Derek Thomas CC BY-NDAhora se están desarrollando nuevas tecnologías de enfriamiento de chips, pero no hay necesidad de hablar sobre su implementación masiva. Por ejemplo, los desarrolladores de una universidad de Nueva York sugirieron

utilizar la impresión láser 3D para aplicar una fina capa termoconductora de titanio, estaño y plata a un cristal. La conductividad térmica de dicho material es 7 veces mejor que la de otras interfaces térmicas (pasta térmica y polímeros).

A pesar de todos los factores,

según Kumi , el límite de energía teórico aún está muy lejos. Se refiere a un estudio realizado por el físico Richard Feynman, quien en 1985 señaló que el índice de eficiencia energética de los procesadores crecerá 100 mil millones de veces. En el momento de 2011, esta cifra aumentó solo 40 mil veces.

La industria de TI está acostumbrada al alto crecimiento de la potencia informática, por lo que los ingenieros están buscando formas de ampliar la ley de Moore y superar las dificultades dictadas por las reglas de Kumi y Dennard. En particular, las empresas y los institutos de investigación están buscando un reemplazo para la tecnología de transistores tradicionales y el silicio. Hablaremos sobre algunas de las posibles alternativas la próxima vez.

Sobre qué escribimos en un blog corporativo:

Nuestros informes con VMware EMPOWER 2019 en Habré: