Un estudio de 2009 realizado por How Much Information mostró que la cantidad de información consumida por semana ha aumentado 5 veces desde 1986. ¡De 250 mil palabras a la semana a 1.25 millones! Desde entonces, esta cifra ha aumentado significativamente. Los siguientes son indicadores asombrosos: en 2018, el número de usuarios de Internet y redes sociales es de 4.021 mil millones y 3.196 mil millones.Una persona moderna analiza una cantidad increíble de información por día, utilizando diversos esquemas y estrategias para procesarla, para tomar decisiones rentables. La especie humana ha generado el 90% de la información en este mundo en los últimos dos años. Ahora, si completa, producimos alrededor de 2.5 quintillones de bytes (2.5 * 10 ^ 18 bytes) de información nueva por día. Si divide este número por el número de personas que viven ahora, resulta que en promedio una persona crea 0.3 gigabytes de información por día.

¿Cuánta información toma el Homo sapiens? (en adelante denominado Homo). Por simplicidad en informática, acuñaron un término llamado bit. El bit es la unidad de información más pequeña. Un archivo con este trabajo toma varios kilobytes. Tal documento hace cincuenta años ocuparía toda la memoria de la computadora más poderosa. El libro promedio en forma digital ocupa mil veces más espacio y esto es megabytes. Una foto de alta calidad en una cámara potente es de 20 megabytes. Una unidad digital es 40 veces más grande. Las proporciones interesantes comienzan con gigabytes. ADN humano, toda la información sobre usted y yo es de aproximadamente 1,5 gigabytes. Multiplicamos esto por siete mil millones y obtenemos 1.05x10 ^ 19 bytes. En general, podemos producir tal volumen de información en condiciones modernas en 10 días. Este número de bits describirá a todas las personas que viven ahora.

Y estos son solo datos sobre las personas mismas, sin interacciones entre ellos, sin interacciones con la naturaleza y la cultura, que una persona creó para sí misma. ¿Cuánto aumentará esta cifra si sumamos las variables e incertidumbres del futuro? Caos sería una buena palabra.

La información tiene una propiedad increíble. Incluso cuando ella no está allí, ella está. Y aquí necesitamos un ejemplo. La biología conductual tiene un famoso experimento. Enfrente hay dos celdas. En el 1er mono de alto rango. Alfa macho En la segunda jaula, un mono con un estado inferior, un macho beta. Ambos monos pueden ver a sus homólogos. Agregue un factor de influencia al experimento. Entre dos celdas ponemos un plátano. Un macho beta no se atreverá a tomar un plátano si sabe que el macho alfa también lo vio. Porque inmediatamente siente toda la agresión del macho alfa. Además, las condiciones iniciales del experimento están ligeramente alteradas. Una célula macho alfa está cubierta con una tela opaca para privarlo de una vista. Repitiendo todo lo que se hizo antes, la imagen se vuelve completamente diferente. El macho beta aparece y toma un plátano sin ningún remordimiento.

Se trata de su capacidad de análisis, él sabe que el macho alfa no vio cómo poner un plátano y para él simplemente no existe. El macho beta analizó el hecho de que no había señal sobre la aparición de información sobre el plátano en el macho alfa y aprovechó la situación. En muchos casos, se hace un diagnóstico específico a un paciente cuando tiene ciertos síntomas, pero una gran cantidad de enfermedades, virus y bacterias pueden incluso confundir a un médico experimentado, ¿cómo puede determinar un diagnóstico preciso sin perder tiempo, lo que puede ser vital para el paciente? Todo es simple Analiza no solo los síntomas que tiene el paciente, sino también los que no tiene, lo que reduce el tiempo de búsqueda en decenas de veces. Si algo no da esta o aquella señal, también lleva cierta información, generalmente de naturaleza negativa, pero no siempre. Analice no solo las señales de información que existen, sino también las que no.

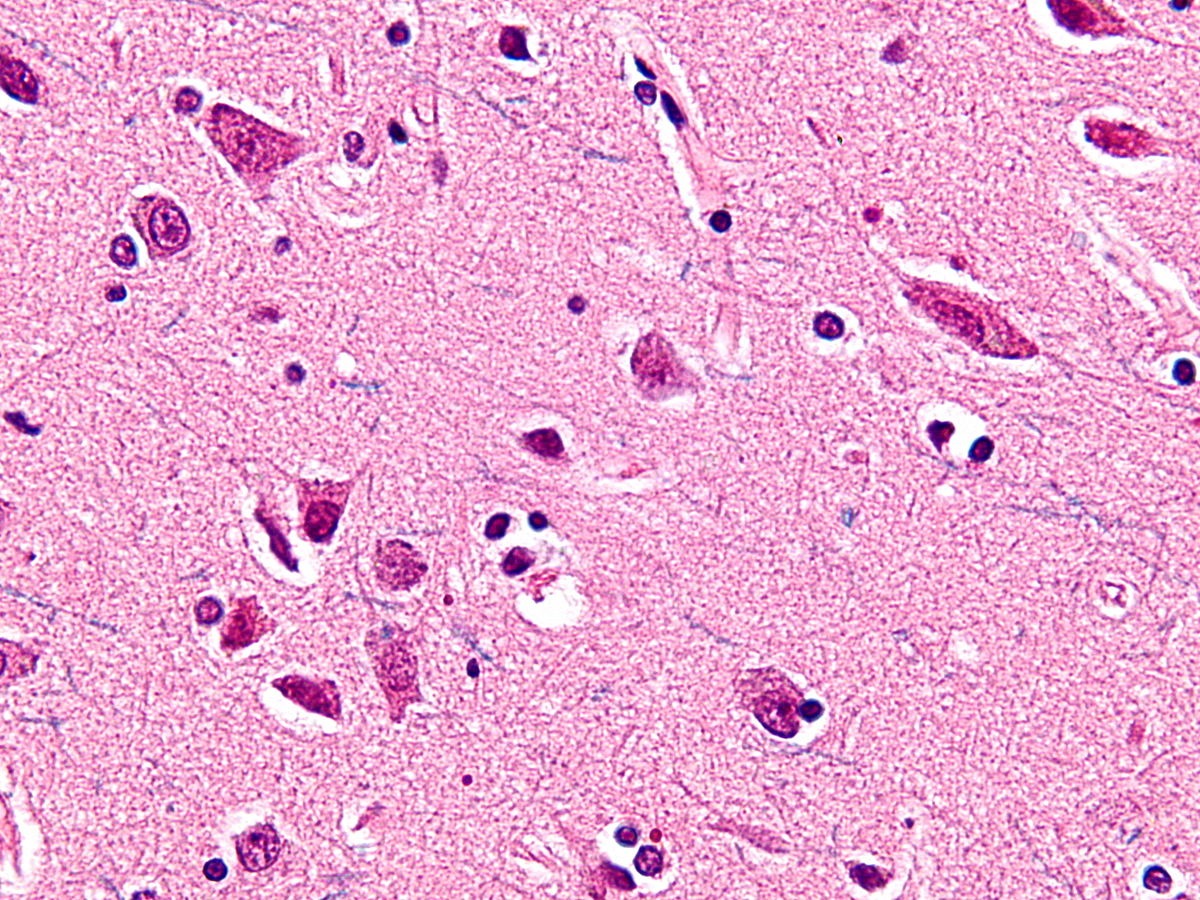

Estos ejemplos agregan ceros y unos a los números anteriores. En relación con las cifras y problemas anteriores, surgen una serie de preguntas. Como? ¿Cómo lograste lograr esto? ¿Es el cuerpo / sociedad capaz de funcionar normalmente en tales condiciones? Cómo afecta la información a los sistemas biológicos, económicos y de otro tipo. La cantidad de información que percibimos en 2019 parecerá escasa para la posteridad a partir de 2050. La vista ya está creando nuevos esquemas y patrones de trabajo con información, estudiando sus propiedades e impacto. Frase: "" He vivido un millón de años en un año "ya no son bromas y no son absurdas, sino realidad. La cantidad de información que crea una persona afecta la vida social, económica, cultural e incluso biológica. En 1980, soñaban con crear una computadora cuántica para aumentar la potencia informática. Sueña con una vista. Los descubrimientos que prometieron este invento fueron anticipar una nueva era. En 2018, IBM lanzó la primera computadora cuántica comercial, pero nadie se dio cuenta. La noticia fue discutida por un número increíblemente pequeño de personas. Ella simplemente se ahogó en la abundancia de información en la que ahora existimos. El área principal de investigación en los últimos años se ha convertido en neurociencia, algoritmos, modelos matemáticos, inteligencia artificial, lo que generalmente indica la búsqueda de la posibilidad de un funcionamiento normal en un entorno enriquecido con información. En 1929, se descubrieron las neuronas von Economo, que se encuentran solo en grupos de animales altamente sociales. Existe una correlación directa entre el tamaño del grupo y el tamaño del cerebro, cuanto mayor es el grupo de animales, mayor es el tamaño de su cerebro en relación con el cuerpo. No es sorprendente que las neuronas von Economo se encuentren solo en cetáceos, elefantes y primates. Las neuronas de Von Economo son responsables de transmitir grandes cantidades de información en el cerebro.

mientras que A.G. Lukashenko no les prohibió comunicarse, míralos

mientras que A.G. Lukashenko no les prohibió comunicarse, míralosEste tipo de neurona es una adaptación neuronal en cerebros muy grandes, lo que le permite procesar y transmitir rápidamente información sobre proyecciones muy específicas, que ha evolucionado en relación con nuevos comportamientos sociales. La presencia aparente de estas neuronas especializadas solo en mamíferos altamente inteligentes puede ser un ejemplo de evolución convergente. La nueva información siempre genera nuevos patrones y relaciones cualitativamente diferentes. Los patrones se establecen solo sobre la base de la información. Ejemplo, un primate golpea una piedra en el hueso de un búfalo muerto. Un golpe y el hueso se rompe en dos partes. Un golpe más y un descanso más. El tercer golpe y algunos fragmentos más. El patrón es claro. Un golpe de hueso y al menos una nueva astilla. ¿Son los primates buenos para reconocer patrones? Muchas relaciones sexuales y parto retrasado después de nueve meses.

¿Cuánto tiempo llevó conectar estos dos eventos? Durante mucho tiempo, el parto no estuvo asociado en absoluto con actos sexuales entre un hombre y una mujer. En la mayoría de las culturas y religiones, los dioses fueron responsables del nacimiento de una nueva vida. La fecha exacta para el descubrimiento de este patrón, lamentablemente, aún no se ha establecido. Sin embargo, vale la pena señalar que todavía hay sociedades cerradas de cazadores-recolectores que no vinculan estos procesos, y para el nacimiento en ellos hay rituales especiales realizados por el chamán. La principal causa de mortalidad infantil en el parto antes de 1920 fueron las manos sucias. Las manos limpias y un niño vivo también son un ejemplo de una regularidad no obvia. Aquí hay otro ejemplo de un patrón que permaneció implícito hasta 1930. De que estas hablando Sobre los grupos sanguíneos. En 1930, Landsteiner recibió el Premio Nobel por este descubrimiento. Hasta este momento, el conocimiento de que una persona puede ser transfundida con un grupo sanguíneo que empareja al donante con el necesitado no estaba claro. Hay miles de ejemplos similares. Vale la pena señalar que la búsqueda de patrones es lo que la especie hace todo el tiempo. Un hombre de negocios que encuentra un patrón en el comportamiento o las necesidades de las personas, y luego gana en este patrón durante muchos años. Investigación científica seria que permita predecir el cambio climático, la migración humana, encontrar lugares para la minería, cometas cíclicos, el desarrollo del embrión, la evolución de los virus y, como la punta, el comportamiento de las neuronas en el cerebro. Por supuesto, todo puede explicarse por la estructura del universo en el que vivimos y la segunda ley de la termodinámica de que la entropía aumenta constantemente, pero este nivel no es adecuado para fines prácticos. Deberías elegir más cerca de la vida. El nivel de biología e informática.

¿Qué es la información? Según las creencias populares, la información es información independientemente de la forma de su presentación o la solución al problema de la incertidumbre. En física, la información es una medida del orden de un sistema. En teoría de la información, la definición de este término es la siguiente: la información son datos, bits, hechos o conceptos, un conjunto de valores. Todos estos conceptos son vagos e inexactos; además, creo que están un poco equivocados.

Para probar esto, presentamos la tesis: la información en sí misma no tiene sentido. ¿Cuál es el número "3"? ¿O cuál es la letra "A"? Un símbolo sin un valor asignado. Pero, ¿cuál es el número "3" en el gráfico del grupo sanguíneo? Este es el significado que salvará una vida. Ya afecta la estrategia de comportamiento. Un ejemplo llevado al punto del absurdo, pero sin perder su significado. Douglas Adams escribió La Guía del autoestopista galáctico. En este libro, se suponía que la computadora cuántica creada debía responder a la pregunta principal de la vida y el universo. ¿Cuál es el significado de la vida y el universo? La respuesta se recibió después de siete millones y medio de años de computación continua. La computadora concluyó comprobando repetidamente el valor de la corrección que la respuesta era "42". Los ejemplos anteriores dejan en claro que la información sin el entorno externo en el que se encuentra (contexto) no significa nada. El número "2" puede significar el número de unidades monetarias, pacientes con ébola, niños felices o ser un indicador de la erudición de una persona en algún asunto. Para más pruebas, pasemos al mundo de la biología: las hojas de las plantas a menudo tienen la forma de un semicírculo y al principio se elevan hacia arriba, se expanden, pero después de cierto punto de refracción, se estiran hacia abajo y se estrechan. En el ADN, como en los principales portadores de información o valores, no existe un gen que codifique su atracción descendente después de cierto punto. El hecho de que la hoja de la planta se estire es un truco de gravedad.

El ADN mismo, el de las plantas, el de los mamíferos, el del Homo Sapiens ya mencionado, lleva poca información, si es que la tiene. El ADN es un conjunto de significados en un entorno particular. El ADN lleva principalmente factores de transcripción, algo que debe ser activado por un determinado entorno externo. Coloque el ADN de la planta / humano en un entorno con una atmósfera o gravedad diferente, y la salida será un producto diferente. Por lo tanto, transferir nuestro ADN con fines de investigación a formas de vida extraterrestres es una ocupación bastante estúpida. Es posible, en medio de ellos, que el ADN humano se convierta en algo más aterrador que un primate erecto bípedo con un pulgar sobresaliente e ideas sobre la igualdad. La información es valores / datos / bits / materia en cualquier forma y en conexión continua con el entorno, el sistema o el contexto. La información no existe sin factores ambientales, sistemas o contextos. Solo inextricablemente vinculado a estas condiciones, la información puede transmitir significados. En el lenguaje de las matemáticas o la biología, la información no existe sin un entorno externo o sistemas cuyas variables afecta. La información es siempre un apéndice de las circunstancias en las que se mueve. Este artículo discutirá las ideas principales de la teoría de la información. Actas de la actividad intelectual de Claude Shannon, Richard Feynman.

Una característica distintiva de la especie es la capacidad de crear abstracciones y crear patrones. Representar algunos fenómenos a través de otros. Estamos codificando Los fotones en la retina crean imágenes, las vibraciones del aire se convierten en sonidos. Asociamos un cierto sonido con una determinada imagen. El elemento químico en el aire, con sus receptores en la nariz, lo interpretamos como un olor. A través de dibujos, imágenes, jeroglíficos y sonidos, podemos conectar eventos y transmitir información.

entonces él realmente codifica tu realidad

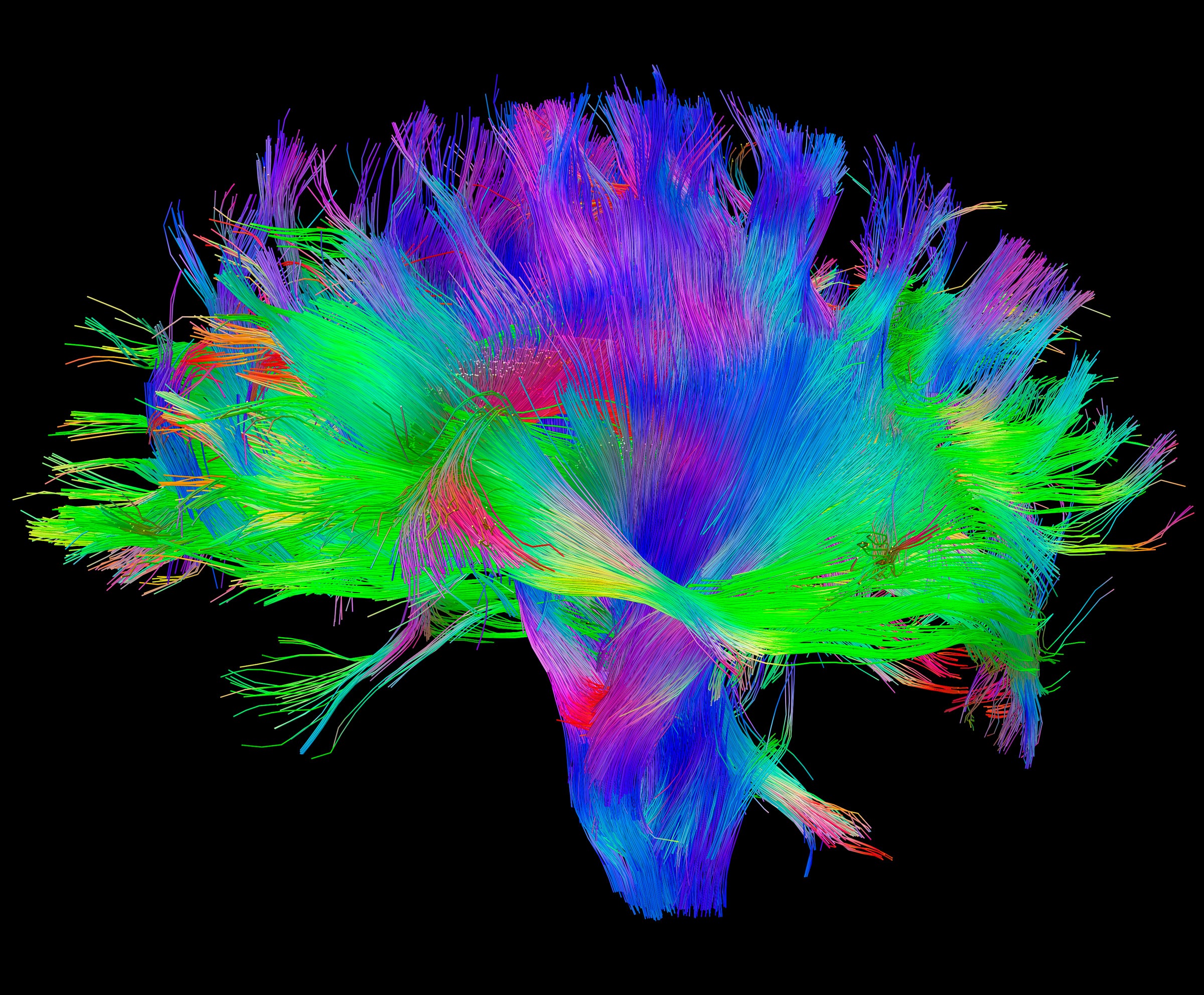

entonces él realmente codifica tu realidadTales codificaciones y abstracciones no deben subestimarse, solo recuerde cuánto afecta a las personas. Las codificaciones pueden prevalecer sobre los programas biológicos, una persona en aras de una idea (una imagen en su cabeza que define una estrategia de comportamiento) se niega a transferir copias de sus genes. O recuerde todo el poder de las fórmulas físicas que nos permitieron enviar un representante de una especie al espacio. Ecuaciones químicas que ayudan a tratar a las personas, etc. Además, podemos codificar lo que ya está codificado. El ejemplo más simple es una traducción de un idioma a otro. Un código se presenta en forma de otro. La facilidad de transformación, como factor principal en el éxito de este proceso, le permite hacerlo interminable. Puede traducir la expresión del japonés al ruso, del ruso al español, del español al sistema binario, del código Morse, luego presentarla en Braille, luego en forma de código de computadora, y luego ponerla directamente en el cerebro en forma de pulsos eléctricos. donde decodifica el mensaje. Recientemente hicieron el proceso inverso y decodificaron la actividad cerebral en el habla.

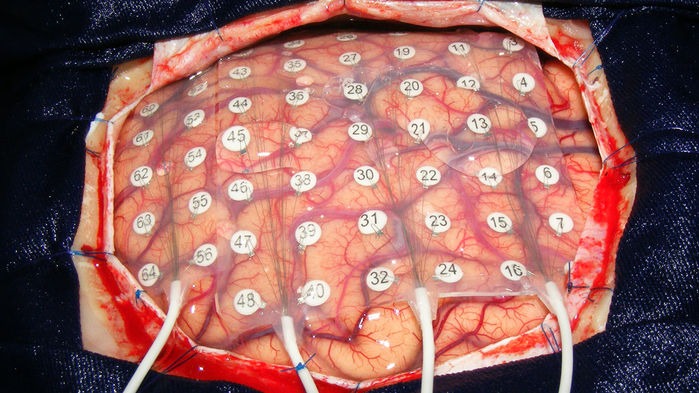

poner electrodos en la imagen de arriba y considerar toda su singularidad

poner electrodos en la imagen de arriba y considerar toda su singularidadEn el período de cuarenta a veinte mil años atrás, las personas primitivas comenzaron a codificar activamente la información en forma de códigos de habla o gestos, pinturas rupestres. La gente moderna, observando las primeras pinturas rupestres, trata de determinar (decodificar) su significado, la búsqueda de significados es otra característica distintiva de la especie. Al reconstruir el contexto de ciertos marcadores o restos de información, los antropólogos modernos están tratando de comprender la vida de las personas primitivas. La quintaesencia del proceso de codificación se materializa en forma de escritura. Al escribir, resolvió el problema de la pérdida de información durante su transmisión no solo en el espacio sino también en el tiempo. Los jeroglíficos de números le permiten codificar cálculos, palabras, objetos, etc. Sin embargo, si el problema se resuelve con mayor precisión y precisión, si, por supuesto, ambos participantes en el proceso de comunicación utilizan los mismos acuerdos condicionales en la interpretación y decodificación de los mismos caracteres (jeroglíficos), la escritura impresa ha fallado con el tiempo y la velocidad de transmisión. Para resolver el problema de la velocidad, se inventaron sistemas de radio y telecomunicaciones. La etapa clave en el desarrollo de la transferencia de información puede considerarse dos ideas. El primero es canales de comunicación digital, y el segundo es el desarrollo del aparato matemático. Los canales de comunicación digital resolvieron el problema en la velocidad de transferencia de información y el aparato matemático en su precisión.

Cualquier canal tiene un cierto nivel de ruido e interferencia, debido a que la información viene con interferencia (un conjunto de valores y caracteres están distorsionados, el contexto se pierde) o no aparece en absoluto. Con el desarrollo de la tecnología, la cantidad de ruido en los canales de comunicación digital disminuyó, pero nunca se redujo a cero. A medida que aumentaba la distancia, generalmente aumentaba. El problema clave que debe resolverse al perder información en los canales de comunicación digital fue

identificado y resuelto por Claude Shannon en 1948, y también acuñó el término bit. Suena como sigue: - “Deje que la fuente del mensaje tenga entropía (H) durante un segundo, y (C) el ancho de banda del canal. Si H <C o H = C, entonces tal codificación de información es posible en la que los datos de origen se transmitirán a través del canal con un número arbitrariamente pequeño de errores ".

pero no te llamaron para jugar este juego

pero no te llamaron para jugar este juegoEsta formulación del problema es la razón del rápido desarrollo de la teoría de la información. Los principales problemas que resuelve e intenta resolver son que los canales digitales, como se mencionó anteriormente, tienen ruido. O lo formulamos de la siguiente manera: "no hay una fiabilidad absoluta del canal en la transmisión de información". Es decir la información puede perderse, distorsionarse, llenarse de errores debido a las influencias ambientales en el canal de transmisión de información. Claude Shannon, presentó una serie de tesis, de las cuales se deduce que la capacidad de transmitir información sin pérdida y cambios en ella, es decir con absoluta precisión, existe en la mayoría de los canales con ruido. De hecho, permitió que el Homo Sapiens no gastara esfuerzos en mejorar los canales de comunicación. En cambio, propuso el desarrollo de esquemas de codificación y decodificación más eficientes para la información. Presente la información en forma de 0 y 1. La idea se puede ampliar a abstracciones matemáticas o codificación de lenguaje. Demostrar la efectividad de la idea puede ser un ejemplo. El científico observa el comportamiento de los quarks en el colisionador de hadrones, ingresa sus datos en una tabla y los analiza, muestra la regularidad en forma de fórmulas, formula las principales tendencias en forma de ecuaciones o escribe en forma de modelos matemáticos, factores que afectan el comportamiento de los quarks. Necesita transferir estos datos sin pérdida. Se enfrenta a una serie de preguntas. ¿Usar o transmitir un canal de comunicación digital a través de su asistente o llamar y contar todo personalmente? El tiempo es críticamente corto y la información debe transmitirse urgentemente, por lo que se elimina el correo electrónico. El ayudante es un canal de comunicación absolutamente poco confiable con una probabilidad de ruido cercana al infinito.

Como canal de comunicación, elige llamar.? , . ? , . , , , , , . , , , . . , , , , , , . , . , . , , . () , . , , . -, , , , , , — .

Los problemas de precisión de transmisión, distancia, tiempo y el proceso de codificación se resolvieron en un grado u otro, y esto nos permitió crear información muchas veces más de lo que una persona puede percibir, encontrar patrones que pasarán desapercibidos durante mucho tiempo. Hay una serie de otros problemas. ¿Dónde almacenar tal volumen de información? ¿Cómo almacenar? La codificación moderna y el aparato matemático, como se vio después, no resuelve completamente los problemas de almacenamiento. Hay un límite para el acortamiento de la información y un límite para su codificación, después de lo cual no es posible decodificar los valores. Como ya se mencionó anteriormente, un conjunto de valores sin contexto o entorno externo, ya no lleva información. Sin embargo, es posible codificar por separado información sobre el entorno externo y el conjunto de valores, y luego combinarlos en forma de ciertos índices y decodificar los mismos índices.sin embargo, los valores originales sobre el conjunto de valores y el entorno externo aún deben almacenarse en algún lugar. Se propusieron ideas maravillosas, que ahora se están utilizando en todas partes, pero serán consideradas en otro artículo.Mirando hacia el futuro, podemos dar un ejemplo del hecho de que no es necesario describir todo el entorno externo, solo podemos formular las condiciones para su existencia en forma de leyes y fórmulas. ¿Qué es la ciencia? La ciencia es el más alto grado de mimetismo sobre la naturaleza. Los logros científicos son una encarnación abstracta de los fenómenos de la vida real. Una de las soluciones al problema del almacenamiento de información se describió en un encantador artículo de Richard Feynman "Hay mucho espacio a continuación: una invitación a un nuevo mundo de la física". Este artículo a menudo se considera el trabajo que sentó las bases para el desarrollo de la nanotecnología. En él, el físico sugiere prestar atención a las características sorprendentes de los sistemas biológicos, como depósitos de información. En los sistemas en miniatura y pequeños, se contiene una cantidad increíblemente grande de datos sobre el comportamiento: la forma en que almacenan y usan la información no puede causar más que admiración. Si hablamos sobre la cantidad de sistemas biológicos que pueden almacenar información, la revista Nature estimó que toda la información, valores, datos y patrones del mundo pueden escribirse en un almacenamiento de ADN que pese hasta un kilogramo. Esa es toda la contribución al universo, un kilogramo de materia. El ADN es una estructura extremadamente eficiente para el almacenamiento de información, que le permite almacenar y usar conjuntos de valores en grandes volúmenes. Si alguien está interesado, entonces aquíun artículo que explica cómo grabar fotografías de gatos y, en general, cualquier información en un repositorio de ADN, incluso canciones de Scriptonite (uso extremadamente estúpido de ADN). Codifica que escuches basuraFeynman llama la atención sobre cuánta información está codificada en los sistemas biológicos, que en el proceso de existencia, no solo codifican información, sino que también cambian la estructura de la materia en base a esto. Si hasta este punto todas las ideas propuestas se basaban solo en la codificación de un conjunto de valores o información, como tal, entonces, después de este artículo, la pregunta ya estaba en la codificación del entorno externo dentro de las moléculas individuales. Codifique y modifique la materia a nivel atómico, incluya información en ellos, etc. Por ejemplo, sugiere crear cables de conexión con un diámetro de varios átomos. Esto, a su vez, aumentará la cantidad de componentes de la computadora en un factor de millones, y tal aumento en los elementos mejorará cualitativamente la potencia informática de las futuras máquinas inteligentes. Feynman, como creador de la electrodinámica cuántica y el hombre,quienes participaron en el desarrollo de la bomba atómica, entendieron perfectamente que la codificación de la materia no es algo fantástico, sino que parece ser un proceso normal en la realidad observada.Él enfatiza que la física no prohíbe la creación de objetos átomo por átomo. En el artículo, recurre a comparar las actividades del hombre y la máquina, prestando atención al hecho de que cualquier representante de la especie puede reconocer fácilmente los rostros de las personas, a diferencia de las computadoras, para lo cual en ese momento era una tarea fuera del poder de la computación. Él hace una serie de preguntas importantes de "¿qué impide la creación de una copia ultra pequeña de algo?" A “¿la diferencia entre las computadoras y el cerebro humano solo en la cantidad de elementos constituyentes?”, también describe los mecanismos y los principales problemas para crear algo de tamaño atómico.Los contemporáneos estimaron el número de neuronas cerebrales en aproximadamente 86 mil millones, naturalmente, ni una sola computadora, entonces y ahora, se acercó a este valor, ya que resultó que esto no era necesario. Sin embargo, el trabajo de Richard Feynman comenzó a mover la idea de información hacia abajo, donde hay mucho espacio. El artículo fue publicado en 1960, después de la aparición del trabajo de Alan Turing "Computers and Mind" de una de las obras más citadas de este tipo. Por lo tanto, una comparación de las actividades humanas y las computadoras fue una tendencia que se reflejó en el artículo de Richard Feynman.Gracias a la contribución directa del físico, el costo de almacenar datos está disminuyendo cada año, las tecnologías en la nube se están desarrollando a un ritmo vertiginoso, se ha creado una computadora cuántica, estamos escribiendo datos en almacenamientos de ADN y haciendo ingeniería genética, lo que una vez más demuestra que la materia puede cambiarse y codificarse. El próximo artículo hablará sobre el caos, la entropía, las computadoras cuánticas, las arañas, las hormigas, los modelos ocultos de Markov y la teoría de categorías. Habrá más matemáticas, punk rock y ADN. Continúa aquí en este artículo .

Codifica que escuches basuraFeynman llama la atención sobre cuánta información está codificada en los sistemas biológicos, que en el proceso de existencia, no solo codifican información, sino que también cambian la estructura de la materia en base a esto. Si hasta este punto todas las ideas propuestas se basaban solo en la codificación de un conjunto de valores o información, como tal, entonces, después de este artículo, la pregunta ya estaba en la codificación del entorno externo dentro de las moléculas individuales. Codifique y modifique la materia a nivel atómico, incluya información en ellos, etc. Por ejemplo, sugiere crear cables de conexión con un diámetro de varios átomos. Esto, a su vez, aumentará la cantidad de componentes de la computadora en un factor de millones, y tal aumento en los elementos mejorará cualitativamente la potencia informática de las futuras máquinas inteligentes. Feynman, como creador de la electrodinámica cuántica y el hombre,quienes participaron en el desarrollo de la bomba atómica, entendieron perfectamente que la codificación de la materia no es algo fantástico, sino que parece ser un proceso normal en la realidad observada.Él enfatiza que la física no prohíbe la creación de objetos átomo por átomo. En el artículo, recurre a comparar las actividades del hombre y la máquina, prestando atención al hecho de que cualquier representante de la especie puede reconocer fácilmente los rostros de las personas, a diferencia de las computadoras, para lo cual en ese momento era una tarea fuera del poder de la computación. Él hace una serie de preguntas importantes de "¿qué impide la creación de una copia ultra pequeña de algo?" A “¿la diferencia entre las computadoras y el cerebro humano solo en la cantidad de elementos constituyentes?”, también describe los mecanismos y los principales problemas para crear algo de tamaño atómico.Los contemporáneos estimaron el número de neuronas cerebrales en aproximadamente 86 mil millones, naturalmente, ni una sola computadora, entonces y ahora, se acercó a este valor, ya que resultó que esto no era necesario. Sin embargo, el trabajo de Richard Feynman comenzó a mover la idea de información hacia abajo, donde hay mucho espacio. El artículo fue publicado en 1960, después de la aparición del trabajo de Alan Turing "Computers and Mind" de una de las obras más citadas de este tipo. Por lo tanto, una comparación de las actividades humanas y las computadoras fue una tendencia que se reflejó en el artículo de Richard Feynman.Gracias a la contribución directa del físico, el costo de almacenar datos está disminuyendo cada año, las tecnologías en la nube se están desarrollando a un ritmo vertiginoso, se ha creado una computadora cuántica, estamos escribiendo datos en almacenamientos de ADN y haciendo ingeniería genética, lo que una vez más demuestra que la materia puede cambiarse y codificarse. El próximo artículo hablará sobre el caos, la entropía, las computadoras cuánticas, las arañas, las hormigas, los modelos ocultos de Markov y la teoría de categorías. Habrá más matemáticas, punk rock y ADN. Continúa aquí en este artículo .