El término Big Data está estropeado por la fantástica exageración moderna de cosas nuevas. A medida que la IA esclaviza a las personas y la cadena de bloques construye una economía ideal, los grandes datos le permitirán saber absolutamente todo sobre todos y ver el futuro.

Pero la realidad, como siempre, es más aburrida y pragmática. No hay magia en los grandes datos, ya que no hay ningún lugar, simplemente hay tanta información y conexiones entre los diferentes datos que lleva demasiado tiempo procesar y analizar todo de la manera antigua.

Están surgiendo nuevos métodos. Nuevas profesiones están con ellos. El decano

del departamento de análisis de Big Data en GeekBrains, Sergey Shirkin, dijo qué tipo de profesión son, dónde se necesitan, qué deben hacer y qué deben poder hacer. Qué herramientas se usan y cuánto pagan generalmente a los especialistas.

¿Qué es el Big Data?

La pregunta "qué llamar big data" es bastante confusa. Incluso en revistas científicas, las descripciones difieren. En algún lugar, millones de observaciones se consideran datos "ordinarios", y en otro lugar cientos de miles se denominan grandes, porque cada una de las observaciones tiene mil signos. Por lo tanto, decidieron dividir condicionalmente los datos en tres partes: pequeña, mediana y grande, de acuerdo con el principio más simple: el volumen que ocupan.

Los datos pequeños son unos pocos gigabytes. Medio: todo sobre un terabyte. Big data es sobre un petabyte. Pero esto no eliminó la confusión. Por lo tanto, el criterio es aún más simple: todo lo que no cabe en el mismo servidor es big data.

Los datos pequeños, medianos y grandes tienen diferentes principios operativos. Los grandes datos generalmente se almacenan en un clúster en varios servidores a la vez. Debido a esto, incluso las acciones simples son más complicadas.

Por ejemplo, una tarea simple es encontrar el valor promedio de una cantidad. Si se trata de datos pequeños, simplemente sumamos y dividimos por la cantidad. Y en big data no podemos recopilar toda la información de todos los servidores a la vez. Esto es complicado A menudo, no necesita obtener datos para usted, sino enviar un programa separado a cada servidor. Después del trabajo de estos programas, se forman resultados intermedios y el valor promedio es determinado por ellos.

Sergey Shirkin

Sergey Shirkin¿Qué empresas de big data

El primero con big data comenzó a funcionar operadores móviles y motores de búsqueda. Los motores de búsqueda se volvieron más y más consultas, y el texto es más pesado que los números. Trabajar con un párrafo de texto lleva más tiempo que con una transacción financiera. El usuario espera que el motor de búsqueda complete la solicitud en una fracción de segundo; es inaceptable que funcione incluso durante medio minuto. Por lo tanto, los motores de búsqueda comenzaron a trabajar en paralelo cuando trabajaban con datos.

Un poco más tarde, se unieron varias organizaciones financieras y minoristas. Las transacciones en sí mismas no son tan voluminosas, pero aparecen grandes datos debido al hecho de que hay muchas transacciones.

La cantidad de datos está creciendo en absoluto. Por ejemplo, los bancos tenían muchos datos antes, pero no siempre requerían principios de trabajo, como con los grandes. Luego, los bancos comenzaron a trabajar más con los datos del cliente. Comenzaron a presentar depósitos, préstamos y tarifas más flexibles, y comenzaron a analizar las transacciones más de cerca. Esto ya requería formas rápidas de trabajar.

Ahora los bancos quieren analizar no solo la información interna, sino también la información externa. Quieren recibir datos del mismo minorista, quieren saber en qué gasta dinero una persona. En base a esta información, están tratando de hacer ofertas comerciales.

Ahora toda la información está conectada entre sí. Venta minorista, bancos, operadores de telecomunicaciones e incluso motores de búsqueda: ahora todos están interesados en los datos de los demás.

Lo que debería ser un especialista en Big Data

Dado que los datos se encuentran en un clúster de servidores, se utiliza una infraestructura más compleja para trabajar con ellos. Esto supone una gran carga para la persona que trabaja con ella: el sistema debe ser muy confiable.

Hacer que un servidor sea confiable es fácil. Pero cuando hay varios de ellos, la probabilidad de caída aumenta en proporción al número, y la responsabilidad del ingeniero de datos que trabaja con estos datos también aumenta.

El analista debe comprender que siempre puede recibir datos incompletos o incluso incorrectos. Escribió el programa, confió en sus resultados y luego descubrió que debido a la caída de un servidor de un millar, parte de los datos se desconectó y todas las conclusiones eran incorrectas.

Tome, por ejemplo, una búsqueda de texto. Digamos que todas las palabras están ordenadas en orden alfabético en varios servidores (si hablamos de manera muy simple y condicional). Y uno de ellos desconectado, todas las palabras en la letra "K" desaparecieron. La búsqueda dejó de dar la palabra "Cine". Todas las noticias desaparecen, y el analista llega a una falsa conclusión de que la gente ya no está interesada en los cines.

Por lo tanto, un especialista en big data debe conocer los principios del trabajo desde los niveles más bajos (servidores, ecosistemas, planificadores de tareas) hasta los programas de más alto nivel: bibliotecas de aprendizaje automático, análisis estadístico y más. Debe comprender los principios del hierro, los equipos informáticos y todo lo que está configurado encima.

Por lo demás, debe saber todo lo mismo que cuando trabaja con datos pequeños. Necesita matemáticas, debe ser capaz de programar, y especialmente es bueno conocer los algoritmos informáticos distribuidos, para poder aplicarlos a los principios habituales de trabajo con datos y aprendizaje automático.

¿Qué herramientas se usan?

Dado que los datos se almacenan en el clúster, se necesita una infraestructura especial para trabajar con ellos. El ecosistema más popular es Hadoop. En él pueden funcionar muchos sistemas diferentes: bibliotecas especiales, planificadores, herramientas para el aprendizaje automático y mucho más. Pero antes que nada, este sistema es necesario para hacer frente a grandes cantidades de datos debido a la informática distribuida.

Por ejemplo, estamos buscando el tweet más popular entre los datos rotos en mil servidores. En un servidor, simplemente haríamos una tabla y eso es todo. Aquí podemos arrastrar todos los datos a nosotros mismos y volver a contar. Pero esto no está bien, porque durante mucho tiempo.

Por lo tanto, hay un paradigma Hadoop con Map Reduce y el marco Spark. En lugar de extraer datos para sí mismos, envían secciones del programa a estos datos. El trabajo va en paralelo, en mil hilos. Luego obtenemos una selección de miles de servidores en función de los cuales puede elegir el tweet más popular.

Map Reduce es un paradigma más antiguo; Spark es más nuevo. Con su ayuda, los datos se extraen de los clústeres y se incorporan modelos de aprendizaje automático.

¿Qué profesiones hay en el campo del big data?

Las dos profesiones principales son analistas e ingenieros de datos.

El analista trabaja principalmente con información. Le interesan los datos tabulares, se dedica a los modelos. Sus responsabilidades incluyen agregación, purificación, adición y visualización de datos. Es decir, el analista es el vínculo entre la información en bruto y los negocios.

El analista tiene dos áreas principales de trabajo. Primero, puede transformar la información recibida, sacar conclusiones y presentarla de una manera comprensible.

El segundo es que los analistas desarrollan aplicaciones que funcionarán y producirán el resultado automáticamente. Por ejemplo, haga un pronóstico en el mercado de valores todos los días.

El ingeniero de datos es una especialidad de nivel inferior. Esta es una persona que debe garantizar el almacenamiento, el procesamiento y la entrega de información al analista. Pero donde hay suministro y limpieza, sus responsabilidades pueden superponerse.

El ingeniero de datos hace todo el trabajo duro. Si los sistemas fallaron o uno de los servidores desapareció del clúster, se conecta. Este es un trabajo muy responsable y estresante. El sistema puede apagarse tanto los fines de semana como fuera de horario, y el ingeniero debe tomar medidas inmediatas.

Estas son dos profesiones principales, pero hay otras. Aparecen cuando se agregan algoritmos de computación paralela a tareas relacionadas con la inteligencia artificial. Por ejemplo, un ingeniero de PNL. Este es un programador que se dedica al procesamiento del lenguaje natural, especialmente en los casos en que no solo necesita encontrar palabras, sino comprender el significado del texto. Dichos ingenieros escriben programas para chatbots y sistemas de conversación, asistentes de voz y centros de llamadas automatizados.

Hay situaciones en las que es necesario clasificar miles de millones de imágenes, moderar, filtrar el exceso y encontrar una similar. Estas profesiones se superponen más con la visión por computadora.

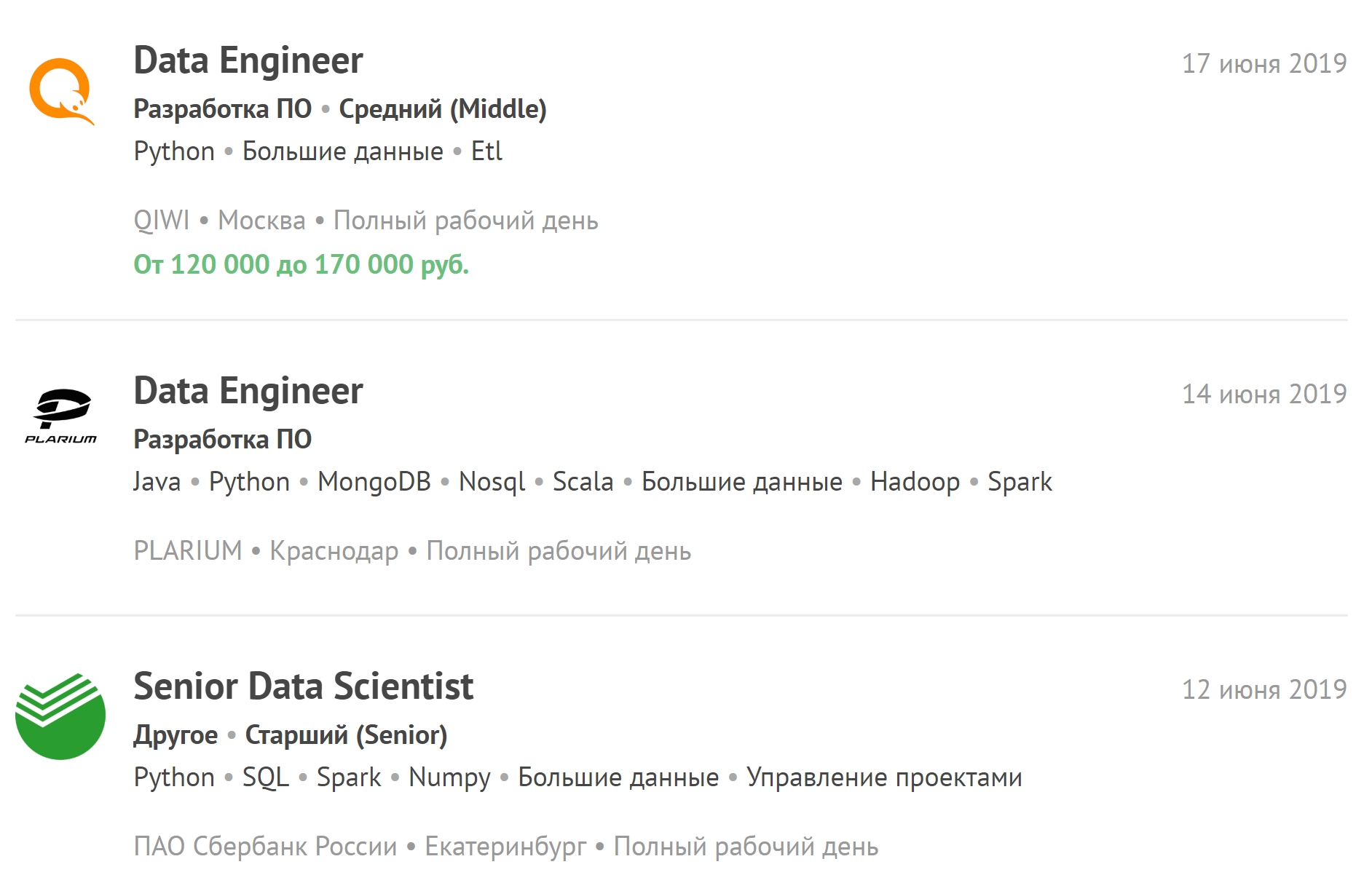

Puede consultar las últimas vacantes relacionadas con big data y suscribirse a nuevas vacantes.

¿Cuánto dura el entrenamiento?

Hemos estado estudiando durante un año y medio. Se dividen en seis cuartos. En algunos, hay un énfasis en la programación, en otros, en trabajar con bases de datos, y en el tercero, en matemáticas.

En contraste, por ejemplo, de la facultad de IA, hay menos matemáticas. No hay un énfasis tan fuerte en el análisis matemático y el álgebra lineal. El conocimiento de los algoritmos informáticos distribuidos es más necesario que los principios del matanálisis.

Pero un año y medio es suficiente para un trabajo real con big data solo si la persona tiene experiencia con datos ordinarios y en general en TI. Se recomienda que los estudiantes restantes después de la graduación trabajen con datos pequeños y medianos. Solo después de esto se puede permitir que los especialistas trabajen con los grandes. Después del entrenamiento, debe trabajar como científico de datos: aplique el aprendizaje automático en diferentes cantidades de datos.

Cuando una persona consigue un trabajo en una gran empresa, incluso si tenía experiencia, la mayoría de las veces no se le permitirá acceder a Big Data de inmediato, porque el precio de un error allí es mucho mayor. Los errores en los algoritmos pueden no detectarse inmediatamente, y esto conducirá a grandes pérdidas.

Qué salario se considera adecuado para especialistas en big data

Ahora hay una gran escasez de personal entre los ingenieros de datos. El trabajo es difícil, mucha responsabilidad recae en una persona, mucho estrés. Por lo tanto, un especialista con experiencia promedio recibe alrededor de doscientos mil. Junior: de cien a doscientos.

Un analista de datos puede tener un salario inicial ligeramente más bajo. Pero no hay trabajo que exceda el tiempo de trabajo, y no lo llamarán durante horas no laborables debido a casos de emergencia.

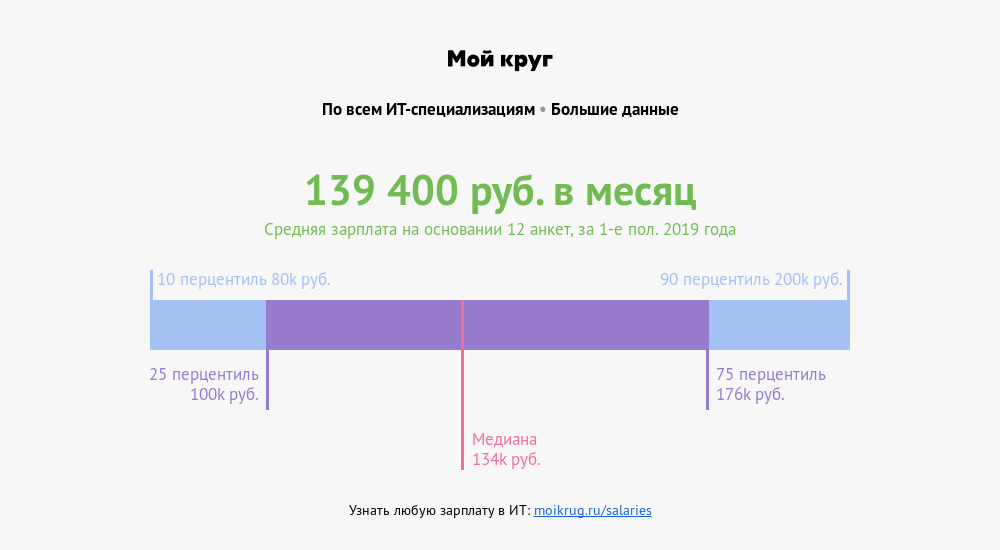

Según el cultivador de salarios "My Circle", el salario promedio de los especialistas cuyas profesiones están asociadas con grandes datos es de 139,400 rublos . Una cuarta parte de los especialistas gana más de 176,000 rublos. Una décima parte: más de 200,000 rublos.

Cómo prepararse para entrevistas

No es necesario profundizar en un solo tema. En las entrevistas hacen preguntas sobre estadísticas, aprendizaje automático, programación. Pueden preguntar sobre estructuras de datos, algoritmos y casos de la vida real: el servidor se bloqueó, ocurrió un accidente, ¿cómo solucionarlo? Puede haber preguntas sobre el área temática, algo que está más cerca de los negocios.

Y si una persona está demasiado metida en una matemática, y en la entrevista no realizó una simple tarea de programación, entonces se reducen las posibilidades de encontrar un trabajo. Es mejor tener un nivel promedio en cada dirección que mostrarse bien en una y fallar completamente en la otra.

Hay una lista de preguntas en el 80 por ciento de las entrevistas. Si esto es aprendizaje automático, definitivamente preguntarán sobre el descenso de gradiente. Si se trata de estadísticas, deberá hablar sobre la correlación y las pruebas de hipótesis. Es probable que la programación dé una pequeña tarea de mediana complejidad. Y puede tener fácilmente en sus manos tareas, solo resuélvalas más.

Dónde adquirir experiencia por tu cuenta

Python se puede extraer en

Pitontutyu , trabajar con la base de datos, en

SQL-EX . Hay tareas específicas para las cuales en la práctica aprenden a hacer solicitudes.

Matemática Superior -

Mathprofi . Allí puede obtener información clara sobre análisis matemático, estadísticas y álgebra lineal. Y si es malo con el plan de estudios de la escuela, es decir,

youclever.org .

La informática distribuida solo funcionará en la práctica. En primer lugar, esto requiere infraestructura y, en segundo lugar, los algoritmos pueden volverse obsoletos rápidamente. Ahora algo nuevo aparece constantemente.

¿Qué tendencias discute la comunidad?

Otra área está ganando fuerza gradualmente, lo que puede conducir a un rápido aumento en la cantidad de datos: Internet de las cosas (IoT). Los datos de este tipo provienen de los sensores de dispositivos conectados en una red, y el número de sensores al comienzo de la próxima década debería llegar a decenas de miles de millones.

Los dispositivos son muy diferentes: desde electrodomésticos hasta vehículos y máquinas industriales, un flujo continuo de información del cual se requerirá infraestructura adicional y una gran cantidad de especialistas altamente calificados. Esto significa que en un futuro cercano habrá una gran escasez de ingenieros de datos y analistas de big data.