Recientemente, describí, gracias a qué robots comenzarán mañana MUCHO mejor para pensar (una publicación sobre

aceleración de hardware de redes neuronales ). Hoy veremos por qué los robots pronto serán mucho mejores para ver. En algunas situaciones, mucho mejor que una persona.

Hablaremos de cámaras de profundidad que filman video, en cada píxel de las cuales se almacena no el color, sino la distancia al objeto en este punto. Estas cámaras han existido durante más de 20 años, pero en los últimos años la velocidad de su desarrollo ha crecido muchas veces y ya podemos hablar de la revolución. Y multi-vector. Se está desarrollando rápidamente en las siguientes áreas:

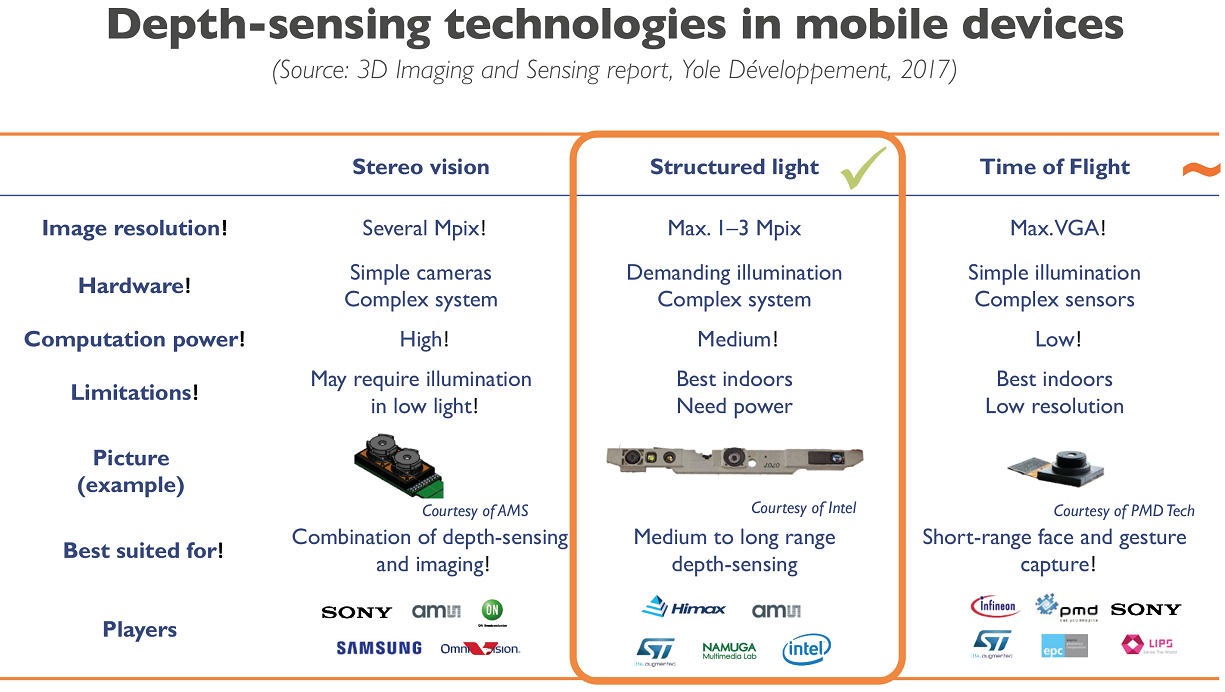

- Luz estructurada de una cámara , o una cámara de luz estructural, cuando hay un proyector (a menudo infrarrojo) y una cámara que registra la luz estructural del proyector;

- Cámaras de tiempo de vuelo , o cámaras basadas en la medición del retraso en la luz reflejada;

- Profundidad de las cámaras estéreo : la dirección clásica y, tal vez, la más famosa, de la profundidad del edificio desde estéreo;

- Cámara de campo de luz : también son cámaras de campo de luz o cámaras pleópticas, sobre las cuales había una publicación detallada por separado;

- Y finalmente, las cámaras basadas en la tecnología Lidar , especialmente los nuevos Lidars de estado sólido , que funcionan sin fallas aproximadamente 100 veces más que los lidares comunes y producen la imagen rectangular habitual.

A quién le importa cómo se verá, así como una comparación de diferentes enfoques y su aplicación actual y de mañana, ¡bienvenido!

Entonces! Analizaremos las principales direcciones de desarrollo de cámaras de profundidad o principios realmente diferentes para medir la profundidad. Con sus pros y sus contras.

Método 1: cámara de luz estructurada

Comencemos con uno de los métodos más simples, antiguos y relativamente baratos de medir la profundidad: la luz estructurada. Este método apareció esencialmente de inmediato, tan pronto como aparecieron las cámaras digitales, es decir Hace más de 40 años y se simplificó enormemente un poco más tarde, con la llegada de los proyectores digitales.

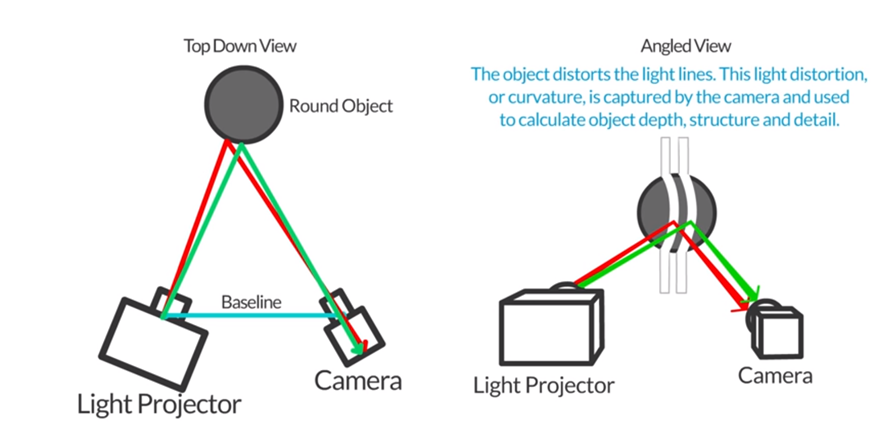

La idea básica es extremadamente simple. Ponemos al lado del proyector, que crea, por ejemplo, rayas horizontales (y luego verticales) y al lado de la cámara, que toma una imagen con rayas, como se muestra en esta figura:

Fuente: Autodesk: Escaneo 3D de luz estructurada

Fuente: Autodesk: Escaneo 3D de luz estructuradaDado que la cámara y el proyector están desplazados entre sí, las tiras también se desplazarán en proporción a la distancia al sujeto. Al medir este desplazamiento, podemos calcular la distancia al objeto:

Fuente: http://www.vision-systems.com/

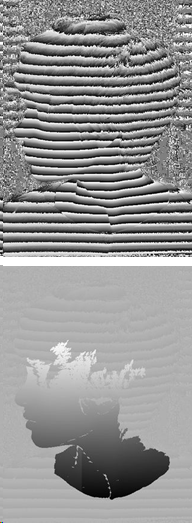

Fuente: http://www.vision-systems.com/De hecho, con el proyector más barato (y su precio comienza en 3.000 rublos) y un teléfono inteligente, puede medir la profundidad de las escenas estáticas en una habitación oscura:

Fuente: Autodesk: Escaneo 3D de luz estructurada

Fuente: Autodesk: Escaneo 3D de luz estructuradaEstá claro que al hacerlo, habrá que resolver un montón de tareas: la calibración del proyector, la calibración de la cámara del teléfono, el reconocimiento de cambio de banda, etc., pero todas estas tareas son bastante capaces incluso para los estudiantes de secundaria avanzados que aprenden programación.

Este principio de medición de profundidad se hizo más conocido cuando, en 2010, Microsoft lanzó el

sensor de profundidad

MS Kinect por $ 150, que en ese momento era revolucionario y barato.

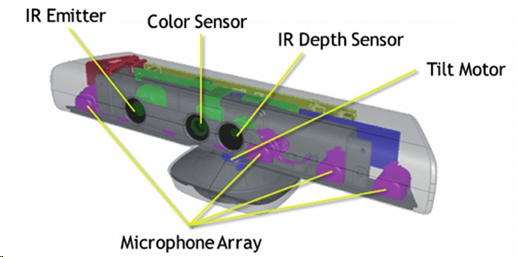

Fuente: Reconstrucción de objetos parcialmente ocluidos utilizando múltiples sensores Kinect

Fuente: Reconstrucción de objetos parcialmente ocluidos utilizando múltiples sensores KinectA pesar de que, además de medir realmente la profundidad con un proyector IR y una cámara IR, Kinect también grabó videos RGB normales, tenía cuatro micrófonos con reducción de ruido y podía ajustarse a la altura de una persona, inclinando hacia arriba o hacia abajo automáticamente, se integró de inmediato en el interior procesamiento de datos, que emitió a la consola de inmediato un mapa de profundidad listo:

Fuente: Implementación de botones de interfaz de usuario natural usando Kinect

Fuente: Implementación de botones de interfaz de usuario natural usando KinectEn total, se vendieron unos 35 millones de dispositivos, lo que convierte a Kinect en la primera cámara de profundidad masiva de la historia. Y si considera que ciertamente había cámaras de profundidad, pero generalmente vendían un máximo de cientos y costaban al menos un orden de magnitud más caro, esta fue una revolución que proporcionó una gran inversión en esta área.

Una razón importante para el éxito fue que cuando Microsoft lanzó la Xbox 360, ya había algunos juegos que usaban activamente a Kinect como sensor. El despegue fue rápido:

Además, Kinect incluso logró ingresar al Libro Guinness de los Récords como el dispositivo más vendido en la historia. Es cierto que Apple pronto expulsó a Microsoft de este lugar, pero no obstante. Para un nuevo sensor experimental que funciona además del dispositivo principal para convertirse en el dispositivo electrónico más vendido en la historia, este es simplemente un gran logro:

En las conferencias, me gusta preguntarle a la audiencia de dónde provienen todos estos millones de clientes. ¿Quiénes eran todas estas personas?

Como regla general, nadie adivina, pero a veces, especialmente si el público es mayor y tiene más experiencia, dan la respuesta correcta: las ventas fueron impulsadas por padres estadounidenses, que vieron con deleite que sus hijos podían jugar en la consola y no sentarse en el sofá con un grueso botín, y saltando frente al televisor. ¡Fue un gran avance! Millones de madres y padres se apresuraron a pedir un dispositivo para sus hijos.

En general, cuando se trata de reconocimiento de gestos, las personas generalmente creen ingenuamente que solo los datos de una cámara 2D son suficientes. Después de todo, ¡vieron muchas demostraciones hermosas! La realidad es mucho más severa. La precisión del reconocimiento de los gestos de una transmisión de video 2D desde una cámara y la precisión del reconocimiento de los gestos desde la profundidad de una cámara difieren en un orden de magnitud. Desde una cámara de profundidad, o más bien, desde una cámara RGB combinada con una cámara de profundidad (esta última es importante), puede reconocer los gestos con mucha más precisión y a un costo menor (incluso si la habitación está oscura) y esto ha traído el éxito a la primera cámara de profundidad masiva.

Sobre Kinect en Habré en el momento en que escribieron

mucho , muy brevemente cómo funciona.

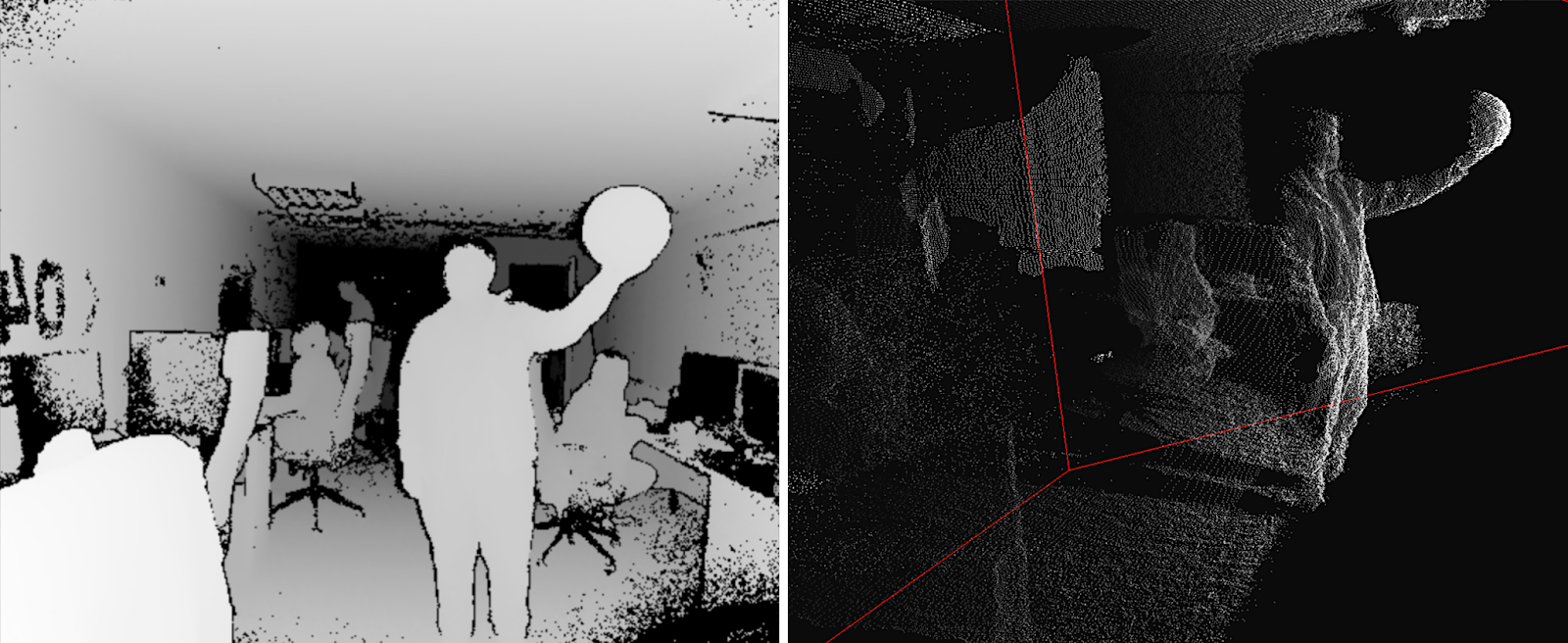

Un proyector de infrarrojos proporciona un conjunto pseudoaleatorio de puntos en el espacio, cuyo desplazamiento determina la profundidad en un píxel dado:

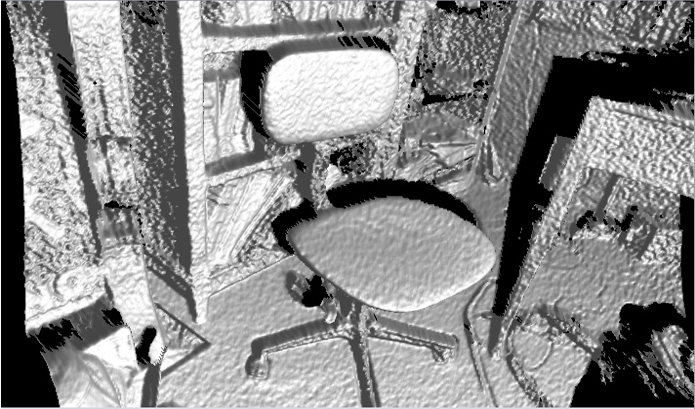

Fuente: Estructuras planas de detección de profundidad: detección de configuraciones de muebles de oficina

Fuente: Estructuras planas de detección de profundidad: detección de configuraciones de muebles de oficinaLa resolución de la cámara se declara como 640x480, pero realmente hay un lugar alrededor de 320x240 con un filtrado bastante fuerte y la imagen en ejemplos reales se ve así (es decir, bastante aterrador):

Fuente: Reconstrucción de objetos parcialmente ocluidos utilizando múltiples sensores Kinect

Fuente: Reconstrucción de objetos parcialmente ocluidos utilizando múltiples sensores KinectLas "sombras" de los objetos son claramente visibles, ya que la cámara y el proyector están lo suficientemente separados. Se puede ver que se realizan desplazamientos de varios puntos del proyector para predecir la profundidad. Además, hay un filtrado (duro) por vecinos inmediatos, pero aún así el mapa de profundidad es bastante ruidoso, especialmente en las fronteras. Esto conduce a un ruido bastante notable en la superficie de los objetos resultantes, que debe suavizarse adicionalmente y de manera no trivial:

Fuente: Biblioteca Java J4K para Kinect SDK de Microsoft

Fuente: Biblioteca Java J4K para Kinect SDK de MicrosoftSin embargo, solo $ 150 (

hoy ya son $ 69 , aunque

es más cercano a $ 200 , por supuesto), ¡y usted "ve" la profundidad!

Realmente hay

muchos productos en serie.

Por cierto, en febrero de este año, se anunció un nuevo

Azure Kinect :

Fuente: Microsoft anuncia Azure Kinect, disponible para pre-pedido ahora

Fuente: Microsoft anuncia Azure Kinect, disponible para pre-pedido ahoraSus entregas a desarrolladores en los EE. UU. Y China deberían comenzar el 27 de junio, es decir, literalmente ahora mismo. De las capacidades, además de la resolución notablemente mejor de RGB y la mejor calidad de las cámaras de profundidad (prometen

1024x1024 a 15 FPS y 512x512 a 30 FPS y

la demostración de la cámara de ToF es

claramente visible ), se admite claramente la compatibilidad con la colaboración de varios dispositivos listos para usar. el sol, el error es inferior a 1 cm a una distancia de 4 metros y 1-2 mm a una distancia de menos de 1 metro, lo que suena extremadamente interesante, por lo que esperamos, esperamos:

Fuente: Presentación de Azure Kinect DK

Fuente: Presentación de Azure Kinect DKEl siguiente producto

masivo , donde se realizó una cámara de profundidad con una luz estructurada, no fue una consola de juegos, sino ... (redoble de batería) correctamente: ¡

iPhone X !

Su tecnología Face ID es una cámara de profundidad típica con un proyector Dot infrarrojo típico y una cámara infrarroja (por cierto, ahora entiendes por qué están en los bordes del flequillo, espaciados lo más posible entre sí; esta es una

base estéreo ):

La resolución del mapa de profundidad es incluso menor que la de Kinect: aproximadamente 150x200. Está claro que si usted dice: "Nuestra resolución es de aproximadamente 150x200 píxeles o 0.03 megapíxeles", la gente dirá breve y sucintamente: "¡Apesta!" Y si dices

"Proyector de puntos: se proyectan más de 30,000 puntos invisibles en tu cara" , la gente dice: "¡Guau, 30 mil puntos invisibles, genial!". Algunas rubias preguntarán si aparecen pecas desde puntos invisibles. ¡Y el tema irá a las masas! Por lo tanto, la segunda opción era la hipermetropía en la publicidad. La resolución es pequeña por tres razones: en primer lugar, los requisitos de miniatura, en segundo lugar, el consumo de energía y, en tercer lugar, los precios.

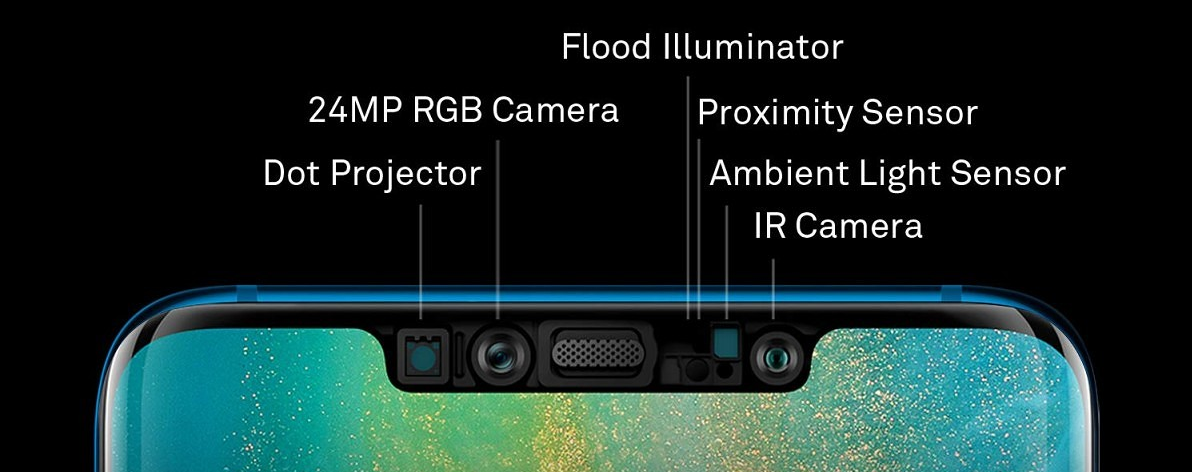

Sin embargo, esta es otra cámara de profundidad en una luz estructurada, que se ha incluido en una serie de millones de copias y ya ha sido repetida por otros fabricantes de teléfonos inteligentes,

por ejemplo, (¡sorpresa-sorpresa!) Huawei (que eludió a Apple en ventas de teléfonos inteligentes el año pasado). Solo Huawei tiene una cámara a la derecha y el proyector a la izquierda, pero también, por supuesto, a lo largo de los bordes del “flequillo”:

Fuente: la actualización de Huawei Mate 20 Pro permite a los usuarios agregar una segunda cara para el desbloqueo facial

Fuente: la actualización de Huawei Mate 20 Pro permite a los usuarios agregar una segunda cara para el desbloqueo facialAl mismo tiempo, se declaran 300,000 puntos, es decir

, 10 veces más que Apple , y la cámara frontal es mejor

y la fuente es más grande . ¿Hay una exageración con respecto a 300 mil? Es difícil de decir, pero Huawei muestra un muy buen

escaneo 3D de objetos con una cámara frontal . Las pruebas independientes son

más aterradoras , pero este es claramente el comienzo del tema y la infancia de la tecnología de las cámaras de profundidad en miniatura de bajo consumo de energía y los anuncios de cámara a finales de este año ya es notablemente mejor en rendimiento.

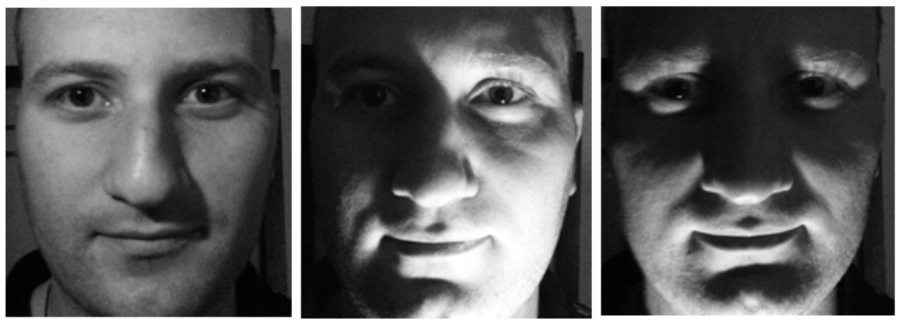

Al mismo tiempo, es comprensible por qué se utilizó la tecnología de identificación facial en los teléfonos. En primer lugar, ahora no puedes engañar al detector mostrando una foto de tu cara (o video de la tableta). En segundo lugar, la cara cambia mucho cuando cambia la iluminación, pero su forma no, lo que nos permite identificar con mayor precisión a la persona junto con los datos de la cámara RGB:

Fuente: foto de TI de la misma persona

Fuente: foto de TI de la misma personaObviamente, el sensor infrarrojo tiene problemas inherentes. En primer lugar, nuestro proyector relativamente débil brilla al sol una o dos veces, por lo que estas cámaras no funcionan en la calle. Incluso a la sombra, si la pared blanca de un edificio está iluminada por el sol, puede tener grandes problemas con Face ID. El nivel de ruido en Kinect también cambia incluso cuando el sol está cubierto por nubes:

Fuente: esta y las dos imágenes siguientes

Fuente: esta y las dos imágenes siguientes -

materiales Basler AGOtro gran problema es la reflexión y la reflexión. Dado que la luz infrarroja también se refleja, para fotografiar un costoso hervidor de acero inoxidable, una mesa barnizada o una pantalla de vidrio con Kinect será problemático:

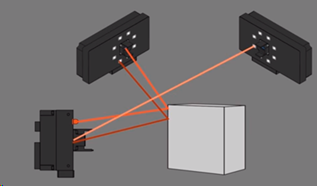

Y finalmente, dos cámaras que disparan un objeto pueden interferir entre sí. Curiosamente, en el caso de la luz estructurada, puede hacer que el proyector parpadee y comprender dónde están nuestros puntos y dónde no, pero esta es una historia separada y bastante complicada:

Ahora sabes cómo romper FaceID ...

Sin embargo, para dispositivos móviles, la luz estructurada parece el compromiso más razonable hoy en día:

Fuente: Las empresas de teléfonos inteligentes luchan por igualar el rendimiento y el costo de la cámara Apple 3D

Fuente: Las empresas de teléfonos inteligentes luchan por igualar el rendimiento y el costo de la cámara Apple 3DPara la luz estructurada, el bajo costo de un sensor convencional es tal que su uso en la mayoría de los casos está más que justificado. Lo que dio vida a una gran cantidad de startups que operan de acuerdo con la fórmula: sensor barato + software complejo = resultado bastante aceptable.

Por ejemplo, nuestro antiguo estudiante de posgrado

Maxim Fedyukov , quien ha estado involucrado en la reconstrucción 3D desde 2004, creó

Texel , cuyo producto principal es una plataforma con 4 cámaras Kinect y un software que convierte a una persona en un monumento potencial en 30 segundos. Bueno, o una figura de escritorio. Este es quien tiene suficiente dinero. O puede enviar a sus amigos fotos baratas y alegres de su modelo 3D (por alguna razón, el caso más popular por alguna razón). Ahora envían sus plataformas y software al extranjero desde el Reino Unido a Australia:

Fuente: crear un modelo 3D de una persona en 30 segundosComo bailarina, no puedo soportar bellamente, así que solo miro pensativamente la aleta de un tiburón nadando:

Fuente: materiales del autor.

Fuente: materiales del autor.En general, un nuevo tipo de sensores generó nuevos proyectos de arte. En invierno, vi una película de realidad virtual bastante curiosa rodada con Kinect. A continuación se muestra una interesante visualización del baile, también hecha con Kinect (parece que se usaron 4 cámaras), y a diferencia del ejemplo anterior, no lucharon con el ruido, sino que agregaron detalles divertidos:

Fuente: un espectáculo de danza capturado con un sensor Kinect y visualizado con software 3D

Fuente: un espectáculo de danza capturado con un sensor Kinect y visualizado con software 3DQué tendencias se pueden observar en el área:

- Como sabe, los sensores digitales de las cámaras modernas son sensibles a la radiación infrarroja, por lo que debe usar filtros de bloqueo especiales para que el ruido infrarrojo no estropee la imagen (incluso aparece la dirección de disparo artístico en el rango infrarrojo , incluso cuando se retira el filtro del sensor). Esto significa que se invierten enormes cantidades de dinero en miniaturización, mayor resolución y sensores más baratos, que pueden usarse como infrarrojos (con un filtro especial ).

- Del mismo modo, los algoritmos para procesar mapas de profundidad ahora están mejorando rápidamente, incluidos los métodos de filtrado cruzado, cuando los datos de un sensor RGB y los datos ruidosos por profundidad le permiten obtener un muy buen video de profundidad juntos. Al mismo tiempo, utilizando enfoques de redes neuronales, se hace posible aumentar drásticamente la velocidad para obtener un buen resultado.

- Todas las principales empresas trabajan en esta área, especialmente los fabricantes de teléfonos inteligentes.

Como resultado:

- Podemos esperar un aumento dramático en la resolución y precisión de disparar cámaras de profundidad de Luz Estructurada en los próximos 5 años.

- Habrá una reducción (aunque más lenta) en el consumo de energía de los sensores móviles, lo que simplificará el uso de sensores de próxima generación en teléfonos inteligentes, tabletas y otros dispositivos móviles.

En cualquier caso, lo que estamos viendo ahora es la infancia de la tecnología. Los primeros productos en masa en los que se acaba de lanzar la depuración de la producción y el uso de un nuevo tipo de datos inusual: video con profundidad.

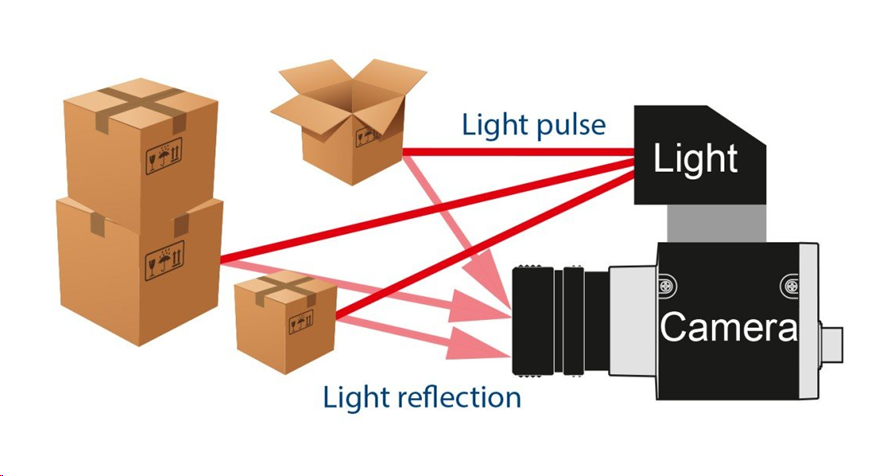

Método 2: cámara de tiempo de vuelo

La siguiente forma de obtener profundidad es más interesante. Se basa en la medición del retraso de la luz de ida y vuelta (ToF -

Tiempo de vuelo ). Como saben, la velocidad de los procesadores modernos es alta, y la velocidad de la luz es pequeña. En un ciclo de reloj del procesador a 3 GHz, la luz logra volar solo 10 centímetros. O 10 medidas por metro. Mucho tiempo, si alguien se dedicaba a la optimización de bajo nivel. En consecuencia, instalamos una fuente de luz pulsada y una cámara especial:

Fuente: La cámara Basler Time-of-Flight (ToF)

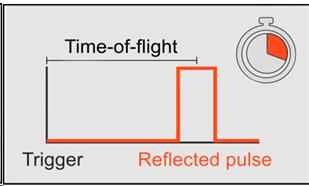

Fuente: La cámara Basler Time-of-Flight (ToF)De hecho, necesitamos medir el retraso con el que la luz vuelve a cada punto:

Fuente: La cámara Basler Time-of-Flight (ToF)

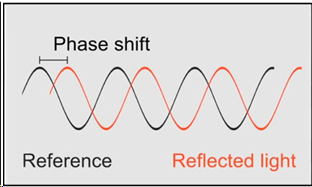

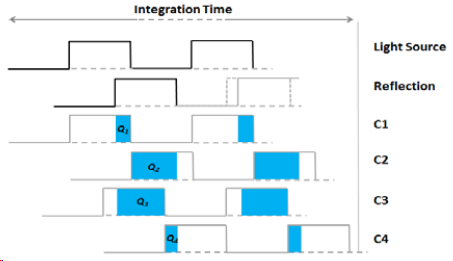

Fuente: La cámara Basler Time-of-Flight (ToF)O, si tenemos varios sensores con diferentes tiempos de acumulación de carga, entonces, conociendo el cambio de tiempo relativo a la fuente para cada sensor y el brillo del flash de disparo, podemos calcular el cambio y, en consecuencia, la distancia al objeto, y al aumentar el número de sensores, aumentamos la precisión:

Fuente: Cámara de tiempo de vuelo de Larry Li: una introducción

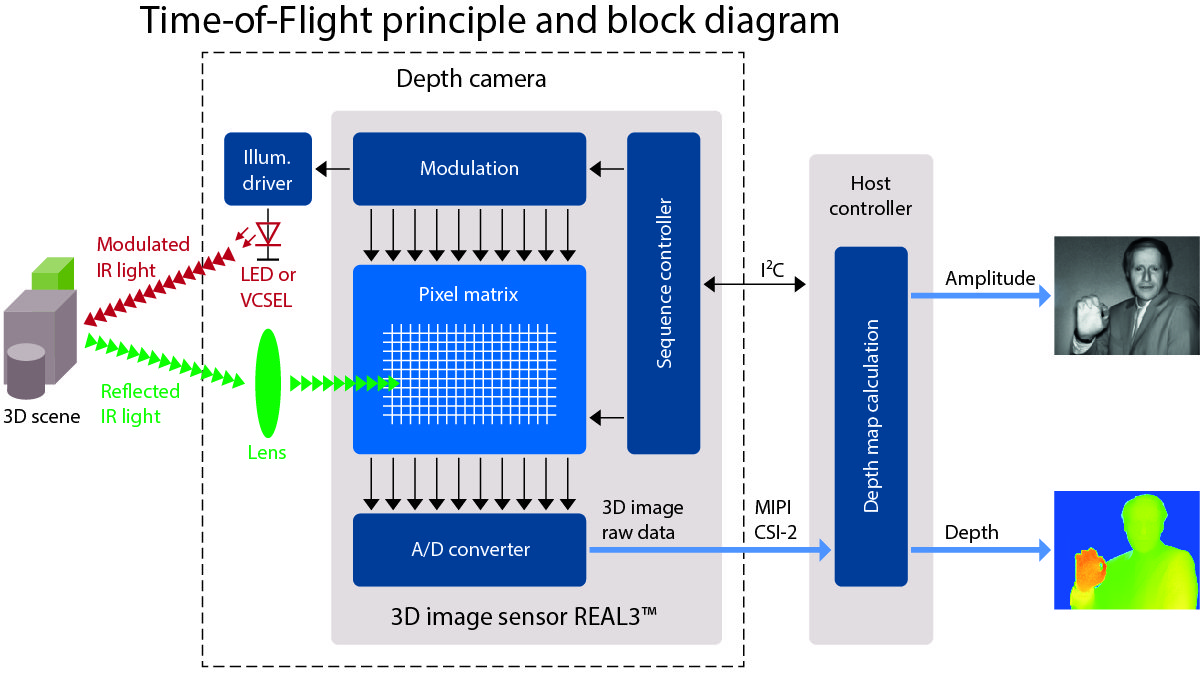

Fuente: Cámara de tiempo de vuelo de Larry Li: una introducciónEl resultado es un esquema de la cámara con iluminación LED o, menos comúnmente, láser (

VCSEL ) de infrarrojos:

Fuente: Una muy buena descripción del trabajo de ToF en allaboutcircuits.com

Fuente: Una muy buena descripción del trabajo de ToF en allaboutcircuits.comEn este caso, la imagen se obtiene a una resolución bastante baja (porque necesitamos colocar varios sensores con diferentes tiempos de sondeo uno al lado del otro), pero potencialmente con un FPS alto. Y los problemas están principalmente en los límites de los objetos (lo cual es típico para todas las cámaras de profundidad). Pero sin las "sombras" típicas de la luz estructurada:

Fuente: video de Basler AG

Fuente: video de Basler AGEn particular, fue este tipo de cámara (ToF) la que probó activamente Google en el proyecto

Google Tango , que estuvo bien representado en

este video . El significado era simple: combinar los datos del giroscopio, el acelerómetro, la cámara RGB y la cámara de profundidad, creando una escena tridimensional frente al teléfono inteligente:

Fuente: Proyecto Tango de Google ahora está diseñado para teléfonos inteligentes

Fuente: Proyecto Tango de Google ahora está diseñado para teléfonos inteligentesEl proyecto en sí no funcionó (mi opinión es que estaba un poco adelantado a su tiempo), pero creó requisitos previos importantes para crear una ola de interés en AR (realidad aumentada) y, en consecuencia, desarrollar sensores que puedan funcionar con él. Ahora todos sus logros se vierten en

ARCore de Google.

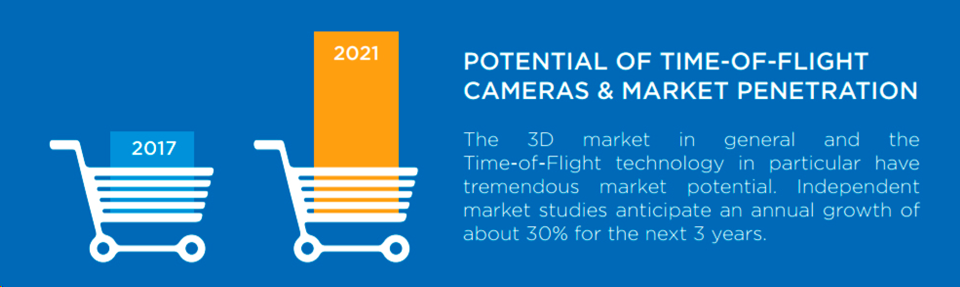

En general, el volumen de mercado de las cámaras ToF crece aproximadamente un 30% cada 3 años, lo que es un crecimiento bastante exponencial, y pocos mercados crecen tan rápido:

Fuente: Potencial de cámaras de tiempo de vuelo y penetración en el mercado

Fuente: Potencial de cámaras de tiempo de vuelo y penetración en el mercadoUn motor serio del mercado hoy en día es el desarrollo rápido (y también exponencial) de robots industriales, para los cuales las cámaras ToF son una solución ideal. Por ejemplo, si su robot empaqueta cajas, entonces con una cámara 2D ordinaria, determinar que está comenzando a atascar el cartón es una tarea extremadamente no trivial. Y para una cámara ToF, es trivial "ver" y procesarla. Y muy rapido. Como resultado, vemos un

auge en las cámaras industriales ToF :

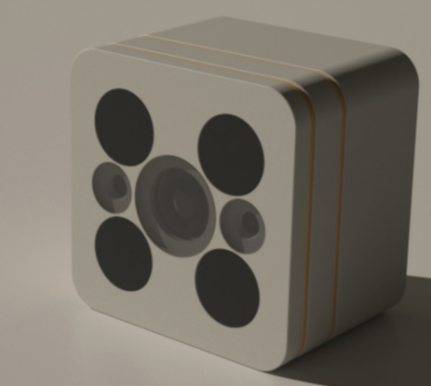

Naturalmente, esto también lleva a la aparición de productos caseros que utilizan cámaras de profundidad. Por ejemplo, una cámara de seguridad con una unidad de video nocturno y una cámara de profundidad ToF de German

PMD Technologies , que ha estado desarrollando cámaras 3D durante

más de 20 años :

Fuente: La detección de profundidad de tiempo de vuelo en 3D aporta magia a la nueva cámara inteligente para el hogar Lighthouse

Fuente: La detección de profundidad de tiempo de vuelo en 3D aporta magia a la nueva cámara inteligente para el hogar Lighthouse¿Recuerdas la capa de invisibilidad bajo la cual Harry Potter se escondía?

Fuente: La capa de invisibilidad de Harry Potter tiene una historia de origen y puede existir pronto en la vida real

Fuente: La capa de invisibilidad de Harry Potter tiene una historia de origen y puede existir pronto en la vida realMe temo que la cámara alemana lo detectará una o dos veces. Y será difícil colocar una pantalla con una imagen frente a dicha cámara (esto no es una protección que lo distraiga):

Fuente: Fragmento de la película "Misión imposible: protocolo fantasma"

Fuente: Fragmento de la película "Misión imposible: protocolo fantasma"Parece que para las nuevas cámaras de CCTV, se requerirá la magia no infantil de Hogwarts para engañarlas con una cámara de profundidad ToF que pueda grabar ese video en completa oscuridad:

Pretender ser una pared, una pantalla y otras formas de protegerse del hecho de que la cámara combinada ToF + RGB detectará un objeto extraño se vuelve técnicamente más difícil.

Otra aplicación pacífica masiva para cámaras de profundidad es el reconocimiento de gestos. En el futuro cercano, puede esperar televisores, consolas y aspiradoras robóticas que podrán percibir no solo los comandos de voz como altavoces inteligentes, sino también el descuidado "¡límpielo!" con un gesto de su mano. Luego, el control remoto (también conocido como vago) del televisor inteligente será completamente innecesario y la ciencia ficción cobrará vida. Como resultado, lo que

fue fantástico en 2002 se convirtió en experimental en 2013 y, finalmente,

en serie en 2019 (aunque la gente no sabrá que hay una cámara de profundidad en el interior,

¿qué diferencia hace, cómo funciona esta magia? ):

Fuente: artículo , experimentos y producto.

Fuente: artículo , experimentos y producto.Y la línea completa de aplicaciones es aún más amplia, por supuesto:

Fuente: video de sensores de profundidad de Terabee (por cierto, ¿qué tipo de ratones corren en el piso por 2 y 3 videos? ¿Los ven? Es broma, es polvo en el aire, una tarifa por el pequeño tamaño del sensor y la proximidad de la fuente de luz al sensor)

Fuente: video de sensores de profundidad de Terabee (por cierto, ¿qué tipo de ratones corren en el piso por 2 y 3 videos? ¿Los ven? Es broma, es polvo en el aire, una tarifa por el pequeño tamaño del sensor y la proximidad de la fuente de luz al sensor)Por cierto, en las famosas "tiendas sin cajeros" de Amazon Go también hay muchas cámaras debajo del techo:

Fuente: Dentro de la tienda de conveniencia de Amazon que funciona sin vigilancia

Fuente: Dentro de la tienda de conveniencia de Amazon que funciona sin vigilanciaAdemás, como escribe

TechCrunch :

"Están aumentados por cámaras de detección de profundidad separadas (usando una técnica de tiempo de vuelo , o eso entendí de Kumar) que se mezclan con el fondo como el resto, todo negro mate". Es decir, el milagro de determinar de qué estante se toma el yogur lo proporcionan, entre otras cosas, las misteriosas cámaras de ToF negro mate (una buena pregunta, ¿están en la foto?):

Desafortunadamente, la información directa es a menudo difícil de encontrar. Pero hay uno indirecto. Por ejemplo, había una compañía

Softkinetic , que desde 2007 ha estado desarrollando cámaras ToF. 8 años después, fueron

comprados por Sony (que, por cierto, está listo para conquistar nuevos mercados bajo la marca

Sony Depthsensing ). Entonces, uno de los

mejores empleados de Softkinetic ahora trabaja solo en Amazon Go. ¡Qué coincidencia! Dentro de un par de años, cuando se presente la tecnología y se presenten las principales patentes, lo más probable es que se revelen los detalles.

Bueno, como siempre, los chinos se encienden.

Pico Zense , por ejemplo, presentó en CES 2019 una línea muy impresionante de cámaras ToF, incluso para uso en exteriores:

Prometen una revolución en todas partes. Los vagones se cargarán más densos debido a la carga automatizada, los cajeros automáticos serán más seguros, debido a las cámaras de profundidad en cada uno, la navegación de los robots será más fácil y precisa, las personas (y, lo más importante, los niños) se contarán un orden de magnitud mejor en la corriente, aparecerán nuevos entrenadores de fitness c la capacidad de controlar la corrección de los ejercicios sin un instructor, y así sucesivamente. Naturalmente, las cámaras chinas baratas de una nueva generación de profundidad ya están listas para toda esta magnificencia. ¡Toma y construye!

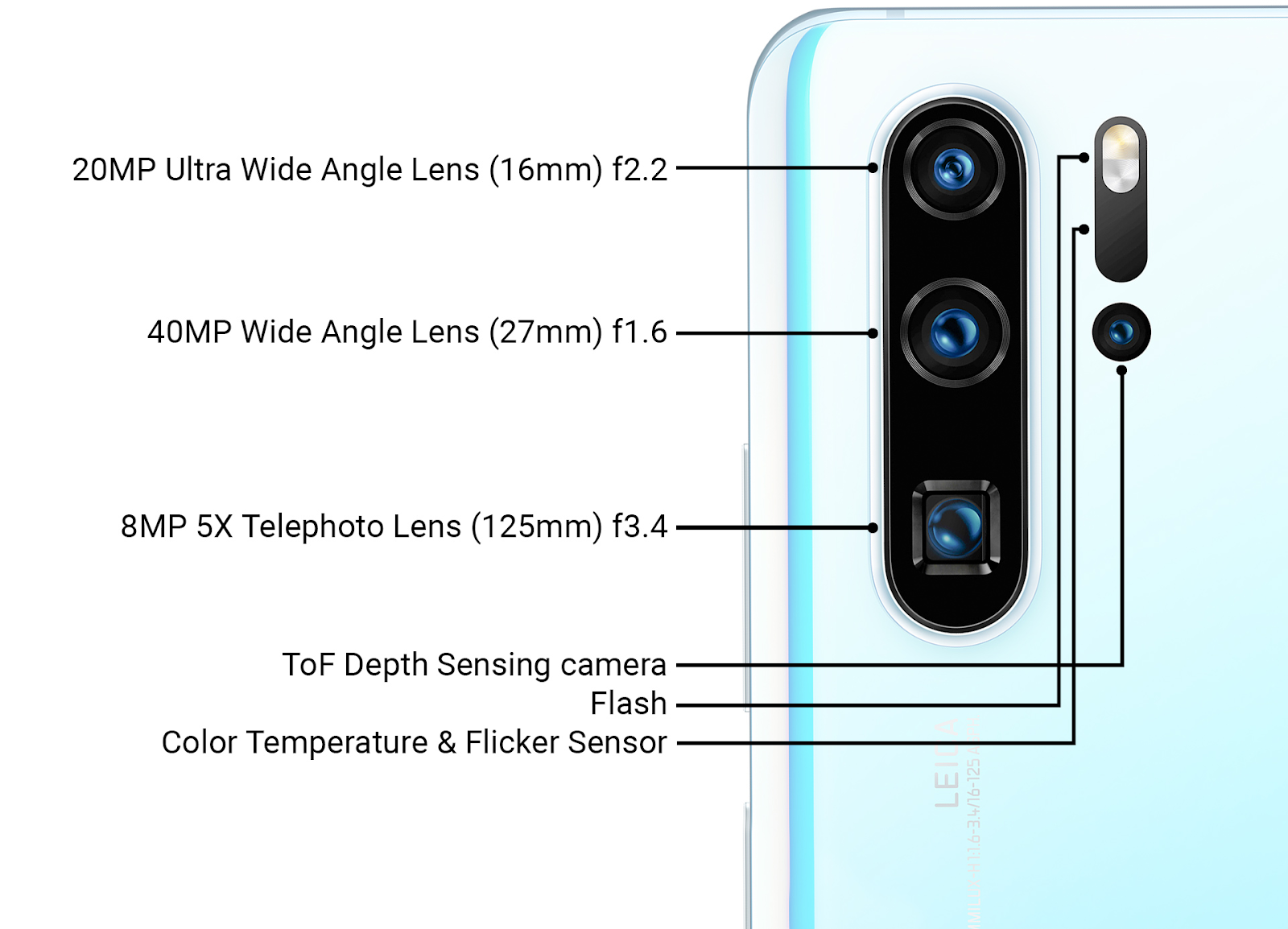

Curiosamente, el último Huawei P30 Pro en serie tiene un sensor ToF junto a las cámaras principales, es decir, el sufrido Huawei es más capaz de fabricar sensores de luz estructurados de frente de Apple y, al parecer, con más éxito Google (Proyecto Tango, que

estaba cerrado ) introdujo una cámara junto a las principales cámaras ToF:

Fuente: Revisión de nueva tecnología de Ars Technica Huawei a fines de marzo de 2019

Fuente: Revisión de nueva tecnología de Ars Technica Huawei a fines de marzo de 2019Los detalles del uso, por supuesto, no fueron revelados, pero además de acelerar el enfoque (que es importante para las tres cámaras principales con lentes diferentes), este sensor se puede usar para aumentar la calidad de desenfocar el fondo de las fotos (simulando pequeños

DOF ).

También es obvio que la próxima generación de sensores de profundidad junto a las cámaras principales se utilizará en aplicaciones de AR, lo que aumentará la precisión del AR desde el actual "frío, pero a menudo con errores" a un nivel de trabajo en masa. Y, obviamente, a la luz de los éxitos chinos, la gran pregunta es cuánto querrá Google apoyar el revolucionario hardware chino en

ARCore . Las guerras de patentes pueden ralentizar significativamente el mercado tecnológico. El desarrollo de esta dramática historia que veremos literalmente en los próximos dos años.

Subtotales

Hace unos 25 años, cuando aparecieron las primeras puertas automáticas, observé personalmente cómo los tíos respetables aceleraban periódicamente frente a esas puertas. ¿Tiene éxito para abrir o no tiene tiempo? Ella es grande, pesada, de cristal! Casi lo mismo que observé durante una gira de profesores bastante respetables en una fábrica automática en China recientemente. Se quedaron un poco atrás del grupo para ver qué pasaría si te pararas frente al robot, llevando piezas pacíficamente y tocando una melodía tranquila y agradable en el camino. Yo también me arrepiento, no pude resistir ... ¡Sabes, se detiene! Quizás sin problemas. Quizás como hombre muerto. ¡Los sensores de profundidad funcionan!

Fuente: Dentro del nuevo campus de Huawei Technology

Fuente: Dentro del nuevo campus de Huawei TechnologyEl hotel también funcionaba como robots de limpieza, que se veían así:

Al mismo tiempo, fueron intimidados con más fuerza que los robots en la fábrica. No tan duro como en lo

inhumano en todos los sentidos de

Bosstown Dynamics , por supuesto. Pero personalmente vi cómo se levantaron en el camino, el robot intentó rodear a una persona, la persona se movió, bloqueando el camino ... Una especie de gato y ratón. En general, parece que cuando aparecen vehículos no tripulados en las carreteras, la primera vez se cortarán con más frecuencia de lo habitual ... Oh, gente-gente ... Hmmm ... Sin embargo, estábamos distraídos.

Resumiendo los puntos clave:

- Debido a otro principio de funcionamiento, podemos colocar la fuente de luz en la cámara ToF lo más cerca posible del sensor (incluso bajo la misma lente). Además, muchos modelos industriales tienen LED ubicados alrededor del sensor. Como resultado, las "sombras" en el mapa de profundidad se reducen radicalmente, o incluso desaparecen. Es decir Trabajo simplificado con objetos de geometría compleja, lo cual es importante para los robots industriales.

- Como la iluminación pulsada, por regla general, permanece infrarroja, se conservan todas las desventajas de la cámara infrarroja descrita en la última sección: exposición al sol, dificultades cuando dos cámaras trabajan juntas, etc. Sin embargo, los robots industriales a menudo trabajan en interiores y se están desarrollando cámaras con iluminación láser.

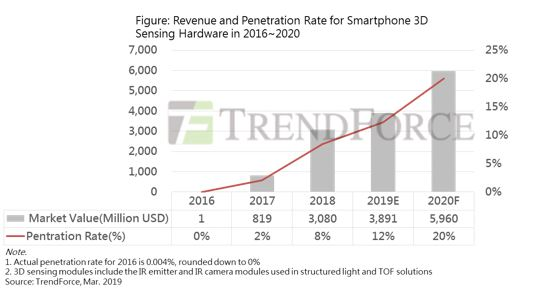

- Por desgracia, los sensores ToF son más difíciles de "seguir" la mejora general de los sensores de las cámaras RGB, por lo que su desarrollo es más lento, pero sorprendentemente seguro y las noticias sobre la introducción de las cámaras ToF son MUY mucho y lo que (allí) no está allí (solo en los teléfonos inteligentes anunciaron la integración de sensores y Samsung, Google Pixel y Sony Xperia ...).

- La nueva Sony promete que 2 cámaras de 8 cámaras telefónicas (!!!) serán cámaras de profundidad ToF (!), Es decir. Las cámaras de profundidad estarán a ambos lados del teléfono:

Fuente: el teléfono Sony Hexa-cam revela las especificaciones de la cámara

- Como resultado, ¡encontraremos muchas cosas interesantes en esta área incluso en el próximo año! Y el próximo año, hasta el 20% de los teléfonos nuevos contarán con cámaras de profundidad (Structured Light + ToF). Dado que en 2017 solo Apple estaba en el mercado en un espléndido aislamiento con "30 mil puntos", y ahora no están poniendo menos de 300 mil, el tema claramente salió bien:

Fuente: Crecimiento limitado del mercado de sensores 3D para teléfonos inteligentes en 2019; Apple será el promotor clave del crecimiento en 2020

¿Todavía dudas de la revolución en curso?

Esta fue la primera parte! Una comparación general será en el segundo.

En la próxima serie, espera:

- Método 3, clásico: profundidad de estéreo;

- Método 4, novedoso: profundidad de los pleópticos;

- Método 5, de rápido crecimiento: lidares, incluidos los lidares de estado sólido;

- Algunos problemas al procesar video con profundidad;

- Y finalmente, una breve comparación de los 5 métodos y conclusiones generales.

Cartago debe estar roto ... ¡ Todo el video será tridimensional para fines de siglo!Estén atentos! (Si tengo suficiente tiempo, describiré nuevas cámaras, incluidas las pruebas de Kinect reciente, para fin de año).

Parte 2AgradecimientosMe gustaría agradecerle cordialmente:

- Laboratorio de Computación Gráfica VMK Universidad Estatal de Moscú MV Lomonosov por su contribución al desarrollo de gráficos por computadora en Rusia en general y su trabajo con cámaras de profundidad en particular,

- Microsoft, Apple, Huawei y Amazon para productos basados en cámaras de gran profundidad,

- Texel para el desarrollo de productos rusos de alta tecnología con cámaras de profundidad,

- personalmente Konstantin Kozhemyakov, quien hizo mucho para hacer este artículo mejor y más visual,

- y, finalmente, muchas gracias a Roman Kazantsev, Eugene Lyapustin, Egor Sklyarov, Maxim Fedyukov, Nikolai Oplachko e Ivan Molodetsky por una gran cantidad de comentarios y correcciones razonables que hicieron que este texto fuera mucho mejor.