Debajo del gato sobre qué enfoque ofrece Huawei al organizar el acceso remoto directo a la memoria utilizando la tecnología AI Fabric y cómo se diferencia de InfiniBand y RDMA pura basada en Ethernet.

La informática distribuida se utiliza en una amplia variedad de industrias. Estas son investigaciones científicas y desarrollos técnicos como herramientas de reconocimiento facial o de piloto automático, y la industria. En general, el análisis de datos está encontrando más y más aplicaciones, y podemos decir con confianza que en un futuro cercano no perderá popularidad. De hecho, ahora estamos experimentando una transición desde la era de la computación en la nube, donde los factores más importantes fueron las aplicaciones y la velocidad de implementación de los servicios, hasta la era de la monetización de datos, incluso mediante el uso de algoritmos de inteligencia artificial. Según nuestros datos internos (informe

GIV 2025: Despliegue del modelo industrial de un mundo inteligente ), para 2025, el 86% de las empresas utilizarán IA en su trabajo. Muchos de ellos consideran esta área como la principal para la modernización de actividades y, posiblemente, la herramienta básica para tomar decisiones comerciales en el futuro. Y esto significa que cada una de estas empresas necesitará algún tipo de procesamiento de datos sin procesar, muy probablemente a través de clústeres distribuidos.

La evolución de la arquitectura.

Con la creciente popularidad de la informática distribuida, aumenta el volumen de tráfico intercambiado entre máquinas de centros de datos individuales. Tradicionalmente, cuando se discuten las redes, la atención se centra en el crecimiento del tráfico entre el centro de datos y los usuarios finales en Internet, y realmente está creciendo. Pero el aumento del tráfico horizontal dentro de los sistemas distribuidos supera con creces todo lo que generan los usuarios. Según Facebook, el tráfico entre sus sistemas internos se duplica en menos de un año.

En los intentos de hacer frente a este tráfico, puede aumentar los clústeres, pero no puede hacerlo sin cesar. Por lo tanto, al predecir el crecimiento de la carga informática en los clústeres, es necesario aumentar la eficiencia del procesamiento, en primer lugar, encontrar y eliminar cuellos de botella dentro de estas redes distribuidas.

Si antes los recursos de cada uno de estos sistemas por separado eran el "eslabón débil" de los sistemas distribuidos, mientras que las redes de transmisión de datos en constante evolución incluso superaron las necesidades, hoy en día las comunicaciones de red son la fuente principal del problema. La familiar pila de protocolos TCP / IP y la topología de árbol ya no corresponden a las tareas asignadas. Por lo tanto, cada vez más centros de datos están abandonando el centralizado y se están mudando a una nueva arquitectura CLOS que proporciona un mayor ancho de banda y una mejor escalabilidad del clúster, como, por ejemplo, Facebook hace varios años.

Al mismo tiempo, es necesario optimizar el proceso en un nivel diferente, en el nivel de interacción de dos sistemas separados. En este artículo, queremos hablar sobre qué herramientas de optimización proporciona el centro de datos de Huawei Ai Fabric. Esta es nuestra tecnología patentada que acelera el intercambio de datos entre nodos.

Cambios de red

El "truco" principal de Huawei Ai Fabric es reducir la sobrecarga cuando se transfieren paquetes de datos entre sistemas dentro del clúster mediante la implementación de RDMA (acceso directo a memoria remota): acceso directo a la memoria de los sistemas en el clúster.

RDMA: una forma de reducir los retrasos en la transmisión

RDMA no es una idea nueva. La tecnología proporciona un intercambio directo de datos entre la memoria y la interfaz de red, reduciendo la latencia y eliminando la copia innecesaria de datos a los buffers. Sus raíces se remontan a la década de 1990 por Compaq, Intel y Microsoft.

Hay tres tipos de retrasos en la transmisión de un paquete de un sistema a otro:

- debido al procesamiento del procesador necesario, por ejemplo, para almacenar datos en el sistema operativo y calcular sumas de verificación;

- debido a los buses y canales de transmisión de datos (es técnicamente imposible aumentar significativamente el ancho de banda);

- debido a equipos de red.

Para reducir las pérdidas a lo largo de esta cadena, ya en la década de 1990, se propuso utilizar el acceso directo a la memoria de los sistemas que interactúan, un modelo abstracto de arquitectura de interfaz virtual. Su idea principal es que las aplicaciones que se ejecutan en dos sistemas interactivos llenan completamente su memoria local y establecen una conexión P2P para la transferencia de datos sin afectar el sistema operativo. De esta manera, los retrasos en la transmisión de paquetes se pueden reducir significativamente. Además, dado que el modelo VIA no implicaba colocar los datos transmitidos en memorias intermedias intermedias, ahorró los recursos necesarios para la operación de copia.

Con respecto al modelo abstracto, VIA RDMA, como tecnología, ha dado un paso más hacia la utilización óptima de los recursos. En particular, no espera a que se llene el búfer para establecer una conexión y permite conexiones a varias computadoras simultáneamente. Debido a esto, la tecnología puede reducir los retrasos de transmisión de hasta 1 ms, lo que reduce la carga en el procesador.

InfiniBand vs Ethernet

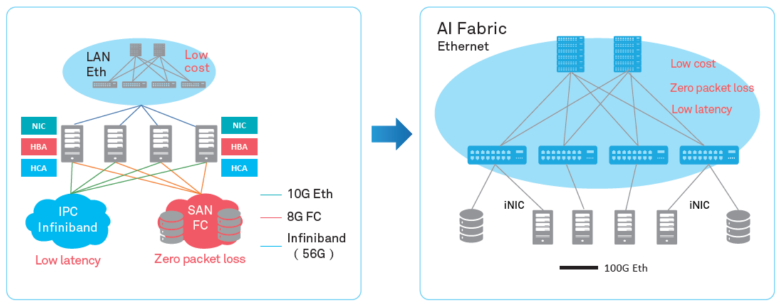

Lamentablemente, las dos principales implementaciones de RDMA en el mercado: el protocolo de transporte patentado InfiniBand y el RDMA "puro" basado en Ethernet, no están exentos de inconvenientes.

El protocolo de transporte InfiniBand tiene un mecanismo de control de entrega de paquetes incorporado (protección de pérdida de datos), pero es compatible con equipos específicos y no es compatible con Ethernet. De hecho, el uso de este protocolo cierra el centro de datos en un proveedor de equipos, lo que conlleva ciertos riesgos y promete dificultades en términos de servicio (dado que InfiniBand tiene una pequeña participación en el mercado, no será tan fácil encontrar especialistas). Bueno, por supuesto, al implementar el protocolo, no puede usar el equipo de red IP existente.

RDMA sobre Ethernet le permite usar el equipo existente en la red, admite redes Ethernet, lo que significa que será más fácil encontrar especialistas en servicio. En comparación con Infiniband, esto reduce significativamente el costo de propiedad de la infraestructura y simplifica su implementación.

El único inconveniente grave que impidió la adopción generalizada de RDMA a través de Ethernet es la falta de protección contra la pérdida de paquetes, lo que limita el ancho de banda de toda la red. Se deben utilizar mecanismos de terceros para reducir la pérdida de paquetes o prevenir la congestión de la red. Seguimos este camino, ofreciendo nuestros propios algoritmos inteligentes para compensar las desventajas de RDMA a través de Ethernet, manteniendo sus ventajas en la nueva herramienta: Huawei Ai Fabric.

Huawei AI Fabric: su camino

AI Fabric implementa RDMA a través de Ethernet, complementado por su propio algoritmo inteligente de gestión de congestión de red, que proporciona cero pérdida de paquetes, alto ancho de banda de red y bajo retraso de transmisión para transmisiones RDMA.

Huawei Ai Fabric se basa en estándares abiertos y admite una variedad de equipos diferentes, lo que optimiza el proceso de implementación. Sin embargo, algunas herramientas adicionales, complementos sobre estándares abiertos, que permiten aumentar la eficiencia del intercambio de datos, que discutiremos en publicaciones posteriores, están disponibles solo para dispositivos fabricados por Huawei. Los conmutadores de la serie CloudEngine que admiten la solución tienen un chip integrado que analiza las características del tráfico y ajusta dinámicamente los parámetros de red, lo que permite un uso más eficiente del búfer del conmutador. Las características recopiladas también se utilizan para predecir futuros patrones de tráfico.

¿Para quién es útil esto?

Huawei Ai Fabric le permite obtener ganancias en dos niveles.

Por un lado, la solución permite optimizar la arquitectura del centro de datos, reduciendo el número de nodos (debido a una utilización más óptima de los recursos), creando un entorno convergente sin la separación tradicional en subredes separadas, que son difíciles y costosas de mantener en partes. Con la herramienta, no tiene que seleccionar subredes separadas para cada tipo de servicio en el controlador de dominio (con sus propios requisitos de red). Puede crear un entorno único que brinde todos los servicios.

Por otro lado, AI Fabric le permite aumentar la velocidad de la computación distribuida, especialmente donde a menudo necesita acceder a la memoria de sistemas remotos. Por ejemplo, la introducción de IA en cualquier campo implica un período de aprendizaje del algoritmo, que puede incluir millones de operaciones, por lo que la ganancia en el retraso en cada operación dará como resultado una aceleración grave del proceso.

El efecto de introducir una herramienta especializada, como Huawei Ai Fabric, se notará en un centro de datos con seis o más conmutadores. Pero cuanto mayor sea el centro de datos, mayores serán las ganancias: debido a la utilización óptima de los recursos, un clúster de la misma escala con Ai Fabric proporcionará un mayor rendimiento. Por ejemplo, un grupo de 384 nodos puede lograr el rendimiento de un grupo "regular" de 512 nodos. Además, la solución no tiene restricciones en la cantidad de conmutadores físicos dentro de la infraestructura. Puede haber decenas de miles (si olvida que los proyectos generalmente se limitan al tamaño del dominio administrativo).