En la

primera parte de este texto, examinamos cámaras de profundidad basadas en luz estructural y mediciones de retardo de luz de ida y vuelta, que utilizan principalmente iluminación infrarroja. Funcionan muy bien en interiores a distancias de 10 centímetros a 10 metros, y lo más importante: son muy baratos. De ahí la ola masiva de su uso actual en teléfonos inteligentes. Pero ... Tan pronto como salimos, el sol, incluso a través de las nubes, ilumina la luz infrarroja y su trabajo se deteriora bruscamente.

Como dice Steve Blank (sin embargo,

por otra razón ): "Si quieres tener éxito, sal del edificio". A continuación hablaremos sobre cámaras de profundidad que trabajan al aire libre. Hoy este tema está fuertemente impulsado por los automóviles autónomos, pero, como veremos, no solo.

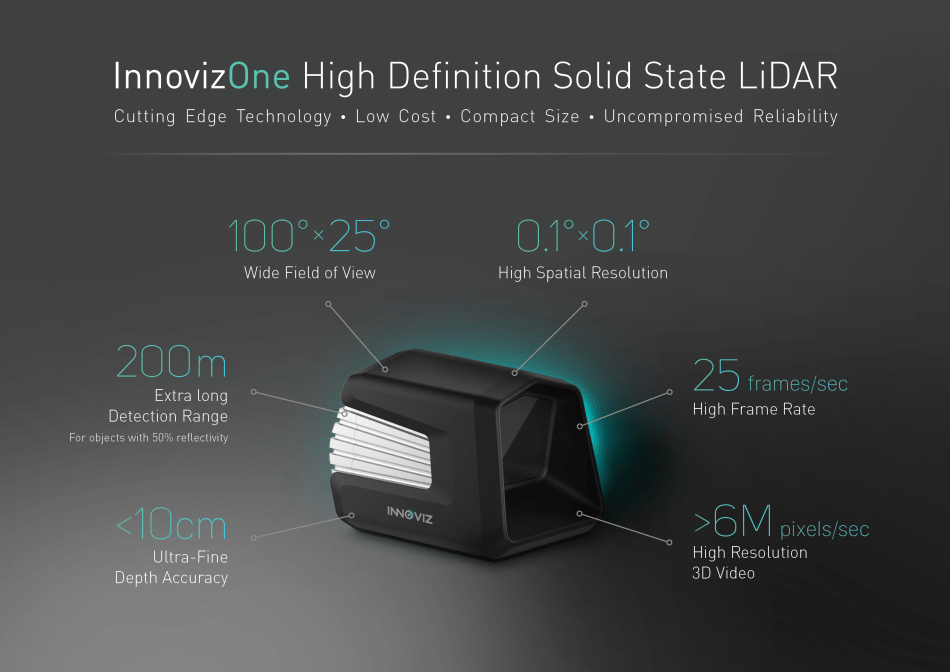

Fuente: Innoviz prevé autos autónomos producidos en masa con LiDAR de estado sólido

Fuente: Innoviz prevé autos autónomos producidos en masa con LiDAR de estado sólidoEntonces, cámaras de profundidad, es decir dispositivos que graban video, en cada píxel de los cuales la distancia al objeto de la escena, ¡funcionan a la luz del sol!

¿A quién le importa? ¡Bienvenido a Kat!

Comencemos con los clásicos atemporales ...

Método 3: Profundidad de la cámara estéreo +

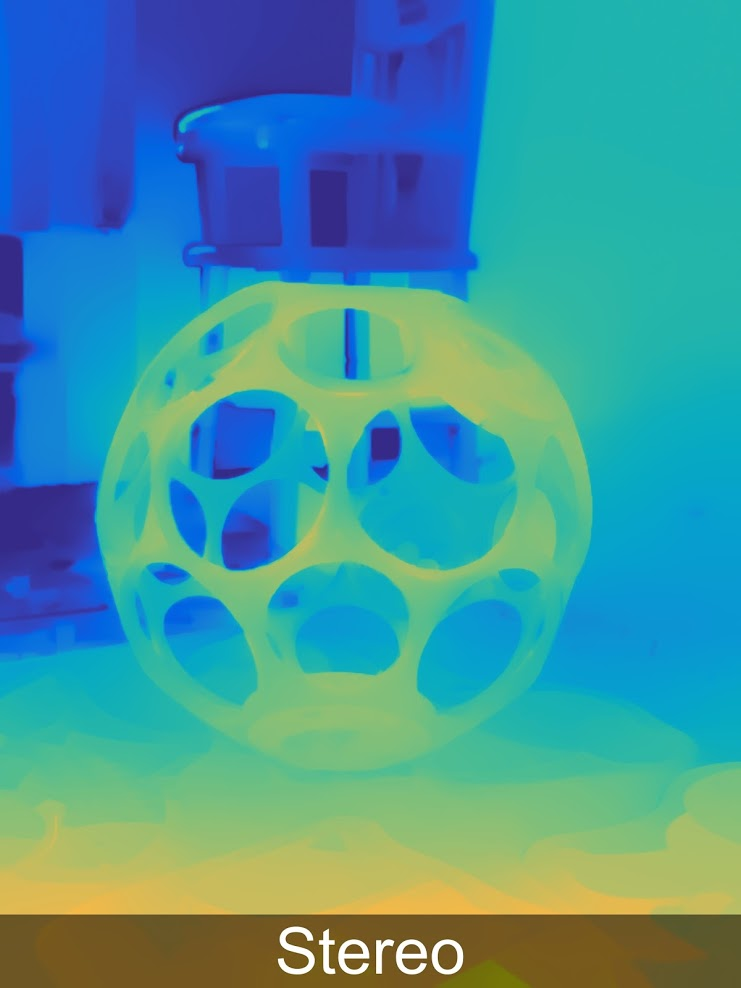

La construcción de un mapa de profundidad desde estéreo es bien conocida y se ha utilizado durante

más de 40 años . A continuación se muestra un ejemplo de una cámara compacta por $ 450, que se puede utilizar para controlar los gestos, junto con la fotografía profesional o con cascos de realidad virtual:

Fuente

FuenteLa principal ventaja de estas cámaras es que la luz solar no solo no las molesta, sino que viceversa, mejora sus resultados y, como resultado, el uso activo de tales cámaras para todo tipo de casos en la calle, por ejemplo, es un gran ejemplo de cómo disparar un modelo tridimensional de un antiguo fuerte en un par de minutos:

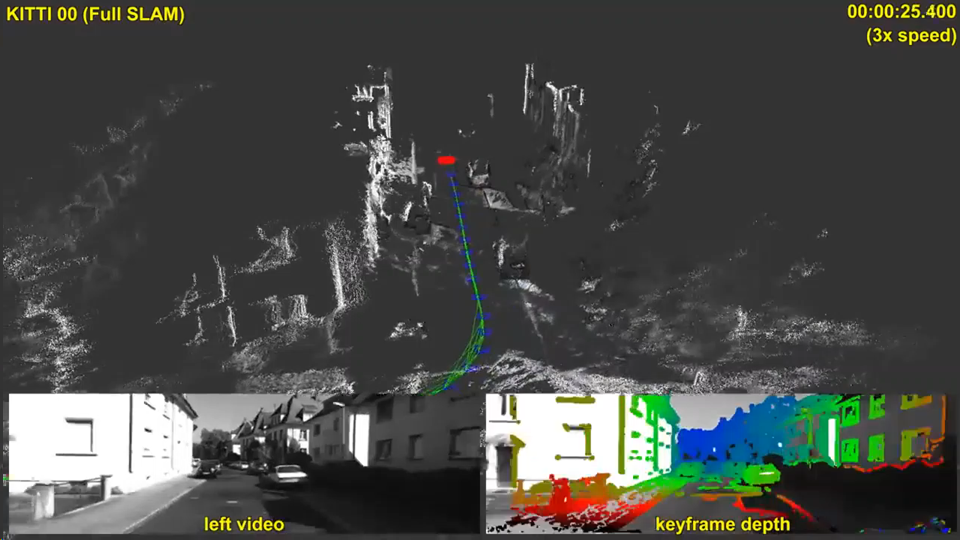

Un ejemplo del uso en la calle de la cámara ZEDEl dinero notable en la traducción de la construcción de la profundidad del estéreo a un nuevo nivel fue influenciado, por supuesto, por el tema de los automóviles autónomos. De los 5 métodos considerados para construir un video de profundidad, solo dos: este y el siguiente (estéreo y pleóptico) no interfieren con el sol y no interfieren con los automóviles vecinos. Al mismo tiempo, los pleópticos son muchas veces más caros y menos precisos a largas distancias. De todos modos, las cosas pueden suceder de todos modos; es difícil hacer pronósticos, pero en este caso vale la pena estar de acuerdo con Elon Mask: el estéreo de los 5 métodos tiene las mejores perspectivas. Y los resultados actuales son muy alentadores:

Fuente: SLAM directo a gran escala con cámaras estéreo

Fuente: SLAM directo a gran escala con cámaras estéreoPero es interesante que parezca que no los vehículos no tripulados (de los cuales pocos se han producido hasta ahora), sino dispositivos mucho más masivos, donde se está construyendo un mapa de profundidad estéreo ahora, tendrán una influencia aún más fuerte en el desarrollo de la profundidad de construcción desde estéreo, es decir ... ¡Eso es correcto! Smartphones!

Hace tres años, simplemente se produjo el auge de los teléfonos inteligentes "de dos ojos", en los que se notaron prácticamente todas las marcas, porque la calidad de las fotos tomadas con una cámara y la calidad de las fotos tomadas con dos diferían drásticamente, pero desde el punto de vista de aumentar el precio de un teléfono inteligente esto no fue tan significativo:

Además, el año pasado el proceso fue aún más lejos: "¿Tiene 2 cámaras en su teléfono inteligente? Apesta Tengo

tres cuatro !!! ":

Fuente: Samsung Galaxy A8 y A9

Fuente: Samsung Galaxy A8 y A9El futuro Sony de seis ojos fue mencionado en la primera parte. En general, los teléfonos inteligentes con múltiples ojos están ganando bastante popularidad entre los fabricantes.

Las causas fundamentales de este fenómeno son simples:

- La resolución de los teléfonos con cámara está creciendo y el tamaño de la lente es pequeño. Como resultado, a pesar de numerosos trucos, el nivel de ruido aumenta y la calidad disminuye, especialmente cuando se dispara en la oscuridad.

- Además, en la segunda cámara, podemos eliminar el llamado filtro Bayer de la matriz, es decir. una cámara será en blanco y negro, y el segundo color. Esto aumenta la sensibilidad en blanco y negro en aproximadamente 3 veces. Es decir la sensibilidad de 2 cámaras crece condicionalmente no 2, sino 4 veces (!). Existen numerosos matices, pero tal aumento en la sensibilidad es realmente claramente visible a simple vista.

- Entre otras cosas, cuando aparece un par estéreo, tenemos la oportunidad de cambiar programáticamente la profundidad de campo, es decir. difumina el fondo, del cual muchas fotos se benefician significativamente (escribimos sobre esto en la segunda mitad aquí ). Esta opción de nuevos modelos de teléfonos inteligentes se hizo rápidamente muy popular.

- Con un aumento en la cantidad de cámaras, también es posible usar otras lentes: más gran angular (enfoque corto) y, por el contrario, enfoque largo, lo que puede mejorar significativamente la calidad al "acercarse" a objetos.

- Curiosamente, un aumento en el número de cámaras nos acerca al tema de un campo de luz enrarecido, que tiene muchas de sus características y ventajas, sin embargo, esta es una historia diferente.

- También observamos que aumentar el número de cámaras le permite aumentar la resolución mediante métodos de recuperación de resolución .

En general, hay tantas ventajas que, cuando las personas los conocen, comienzan a preguntarse por qué no se han configurado al menos 2 cámaras durante mucho tiempo.

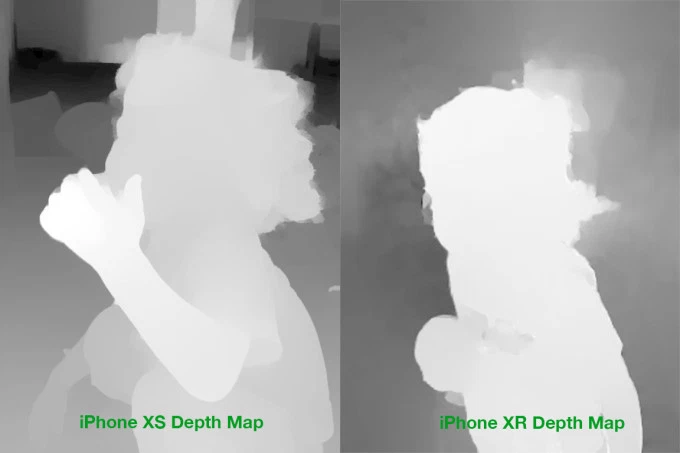

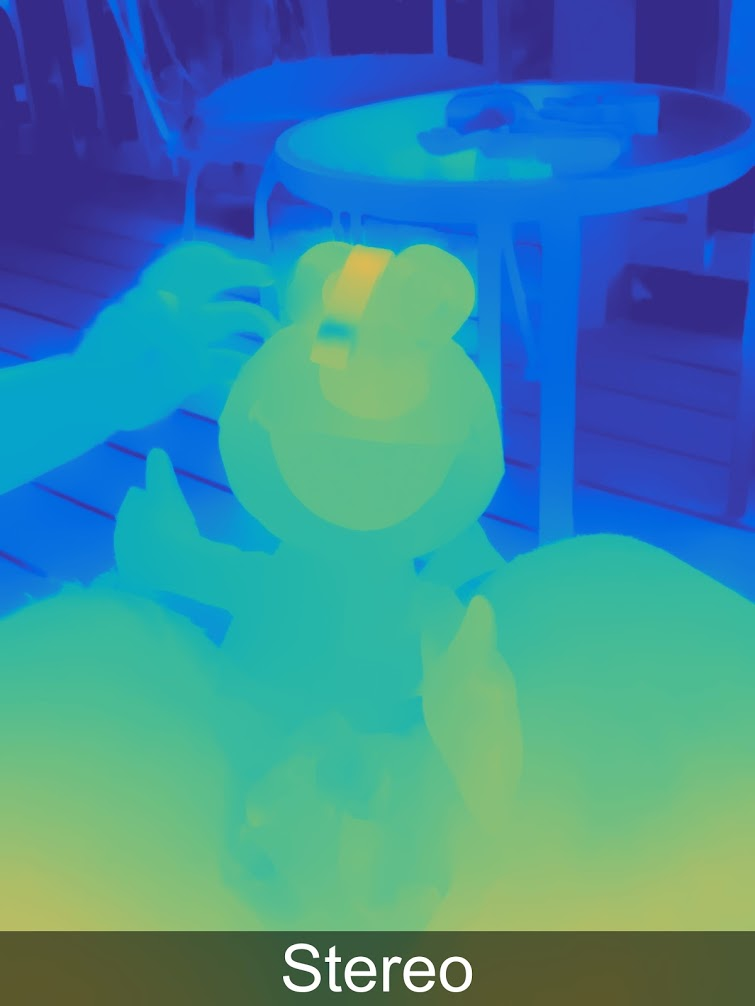

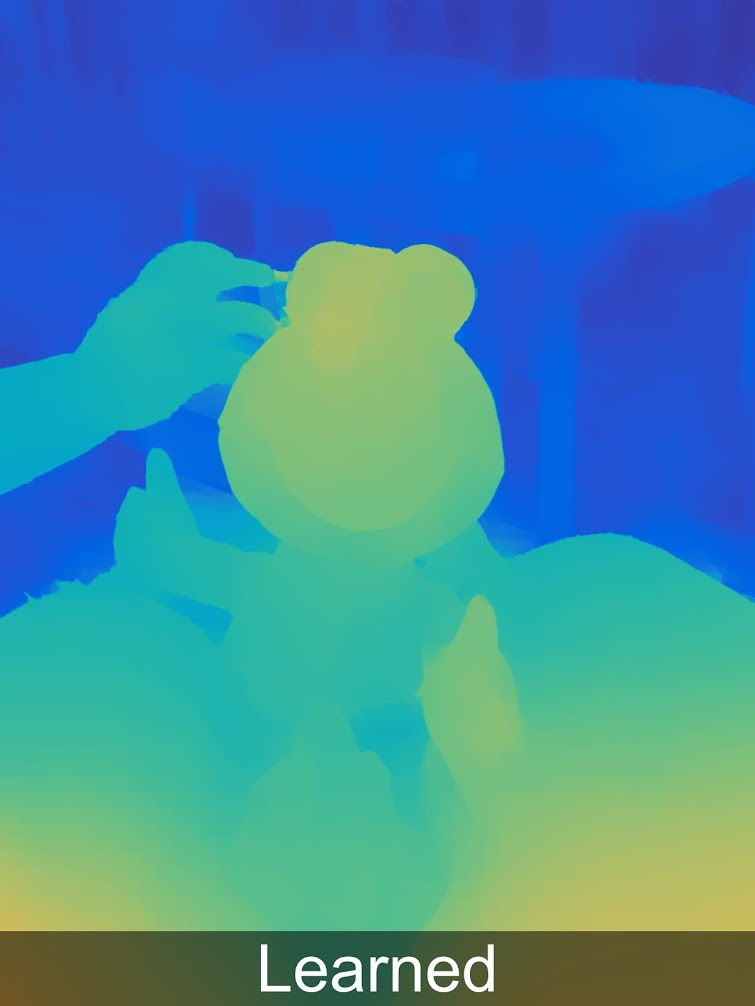

Y luego resulta que no todo es tan simple. Para utilizar significativamente cámaras adicionales para mejorar la imagen (y no solo cambiar a una cámara con una lente diferente), estamos obligados a construir un llamado mapa de disparidad, que se convierte directamente en un mapa de profundidad. Y esta es una tarea muy trivial, a cuya solución acaba de llegar el poder de los teléfonos inteligentes. E incluso ahora, los mapas de profundidad son a menudo de una calidad bastante dudosa. Es decir, antes de que la coincidencia exacta "píxel en la imagen de la derecha con el píxel de la izquierda" todavía necesite sobrevivir. Por ejemplo, aquí hay ejemplos reales de mapas de profundidad para iPhone:

Fuente: Comparación de mapas de profundidad de iPhone XS y XR

Fuente: Comparación de mapas de profundidad de iPhone XS y XRIncluso a simple vista, los problemas de masas son claramente visibles en el fondo, en los bordes, no digo nada sobre el cabello

translúcido . Por lo tanto, existen numerosos problemas que surgen tanto al transferir el color de una cámara en blanco y negro a una de color como durante el procesamiento posterior.

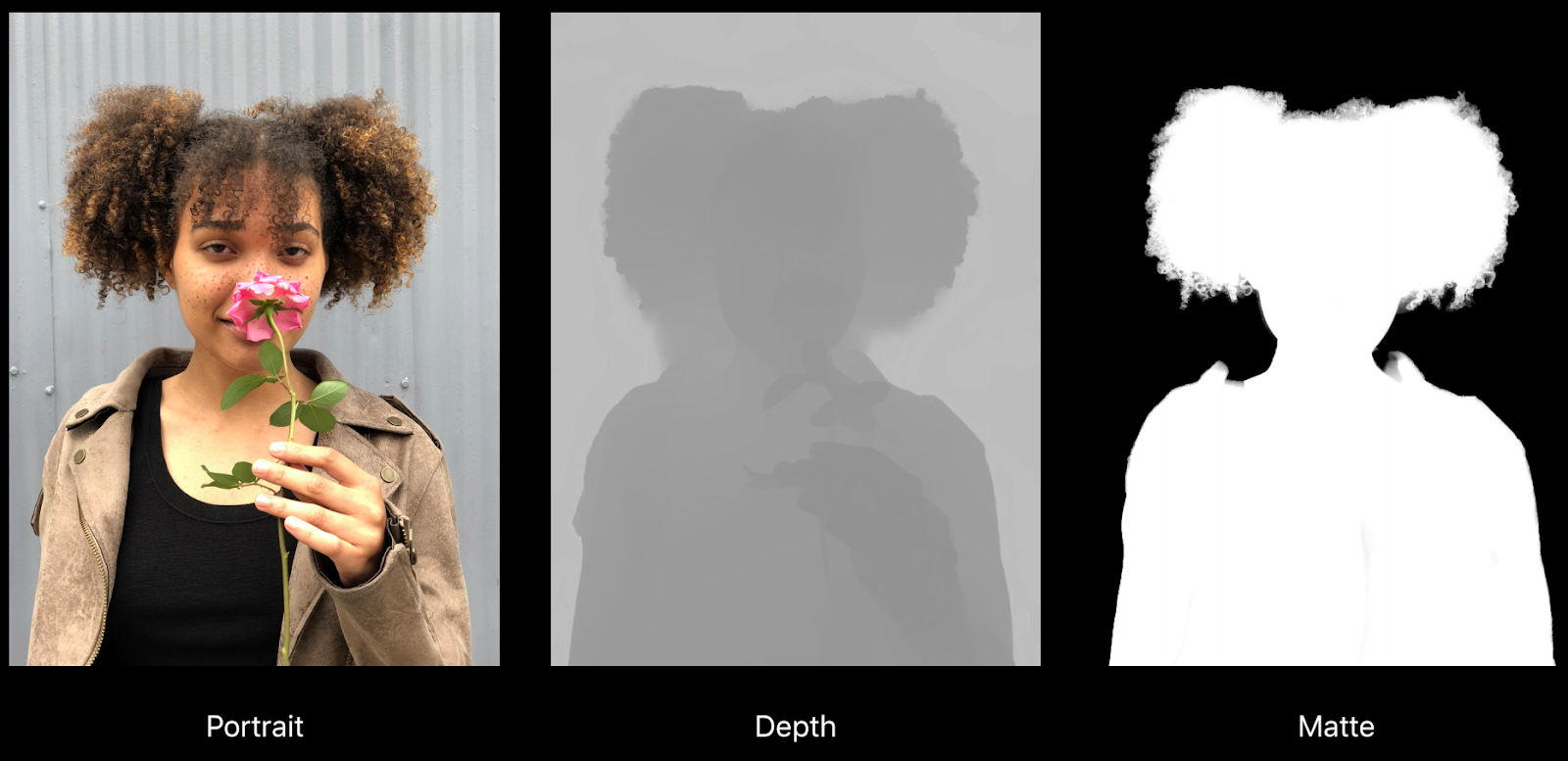

Por ejemplo, aquí hay un buen ejemplo de un informe sobre "Creación de efectos de fotos y videos usando la profundidad" de Apple:

Fuente: Creación de efectos de foto y video • Uso de profundidad, Apple, WWDC18

Fuente: Creación de efectos de foto y video • Uso de profundidad, Apple, WWDC18Puede ver claramente cómo la profundidad tiene errores debajo del cabello y, de hecho, contra un fondo más o menos uniforme, pero lo que es más importante, en el mapa de alfombrilla derecho el collar quedó en el fondo (es decir, estará borroso). Otro problema es la resolución real de la profundidad y el mapa mate es significativamente menor que la resolución de la imagen, lo que también afecta la calidad durante el procesamiento:

Sin embargo, todo esto es un problema de crecimiento. Si hace 4 años no había dudas sobre los efectos graves en el video, el teléfono simplemente "no los tiró", pero hoy el procesamiento de video con profundidad se muestra en los principales teléfonos seriales (fue en la misma presentación de Apple):

Fuente: Creación de efectos de foto y video • Uso de profundidad, Apple, WWDC18

Fuente: Creación de efectos de foto y video • Uso de profundidad, Apple, WWDC18En general, el tema de los teléfonos multi-multi-celulares y, como resultado, el tema de obtener profundidad del estéreo en los teléfonos móviles, conquista a las masas sin luchar:

Fuente: "encontrado en estos de su internet"

Fuente: "encontrado en estos de su internet"Hallazgos clave:

- La profundidad del estéreo, en términos del costo del equipo, es la forma más económica de obtener profundidad, ya que las cámaras ahora son económicas y continúan haciéndose más baratas rápidamente. La dificultad es que el procesamiento adicional requiere muchos más recursos que otros métodos.

- En los teléfonos móviles no puede aumentar el diámetro de la lente, mientras que la resolución crece rápidamente. Como resultado, el uso de dos o más cámaras puede mejorar significativamente la calidad de la foto, reducir el ruido en condiciones de poca luz y aumentar la resolución. Dado que hoy en día se elige un teléfono móvil por la calidad de la cámara, esta es una ventaja extremadamente tangible. La construcción de un mapa de profundidad es una ventaja adicional discreta.

- Las principales desventajas de construir profundidad desde estéreo:

- Tan pronto como la textura desaparece o simplemente se vuelve menos contrastante, el ruido aumenta bruscamente en profundidad, como resultado, incluso en objetos planos, la profundidad a menudo se usa de manera deficiente (son posibles errores graves).

- Además, la profundidad está mal determinada en objetos delgados y pequeños (dedos "cortados", o incluso manos, columnas hundidas, etc.)

- Tan pronto como el poder del hierro le permita construir un mapa de profundidad para video, la profundidad en los teléfonos inteligentes dará un poderoso impulso al desarrollo de AR (en algún momento, completamente inesperado para el público, la calidad de las aplicaciones de AR en todos los nuevos modelos de teléfonos, incluidos los económicos, de repente se volverá notablemente más alta y una nueva ola irá) . Totalmente inesperado!

El siguiente método es menos trivial y famoso, pero muy bueno. Conoceme

Método 4: cámaras de profundidad de campo claro

El tema de los pleópticos (del latín plenus - full y optikos - visual) o campos ligeros todavía es relativamente poco conocido por las masas, aunque los profesionales comenzaron a tratarlo muy densamente. Se asignaron secciones separadas para artículos sobre Light Field en muchas de las principales conferencias (el autor se sorprendió una vez por el número de investigadores asiáticos en la Conferencia Internacional de IEEE sobre Multimedia y Expo que están estrechamente involucrados en este tema).

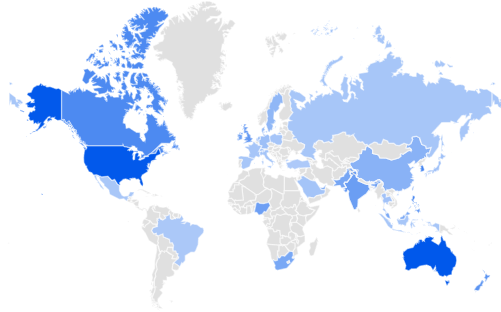

Google Trends dice que Estados Unidos y Australia lideran en interés en Light Field, seguidos de Singapur y Corea. Gran bretaña Rusia está en el lugar 32 ... Vamos a corregir el retraso de la India y Sudáfrica:

Fuente: Tendencias de Google

Fuente: Tendencias de GoogleSu humilde servidor hace algún tiempo hizo un

artículo detallado sobre Habré con una descripción detallada de cómo funciona y qué ofrece, así que repasemos brevemente.

La idea principal es tratar de arreglar en cada punto no solo la luz, sino una matriz bidimensional de rayos de luz, haciendo que cada cuadro sea tetradimensional. En la práctica, esto se hace usando una variedad de microlentes:

Fuente: plenoptic.inf® (se recomienda hacer clic y ver en resolución completa)

Fuente: plenoptic.inf® (se recomienda hacer clic y ver en resolución completa)Como resultado, tenemos

muchas nuevas oportunidades , pero la resolución está cayendo seriamente. Después de resolver muchos problemas técnicos complicados, aumentaron radicalmente la resolución en

Lytro (comprado por Google), donde en Lytro Cinema la resolución del sensor de la cámara se incrementó a 755 megapíxeles de datos RAW, y se veía voluminosa como las primeras cámaras:

Fuente: NAB: se presenta la nueva cámara Lytro Light-Field que podría traer grandes cambios al trabajo de efectos visuales

Fuente: NAB: se presenta la nueva cámara Lytro Light-Field que podría traer grandes cambios al trabajo de efectos visualesEs interesante que incluso los profesionales evalúen incorrectamente con regularidad la caída de resolución de las cámaras pleópticas, porque subestiman lo bien que pueden trabajar en algoritmos de

Super Resolución que realmente restauran perfectamente muchos detalles de los micro-cambios de la imagen en el campo de luz (preste atención a agujas de tejer borrosas y movimientos de fondo en movimiento) :

Fuente: Restauración de cuadros pleópticos ingenuos, inteligentes y de súper resolución del Informe técnico de Adobe "Superresolución con cámara plenoptic 2.0"

Fuente: Restauración de cuadros pleópticos ingenuos, inteligentes y de súper resolución del Informe técnico de Adobe "Superresolución con cámara plenoptic 2.0"Todo esto sería de interés relativamente teórico si Google no hubiera implementado los pleópticos en Pixel 2 al

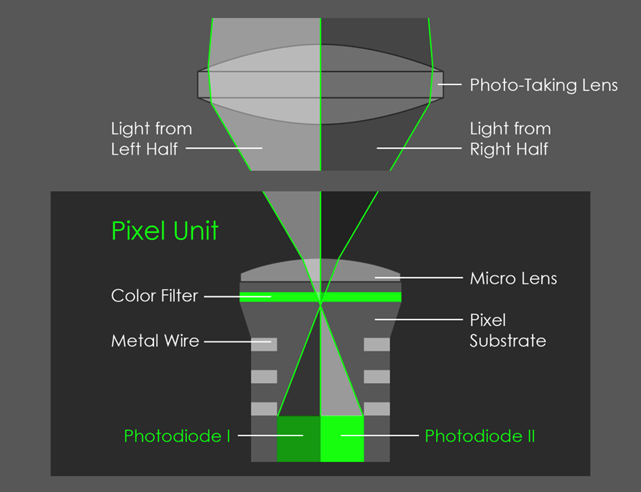

cubrir 2 píxeles con una lente :

Fuente: AI Google Blog

Fuente: AI Google BlogComo resultado, se formó un micro estereopar, que permitió MEDIR la profundidad a la que Google, fiel a las nuevas tradiciones, agregó redes neuronales, y en general resultó notablemente:

Más ejemplos de profundidad en resolución completa

en una galería especial .

Curiosamente, la profundidad es almacenada por Google (como Huawei y otros) en la imagen misma, por lo que puede extraerla desde allí y ver:

Fuente: Tres características secretas de la nueva aplicación de cámara de Google que te dejarán boquiabierto

Fuente: Tres características secretas de la nueva aplicación de cámara de Google que te dejarán boquiabiertoY luego puedes convertir la foto en tridimensional:

Fuente: Tres características secretas de la nueva aplicación de cámara de Google que te dejarán boquiabierto

Fuente: Tres características secretas de la nueva aplicación de cámara de Google que te dejarán boquiabiertoPuedes experimentar de forma independiente con esto en el sitio

http://depthy.me , donde puedes subir tu foto. Curiosamente, el sitio

está disponible en la fuente , es decir el procesamiento en profundidad se puede mejorar, hay muchas oportunidades para esto, ahora los algoritmos de procesamiento más simples se aplican allí.

Puntos clave:

- En una de las conferencias de Google, se anunció que, quizás, 4 píxeles se cubrirían con una lente. Esto reducirá la resolución directa del sensor, pero mejorará drásticamente el mapa de profundidad. En primer lugar, debido a la aparición de pares estéreo en dos direcciones perpendiculares, y en segundo lugar, debido al hecho de que la base estéreo aumentará condicionalmente en 1,4 veces (dos diagonales). Esto también significa una mejora notable en la precisión de profundidad a distancia.

- Plenoptics en sí (también es una fotografía calculada) hace posible:

- El cambio "honesto" de enfoque y profundidad de campo después del disparo es la capacidad más conocida de los sensores pleópticos.

- Calcular la forma de apertura.

- Calcule la iluminación de la escena.

- Cambie un poco el punto de disparo, incluida la recepción de estéreo (o marco de múltiples ángulos) con una lente.

- Calcule la resolución, porque utilizando la gran complejidad computacional de los algoritmos de Super Resolución, en realidad puede restaurar el marco.

- Calcular un mapa de transparencia para bordes translúcidos.

- Y finalmente, construya un mapa de profundidad, que es importante hoy.

- Potencialmente, cuando la cámara principal del teléfono puede construir un mapa de profundidad de alta calidad en tiempo real en paralelo con el disparo, esto creará una revolución . Esto depende en gran medida de la potencia informática a bordo (esto es lo que nos impide hacer mapas de profundidad mejores y de mayor resolución en tiempo real hoy). Esto es muy interesante para AR, por supuesto, pero habrá muchas oportunidades para cambiar las fotos.

Y finalmente, pasamos al último en este método de revisión para medir la profundidad.

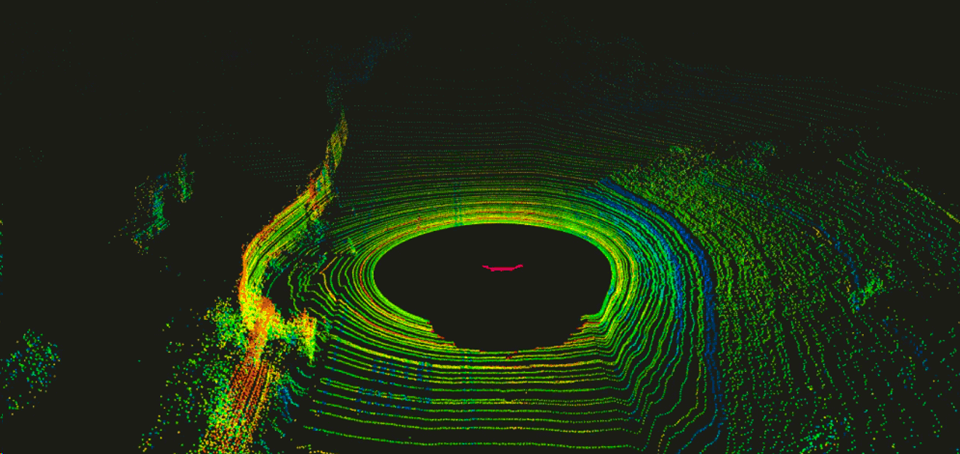

Método 5: cámaras en tecnologías LIDAR

En general,

los telémetros láser están firmemente arraigados en nuestras vidas, son económicos y proporcionan una alta precisión. Los primeros lidares (de LIDaR -

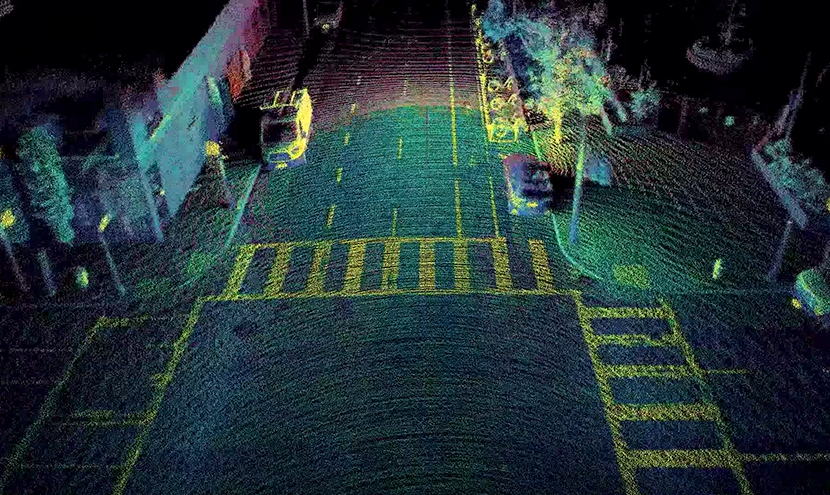

Light Identification Detection and Ranging ), construidos como paquetes de dispositivos similares que giran alrededor de un eje horizontal, fueron utilizados por primera vez por los militares, luego fueron probados en pilotos automáticos de automóviles. Resultó ser bastante bueno allí, lo que provocó un fuerte aumento de la inversión en la región. Inicialmente, los lidares giraron, dando una imagen similar varias veces por segundo:

Fuente: Introducción a LIDAR: el sensor clave del automóvil autónomo

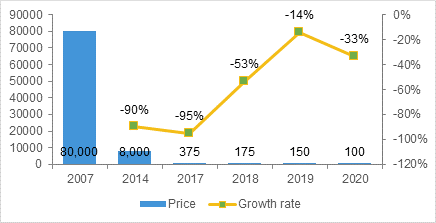

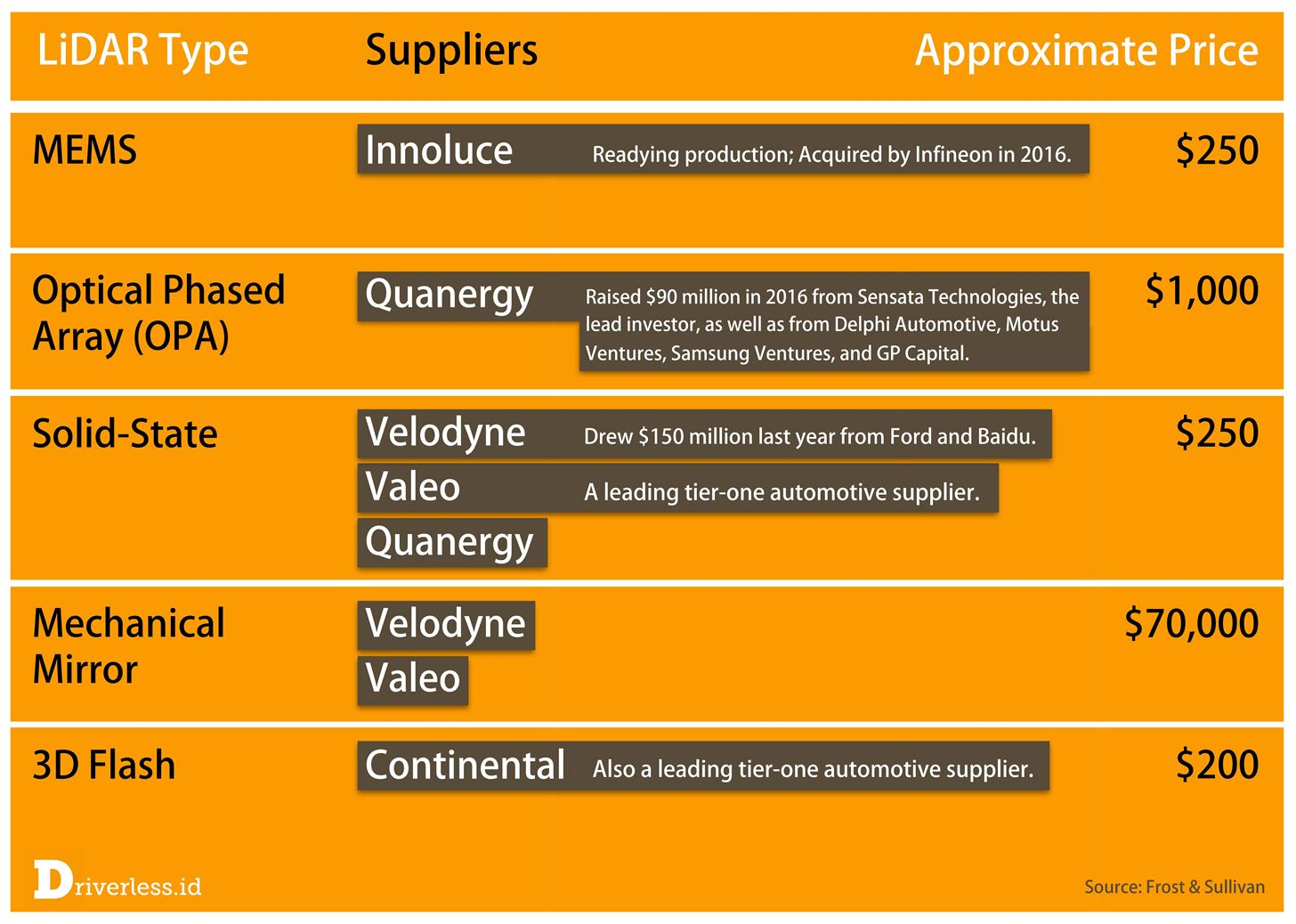

Fuente: Introducción a LIDAR: el sensor clave del automóvil autónomoEra incómodo, poco confiable debido a las partes móviles y bastante costoso.

Tony Ceba en sus conferencias proporciona datos interesantes sobre la tasa de disminución en el costo de los lidares. Si los lidares cuestan $ 70 mil para las primeras máquinas autónomas de Google (por ejemplo, el

HDL-64E especializado utilizado en las primeras máquinas cuesta 75 mil):

Fuente: Esto y lo siguiente del estacionamiento a los parques: Bellevue y la interrupción del transporte

Fuente: Esto y lo siguiente del estacionamiento a los parques: Bellevue y la interrupción del transporteLuego, en la producción en masa, los nuevos modelos de las próximas generaciones amenazan con reducir el precio significativamente menos de $ 1000:

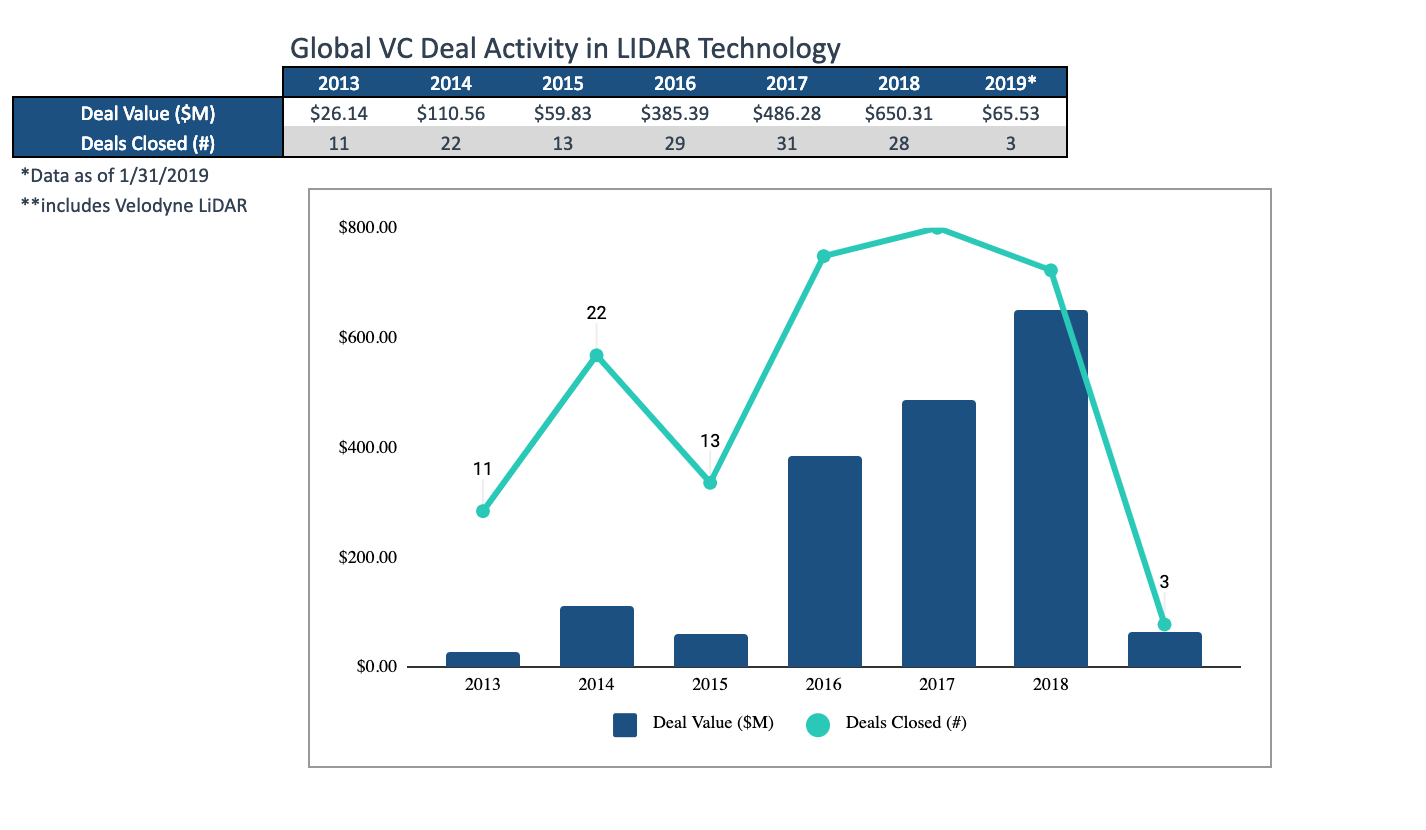

Uno puede discutir sobre el ejemplo de Tony (la promesa de una startup no es el costo final), pero que hay un auge en la investigación en esta área, el rápido aumento en las corridas de producción, la aparición de productos completamente nuevos y una disminución general en los precios son indiscutibles. Un poco más tarde en 2017, el pronóstico para una caída en los precios fue el siguiente (y el momento de la verdad llegará cuando se los ponga en los autos):

Fuente: LiDAR completa la detección del triunvirato

Fuente: LiDAR completa la detección del triunviratoEn particular, relativamente recientemente, varios fabricantes lanzaron de inmediato el llamado

Lidar de estado sólido , que básicamente no tiene partes móviles que muestren una confiabilidad radicalmente más alta, especialmente cuando se sacude,

cuesta menos , etc. Recomiendo ver este video, donde su dispositivo se explica en 84 segundos con mucha claridad:

Fuente: Sensor Lidar de estado sólidoLo importante para nosotros es que Lidar de estado sólido da una imagen rectangular, es decir de hecho, comienza a funcionar como una cámara de profundidad "normal":

Fuente: Innoviz prevé autos autónomos producidos en masa con LiDAR de estado sólido

Fuente: Innoviz prevé autos autónomos producidos en masa con LiDAR de estado sólidoEl ejemplo anterior ofrece un video de aproximadamente 1024x256, 25 FPS, 12 bits por componente. Dichos lidares se montarán debajo de la parrilla de la campana (ya que el dispositivo se calienta bien)

Fuente: LiDAR Magna Electronics de estado sólido

Fuente: LiDAR Magna Electronics de estado sólidoComo de costumbre, los chinos están encendidos, quienes están hoy en primer lugar en el mundo en la producción de vehículos eléctricos y claramente apuntan al primer lugar en el mundo en autos autónomos:

Fuente: Alibaba, RoboSense lanza vehículo no tripulado utilizando LIDAR de estado sólido

Fuente: Alibaba, RoboSense lanza vehículo no tripulado utilizando LIDAR de estado sólidoEn particular, sus experimentos con un "píxel" de profundidad no cuadrado son interesantes, si realiza un procesamiento conjunto con una cámara RGB, puede aumentar la resolución y esto es un compromiso bastante interesante (el "cuadrado" de píxeles es importante, de hecho, solo para una persona):

Fuente: MEMS Lidar para vehículos sin conductor da otro gran paso

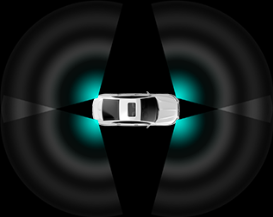

Fuente: MEMS Lidar para vehículos sin conductor da otro gran pasoLos lidares se montan en diferentes esquemas dependiendo del costo del kit y la potencia del sistema de a bordo, que necesitará procesar todos estos datos. En consecuencia, las características generales del piloto automático también cambian. Como resultado, los autos más caros estarán mejor transportando carreteras polvorientas y más fáciles de "esquivar" los autos que ingresan a los autos en las intersecciones laterales, los baratos solo ayudarán a reducir la cantidad de (numerosos) embotellamientos estúpidos:

Fuente: Descripción RoboSense RS-LiDAR-M1

Fuente: Descripción RoboSense RS-LiDAR-M1Tenga en cuenta que, además de los bajos precios en estado sólido, prometen un par de áreas más en las que se están desarrollando los lidars. Predecir algo aquí es una tarea ingrata, ya que demasiado dependerá no de las características potenciales de ingeniería de la tecnología, sino, por ejemplo, de las patentes. Es solo que varias compañías ya están involucradas en estado sólido, por lo que el tema parece más prometedor. Pero no decir nada sobre el resto sería injusto:

Fuente: Este cuello de botella LiDAR 2017 está causando una fiebre del oro moderna

Fuente: Este cuello de botella LiDAR 2017 está causando una fiebre del oro modernaSi hablamos de lidars como cámaras, vale la pena mencionar otra característica importante que es importante cuando se usan lidars de estado sólido. Por su naturaleza, funcionan como cámaras con un

obturador en movimiento ya olvidado, que introduce distorsiones notables al disparar objetos en movimiento:

Fuente: ¿Cuál es la diferencia entre una persiana global (global) y una persiana enrollable ?

Fuente: ¿Cuál es la diferencia entre una persiana global (global) y una persiana enrollable ?Dado que en la carretera, especialmente en la autopista a una velocidad de 150 km / h, todo cambia bastante rápido, esta característica de los lidars distorsionará en gran medida los objetos, incluidos los que vuelan rápidamente hacia nosotros ... Incluyendo en profundidad ... Tenga en cuenta que los dos métodos anteriores obtener profundidad no es tal problema.

Fuente: bonita animación de Wikipedia que muestra la distorsión del automóvil

Fuente: bonita animación de Wikipedia que muestra la distorsión del automóvil, FPS , , .

, , - . , FPS, . , Lytro Cinema ( — , 300 FPS,

):

: Lytro poised to forever change filmmaking: debuts Cinema prototype and short film at NAB

: Lytro poised to forever change filmmaking: debuts Cinema prototype and short film at NAB, ( ) , .

- — , 1.5 (

10 6 , ):

: Techcrunch

: Techcrunch— 1.5-2 , . .

:

- :

- :

- ,

- ,

- el obturador en funcionamiento y la necesidad de compensarlo durante el procesamiento,

- los lidares cercanos interfieren entre sí, lo que no es tan fácil de compensar.

- Sin embargo, estamos observando cómo, literalmente en 2 años, esencialmente ha aparecido un nuevo tipo de cámaras de profundidad con excelentes perspectivas y un enorme mercado potencial. En los próximos años, podemos esperar una seria reducción en los precios, incluida la aparición de pequeños lidares universales para robots industriales.

Procesamiento de video con profundidad

En pocas palabras, considere por qué la profundidad no es tan fácil de manejar.

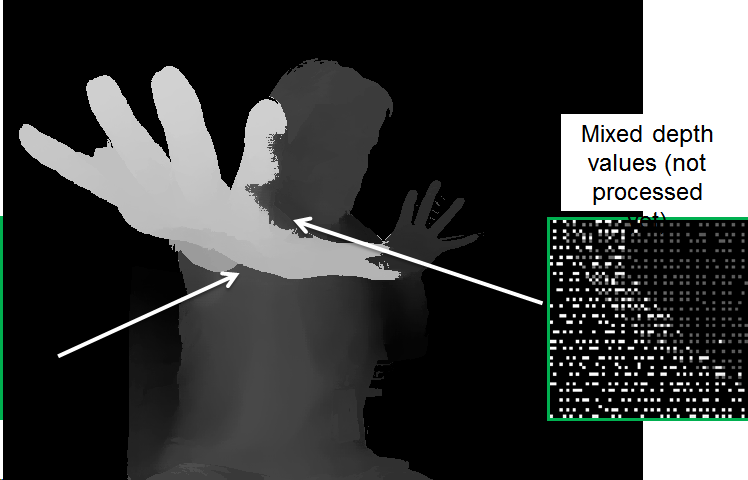

A continuación se muestra un ejemplo de datos sin procesar en profundidad de una muy buena línea de

cámaras Intel RealSense . En los dedos de este video, puede evaluar relativamente fácilmente "a simple vista" el funcionamiento de la cámara y los algoritmos de procesamiento:

Fuente: en adelante - los materiales del autor

Fuente: en adelante - los materiales del autorLos problemas típicos de las cámaras de profundidad son claramente visibles:

- El valor de los datos es inestable, los píxeles "ruido" en profundidad.

- A lo largo de los límites en un ancho bastante grande, los datos también son muy ruidosos (por esta misma razón, los valores de profundidad a lo largo de los bordes a menudo simplemente se enmascaran para no interferir con el trabajo).

- Alrededor de la cabeza se pueden ver muchos píxeles de "caminar" (aparentemente, la proximidad a la pared en la parte posterior + cabello comienza a influir).

Pero eso no es todo. Si miramos los datos más de cerca, está claro que en algunos lugares los datos más profundos "brillan" a los más cercanos:

Esto se debe a que, para la conveniencia del procesamiento, la imagen se reduce a la imagen de la cámara RGB, y dado que los límites no se determinan con precisión, se hace necesario procesar especialmente tales "superposiciones", de lo contrario surgen problemas, tales como "agujeros" en profundidad en el brazo:

Al procesar, hay muchos problemas, por ejemplo:

- "Fuga" de profundidad de un objeto a otro.

- Inestabilidad de la profundidad en el tiempo.

- Aliasing (la formación de una "escalera"), cuando la supresión del ruido en profundidad conduce a la discretización de los valores de profundidad:

Sin embargo, está claro que la imagen ha mejorado mucho. Tenga en cuenta que los algoritmos más lentos aún pueden mejorar significativamente la calidad.

En general, el

procesamiento de video en profundidad es un gran tema separado, que hasta ahora no está involucrado en tanta gente, pero que está ganando popularidad rápidamente. El mercado anterior, que cambió por completo, es la conversión de películas de 2D a 3D. El resultado de la construcción manual de estéreo a partir de video 2D mejoró tan rápidamente, mostró un resultado mucho más predecible, causó menos dolor de cabeza y menos costo que en el cine 3D, después de casi 100 años de filmación (!), Bastante rápidamente dejaron de filmar casi por completo y comenzaron a convertir solo . Incluso había una especialidad separada:

artista de profundidad , y los

estereógrafos de la vieja escuela estaban en estado de shock ("ka-ak-a-ak?"). Y el papel clave en esta revolución fue jugado por la rápida mejora de los algoritmos de procesamiento de video. Quizás algún día encuentre tiempo para escribir sobre esto una serie separada de artículos, porque mi material está en grandes cantidades.

Se puede esperar casi lo mismo en el futuro cercano para cámaras de profundidad de robots, teléfonos inteligentes y automóviles autónomos.

¡Despierta! La revolución se acerca!En lugar de una conclusión

Hace un par de años, su humilde servidor trajo una comparación de diferentes enfoques para obtener videos con profundidad en una sola placa. En general, durante este tiempo la situación no ha cambiado. La separación aquí es bastante arbitraria, ya que los fabricantes son conscientes de las desventajas de las tecnologías y tratan de compensarlas (a veces de manera extremadamente exitosa). Sin embargo, en general, se puede utilizar para comparar diferentes enfoques:

Fuente: materiales del autor.

Fuente: materiales del autor.Repasemos la mesa:

- Por resolución, la profundidad del estéreo está a la cabeza, pero todo depende mucho de la escena (si es monofónico, la cosa es una tubería).

- En términos de precisión , los lidares están más allá de la competencia, la situación con los pleópticos es la peor, por cierto.

- Por la complejidad del procesamiento , solo ToF y lidars obtienen la "profundidad" directamente, obtener profundidad de estéreo y pleópticos requiere muchos cálculos muy no triviales.

- Según FPS, las cámaras ToF son estructuralmente buenas y en el futuro cercano, cuando se levante la plancha, se verán atrapadas con cámaras estéreo (capaces de entregar hasta 300 fps). Lidaram hasta ahora solo sueña.

- Según los resultados en condiciones de poca luz, se espera que el estéreo y los pleópticos pierdan.

- Cuando trabaje al aire libre : las cámaras ToF y de luz estructurada no funcionan bien.

Al mismo tiempo, es importante comprender bien la situación en mercados específicos. Por ejemplo, el enfoque pleóptico parece claramente rezagado. Sin embargo, si resulta ser el mejor para AR (y esto quedará claro en los próximos 3-4 años), ocupará el lugar que le corresponde en

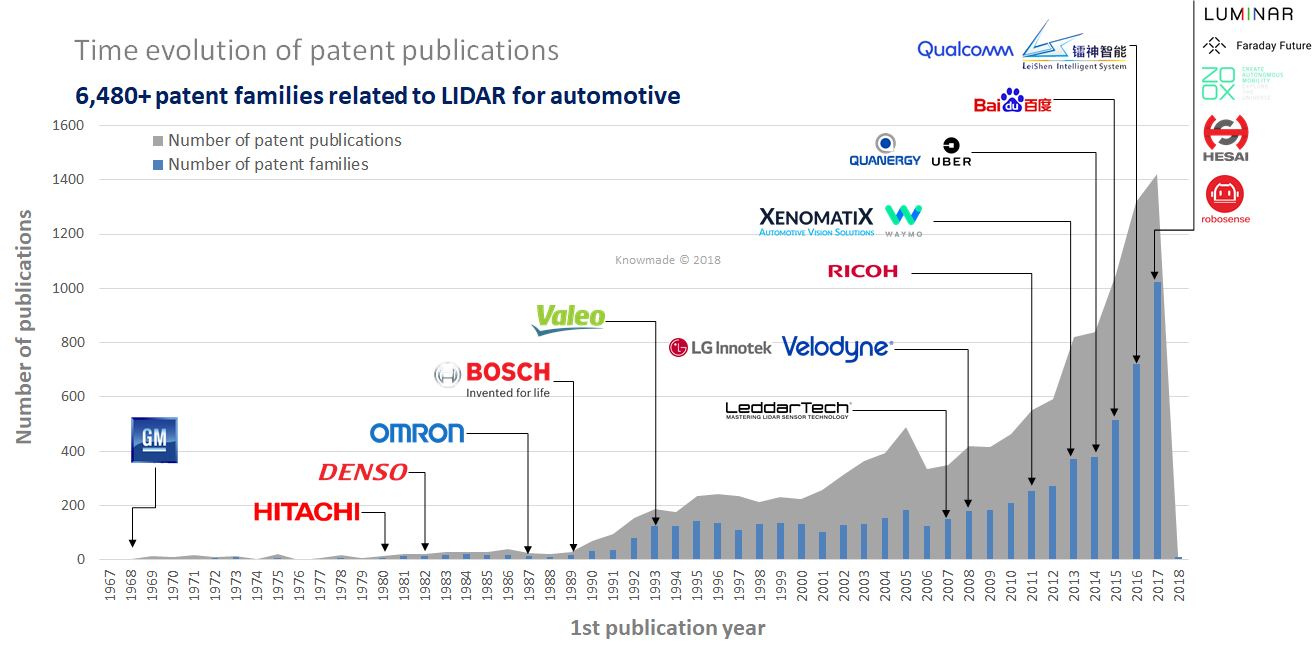

cada teléfono y tableta. También se ve que los lidares de estado sólido se ven mejor (los "más verdes"), pero esta es la tecnología más joven, y estos son sus propios riesgos, principalmente los patentes (en el campo hay una gran cantidad de patentes nuevas que no caducarán pronto):

Fuente: LiDAR: una visión general del panorama de patentes

Fuente: LiDAR: una visión general del panorama de patentesSin embargo, no lo olvidamos: el mercado de sensores de profundidad para teléfonos inteligentes está planeado en

$ 6 mil millones el próximo año

, y no puede ser inferior a 4, ya que el año pasado ascendió a más de 3 mil millones. Esta es una gran cantidad de dinero que no solo se destinará al retorno de la inversión (a los inversores más exitosos), sino también al desarrollo de nuevas generaciones de sensores. Todavía no hay un crecimiento similar en los lidares, pero según todos los indicios, irá literalmente en los próximos 3 años. Y entonces este es un proceso exponencial ordinario similar a una avalancha, que ya ha sucedido más de una vez.

¡El futuro cercano de las cámaras de profundidad se ve extremadamente interesante!

Cartago debe estar roto ... ¡ Todo el video será tridimensional para fines de siglo!Estén atentos!

¿Quién no ha leído - la

primera parte del texto !

AgradecimientosMe gustaría agradecerle cordialmente:

- Laboratorio de Computación Gráfica VMK Universidad Estatal de Moscú MV Lomonosov por su contribución al desarrollo de gráficos por computadora en Rusia y no solo

- Google, Apple e Intel para grandes soluciones compactas, y todos los fabricantes de LIDAR para un rápido progreso,

- personalmente Konstantin Kozhemyakov, quien hizo mucho para hacer este artículo mejor y más visual,

- y finalmente, muchas gracias a Roman Kazantsev, Eugene Lyapustin y Yegor Sklyarov por una gran cantidad de comentarios y correcciones razonables que hicieron que este texto fuera mucho mejor.