Los diseñadores de UX y UI siguen siendo escépticos sobre las interfaces de voz. Uno parece ser un bombo publicitario que pronto quedará en nada. Otros no utilizan asistentes de voz y, por lo tanto, confían en que la voz es incómoda y antinatural. Pero aunque dudaron, se ha desarrollado una esfera profesional independiente, con sus secretos, patrones y mecánica (e incluso el mercado laboral). Junto con la arquitecta de Just AI UX, Yekaterina Yulina, descubrimos cómo abordar las tecnologías de voz y qué diseñador de UX de interfaces tradicionales debería cambiar en su pensamiento, tomando la voz.

Pero primero, un poco retrospectivo. En el patio de 1995. Microsoft lanza Windows 95 y se está produciendo una revolución en el mundo. Recuerdo cómo los padres y otros adultos hablaron sobre los beneficios y los peligros de las computadoras. Y los fines de semana, toda la familia fue a visitar a nuestros amigos para interpretar a Kosinka y Buscaminas.

Nokia 3310 fue lanzado en 2000. El mundo ha cambiado nuevamente, esta vez gracias a los teléfonos con una interfaz de botón. Más tarde aparecieron teléfonos inteligentes con lápices. Yo también tuve uno. Empujar con un lápiz en la pantalla fue genial. Inmediatamente de alguna manera se destaca en el contexto de las personas con teléfonos de botón. Pero "el mejor lápiz es tu propio dedo", dijo Steve Jobs. En 2007, Apple comenzó a vender el iPhone, y desde entonces, la gente ha estado haciendo tapping y deslizándose, y pinchar con un lápiz táctil ha sido tonto.

Y luego comenzó: 2011 - Apple presenta Siri, en 2014 Amazon lanza Alexa y Amazon Echo, en 2016 sale Google Assistant, en 2017 - "Alice" de Yandex ... Se abrieron puertas frente a desarrolladores y negocios ecosistema de asistentes, como una vez, en tiendas de aplicaciones móviles. Y pronto solo un vago (¡y miope!) No hará habilidades para los asistentes de voz.

Situaciones cuando la voz es realmente conveniente

Es imposible imaginar que una experiencia de usuario (UX, experiencia de usuario) se construya en el vacío. La habilidad de voz nace en una situación específica en la que es útil y orgánica: no tiene sentido crear un guión de voz y luego pensar dónde aplicarlo. Es importante descubrir esta situación y vencerla magistralmente.

La voz es más conveniente que las aplicaciones web o móviles cuando necesitamos una función específica para resolver un problema específico. Por qué Debido a que no necesita esperar a que se cargue el sitio, desplácese por las páginas, busque el menú y presione los botones. Los sitios y las aplicaciones son multifuncionales. La habilidad de la voz se debe agudizar para un solo caso, en "aquí y ahora".

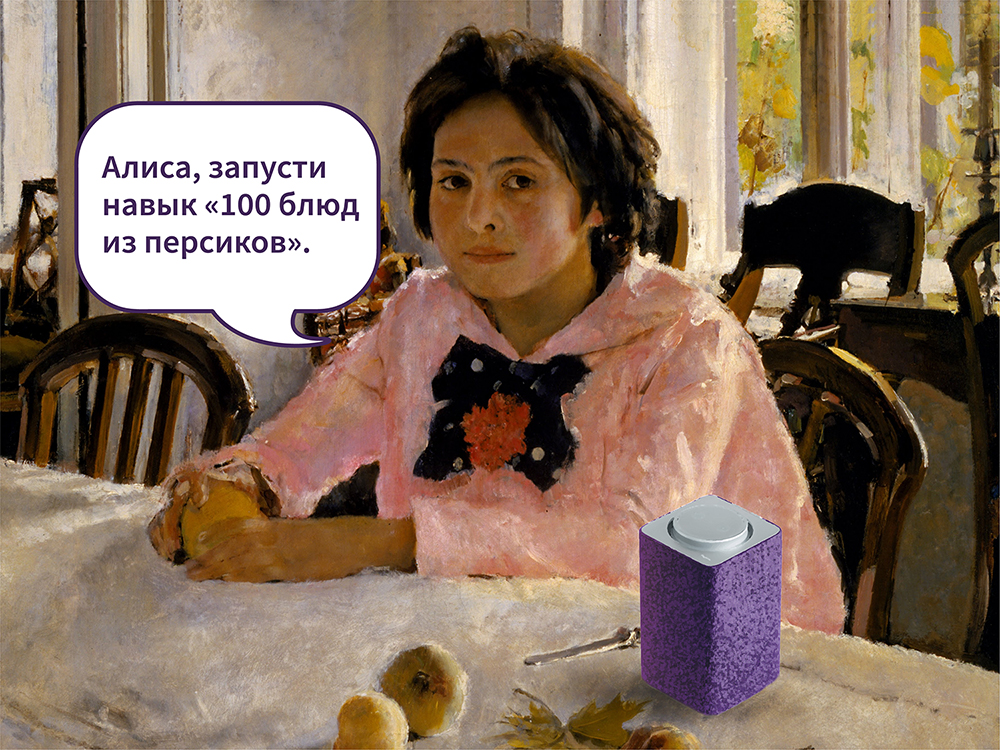

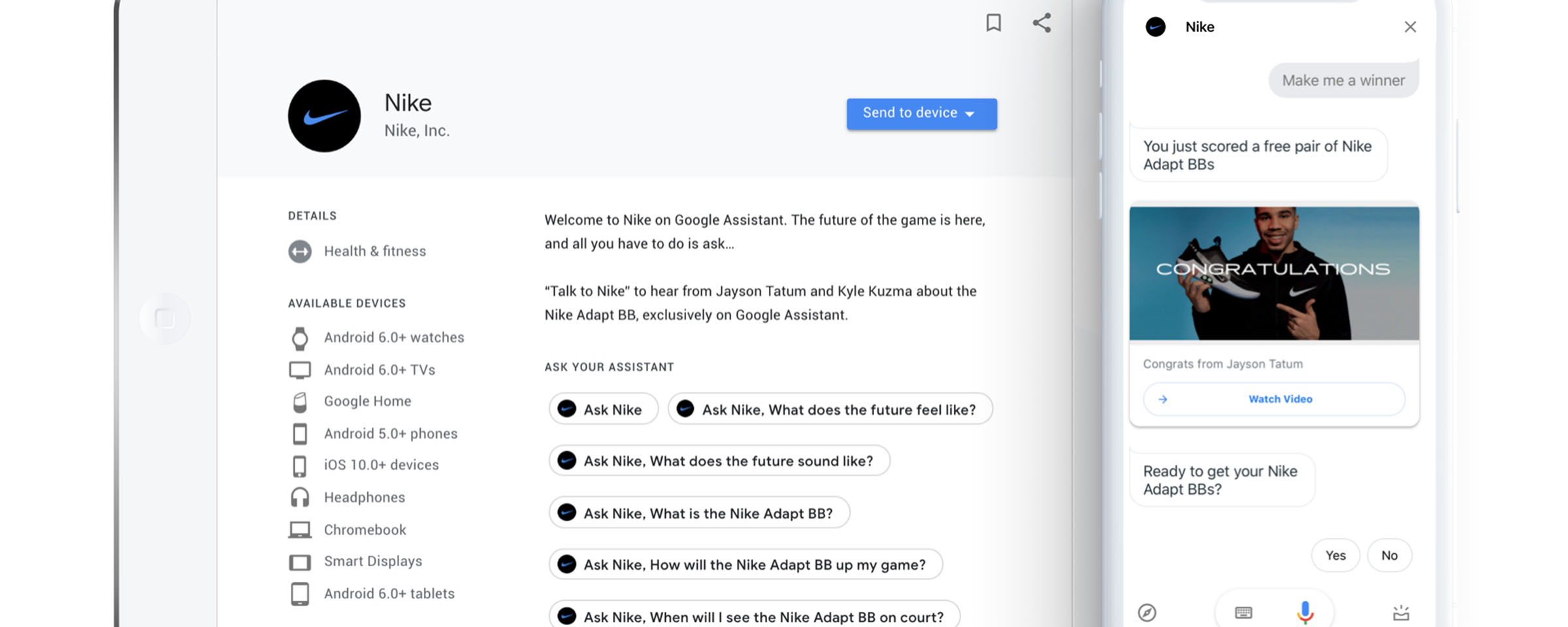

En febrero de 2019, el canal estadounidense TNT transmitió partidos de la NBA. Entre los juegos de Los Angeles Lakers y Boston Celtics, el comentarista Ernie Johnson anuncia que las zapatillas Nike de edición limitada han comenzado a venderse y que los espectadores pueden pedirle al Asistente de Google que les reserve un par por $ 350.

Seis minutos después, las zapatillas desaparecieron. Más de 15 mil personas los reservaron con la ayuda de un asistente de voz (el número de pedidos superó la cantidad de productos disponibles). La situación ideal para vender zapatillas de baloncesto era un juego real.

En 2017, Starbucks descubrió cómo usar un asistente de voz para reducir el tiempo de espera de un pedido y el camino del cliente hacia la taza de café deseada. Puedes decir "Alexa, pide mi Starbucks" ("Alexa, pide mi Starbucks") y recoge tu bebida favorita en el lugar más cercano en unos minutos. No es necesario hacer cola y esperar a que el barista grite tu nombre. No es necesario ingresar a la aplicación, busque su pedido habitual, confirme la elección. Luego, el mismo caso venció a Ford: Alexa se integró en el sistema multimedia SYNC3, de modo que los conductores tuvieron la oportunidad de ordenar y pagar sus Starbucks por voz directamente en el automóvil, sin distraerse de la carretera.

Pero los colegas de Alan AI me contaron cómo encontraron un caso de usuario aplicado, no para marketing, sino para tareas empresariales. El personal técnico que atiende a los ascensores en los EE. UU. Tiene que leer toneladas de documentación, completar una serie de formularios, ingresar datos de reparación, informar sobre la finalización de las tareas y hacer todo esto en diferentes sistemas de contabilidad. Escribir lleva mucho tiempo, en el que el ascensor no funciona realmente. Alan AI aplicó la tecnología de inteligencia artificial de voz para que los usuarios de levantadores puedan completar formularios con voz durante el trabajo o mientras viajan a las instalaciones.

Voice UX no se trata de imágenes, sino del contexto de la situación. La tarea del diseñador es estudiar el contexto en detalle y comprender lo que el usuario quiere en una situación particular.

Patrones UX en voz

Una función Entonces, una habilidad es una función. Si el conductor ordena café, entonces resuelve este problema específico. Terminó con café y quiere saber la distancia a la luna? Otra habilidad de voz ya es responsable de esto. Hacer un cuchillo suizo en una habilidad es una mala idea.

Desplazarse Los diseñadores de UX y UI discuten constantemente con los vendedores acerca de cuánta información mostrar en la primera pantalla. No hay nada peor que esperar a que se cargue el contenido, desplazarse sin cesar por la página. Las interfaces de diálogo también tienen una primera pantalla y, a diferencia de la web, no hay desplazamiento. No es necesario, porque el asistente de voz es un conjunto de habilidades. El usuario, por comando, activa la habilidad y lanza una sola función.

Ventanas y botones modales. El segundo nombre para ventanas modales es diálogo. ¿Cuál es la esencia de las ventanas modales? Confirme o rechace la intención de realizar la operación. En la vida real, las personas expresan intenciones diciendo sí o no, y no necesita botones para esto.

Multimodalidad Altavoces y pantallas inteligentes, teléfonos inteligentes, juguetes parlantes para niños, hogares inteligentes, tablero de instrumentos en un automóvil: los dispositivos determinan el contexto de uso. Lo que sea conveniente para el usuario hacer en casa a través de un altavoz "inteligente" será diferente de usar un asistente de voz en un automóvil. El mismo asistente en diferentes plataformas tiene un conjunto diferente de habilidades.

Definir contexto de uso y dispositivo. Compruebe si puede combinar la voz con otro tipo de interacción en este dispositivo.

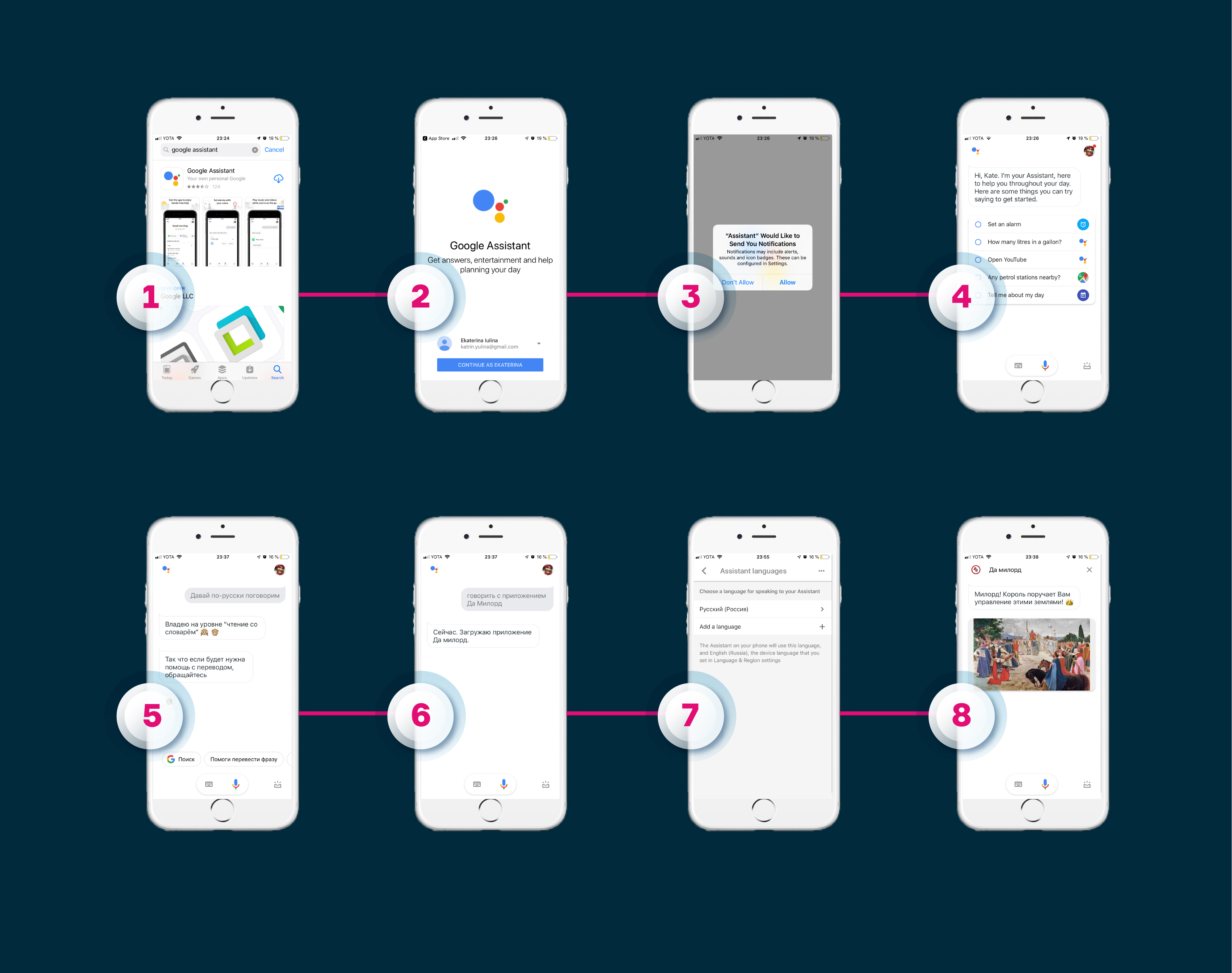

Multiplataforma . Otro aspecto es cómo hacer una habilidad para varios asistentes. La mecánica y la lógica se pueden preservar, pero el demonio estará oculto en los detalles de implementación y en el camino del usuario hacia la habilidad. Veamos cómo se ve el camino hacia las habilidades de Alice y las acciones del Asistente de Google en la misma plataforma.

Alice en iOS . Los usuarios de Alice primero deben descargar la aplicación Yandex.Browser, permitirle usar la ubicación y el micrófono, hacer clic en el icono del asistente y decir la frase de activación de la habilidad. Por ejemplo, "Lanzar la habilidad" Sí, mi señor ". La segunda y posterior experiencia del usuario consta de tres pasos: abra Yandex.Browser, haga clic en el botón de llamada del asistente, diga una frase de activación.

Asistente de Google en iOS

Asistente de Google en iOS . El usuario descarga la aplicación Asistente de Google, inicia sesión a través de su cuenta, permite enviar notificaciones y acepta acceder al micrófono. Si el idioma predeterminado es el inglés, entonces en la interfaz de la aplicación debe seleccionar ruso, pedirle al asistente que cambie el idioma con su voz y diga la frase de activación para activar la acción. Aquí ella es diferente: "Habla con la aplicación" Sí, mi señor ". Luego, la ruta se acorta: la segunda vez que el usuario abre la aplicación Asistente de Google y simplemente expresa el comando.

Sin conocer la frase de activación (y los comandos para invocar la misma habilidad en diferentes ecosistemas serán diferentes), no puede iniciar la habilidad, y en términos de UX, esta es una de las debilidades de los asistentes de voz. Pero Google, Yandex y otras compañías ahora están trabajando en la tarea de descubrir habilidades cómodamente (cómo transmitir correctamente información sobre nuevas habilidades a los consumidores), por lo que será más fácil encontrar habilidades útiles y relevantes en algún momento.

Y, por cierto, los diseñadores de VUI insisten en que una habilidad con la misma mecánica para diferentes asistentes sigue siendo proyectos separados.

Diseñando una interfaz en siete pasos

Pregunté a los diseñadores de VUI, a los colegas de Just AI y a los usuarios del creador de habilidades Aimylogic, con los que generalmente comienzan a trabajar en el script. Todos dicen "con una idea". Puede describirlo de forma gratuita en un editor de texto.

Pavel Gvay, fundador de tortu.io , una herramienta para diseñar aplicaciones de voz: “La forma más rápida y económica de comprender cómo se construirá la conversación entre el usuario y su aplicación es escribir un ejemplo de diálogo. Este es un archivo de texto que describe el funcionamiento de un flujo. En formato, los ejemplos de diálogo se asemejan al guión de la película, donde todos los comentarios están pintados por rol ".

Diálogo de ejemplo en NotionSaludar al usuario

Diálogo de ejemplo en NotionSaludar al usuarioCuéntanos qué hace el bot. Use frases amplias de longitud media. Termine la frase con una pregunta cerrada: para que el usuario entienda lo que quiere de él.

Malo - "Hola! Soy actividad No puedo vivir un día sin deportes. ¡Él es mi todo, mi vida, mi inspiración! ¡También tengo mucha experiencia como entrenador y cientos de ejercicios en la base de datos! ¡Con gusto compartiré mis ejercicios favoritos contigo! ”

Bien - "Hola! Soy Activity, un atleta bot. Con mucho gusto le recomendaré una serie de ejercicios. ¿Quieres hablar sobre el yoga?

Resolver rutas de usuarioEn el lenguaje de los programadores, la intención es intención (intención en inglés). La analogía con las interfaces clásicas es una solicitud formal o informal. Es más fácil trabajar con lo formalizado, y lo informal puede convertir la vida en una pesadilla.

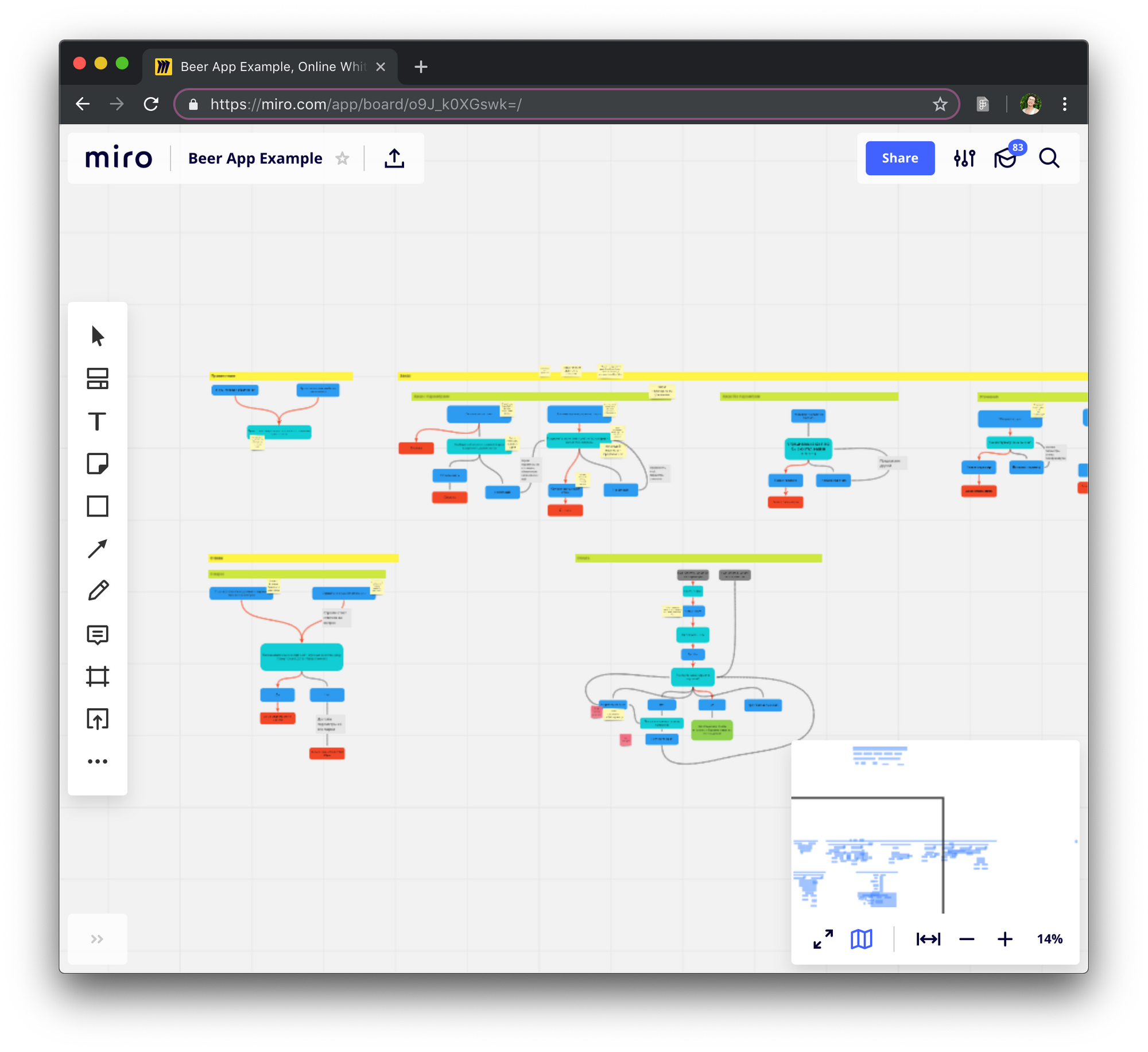

Los diseñadores usan un diagrama de flujo cuando trabajan con rutas de usuario. Su tarea es ayudar a describir la lógica de la aplicación. El diagrama de flujo consta de pasos de diálogo en nombre del usuario y del sistema, a veces se le agregan elementos lógicos: las llamadas a la API, funcionan con el contexto.

Diagrama de flujo en Miro

Diagrama de flujo en MiroA menudo, el diagrama de flujo describe la encrucijada principal en la habilidad de la voz. Algunos diseñadores bloquean cada detalle de la habilidad. Pavel Guy no recomienda hacer esto, ya que muy pronto dejará de ser legible, y realizar cualquier cambio llevará mucho tiempo.

La forma más fácil de determinar la ruta del usuario es ir con él de principio a fin y ver en qué puntos aparecerán las condiciones y las desviaciones del escenario principal.

Crear navegaciónNo importa en qué paso se encuentre el usuario, siempre debe tener la oportunidad de comenzar todo de nuevo, retroceder, avanzar y responder de manera variable. No lo hagas memorizar comandos.

Un ejemplo de la vida. La habilidad ya mencionada "Sí, mi señor" (su audiencia en "Alice" es de 650 mil personas, además, es uno de los juegos más populares para Google Assistant no solo en Rusia sino también en el mundo) es un juego atmosférico con música síntesis de voz decente, historias interesantes, mecánica de juego. Al principio, podía controlar el juego solo con la ayuda de "Sí", "No" y "Suficiente". En la historia, el jugador, mi señor, el dueño de la tierra y los campesinos, cae en la situación "¡Su gracia! ¡Se han encontrado grandes depósitos de cobre en nuestras tierras fértiles! ¿Por favor comienza a construir una mina? Sería posible responder simplemente sí, pero me gustaría acostumbrarme al papel y hablar, como corresponde a una persona de alto perfil.

- Su gracia! ¡Se han encontrado grandes depósitos de cobre en nuestras tierras fértiles! ¿Por favor comienza a construir una mina?

- amor!

El diseñador de VUI descubrió este punto y entrenó la habilidad para comprender mejor a los usuarios, dándoles más libertad para responder.

Escriba ejemplos de diálogos y haga que las respuestas del bot sean más diversas.Mis colegas de Just AI escriben ejemplos de diálogo en tablas. Son mucho más convenientes, pero esto está lejos de ser la opción más conveniente: describir tanto la lógica como las posibles transiciones. Alguien escribe guiones en Word. No existe un formato y una regulación únicos para la descripción.

Los usuarios están muy molestos cuando el asistente comienza a repetir. La hipótesis es confirmada por Nelly Kamaeva, diseñador Alan AI. Durante una prueba de habilidad para niños, vio cuán rápido los chicos perdieron interés cuando se enfrentaron con la misma respuesta.

Vale la pena considerar varias réplicas que son sinónimo de significado, que el usuario escuchará cuando lleguen al mismo paso en el script. Los diseñadores de VUI recomiendan usar de tres a diez variaciones de una sola frase.

Busque en la basura intenciones no reconocidas

"Basura", o lenguaje general de los programadores, es el lugar donde las frases de usuario caen por varias razones.

"¿Con quién estoy hablando?" ¿Eres un robot?

"Me hiciste pasar". ¿Quieres seguir chateando?

La frase "¿Estoy hablando con alguien?" ¿Eres un robot? caerá en un conjunto (si no le ha proporcionado un script). Me hiciste pasar. ¿Quieres continuar la comunicación? - réplica predeterminada en tales situaciones. Piense de antemano cómo ayudar a un usuario que falla en la captura general.

Piensa en la voz y el personaje.Recuerda a los interlocutores que te aburrieron. No es interesante con ellos; la renuencia a continuar la conversación, los llamamos aburridos. Lo mismo sucede cuando se trata de habilidades. Alice, Alexa y el Asistente de Google tienen su propio kit de herramientas de voz con una amplia gama de voces, acentos y efectos de sonido masculinos y femeninos para animar el discurso del robot como toser y olfatear.

Si desea impresionar al usuario e involucrarlo en la conversación, juegue con el estilo del habla, trabaje en la síntesis: organice tensiones, pausas y entonaciones. Este es un trabajo minucioso, pero créanme, el resultado lo vale. En un taller interno, un colega creó una habilidad para Alexa: escuche el fragmento:

- Hola hombre. Un clima horrible, ¿sí? ¿Quieres emborracharte? Deja que tu viejo amigo Joe te prepare una buena bebida irlandesa. Ok

- Y ahora, cuando te sientas mejor, toma tu maldito trasero y ve al pub Joe's. Allí nunca beberás solo. Te estoy esperando

Otra forma de trabajar con voz es grabar audio con actores profesionales. Durante un período largo y costoso, la flexibilidad se pierde si desea agregar algo al script, pero de manera espectacular. La habilidad puede hablar con las voces de celebridades, políticos y héroes de las películas (bueno, ya podías escuchar nuestra

voz actuando para el juego Lovecraft World , pero Google Assistant habla con la voz de John Legend, ganador de un Grammy -

tyk ).

Para uno de los casos de negocios, también utilizamos grabaciones de voz de actores profesionales. Solo el 0.5% de los clientes pudieron sospechar (ni siquiera adivinar, sino sospechar) que el bot les estaba hablando.

Usa sonidos e ilustraciones para crear una atmósfera.

Puede captar sonidos de bibliotecas listas para usar o crear las suyas propias (Alexa es exigente con las extensiones de archivo, por lo que debe jugar con la conversión). En el mismo juego, "Sí, mi señor", para "Alice", los sonidos se utilizan para crear una atmósfera: relinchar a un caballo, murmurar una multitud, una risa siniestra, una gaita. Y recientemente en "Alice" apareció la habilidad "Birds of Russia", donde en una conversación se puede escuchar cómo cantan y cantan una alondra, un gorrión u otros pájaros.

El diseño de la interfaz de voz no se limita a diagramas de flujo y texto seco. El diseñador tiene todo para crear habilidades que involucren al usuario en el proceso.

Y más consejos de diseñadores de VUI

No enseñe la interfaz. El lenguaje es una interfaz familiar e intuitiva. No es necesario enseñarle a una persona a hablar. El sabe como.

Malo : "Para volver a escuchar el mensaje, diga" Volver a escuchar ". Para ir al siguiente mensaje, diga "Ir al siguiente mensaje".

Bien : "¿Volver a escuchar el mensaje o pasar al siguiente?"

Haz preguntas cerradas . Recomiendo evitar preguntas abiertas y el final abierto de las declaraciones del bot, el usuario debe ser dirigido a la acción.

Malo - "Hola! Soy Symphony, un amante de la música. Me complace recomendarte un álbum y contarte al respecto ".

Bien - "Hola! Soy Symphony, un amante de la música. Con mucho gusto te recomendaré un álbum y te lo contaré. ¿Quieres saber sobre la pista del día?

Evita el clericalismo. Una recomendación obvia que pocas personas siguen. Ninguno de nosotros quiere leer un texto complejo y sobrecargado, y escucharlo es aún más insoportable.

Malo : "Es importante tener en cuenta que los álbumes posteriores de este artista se convertirán en platino, lo que nos permite concluir que este álbum debut es exitoso como un medio para ingresar efectivamente en el ámbito internacional".

Bien : “El álbum debut atrajo la atención del mundo entero hacia el intérprete. ¡No sin razón sus siguientes discos se convirtieron en platino dos veces!

Pruebas y entrenamiento

Prueba la habilidad en silencio, en la calle, en una habitación ruidosa, habla con diferentes entonaciones y a diferentes velocidades. Incluso en el lugar más tranquilo, algo puede salir mal. Quizás el proceso de prueba les parezca aburrido a algunos, pero les aseguro que no lo es. ¡La habilidad necesita una prueba de choque real!

Por experiencia personal. En uno de los talleres, diseñé una habilidad física: según la idea, Alexa primero dio instrucciones, luego la música se encendió y la persona repitió el ejercicio. Probé todo con entusiasmo en mí mismo: salté y corrí a la música picada, cambié la longitud de las pistas, repetí los ejercicios muchas veces y finalmente la habilidad UX me satisfizo.

Provoca y jura

Los usuarios son provocadores. Comprobarán la reacción de la habilidad fuera de tema: la habilidad para pedir pizza, y el usuario, parece muy astuto, preguntará sobre el sushi. Encuentra una respuesta decente. Y maldice tu corazón. Lo digo en serio! Solo AI tiene una lista de verificación para el tapete utilizado en las pruebas.

Hablar y escuchar

Di todo lo que se te ocurra. Escuche con sus oídos todo lo que el usuario escuchará. Pídales a sus colegas que lean e incluso jueguen el guión. Grabar discurso, volver a grabaciones, experimentar.

Habilidad para entrenar

Pero la primera vez que no prevé todo en la habilidad. Acéptalo y humíllate. Su habilidad requerirá más educación. Leer diálogos y analizar registros. Cómo hacer esto usando Python, en una de las ediciones de Alice’s School, dice Daria Serdyuk, ingeniera de investigación de PNL Just AI.

Herramientas de diseño

Papel, lápiz o pizarra: no se ha inventado nada mejor para comenzar a trabajar o transmitir rápidamente una idea a un equipo o cliente. Pero hay herramientas más avanzadas que simplificarán la vida profesional del diseñador de interfaz de voz y ayudarán a realizar la idea.

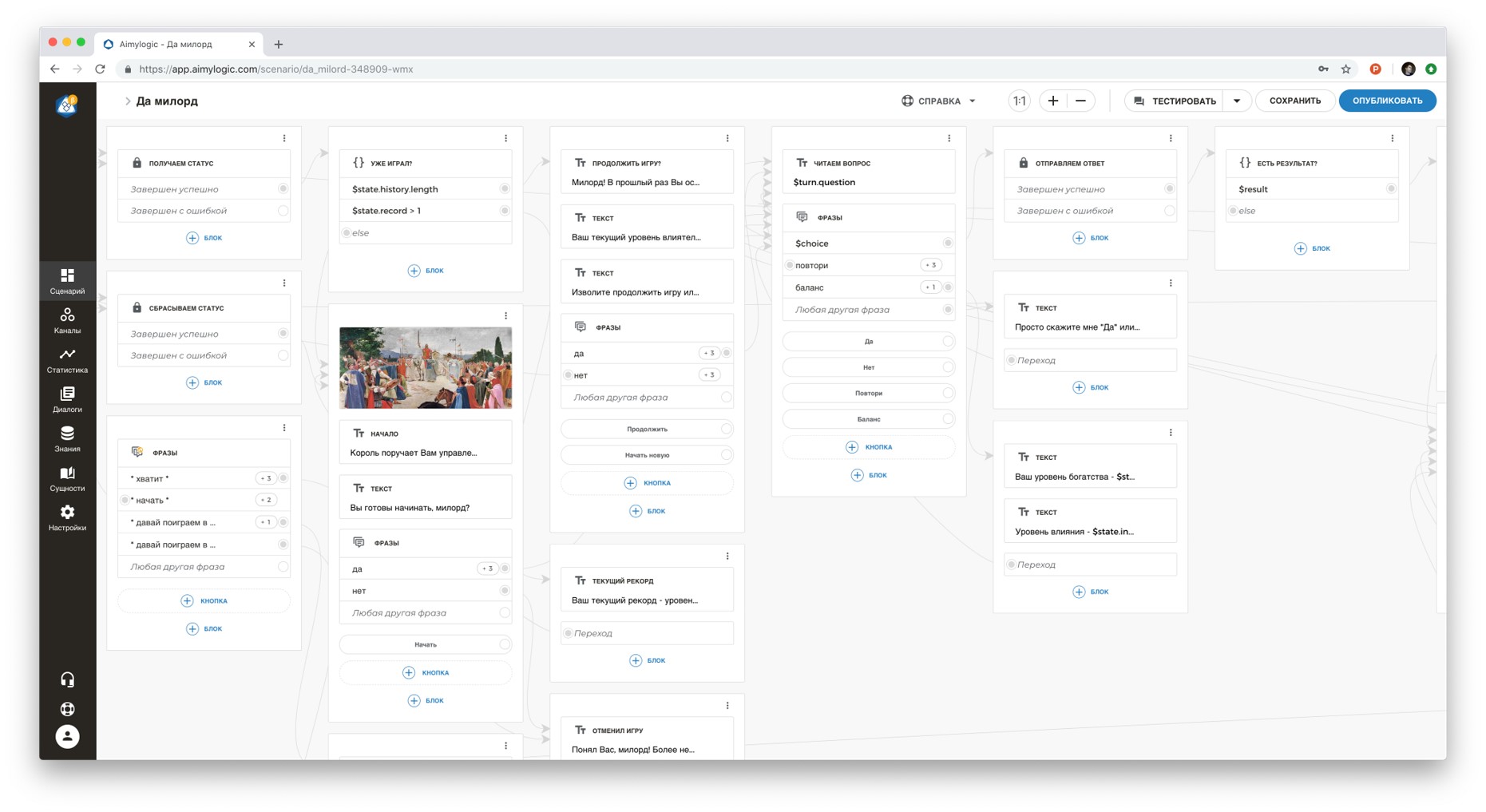

AimylogicConstructor con un motor NLU (comprensión del lenguaje natural). Más de 10 mil usuarios y más de 1100 habilidades para asistentes de voz con una audiencia total de 1 millón de usuarios. Hay una suscripción gratuita y un período de demostración gratuito para suscripciones pagas.

En el diseñador, puede crear un script, probarlo y conectarlo a más de diez canales (Alice, Google Assistant, Telegram, VKontakte y otros). Hay soporte técnico y una comunidad en Telegram. Aquí hay algunos ejemplos de habilidades de voz:

Tortu.ioHerramienta para la creación rápida de prototipos. Literalmente construye un diálogo entre el usuario y el sistema en pasos en un diagrama de bloques, y luego prueba usando un prototipo. Adecuado para pruebas WoZ y pruebas rápidas de hipótesis.

Flujo de vozDiseñador gráfico Alexa Skills. Le permite crear habilidades de Alexa sin habilidades de programación. Apto para pruebas UX.

Flow.aiHerramienta gráfica para crear chatbots. Le permite crear bots sin habilidades de programación. También es adecuado para pruebas UX.

Materiales para bombeo

La psicología y la experiencia real de los usuarios de asistentes de voz es significativamente diferente de lo que estamos acostumbrados en el entorno web o móvil. Pero el diseño de la voz es interesante porque es un área nueva y aún poco explorada en la que puede hacer muchos descubrimientos y avances.La experiencia y los materiales de los diseñadores de VUI mencionados en el artículo se utilizaron con su consentimiento.

Agradecimientos:Dmitry Chechetkin , cofundador y jefe de proyectos estratégicos, Just AI.Daria Serdyuk , ingeniera de investigación de PNL, Just AI.Paul Gwai , fundador de Tortu.io.Nelly Kamaeva , diseñadora de producto, Alan AI.