Nota perev. : El autor del artículo, Erkan Erol, ingeniero de SAP, comparte su estudio sobre los mecanismos de funcionamiento del equipo kubectl exec , tan familiar para todos los que trabajan con Kubernetes. Acompaña todo el algoritmo con listados de código fuente de Kubernetes (y proyectos relacionados), que le permiten comprender el tema tan profundo como sea necesario.

Un viernes, un colega se me acercó y me preguntó cómo ejecutar un comando en el pod usando

client-go . No pude responderle y de repente me di cuenta de que no sabía nada sobre el mecanismo de trabajo de

kubectl exec . Sí, tenía ciertas ideas sobre su dispositivo, pero no estaba 100% seguro de su corrección y, por lo tanto, decidí abordar este problema. Después de estudiar blogs, documentación y código fuente, aprendí muchas cosas nuevas, y en este artículo quiero compartir mis descubrimientos y comprensión. Si algo está mal, contáctame en

Twitter .

Preparación

Para crear un clúster en una MacBook,

cloné ecomm -integration-ballerina / kubernetes-cluster . Luego corrigió las direcciones IP de los nodos en la configuración de kubelet, ya que la configuración predeterminada no permitía

kubectl exec . Puede leer más sobre la razón principal de esto

aquí .

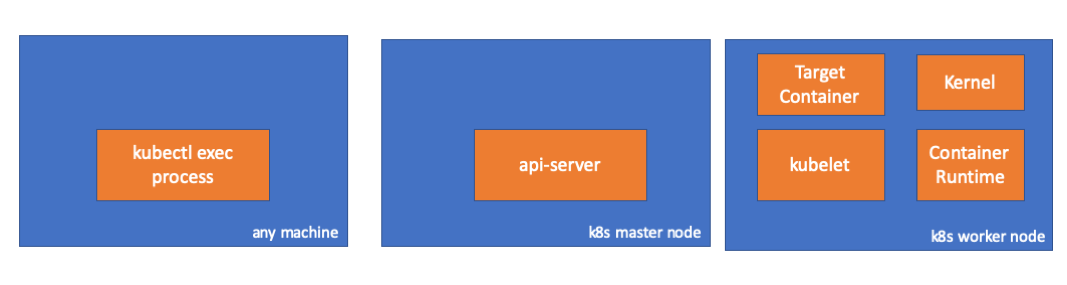

- Cualquier auto = mi MacBook

- IP maestra = 192.168.205.10

- IP del host del trabajador = 192.168.205.11

- Puerto del servidor API = 6443

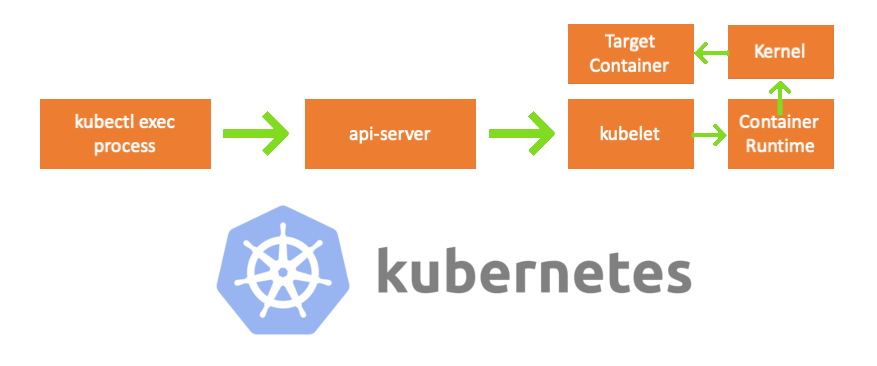

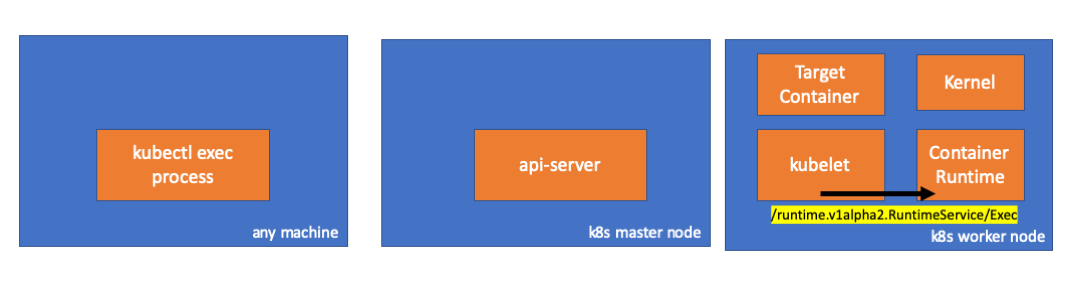

Componentes

- Proceso exec de kubectl : cuando ejecutamos "exec kubectl ...", comienza el proceso. Puede hacerlo en cualquier máquina con acceso al servidor K8s API. Nota trans .: Además, en las listas de consolas, el autor utiliza el comentario "cualquier máquina", lo que implica que los comandos posteriores se pueden ejecutar en cualquiera de esas máquinas con acceso a Kubernetes.

- servidor api : un componente en el maestro que proporciona acceso a la API de Kubernetes. Esta es la interfaz para el plano de control en Kubernetes.

- Kubelet : un agente que se ejecuta en cada nodo del clúster. Proporciona contenedores en pod'e.

- contenedor de tiempo de ejecución ( contenedor de tiempo de ejecución ): software responsable de la operación de contenedores. Ejemplos: Docker, CRI-O, contenedor ...

- kernel : kernel del sistema operativo en el nodo de trabajo; responsable de la gestión de procesos.

- contenedor de destino : un contenedor que forma parte de un pod y opera en uno de los nodos de trabajo.

Lo que descubri

1. Actividad del lado del cliente

Cree un pod en el espacio de nombres

default :

// any machine $ kubectl run exec-test-nginx --image=nginx

Luego ejecutamos el comando exec y esperamos 5000 segundos para nuevas observaciones:

// any machine $ kubectl exec -it exec-test-nginx-6558988d5-fgxgg -- sh

Aparece el proceso kubectl (con pid = 8507 en nuestro caso):

// any machine $ ps -ef |grep kubectl 501 8507 8409 0 7:19PM ttys000 0:00.13 kubectl exec -it exec-test-nginx-6558988d5-fgxgg -- sh

Si verificamos la actividad de red del proceso, encontramos que tiene conexiones con el servidor api (192.168.205.10.6443):

// any machine $ netstat -atnv |grep 8507 tcp4 0 0 192.168.205.1.51673 192.168.205.10.6443 ESTABLISHED 131072 131768 8507 0 0x0102 0x00000020 tcp4 0 0 192.168.205.1.51672 192.168.205.10.6443 ESTABLISHED 131072 131768 8507 0 0x0102 0x00000028

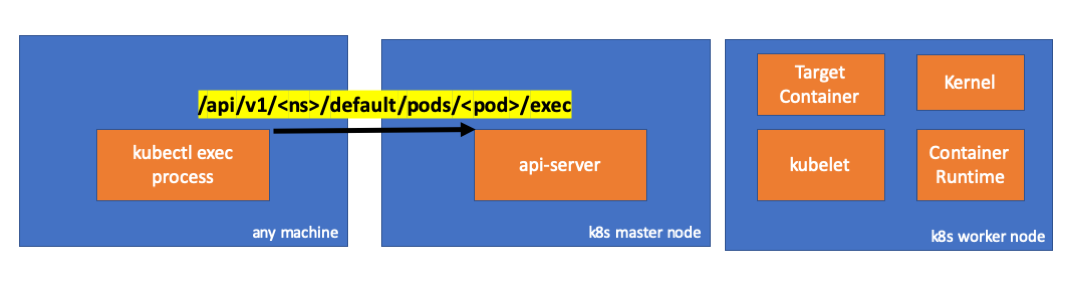

Miremos el código. Kubectl crea una solicitud POST con el subrecurso exec y envía una solicitud REST:

req := restClient.Post(). Resource("pods"). Name(pod.Name). Namespace(pod.Namespace). SubResource("exec") req.VersionedParams(&corev1.PodExecOptions{ Container: containerName, Command: p.Command, Stdin: p.Stdin, Stdout: p.Out != nil, Stderr: p.ErrOut != nil, TTY: t.Raw, }, scheme.ParameterCodec) return p.Executor.Execute("POST", req.URL(), p.Config, p.In, p.Out, p.ErrOut, t.Raw, sizeQueue)

( kubectl / pkg / cmd / exec / exec.go )

2. Actividad en el lado del nodo maestro

También podemos observar la solicitud en el lado del servidor api:

handler.go:143] kube-apiserver: POST "/api/v1/namespaces/default/pods/exec-test-nginx-6558988d5-fgxgg/exec" satisfied by gorestful with webservice /api/v1 upgradeaware.go:261] Connecting to backend proxy (intercepting redirects) https://192.168.205.11:10250/exec/default/exec-test-nginx-6558988d5-fgxgg/exec-test-nginx?command=sh&input=1&output=1&tty=1 Headers: map[Connection:[Upgrade] Content-Length:[0] Upgrade:[SPDY/3.1] User-Agent:[kubectl/v1.12.10 (darwin/amd64) kubernetes/e3c1340] X-Forwarded-For:[192.168.205.1] X-Stream-Protocol-Version:[v4.channel.k8s.io v3.channel.k8s.io v2.channel.k8s.io channel.k8s.io]]

Tenga en cuenta que la solicitud HTTP incluye una solicitud de cambio de protocolo. SPDY le permite multiplexar flujos individuales de stdin / stdout / stderr / spdy-error a través de una única conexión TCP.El servidor API recibe la solicitud y la convierte a

PodExecOptions :

( paquete / apis / core / types.go )Para realizar las acciones requeridas, api-server debe saber con qué pod necesita contactar:

( paquete / registro / núcleo / pod / estrategia.go )Por supuesto, los datos del punto final se toman de la información del host:

nodeName := types.NodeName(pod.Spec.NodeName) if len(nodeName) == 0 {

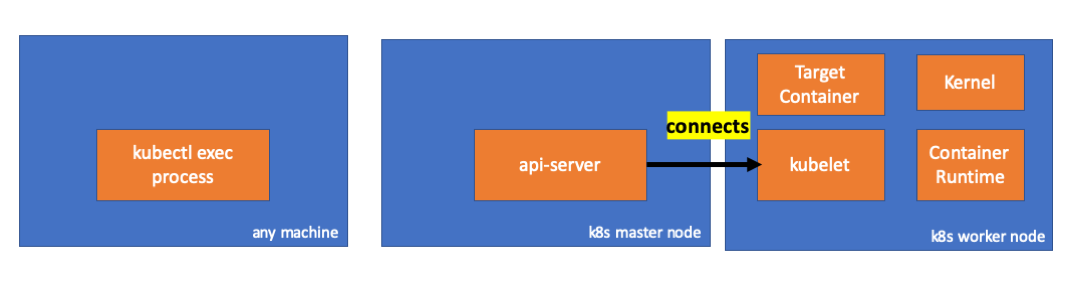

( paquete / registro / núcleo / pod / estrategia.go )¡Hurra! Kubelet ahora tiene un puerto (

node.Status.DaemonEndpoints.KubeletEndpoint.Port ) al que se puede conectar el servidor API:

( pkg / kubelet / client / kubelet_client.go )De la documentación de Master-Node Communication> Master to Cluster> apiserver to kubelet :

Estas conexiones están cerradas en el punto final HTTPS de kubelet. De manera predeterminada, apiserver no verifica el certificado de kubelet, lo que hace que la conexión sea vulnerable a "ataques intermedios" (MITM) y no sea segura para trabajar en redes no confiables y / o públicas.

Ahora el servidor API conoce el punto final y establece una conexión:

( paquete / registro / núcleo / pod / rest / subresources.go )Veamos qué sucede en el nodo maestro.

Primero descubrimos la IP del nodo de trabajo. En nuestro caso, esto es 192.168.205.11:

// any machine $ kubectl get nodes k8s-node-1 -o wide NAME STATUS ROLES AGE VERSION INTERNAL-IP EXTERNAL-IP OS-IMAGE KERNEL-VERSION CONTAINER-RUNTIME k8s-node-1 Ready <none> 9h v1.15.3 192.168.205.11 <none> Ubuntu 16.04.6 LTS 4.4.0-159-generic docker://17.3.3

Luego instale el puerto kubelet (10250 en nuestro caso):

// any machine $ kubectl get nodes k8s-node-1 -o jsonpath='{.status.daemonEndpoints.kubeletEndpoint}' map[Port:10250]

Ahora es el momento de verificar la red. ¿Hay alguna conexión con el nodo de trabajo (192.168.205.11)? Esta ahi! Si elimina el proceso

exec , desaparecerá, así que sé que la conexión fue establecida por el servidor api como resultado del comando exec ejecutado.

// master node $ netstat -atn |grep 192.168.205.11 tcp 0 0 192.168.205.10:37870 192.168.205.11:10250 ESTABLISHED …

La conexión entre kubectl y el servidor api aún está abierta. Además, hay otra conexión que conecta api-server y kubelet.

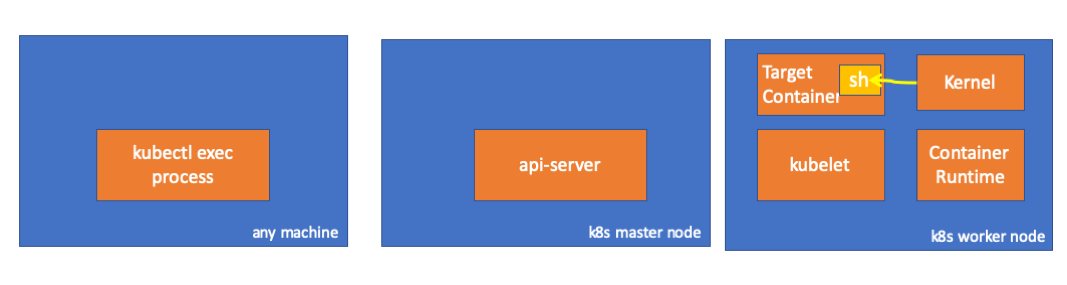

3. Actividad en el nodo de trabajo.

Ahora conectemos al nodo trabajador y veamos qué sucede en él.

En primer lugar, vemos que también se establece la conexión con él (segunda línea); 192.168.205.10 es la IP del nodo maestro:

// worker node $ netstat -atn |grep 10250 tcp6 0 0 :::10250 :::* LISTEN tcp6 0 0 192.168.205.11:10250 192.168.205.10:37870 ESTABLISHED

¿Qué hay de nuestro equipo de

sleep ? ¡Hurra, ella también está presente!

// worker node $ ps -afx ... 31463 ? Sl 0:00 \_ docker-containerd-shim 7d974065bbb3107074ce31c51f5ef40aea8dcd535ae11a7b8f2dd180b8ed583a /var/run/docker/libcontainerd/7d974065bbb3107074ce31c51 31478 pts/0 Ss 0:00 \_ sh 31485 pts/0 S+ 0:00 \_ sleep 5000 …

Pero espera: ¿cómo hizo Kubelet para subir esto? Hay un demonio en kubelet que permite el acceso a la API a través del puerto para solicitudes de servidor de API:

( pkg / kubelet / server / streaming / server.go )Kubelet calcula el punto final de respuesta para solicitudes de ejecución:

func (s *server) GetExec(req *runtimeapi.ExecRequest) (*runtimeapi.ExecResponse, error) { if err := validateExecRequest(req); err != nil { return nil, err } token, err := s.cache.Insert(req) if err != nil { return nil, err } return &runtimeapi.ExecResponse{ Url: s.buildURL("exec", token), }, nil }

( pkg / kubelet / server / streaming / server.go )No confundir No devuelve el resultado del comando, sino el punto final para la comunicación:

type ExecResponse struct {

( cri-api / pkg / apis / runtime / v1alpha2 / api.pb.go )Kubelet implementa la interfaz

RuntimeServiceClient , que forma parte de la interfaz Container Runtime

(escribimos más sobre esto, por ejemplo, aquí , aprox. Transl.) :

Lista larga de cri-api a kubernetes / kubernetes Simplemente usa gRPC para invocar un método a través de la interfaz de tiempo de ejecución del contenedor:

type runtimeServiceClient struct { cc *grpc.ClientConn }

( cri-api / pkg / apis / runtime / v1alpha2 / api.pb.go ) func (c *runtimeServiceClient) Exec(ctx context.Context, in *ExecRequest, opts ...grpc.CallOption) (*ExecResponse, error) { out := new(ExecResponse) err := c.cc.Invoke(ctx, "/runtime.v1alpha2.RuntimeService/Exec", in, out, opts...) if err != nil { return nil, err } return out, nil }

( cri-api / pkg / apis / runtime / v1alpha2 / api.pb.go )Container Runtime es responsable de implementar

RuntimeServiceServer :

Lista larga de cri-api a kubernetes / kubernetes

Si es así, deberíamos ver una conexión entre el kubelet y el tiempo de ejecución del contenedor, ¿verdad? Vamos a verlo

Ejecute este comando antes y después del comando exec y observe las diferencias. En mi caso, la diferencia es esta:

// worker node $ ss -a -p |grep kubelet ... u_str ESTAB 0 0 * 157937 * 157387 users:(("kubelet",pid=5714,fd=33)) ...

Hmmm ... Una nueva conexión a través de sockets unix entre kubelet (pid = 5714) y algo desconocido. Que podria ser Así es, este es Docker (pid = 1186)!

// worker node $ ss -a -p |grep 157387 ... u_str ESTAB 0 0 * 157937 * 157387 users:(("kubelet",pid=5714,fd=33)) u_str ESTAB 0 0 /var/run/docker.sock 157387 * 157937 users:(("dockerd",pid=1186,fd=14)) ...

Como recordarán, este es un proceso de Docker Daemon (pid = 1186) que ejecuta nuestro comando:

// worker node $ ps -afx ... 1186 ? Ssl 0:55 /usr/bin/dockerd -H fd:// 17784 ? Sl 0:00 \_ docker-containerd-shim 53a0a08547b2f95986402d7f3b3e78702516244df049ba6c5aa012e81264aa3c /var/run/docker/libcontainerd/53a0a08547b2f95986402d7f3 17801 pts/2 Ss 0:00 \_ sh 17827 pts/2 S+ 0:00 \_ sleep 5000 ...

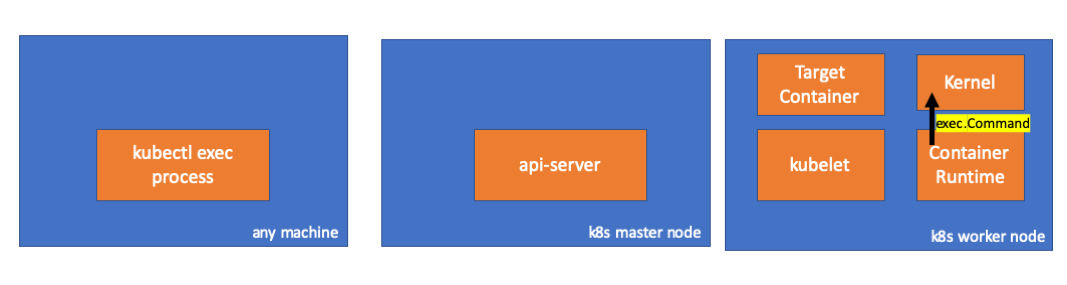

4. Actividad en el tiempo de ejecución del contenedor

Examinemos el código fuente de CRI-O para comprender lo que está sucediendo. En Docker, la lógica es similar.

Hay un servidor responsable de implementar el

RuntimeServiceServer :

( cri-o / server / server.go )

( cri-o / erver / container_exec.go )Al final de la cadena, el tiempo de ejecución del contenedor ejecuta un comando en el nodo de trabajo:

( cri-o / internal / oci / runtime_oci.go )

Finalmente, el kernel ejecuta los comandos:

Recordatorios

- API Server también puede iniciar una conexión a kubelet.

- Las siguientes conexiones se mantienen hasta el final de la sesión de ejecución interactiva:

- entre kubectl y api-server;

- entre api-server y kubectl;

- entre kubelet y el tiempo de ejecución del contenedor.

- Kubectl o api-server no pueden ejecutar nada en los nodos de producción. Kubelet puede iniciarse, pero para estas acciones también interactúa con el tiempo de ejecución del contenedor.

Recursos

PD del traductor

Lea también en nuestro blog: