La idea de la inteligencia artificial ha preocupado durante mucho tiempo a la humanidad. Los autómatas recibieron mucha atención en los mitos de la antigua Grecia, y el ejemplo más famoso es la mujer artificial Pandora, creada por Zeus. Los golems místicos se encuentran en la cultura judía. Y las increíbles muñecas karakuri ocupan un lugar importante en la epopeya japonesa.

En el siglo XVII, algunos filósofos reflexionaron sobre la posibilidad de "poner la mente" en objetos inanimados. Se han presentado muchas teorías. Por ejemplo, René Descartes creía en el dualismo de la mente y el cuerpo. Sus puntos de vista rechazaron la posibilidad de la mecanización de la inteligencia.

Leibniz tenía otras opiniones. Él creía que todo pensamiento humano puede representarse matemáticamente usando símbolos elementales. Para ello, propuso Characteristica Universalis, el simbolismo de los conceptos necesarios para la descripción del conocimiento.

La inteligencia artificial y los autómatas han aparecido en la ficción desde tiempos inmemoriales. Un ejemplo es el "Frankenstein o Modern Prometheus" de Mary Shelley y los "Rossum Universal Robots" de Karel Chapek. Gracias a ellos, en 1921 la palabra "robot" apareció en la literatura.

Estos fueron los prerrequisitos filosóficos para el surgimiento de la IA. Ahora hablemos de científicos específicos y sus trabajos, gracias a los cuales la inteligencia artificial de la ficción se ha convertido en una realidad. Una historia relativamente concreta y objetiva comenzó relativamente recientemente. La famosa prueba de Turing se realizó por primera vez en 1950, pero solo seis años después, en 1956, la IA comenzó a formarse como una disciplina separada. Veamos como fue.

Primeros pasos

El número de artículos científicos relacionados con la inteligencia artificial aumentó considerablemente en los años 50 y 60. Pero anteriormente ha habido estudios que afectan este tema. Bertrand Russell y Alfred North Whitehead publicaron Los principios de las matemáticas en 1913. Casi al mismo tiempo, George Bull presentó sus leyes de pensamiento . Así se sentaron las bases de la lógica matemática.

Quizás todo comenzó en el momento en que un incomprensible niño de 15 años irrumpió en la oficina de Rudolf Karnap. Karnap ya se convirtió en un filósofo influyente y enseñó en la Universidad de Chicago. Publicó La sintaxis lógica del lenguaje. El niño vino sin permiso e indicó errores en este trabajo. Rudolph estaba sorprendido. El visitante fue inusual. Además, ni siquiera se presentó, e inmediatamente se escapó. Después de meses de búsqueda, Rudolph finalmente encontró a su visitante en una universidad local. Resultó ser Walter Harry Pitts .

Tres años antes (sí, a los 12 años), Walter escribió una carta a Bertrand Russell, señalando los problemas encontrados en los Principios antes mencionados. Russell estaba tan impresionado que invitó al niño a graduarse de la Universidad de Cambridge en el Reino Unido. Walter, aunque creció en una familia disfuncional, no se atrevió a mudarse de Detroit. Sin embargo, cuando Russell llegó a Chicago para dar conferencias, Pitts huyó a su casa para estudiar con él. No se convirtió en estudiante en la Universidad de Chicago, pero asistió diligentemente a conferencias. (La vida de Walter Pitts es, en general, muy brillante e interesante, a pesar de su corta duración. Recomiendo leer por su cuenta, traductor de aprox. ).

En 1942, Walter Pitts se reunió con Warren McCallock . McCullock invitó a Pitts a quedarse en su casa. Estaban convencidos de la exactitud de la teoría de Leibniz , que sugería la posibilidad de "mecanización" del pensamiento humano. Y trataron de crear un modelo para la neurobiología del sistema nervioso humano. Publicaron su artículo principal sobre el mismo en 1943, llamándolo "El cálculo lógico de ideas relacionadas con la actividad nerviosa ". Este documento ha hecho una contribución invaluable al campo de la inteligencia artificial. Los científicos han propuesto un modelo simple conocido como la neurona matemática McCullock-Pitts . Ella todavía está estudiando en cursos de aprendizaje automático. Las ideas que los científicos han propuesto son la base de casi toda la IA moderna.

Warren McCallock y Walter Pitts

La cibernética de Norbert Weiner y la teoría de la información de Claude Shannon se publicaron en 1948. La cibernética es un estudio de "control y comunicación en un organismo vivo y en una máquina". La teoría de la información es la medición de la cantidad de información, su almacenamiento y transmisión. Ambas obras tuvieron un gran impacto en la IA.

La cibernética proporcionó un estudio directo de la inteligencia biológica y mecánica. Y la teoría de la información ha influido en las matemáticas básicas.

Después de un par de años, Alan Turing realizó la prueba de Turing . Describió un método para determinar si una máquina es inteligente. La prueba simplificada es la siguiente: una persona se comunica con una computadora y una persona. Según sus respuestas a las preguntas, debe determinar con quién está hablando: una persona o un programa de computadora. La tarea de un programa de computadora es engañar a una persona y obligarla a tomar la decisión equivocada ”.

Aunque la prueba de Turing es demasiado limitada para probar los sistemas inteligentes modernos, fue un gran avance en ese momento. El nombre de Alan Turing llegó a la prensa, haciendo que la industria sea más popular.

Prueba de Turing

En 1956, se celebró una conferencia en Dartmouth sobre el tema del estudio de los conceptos de "mecanización" de la inteligencia. Más tarde, los participantes en esta conferencia se convertirán en personalidades destacadas en el campo de la IA. El más famoso fue Marvin Minsky , quien en 1951 creó la primera máquina de redes neuronales, SNARC. Se convertirá en el nombre más famoso en el mundo de la inteligencia artificial en las próximas décadas.

Claude Shannon también asistió a la conferencia. Y el futuro premio Nobel Herbert A. Simon y Allen Newell hicieron su debut con su " Lógico-Teórico ". Posteriormente, resolverá 38 de los primeros 52 teoremas en los Principios de Matemáticas de Russell.

John McCarthy, también uno de los pioneros de la inteligencia artificial, acuñó el nombre de "Inteligencia Artificial". Los participantes estuvieron de acuerdo con este término. Este fue el nacimiento de la IA.

Desarrollo industrial (1956–1974)

Red semántica

Gracias a esta conferencia, el interés por la IA ha crecido y han aparecido muchos desarrollos interesantes. En 1959, Newell y Simon crearon el "Solucionador de problemas comunes", que en teoría podría resolver cualquier problema formalizado. Y James Slagle creó un programa heurístico SAINT (Symbical Automatic INTegrator) que resolvió los problemas de integración simbólica en el cálculo. Estos programas fueron impresionantes.

Después de crear la prueba de Turing, la naturalidad del lenguaje se ha convertido en un área importante de la IA. El programa ESTUDIANTE de Daniel Bobrow pudo resolver problemas de palabras en la escuela secundaria. Un poco más tarde, apareció el concepto de red semántica: un mapa de varios conceptos y las relaciones entre ellos (como en la figura). Se han creado varios programas exitosos en esta red. En 1966, Joseph Weisenbaum creó ELIZA. Un interlocutor virtual podría mantener conversaciones realistas con personas.

En relación con un desarrollo tan activo de la industria de IA, los científicos hicieron declaraciones extremadamente audaces:

- Newell y Simon, 1958: "En 10 años, la computadora digital se convertirá en el campeón mundial de ajedrez". Y "dentro de 10 años, una computadora digital descubrirá y probará un nuevo teorema matemático importante".

- Simon GA, 1965: "Las máquinas serán capaces de realizar cualquier trabajo que una persona pueda hacer durante 20 años".

- Marvin Minsky, 1967: "En una generación ... el problema de crear" inteligencia artificial "se resolverá sustancialmente".

- Marvin Minsky, 1970: "En tres u ocho años, tendremos una máquina con la inteligencia general de una persona común".

De una forma u otra, el dinero entró en la industria. La Oficina de Proyectos de Investigación Avanzada (ARPA, más tarde renombrada DARPA) asignó $ 2.2 millones al equipo del MIT. El entonces presidente de DARPA decidió que deberían "financiar personas, no proyectos", y crearon una cultura de investigación gratuita. Esto permitió a los investigadores llevar a cabo cualquier proyecto que consideraran correcto.

Enfriamiento temporal (1974-1980)

En 1969, Marvin Minsky y Seymour Papert publicaron su libro Perceptrons . En él, mostraron las limitaciones fundamentales de los perceptrones y destacaron la incapacidad de los perceptrones para controlar el esquema elemental XOR. Esto llevó a un cambio en el interés de los investigadores de inteligencia artificial hacia el área de la computación simbólica, que es opuesta a las redes neuronales.

El enfoque alternativo de la IA simbólica ganó un crecimiento explosivo. Pero este enfoque no arrojó ningún resultado significativo. En la década de 1970, quedó claro que los investigadores de IA eran demasiado optimistas sobre la IA. Los objetivos que prometieron aún no se han alcanzado y su logro parece ser una cuestión de un futuro muy lejano.

Los investigadores se dieron cuenta de que descansan contra la pared. La IA se aplicó a tareas simples. Pero los escenarios reales eran demasiado complejos para estos sistemas. El número de posibilidades que los algoritmos tuvieron que explorar resultó ser astronómico. Esto condujo al problema de una explosión combinatoria . Y luego surgió la clásica pregunta "cómo hacer que una computadora sea inteligente". Era un problema de sentido común .

Todo esto llevó al hecho de que los inversores estaban decepcionados con la tecnología. La financiación de IA ha desaparecido y la investigación ha cesado. DARPA tampoco podría seguir apoyando una cultura de investigación de hackers debido a cambios en la legislación. Los patrocinadores han congelado los fondos para la investigación en el campo de la inteligencia artificial. Por lo tanto, el período 1974-1980. llamado " AI de invierno ".

Renacimiento

En 1981, el gobierno japonés comenzó a invertir seriamente en investigación en el campo de la inteligencia artificial. El país asignó $ 850 millones para el proyecto informático de quinta generación. Apuntó a desarrollar IA. Las supuestas computadoras tenían que comunicarse, traducir otros idiomas, reconocer imágenes. Se esperaba que las computadoras fueran la base para crear dispositivos que puedan simular el pensamiento.

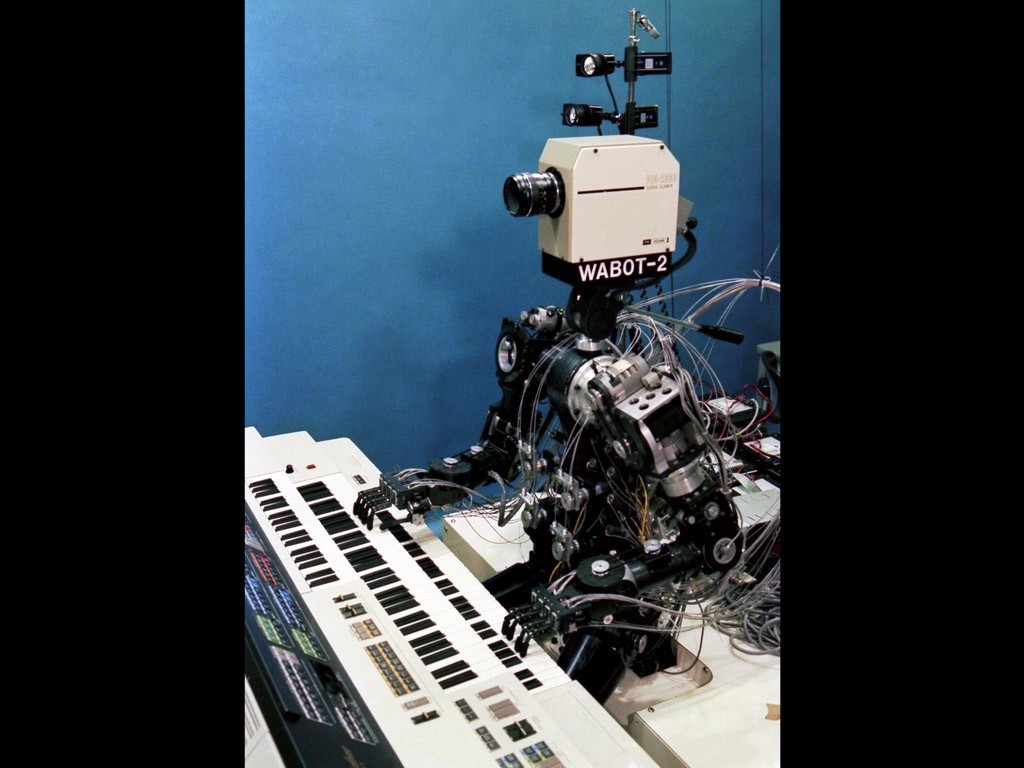

Wabot-2

La investigación en Japón parecía prometedora. En 1980, el robot Wabot-2 se desarrolló en la Universidad de Waseda. Podía comunicarse con la gente, leer partituras y tocar el órgano electrónico. El éxito de los japoneses ha obligado a otros gobiernos y empresas privadas a volver a mirar a la IA.

En este punto, surgió la cuestión del conexionismo. En 1982, Hopfield creó una nueva forma de red neuronal que es capaz de estudiar y procesar información. Jeffrey Hinton y David Rumelhart popularizaron la auto-distinción inversa. Esta tecnología fue fenomenal y sigue siendo vital en el aprendizaje automático hasta nuestros días.

AI obtuvo éxito comercial en forma de "sistemas expertos". Estos sistemas tenían un profundo conocimiento de un tema en particular. La Universidad Carnegie Mellon (CMU) lanzó un sistema experto llamado XCON en 1980. Fue utilizado en Digital Equipment Corporation. Hasta 1986, la compañía ahorró $ 40 millones anualmente.

Segundo invierno

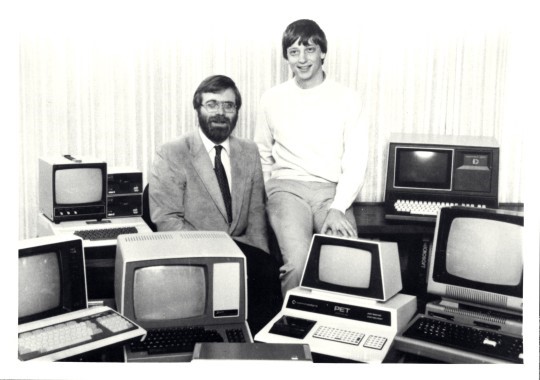

La revolución de la PC ha cambiado el curso del desarrollo de la IA

A fines de la década de 1980, la revolución informática eclipsó el éxito de la industria de inteligencia artificial. Apple e IBM produjeron computadoras cada vez más potentes al mismo tiempo. Las computadoras de escritorio se han vuelto más baratas y potentes que las máquinas Lisp de inteligencia artificial. Toda una industria por valor de medio billón de dólares fue destruida en una noche. Los éxitos de IA en sistemas expertos como la máquina XCON han demostrado ser demasiado caros.

Hay problemas con los sistemas expertos. No pudieron aprender. Eran "frágiles" (es decir, podrían cometer errores graves si recibieran datos inusuales). El alcance práctico de los sistemas expertos se ha vuelto limitado. El nuevo liderazgo de DARPA ha decidido que la IA no es la "próxima ola". Y redirigió las inversiones a proyectos que, desde su punto de vista, deberían traer resultados inmediatos.

Para 1991, los objetivos de un proyecto informático en Japón no se habían logrado. Los científicos subestimaron las dificultades que tuvieron que enfrentar. Más de 300 compañías de IA cerraron, se declararon en quiebra o fueron compradas a fines de 1993. En realidad, fue el final de la primera ola de uso comercial de la inteligencia artificial.

Corriente fresca

Cuando los ecos de la revolución informática comenzaron a disminuir, las personas tuvieron la oportunidad de utilizar una gran potencia informática. Con la ubicuidad de las computadoras, el número de bases de datos diversas ha crecido. Todo fue muy bueno en términos de desarrollo de IA.

Las nuevas tecnologías resolvieron problemas y eliminaron las barreras que interferían con los científicos. Usando una potencia informática cada vez mayor, los investigadores empujaron los límites de lo posible. De las bases de datos que se convirtieron en Big Data, fue posible extraer más y más conocimiento. Las posibilidades para el uso práctico de la IA se han vuelto más evidentes.

Un nuevo concepto llamado " agente inteligente " se estableció en la década de 1990. El agente inteligente (IA) es un sistema que realiza de forma independiente la tarea emitida por el usuario durante largos períodos de tiempo. Había la esperanza de que algún día podamos enseñar a la IA a interactuar entre sí. Esto llevaría a la creación de sistemas universales y más "inteligentes".

En la comunidad de IA, diferentes opiniones sobre el uso de las matemáticas en el campo de la inteligencia artificial vagaron. Algunos pensaban que la inteligencia era demasiado compleja para ser descrita con símbolos matemáticos. En su opinión, las personas rara vez se guían por la lógica al tomar decisiones. Sus oponentes objetaron que las cadenas lógicas son el camino a seguir.

G. Kasparov juega con Deep Blue

Muy pronto, en 1997, la supercomputadora IBM Deep Blue derrotó a Garry Kasparov. En ese momento, Kasparov era el campeón mundial de ajedrez. Lo que, según Newell y Simon, debía suceder en 1968, finalmente sucedió en 1997.

Las computadoras modernas de ajedrez son mucho más fuertes que cualquier persona. La calificación de Elo más alta jamás alcanzada por los humanos es de 2,882. Para las computadoras, la cifra más común es de 3,000 Elo. El más alto jamás registrado fue de más de 3.350.

En 2005, Stanford desarrolló un robot para la conducción autónoma. Ganó el DARPA Grand Challenge conduciendo 131 millas (211 km) a lo largo de un sendero por el desierto inexplorado.

Peligro

En febrero de 2011, IBM decidió probar su IBM Watson en el cuestionario Jeopardy. La computadora fue capaz de derrotar a los dos mejores campeones de Jeopardy por un margen significativo.

Con el desarrollo similar a una avalancha de Internet y las redes sociales, la cantidad de información ha crecido. Las compañías de TI necesitaban hacer algo con los datos que recibían. Y el uso de IA se ha convertido en una necesidad, no en entretenimiento.

Ahora Google clasifica los SERPs utilizando Machine Learning. YouTube selecciona videos recomendados utilizando algoritmos ML, recomienda productos de Amazon de la misma manera. La fuente de noticias de Facebook es generada por una computadora inteligente. E incluso Tinder encuentra personas que utilizan algoritmos ML.

Gracias a la revolución informática, la tecnología de IA se ha convertido en nuestra herramienta indispensable. Y ahora la humanidad mira hacia adelante, esperando la creación de súper máquinas. Y aunque los efectos de la inteligencia artificial a veces son controvertidos, un mayor desarrollo de esta tecnología es inevitable.

¿Qué más es útil para leer en el blog de Cloud4Y?

→ La computadora te hará sabrosa

→ AI ayuda a estudiar animales en África

→ El verano casi ha terminado. Casi no se filtraron datos

→ 4 formas de ahorrar en copias de seguridad en la nube

→ IoT, niebla y nubes: ¿hablar de tecnología?

¡Suscríbete a nuestro canal de Telegram para no perderte otro artículo! No escribimos más de dos veces por semana y solo por negocios.