A lo largo de su historia, desde los primeros robots de Asimov hasta AlphaGo, la IA ha tenido altibajos. Pero, de hecho, su historia recién comienza.

La inteligencia artificial es todavía muy joven. Sin embargo, muchos eventos importantes ya han ocurrido en esta área. Algunos de ellos atrajeron la atención de la cultura, otros generaron una onda expansiva, percibida solo por los científicos. Aquí hay algunos puntos clave que han tenido el mayor impacto en la IA.

1. Isaac Asimov mencionó por primera vez las " Tres leyes de la robótica " (1942)

La historia de Azimov "

Danza redonda " marca la primera aparición en las historias de este famoso escritor de ciencia ficción de las "Tres leyes de la robótica":

- Un robot no puede dañar a una persona o, por inacción, permitir que una persona sufra daños.

- Un robot debe obedecer todas las órdenes dadas por una persona, excepto en los casos en que estas órdenes sean contrarias a la Primera Ley.

- El robot debe cuidar su seguridad en la medida en que no contradiga las Leyes Primera o Segunda.

En la historia "Round dance", el robot Speedy se coloca en una posición en la que la tercera ley está en conflicto con las dos primeras. Las historias de Azimov sobre robots hicieron pensar a los fanáticos de NF, incluidos los científicos, sobre la posibilidad de pensar en máquinas. Hasta el día de hoy, las personas participan en ejercicios intelectuales, aplicando las leyes de Asimov a la inteligencia artificial moderna.

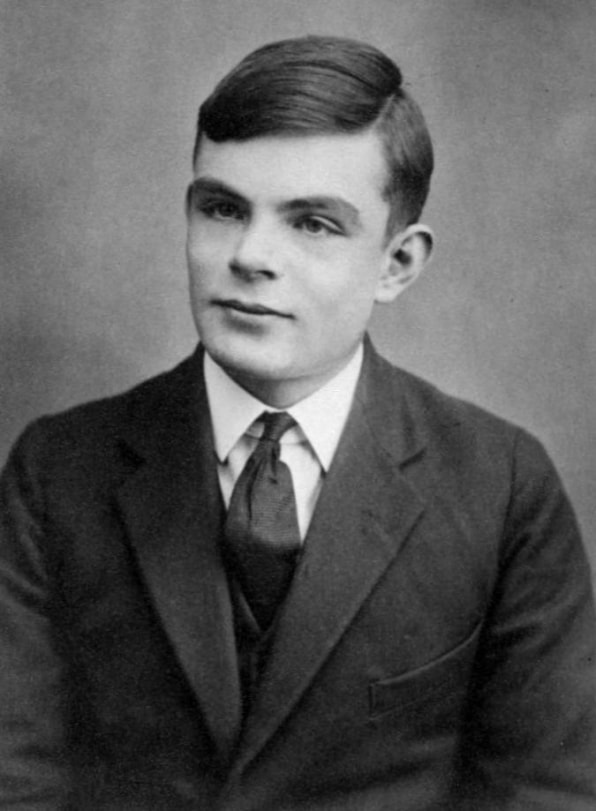

2. Alan Turing propuso su "Juego de imitación" (1950)

Alan Turing describió el primer principio de medir el grado de racionalidad de una máquina en 1950.

Alan Turing describió el primer principio de medir el grado de racionalidad de una máquina en 1950.Propongo considerar la pregunta "¿Pueden pensar los automóviles?" Así comenzó el influyente trabajo de investigación de Turing de 1950, que desarrolló un sistema de creencias para razonar sobre la mente mecánica. Preguntó si una máquina puede considerarse inteligente si puede imitar el comportamiento humano.

Esta pregunta teórica dio origen al famoso "Juego de simulación" [más tarde se llamará "

Prueba de Turing " / aprox. transl.], un ejercicio en el que una persona investigadora debe determinar con quién se correspondía, con una computadora o una persona. En el momento de Turing, no había máquinas capaces de pasar esta prueba; hoy no hay ninguna. Sin embargo, su prueba dio una manera simple de determinar si la mente estaba en el auto. También ayudó a dar forma a la filosofía de la IA.

3. Conferencia de IA de Dartmouth (1956)

Para 1955, los científicos de todo el mundo ya habían formado conceptos como redes neuronales y lenguaje natural, pero todavía no había conceptos unificadores que abarcaran diversas variedades de inteligencia artificial. John McCarthy, profesor de matemáticas en el Dartmouth College, acuñó el término "inteligencia artificial" para reunirlos a todos.

McCarthy dirigió el grupo que solicitó una subvención para organizar una conferencia de IA en 1956. Muchos investigadores destacados de la época fueron invitados a Dartmouth Hall en el verano de 1956. Los científicos discutieron varias áreas potenciales de estudio de IA, incluyendo aprendizaje y búsqueda, visión, razonamiento lógico, lenguaje y razón, juegos (en particular ajedrez), interacciones humanas con máquinas inteligentes como robots personales.

El consenso general de esas discusiones fue que la IA tiene un tremendo potencial para beneficiar a las personas. Se describió el campo general de las áreas de investigación, cuyo desarrollo puede ser influenciado por la inteligencia artificial. La conferencia organizó e inspiró la investigación de IA durante muchos años.

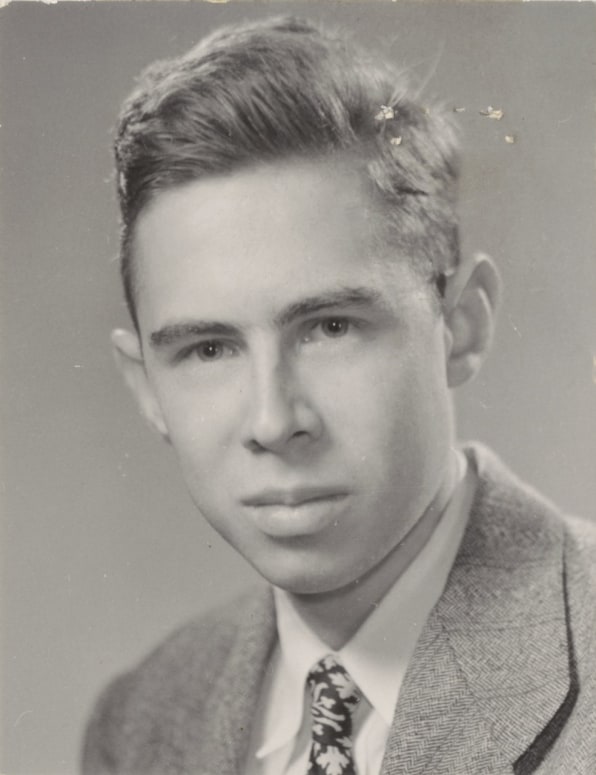

4. Frank Rosenblatt crea el perceptrón (1957)

Frank Rosenblatt creó una red neuronal mecánica en el Laboratorio de Aeronáutica de Cornell en 1957.

Frank Rosenblatt creó una red neuronal mecánica en el Laboratorio de Aeronáutica de Cornell en 1957.El componente básico de la red neuronal se llama "

perceptrón " [este es solo el

primer tipo

primitivo de neurona artificial / aprox. transl.]. Un conjunto de datos de entrada cae en el nodo que calcula el valor de salida y proporciona una clasificación y un nivel de confianza. Por ejemplo, los datos de entrada pueden analizar varios aspectos de la imagen en función de los datos de entrada y "votar" (con un cierto nivel de confianza) para ver si hay una cara en ella. Luego, el nodo cuenta todas las "voces" y el nivel de confianza, y da consenso. En las redes neuronales de hoy, que se ejecutan en computadoras potentes, miles de millones de estructuras similares están trabajando juntas.

Sin embargo, los perceptrones existían incluso antes del advenimiento de las computadoras poderosas. A fines de la década de 1950, un joven investigador psicólogo Frank Rosenblatt creó un modelo electromecánico del perceptrón llamado Mark I Perceptron, que se almacena hoy en la Institución Smithsonian. Era una red neuronal analógica, que consistía en una red de elementos fotosensibles conectados por cables a bancos de nodos que contenían motores eléctricos y resistencias rotativas. Rosenblatt desarrolló el "algoritmo de perceptrón", que controlaba la red, que ajustaba gradualmente la fuerza de las señales de entrada para que, como resultado, los objetos se identificaran correctamente; de hecho, se entrenó.

Los científicos discutieron sobre la importancia de esta máquina hasta la década de 1980. Jugó un papel importante en la creación de la encarnación física de la red neuronal, que hasta entonces existía principalmente en forma de un concepto científico.

5. La IA se enfrenta a su primer invierno (años 70)

Durante la mayor parte de su historia, la IA solo existió en la investigación. Durante gran parte de la década de 1960, las agencias gubernamentales, en particular DARPA, invirtieron dinero en investigación y prácticamente no requirieron un informe de inversión. Los investigadores de IA a menudo exageraron el potencial de su trabajo para continuar recibiendo fondos. Todo cambió a fines de los años sesenta y principios de los setenta. Dos informes, uno de la Junta Asesora de ALPAC para el Gobierno de EE. UU. En 1966 y el segundo de Lighthill para el Gobierno Británico en 1973, evaluaron pragmáticamente el progreso en la investigación de IA y dieron un pronóstico muy pesimista sobre el potencial de esta tecnología. Ambos informes cuestionaron la existencia de un progreso tangible en varias áreas de la investigación de IA. Lighthill en su informe argumentó que la IA para tareas de reconocimiento de voz sería extremadamente difícil de escalar a tamaños que podrían ser útiles para el gobierno o el ejército.

Como resultado, los gobiernos de los Estados Unidos y Gran Bretaña comenzaron a recortar fondos para la investigación de IA para las universidades. DARPA, que financió la investigación de IA sin problemas en la década de 1960, comenzó a exigir plazos claros de los proyectos y una descripción detallada de los resultados esperados. Como resultado, comenzó a parecer que la IA no cumplía con las expectativas y nunca podría alcanzar el nivel de las capacidades humanas. El primer "invierno" de la IA duró todos los años setenta y ochenta.

6. La llegada del segundo invierno de AI (1987)

La década de 1980 comenzó con el desarrollo y los primeros éxitos de los "

sistemas expertos " que almacenaban grandes cantidades de datos y emulaban el proceso de toma de decisiones por parte de las personas. La tecnología se desarrolló originalmente en la Corporación Carnegie Mellon para Digital Equipment Corporation, y luego otras corporaciones comenzaron a implementarla rápidamente. Sin embargo, los sistemas expertos requerían equipos especializados costosos, y esto se convirtió en un problema cuando comenzaron a aparecer estaciones de trabajo similares y más baratas de Sun Microsystems, así como computadoras personales de Apple e IBM. El mercado de sistemas informáticos expertos colapsó en 1987 cuando los principales fabricantes de equipos lo abandonaron.

El éxito de los sistemas expertos a principios de los años 80 inspiró a DARPA a aumentar los fondos para la investigación de IA, pero pronto cambió nuevamente y la agencia redujo la mayor parte de estos fondos, dejando solo unos pocos programas. Una vez más, el término "inteligencia artificial" en la comunidad de investigación se ha vuelto casi prohibido. Para que no fueran percibidos como soñadores poco prácticos en busca de financiación, los investigadores comenzaron a usar otros nombres para el trabajo relacionado con las SS: "informática", "aprendizaje automático" y "análisis". Este segundo invierno de IA continuó hasta la década de 2000.

7. IBM Deep Blue derrota a Kasparov (1997)

IBM Deep Blue derrotó al mejor jugador de ajedrez del mundo, Garry Kasparov, en 1997.

IBM Deep Blue derrotó al mejor jugador de ajedrez del mundo, Garry Kasparov, en 1997.La conciencia pública sobre la IA mejoró en 1997 cuando la computadora de ajedrez Deep Blue de IBM derrotó al entonces campeón mundial Garry Kasparov. De los seis juegos celebrados en el estudio de televisión, Deep Blue ganó en dos, Kasparov en uno, y tres terminaron en empate. A principios de ese año, Kasparov derrotó a la versión anterior de Deep Blue.

La computadora Deep Blue tenía suficiente poder de cómputo, y utilizaba el "método de fuerza bruta", o búsqueda exhaustiva, evaluando 200 millones de movimientos posibles por segundo y eligiendo el mejor. Las habilidades de las personas se limitan a evaluar solo unos 50 movimientos después de cada movimiento. El trabajo de Deep Blue fue similar al trabajo de AI, pero la computadora no pensó en estrategias y no aprendió el juego, como los sistemas que lo siguieron podrían hacer.

Sin embargo, la victoria de Deep Blue sobre Kasparov devolvió de manera impresionante a AI al círculo de la atención pública. Algunas personas estaban fascinadas. A otros no les gustó que la máquina venciera a un experto en ajedrez. Los inversores quedaron impresionados: la victoria de Deep Blue de $ 10 aumentó el valor de las acciones de IBM, llevándolas al máximo de ese tiempo.

8. Red neuronal ve gatos (2011)

Para 2011, científicos de universidades de todo el mundo hablaron sobre redes neuronales y las crearon. El programador de Google

Jeff Dean se reunió con el profesor de TI de Stanford

Andrew Eun ese año. Juntos, concibieron la creación de una gran red neuronal, proporcionada por la enorme potencia informática de los servidores de Google, que podría alimentar un gran conjunto de imágenes.

La red neuronal que crearon funcionó en 16,000 procesadores de servidor. Le dieron 10 millones de marcos aleatorios y sin etiqueta de videos de YouTube. Dean y Eun no le pidieron a la red neuronal que brinde información específica o que marque estas imágenes. Cuando una red neuronal funciona de esta manera, aprendiendo sin un maestro, naturalmente trata de encontrar patrones en las clasificaciones de datos y formularios.

La red neuronal procesó las imágenes durante tres días. Luego, produjo tres imágenes borrosas que denotan imágenes visuales que encontró una y otra vez en los datos de entrenamiento: la cara de una persona, el cuerpo de una persona y un gato. Este estudio fue un gran avance en el uso de redes neuronales y el aprendizaje no docente en la visión por computadora. También marcó el inicio del proyecto Google Brain.

9. Joffrey Hinton desató redes neuronales profundas (2012)

La investigación de Joffrey Hinton ha revivido el interés en el aprendizaje profundo

La investigación de Joffrey Hinton ha revivido el interés en el aprendizaje profundoUn año después del avance, Dean y Un, un profesor de la Universidad de Toronto, Joffrey Hinton, y dos de sus estudiantes crearon una red neuronal para visión artificial, AlexNet, para participar en el concurso de reconocimiento de imágenes ImageNet. Los participantes tuvieron que usar sus sistemas para procesar millones de imágenes de prueba e identificarlas con la mayor precisión posible. AlexNet ganó la competencia con un porcentaje de errores dos veces y media menor que el del competidor más cercano. En cinco versiones del título de imagen proporcionado por la red neuronal, solo en el 15,3% de los casos no había una opción correcta. El registro anterior fue el 26% de los errores.

Esta victoria mostró de manera convincente que las redes neuronales profundas que se ejecutan en GPU, donde mejor que otros sistemas pueden determinar y clasificar con precisión las imágenes. Este evento, quizás más que otros, influyó en la reactivación del interés en las redes neuronales profundas y le valió a Hinton el apodo de "padrino del aprendizaje profundo". Junto con otros gurús de la IA, Yoshua Benjio y Jan Lekun, Hinton recibió el tan esperado Premio Turing en 2018.

10. AlphaGo derrota al campeón mundial en go (2016)

En 2013, los investigadores de la startup británica DeepMind publicaron un artículo que describe cómo una red neuronal aprendió a jugar y ganar en 50 juegos antiguos de Atari. Impresionado por esto, Google compró la compañía, como dicen, por $ 400 millones. Sin embargo, la fama principal de DeepMind todavía estaba por delante.

Unos años más tarde, los científicos de DeepMind, ahora dentro del marco de Google, cambiaron de los juegos de Atari a una de las tareas de IA más antiguas: el juego de mesa japonés. Desarrollaron la red neuronal AlphaGo, capaz de jugar y aprender mientras juegan. El programa ha llevado a cabo miles de juegos contra otras versiones de AlphaGo, aprendiendo de pérdidas y victorias.

Y funcionó. AlphaGo derrotó al mejor jugador de go del mundo,

Lee Sedola , 4-1 en una serie de juegos en marzo de 2016. El proceso fue filmado para un documental. Al verlo, es difícil no notar la tristeza con que Sedol percibió la pérdida. Parecía que todas las personas perdieron, y no solo una persona.

Los avances recientes en el campo de las redes neuronales profundas han cambiado tanto el campo de la inteligencia artificial que su historia real, tal vez, apenas está comenzando. Estamos esperando muchas esperanzas, exageraciones e impaciencia, pero ahora está claro que la IA afectará todos los aspectos de la vida en el siglo XXI, y tal vez incluso más que Internet en un momento dado.