Una paleta facilita a los pintores organizar y mezclar pinturas de diferentes colores a medida que crean arte en el lienzo que tienen delante. Tener una herramienta similar que permita a AI aprender conjuntamente de diversas fuentes de datos, como las de conversaciones, narrativas, imágenes y conocimiento, podría abrir puertas para que investigadores y científicos desarrollen sistemas de IA capaces de una inteligencia más general.

Una paleta le permite al pintor organizar y mezclar pinturas de diferentes colores. SpaceFusion busca ayudar a los científicos de IA a hacer cosas similares para diferentes modelos entrenados en diferentes conjuntos de datos.

Una paleta le permite al pintor organizar y mezclar pinturas de diferentes colores. SpaceFusion busca ayudar a los científicos de IA a hacer cosas similares para diferentes modelos entrenados en diferentes conjuntos de datos. Para los modelos de aprendizaje profundo en la actualidad, los conjuntos de datos generalmente están representados por vectores en diferentes espacios latentes utilizando diferentes redes neuronales. En el documento "

Optimización conjunta de la diversidad y la relevancia en la generación de respuesta neuronal ", mis coautores y yo proponemos SpaceFusion, un paradigma de aprendizaje para alinear estos diferentes espacios latentes, organizarlos y mezclarlos suavemente como la pintura en una paleta, para que la IA pueda aprovechar Los patrones y el conocimiento incrustado en cada uno de ellos. Este trabajo, que presentamos en la

Conferencia Anual 2019 del Capítulo de América del Norte de la Asociación de Lingüística Computacional: Tecnologías del Lenguaje Humano (NAACL-HLT) , es parte del proyecto de

Conversación Dirigida por Datos , y su implementación es disponible en

GitHub .

Capturando el color de la conversación humana.

Como primer intento, aplicamos esta técnica a la IA neuronal conversacional. En nuestra configuración, se espera que un modelo neuronal genere respuestas relevantes e interesantes dado un historial de conversación o contexto. Si bien se han realizado avances prometedores en los modelos de conversación neuronal, estos modelos tienden a ser seguros, produciendo respuestas genéricas y aburridas. Se han desarrollado enfoques para diversificar estas respuestas y capturar mejor el color de la conversación humana, pero a menudo,

hay una compensación, con una disminución de la relevancia .

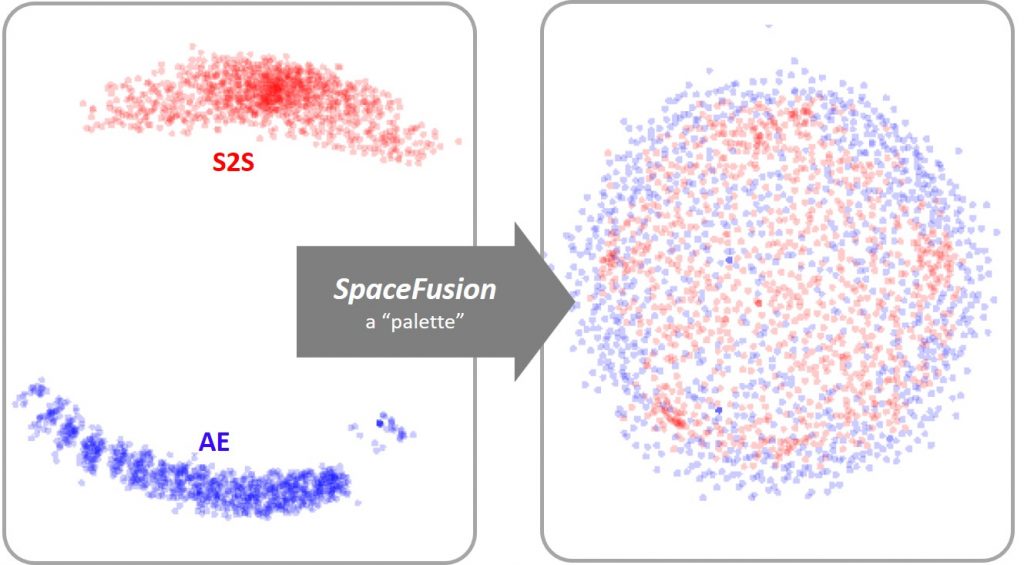

Figura 1: al igual que una paleta permite la combinación fácil de pinturas, SpaceFusion alinea o mezcla, los espacios latentes aprendidos de un modelo secuencia a secuencia (S2S, puntos rojos) y un autoencoder (AE, puntos azules) para utilizar conjuntamente Los dos modelos más eficientemente.

Figura 1: al igual que una paleta permite la combinación fácil de pinturas, SpaceFusion alinea o mezcla, los espacios latentes aprendidos de un modelo secuencia a secuencia (S2S, puntos rojos) y un autoencoder (AE, puntos azules) para utilizar conjuntamente Los dos modelos más eficientemente.SpaceFusion aborda este problema alineando los espacios latentes aprendidos de dos modelos (Figura 1):

- un modelo de secuencia a secuencia (S2S), cuyo objetivo es producir respuestas relevantes, pero puede carecer de diversidad; y

- un modelo de autoencoder (AE), que es capaz de representar diversas respuestas, pero no captura su relación con la conversación.

El modelo aprendido conjuntamente puede utilizar las fortalezas de ambos modelos y organizar los puntos de datos de una manera más estructurada.

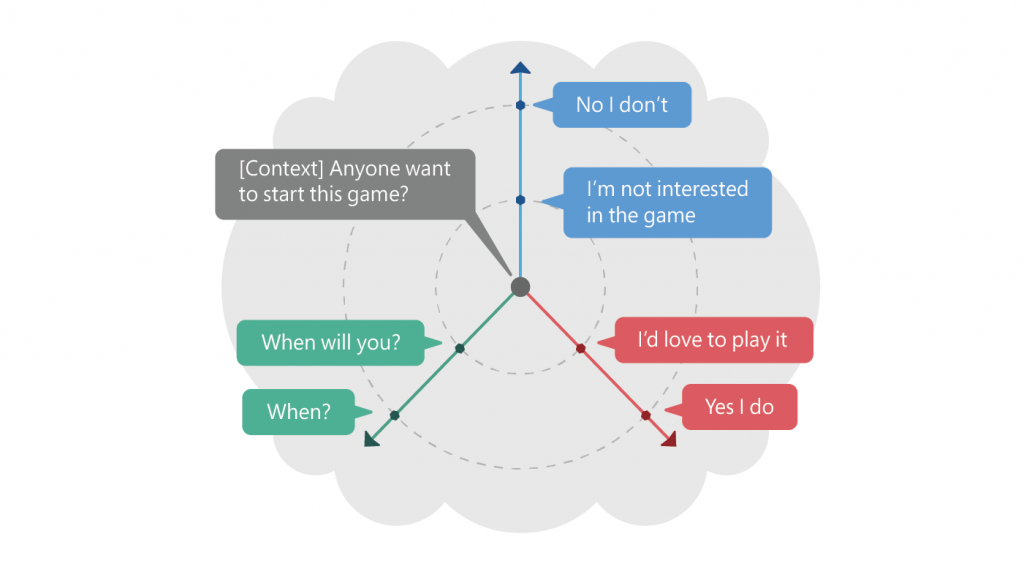

Figura 2: lo anterior ilustra un contexto y sus múltiples respuestas en el espacio latente inducido por SpaceFusion. La distancia y la dirección del vector de respuesta previsto dado el contexto coinciden aproximadamente con la relevancia y la diversidad, respectivamente.

Figura 2: lo anterior ilustra un contexto y sus múltiples respuestas en el espacio latente inducido por SpaceFusion. La distancia y la dirección del vector de respuesta previsto dado el contexto coinciden aproximadamente con la relevancia y la diversidad, respectivamente.Por ejemplo, como se ilustra en la Figura 2, dado un contexto, en este caso, "¿Alguien quiere comenzar este juego?", Las respuestas positivas "Me encantaría jugarlo" y "Sí, lo hago" están organizadas a lo largo del misma direccion. Los negativos, "No estoy interesado en el juego" y "No, no", se asignan en una línea en otra dirección. La diversidad en las respuestas se logra explorando el espacio latente a lo largo de diferentes direcciones. Además, la distancia en el espacio latente corresponde a la relevancia. Las respuestas más alejadas del contexto ("Sí, lo hago" y "No, no lo hago") suelen ser genéricas, mientras que las más cercanas son más relevantes para el contexto específico: "No estoy interesado en el juego" y " ¿Cuándo lo harás?

SpaceFusion separa los criterios de relevancia y diversidad y los representa en dos dimensiones independientes: dirección y distancia, lo que facilita la optimización conjunta de ambos. Nuestros experimentos empíricos y la evaluación en humanos han demostrado que SpaceFusion funciona mejor en estos dos criterios en comparación con las líneas de base competitivas.

Aprendiendo un espacio latente compartido

Entonces, ¿cómo exactamente SpaceFusion alinea diferentes espacios latentes?

La idea es bastante intuitiva: para cada par de puntos de dos espacios latentes diferentes, primero minimizamos su distancia en el espacio latente compartido y luego fomentamos una transición suave entre ellos. Esto se realiza mediante la adición de dos nuevos términos de regularización - término de distancia y término de suavidad - a la función objetivo.

Tomando como ejemplo la conversación, el término distancia mide la distancia euclidiana entre un punto del espacio latente S2S, que se mapea desde el contexto y representa la respuesta pronosticada, y los puntos del espacio latente AE, que corresponden a sus respuestas objetivo. Minimizar dicha distancia alienta al modelo S2S a mapear el contexto a un punto cercano y rodeado por sus respuestas en el espacio latente compartido, como se ilustra en la Figura 2.

El término suavidad mide la probabilidad de generar la respuesta objetivo a partir de una interpolación aleatoria entre el punto mapeado desde el contexto y el mapeado desde la respuesta. Al maximizar esta probabilidad, fomentamos una transición suave del significado de las respuestas generadas a medida que nos alejamos del contexto. Esto nos permite explorar la vecindad del punto de predicción realizado por el S2S y generar respuestas diversas que son relevantes para el contexto.

Con estas dos nuevas regularizaciones agregadas en la función objetivo, ponemos las restricciones de distancia y suavidad en el aprendizaje del espacio latente, por lo que la capacitación no solo se centrará en el rendimiento en cada espacio latente, sino que también intentaremos alinearlas agregando estas estructuras deseadas Nuestro trabajo se centró en modelos conversacionales, pero esperamos que SpaceFusion pueda alinear los espacios latentes aprendidos por otros modelos entrenados en diferentes conjuntos de datos. Esto hace posible unir diferentes habilidades y dominios de conocimiento aprendidos por cada sistema de IA específico y es un pequeño paso hacia una inteligencia más general.