El mundo que nos rodea está cambiando constante y continuamente, lo queramos o no. Y un gran papel en esto lo juegan las tecnologías, cuyo desarrollo y difusión se está volviendo cada vez más activo cada año. Ya no consideramos que el automóvil sea una rareza, sino que las comunicaciones móviles son mágicas. La tecnología se ha convertido en parte de nuestra vida diaria, trabajo y de nosotros mismos. Según los filmes sobre Terminator, uno de los temas más populares entre los futurólogos y los escritores de ciencia ficción siempre ha sido los robots, máquinas autónomas que pueden facilitar la vida de una persona u organizar el genocidio total de todos los seres vivos del planeta. En cualquier caso, quedan varias preguntas muy divertidas: ¿cómo se comportará una persona con una máquina, confiará en ella y qué tan efectiva será su cooperación? Los científicos del laboratorio de investigación del Ejército de EE. UU. Decidieron realizar una serie de experimentos para establecer qué aspectos del comportamiento y la "apariencia" de una máquina autónoma mejoran la colaboración con los humanos. Lo que logramos averiguar exactamente lo aprendemos de su informe. Vamos

Base de estudio

Para comprender mejor la relación entre el hombre y la máquina, primero debe mirar la relación entre el hombre y el hombre. Dado que la población del planeta está dividida en muchos grupos (religión, nacionalidad, etnia, etc.), una persona siempre dividirá a las personas en "nosotros" y "ellos". Este proceso de separación, según los investigadores, avanza a un nivel subconsciente y conduce a un aumento en la probabilidad de elegir una persona que pertenezca al mismo grupo para la cooperación. Los científicos también señalan que estas preferencias no tienen nada que ver con las manifestaciones de discriminación contra personas de otras nacionalidades, religiones y otras cosas.

En el caso de las máquinas autónomas, no queda claro si dicha categorización social tiene lugar en el momento de la cooperación del hombre y la máquina. Si es así, ¿cómo se manifiesta, cómo se regula y cómo se puede cambiar?

Para probar esto, los científicos llevaron a cabo una serie de experimentos, cuyos participantes eran personas de dos culturas distantes (Estados Unidos y Japón) y automóviles con caras virtuales correspondientes a las mismas culturas y que expresaban ciertas emociones.

Hubo 468 participantes de los Estados Unidos y 477 de Japón.

Las características demográficas de un grupo de EE. UU. Fueron las siguientes:

- género: 63.2% - hombres y 36.8% - mujeres;

- edad: 0.9% - 18-21; 58.5% - 22-34; 21,6% - 35-44; 10,7% - 45-54; 6.2% - 55-64; 2.1% - mayores de 64 años;

- origen étnico: 77,3% - indoeuropeo; 10,3% - afroamericanos; 1.3% - Indias Orientales; 9.2% - hispano; 6.0% - Asiático (sureste).

Las características demográficas para el grupo de Japón fueron las siguientes:

- género: 67.4 - hombres y 32.6% - mujeres;

- edad: 0.6% - 18-21; 15,7% - 22-34; 36,4% - 35-44; 34,7% - 45-54; 10,4% - 55-64; 2.1% - mayores de 64 años;

- origen étnico: 0.6% - indio del este; 99.4% - Asiático (sureste).

Las personas pueden relacionarse entre sí de diferentes maneras, dependiendo de la categorización personal, pero vale la pena recordar que una máquina autónoma no es una persona. Por lo tanto, este dispositivo ya pertenece a otro grupo social, por así decirlo, de forma predeterminada. Por supuesto, una persona puede percibir una máquina como un actor social (participante en algún tipo de interacción), pero la percibirá de manera diferente de lo que percibiría a otra persona viva de carne y hueso.

Un ejemplo sorprendente de esto es el estudio anterior del cerebro humano durante un juego de "piedra-papel-tijera". Cuando una persona jugaba con otra persona, se activaba la corteza prefrontal medial, que desempeña un papel importante en la

mentalización * .

Mentalización * : la capacidad de representar el estado mental de uno mismo y de otras personas.

Pero cuando jugaba con la máquina, esta parte del cerebro no se activaba.

Resultados similares fueron mostrados por experimentos con el juego del ultimátum.

El juego de ultimátum * es un juego económico en el que el jugador número 1 recibe una cierta cantidad de dinero y debe compartirlo con el jugador número 2, a quien ve por primera vez. La oferta puede ser cualquiera, pero si el jugador número 2 la rechaza, ambos jugadores no recibirán dinero en absoluto.

Cuando el jugador # 2 recibió una oferta injusta del jugador # 1 (humano), activó secciones del lóbulo central del cerebro responsables de la formación de emociones negativas. Si el jugador 1 era un auto, entonces no se observó tal reacción.

Tales experimentos confirman una vez más el hecho de que una persona percibe una máquina de manera diferente a otra persona. Algunos investigadores creen que la máquina no representa competencia para nosotros desde el punto de vista de nuestros instintos y, por lo tanto, existe una actividad reducida similar (o incluso ninguna) de ciertas regiones del cerebro.

Todo es bastante lógico: el hombre es un lobo para el hombre, pero incluso entre los lobos hay un cierto grado de confianza y deseo de cooperar en ciertas condiciones. Pero el auto actúa como un zorro, con el cual los lobos no quieren cooperar con la palabra. Sin embargo, tales preferencias no cancelan el hecho de que hay más y más robots en nuestro mundo y, por lo tanto, necesitamos encontrar métodos para mejorar la relación entre nosotros y ellos.

¿Por qué los investigadores decidieron usar este tipo de categorización social como identidad cultural? En primer lugar, ya se ha establecido anteriormente que una persona reacciona positivamente a máquinas que tienen ciertas características del habla (énfasis, por ejemplo), normas sociales y raza.

En segundo lugar, en los casos en que representantes de diferentes grupos sociales participan en los experimentos, se traza un entretejido distinto de cooperación y competencia en las primeras etapas. En las etapas posteriores, cuando los participantes se conocen mejor, se traza una línea clara de comportamiento correspondiente a la tarea de la experiencia. En pocas palabras, los participantes de diferentes grupos sociales no confiaban entre sí, incluso cuando la tarea de la experiencia estaba relacionada con la cooperación. Pero después de un tiempo, la confianza y el deseo de completar la tarea superaron la desconfianza subconsciente.

En tercer lugar, los experimentos anteriores han demostrado que las expectativas iniciales de cooperación basadas en la categorización social pueden rechazarse si recurrimos a signos (emociones) más significativos en la situación.

Es decir, los investigadores dotaron a la máquina de características visuales de aquellos grupos sociales a los que pertenecían los participantes del experimento (personas) y una serie de expresiones emocionales, y luego verificaron diferentes combinaciones para identificar la conexión.

De todo esto, se identificaron dos hipótesis principales. La primera es que la asociación de signos positivos de identidad cultural puede mitigar los prejuicios desfavorables que las personas tienen por defecto sobre las máquinas. En segundo lugar, la expresión de las emociones puede superar las expectativas de cooperación / competencia basadas en la identidad cultural. En otras palabras, si le das al automóvil características visuales de un determinado grupo cultural, entonces las personas del mismo grupo pueden confiar más en él inconscientemente. Sin embargo, en el caso de la manifestación de ciertas emociones, que indican la falta de voluntad de la máquina para cooperar, todos los prejuicios culturales instantáneamente dejan de ser importantes.

Curiosamente, el experimento se basó en el dilema del prisionero, un juego en el que la cooperación no es una táctica ganadora. Siguiendo la teoría de los juegos, el prisionero (jugador) siempre maximizará su propio beneficio, sin pensar en los beneficios de otros jugadores. Por lo tanto, la racionalidad debería empujar a los jugadores hacia la traición y la falta de voluntad para cooperar, pero en realidad los resultados de tales experimentos a menudo están lejos de ser racionales, lo que explica la presencia de la palabra "dilema" en el nombre de este juego matemático. Hay una pequeña trampa: si un jugador cree que el segundo no cooperará, entonces tampoco debería cooperar, sin embargo, si ambos jugadores siguen esas tácticas, ambos perderán.

Resultados del experimento

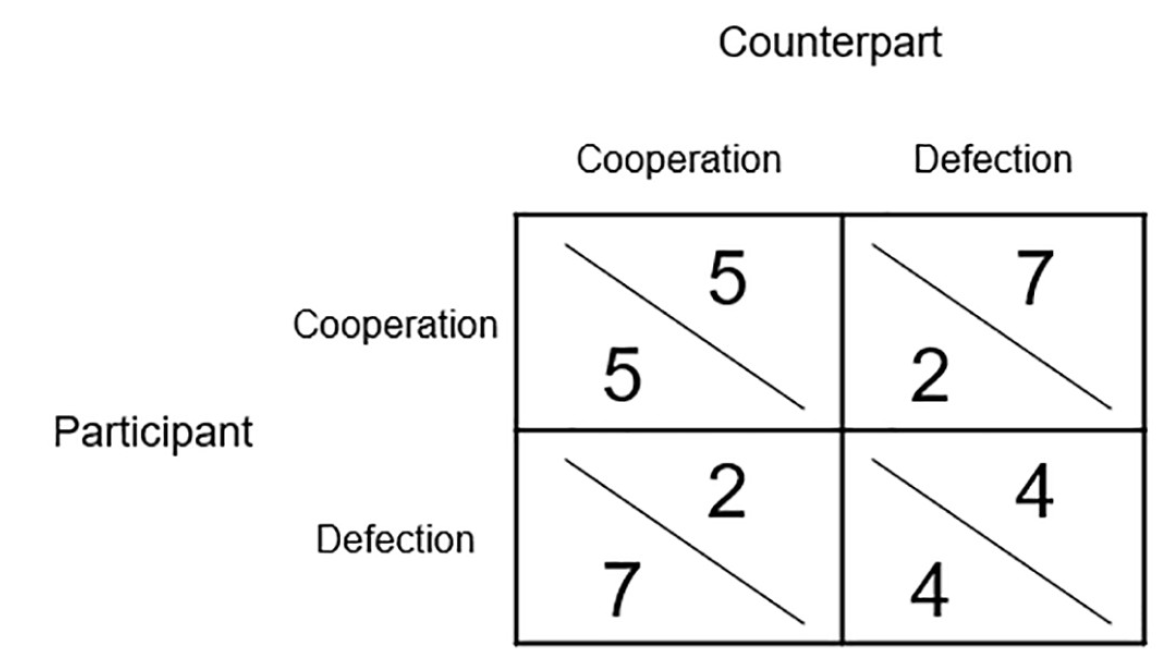

Imagen No. 1

Imagen No. 1En total, cada uno de los participantes en el experimento pasó 20 rondas jugando con la máquina. La imagen de arriba es una matriz de ganancia. Los puntos obtenidos durante el juego tuvieron beneficios financieros reales, ya que posteriormente se convirtieron en boletos de lotería con un monto ganador de $ 30.

El objetivo principal del experimento fue identificar cómo los participantes colaborarán / competirán con personas o máquinas, y cómo la identidad cultural y las emociones influirán en estos procesos.

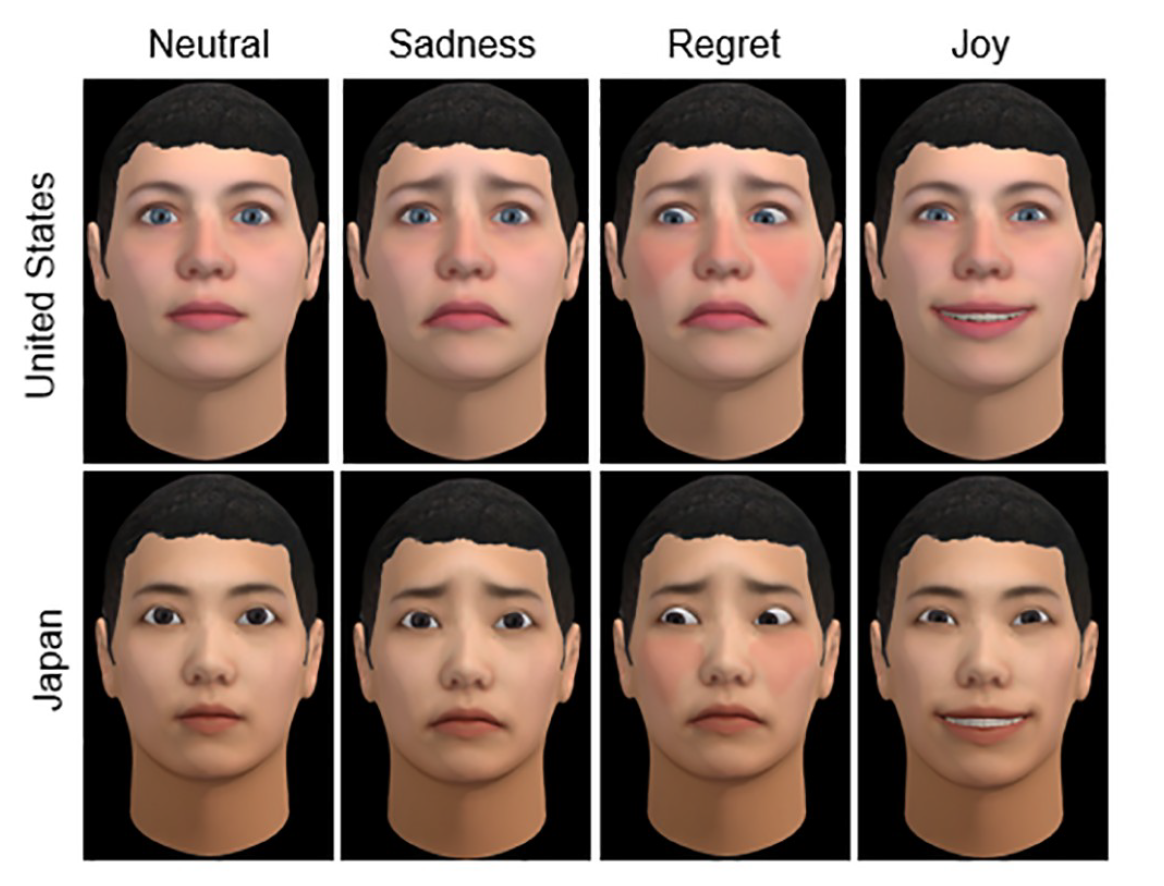

Imagen No. 2

Imagen No. 2Lo anterior son dos identidades culturales (Estados Unidos y Japón) de caras virtuales para máquinas que expresan diferentes emociones (neutral, tristeza, arrepentimiento y alegría). Vale la pena señalar que todos los participantes en los experimentos usaron caras virtuales, es decir personas y autos.

La serie emocional no fue elegida por casualidad. Experimentos anteriores con el dilema del prisionero mostraron que algunas emociones pueden alentar la cooperación, mientras que otras pueden competir, dependiendo del momento en que se expresen.

En este modelo, las emociones de la máquina y las acciones que las causan se dividieron en dos categorías principales.

Empujar a una persona a la competencia:

- arrepentimiento después de la cooperación mutua (la máquina perdió la oportunidad de operar un miembro humano para su propio beneficio);

- alegría después de la operación (el participante coopera, pero no recibe nada a cambio del automóvil);

- tristeza después de la competencia mutua / emoción neutral después de la cooperación mutua.

Animar a las personas a cooperar:

- la alegría de la cooperación mutua;

- arrepentimiento de la explotación;

- tristeza después de la competencia mutua.

Así, en el experimento hubo varias variables al mismo tiempo: identidad cultural (EE. UU. O Japón), el tipo declarado de pareja (persona o máquina) y emociones expresadas (competitivas o colaborativas).

Los resultados de los experimentos se dividieron en dos categorías según el tipo de pares de participantes: participantes de un grupo cultural y participantes de diferentes grupos culturales.

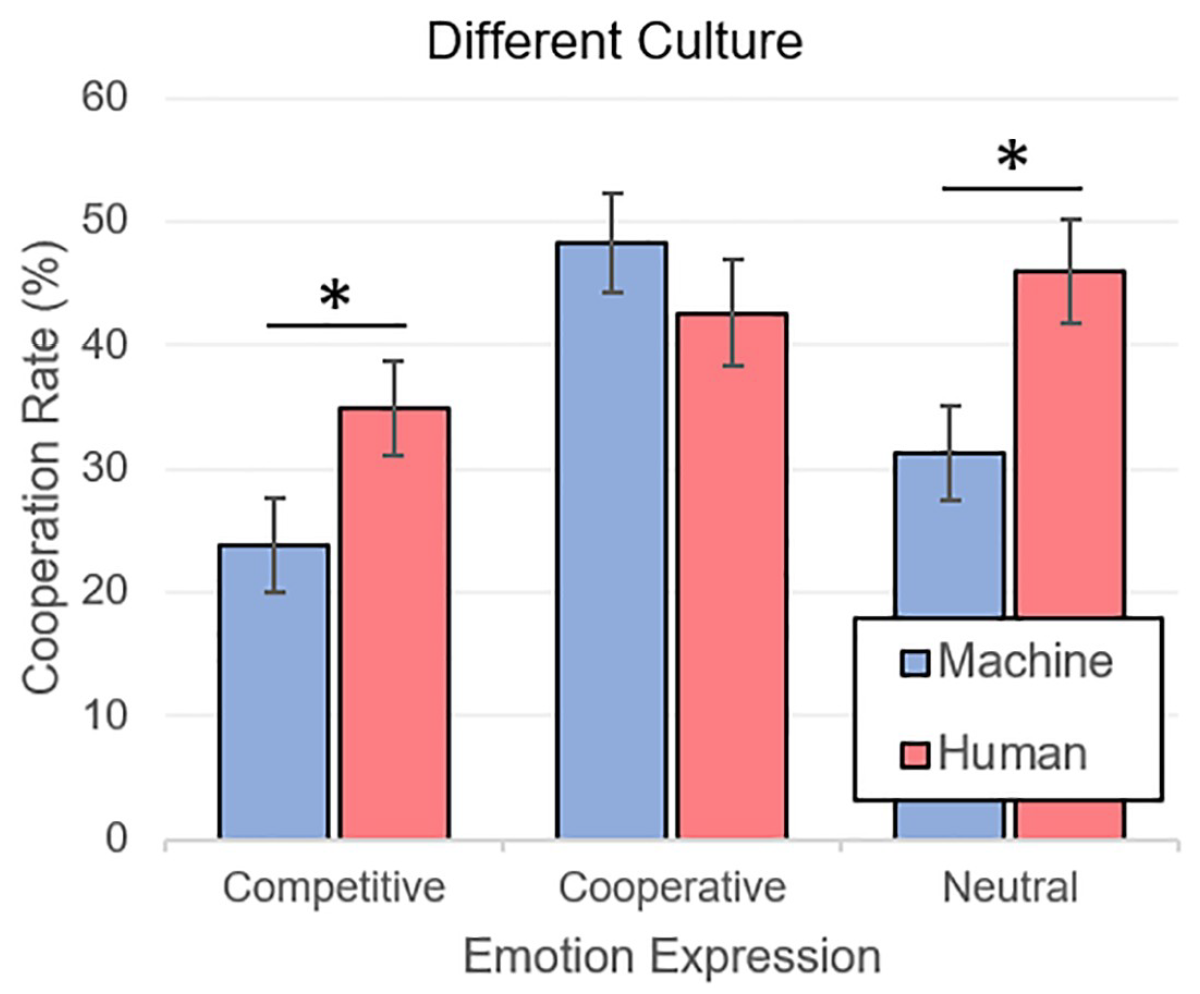

Imagen No. 3

Imagen No. 3Arriba hay un gráfico de los resultados (análisis de varianza, es decir, ANOVA) de experimentos en los que diferentes grupos culturales se unieron en el juego. Como se esperaba, la cooperación con las personas (M = 41.15, SE = 2.39) se expresó más que la cooperación con las máquinas (M = 34.45, SE = 2.25). Con respecto a las emociones, no todo era menos predecible: los jugadores colaboraban con más frecuencia con aquellos que expresaban emociones de cooperación (M = 45.42, SE = 2.97) que las emociones de la competencia (M = 29.34, SE = 2.70). Las emociones neutrales (M = 38.63, SE = 2.85) también superaron a las competitivas.

Es curioso que las emociones que inspiran confianza en los jugadores humanos neutralizan por completo el hecho de que juegan con la máquina, reduciendo así el grado de desconfianza.

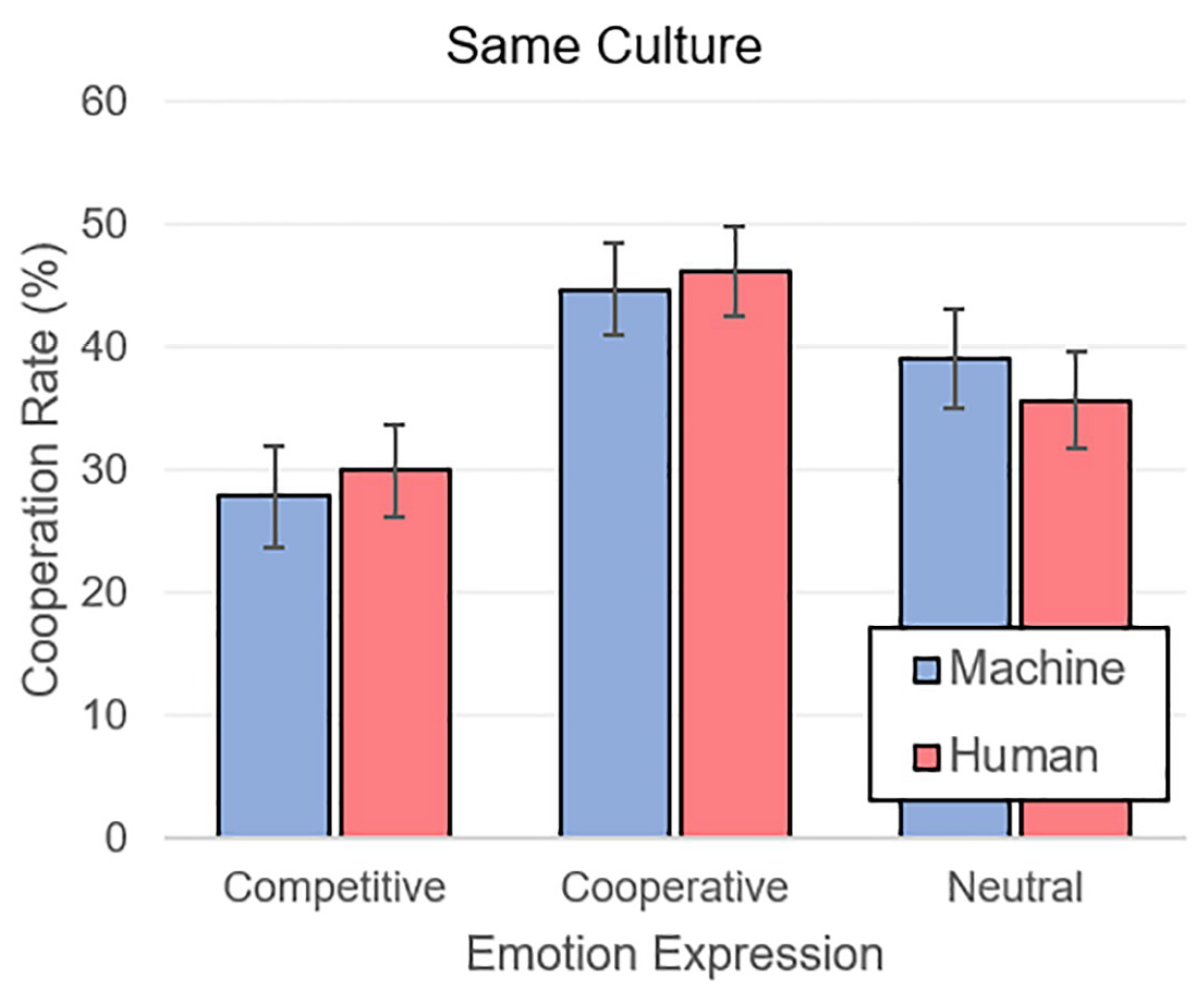

Imagen No. 4

Imagen No. 4Cuando los participantes se encontraron con socios del mismo grupo cultural, la situación fue similar. Las emociones cooperativas (M = 45.55, SE = 2.61) superaron a las neutrales (M = 37.42, SE = 2.81) y competitivas (M = 28.99, SE = 2.78).

La totalidad de los resultados deja en claro que una persona usa los mismos parámetros psicológicos de confianza y desconfianza en la comunicación con una máquina que otra persona. Los automóviles autónomos se perciben inicialmente como miembros de un grupo social ajeno a la persona. Sin embargo, el uso de una cara visual con rasgos de una determinada identidad cultural apropiada para la pareja humana puede mitigar la desconfianza de la máquina.

La observación más importante es que la identidad cultural y la pertenencia a las máquinas están completamente niveladas por las emociones correctas, por así decirlo.

Para un conocimiento más detallado de los matices del estudio, le recomiendo que consulte el

informe de los científicos .

Epílogo

Este estudio es muy ambiguo, pero nos muestra una característica importante de la psicología humana. Inconscientemente clasificamos a las personas que nos rodean en ciertos grupos sociales, experimentando una mayor confianza en aquellos que pertenecen a nuestro grupo. Esta es nuestra reacción principal. Pero no es el único, ya que cuando nos comunicamos con una persona, comenzamos a recibir una serie de señales (visuales y sonoras) expresadas por las emociones, la forma de hablar, la voz, etc. Estas señales complementan la imagen de la representación de una persona para nosotros, de la cual somos rechazados en el momento de tomar una decisión: confiar o no. En otras palabras, la categorización social que ocurre en nuestras cabezas no importa cuando se trata de una comunicación animada. Esto es lo que dicen los viejos dichos: "son recibidos por la ropa, pero escoltados por la mente" y "no juzguen un libro por su portada".

En relación con los automóviles, una persona siempre estaba sintonizada con la aprensión y la desconfianza, que a menudo no estaban respaldadas por razones significativas. Tal es la naturaleza del hombre: rechazar inicialmente lo que es extraño. Sin embargo, así como el conocimiento conquista la ignorancia, la interacción real con máquinas autónomas capaces de expresar emociones conquista los prejuicios humanos.

¿Significa esto que todos los robots en el futuro deberían tener emociones? Si y no Los investigadores, cuyo trabajo examinamos hoy, creen que en el primer par de emociones para los robots será una función excelente que puede acelerar el proceso de adopción de máquinas autónomas por parte de una sociedad de personas. ¿Qué puedo decir para vivir con lobos? Aullar como un lobo, no importa cuán grosero suene.

Además, ya dotamos a los robots de nuestros propios rasgos: los hacemos ojos como los nuestros, rostros como los nuestros, los dotamos de voces y emociones. Una persona siempre tratará de humanizar el automóvil y, como muestra este estudio, no en vano.

Viernes off-top:El documental "Hyper Evolution: The Rise of the Machines" (Parte I, Parte II , Parte III ). Gracias por su atención, tengan curiosidad y tengan un gran fin de semana a todos, muchachos. :)

Gracias por quedarte con nosotros. ¿Te gustan nuestros artículos? ¿Quieres ver más materiales interesantes? Apóyenos haciendo un pedido o recomendando a sus amigos,

VPS en la nube para desarrolladores desde $ 4.99 , un

descuento del 30% para usuarios de Habr en un análogo único de servidores de nivel básico que inventamos para usted: toda la verdad sobre VPS (KVM) E5-2650 v4 (6 Núcleos) 10GB DDR4 240GB SSD 1Gbps desde $ 20 o ¿cómo compartir un servidor? (las opciones están disponibles con RAID1 y RAID10, hasta 24 núcleos y hasta 40GB DDR4).

Dell R730xd 2 veces más barato? ¡Solo tenemos

2 x Intel TetraDeca-Core Xeon 2x E5-2697v3 2.6GHz 14C 64GB DDR4 4x960GB SSD 1Gbps 100 TV desde $ 199 en los Países Bajos! Dell R420 - 2x E5-2430 2.2Ghz 6C 128GB DDR3 2x960GB SSD 1Gbps 100TB - ¡desde $ 99! Lea sobre

Cómo construir un edificio de infraestructura. clase utilizando servidores Dell R730xd E5-2650 v4 que cuestan 9,000 euros por un centavo?