El mundo que nos rodea está lleno de todo tipo de información que nuestro cerebro procesa continuamente. Recibe esta información a través de los sentidos, cada uno de los cuales es responsable de su parte de señales: ojos (visión), lengua (sabor), nariz (olor), piel (tacto), aparato vestibular (equilibrio, posición espacial y sentido del peso) y orejas (sonido) Al reunir señales de todos estos órganos, nuestro cerebro puede construir una imagen precisa del medio ambiente. Pero no todos los aspectos del procesamiento de señales externas son conocidos por nosotros. Uno de estos secretos es el mecanismo de localización de la fuente de sonido.

Los científicos del Laboratorio de Neuroingeniería para el Habla y la Audición (Instituto de Tecnología de Nueva Jersey) han propuesto un nuevo modelo del proceso neural de localización del sonido. Qué procesos exactamente ocurren en el cerebro durante la percepción del sonido, cómo nuestro cerebro comprende la posición de la fuente de sonido y cómo este estudio puede ayudar en la lucha contra los defectos auditivos. Aprendemos sobre esto del informe del grupo de investigación. Vamos

Base de estudio

La información que nuestro cerebro recibe de los sentidos difiere entre sí tanto en términos de fuente como en términos de su procesamiento. Algunas señales aparecen inmediatamente frente a nuestro cerebro en forma de información precisa, mientras que otras necesitan procesos computacionales adicionales. En términos generales, sentimos el toque de inmediato, pero cuando escuchamos el sonido, todavía tenemos que encontrar de dónde viene.

La base para localizar sonidos en el plano horizontal es la

diferencia de tiempo

interaural * (ITD de la

diferencia de tiempo interaural ) de los sonidos que llegan a los oídos del oyente.

Base interaccional * : la distancia entre las orejas.

Hay un área determinada en el cerebro (oliva medial superior o MBO) que es responsable de este proceso. En el momento de recibir la señal de sonido en el MBO, las diferencias interaurales en el tiempo se convierten en la velocidad de reacción de las neuronas. La forma de las curvas de velocidad de salida del MBO como una función ITD se asemeja a la forma de la función de correlación cruzada de las señales de entrada para cada oído.

La forma en que se procesa e interpreta la información en el MBO no queda completamente clara, por lo que existen varias teorías muy conflictivas. La teoría más famosa y clásica de la localización del sonido es el modelo Jeffress (

Lloyd A. Jeffress ). Se basa en una

línea marcada * de detectores

de neuronas que son sensibles al sincronismo binaural de las señales de entrada neural de cada oído, y cada neurona es más sensible a un valor ITD específico (

1A ).

El principio de la línea marcada * es una hipótesis que explica cómo diferentes nervios, que utilizan los mismos principios fisiológicos para transmitir impulsos a lo largo de sus axones, son capaces de generar diferentes sensaciones. Los nervios estructuralmente similares pueden generar diferentes percepciones sensoriales si están asociados con neuronas únicas en el sistema nervioso central que pueden decodificar señales nerviosas similares de varias maneras.

Imagen No. 1

Imagen No. 1Este modelo es computacionalmente similar a la codificación neural basada en correlaciones cruzadas ilimitadas de sonidos que llegan a ambos oídos.

También hay un modelo en el que se supone que la localización del sonido se puede modelar sobre la base de las diferencias en la velocidad de reacción de ciertas poblaciones de neuronas de diferentes hemisferios del cerebro, es decir. modelo de asimetría interhemisférica (

1B ).

Hasta ahora era difícil establecer inequívocamente cuál de las dos teorías (modelos) es correcta, dado que cada una de ellas predice diferentes dependencias de la localización del sonido en la intensidad del sonido.

En el estudio que estamos considerando hoy, los científicos decidieron combinar ambos modelos para comprender si la percepción de los sonidos se basa en la codificación neural o en la diferencia en la respuesta de las poblaciones neurales individuales. Se llevaron a cabo varios experimentos en los que participaron personas de 18 a 27 años (5 mujeres y 7 hombres). La audiometría (medición de la agudeza auditiva) de los participantes fue de 25 dB o más a una frecuencia de 250 a 8000 Hz. El participante del experimento se colocó en una sala insonorizada en la que se calibró un equipo especial con alta precisión. Los participantes deberían, habiendo escuchado una señal sonora, indicar la dirección de donde proviene.

Resultados de la investigación

Para evaluar la dependencia de la

lateralización * de la actividad cerebral en la intensidad del sonido en respuesta a las neuronas marcadas, utilizamos datos sobre la velocidad de reacción de las neuronas en el núcleo laminar del cerebro de la lechuza común.

Lateralidad * : asimetría de las mitades izquierda y derecha del cuerpo.

Para evaluar la dependencia de la lateralización de la actividad cerebral en la velocidad de reacción de ciertas poblaciones de neuronas, utilizamos los datos de actividad de los dos cerebros inferiores del mono rhesus, después de lo cual se calcularon adicionalmente las diferencias en la velocidad de las neuronas de diferentes hemisferios.

El modelo de la línea marcada de detectores de neuronas sugiere que con una disminución en la intensidad del sonido, la lateralidad de la fuente percibida convergerá en valores promedio similares a la proporción de sonidos silenciosos y fuertes (

1C ).

El modelo de asimetría interhemisférica, a su vez, sugiere que con una disminución en la intensidad del sonido hasta casi el umbral, la lateralidad percibida cambiará a la línea media (

1D ).

A una intensidad de sonido general más alta, se supone que la lateralización será invariante en intensidad (insertos en

1C y

1D ).

Por lo tanto, un análisis de cómo la intensidad del sonido afecta la dirección percibida del sonido le permite determinar con precisión la naturaleza de los procesos que tienen lugar en ese momento: neuronas de un área común o neuronas de diferentes hemisferios.

Obviamente, la capacidad de una persona para distinguir entre ITD puede variar con la intensidad del sonido. Sin embargo, los científicos dicen que es difícil interpretar hallazgos previos relacionados con la sensibilidad a ITD y la evaluación del oyente de la dirección de la fuente de sonido en función de la intensidad del sonido. Algunos estudios dicen que cuando la intensidad del sonido alcanza el umbral límite, la lateralidad percibida de la fuente disminuye. Otros estudios sugieren que no hay ningún efecto de intensidad en la percepción en absoluto.

En otras palabras, los científicos insinúan "suavemente" que no hay suficiente información en la literatura sobre la relación de ITD, la intensidad del sonido y la determinación de la dirección de su fuente. Existen teorías que existen como una especie de axiomas generalmente aceptados por la comunidad científica. Por lo tanto, se decidió probar en detalle todas las teorías, modelos y posibles mecanismos de percepción auditiva en la práctica.

El primer experimento se realizó utilizando el paradigma psicofísico, que nos permitió estudiar la lateralización basada en ITD en función de la intensidad del sonido en un grupo de diez participantes con audición normal en el experimento.

Imagen No. 2

Imagen No. 2Las fuentes de sonido se sintonizaron especialmente para cubrir la mayor parte del rango de frecuencia dentro del cual las personas pueden reconocer ITD, es decir 300 a 1200 Hz (

2A ).

En cada una de las pruebas, el oyente tuvo que indicar la lateralidad esperada, medida en función del nivel de sensaciones, en el rango de valores de ITD de 375 a 375 ms. Para determinar el efecto de la intensidad del sonido, se usó el modelo de efectos mixtos no lineales (NMLE), que incluía una intensidad de sonido fija y aleatoria.

El gráfico

2B muestra la lateralización estimada con ruido espectralmente plano a dos intensidades de sonido para un oyente representativo. Un gráfico

2C muestra los datos sin procesar (círculos) y adaptados al modelo NMLE (líneas) de todos los oyentes.

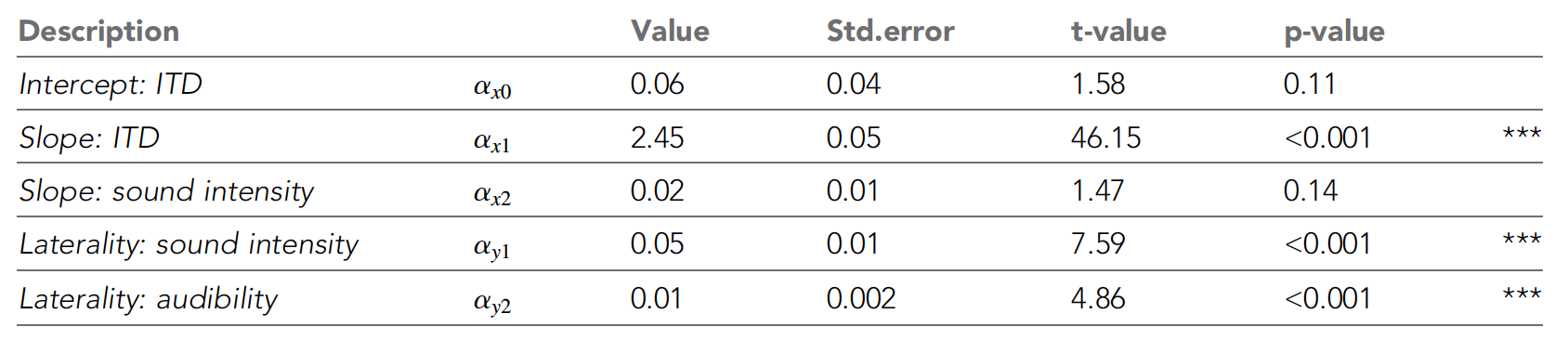

Tabla número 1

Tabla número 1La tabla anterior muestra todos los parámetros de NLME. Se puede ver que la lateralidad percibida aumenta con el aumento de ITD, como los científicos esperaban. Con una disminución en la intensidad del sonido, la percepción se desplazó más y más hacia la línea media (inserte en el gráfico

2C ).

Estas tendencias fueron reforzadas por el modelo NLME, que mostró una influencia significativa de ITD y la intensidad del sonido en el grado máximo de lateralidad, confirmando el modelo de diferencias interhemisféricas.

Además, los umbrales audiométricos promedio de los tonos puros tuvieron un efecto insignificante en la lateralidad percibida. Pero la intensidad del sonido no afectó significativamente el desempeño de las funciones psicométricas.

El objetivo principal del segundo experimento fue determinar cómo cambian los resultados obtenidos en el experimento anterior cuando se tienen en cuenta las características espectrales de los estímulos (sonidos). La necesidad de probar el ruido espectralmente plano a baja intensidad de sonido es que partes del espectro pueden no escucharse, y esto puede afectar la determinación de la dirección del sonido. Por lo tanto, el hecho de que el ancho de la parte audible del espectro puede disminuir con la disminución de la intensidad del sonido puede confundirse con los resultados del primer experimento.

Por lo tanto, se decidió llevar a cabo otro experimento, pero ya se estaba utilizando ruido A

* ponderado hacia atrás.

La ponderación A * se aplica a los niveles de sonido para tener en cuenta el volumen relativo percibido por el oído humano, ya que el oído es menos sensible a las bajas frecuencias de sonido. La ponderación A se implementa mediante aritmética agregando una tabla de valores listados en bandas de octava a los niveles de presión sonora medidos en dB.

El gráfico

2D muestra los datos sin procesar (círculos) y los datos (líneas) adaptados al modelo NMLE para todos los participantes en el experimento.

Un análisis de los datos mostró que cuando todas las partes del sonido son aproximadamente igualmente audibles (tanto en el primer como en el segundo experimento), la lateralidad percibida y la pendiente en el gráfico que explica el cambio en la lateralidad con ITD disminuyen al disminuir la intensidad del sonido.

Por lo tanto, los resultados del segundo experimento confirmaron los resultados del primero. Es decir, en la práctica se demostró que el modelo propuesto en 1948 por Jeffress no es correcto.

Resulta que la localización de los sonidos se deteriora con una disminución en la intensidad del sonido, y Jeffress creía que los sonidos son percibidos y procesados por una persona igualmente, independientemente de su intensidad.

Para un conocimiento más detallado de los matices del estudio, le recomiendo que consulte el

informe de los científicos .

Epílogo

Los supuestos teóricos y los experimentos prácticos que los confirmaron mostraron que las neuronas cerebrales de mamíferos se activan a diferentes velocidades dependiendo de la dirección de la señal de sonido. Después de esto, el cerebro compara estas velocidades entre todas las neuronas involucradas en el proceso para mapear dinámicamente el entorno de sonido.

El modelo Jeffresson en realidad no es 100% erróneo, ya que puede usarse para describir perfectamente la ubicación de una fuente de sonido en una lechuza común. Sí, para las lechuzas, la intensidad del sonido no importa, en cualquier caso determinarán la posición de su fuente. Sin embargo, este modelo no funciona con los monos rhesus, como lo demuestran los experimentos anteriores. Por lo tanto, este modelo de Jeffresson no puede describir la localización de sonidos para todos los seres vivos.

Los experimentos con personas confirmaron una vez más que la localización de los sonidos ocurre en diferentes organismos de diferentes maneras. Muchos de los participantes no pudieron determinar correctamente la posición de la fuente de las señales de sonido debido a la baja intensidad de los sonidos.

Los científicos creen que su trabajo muestra una cierta similitud entre la forma en que vemos y cómo escuchamos. Ambos procesos están asociados con la velocidad de las neuronas en diferentes partes del cerebro, así como con la evaluación de esta diferencia para determinar tanto la posición de los objetos que vemos en el espacio como la posición de la fuente del sonido que escuchamos.

En el futuro, los investigadores llevarán a cabo una serie de experimentos para examinar más de cerca la relación entre la audición y la visión humanas, lo que nos ayudará a comprender mejor cómo nuestro cerebro construye dinámicamente un mapa del mundo que nos rodea.

¡Gracias por su atención, sigan curiosos y tengan una buena semana de trabajo, muchachos! :)

Gracias por quedarte con nosotros. ¿Te gustan nuestros artículos? ¿Quieres ver más materiales interesantes? Apóyenos haciendo un pedido o recomendando a sus amigos,

VPS en la nube para desarrolladores desde $ 4.99 , un

descuento del 30% para usuarios de Habr en un análogo único de servidores de nivel básico que inventamos para usted: toda la verdad sobre VPS (KVM) E5-2650 v4 (6 Núcleos) 10GB DDR4 240GB SSD 1Gbps desde $ 20 o ¿cómo compartir un servidor? (las opciones están disponibles con RAID1 y RAID10, hasta 24 núcleos y hasta 40GB DDR4).

Dell R730xd 2 veces más barato? ¡Solo tenemos

2 x Intel TetraDeca-Core Xeon 2x E5-2697v3 2.6GHz 14C 64GB DDR4 4x960GB SSD 1Gbps 100 TV desde $ 199 en los Países Bajos! Dell R420 - 2x E5-2430 2.2Ghz 6C 128GB DDR3 2x960GB SSD 1Gbps 100TB - ¡desde $ 99! Lea sobre

Cómo construir un edificio de infraestructura. clase utilizando servidores Dell R730xd E5-2650 v4 que cuestan 9,000 euros por un centavo?