Todos conocen la legendaria

prueba de confiabilidad SSD de 3dnews (publicada en 2018.01), como resultado de lo cual algunas unidades de presupuesto excedieron el recurso declarado por el fabricante por un factor de diez.

Después de este estudio, apareció una teoría teológica de la conspiración de que los fabricantes subestiman los recursos de los SSD de presupuesto, así como la creencia de que casi todos los SSD son capaces de realizar y nivelar el desgaste de forma cualitativa.

Se realizó un estudio de 3dnews.ru basado en

las pruebas de Techreport.com (publicado el 08.08.2013).

La metodología para medir la resistencia al desgaste también se utilizó de la misma manera.

Técnica de Techreport:

Podemos impulsar los límites de resistencia SSD mucho más rápido con puntos de referencia sintéticos. Hay innumerables opciones, pero la mejor es las Utilidades de almacenamiento imaginativamente llamadas de Anvil.

Desarrollado por un frecuentador de los foros de XtremeSystems, esta pequeña aplicación práctica incluye una prueba de resistencia dedicada que llena los discos con archivos de diferentes tamaños antes de eliminarlos y comenzar el proceso nuevamente. Podemos ajustar la carga útil de cada ciclo para escribir la misma cantidad de datos en cada unidad. Hay una comprobación integrada de hash MD5 que verifica la integridad de los datos, y la velocidad de escritura es más de un orden de magnitud más rápida que la velocidad de escritura efectiva de DriveBench 2.0.

La prueba de resistencia de Anvil escribe archivos secuencialmente, por lo que no es una simulación ideal del mundo real. Sin embargo, es la mejor herramienta que tenemos, y nos permite cargar unidades con una porción de datos estáticos para desafiar las rutinas de nivelación de desgaste. Estamos utilizando 10 GB de datos estáticos, incluida una copia de la carpeta de instalación de Windows 7, un puñado de archivos de aplicaciones y algunas películas.

Técnica 3dnews.ru:

Por lo tanto, en nuestra prueba de resistencia, utilizamos unidades formateadas con el sistema de archivos NTFS, en el que se crean dos tipos de archivos de forma continua y alternativa: pequeño, con un tamaño aleatorio de 1 a 128 KB y grande, con un tamaño aleatorio de 128 KB a 10 MB. Durante la prueba, estos archivos con relleno aleatorio se multiplican, mientras que el disco tiene más de 12 GB de espacio libre, cuando se alcanza este umbral, todos los archivos creados se eliminan, se hace una breve pausa y el proceso se repite nuevamente. Además, el tercer tipo de archivos también está presente en las unidades de prueba: permanente. Dichos archivos con un volumen total de 16 GB no participan en el proceso de borrado y sobrescritura, pero se utilizan para verificar la operatividad correcta de las unidades y la legibilidad estable de la información almacenada: en cada ciclo de llenado de SSD verificamos la suma de verificación de estos archivos y la comparamos con el valor de referencia calculado de antemano.

En ambos casos, se utilizaron las Utilidades de almacenamiento de Anvil.

1. ¿Y qué tiene de malo la técnica?

El problema es que el disco se llena secuencialmente. Lo que no corresponde ni a los escenarios de uso real ni al procedimiento de resistencia al desgaste recomendado por

JEDEC (comité de estandarización de ingeniería de semiconductores, también denominado Asociación de Tecnología de Estado Sólido, que incluye a todos los mayores fabricantes de memoria flash).

Tanto el sistema operativo como el controlador (si tiene un caché DRAM pequeño) agrupan bloques consecutivos para grabar y anotar grandes bloques nativos característicos de un dispositivo en particular. Al mismo tiempo, la amplificación de grabación está prácticamente ausente y prácticamente no hay necesidad de algoritmos de nivelación de desgaste.

En condiciones reales, tanto el multiplicador como la implementación de alta calidad del algoritmo de nivelación de desgaste tienen un fuerte efecto en el recurso de almacenamiento.

Problema 1. Al escribir secuencialmente archivos WAF ≈ 1

Una prueba construida de tal manera que el factor de multiplicación récord (WAF) tiende a la unidad en ella predeciblemente dará resultados sobreestimados en el recurso. La mayoría de los discos analizados por 3dnews (de los cuales se pudo extraer WAF) tuvieron una ganancia de grabación de ≈1-1.11. Los expertos de 3dnews explicaron esto con algoritmos de controlador eficientes. Literalmente, una instancia de WAF tuvo que ser explicada por un controlador ineficaz.

Sin embargo, en mi opinión, todo el punto está en la metodología de prueba, que generó un registro secuencial (en el que WAF → 1), que dio una sobreestimación del recurso de las unidades SSD.

A continuación, evaluaré cuántas veces.

Problema 2. La calidad del algoritmo de nivelación de desgaste no se prueba

Con el llenado sucesivo del disco y el posterior borrado, el mecanismo de nivelación de desgaste está mal probado. Si el fabricante ha adivinado que los primeros GB del disco (donde se encuentra el mapa de bits del disco, FAT y otros metadatos) funcionan en modo SLC (o los almacenan en caché en el búfer RAM), entonces el algoritmo de nivelación de desgaste puede estar completamente ausente en el firmware y aún así se logrará con la grabación secuencial Excelentes indicadores de recursos.

Problema 3. La retención de datos después del agotamiento de recursos no se prueba

Si va a viajar durante varios meses, no está claro si es posible confiar en un disco que ha desarrollado su recurso de pasaporte.

Problema 4. Llenar secuencialmente un disco, seguido de un borrado casi completo, no es un patrón de comportamiento real definido por el usuario

Dado que SSD sigue siendo un recurso bastante costoso, las personas generalmente intentan usarlo lo más posible y dejan un mínimo de espacio libre.

La prueba ideal, en mi opinión, es que durante la prueba, el SSD permanece obstruido en un 80-90%, mientras borra aleatoriamente archivos antiguos y agrega nuevos.

2. Grabación de factores de animación

2.1. Fragmentación del sistema de archivos

Dado que la desfragmentación está deshabilitada para las SSD de Windows y el tamaño predeterminado del clúster NTFS es 4K, en la vida real el disco está muy fragmentado. En este caso, incluso la grabación secuencial convierte la velocidad en casi aleatoria.

Para escribir 1 clúster modificado, el controlador primero debe leer toda la página de hardware NAND (que puede alcanzar cientos de kilobytes de tamaño), cambiar 4K y luego escribirlo todo. Si el tamaño de la capacidad útil de la página NAND es de 64K, entonces tenemos una ganancia de grabación de 16 veces.

Tamaños reales de página en NANDDel comentario :

Los tamaños de página reales en chips NAND generalmente no son cientos de kilobytes, sino 528, 2112, 4224, 4320, 8576, 8640, 8832, 8896, 9216, 17664, 18048, 18336, etc. Los tamaños pequeños son válidos para chips SLC antiguos, para tamaños TLC y QLC son más grandes. Tales tamaños extraños porque, además de los datos del usuario, es necesario almacenar datos auxiliares (ECC, banderas, números de bloque, contadores de registros, etc.).

2.2. Algoritmo de alineación de desgaste

Tal algoritmo puede implementarse como un proceso separado dentro del controlador. Funcionará algo como esto:

Para mover datos estáticos a un área con mayor desgaste, es necesario registrar un tamaño igual al de los datos que se mueven, siempre que haya un bloque TRIM liberado. Y con una pequeña cantidad de bloques libres, debe realizar 2 entradas para intercambiar datos.

RAM = a a = b b = RAM

Con un búfer DRAM pequeño o faltante, se requieren tres entradas.

temp = a a = b b = temp

Estas operaciones en un algoritmo de nivelación de desgaste ideal serán extremadamente raras, ya que tiene sentido mover solo datos estáticos para usar páginas de bajo desgaste, por lo que descuidaremos el efecto del algoritmo de nivelación de desgaste en la animación de grabación. Aunque, por supuesto, no hay garantía de que los algoritmos reales usen algoritmos ideales.

2.3. La escritura típica de SSD es aleatoria, bloque de 4-8 KB

La naturaleza habitual de las grabaciones SSD es básicamente un

registro aleatorio de 8 KB . Incluso si no hay fragmentación, el tamaño de un bloque de grabación típico será menor que el tamaño de la página NAND y hará que la grabación se multiplique.

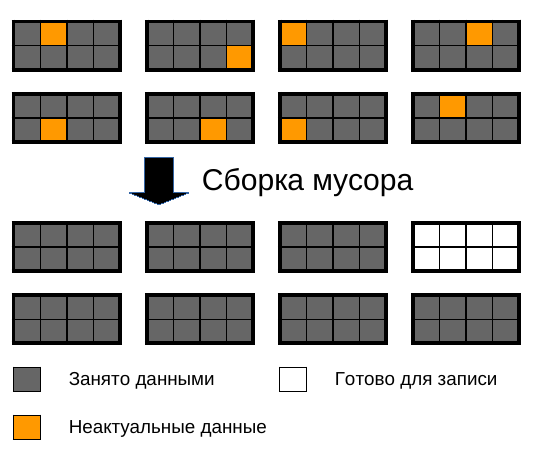

2.4. Algoritmo de recolección de basura

Aquí yace los mayores escollos. El tamaño del bloque en la memoria NAND alcanza varios megabytes. Un bloque consta de varias páginas.

Las páginas se pueden leer y escribir por separado, y un bloque solo se puede borrar por completo.

Con el tiempo, muchas páginas en el bloque se marcan como no válidas, ya que los datos que se han cambiado en ellas y se escribieron en otra ubicación o debido a una llamada TRIM. Y tarde o temprano, el recolector de basura debe tomar algunos bloques parcialmente llenos y armarlos completamente escritos y libres.

Mientras haya espacio libre, lo más probable es que ni siquiera comience, por lo que con el tiempo, se forman numerosos agujeros en los bloques.

Cuanto menos espacio en el disco, más rápido aumenta el WAF (Factor de amplificación de escritura).

Para ilustrar el aumento de WAF, daré la siguiente imagen:

La imagen muestra bloques de memoria NAND con datos llenos al 87.5%, paginados. Para liberar espacio para la grabación, se produce una reorganización, en la que se reescriben y borran 7 bloques 1. Total WAF resulta =

8 !

Por supuesto, también debe tener en cuenta que la mayoría de los SSD tienen un área de respaldo en la que también se produce la redistribución de registros. Pero, como regla, es pequeño.

El tamaño típico del área oculta para las unidades de consumo es

7.37% , como Los fabricantes indican el tamaño en miles de millones de bytes, y los microcircuitos tienen una capacidad en gigabytes. 1 gigabyte = 1,073,741,824 bytes).

Si el disco está lleno al 90% y hay un área oculta del 7.37%, ¡WAF será

6.18 !

WAF se puede calificar con esta fórmula:

WAF textrecoleccióndebasura= frac11− fracK textdiscollenoK textárea d e r e s e r v a

K llenura de disco : de 0 a 1, donde 1 - 100% de llenura de disco.

Área de reserva K : desde 1, donde 1 - 0% de área de reserva, 1.1 - 10% del área de reserva, y así sucesivamente.

Una gráfica aproximada de WA versus porcentaje de espacio libre en disco.

El gráfico muestra que WA aumenta catastróficamente a medida que el disco se llena, acercándose a 15 cuando el disco está lleno con un área de reserva del

7,37% (un número típico para discos de consumo, porque los fabricantes indican el tamaño en miles de millones de bytes, y los microcircuitos tienen una capacidad en gigabytes. 1 gigabyte = 1,073,741,824 bytes).

Probablemente usted mismo notó cuánto comienza a disminuir la velocidad del teléfono si solo hay un pequeño porcentaje de espacio libre allí. Después de todo, también usa memoria flash. La obstrucción de la memoria al 100% no solo es terriblemente lenta, sino que también agota el recurso de almacenamiento.

Un artículo separado sobre el tema .

2.5. WAF total de todos los factores

Los WAF introducidos por factores débilmente acoplados se multiplican.

3. Metodología para medir los recursos de JEDEC para SSD personalizados

En las “Cargas de trabajo de resistencia de la unidad de estado sólido (SSD) de JEDEC” de septiembre de 2010, la revisión JESD219A describe la metodología para probar las SSD.

En pocas palabras: los ingenieros de JEDEC grabaron registros de grabaciones, TRIM y flush (un comando para descargar buffers al disco) de un usuario de computadora portátil durante 7 meses, trabajando principalmente con programas de oficina. Presumiblemente, Windows 7 se instaló en la computadora portátil (admite TRIM desde 2009) en el sistema de archivos NTFS

con un tamaño de clúster de 4K .

Detalles de la computadora de referencia del usuario y estadísticas generalesPlataforma y carga de trabajoRecogido en una PC portátil estándar, 2 GB de RAM, SSD SATA de 128 GB, sistema operativo compatible con ajuste

Uso principal: productividad de la oficina

Uso secundario: almacenamiento de fotos, música y aplicaciones.

Características de seguimientoEscrituras / Recortes / Flushes capturados en un archivo con un formato CSV: tamaño de desplazamiento del comando $

Huella de 49 GB (datos totales tocados)

128 GB abarcados (rango de acceso de LBA)

Cantidad promedio de espacio recortado = 13 GB (promedio a lo largo de la duración del rastreo)

Otras características de traza

Analicé este registro para comprender qué actividades se registraron allí.

Durante la prueba, se sugiere repetir las entradas usando

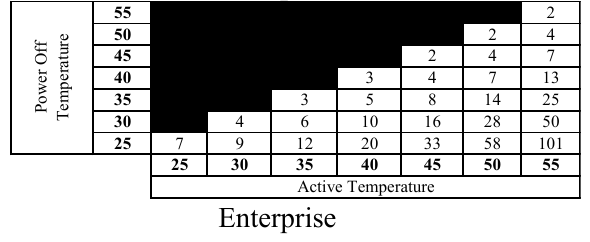

este registro (Master Trace) hasta que se escriba el número requerido de terabytes registrados (TBW), después de lo cual es necesario verificar cuánto tiempo las células almacenan la carga (tiempo de retención). Para un SSD personalizado, este tiempo debe ser de aproximadamente 2 años a una temperatura de almacenamiento de 25 ℃ si la temperatura de funcionamiento fue de 40 ℃. Como nadie esperará 2 años, aumentan la temperatura de almacenamiento, lo que conduce a una mayor fuga de electrones, y según tablas especiales (construidas según

la ecuación de Arrhenius ), se calcula el tiempo de almacenamiento de datos a temperatura normal.

Hechos interesantes:

Como saben, la memoria NAND se divide en páginas que se combinan en bloques. La escritura y la lectura ocurren página por página, y se borran solo en bloques.

Cuando necesita reescribir algo, el firmware ideal funciona de la siguiente manera: escribe páginas con datos modificados en un bloque donde todavía hay páginas no escritas y establece una nueva correspondencia LBA → página en FTL (Capa de traducción Flash), y marca la página anterior como inválida. Si no existen tales bloques, se inicia el recolector de basura, que compila los datos de los bloques medio llenos en los llenos con la liberación de bloques.

Esta es una opción ideal. No todos los SSD personalizados tienen buenos algoritmos de nivelación de desgaste. Como se ve en los resultados de pruebas dramáticamente diferentes de 3dnews.

Un tamaño de página típico es de 8 KB y superior, y un tamaño de bloque de 2 MB y superior. En las pruebas de JEDEC, la unidad nunca llenó más del 38%, por lo tanto, como sospecho, siempre había bloques libres allí y, por lo tanto, no había un recolector de basura activo, lo que también desperdicia recursos SSD. Pero había WAF (Factor de multiplicación de escritura) debido al hecho de que los datos a veces se escribían con páginas incompletas, y a veces un registro pasaba a lo largo del borde de las páginas NAND.

Escribí un script para calcular WAF dependiendo del tamaño de la página en las pruebas de JEDEC. Aquí está WAF dependiendo del tamaño de la página NAND:

Al probar 3dnews, WAF es aproximadamente 1, ya que los archivos se escriben secuencialmente y Windows tiene almacenamiento en caché de escritura, durante el cual los sectores se escriben de manera ordenada.

En un escenario típico, cuando la página es 8K (Samsung 840 EVO) WAF es solo 1.11 (un error del 11% de los datos de 3dnews), lo que parece ser perdonado. Pero si tenemos en cuenta WAF, que introduce el algoritmo de recolección de basura, no podemos perdonar.

4. Metodología JEDEC para probar unidades corporativas para resistencia al desgaste

Se describe mucho más formalizado y las condiciones son más severas. Se especifica un porcentaje claro de registros de varias longitudes. Los registros de hasta 4096 bytes de tamaño se pueden cambiar aleatoriamente, y con una longitud de más de 4K se deben alinear en desplazamientos de 4K.

Cálculo de WAF dependiendo del tamaño de la página.5. Cálculo de enmiendas a los resultados de la prueba 3dnews

Necesitamos factores de corrección para convertir la resistencia al desgaste según 3dnews en la resistencia al desgaste según el método Jedec.

Para empezar, reduciremos el resultado logrado en 2 veces, ya que las pruebas no verificaron la durabilidad del almacenamiento. Nadie quiere descubrir que después de unas vacaciones, el disco en su computadora dejó de funcionar o estaba cubierto de problemas. El número 2 está tomado del techo.

Según el método JEDEC, el disco está lleno solo un 38%, lo que nos da un aumento en WAF debido a la recolección de basura de 1.55 veces (de acuerdo con la fórmula anterior). Esta relación estará en el denominador.

A continuación, tendremos en cuenta el factor de multiplicación del registro en función del tamaño de la página NAND (obtenida del análisis de pruebas de SSD personalizadas utilizando el método JEDEC) y multiplicaremos por WAF, que tenemos del recolector de basura.

K textenmiendas= frac2∗WAF textrecolectordebasuradelaplenituddeldisco∗WAF texttamañodepáginaynaturalezadelosregistrosWAF textrec o l e c c i ó n d e b a s u r a J e d e c

Factores de corrección para discos con un área en exceso del 7.37%.Factores de corrección para discos con un área en exceso del 10%. Factores de corrección para discos con un área en exceso del 20%. Factores de corrección para discos con un área en exceso del 30%. 6. Modificaciones a los resultados de las pruebas de 3dnews para el uso de SSD personalizados en servidores

Debo decir que esta es una mala idea. Pero muchos lo hacen. Por lo tanto, intentaremos calcular los factores de corrección para determinar el recurso de los discos de usuario como servidores. Tomamos resistencia al desgaste de las pruebas 3dnews y lo dividimos por el coeficiente requerido para obtener el recurso esperado (metodología JEDEC) para uso corporativo.

Los servidores no requieren dicho almacenamiento a largo plazo en el estado desconectado, como en los SSD de usuario. Aquí está la tabla correspondiente:

A una temperatura típica de 50 ℃ de operación bajo carga, la unidad debe proporcionar 58 semanas ≈ 1 año de almacenamiento de datos en estado apagado a 25 ℃.

Para aplicaciones personalizadas (donde se requiere seguridad de datos durante 2 años en estado apagado), redujimos el recurso en 2 veces. Para uso corporativo, no es necesaria una vida útil tan larga, por lo que tomamos un número menor, por ejemplo, 1.3.

Después de eso, multiplicamos por WAF, que es típico para la carga corporativa, y luego tomamos en cuenta el trabajo del recolector de basura y obtenemos las siguientes tablas de coeficientes. El resultado obtenido por 3dnews debe dividirse por este número.

Existe un problema con el hecho de que el estándar no describe el tamaño del área de respaldo o el espacio libre para las unidades corporativas. Por lo tanto, no podemos evaluar con precisión el WAF de

la prueba corporativa JEDEC , por lo que tomaremos este número (1.55) de la prueba SSD personalizada de JEDEC.

Factores de corrección para discos con un área en exceso del 7.37%.Factores de corrección para discos con un área en exceso del 10%. Factores de corrección para discos con un área en exceso del 20%. Factores de corrección para discos con un área en exceso del 30%. 8. Conclusiones

Si nunca apaga su computadora durante varios meses, el tamaño de la página NAND no es más de 16 KB, y el disco está aproximadamente medio lleno, entonces los indicadores de recursos logrados por 3dnews deben dividirse por 3.

Para un escenario típico (ocupación de disco del 90%, tamaño de página 8 KB), para obtener un recurso de acuerdo con los estándares JEDEC, divida por 9 el recurso obtenido por 3dnews.

Si a veces realiza viajes realmente largos, y la unidad no se utiliza en este momento, le aconsejo que permanezca dentro del recurso del pasaporte, después de lo cual se debe cambiar la unidad.

Para casos raros, cuando el tamaño de la página NAND es superior a 16K y el disco está bastante denso, para calcular el recurso real de la unidad, debe reducirse en decenas, y a veces cientos de veces.

Y si coloca una unidad de presupuesto en el servidor, cuide tanto la incursión como la copia de seguridad. No tendrá un tiempo de respuesta y velocidades estables, protección de energía y otras ventajas de las unidades corporativas, pero puede calcular el recurso utilizando divisores de corrección de la tabla correspondiente del artículo. En un caso típico, divida por 11.

Referencias

→

Optimizando Linux con unidades flash baratas→

Cómo determinar el tamaño de la página y el bloque de memoria flashPS Errores directos que notas en PM. Aumento el karma para esto.

Gracias por la imagen TripletConcept .

Puede solicitar una máquina virtual con SSD de

RUVDS para el cupón a continuación.