En relación con el fin de las ventas en Rusia del sistema de registro y análisis de Splunk, surgió la pregunta de cómo se puede reemplazar esta solución. Después de pasar tiempo familiarizándome con diferentes soluciones, me decidí por una solución para un hombre real:

"ELK stack" . Este sistema requiere tiempo para configurarlo, pero como resultado, puede obtener un sistema muy poderoso para analizar el estado y la respuesta operativa a los incidentes de seguridad de la información en la organización. En esta serie de artículos, consideraremos las características básicas (o quizás no) de la pila ELK, consideraremos cómo analizar registros, cómo construir gráficos y tableros, y qué funciones interesantes se pueden hacer usando registros del firewall de Check Point o el escáner de seguridad OpenVas como ejemplo. Para comenzar, considere de qué se trata: la pila ELK y en qué componentes está compuesta.

La pila ELK es una abreviatura para tres proyectos de código abierto:

Elasticsearch, Logstash y

Kibana . Desarrollado por Elastic, junto con todos los proyectos relacionados. Elasticsearch es el núcleo de todo el sistema, que combina las funciones de una base de datos, búsqueda y sistema analítico. Logstash es un canal de procesamiento de datos del lado del servidor que recibe datos de varias fuentes al mismo tiempo, analiza el registro y luego lo envía a la base de datos de Elasticsearch. Kibana permite a los usuarios visualizar datos usando tablas y gráficos en Elasticsearch. También a través de Kibana puedes administrar la base de datos. A continuación, consideramos cada sistema por separado con más detalle.

Logstash

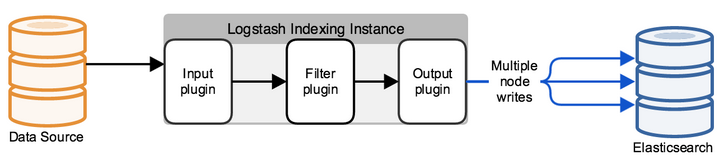

Logstash es una utilidad para procesar eventos de registro de varias fuentes, con el que puede seleccionar campos y sus valores en un mensaje, también puede configurar el filtrado y la edición de datos. Después de todas las manipulaciones, Logstash redirige los eventos al almacén de datos final. La utilidad se configura solo a través de archivos de configuración.

Una configuración típica de logstash es un archivo (s) que consta de varios flujos de información entrantes (entrada), varios filtros para esta información (filtro) y varios flujos salientes (salida). Parece uno o más archivos de configuración, que en la versión más simple (que no hace nada) se ve así:

input { } filter { } output { }

En INPUT, configuramos en qué puerto entrarán los registros y de acuerdo con qué protocolo, o desde qué carpeta leer archivos nuevos o escritos constantemente. En FILTER, configuramos el analizador de registros: análisis de campos, edición de valores, adición de nuevos parámetros o eliminación. FILTER es un campo de gestión de mensajes que llega a Logstash con toneladas de opciones de edición. En la salida, configuramos dónde enviamos el registro ya analizado, en caso de que este elasticsearch envíe una solicitud JSON en la que se envían los campos con los valores, o, como parte de la depuración, se puede enviar a stdout o escribir en un archivo.

Búsqueda elástica

Inicialmente, Elasticsearch es una solución de búsqueda de texto completo, pero con servicios adicionales, como escalamiento fácil, replicación y más, lo que hizo del producto una solución muy conveniente y buena para proyectos altamente cargados con grandes cantidades de datos. Elasticsearch es un repositorio no relacional (NoSQL) de documentos en formato JSON y un motor de búsqueda basado en la búsqueda de texto completo de Lucene. La plataforma de hardware es Java Virtual Machine, por lo que el sistema requiere una gran cantidad de recursos de procesador y RAM para funcionar.

Cada mensaje entrante, ya sea con Logstash o utilizando la API de consulta, se indexa como un "documento", un análogo de una tabla en SQL relacional. Todos los documentos se almacenan en el índice, un análogo de la base de datos en SQL.

Un ejemplo de un documento en la base de datos:

{ "_index": "checkpoint-2019.10.10", "_type": "_doc", "_id": "yvNZcWwBygXz5W1aycBy", "_version": 1, "_score": null, "_source": { "layer_uuid": [ "dae7f01c-4c98-4c3a-a643-bfbb8fcf40f0", "dbee3718-cf2f-4de0-8681-529cb75be9a6" ], "outzone": "External", "layer_name": [ "TSS-Standard Security", "TSS-Standard Application" ], "time": "1565269565", "dst": "103.5.198.210", "parent_rule": "0", "host": "10.10.10.250", "ifname": "eth6", ] }

Todo el trabajo con la base de datos se basa en solicitudes JSON que utilizan la API REST, que emite documentos por índice o algunas estadísticas en el formato: pregunta - respuesta. Para visualizar todas las respuestas a las solicitudes, se escribió Kibana, que es un servicio web.

Kibana

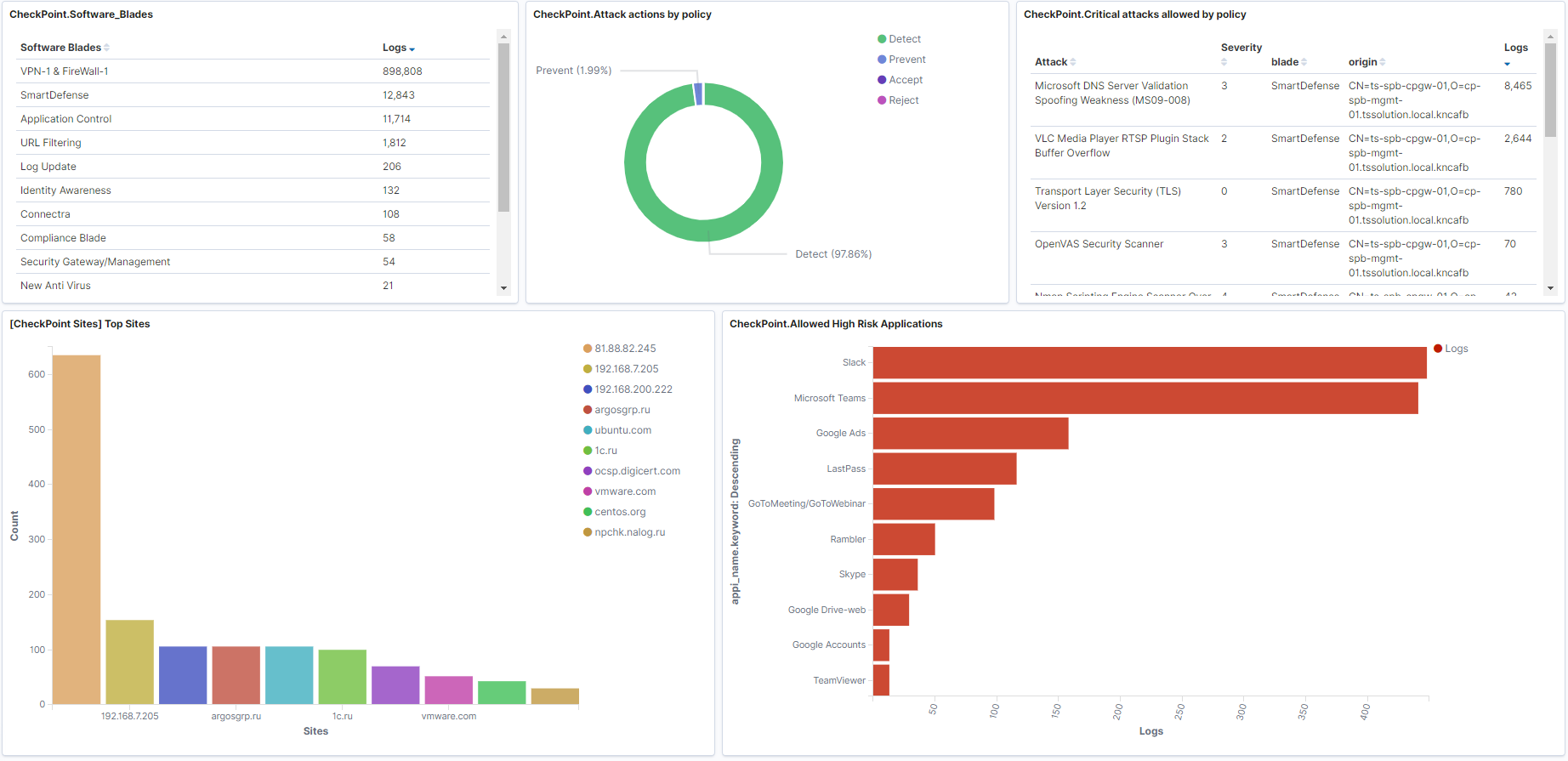

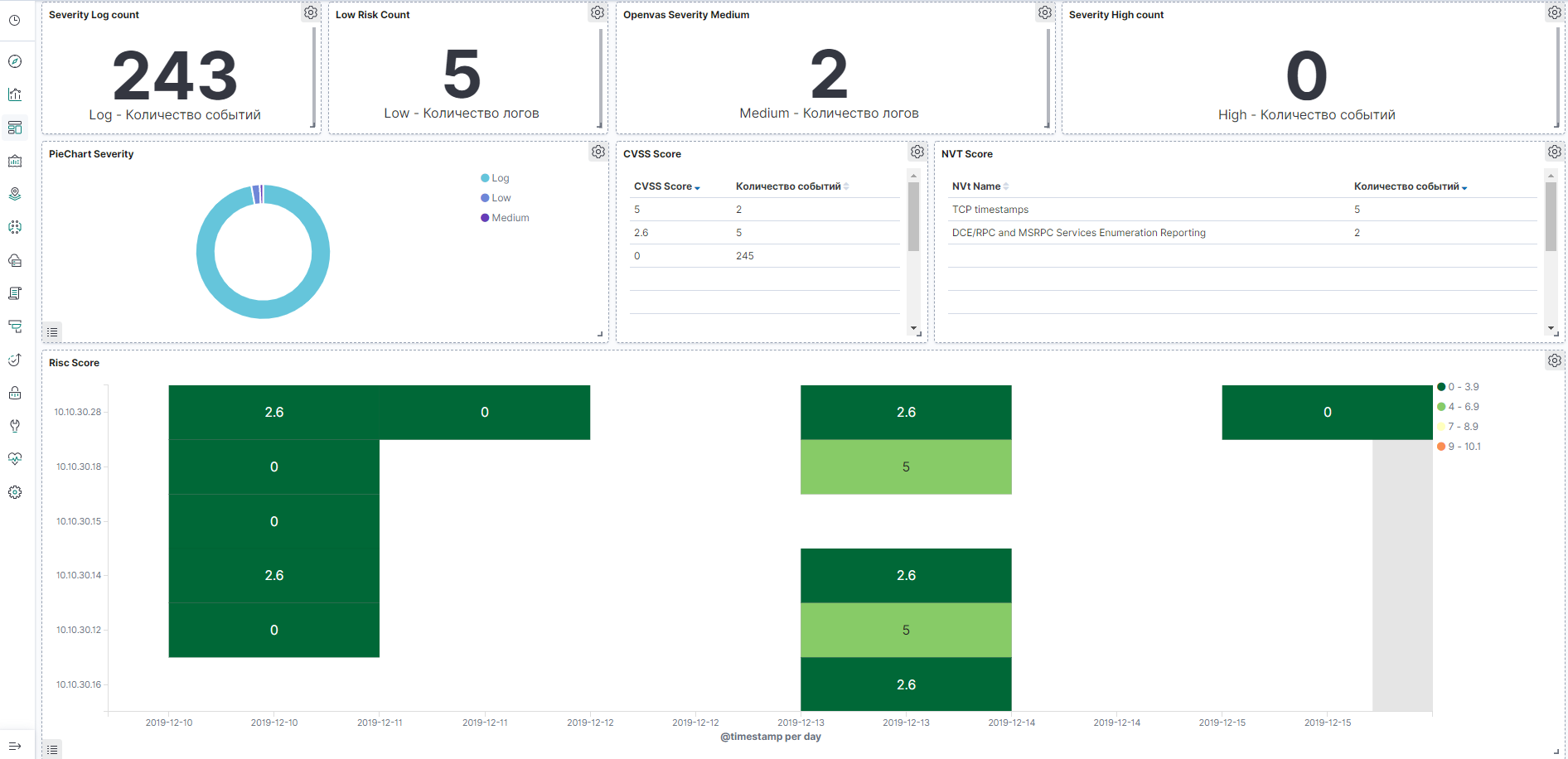

Kibana le permite buscar / tomar datos y solicitar estadísticas de la base de datos de Elasticsearch, pero muchos gráficos y tableros hermosos se construyen en base a las respuestas. El sistema también tiene la funcionalidad de administración de la base de datos de Elasticsearch, en artículos posteriores consideraremos este servicio con más detalle. Ahora vamos a mostrar un ejemplo de paneles en el firewall de Check Point y el escáner de vulnerabilidades OpenVas que se pueden construir.

Ejemplo de panel para Check Point, se puede hacer clic en la imagen:

Ejemplo de tablero de OpenVas, se puede hacer clic en la imagen:

Conclusión

Examinamos en qué consiste la

pila ELK , nos familiarizamos un poco con los productos principales, luego, en el curso, consideraremos por separado escribir el archivo de configuración de Logstash, configurar paneles en Kibana, familiarizarnos con las solicitudes de API, la automatización y mucho más.

Así que estad atentos (

Telegram ,

Facebook ,

VK ,

TS Solution Blog ),

Yandex.Zen .