Hola habr Los conjuntos de datos para Big Data y el aprendizaje automático están creciendo exponencialmente y deben procesarse. Nuestra publicación sobre otra tecnología innovadora en High Performance Computing (HPC), presentada en el stand de Kingston en

Supercomputing 2019 . Este es el uso de sistemas de almacenamiento Hi-End (SHD) en servidores con procesadores gráficos (GPU) y tecnología de bus de almacenamiento GPUDirect. Gracias al intercambio directo de datos entre el almacenamiento y las GPU, sin pasar por la CPU, la carga de datos en los aceleradores de GPU se acelera en un orden de magnitud, por lo tanto, las aplicaciones de Big Data se ejecutan con el máximo rendimiento que proporciona la GPU. A su vez, los desarrolladores de sistemas HPC están interesados en los logros en el campo del almacenamiento con la mayor velocidad de entrada / salida, como los lanzados por Kingston.

Rendimiento de la GPU antes de la carga de datos

Desde la creación de CUDA, una arquitectura de computación paralela de hardware y software basada en GPU para desarrollar aplicaciones de propósito general, en 2007, las capacidades de hardware de las GPU en sí mismas han crecido increíblemente. Hoy en día, las GPU se utilizan cada vez más en el campo de las aplicaciones de HPC, como Big Data, aprendizaje automático y aprendizaje profundo.

Tenga en cuenta que a pesar de la similitud de los términos, las dos últimas son tareas algorítmicamente diferentes. ML enseña una computadora basada en datos estructurados, y DL enseña una computadora basada en la respuesta de una red neuronal. Un ejemplo que ayuda a comprender las diferencias es bastante simple. Suponga que una computadora debe distinguir las fotos de gatos y perros que se cargan del almacenamiento. Para ML, debe enviar un conjunto de imágenes con muchas etiquetas, cada una de las cuales define una característica particular del animal. Para DL, es suficiente cargar una cantidad mucho mayor de imágenes, pero con solo una etiqueta "esto es un gato" o "esto es un perro". DL es muy similar a cómo se les enseña a los niños pequeños: simplemente se les muestran imágenes de perros y gatos en libros y en la vida (con mayor frecuencia, sin siquiera explicar la diferencia detallada), y el cerebro del niño comienza a determinar el tipo de animal después de un cierto número crítico de imágenes para comparar ( Según las estimaciones, estamos hablando de cien o dos impresiones para todo el tiempo de la primera infancia). Los algoritmos DL aún no son tan perfectos: para trabajar con éxito en la definición de imágenes de una red neuronal, es necesario enviar y procesar millones de imágenes en la GPU.

El resultado de la introducción: sobre la base de la GPU, puede crear aplicaciones HPC en el campo de Big Data, ML y DL, pero hay un problema: los conjuntos de datos son tan grandes que el tiempo necesario para cargar datos desde el sistema de almacenamiento a la GPU comienza a reducir el rendimiento general de la aplicación. En otras palabras, las GPU rápidas permanecen subcargadas debido a la lenta entrada / salida de datos de otros subsistemas. La diferencia en la velocidad de entrada / salida de la GPU y el bus a la CPU / SHD puede ser de un orden de magnitud.

¿Cómo funciona la tecnología GPUDirect Storage?

El proceso de entrada / salida es controlado por la CPU, así como el proceso de carga de datos desde el almacenamiento a las GPU para su posterior procesamiento. Esto provocó una solicitud de tecnología que proporcionaría acceso directo entre la GPU y los discos NVMe para una interacción rápida entre ellos. La primera tecnología de este tipo fue propuesta por NVIDIA y la llamó GPUDirect Storage. De hecho, esta es una variación de la tecnología GPUDirect RDMA (Dirección de memoria directa remota) que desarrollaron previamente.

Jensen Huang, CEO de NVIDIA, presenta GPUDirect Storage como una variación de GPUDirect RDMA en SC-19. Fuente: NVIDIA

Jensen Huang, CEO de NVIDIA, presenta GPUDirect Storage como una variación de GPUDirect RDMA en SC-19. Fuente: NVIDIALa diferencia entre GPUDirect RDMA y GPUDirect Storage está en los dispositivos entre los que se realiza el direccionamiento. La tecnología GPUDirect RDMA se reasigna para mover datos directamente entre la tarjeta de entrada de interfaz de red (NIC) y la memoria GPU, y GPUDirect Storage proporciona una ruta de transferencia de datos directa entre almacenamiento local o remoto, como NVMe o NVMe a través de Fabric (NVMe-oF) y memoria GPU.

Ambas opciones, GPUDirect RDMA y GPUDirect Storage, evitan el movimiento innecesario de datos a través de un búfer en la memoria de la CPU y permiten que el mecanismo de Acceso directo a memoria (DMA) transfiera datos desde una tarjeta de red o almacenamiento directamente hacia o desde la memoria de la GPU, todo sin carga en la central procesador Para GPUDirect Storage, la ubicación de almacenamiento no importa: puede ser un disco NVME dentro de una unidad GPU, dentro de un bastidor o conectado a través de una red como NVMe-oF.

Esquema operativo GPUDirect Storage. Fuente: NVIDIA

Esquema operativo GPUDirect Storage. Fuente: NVIDIAAlmacenamiento NVMe Hi-End requerido en el mercado de aplicaciones HPC

Al comprender que con el advenimiento de GPUDirect Storage, el interés de los grandes clientes se centrará en ofrecer sistemas de almacenamiento con una velocidad de entrada / salida correspondiente al ancho de banda de la GPU, Kingston mostró un sistema de demostración que consta de sistemas de almacenamiento basados en discos NVMe y una unidad con una GPU en SC-19 que analizó miles de imágenes de satélite por segundo. Ya escribimos sobre este sistema de almacenamiento basado en 10 unidades DC1000M U.2 NVMe

en un informe de la exposición de supercomputadoras .

El almacenamiento basado en 10 unidades DC1000M U.2 NVMe complementa adecuadamente el servidor con aceleradores gráficos. Fuente: Kingston

El almacenamiento basado en 10 unidades DC1000M U.2 NVMe complementa adecuadamente el servidor con aceleradores gráficos. Fuente: KingstonDicho almacenamiento se realiza en forma de una unidad de bastidor de 1U o más y se puede escalar según la cantidad de discos DC1000M U.2 NVMe, donde cada uno tiene una capacidad de 3.84-7.68 TB. El DC1000M es el primer modelo de SSD NVMe en el factor de forma U.2 en la línea de unidades de Kingston para centros de datos. Tiene una clasificación de resistencia (DWPD, Drive escribe por día), que le permite sobrescribir los datos a plena capacidad una vez al día para una vida útil garantizada.

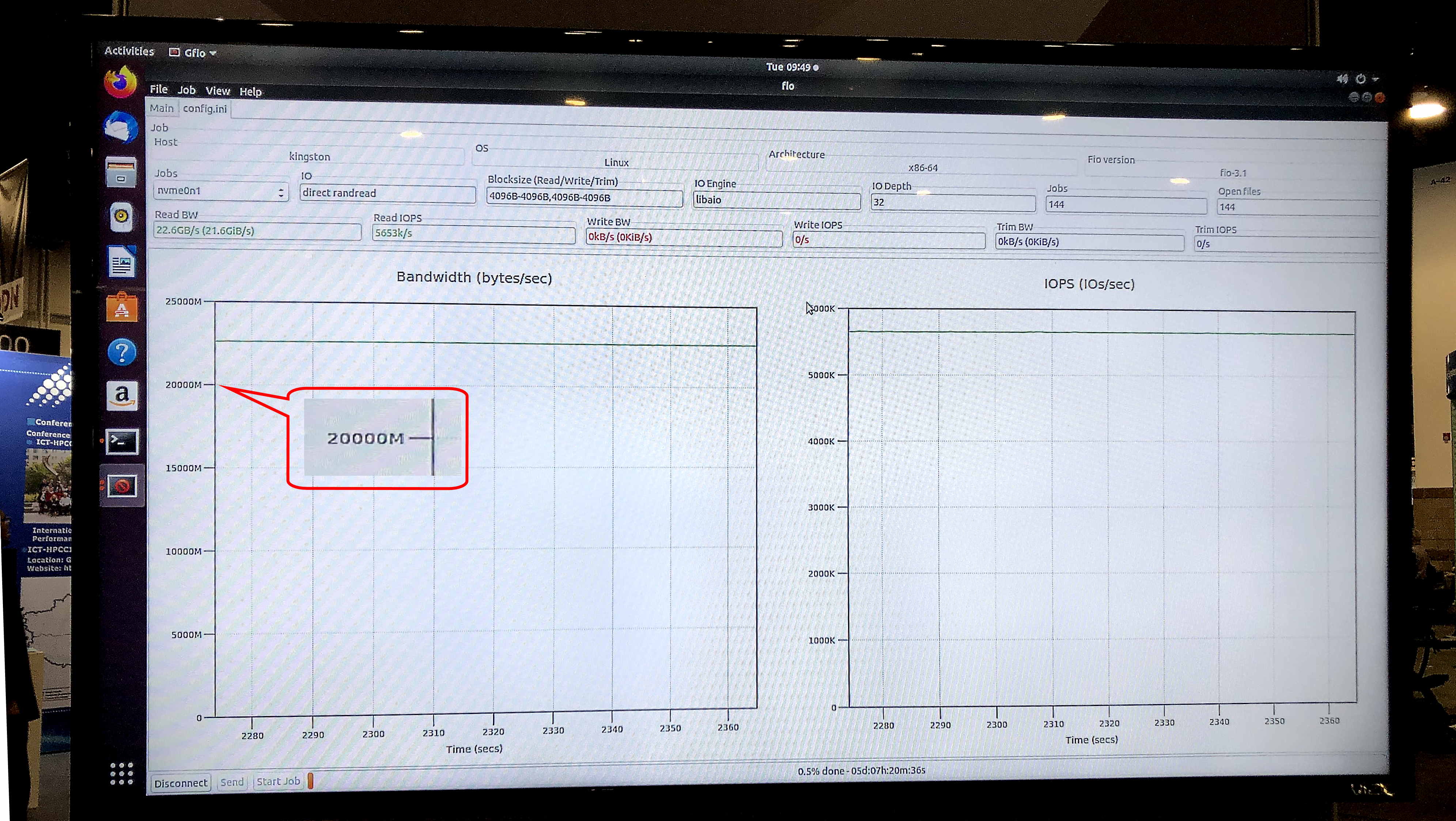

En la prueba de fio v3.13 en el sistema operativo Ubuntu 18.04.3 LTS, kernel de Linux 5.0.0-31-generic, el modelo de almacenamiento de exhibición mostró una velocidad de lectura sostenida de 5.8 millones de IOPS con un ancho de banda sostenido de 23.8 Gb / s.

Ariel Pérez, gerente comercial de SSD de Kingston, describió los nuevos sistemas de almacenamiento de la siguiente manera: “Estamos listos para proporcionar a la próxima generación de servidores SSD NVMe U.2 para abordar muchos de los cuellos de botella de transferencia de datos que tradicionalmente se han asociado con el almacenamiento. La combinación de SSD NVMe y nuestra DRAM Premier Server Premier hace de Kingston uno de los proveedores de procesadores de datos de extremo a extremo más completos de la industria ".

La prueba gfio v3.13 mostró un ancho de banda de 23.8 Gb / s para el almacenamiento de demostración en unidades DC1000M U.2 NVMe. Fuente: Kingston

La prueba gfio v3.13 mostró un ancho de banda de 23.8 Gb / s para el almacenamiento de demostración en unidades DC1000M U.2 NVMe. Fuente: Kingston¿Cómo se verá un sistema típico para las aplicaciones HPC que usan la tecnología GPUDirect Storage o similar? Esta es una arquitectura con separación física de bloques funcionales dentro de un rack: una o dos unidades para RAM, algunas más para nodos informáticos de GPU y CPU, y una o más unidades para almacenamiento.

Con el anuncio de GPUDirect Storage y la posible aparición de tecnologías similares en otros proveedores de GPU, Kingston amplía su demanda de sistemas de almacenamiento diseñados para su uso en informática de alto rendimiento. El marcador será la velocidad de lectura de datos del sistema de almacenamiento, comparable con el ancho de banda de las tarjetas de red de 40 o 100 Gbit en la entrada de la unidad informática con la GPU. Por lo tanto, los sistemas de almacenamiento ultrarrápidos, que incluyen NVMe externo a través de Fabric, de exótico se convertirán en la corriente principal para las aplicaciones HPC. Además de los cálculos científicos y financieros, encontrarán aplicación en muchas otras áreas prácticas, como sistemas de seguridad del nivel de la Ciudad Segura de megalópolis o centros de vigilancia en el transporte, donde se requiere la velocidad de reconocimiento e identificación al nivel de millones de imágenes HD por segundo ", el nicho de mercado de la parte superior SHD

Puede encontrar información adicional sobre los productos Kingston en

el sitio web oficial de la compañía.