Controlar los pensamientos con cualquier cosa que no sean sus propias extremidades es un área fascinante. Siempre es interesante imaginar un futuro en el que podamos interactuar con Internet no solo con nuestros dedos, boca, ojos y oídos.

Si lo piensa, la computadora y el teléfono son interfaces terriblemente ineficientes para obtener la información necesaria. Sabes exactamente lo que quieres saber: por ejemplo, el tipo de cambio actual del rublo frente al dólar. Use sus dedos para hacer clic en ciertas áreas de la pantalla del teléfono con letras, apuntando a los puntos correctos cada vez, y luego vea la respuesta.

Sería mucho más hermoso decir mentalmente "¡Hola Igor!", Formular una pregunta mentalmente y obtener una respuesta con un oído / ojo / de otra manera. O envíe un mensaje a un amigo de la misma manera rápida. En general, conecte Internet al cerebro.

Dado que esto se puede probar en la práctica ahora, vale la pena administrar algo, ver qué tan conveniente es y sacar conclusiones. Un video con los resultados está al final del artículo.

1. Idea de entrada2. Lo que se necesita3. Poniéndolo todo junto4. Intentamos una vez5. Prueba dos6. tres7. Pensamientos de fin de semanaIdea

El plan salió simple:

Paso 1. Tome un

dispositivo EEG que lea la actividad cerebral.

Paso 2. Entrenamos un algoritmo que nos permite determinar comandos mentales con suficiente precisión. Intentamos varios tipos de comandos mentales (más sobre eso más adelante).

Paso 3. Conéctese a cualquier cosa en movimiento.

Paso 4. Intentamos realizar una tarea simple, por ejemplo, conducir del punto A al punto B.

Paso 5. Sacamos conclusiones de todo esto, si es el momento. Si no, repita los pasos 2 y 4.

Sí, varios expertos realizaron previamente experimentos similares: hay muchas pruebas del

enfoque P300 , que le permite escribir pensamientos (sale con mucha precisión,

pero durante mucho tiempo ), controlar varias prótesis y otros dispositivos. Nada nuevo desde un punto de vista científico está sucediendo en el experimento actual, el objetivo es probar el control del cerebro en persona y sacar algunas conclusiones de los sentimientos y pensamientos sobre el BCI (interfaz cerebro-computadora).

Lo que se necesita

Tomamos

Emotiv Insight como un dispositivo EEG. Lejos del dispositivo más preciso con una baja resolución de una tarjeta electromagnética montada, pero suficiente para nuestros propósitos. Cuesta

$ 299 , casi siempre hay descuentos en este modelo, pero el problema es con la entrega a Rusia: no lo es. Esto se explica no tanto por problemas logísticos como por problemas legislativos: los dispositivos EEG son dispositivos médicos desde el punto de vista de las normas aduaneras de la Federación de Rusia (con las consecuencias correspondientes).

También es imposible venir y recoger en algún lugar del mundo, por lo que solo queda pedir a aquellos países cercanos a Rusia para los que hay una opción de entrega: Polonia, Israel o algo así. Se rumorea que se está vendiendo en Moscú desde abajo, pero con los márgenes adecuados.

Los dispositivos Emotiv también son buenos desde el punto de vista del software: es propietario, pero puede hacer mucho y, importante para los propósitos de nuestro experimento, tiene herramientas integradas para trabajar con comandos mentales.

Como robot, tomamos la plataforma

Hicat.Livera . Construido sobre la base de Arduino. De hecho, esto es todo, solo con una cámara, ruedas, un láser y modificaciones menores al software. Cuesta alrededor de

$ 100- $ 150 , probablemente sea más conveniente ordenar a través de AliExpress, pero pedimos directamente a través del sitio, aunque no hubo problemas de entrega.

Poniéndolo todo junto

En algunos puntos, el proceso de conectar todo a un banco de pruebas se veía así:

1. Instale el software necesario para Emotiv desde aquí . De todo el conjunto, necesitamos un conector y

Emotiv BCI .

2. Conecte Insight a la computadora y pruebe la conexión.

3. Instale Node-RED . Esto es algo tan maravilloso que le permite procesar convenientemente datos y señales. Con la ayuda de una gran cantidad de módulos, puede compilar algún tipo de utilidad en un par de minutos: envíese una alerta de la próxima lluvia en telegramas, procese un montón de datos en bruto y todo eso.

4. Agregue al Nodo-RED Emotiv Toolbox como un módulo.

Aquí se

describe lo que es. Poner en un par de clics.

5. Recopilamos Hicat.Livera. Está sucediendo así: si todo se hace de acuerdo con las instrucciones, la batería se caerá constantemente, uno de los tornillos autorroscantes bloquea las rotaciones de la cámara, etc. Aquí necesitas un poco de creatividad.

6. Conecte el robot a la computadora. Para esto, no necesita ningún software adicional, se controla a través de WebSocket, es suficiente para estar en la misma red Wi-Fi. Es cierto, aquí tampoco es tan simple: resultó que el fabricante no escribió todos los archivos en la tarjeta de memoria, por lo que tuve que desmontarlos, descargarlos del

repositorio y sobrescribirlos. En general, el clásico esplendor y pobreza de los proyectos

kickstarter .

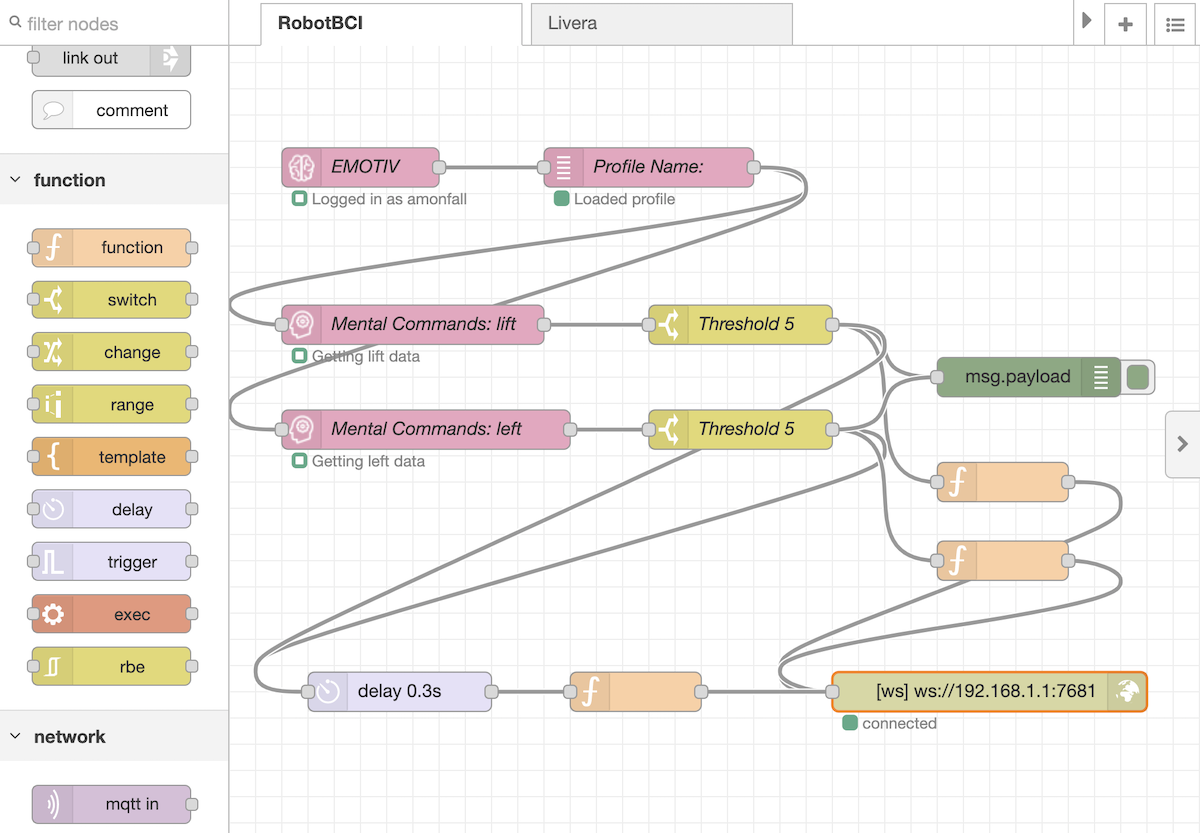

7. Flujo maestro en Nodo-RED. Tomamos señales de los equipos capacitados en Emotiv BCI, los eliminamos del ruido en el umbral y enviamos el valor de potencia recibido al robot. Un tercio de segundo después de cada señal, restablecemos el voltaje en los motores. Resultó así:

La tarjeta en sí para Node-RED se puede descargar

desde aquí e importar a su Flow.

Además, solo queda practicar y probar.

Intenta una vez

El robot puede avanzar / retroceder, girar por separado cada rueda, subir / bajar la cámara y encender / apagar el láser. Es difícil entrenar al mismo tiempo para 6-8 acciones, por lo que el primer intento involucró tres acciones: avanzar, girar a la izquierda y girar a la derecha.

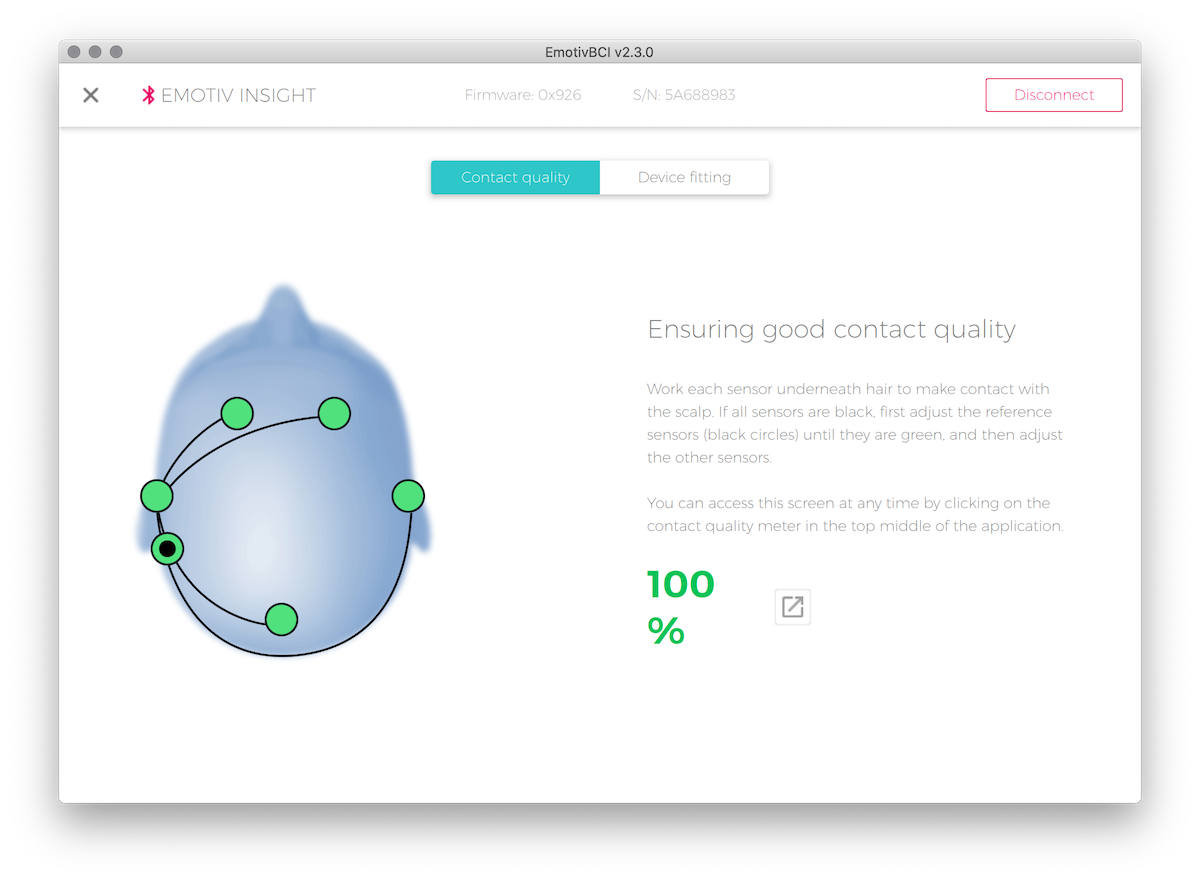

Calidad de conexión Cerebras se puede ver en un monitor conveniente. En el caso de Insight, es importante que el sensor principal detrás de la oreja esté muy apretado contra el cuero cabelludo: si hay interferencia en él, no habrá señal de los otros seis sensores.

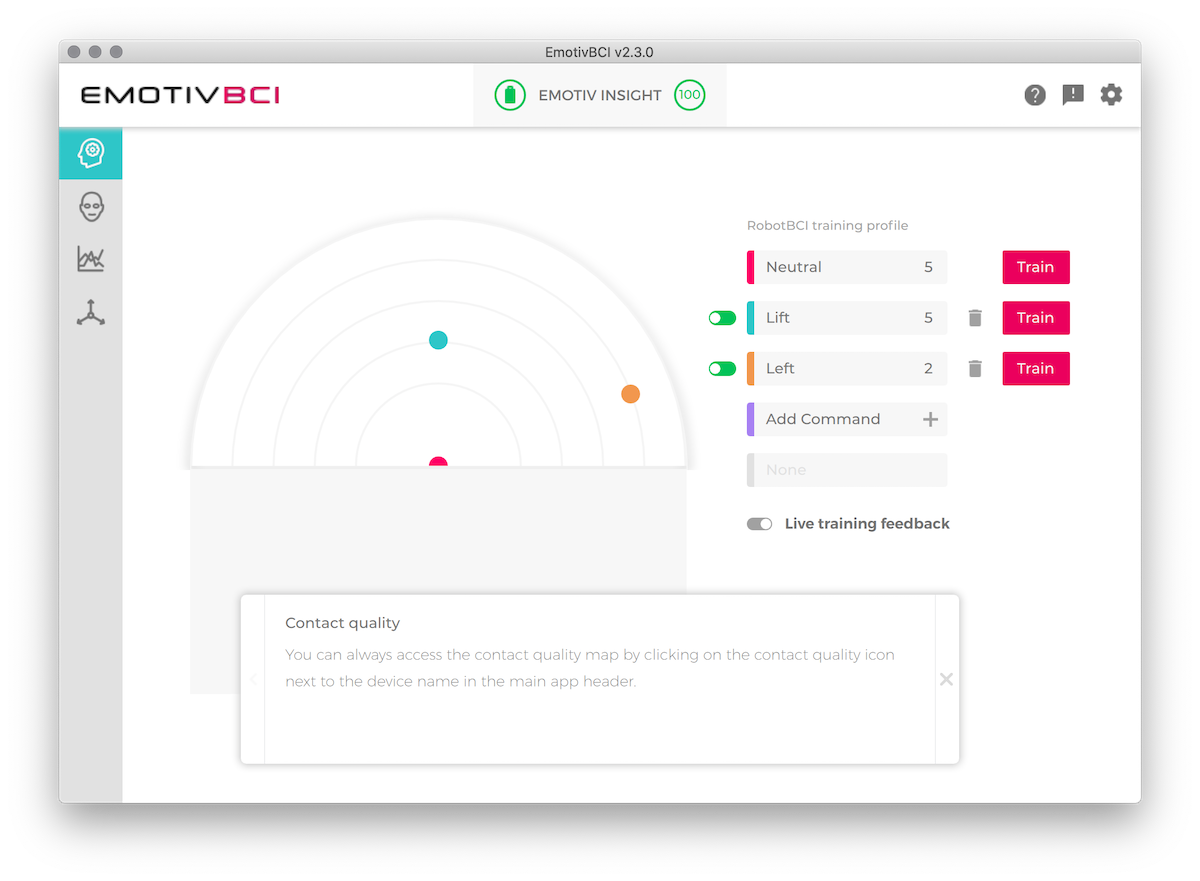

El siguiente es el entrenamiento. Primero, lo más difícil es registrar un estado de conciencia tranquilo y normal, sin estímulos ni pensamientos externos. Quién sabe las prácticas meditativas todavía no importa dónde, pero así, no es nada fácil pensar en nada. El algoritmo tomará este registro como fondo y buscará diferencias entre los estados de comando y los predeterminados.

Después de eso - entrenamiento de cada equipo. Las primeras dos o tres entradas se perciben incondicionalmente como la base para la capacitación. A continuación, el algoritmo determina cada vez qué tanto su registro es similar al anterior. Si la diferencia es demasiado grande, se sugiere no considerar esta sesión en el entrenamiento. Obviamente, con estados de conciencia de muchos lados, el entrenamiento no tiene sentido.

Cada sesión de entrenamiento posterior aclara el estado del modelo, el equipo de seguimiento. En el mapa de este modelo, puede ver cuánto difieren los equipos entre sí: si las similitudes son demasiado grandes (los puntos en el radar están cerca), entonces el algoritmo difícilmente comprenderá lo que tenía en mente en cada caso particular.

La pregunta principal durante el entrenamiento es, de hecho, ¿qué pensar? Con el cerebro, podemos hacer dos cosas: controlar los músculos y pensar. El hecho es que la corteza motora, que es responsable de los movimientos musculares, produce una interferencia muy fuerte desde el punto de vista del EEG. Es decir, si, como equipo, intenta mover las extremidades, tensarlas o imaginar que están funcionando, esto generará un ruido continuo indistinguible con una precisión tan general como el modelo Insight.

Queda por pensar. Hay una gran extensión: para hablar mentalmente palabras, pensar en algún tipo de sensación, imaginarse en algún lugar, imaginar el robot moviéndose en la dirección correcta, etc.

Para comenzar, se eligió una dirección verbal: pronunciar una frase específica para cada equipo con una voz interna.

Los resultados de este enfoque resultaron ser insatisfactorios: sí, los comandos se ejecutaron definitivamente con diferentes configuraciones de sensibilidad, pero era completamente imposible controlarlos. Hay una clara distinción entre tratar de ejecutar comandos y su ausencia: en el primer caso, el robot hace algo, en el segundo prácticamente no hay nada, pero no fue posible obligarlo a ir al menos en la dirección aproximada.

Prueba dos

Además, surgió la idea de probar las siguientes áreas:

- Para pensar en algún momento brillante, por ejemplo, te acuestas en la playa y el sol se calienta cálidamente.

- Escuche diferentes señales de sonido / extractos musicales.

- Representar frío / calor en ciertas partes de ciertas extremidades.

- Intenta imitar el buen humor y el mal humor.

- Escuche los comandos de voz de diferentes personas desde diferentes ángulos (para aumentar la diferenciación de las señales agregando sensación espacial).

Los resultados fueron interesantes: por ejemplo, la voz de una persona al lado del sujeto del experimento condujo al movimiento del robot en una dirección y a la otra persona en la otra. No importaba lo que dijeran estas personas.

Pero en general, la precisión resultó ser igual de triste: administrar con una calidad que le permite realizar una secuencia estricta de comandos no funcionó.

Tres

Para aumentar la precisión del control, se decidió reducir el número de equipos de tres a dos: avanzar y girar en su lugar en una dirección. Esto es suficiente para moverse en el avión, y el reconocimiento de solo dos equipos debería ser más fácil.

El resultado es el siguiente:

Es muy fácil llegar del punto A al punto B, pero después de una serie de entrenamientos hay un resultado aproximado.

Pensamientos de fin de semana

BCI en forma de comandos mentales abstractos es más bien una cosa imposible desde un punto de vista práctico. Sí, puede implantar electrodos en una parte específica del cerebro, entrenar durante mucho tiempo y, como resultado, aprender a controlar el cursor o un brazo robótico, como propio. Esto es muy adecuado para resolver problemas de discapacidad y otros problemas, pero en cada caso esta solución es individual para una persona en particular, porque El cerebro necesita un período relativamente largo para construir nuevas conexiones neuronales.

Como interfaz masiva: lo compré, lo puse en mi cabeza y lo uso, no funciona. Algunos de nosotros tuvimos éxito inmediatamente en lograr una implementación clara de los comandos, mientras que otros no lograron hacer nada, incluso después de largos entrenamientos. El proceso es demasiado individual y demasiado complicado de explicar en las instrucciones de uso. Además, al día siguiente después de una gestión exitosa, es difícil repetir lo mismo: el estado de conciencia ya es algo diferente.

Es mucho más efectivo, en mi opinión, usar dispositivos que lean la voz interna a través de cambios en los potenciales de los músculos de la mandíbula inferior y el cuello para el control "mental". Cuando hablamos con nosotros mismos, se dan señales nerviosas a los músculos del aparato vocal,

que se mueven muy ligeramente . Si son monitoreados por sensores sensibles, casi sin entrenamiento, puede dictar el texto con su voz interior.

Hay muchos dispositivos similares, uno de los últimos es el proyecto

AlterEgo de los investigadores del MIT. Mientras está en desarrollo, pero en las demostraciones de video, puede ver que todavía funciona relativamente bien.

En esencia, sin embargo, es el mismo control del habla, pero sin sonido. El problema con todas las interfaces de voz es la falta de comprensión de la paleta de comandos. Si miramos un sitio web o una aplicación, vemos botones, firmas para ellos y entendemos dónde tocar. En el caso de un asistente de voz, entender lo que se puede preguntar exactamente no es, los posibles comandos se deben aprender de memoria o cada vez que se escuchan largas listas de posibles temas para el diálogo. Todo esto, junto con el reconocimiento de voz no ideal, lleva al hecho de que ahora solo usamos el conjunto estándar de comandos de asistente de voz: llame a Sophocles, configure un temporizador durante quinientos años, le recuerde que se detenga para trabajar.

Entonces, en este momento tenemos lo siguiente: a) si logras algo para que se vea bien, pero al mismo tiempo funciona, solo está leyendo la voz interna (será necesario hacer un experimento aquí también) yb) competencia por la interfaz gráfica hasta ahora Ni siquiera cerca.

En cuanto al segundo punto, existen tecnologías en el campo de la

estimulación magnética transcraneal . En resumen: si enfoca algo como un microondas en la corteza visual, entonces veremos fosfenos, puntos brillantes y efectos que el ojo no ve. Dichos dispositivos pueden dibujar caracteres bastante precisos, por ejemplo, letras en el espacio. Estos procedimientos, por regla general, causan fuertes dolores de cabeza y náuseas, no son muy recomendables para los experimentos, pero en teoría es posible dibujar una interfaz en la cara de un hombre de hierro sin lentes ni anteojos. Es cierto que puede usar lentes y anteojos, pero más sobre eso, tal vez en otro momento.

En la portada hay una foto tomada por Road to VR para un artículo sobre los experimentos BCI de Valve.