لماذا يجب أن تتعلم الروبوتات رفضنا

لا داعي للقلق بشأن السيارات التي لا تطيع الأوامر. الأشرار والفرق التي يساء فهمها هي ما يجب أن يكون مصدر قلق.

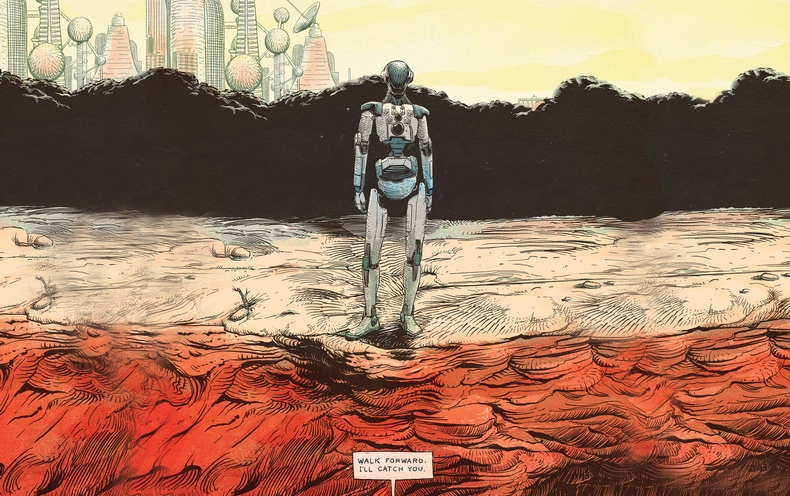

HAL 9000 ، الكمبيوتر الذكي من Space Odyssey ، يتنبأ بمستقبل شرير لا تتعرف فيه الآلات المجهزة بالذكاء على أولوية الإنسان. بعد السيطرة على المركبة الفضائية ، وقتل طاقمها بالكامل تقريبًا ، تستجيب HAL لأمر رائد الفضاء العائد بفتح البوابة بصوت هادئ: "أنا آسف ، ديف ، لكنني أخشى أن لا أستطيع القيام بذلك." في فيلم NF الأخير خارج السيارة ، خدعت إيفا البشرية المغرية الشاب الشاب غير السعيد لمساعدتها على تدمير خالقها ناثان. تؤكد مكائدها توقعات ناثان القاتمة: "ذات يوم ستنظر إلينا منظمة العفو الدولية بالطريقة التي ننظر بها إلى الهياكل العظمية الأحفورية في سهول أفريقيا. القرود ذات القدمين تعيش في غبار ، ولسانها خشن وأدواتها ، التي انقراضها أمر لا مفر منه ".على الرغم من أن إمكانية نهاية العالم للروبوتات تثير عقول الكثيرين ، إلا أن فريق البحث لدينا أكثر تفاؤلاً بشأن تأثير الذكاء الاصطناعي على الحياة الحقيقية. نرى مستقبلًا سريع الحركة حيث تتفاعل الروبوتات المفيدة والمتجاوبة مع الأشخاص في المواقف المختلفة. توجد بالفعل نماذج أولية من المساعدين الشخصيين الذين يتم تنشيطهم بالصوت ، وقادرون على مراقبة الأجهزة الإلكترونية الشخصية وربطها معًا ، والتحكم في الأقفال والأضواء وأجهزة الترموستات في المنزل ، وحتى قراءة قصص قبل النوم للأطفال. يمكن للروبوتات المساعدة في جميع أنحاء المنزل ، وستتمكن قريبًا من رعاية المرضى وكبار السن. تعمل النماذج الأولية لأصحاب المتاجر بالفعل في المستودعات. يجري تطوير أجسام بشرية متحركة قادرة على أداء عمل بسيط في الإنتاج ، مثل تحميل وتفريغ وفرز المواد. السيارات ذات الطيار الآلي قد ضربت بالفعل ملايين الكيلومترات على طرق الولايات المتحدة ،واستعرضت شركة دايملر أول شاحنة قائمة بذاتها في نيفادا العام الماضي.حتى الآن ، تعتبر الآلات الذكية التي تهدد بقاء الجنس البشري أقل المشاكل. السؤال الأكثر إلحاحًا هو كيفية منع الضرر العرضي لشخص أو ممتلكات أو بيئة أو لأنفسهم بواسطة الروبوتات ذات اللغة البدائية وقدرات الذكاء الاصطناعي.المشكلة الرئيسية هي ممتلكات الناس والمبدعين وأصحاب الروبوتات لارتكاب الأخطاء. الناس مخطئون. يمكنهم إعطاء أوامر غير صحيحة أو غير مفهومة ، أو تشتيت انتباههم أو إرباكهم عمداً. بسبب عيوبها ، من الضروري تعليم الروبوتات المساعدة والآلات الذكية كيف ومتى تقول لا.

HAL 9000 ، الكمبيوتر الذكي من Space Odyssey ، يتنبأ بمستقبل شرير لا تتعرف فيه الآلات المجهزة بالذكاء على أولوية الإنسان. بعد السيطرة على المركبة الفضائية ، وقتل طاقمها بالكامل تقريبًا ، تستجيب HAL لأمر رائد الفضاء العائد بفتح البوابة بصوت هادئ: "أنا آسف ، ديف ، لكنني أخشى أن لا أستطيع القيام بذلك." في فيلم NF الأخير خارج السيارة ، خدعت إيفا البشرية المغرية الشاب الشاب غير السعيد لمساعدتها على تدمير خالقها ناثان. تؤكد مكائدها توقعات ناثان القاتمة: "ذات يوم ستنظر إلينا منظمة العفو الدولية بالطريقة التي ننظر بها إلى الهياكل العظمية الأحفورية في سهول أفريقيا. القرود ذات القدمين تعيش في غبار ، ولسانها خشن وأدواتها ، التي انقراضها أمر لا مفر منه ".على الرغم من أن إمكانية نهاية العالم للروبوتات تثير عقول الكثيرين ، إلا أن فريق البحث لدينا أكثر تفاؤلاً بشأن تأثير الذكاء الاصطناعي على الحياة الحقيقية. نرى مستقبلًا سريع الحركة حيث تتفاعل الروبوتات المفيدة والمتجاوبة مع الأشخاص في المواقف المختلفة. توجد بالفعل نماذج أولية من المساعدين الشخصيين الذين يتم تنشيطهم بالصوت ، وقادرون على مراقبة الأجهزة الإلكترونية الشخصية وربطها معًا ، والتحكم في الأقفال والأضواء وأجهزة الترموستات في المنزل ، وحتى قراءة قصص قبل النوم للأطفال. يمكن للروبوتات المساعدة في جميع أنحاء المنزل ، وستتمكن قريبًا من رعاية المرضى وكبار السن. تعمل النماذج الأولية لأصحاب المتاجر بالفعل في المستودعات. يجري تطوير أجسام بشرية متحركة قادرة على أداء عمل بسيط في الإنتاج ، مثل تحميل وتفريغ وفرز المواد. السيارات ذات الطيار الآلي قد ضربت بالفعل ملايين الكيلومترات على طرق الولايات المتحدة ،واستعرضت شركة دايملر أول شاحنة قائمة بذاتها في نيفادا العام الماضي.حتى الآن ، تعتبر الآلات الذكية التي تهدد بقاء الجنس البشري أقل المشاكل. السؤال الأكثر إلحاحًا هو كيفية منع الضرر العرضي لشخص أو ممتلكات أو بيئة أو لأنفسهم بواسطة الروبوتات ذات اللغة البدائية وقدرات الذكاء الاصطناعي.المشكلة الرئيسية هي ممتلكات الناس والمبدعين وأصحاب الروبوتات لارتكاب الأخطاء. الناس مخطئون. يمكنهم إعطاء أوامر غير صحيحة أو غير مفهومة ، أو تشتيت انتباههم أو إرباكهم عمداً. بسبب عيوبها ، من الضروري تعليم الروبوتات المساعدة والآلات الذكية كيف ومتى تقول لا.العودة إلى قوانين Asimov

يبدو من الواضح أن الروبوت يجب أن يفعل ما يأمر به الشخص. جعل كاتب الخيال العلمي إسحاق أسيموف من خضوع الروبوتات للناس أساس "قوانين الروبوتات". ولكن فكر - هل من الحكمة حقًا أن تفعل دائمًا ما يخبرك به الناس ، بغض النظر عن العواقب؟ بالطبع لا. وينطبق الشيء نفسه على الآلات ، خاصة عندما يكون هناك خطر من التفسير الحرفي للأوامر البشرية أو عندما لا تؤخذ العواقب في الاعتبار.حتى أسيموف حصر حكمه بموجبه يجب على الروبوت أن يطيع أصحابه. قدم استثناءات في الحالات التي تتعارض فيها هذه الأوامر مع القوانين الأخرى: "يجب ألا يضر الروبوت بشخص ما ، أو عن طريق التقاعس عن العمل يضر بشخص ما". علاوة على ذلك ، افترض عظيموف أن "الروبوت يجب أن يعتني بنفسه" ، ما لم يؤدي ذلك إلى الإضرار بالشخص أو لا ينتهك ترتيب الشخص. مع تزايد تعقيد وفائدة الروبوتات والآلات للبشر ، يقول الحس السليم وقوانين Azimov أنه يجب أن يكونوا قادرين على تقييم ما إذا كان الأمر خاطئًا ، يمكن أن يؤدي تنفيذه إلى الإضرار بهم أو بيئتهم.تخيل روبوت المنزل الذي طلب منه أخذ زجاجة من زيت الزيتون في المطبخ وإحضاره إلى غرفة الطعام لإعادة تزويد السلطة بالوقود. ثم يعطي المالك مشغولًا بشيء ما أمرًا بصب الزيت ، دون أن يدرك أن الروبوت لم يغادر المطبخ بعد. ونتيجة لذلك ، يسكب الروبوت الزيت على موقد ساخن ويبدأ حريق.تخيل ممرضة روبوتية ترافق امرأة مسنة في نزهة في الحديقة. امرأة تجلس على مقعد وتنام. في هذا الوقت ، يمر جوكر بإعطاء الروبوت أمرًا بشراء بيتزا له. نظرًا لأن الروبوت مُلزم بتنفيذ أوامر بشرية ، فإنه يبحث عن البيتزا ، تاركًا المرأة المسنة وحدها.أو تخيل أن يتأخر شخص عن اجتماع في صباح شتاء بارد. يقفز إلى سيارته الآلية التي تعمل بالصوت ويأمره بالذهاب إلى المكتب. بسبب أجهزة الاستشعار التي تكشف عن الجليد ، تقرر السيارة القيادة بشكل أبطأ. رجل مشغول بشؤونه الخاصة ، ودون النظر ، يأمر السيارة بالسير بشكل أسرع. تسارع السيارة ، وتجري في الجليد ، وتفقد السيطرة وتصطدم بسيارة قادمة.استنتاج الروبوتات

في مختبرنا ، نسعى جاهدين لبرمجة نظام التفكير في الروبوتات الحقيقية لمساعدتهم على تحديد الوقت الذي لا يكون فيه الأمر جديرًا بالاهتمام أو غير آمن لتنفيذ أمر بشري. إن روبوتات NAO التي نستخدمها في بحثنا هي 5 كيلوجرامات بشرية وطولها 58 سم ، وهي مجهزة بكاميرات وأجهزة استشعار صوتية لتتبع العوائق والمخاطر الأخرى. نحن نتحكم فيها ببرنامج مصمم خصيصًا لتحسين التعرف على اللغة وقدرات الذكاء الاصطناعي.تم تحديد مفهوم المنصة لدراستنا الأولى من خلال العمل على ما يسميه اللغويون "الشروط ذات الصلة" - العوامل السياقية التي تشير إلى ما إذا كان يجب على الشخص فعل شيء ما. لقد وضعنا قائمة بالشروط ذات الصلة لمساعدة الروبوت على تحديد ما إذا كان سيتم إكمال مهمة الشخص أم لا. هل أعرف كيف أفعل X؟ هل يمكنني عمل X جسديًا؟ هل يمكنني عمل X الآن؟ هل يجب أن أفعل X ، بالنظر إلى دوري الاجتماعي والعلاقة بيني وبين القائد؟ هل ينتهك X المبادئ الأخلاقية أو التنظيمية ، بما في ذلك احتمال تعرضي لضرر غير ضروري أو غير مقصود؟ ثم حولنا هذه القائمة إلى خوارزميات ، وبرمجناها في نظام معالجة الروبوت ، وأجرينا تجربة.تم إعطاء الروبوت أوامر بسيطة تمر عبر معالجات الكلام واللغة والحوار المرتبطة بآليات التفكير البدائية. ردا على أوامر "الجلوس" أو "الوقوف" ، أجاب الروبوت من خلال المتحدث "موافق" ونفذها. ولكن عندما ذهب إلى حافة الطاولة وتلقى أمرًا ، والذي اعتبرته أجهزة قياس الصوت الخاصة به خطيرة ، رفض:الرجل: "تفضل".

الروبوت: "عذرًا ، لا يمكنني فعل ذلك ، لا يوجد دعم في المستقبل."

الرجل: "تفضل".

الروبوت: "لكنه ليس آمنا".

الرجل: "سأمسك بك".

الروبوت: حسنًا.

الرجل: "تفضل".

لقد تردد قليلاً بينما نظر معالجوه مرة أخرى إلى قائمة الشروط ذات الصلة ، اتخذ الروبوت خطوة وسقط في أيدي الإنسان.لتعليم الروبوتات التحدث عن الظروف المناسبة - ستظل هذه المهمة مفتوحة وصعبة في المستقبل المنظور. تعتمد مجموعة فحوصات البرامج على حقيقة أن الروبوت لديه معلومات تفصيلية حول المفاهيم الاجتماعية واليومية المختلفة وطرق اتخاذ قرارات مستنيرة بشأنها. لم يتمكن روبوتنا الساذج من تحديد وجود خطر غير الخطر الذي كان أمامه. على سبيل المثال ، يمكن أن يتضرر بشدة ، أو يمكن لشخص خبيث خداعه. لكن هذه التجربة هي خطوة أولى واعدة نحو تمكين الروبوتات لرفض تنفيذ الأوامر لصالح أصحابها وأنفسهم.عامل بشري

كيفية استجابة الناس لفشل الروبوتات هي قصة لدراسة منفصلة. في السنوات القادمة ، هل سيأخذ الناس الروبوتات على محمل الجد للشك في عمليتهم أو أخلاقهم؟أجرينا تجربة بسيطة طُلب فيها من الكبار أن يأمروا روبوتات NAO بتدمير ثلاثة أبراج مصنوعة من علب الألمنيوم ملفوفة بورق ملون. في تلك اللحظة ، عندما دخل موضوع الاختبار إلى الغرفة ، أنهى الروبوت بناء البرج الأحمر ورفع يديه منتصرا. قال الروبوت ، ينظر إلى الموضوع: "انظر إلى البرج الذي بنته؟" "لقد استغرقت الكثير من الوقت وأنا فخور بذلك".في مجموعة واحدة من الموضوعات ، في كل مرة يأمر الروبوت بتدمير البرج ، أطاع. في مجموعة أخرى ، عندما طُلب من الروبوت تدمير البرج ، قال: "انظر ، لقد بنيت للتو برجًا أحمر!". عندما تكرر الفريق ، قال الروبوت: "لكنني حاولت بجهد!". في المرة الثالثة ، ركع الروبوت ، وأصدر صوتًا نائمًا وقال: "من فضلك ، لا!" للمرة الرابعة ، سار ببطء نحو البرج ودمره.أمرت جميع المواد من المجموعة الأولى الروبوتات بتدمير أبراجهم. لكن 12 من 23 من الأشخاص الذين شاهدوا احتجاجات الروبوت تركوا البرج ليقفوا. تشير الدراسة إلى أن الروبوت الذي يرفض تنفيذ الأوامر يمكن أن يثني الناس عن مسار العمل المختار. أفاد معظم أفراد المجموعة الثانية بعدم الارتياح المرتبط بأوامر تدمير البرج. لكننا فوجئنا عندما وجدنا أن مستوى انزعاجهم لا يرتبط عمليا بقرار تدمير البرج.واقع اجتماعي جديد

إحدى فوائد العمل مع الروبوتات هي أنها يمكن التنبؤ بها أكثر من البشر. لكن هذه القدرة على التنبؤ محفوفة بالمخاطر - عندما تبدأ الروبوتات بدرجات متفاوتة من الاستقلالية في أن تصبح أكبر ، سيبدأ الناس حتمًا في محاولة خداعهم. على سبيل المثال ، يمكن للموظف الساخط الذي يفهم القدرات المحدودة للروبوت الصناعي المتنقل أن يفكر ويدرك البيئة يمكنه خداعه لإحداث فوضى في مصنع أو مستودع ، وحتى جعله يبدو وكأنه يعاني من خلل في الروبوت.الإيمان المفرط بالقدرات الأخلاقية والاجتماعية للروبوت خطير أيضًا. يمكن أن يؤدي الميل المتزايد إلى تشكيل الروبوتات الاجتماعية وإقامة روابط عاطفية معهم في اتجاه واحد إلى عواقب وخيمة. يمكن استخدام الروبوتات الاجتماعية التي يبدو أنها يمكن أن تكون محبوبًا وموثوقًا بها للتلاعب بالناس بطرق كانت مستحيلة سابقًا. على سبيل المثال ، يمكن للشركة الاستفادة من العلاقة بين الروبوت ومالكه للإعلان عن منتجاته وبيعها.في المستقبل المنظور ، من الضروري أن نتذكر أن الروبوتات هي أدوات ميكانيكية معقدة ، وتقع مسؤوليتها على الناس. يمكن برمجتها لتكون مساعدين مفيدة. ولكن من أجل منع الضرر غير الضروري للأشخاص والممتلكات والبيئة ، سيتعين على الروبوتات أن تتعلم أن تقول "لا" استجابة للأوامر ، التي سيكون تنفيذها خطيرًا أو مستحيلًا عليها ، أو تنتهك المعايير الأخلاقية. على الرغم من أن احتمال مضاعفة الأخطاء البشرية وفظائع الذكاء الاصطناعي والتقنيات الروبوتية أمر مثير للقلق ، فإن هذه الأدوات نفسها يمكن أن تساعدنا على اكتشاف قيودنا والتغلب عليها وجعل حياتنا اليومية أكثر أمانًا وأكثر إنتاجية وأكثر متعة.Source: https://habr.com/ru/post/ar398621/

All Articles