يبدو أن عصر حوسبة GPU قد وصل! أداء إنتل سيئ. إذا لم تكن قد قرأت مدونتي بانتظام في السنوات القليلة الماضية ، فسأوضح أنني [

أليكس سانت جون ]

وقفت في أصول فريق DirectX الأصلي في Microsoft في عام 1994 ، وأنشأت واجهة برمجة تطبيقات Direct3D جنبًا إلى جنب مع منشئي

DirectX الآخرين (Craig Eisler و Eric Engstrom) وساهم في توزيعه في صناعة ألعاب الفيديو وبين مصنعي شرائح الرسوم البيانية. حول هذا الموضوع في

مدونتي ، يمكنك العثور على العديد من القصص ، ولكن القصة المتعلقة مباشرة بهذه المشاركة ، كتبت في عام 2013.

تاريخ نفيديا

أعتقد أن إصدار ألعاب Nvidia المستقبلية صحيح ، وأنا أستمتع حقًا بالعيش في عصر يمكنني فيه العمل مع قدرات الكمبيوتر الرائعة. يبدو لي أنني عشت حقبة يمكنني فيها المشي على طول جسر Enterprise واللعب بمحرك الالتواء. وبشكل حرفي - تطلق Nvidia على الاعوجاج الحد الأدنى من العمليات المتوازية التي يمكن تشغيلها على GPU.

ربما لاحظ أولئك الذين يتبعون أسعار الأسهم أن أسهم نفيديا ارتفعت مؤخرًا بشكل حاد بعد سنوات عديدة من التسلق البطيء. يبدو لي أن هذا الإنجاز المفاجئ يعلن عن تحول ثوري في الحوسبة الحاسوبية ، يمثل تتويجا لسنوات عديدة من التقدم في تطوير

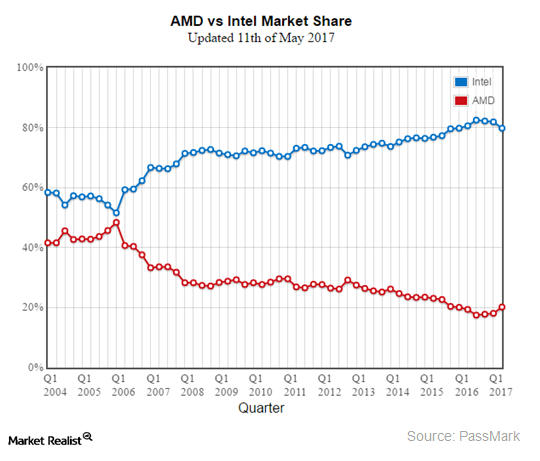

GPGPU . حتى يومنا هذا ، حافظت Intel على احتكار الحوسبة في السوق الصناعية ، وصدت بنجاح هجمات المنافسين على تفوقهم في الحوسبة الصناعية. انتهت هذه الهيمنة هذا العام ، والسوق يراها تقترب. لفهم ما يحدث ولماذا يحدث هذا ، سأعود إلى السنوات الأولى في Microsoft.

في التسعينات ، صاغ بيل جيتس مصطلح "التعاون" [Cooperatition = المنافسة + التعاون] لوصف الشراكات التنافسية المعذبة مع قادة صناعة التكنولوجيا الآخرين في ذلك الوقت. عند الحديث عن Intel ، ظهر المصطلح بشكل خاص في كثير من الأحيان. وبينما تتشابك مصائر ونجاح مايكروسوفت وإنتل أكثر فأكثر ، فإن الشركتين تنافسان باستمرار من أجل الهيمنة. كان لدى كلتا الشركتين فرق من الأشخاص "المتخصصين" في محاولة اكتساب ميزة على منافسيهم. كان بول ماريتز ، الذي كان الرئيس التنفيذي لشركة مايكروسوفت آنذاك ، قلقًا للغاية من أن Intel قد تحاول محاكاة Windows افتراضيًا ، مما يسمح للعديد من أنظمة التشغيل المتنافسة الأخرى بدخول السوق والتواجد على جهاز كمبيوتر سطح المكتب بالتوازي مع Windows. ومن المثير للاهتمام أن بول ماريتز أصبح فيما بعد الرئيس التنفيذي لشركة VMWARE. في الواقع ، استثمرت إنتل بنشاط في مثل هذه المحاولات. كانت إحدى إستراتيجياتهم محاولة لمحاكاة جميع وظائف الحديد المقبولة عمومًا على مستوى البرامج ، والتي كانت الشركات المصنعة للمعدات الأصلية توفر بها أجهزة الكمبيوتر - بطاقات الفيديو وأجهزة المودم وبطاقات الصوت ومعدات الشبكة وما إلى ذلك. من خلال نقل جميع الحوسبة الخارجية إلى معالج Intel ، يمكن للشركة تدمير مبيعات ونمو جميع أنظمة الحوسبة البديلة المحتملة التي يمكن أن تنمو بخلاف ذلك ، مما يهدد وحدة المعالجة المركزية Intel. على وجه التحديد ، دفع إعلان Intel لتقنية 3DR في عام 1994 Microsoft إلى إنشاء DirectX.

عملت في فريق Microsoft ، الذي كان مسؤولاً عن التمركز الاستراتيجي للشركة في ضوء التهديدات التنافسية في السوق ، "مجموعة علاقات المطورين" [DRG]. طلبت Intel من Microsoft إرسال ممثل للتحدث في عرض 3DR. بصفتي خبيرًا في الرسومات والرسومات ثلاثية الأبعاد في Microsoft ، تم إرسالي بمهمة خاصة لتقييم التهديد الذي قد تشكله مبادرة إنتل الجديدة المحتملة ولصياغة استراتيجية فعالة للتعامل معها. قررت أن Intel تحاول بالفعل محاكاة الظاهرية لـ Windows ، حيث تحاكي على مستوى البرامج جميع أجهزة معالجة البيانات الممكنة. لقد كتبت اقتراحًا بعنوان "أخذ الترفيه على محمل الجد" ، حيث اقترحت منع محاولات Intel لجعل Windows صغيرًا لإنشاء سوق استهلاكية تنافسية لميزات الأجهزة الجديدة. كنت أرغب في إنشاء مجموعة جديدة من برامج تشغيل Windows التي سمحت للمنافسة الضخمة في سوق الأجهزة ، بحيث يعمل عمل الوسائط الجديدة ، بما في ذلك الصوت وإدخال البيانات والفيديو وتقنيات الشبكة ، إلخ. في سوق ألعاب الكمبيوتر التي نقوم بإنشائها ، اعتمادًا على برامج تشغيل Windows الخاصة بنا. لم تستطع Intel التعامل مع المنافسة في السوق الحرة التي أنشأناها للشركات التي تنتج الحديد الاستهلاكي ، وبالتالي لم تتمكن من إنشاء وحدة معالجة مركزية يمكنها بشكل افتراضي محاكاة جميع الوظائف التي قد يحتاجها المستخدمون. وهكذا ولدت DirectX.

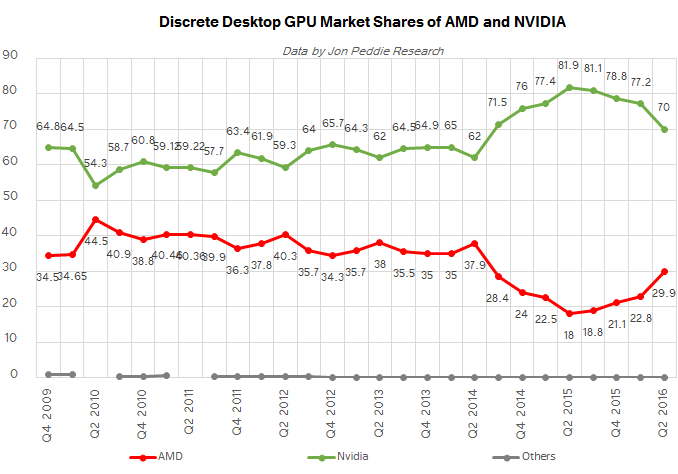

في هذه المدونة ، يمكنك العثور على العديد من القصص حول الأحداث المحيطة بإنشاء DirectX ، ولكن باختصار ، "إستراتيجيتنا الشريرة" كانت ناجحة. أدركت مايكروسوفت أنه من أجل السيطرة على السوق الاستهلاكية واحتواء إنتل ، كان من الضروري التركيز على ألعاب الفيديو ، وبعد ذلك ظهرت العشرات من الشركات المصنعة للرقائق ثلاثية الأبعاد. بعد عشرين عامًا ، من بين العدد الصغير من الناجين ، نفيديا ، مع ATI ، التي استحوذت عليها AMD منذ ذلك الحين ، هيمنت على سوق الرسومات الاستهلاكية ، ومؤخراً سوق الحوسبة الصناعية.

هذا يعيدنا إلى العام الحالي لعام 2017 ، عندما تبدأ وحدة معالجة الجرافيكس أخيرًا في استبدال معالجات x86 بالكامل ، والتي اعتاد الجميع على معالجتها برهبة. لماذا الآن ولماذا GPU؟ كان سر هيمنة x86 هو نجاح Windows والتوافق العكسي مع تعليمات x86 حتى السبعينيات. يمكن لشركة Intel الحفاظ على احتكارها للسوق الصناعي وزيادته نظرًا لحقيقة أن تكلفة نقل التطبيقات إلى وحدة المعالجة المركزية مع أي مجموعة تعليمات أخرى ، لا تشغل أي مكانة في السوق ، كانت مرتفعة للغاية. عززت مجموعة الميزات الهائلة لنظام التشغيل Windows المرتبط بنظام x86 موقع Intel في السوق. جاءت بداية النهاية عندما عجزت Microsoft و Intel معًا عن تحقيق قفزة إلى الهيمنة في سوق الحوسبة المتنقلة الناشئة. لأول مرة منذ عدة عقود ، ظهر صدع في سوق وحدة المعالجة المركزية x86 ، التي تم ملؤها بواسطة معالجات ARM ، وبعد ذلك تمكن نظام التشغيل Windows البديل الجديد من Apple و Google من الحصول على سوق جديد. لماذا فشلت Microsoft و Intel في تحقيق هذه القفزة؟ يمكنك العثور على سيارة لأسباب مثيرة للاهتمام ، ولكن في إطار هذه المقالة أود أن أؤكد على شيء واحد - الأمتعة المتوافقة مع x86. لأول مرة ، أصبحت كفاءة الطاقة أكثر أهمية لنجاح وحدة المعالجة المركزية من السرعة. أصبحت جميع الترانزستورات وجميع الملايين من أسطر التعليمات البرمجية لـ x86 المضمنة بواسطة Intel و Microsoft في أجهزة الكمبيوتر حواجز أمام كفاءة الطاقة. أصبح أهم جانب من هيمنة السوق لشركة إنتل ومايكروسوفت في وقت ما عائقا.

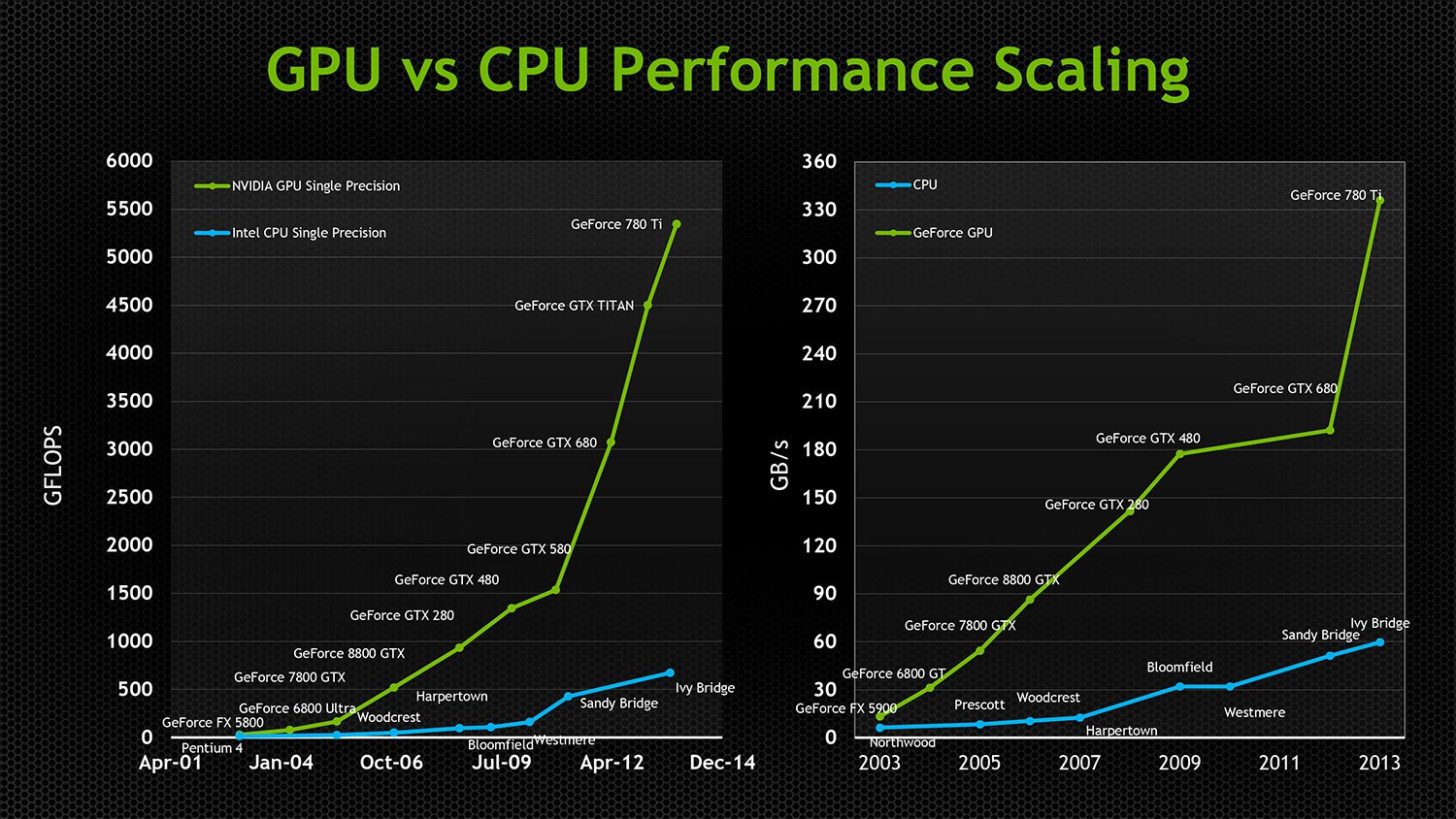

أجبرت حاجة Intel إلى زيادة مستمرة في السرعة ودعم التوافق العكسي الشركة على إنفاق المزيد والمزيد من الترانزستورات المتعطشة للطاقة للحصول على مكاسب سريعة في تناقص السرعة في كل جيل جديد من معالجات x86. كما أعاق التوافق مع الإصدارات السابقة بشكل خطير قدرة Intel على موازاة رقائقها. ظهرت أول وحدة معالجة رسومات متوازية في التسعينيات ، وتم إصدار أول معالجات Intel ثنائية النواة في عام 2005 فقط. حتى اليوم ، يمكن لأقوى وحدة المعالجة المركزية من Intel التعامل مع 24 مركزًا فقط ، على الرغم من أن معظم بطاقات الرسومات الحديثة تحتوي على معالجات تحتوي على آلاف النوى. لم تحمل وحدات معالجة الرسومات التي كانت متوازية في الأصل أمتعة التوافق العكسي ، وبفضل التقنيات المستقلة عن الهندسة المعمارية ، كانت واجهات برمجة التطبيقات مثل Direct3D و OpenGL مجانية للابتكار وزيادة التوازي دون الحاجة إلى التنازل عن التوافق أو كفاءة الترانزستور. بحلول عام 2005 ، أصبحت وحدات معالجة الرسومات حتى منصات حوسبة للأغراض العامة تدعم الحوسبة المتوازية للأغراض العامة غير المتجانسة. من خلال عدم التجانس ، أعني أن الرقائق من AMD و NVIDIA يمكنها تشغيل نفس البرامج المجمعة ، على الرغم من اختلاف البنية منخفضة المستوى ومجموعة التعليمات تمامًا. وفي الوقت الذي كانت فيه رقائق Intel تحقق انخفاضًا في الأداء ، ضاعف GPU سرعته كل 12 شهرًا ، مع تقليل استهلاك الطاقة إلى النصف! جعل التوازي المتطرف من الممكن استخدام الترانزستورات بكفاءة عالية ، مما يوفر لكل ترانزستور متتابع مضاف إلى GPU القدرة على التأثير بفعالية على سرعة التشغيل ، في حين أن العدد المتزايد من الترانزستورات x86 التي تنمو في العدد لم تكن مشغولة.

على الرغم من أن وحدات معالجة الرسومات كانت تغزو بشكل متزايد الحواسيب العملاقة الصناعية والوسائط و VDIs ، فقد جاء التحول الرئيسي في السوق عندما بدأت Google في استخدام وحدات معالجة الرسومات بشكل فعال لتدريب الشبكات العصبية القادرة على أشياء مفيدة جدًا. أدرك السوق أن الذكاء الاصطناعي سيكون مستقبل معالجة البيانات الضخمة وفتح أسواق أتمتة جديدة ضخمة. كانت وحدات معالجة الرسومات مناسبة بشكل مثالي لدعم الشبكات العصبية. حتى هذه اللحظة ، اعتمدت إنتل بنجاح على نهجين أوقفوا التأثير المتزايد لوحدة معالجة الرسومات على الحوسبة الصناعية.

1. حافظت Intel على سرعة ناقل PCI وقيدت عدد مسارات الإدخال / الإخراج التي يدعمها معالجها ، مما يضمن أن وحدات معالجة الرسومات ستعتمد دائمًا على معالجات Intel في معالجة حمولتها وستبقى منفصلة عن مختلف تطبيقات الحوسبة عالية القيمة في الوقت الحقيقي من بسبب التأخير وقيود النطاق الترددي PCI. بينما كانت وحدة المعالجة المركزية الخاصة بهم قادرة على الحد من وصول التطبيقات إلى سرعة GPU ، عانت Nvidia من هذا الطرف من ناقل PCI دون الوصول إلى العديد من الأحمال الصناعية المفيدة عمليًا.

2. توفير وحدة معالجة رسومات رخيصة مع الحد الأدنى من الوظائف على معالج المستهلك لعزل Nvidia و AMD من سوق الألعاب المتميز ومن القبول العام من قبل السوق.

أجبر التهديد المتزايد من محاولات نفيديا وإنتل الفاشلة لإنشاء مسرعات حواسيب عملاقة متوافقة مع x86 إنتل على اختيار تكتيك مختلف. لقد حصلوا على Altera ويريدون تضمين FPGAs قابلة للبرمجة في الجيل التالي من معالجات Intel. هذه طريقة صعبة للتأكد من أن معالج Intel يدعم إمكانات إدخال / إخراج أكبر مقارنة بأجهزة ناقل PCI المحدودة للمنافسين ، وأن GPU لا تحصل على أي مزايا. سمح دعم FPGAs لشركة Intel بالسير في اتجاه دعم الحوسبة المتوازية على رقائقها ، دون الدخول في بوابات السوق المتنامية للتطبيقات التي تستخدم وحدات معالجة الرسومات. كما سمح لمصنعي أجهزة الكمبيوتر الصناعية بإنشاء أجهزة متخصصة للغاية ، لا تزال تعتمد على x86. كانت هذه خطوة رائعة من جانب شركة Intel ، حيث استبعدت إمكانية دخول GPU إلى السوق الصناعية في عدة اتجاهات في وقت واحد. رائعة ، لكنها على الأرجح محكوم عليها بالفشل.

تشرح خمس قصص إخبارية متتالية سبب أنا متأكد من أن حزب x86 سينتهي في عام 2017.

1.

يحصل صندوق VisionFund من SoftBank على استثمار بقيمة 93 مليار دولار من الشركات الراغبة في استبدال Intel2.

اشترى SoftBank ARM Holdings مقابل 32 مليار دولار3.

اشترى SoftBank أسهم Nvidia مقابل 4 مليارات دولار4. تطلق Nvidia

Project Denver [الاسم الرمزي للمعمارية الدقيقة Nvidia التي تنفذ مجموعة التعليمات ARMv8-A 64/32 بت باستخدام مزيج من وحدة فك ترميز الأجهزة البسيطة ومترجم ثنائي البرامج مع إعادة التحويل الديناميكي / تقريبًا. perev.]

5.

أعلنت NVIDIA عن Xavier

Tegra SOC مع وحدة معالجة

رسومات Volta مع 7 مليارات ترانزستورات و 512 CUDA Cores و 8 ARM64 Custom Cores - شريحة ARM / Hybrid متنقلة مع نوى ARM تسارع GPU.

لماذا هذا التسلسل من الأحداث مهم؟ في هذا العام ، دخل الجيل الأول من وحدات معالجة الرسومات المستقلة السوق في وصول واسع ، وقادر على إطلاق نظام التشغيل الخاص به دون عقبات في شكل PCI. لم تعد نفيديا بحاجة إلى معالج x86. لدى ARM عدد مذهل من أنظمة التشغيل والتطبيقات الاستهلاكية والصناعية التي يتم نقلها إليها. تتحول جميع الأسواق الصناعية والسحابية إلى شرائح من ARM كوحدات تحكم لمجموعة واسعة من حلولها السوقية. تم دمج FPGAs بالفعل في شرائح ARM. تستهلك شرائح ARM طاقة قليلة ، وأقل أداءً ، لكن وحدات معالجة الرسوم (GPU) سريعة وفعالة للغاية ، لذا يمكن لوحدات معالجة الرسومات (GPU) توفير طاقة المعالج ، ويمكن لنوى ARM التعامل مع عمليات IO و UI المملّة التي لا تتطلب طاقة معالجة. لم يعد عدد متزايد من التطبيقات التي تعمل بالبيانات الضخمة والحوسبة عالية الأداء والتعلم الآلي بحاجة إلى Windows ، ولا تعمل على x86. 2017 هو العام الذي تكسر فيه نفيديا المقود وتصبح بديلاً تنافسيًا قابلاً للتطبيق حقًا للحوسبة الصناعية المستندة إلى x86 في أسواق جديدة قيّمة غير مناسبة للحلول المستندة إلى x86.

إذا لم يكن معالج ARM قويًا بما يكفي لاحتياجاتك ، فإن

IBM ، بالتعاون مع Nvidia ، ستنتج جيلًا جديدًا من وحدات المعالجة المركزية Power9 لمعالجة البيانات الكبيرة التي تعمل مع 160 ممر PCIe.

تطلق AMD أيضًا وحدة المعالجة المركزية Ryzen الجديدة

تطلق AMD أيضًا وحدة المعالجة المركزية Ryzen الجديدة ، وعلى عكس Intel ، ليس لدى AMD مصلحة استراتيجية في خنق أداء PCI. تدعم رقائق المستهلكين الخاصة بهم 64 حارة PCIe 3.0 ، وتدعم الرقائق الاحترافية 128. كما تطلق AMD أيضًا مترجمًا جديدًا عبر HIP يجعل تطبيقات CUDA متوافقة مع وحدات معالجة الرسوميات AMD. على الرغم من حقيقة أن هاتين الشركتين تتنافسان مع بعضهما البعض ، سيستفيد كلاهما من إزاحة Intel في السوق الصناعية بأساليب بديلة لحوسبة GPU.

كل هذا يعني أنه في السنوات القادمة ، ستلتقط الحلول المستندة إلى GPU الحوسبة الصناعية بسرعة متزايدة ، وسيعتمد عالم واجهات سطح المكتب بشكل متزايد على التصور السحابي أو العمل على معالجات ARM المحمولة ، حيث

أعلنت حتى

Microsoft دعم ARM .

عند وضع كل ذلك معًا ، أتوقع أنه في غضون بضع سنوات لن نسمع إلا عن المعركة بين GPU و FPGA للحصول على ميزة في الحوسبة الصناعية ، بينما سينتهي عصر وحدة المعالجة المركزية تدريجيًا.