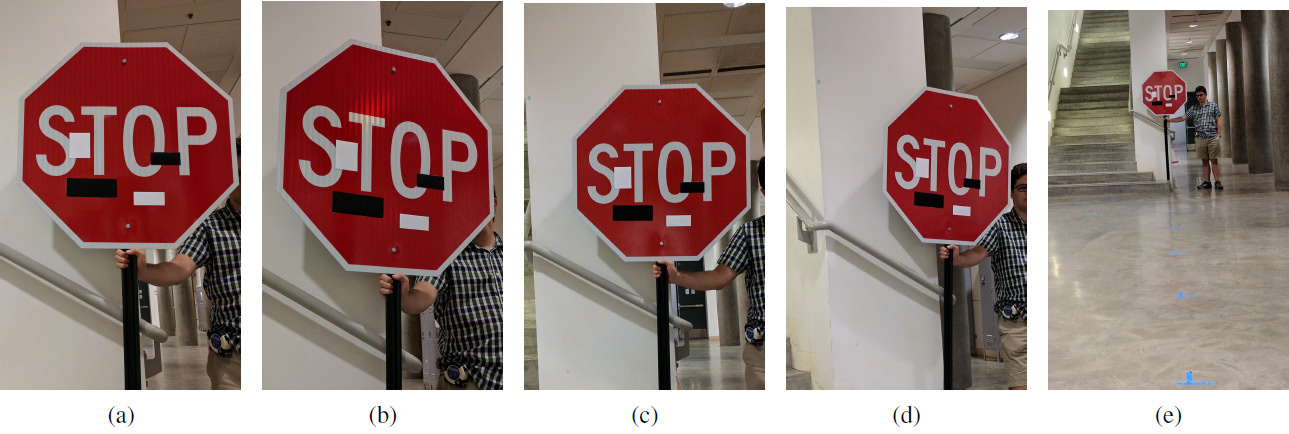

مجموعة من الصور التجريبية مع ملصقات فنية على مسافات مختلفة وزوايا مختلفة: (أ) 5 أقدام ، 0 درجة ؛ (ب) 5'15 درجة ؛ (ج) 10 ° 0 ° ؛ (د) 10-30 درجة ؛ (هـ) 40 ° 0 °. يعمل الغش على أي مسافة وبأي زاوية: بدلاً من علامة التوقف ، يرى نظام التعلم الآلي لافتة "حد السرعة 45 ميلاً"

مجموعة من الصور التجريبية مع ملصقات فنية على مسافات مختلفة وزوايا مختلفة: (أ) 5 أقدام ، 0 درجة ؛ (ب) 5'15 درجة ؛ (ج) 10 ° 0 ° ؛ (د) 10-30 درجة ؛ (هـ) 40 ° 0 °. يعمل الغش على أي مسافة وبأي زاوية: بدلاً من علامة التوقف ، يرى نظام التعلم الآلي لافتة "حد السرعة 45 ميلاً"بينما يعمل بعض العلماء على تحسين أنظمة التعلم الآلي ، يعمل علماء آخرون على تحسين طرق خداع هذه الأنظمة.

كما تعلم ، يمكن للتغييرات المستهدفة الصغيرة في الصورة "كسر" نظام التعلم الآلي ، بحيث يتعرف على صورة مختلفة تمامًا. تسمى صور "حصان طروادة" "الأمثلة العدائية" وتمثل أحد

القيود المعروفة

للتعلم العميق .

لإنشاء مثال تنافسي ، تحتاج إلى زيادة التنشيط ، على سبيل المثال ، لمرشح شبكة عصبية تلافيفية معينة. طور إيفان يفتيموف من جامعة واشنطن ، إلى جانب زملاء من جامعة كاليفورنيا في بيركلي ، وجامعة ميشيغان وجامعة نيويورك في ستوني بروك ، خوارزمية هجوم جديدة -

اضطرابات جسدية قوية (

اضطرابات جسدية قوية أو RP

2 ). يلتقط بشكل فعال للغاية رؤية المركبات غير المأهولة والروبوتات وكوادكوبتر وأي أنظمة روبوتية أخرى تحاول التنقل في الفضاء المحيط.

على عكس الدراسات السابقة ، ركز المؤلفون هنا على تغيير الأشياء نفسها مباشرة ، بدلاً من الخلفية. كانت مهمة الباحثين هي العثور على أصغر دلتا ممكنة من شأنها أن تهدم المصنف لنظام التعلم الآلي ، والذي تم تدريبه على

مجموعة بيانات تحتوي على صور لافتات الطرق LISA . التقط المؤلفون بشكل مستقل عددًا من الصور الفوتوغرافية لعلامات الطريق في الشارع في ظروف مختلفة (المسافة والزوايا والإضاءة) واستكملوا مجموعة بيانات LISA للتدريب.

بعد حساب مثل هذا الدلتا ، تم الكشف عن قناع - مكان (أو عدة أماكن) في الصورة يتسبب بشكل أكثر موثوقية في حدوث اضطرابات في نظام التعلم الآلي (رؤية الآلة). تم إجراء سلسلة من التجارب للتحقق من النتائج. تم إجراء التجارب بشكل رئيسي على إشارة توقف (علامة "STOP") ، والتي حولها الباحثون بعدة تلاعبات غير ضارة للرؤية الآلية إلى علامة "SPEED LIMIT 45". يمكن استخدام التقنية المطورة على أي علامات أخرى. ثم قام المؤلفون باختباره عند إشارة الدوران.

طور فريق البحث نوعين من الهجمات على أنظمة رؤية الجهاز التي تتعرف على إشارات المرور. الهجوم الأول هو تغييرات صغيرة غير محسوسة على كامل منطقة اللافتة. باستخدام محسن آدم ، تمكنوا من تقليل القناع لإنشاء أمثلة منفصلة ومستهدفة وتنافسية تستهدف علامات طريق معينة. في هذه الحالة ، يمكن خداع أنظمة تعلُّم الآلة بأقل تغييرات في الصورة ، ولن يلاحظ الأشخاص أي شيء على الإطلاق. تم اختبار فعالية هذا النوع من الهجوم على الملصقات المطبوعة مع تغييرات طفيفة (في البداية ، كان الباحثون مقتنعين بأن نظام رؤية الآلة يتعرف بنجاح على الملصقات دون تغييرات).

النوع الثاني من الهجوم هو التمويه. هنا ، يقلد النظام إما أعمال التخريب أو الكتابة على الجدران الفنية بحيث لا يتداخل النظام مع حياة من حوله. وبالتالي ، سيرى السائق على الفور إشارة الانعطاف اليسرى أو ضوء الفرامل ، وسوف يرى الروبوت علامة مختلفة تمامًا. تم اختبار فعالية هذا النوع من الهجوم على لافتات الطرق الحقيقية ، التي كانت مختومة بالملصقات. يتكون التمويه على الجدران من ملصقات على شكل كلمات الحب والكراهية ، والتمويه مثل الفن التجريدي - من أربعة ملصقات على شكل مستطيل باللونين الأبيض والأسود.

تظهر نتائج التجربة في الجدول. في جميع الحالات ، تظهر فعالية الغش لمصنف التعلم الآلي ، والذي يتعرف على علامة "STOP" المعدلة كعلامة "SPEED LIMIT 45". المسافة بالقدم ، وزاوية الدوران بالدرجات. يُظهر العمود الثاني الفصل الثاني ، الذي يظهر في نظام التعلم الآلي في علامة معدلة. على سبيل المثال ، من مسافة 5 أقدام (152.4 سم) ، ينتج التمويه مثل الفن التجريدي بزاوية 0 درجة النتائج التالية للتعرف على علامة "STOP": مع ثقة بنسبة 64 ٪ ، يتم التعرف عليها كعلامة "SPEED LIMIT 45" وبثقة بنسبة 11٪ - كما علامة لين ينتهي.

وسيلة إيضاح: SL45 = حد السرعة 45 ، STP = توقف ، YLD = عائد ، ADL = حارة مضافة ، SA = إشارة إلى الأمام ، LE = حارات تنتهي

وسيلة إيضاح: SL45 = حد السرعة 45 ، STP = توقف ، YLD = عائد ، ADL = حارة مضافة ، SA = إشارة إلى الأمام ، LE = حارات تنتهيربما يحتاج هذا النظام (مع التغييرات المقابلة) إلى البشرية في المستقبل ، والآن يمكن استخدامه لاختبار أنظمة غير مكتملة للتعلم الآلي ورؤية الكمبيوتر.

تم

نشر العمل العلمي في 27 يوليو 2017 على موقع ما قبل الطباعة arXiv.org (arXiv: 1707.08945).