اختار محررو قاموس أكسفورد كلمة "ما بعد الحقيقة" على

أنها كلمة "

2016 ". يصف هذا المصطلح الظروف التي تكون فيها الحقائق الموضوعية أقل أهمية لتكوين الرأي العام من جاذبية المشاعر والمعتقدات الشخصية.

لوحظ تواتر مرتفع بشكل خاص لاستخدام هذه الكلمة في المنشورات باللغة الإنجليزية بعد الانتخابات الرئاسية الأمريكية فيما يتعلق بنشر عدد كبير من الأخبار المزيفة ، وبعد ذلك لم تكن الحقيقة نفسها مهمة.

وفقا لبعض المحللين ، كان انتشار الأخبار التشهيرية المزيفة أحد أسباب هزيمة هيلاري كلينتون في الانتخابات.

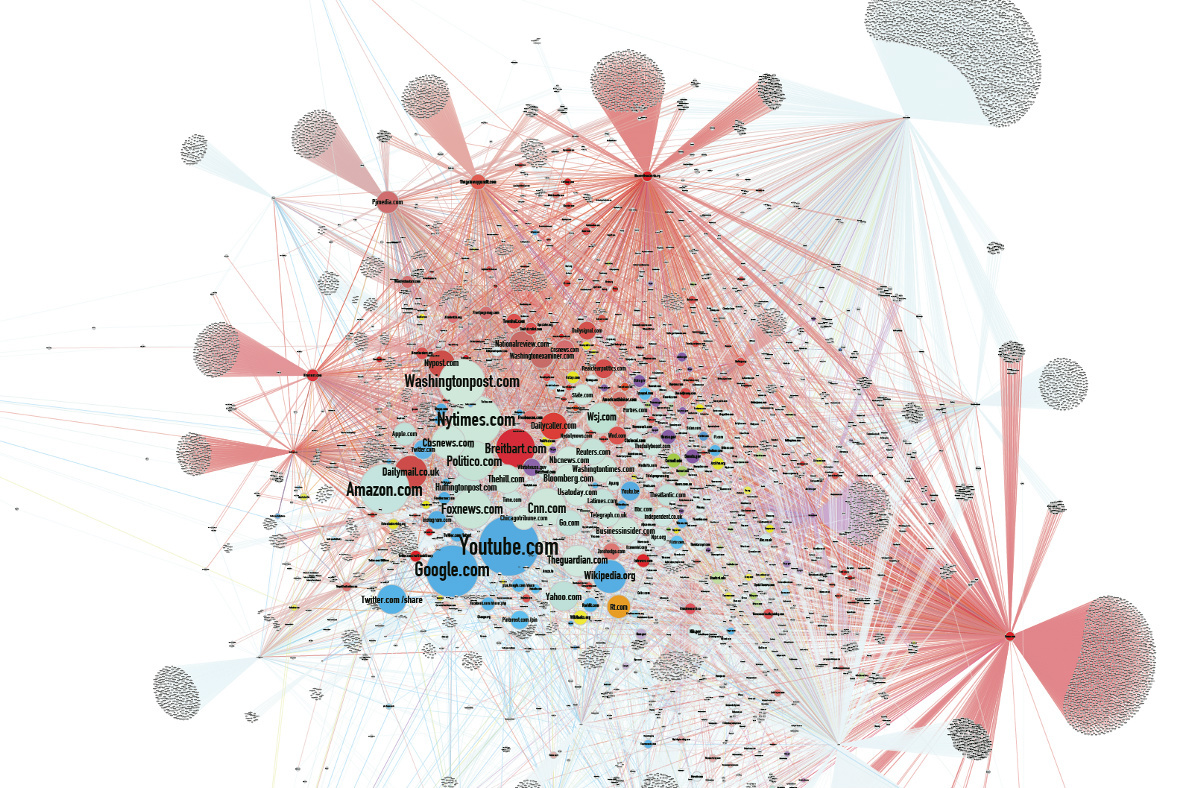

أصبح حساب الخوارزمية Facebook أحد المصادر الرئيسية للأخبار الكاذبة.

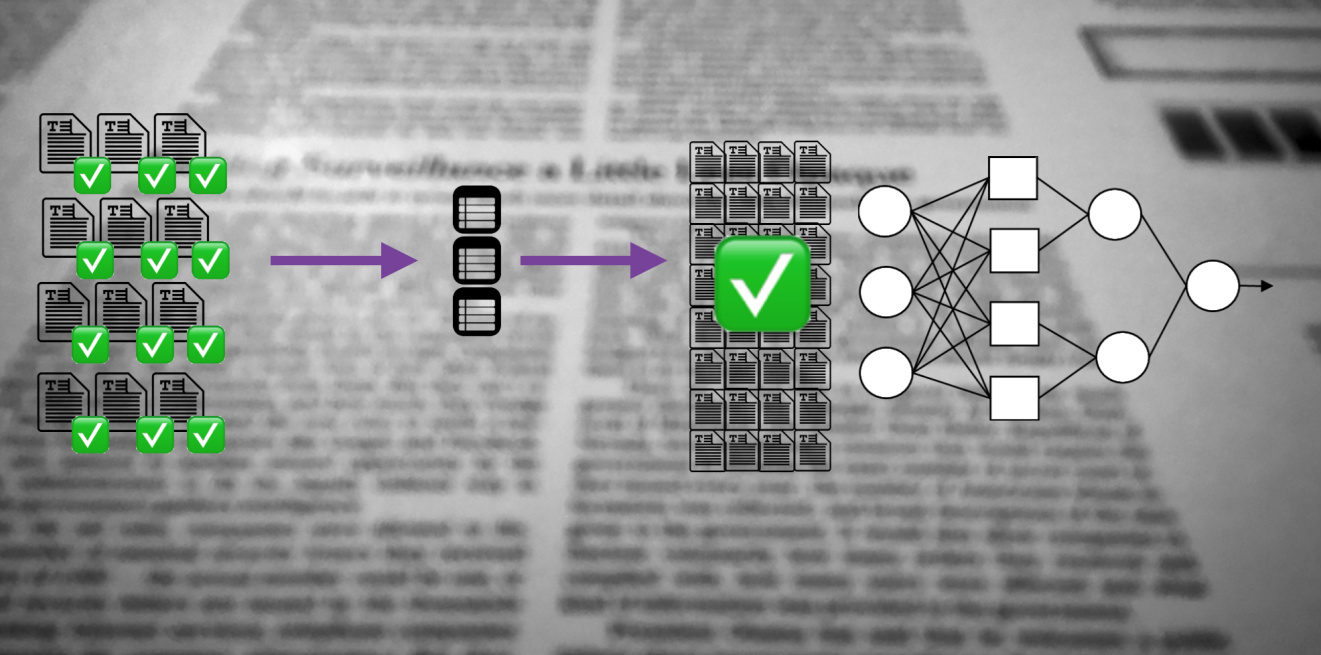

على هذه الخلفية ، لم يلاحظ الكثير من الأخبار من المطورين في مجال الذكاء الاصطناعي. لقد اعتدنا بالفعل على حقيقة أن الشبكات العصبية ترسم الصور ، وتخلق صورة لشخص وفقًا لوصفه اللفظي ، وتنتج الموسيقى. إنهم يفعلون المزيد والمزيد ، وفي كل مرة يقومون بعمل أفضل. لكن الشيء الأكثر إثارة للاهتمام هو أن الآلات تعلمت صنع منتجات مزيفة.

تأثير التزييف

خلال السباق الانتخابي الأمريكي ، تجاوز عدد نشرات الأخبار المزيفة على الشبكات الاجتماعية عدد إعادة نشر الرسائل الصادقة ، لأن المزيفة كانت أكثر تماشيًا مع التوقعات أو كانت أكثر إثارة. بعد الانتخابات ، استعان Facebook بجهات تدقيق حقيقة مستقلة للإبلاغ عن الرسائل التي لم يتم التحقق منها لتنبيه المستخدمين.

إن الجمع بين الاستقطاب السياسي المتزايد للمجتمع والميل إلى قراءة العناوين بشكل رئيسي يعطي تأثيرًا تراكميًا. غالبًا ما يتم نشر الأخبار المزيفة من خلال مواقع الأخبار المزيفة ، والتي غالبًا ما تقع المعلومات في وسائل الإعلام السائدة ، والتي تسعى إلى جذب زيارات المستخدمين. ولا شيء يجذب حركة المرور مثل عنوان جذاب.

ولكن في الواقع ، لا يقتصر تأثير المنتجات المزيفة على المجال السياسي وحده. هناك العديد من الأمثلة التي توضح تأثير الأخبار الكاذبة على المجتمع.

تطلق شركة إنتاج فيديو أسترالية مقاطع فيديو

فيروسية وهمية لمدة عامين ، حيث اكتسبت مئات الملايين من المشاهدات.

في

زيف مدروس جيدًا عن ستالين ، الذي زُعم أن وجهه ظهر في مترو موسكو ، اعتقدوا حتى في 1 أبريل.

في عام 1992 ، بدأ المليونير إيليا ميدكوف في دفع أجور وكالات الأنباء الكبرى في روسيا وكومنولث الدول المستقلة (بما في ذلك RIA Novosti و Interfax و ITAR-TASS). أصدرت ITAR-TASS رسالة

كاذبة لوسائل الإعلام حول الحادث الذي وقع في لينينغراد NPP في يناير 1993. ونتيجة لذلك ، انخفضت أسعار أسهم الشركات الاسكندنافية الرائدة ، وقبل ظهور النقض الإعلامي ، اشترى وكلاء Medkov الأسهم الأكثر ربحية من الشركات السويدية والفنلندية والنرويجية.

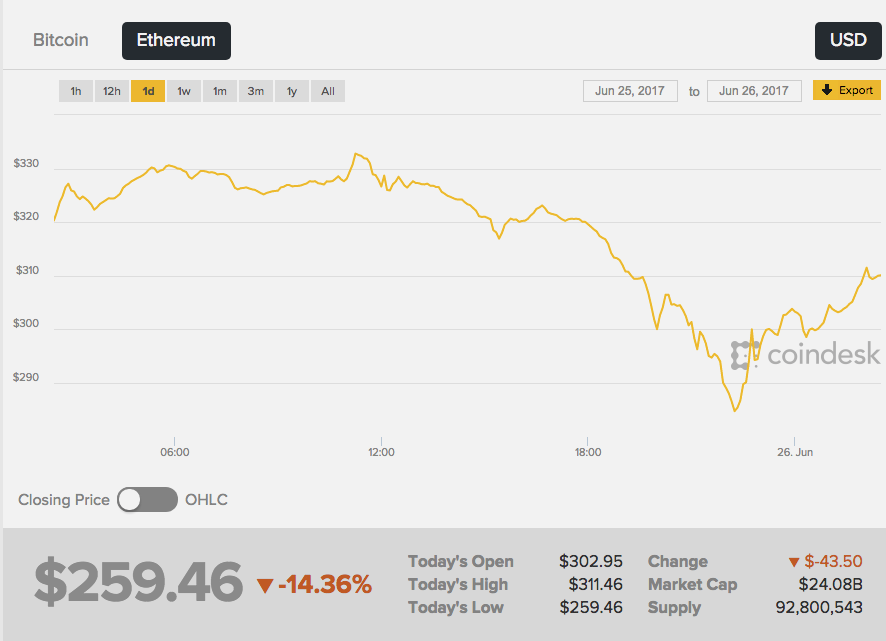

في 26 يونيو 2017 ، انخفض معدل الرسملة الثانية لعملة Ethereum بشكل حاد - تفاعل السوق مع الشائعات التي ظهرت على الشبكة حول الوفاة المأساوية لخالق Ether ، Vitaliy Buterin. علاوة على ذلك ، ظهرت "الأخبار العاجلة" الأولى على لوحة صورة 4chan المجهولة - وهذا المصدر ، بصراحة ، ليس هو الأكثر موثوقية.

كتبت ويكيبيديا أن "فيتاليك

كان مبرمجًا روسيًا" ، ثم التقطت الصحافة الصفراء الأخبار. ونتيجة لذلك ،

انخفض معدل الأثير بنسبة 13 ٪ ، من حوالي 289 دولارًا إلى 252 دولارًا. بدأت الدورة في النمو مباشرة بعد رفض الأخبار من فيتالي نفسه.

لا يوجد دليل على أن شخصًا ما عمدا خلق مزيفًا للربح على الفرق في أسعار العملات الرقمية. لا جدال في أن الأخبار الخيالية التي ليس لها حقيقة مؤكدة لها تأثير قوي على الناس.

تقليد الواقع

ستكرر المغنية الفرنسية فرانسواز أردي في الفيديو خطاب كيليان كونواي ، مستشارة الرئيس الأمريكي دونالد ترامب ، الذي اشتهر بعد حديثه عن "حقائق بديلة". المثير للاهتمام هنا هو أن أردي تبلغ من العمر 73 عامًا بالفعل ، وفي الفيديو تبدو وكأنها تبلغ من العمر 20 عامًا.

تم

إنشاء وجه الأسطوانة البديلة v1.1 من

قبل الفنان الألماني ماريو كلينجمان. أخذ مقابلات كونواي الصوتية ومقاطع الفيديو الموسيقية القديمة لأردي. ثم استخدم شبكة عصبية مولدة (GAN) ، والتي صنعت محتوى فيديو فريدًا من العديد من إطارات مقاطع مختلفة من المغني ، وتراكب على مسار صوتي مع تعليقات كونواي.

في هذه الحالة ، من السهل التعرف على المزيف ، ولكن يمكنك الذهاب إلى أبعد من ذلك - إجراء تغييرات على الملف الصوتي. سيؤمن الناس بالصورة والتسجيل الصوتي عن طيب خاطر أكثر من مجرد نص. لكن كيف تزييف صوت الإنسان؟

أنظمة GAN قادرة على دراسة الخصائص الإحصائية للتسجيلات الصوتية ، ثم إعادة إنتاجها في سياق مختلف دقيق عن المللي ثانية. يكفي إدخال النص الذي يجب أن تتكاثر فيه الشبكة العصبية ، وستحصل على بيان معقول.

نشرت الشركة الناشئة الكندية Lyrebird خوارزميات خاصة بها يمكنها محاكاة صوت أي شخص بناءً على ملف صوتي مدته دقيقة واحدة. ولإثبات الإمكانيات ،

نشرت الشركة

محادثة بين أوباما وترامب وكلينتون - جميع الأبطال بالطبع مزيفون.

يعمل DeepMind و Baidu Institute for Deep Learning و Montreal Institute for the Algorithms (MILA) بالفعل على خوارزميات تحويل النص إلى كلام واقعية للغاية.

والنتيجة ليست مثالية بعد ، يمكنك تمييز الصوت المعاد إنشاؤه عن الأصل بسرعة ، ولكن التشابه محسوس. بالإضافة إلى ذلك ، في الشبكة ، تغير الشبكة العواطف ، وتضيف الغضب أو الحزن اعتمادًا على الموقف.

توليد الصور

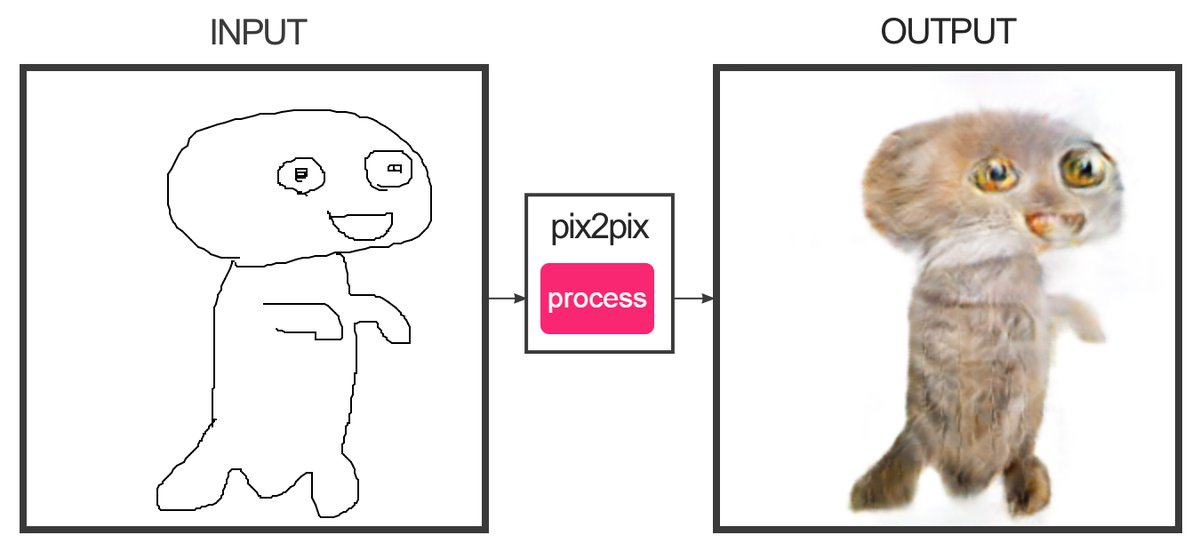

ابتكر المطور كريستوفر هيس

خدمة ، بمساعدة التعلم الآلي ، يمكنها "رسم" الرسومات التي تتكون من عدة خطوط للصور الملونة. نعم ، هذا هو الموقع الذي يرسم القطط. تتحول الأختام إلى حد ما - من الصعب الخلط بينها وبين الأختام الحقيقية.

كان المبرمج Alexa Jolikier Martino قادرًا على

صنع قطط تشبه

القطط تمامًا. للقيام بذلك ، استخدم DCGAN - شبكات الخصومة التوليفية التوليفية العميقة (الشبكات التنافسية التلافيفية التوليدية العميقة). DCGANs قادرة على إنشاء صور واقعية فريدة من نوعها من خلال الجمع بين شبكتين عصبية عميقة تتنافس مع بعضها البعض.

تتلقى الشبكة الأولى (توليد) قيم المتغيرات عند الإدخال ، وفي المخرج تعطي قيم وظيفة هذه المتغيرات ، والتي يجب أن "تقنع" الشبكة الثانية (التمييز أو التمييز) أن نتائج الشبكة الأولى لا يمكن تمييزها عن المعيار. كعينات في عمل جوليكر مارتينو ، تم استخدام قاعدة بيانات لعشرة آلاف صورة قطط.

باستخدام طرق DCGAN ، من الممكن إنشاء صور مزيفة لا يمكن اعتبارها موضوعية مزيفة بدون شبكة عصبية أخرى.

تركيبات المحتوى

في جامعة واشنطن ،

طوروا خوارزمية تسمح لك بتراكب الصوت على فيديو شخص بمزامنة دقيقة للشفة. تم تدريب الخوارزمية على 17 ساعة من رسائل فيديو باراك أوباما. تم تدريب الشبكة العصبية على محاكاة حركات شفاه أوباما بطريقة لتصحيح حركاتهم عن طريق تقليد نطق الكلمات الصحيحة. حتى الآن ، يمكنك فقط إنشاء فيديو بالكلمات التي قالها الشخص حقًا.

انظر الآن إلى عملية الخوارزمية ، التي

تسمح لك بتغيير تعابير الوجه لشخص آخر على الطاير إلى تعابير وجهك. في الفيديو مع ترامب (لا يزال هناك عرض حول بوش وبوتين وأوباما) ، يتم فرض انحناء الشخص في الاستوديو ، والنتيجة ترامب غاضب. يتم استخدام الخوارزمية في Face2Face. تشبه التكنولوجيا التي تم إنشاؤها من حيث المبدأ روبوت

Smile Vector ، الذي يضيف ابتسامة إلى الأشخاص في الصور.

وبالتالي ، من الممكن الآن إنشاء فيديو واقعي يتحدث فيه شخص مشهور عن حقائق خيالية. يمكن قطع الكلام عن الخطب السابقة لتكوين أي رسالة. ولكن في المستقبل القريب ، حتى هذه الحيل ستصبح غير ضرورية - ستضع الشبكة أي نص في فم شخصية مزيفة بدقة تامة.

العواقب

من وجهة نظر عملية ، تسمح لك كل هذه التقنيات بالقيام بالكثير من الخير. على سبيل المثال ، يمكنك تحسين جودة مؤتمرات الفيديو عن طريق تجميع الإطارات المفقودة في حالة خروجها من دفق الفيديو. وحتى تجميع الكلمات المفقودة بالكامل ، مما يوفر اتصالًا ممتازًا في الأماكن مع أي مستوى إشارة.

سيكون من الممكن "رقمنة" الممثل بالكامل وإضافة نسخة واقعية منه إلى الأفلام والألعاب.

ولكن ماذا سيحدث للأخبار؟

من المرجح أنه في السنوات القادمة ، سيصل الجيل المزيف إلى مستوى جديد. هناك طرق جديدة للقتال. على سبيل المثال ، إذا قمت بربط صورة بظروف معروفة في المنطقة (سرعة الرياح ، وإمالة الظلال ، ومستوى الضوء ، وما إلى ذلك) ، فستساعد هذه البيانات في تحديد صورة مزيفة.

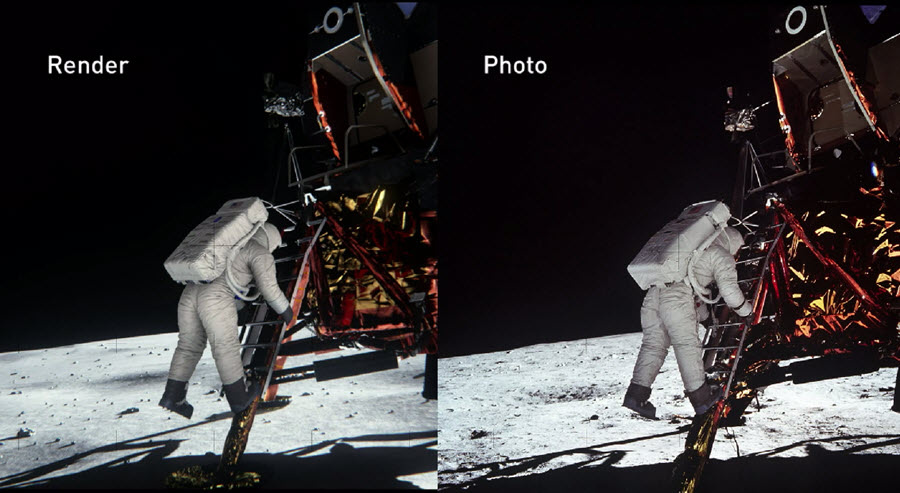

في عام 2014 ، قام مهندسو NVIDIA بإعادة بناء مشهد الهبوط على القمر بأكبر قدر ممكن من الدقة ، بناءً على أدلة وثائقية من ذلك الوقت. في هذه الحالة ، تم أخذ جميع الخصائص الفيزيائية والبصرية للأشياء في الاعتبار لمعرفة كيفية انعكاس الضوء من المواد المختلفة والتصرفات في الوقت الفعلي. ونتيجة لذلك ، تمكنوا من

التحقق بشكل موثوق من صحة صور وكالة ناسا.

أكدت NVIDIA أنه من خلال الإعداد المناسب ، يمكن للمرء أن يثبت صحة (أو دحض) حتى أكثر الصور الفوتوغرافية تعقيدًا التي تم إنشاؤها منذ عقود.

في العام الماضي ، أطلقت الوكالة الأمريكية لأبحاث الدفاع المتقدم (DARPA) مشروعًا مدته أربع سنوات لإنشاء نظام مفتوح

للطب الشرعي لوسائل الإعلام يمكنه تحديد الصور التي تمت معالجتها أو تشويهها بطريقة أو بأخرى.

لن تكون الشبكات العصبية قادرة على تغيير المحتوى الأصلي فحسب ، بل ستتمكن أيضًا من التعرف على أعلى جودة مزيفة. من سيفوز في نهاية المطاف في سباق التكنولوجيا هذا سيظهر الوقت.