رجل الأعمال إيلون موسك ، الذي يرأس العديد من شركات التكنولوجيا المعروفة ، معروف بوجهة نظره حول مخاطر الذكاء الاصطناعي. بالطبع هو مشهور ليس فقط بسبب هذا الرأي. ومع ذلك ، فقد عارض إنشاء شكل قوي من الذكاء الاصطناعي منذ عام 2014. ثم صرح علنا لأول مرة أن الذكاء الاصطناعي يمكن أن يكون خطيرا. يتفق معه ستيفن هوكينج والعديد من العلماء وعلماء المستقبل والمتخصصين في تكنولوجيا المعلومات. ويعتقد أن البشرية كلها قد تقع ضحية التفرد التكنولوجي.

الأخطر ، بحسب ماسك ، هو الميل إلى إنشاء سلاح "ذكي" مستقل. وفقا لرائد الأعمال ، فإن خطر ظهور "الروبوتات القاتلة" مرتفع للغاية ، لذلك من الضروري معالجة هذه المشكلة بكل رعاية ممكنة. "الثورة الثالثة في التسلح" قريبة بالفعل ، الخبراء مقتنعون ، و "الروبوتات القاتلة" المستقلة هي نوع من علب باندورا. لم يتبق سوى وقت قليل لحل المشكلة.

منذ حوالي أسبوع ، وقع موسك ، مع 115 خبيرًا بارزًا من مختلف مجالات العلوم والتكنولوجيا ،

رسالة مفتوحة ، يطلب مؤلفوها من الأمم المتحدة معالجة هذه المشكلة ، في أسرع وقت ممكن.

تم توقيع الرسالة في المؤتمر

الدولي المشترك حول الذكاء الاصطناعي (IJCAI 2017) ، الذي عقد في ملبورن. بالمناسبة ، من بين الموقعين - ومؤسس DeepMind مصطفى سليمان ، وكذلك جيروم مونسي ، رئيس Aldebaran Robotics ، الذي طور الروبوت الفلفل. إذا وقع رؤساء الشركات على رأس التقدم التكنولوجي على هذه الرسالة ، فربما تكون المشكلة جديرة بالنظر.

تنص الرسالة ، على وجه الخصوص ، على أن الذكاء الاصطناعي والروبوتات يتطوران بوتيرة سريعة لدرجة أن احتمال شن حرب بأسلحة مستقلة ، بما في ذلك الروبوتات ، أصبح أكثر احتمالا. علاوة على ذلك ، فهذه مسألة السنوات القادمة ، وليس عقودًا على الإطلاق ، كما كان يُعتقد سابقًا. لذا من الضروري الآن التفكير في كيفية تأثير التكنولوجيا على مصير البشرية. وقبل كل شيء ، يجب على قادة الدول التي تتطور فيها التكنولوجيا بنشاط أكبر قدر ممكن التفكير في هذا الأمر.

يمكن للمرء أن يضيف إلى ذلك خطر وقوع مثل هذه التقنيات في أيدي الإرهابيين والمستبدين الذين ، دون أي ندم ، سيرسلون أدوات مميتة ضد الناس العاديين. حتى إذا كان من الممكن تجنب ذلك ، فلا يزال هناك خطر تهديد أنظمة القرصنة ، وهو غير خالٍ تمامًا. لقد أثبت الهاكرز بشكل متكرر أنه يمكن اختراق كل شيء تقريبًا ، بغض النظر عن مدى حماية "كل شيء".

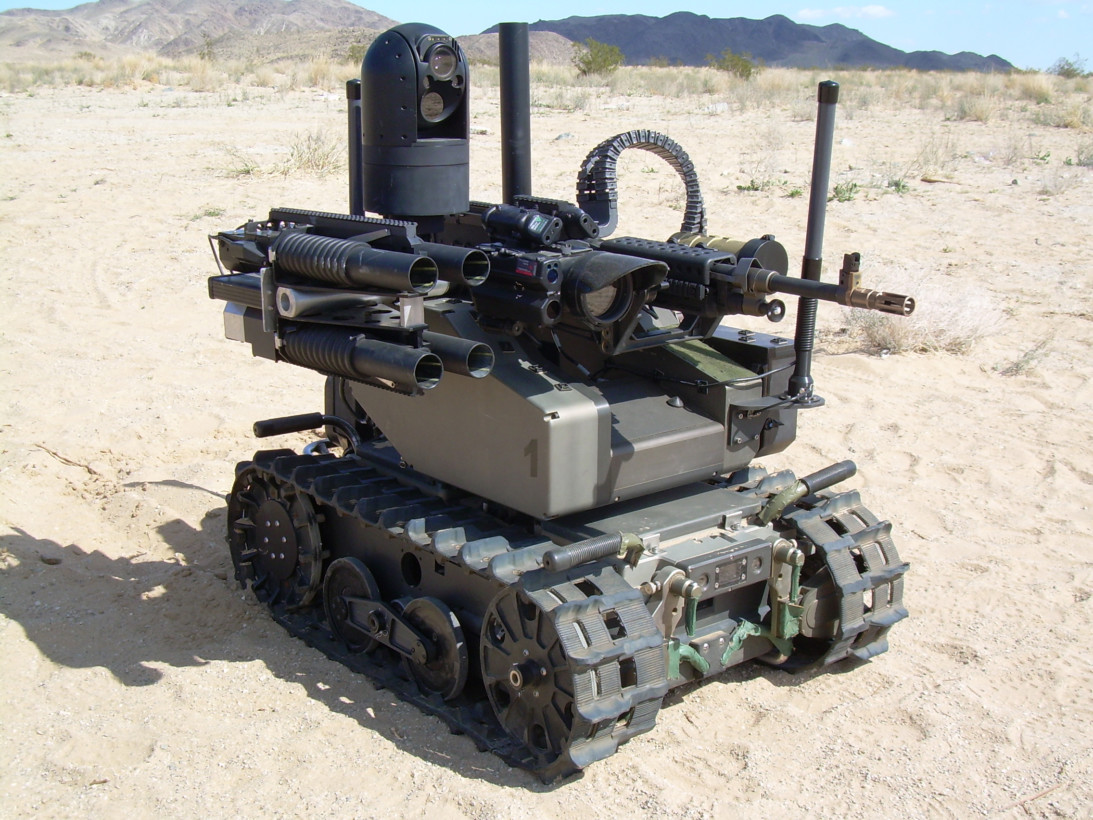

بالفعل ، هناك تطورات للأسلحة الفتاكة التي تعمل في وضع مستقل أو شبه مستقل. من بين أمور أخرى ، هذا مثل هذا الجهاز.

الصورة فقط لتوضيح كيف يمكن تجهيز الأسلحة بأجهزة الروبوت في الحروب المستقبلية. ولكن بالفعل الآن تحلق الطائرات بدون طيار في السماء ، قادرة على العمل في الوضع التلقائي. والسفن مزودة بمدافع أوتوماتيكية تتعقب بشكل مستقل تهديدًا محتملاً.

لا توافق حكومات البلدان المختلفة على وجهة نظر العلماء والتقنيين لأسباب مختلفة. الرئيسي - بالنسبة للدول ، الأسلحة المستقلة - هذا مفيد. يمكن أن تزيد من فعالية حماية الحدود أو تقلل من عدد القتلى من الجنود في حالة النزاعات المحلية أو الإقليمية. لذا ، في عام 2015 ، عارضت حكومة المملكة المتحدة حظر الأسلحة الفتاكة المستقلة. علاوة على ذلك ، فإن تطوير أسلحة من هذا النوع نشط للغاية هنا.

حسنًا ، وجهة نظر العلماء الذين يعارضون "الروبوتات القاتلة" المستقلة موضحة جيدًا في بيان مؤسس Element AI ، جوشوا بينجيو: "لقد وقعت رسالة مفتوحة ، لأن استخدام الذكاء الاصطناعي في أنظمة الأسلحة المستقلة يتعارض مع فهمي للأخلاق ، وكلها يمكن أن تؤدي إلى تصعيد خطير للغاية ، تؤثر على النطاق الكامل لتطوير الذكاء الاصطناعي. يجب أن يؤخذ الوضع تحت سيطرة المجتمع الدولي ، تماما كما تم مع أنواع أخرى من الأسلحة (البيولوجية والكيميائية والنووية) ".

وقالت الرسالة "إن صنع أسلحة ذاتية الحكم القاتلة يسمح لنا بتوسيع نطاق الحروب إلى أبعاد غير مسبوقة يصعب تخيلها". وربما يكون مؤلفو الرسالة على حق.