تكتسب أنظمة الذكاء الاصطناعي (AI) أرضية. وفي هذا الصدد ، يناقش المحامون والمشرعون مشكلة كيفية تنظيم هذه الأنظمة ، ومن سيكون مسؤولاً عن أفعالهم. تتطلب هذه المشكلة دراسة دقيقة ونهجًا متوازنًا ، لأن أنظمة الذكاء الاصطناعي قادرة على توليد كميات هائلة من البيانات وتستخدم في تطبيقات وظائف مختلفة - من الأنظمة الطبية والطيارين الآليين في السيارات إلى التنبؤ بالجرائم وحساب المجرمين المحتملين. في الوقت نفسه ، يسعى العلماء جاهدين لإنشاء "ذكاء اصطناعي قوي" قادر على التفكير ، ويطرح السؤال حول كيفية تحديد وجود النية في أفعاله - أو الاعتراف بالأفعال على أنها غير مقصودة.

هناك العديد من الطرق لتقديم نظام الذكاء الاصطناعي إلى المساءلة والمسؤولية ؛ تم نشر العديد من الدراسات حول هذا الموضوع. في

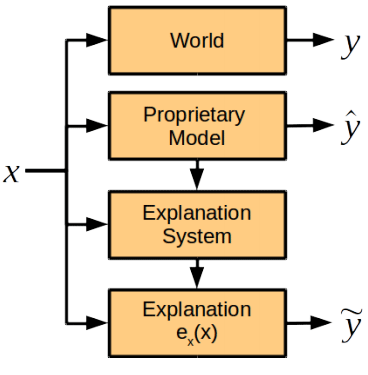

ورقة بحثية جديدة ، يناقش خبراء علوم الكمبيوتر والمعرفون والمحامون من جامعتي هارفارد وكامبريدج (الولايات المتحدة الأمريكية) أحد مكونات نظام مساءلة الذكاء الاصطناعي المستقبلي ، وهو دور الملاحظة التوضيحية من الذكاء الاصطناعي ، أي تقييم كيفية تفسير نظام الذكاء الاصطناعي لأفعاله . توصل العلماء إلى استنتاج مفاده أنه يجب فصل وحدة شرح الإجراءات عن نظام الذكاء الاصطناعي العام.

يصف مؤلفو العمل العلمي جميع المشاكل التي تنشأ عند محاولة طلب نظام الذكاء الاصطناعي شرحًا لأفعاله.

أولاً ، يجب توفير مثل هذه الفرصة في مرحلة تطوير النظام ، وإلا قد يرفض الذكاء الاصطناعي أو لن يكون قادرًا على شرح أفعاله.

ثانيًا ، يعالج نظام الذكاء الاصطناعي مجموعة كبيرة من البيانات باستخدام خوارزميات أو أساليب ملكية معقدة طورها في عملية التعلم. وبالتالي ، عند محاولتها شرح أفعالها بأكثر الطرق اكتمالًا ، يمكنها توليد الكثير من البيانات غير المفهومة للبشر. أو - مثل المتطرف الآخر - سيوفر نموذجًا مبسطًا للغاية لا يعكس النوايا الحقيقية للذكاء الاصطناعي ودوافع الإجراءات. بالإضافة إلى ذلك ، قد تكون خوارزميات تشغيل نظام الذكاء الاصطناعي ملكية فكرية للشركة النامية ، لذلك من الضروري توفير طريقة تجميع ملاحظة توضيحية من أجل تحديد أسباب النظام ، ولكن ليس لإعطاء الخوارزميات الأساسية.

يعتقد الباحثون أن التفسير ممكن دون الكشف عن الخوارزميات والقواعد التي تكمن وراء عمل نظام الذكاء الاصطناعي. في حالة وقوع حادث ، يجب على النظام تقديم إجابات على الأسئلة التالية:

- ما هي العوامل الرئيسية المؤثرة على القرار؟

- هل سيؤدي التغيير في عامل معين إلى تغيير في القرار؟

- لماذا أدت حالتان مماثلتان إلى حلول مختلفة؟

لا تتطلب الإجابات على مثل هذه الأسئلة بالضرورة الكشف عن أسرار الملكية وخوارزميات النظام الداخلي ، ولكنها في نفس الوقت ستعطي فهمًا واضحًا لدوافعها.

يجادل العلماء في الحالات التي يكون من المناسب فيها مطالبة منظمة العفو الدولية بشرح أفعالها. في الواقع ، هذا مطلوب في الحالات التي تفوق فيها فائدة التفسير سعر إيصالها: “نعتقد أن هناك ثلاثة شروط للحالات التي ترى فيها الشركة أنه من الضروري الحصول على تفسير من صانع القرار. هذه أسباب أخلاقية أو اجتماعية أو قانونية ”، توضح فينالي دوشي فيليز ، المؤلفة الرئيسية للصحيفة.

في الوقت نفسه ، لا ينبغي للمرء أن يطلب تفسيرات من الذكاء الاصطناعي حرفياً في كل موقف. كما ذكر أعلاه ، فإن هذا يزيد من مخاطر إصدار الأسرار التجارية ويضع عبئًا إضافيًا على مطوري أنظمة الذكاء الاصطناعي. وبعبارة أخرى ، فإن المساءلة المستمرة للذكاء الاصطناعي تجاه البشر ستمنع تطور هذه الأنظمة ، بما في ذلك في المجالات المهمة للبشر.

على عكس الاعتقاد السائد بأن نظام الذكاء الاصطناعي هو صندوق أسود ، أسبابه غير مفهومة للبشر ، فإن مؤلفي العمل العلمي على يقين من أنه يمكن تطوير وحدة تعمل بشكل طبيعي لشرح إجراءات الذكاء الاصطناعي. سيتم دمج هذه الوحدة النمطية في النظام ، ولكنها تعمل بشكل مستقل عن خوارزميات اتخاذ القرار ولا تطيعها.

يعتقد العلماء أن هناك بعض النقاط في تفسير الإجراءات التي يسهل على الناس وضعها وصعوبة الآلات ، والعكس صحيح.

مقارنة القدرات البشرية والذكاء الاصطناعي للشرح | رجل | AI |

|---|

| الفوائد | قد يشرح الفعل الخلفي | التكاثر ، وعدم وجود ضغط اجتماعي |

| المساوئ | قد يكون غير دقيق وغير موثوق به ، ويشعر بالضغط الاجتماعي | يتطلب برمجة أولية لوحدة الشرح والتصنيفات الإضافية وتوسيع نظام التخزين |

ومع ذلك ، يوصي فريق الخبراء بأن المرة الأولى التي تم تعيينها لأنظمة الذكاء الاصطناعي هي نفس المعيار لشرح الإجراءات التي يتم تعيينها للناس اليوم (يتم توضيح هذا المعيار في قانون الولايات المتحدة: على وجه الخصوص ، مطلوب تفسير في حالات المسؤولية الصارمة والطلاق والتمييز ، لاتخاذ قرارات إدارية ومن القضاة وهيئة المحلفين لشرح قراراتهم - على الرغم من أن مستوى تفاصيل المذكرة التفسيرية يختلف تمامًا في كل حالة).

ولكن إذا تجاوزت أسباب تصرفات الذكاء الاصطناعي فهم الإنسان ، فعندئذٍ من أجل حساب الذكاء الاصطناعي في المستقبل ، يمكن تطوير معيار آخر لملاحظاتهم التفسيرية ، كما يقول العلماء.

تم

نشر المقالة العلمية في 3 نوفمبر 2017 على موقع ما قبل الطباعة arXiv.org (arXiv: 1711.01134v1).