لقد

قطعت الترجمة الآلية بمساعدة الشبكات العصبية

شوطًا كبيرًا من لحظة البحث العلمي الأول حول هذا الموضوع حتى اللحظة التي أعلنت فيها Google عن

النقل الكامل لخدمة الترجمة من Google إلى التعلم العميق .

كما تعلم ، فإن أساس المترجم العصبي هو آلية الشبكات العصبية المتكررة ثنائية الاتجاه ، المبنية على حسابات المصفوفة ، والتي تسمح لك ببناء نماذج احتمالية أكثر تعقيدًا من المترجمين الإحصائيين. ومع ذلك ، كان يُعتقد دائمًا أن الترجمة العصبية ، مثل الترجمة الإحصائية ، تتطلب نصوصًا ثنائية اللغة موازية للتدريب. يتم تدريب شبكة عصبية على هذه المباني ، مع أخذ ترجمة بشرية كمرجع.

كما اتضح الآن ، الشبكات العصبية قادرة على إتقان لغة جديدة للترجمة حتى بدون مجموعة موازية من النصوص!

تم نشر عملين حول هذا الموضوع على موقع arXiv.org preprint.

"تخيل أنك تعطي شخصًا الكثير من الكتب الصينية والكثير من الكتب العربية - لا يوجد بينها كتب متطابقة - وهذا الشخص يتعلم الترجمة من الصينية إلى العربية. يبدو مستحيلاً ، صحيح؟

يقول Mikel Artetxe ، عالم الكمبيوتر في جامعة بلاد الباسك في سان سيباستيان (إسبانيا): "لكننا أظهرنا أن الكمبيوتر قادر على ذلك".

يتم تدريس معظم الشبكات العصبية للترجمة الآلية "مع مدرس" ، ودورها هو بالضبط مجموعة موازية من النصوص التي ترجمها الإنسان. في عملية التعلم ، تقريبًا ، تضع الشبكة العصبية افتراضًا ، وتتحقق من المعيار ، وتضع الإعدادات اللازمة في أنظمتها ، ثم تتعلم أكثر. تكمن المشكلة في أنه بالنسبة لبعض اللغات في العالم لا يوجد عدد كبير من النصوص المتوازية ، وبالتالي فهي غير متاحة للشبكات العصبية التقليدية للترجمة الآلية.

يقدم نموذجان جديدان نهجًا جديدًا: تدريس شبكة عصبية للترجمة الآلية

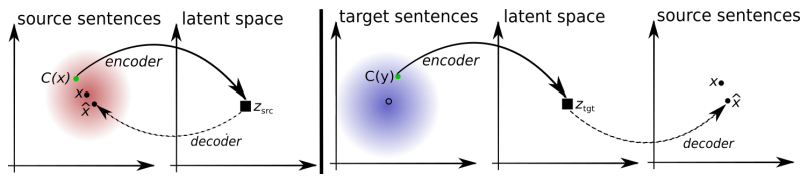

بدون معلم . يحاول النظام نفسه تكوين نوع من مجموعة موازية من النصوص ، يجمع الكلمات حول بعضها البعض. والحقيقة هي أنه في معظم لغات العالم هناك نفس المعاني التي تتوافق ببساطة مع كلمات مختلفة. لذلك ، يتم تجميع كل هذه المعاني في مجموعات متطابقة ، أي أن نفس معاني الكلمة يتم تجميعها حول نفس معاني الكلمة ، بغض النظر عن اللغة تقريبًا (انظر مقال "

شبكة الترجمة العصبية من Google جمعت قاعدة موحدة لمعاني الكلمات البشرية ") .

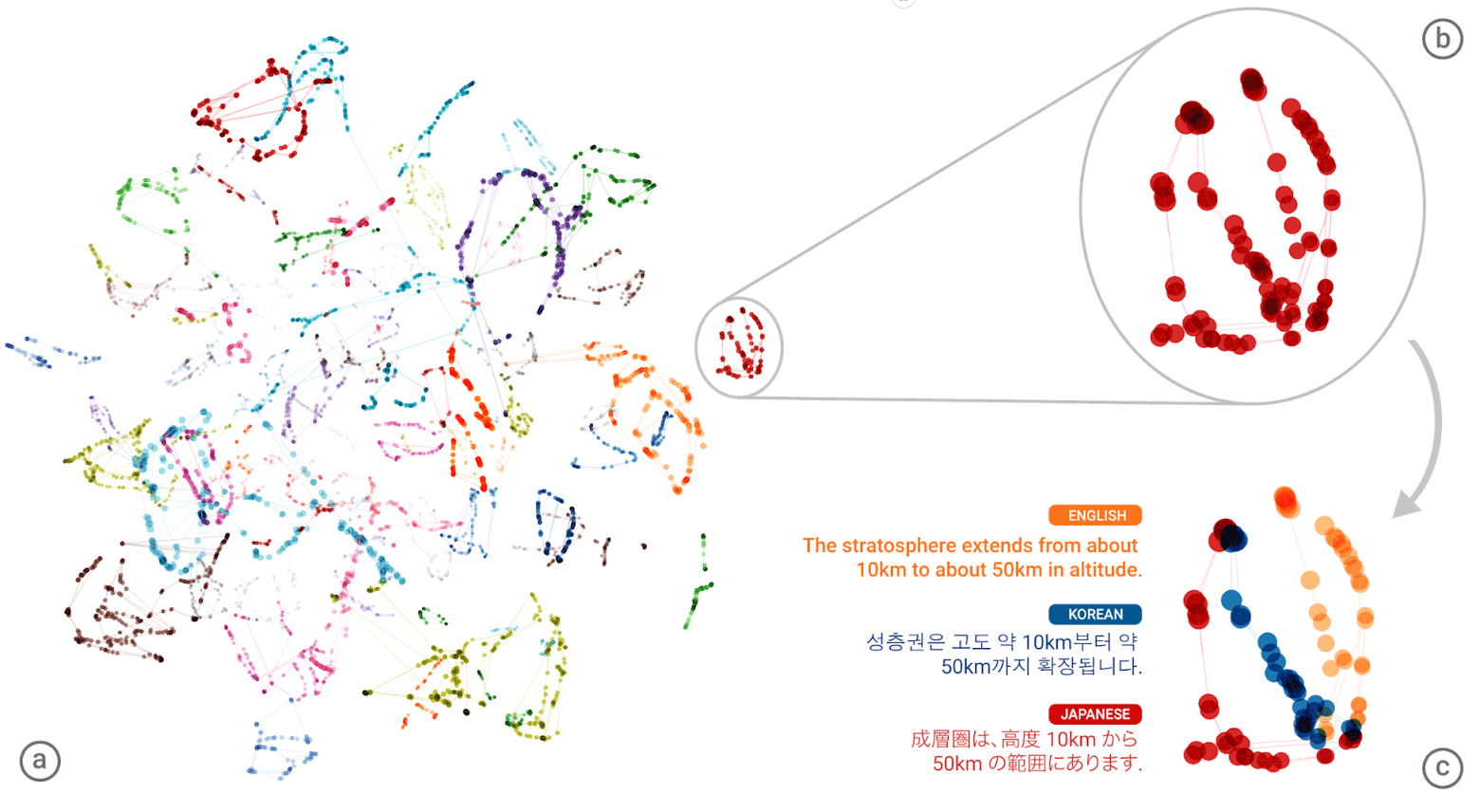

"اللغة العالمية" للشبكة العصبية لـ Google Neural Machine Translation (GNMT). يتم عرض مجموعات معاني كل كلمة بألوان مختلفة على الرسم التوضيحي الأيسر ، والمعاني السفلية هي معاني كلمة تم الحصول عليها من لغات بشرية مختلفة: الإنجليزية والكورية واليابانية

"اللغة العالمية" للشبكة العصبية لـ Google Neural Machine Translation (GNMT). يتم عرض مجموعات معاني كل كلمة بألوان مختلفة على الرسم التوضيحي الأيسر ، والمعاني السفلية هي معاني كلمة تم الحصول عليها من لغات بشرية مختلفة: الإنجليزية والكورية واليابانيةبعد أن جمعت "أطلس" عملاق لكل لغة ، يحاول النظام تراكب أحد هذه الأطلس على لغة أخرى - وأنت هنا ، أنت جاهز للحصول على مجموعة من النصوص المتوازية!

يمكنك مقارنة أنماط معماري التعلم المقترحين بدون معلم.

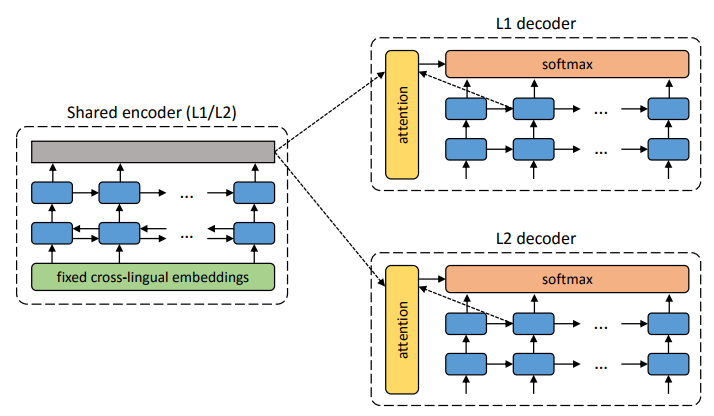

هيكل النظام المقترح. بالنسبة لكل جملة في لغة L1 ، يتعلم النظام التناوب بين خطوتين: 1) التقليل ، مما يعمل على تحسين احتمالية ترميز نسخة صاخبة من الجملة باستخدام برنامج تشفير مشترك وإعادة بنائها بواسطة وحدة فك ترميز L1 ؛ 2) الترجمة الخلفية ، عندما تُترجم جملة في وضع الإخراج (أي يتم تشفيرها بواسطة جهاز تشفير مشترك وفك تشفيرها بواسطة وحدة فك ترميز L2) ، ومن ثم يتم تحسين احتمال تشفير هذه الجملة المترجمة باستخدام برنامج تشفير مشترك واستعادة الجملة الأصلية بواسطة جهاز فك التشفير L1. رسم توضيحي: مقالة علمية بقلم Mikel Artetks et al.

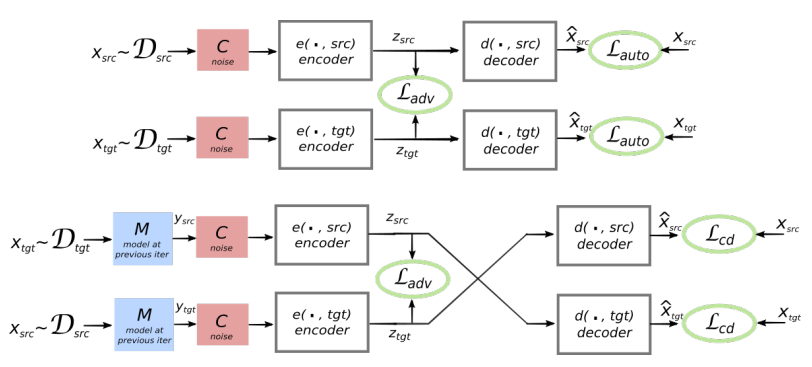

هيكل النظام المقترح. بالنسبة لكل جملة في لغة L1 ، يتعلم النظام التناوب بين خطوتين: 1) التقليل ، مما يعمل على تحسين احتمالية ترميز نسخة صاخبة من الجملة باستخدام برنامج تشفير مشترك وإعادة بنائها بواسطة وحدة فك ترميز L1 ؛ 2) الترجمة الخلفية ، عندما تُترجم جملة في وضع الإخراج (أي يتم تشفيرها بواسطة جهاز تشفير مشترك وفك تشفيرها بواسطة وحدة فك ترميز L2) ، ومن ثم يتم تحسين احتمال تشفير هذه الجملة المترجمة باستخدام برنامج تشفير مشترك واستعادة الجملة الأصلية بواسطة جهاز فك التشفير L1. رسم توضيحي: مقالة علمية بقلم Mikel Artetks et al. العمارة المقترحة وأهداف التعلم للنظام (من العمل العلمي الثاني). الهندسة عبارة عن نموذج ترجمة جملة ، حيث يعمل كل من برنامج التشفير وفك الشفرة بلغتين ، اعتمادًا على معرف لغة الإدخال ، والذي يبدل جداول البحث. أعلاه (الترميز التلقائي): يتعلم النموذج كيفية إجراء تقليل الضوضاء في كل مجال. أدناه (الترجمة): كما كان من قبل ، بالإضافة إلى أننا نرمز من لغة أخرى ، باستخدام المدخلات الترجمة التي ينتجها النموذج في التكرار السابق (مستطيل أزرق). تشير علامات الحذف الخضراء إلى المصطلحات في دالة الخسارة. رسم توضيحي: مقالة علمية كتبها غيوم لامبل وآخرون.

العمارة المقترحة وأهداف التعلم للنظام (من العمل العلمي الثاني). الهندسة عبارة عن نموذج ترجمة جملة ، حيث يعمل كل من برنامج التشفير وفك الشفرة بلغتين ، اعتمادًا على معرف لغة الإدخال ، والذي يبدل جداول البحث. أعلاه (الترميز التلقائي): يتعلم النموذج كيفية إجراء تقليل الضوضاء في كل مجال. أدناه (الترجمة): كما كان من قبل ، بالإضافة إلى أننا نرمز من لغة أخرى ، باستخدام المدخلات الترجمة التي ينتجها النموذج في التكرار السابق (مستطيل أزرق). تشير علامات الحذف الخضراء إلى المصطلحات في دالة الخسارة. رسم توضيحي: مقالة علمية كتبها غيوم لامبل وآخرون.تستخدم كلتا الورقتين العلميتين أسلوبًا مشابهًا بشكل ملحوظ مع اختلافات طفيفة. ولكن في كلتا الحالتين ، تتم الترجمة من خلال "لغة" وسيطة ، أو بشكل أفضل ، بعد أو مسافة وسيطة. حتى الآن ، لا تظهر الشبكات العصبية التي لا يوجد بها معلم جودة عالية جدًا للترجمة ، لكن المؤلفين يقولون أنه من السهل تحسينها إذا كنت تستخدم القليل من المساعدة من المعلم ، الآن فقط من أجل نقاء التجربة التي لم يفعلوا.

لاحظ أن العمل العلمي الثاني نشره باحثون من قسم الذكاء الاصطناعي على Facebook.

يتم تقديم الأعمال للمؤتمر الدولي حول تمثيلات التعلم 2018. لم تنشر أي من المقالات حتى الآن في الصحافة العلمية.