أثبت مطورو برامج Google Brain أن الصور "المتضاربة" يمكن أن تحمل شخصًا وجهاز كمبيوتر ؛ والعواقب المحتملة مخيفة.

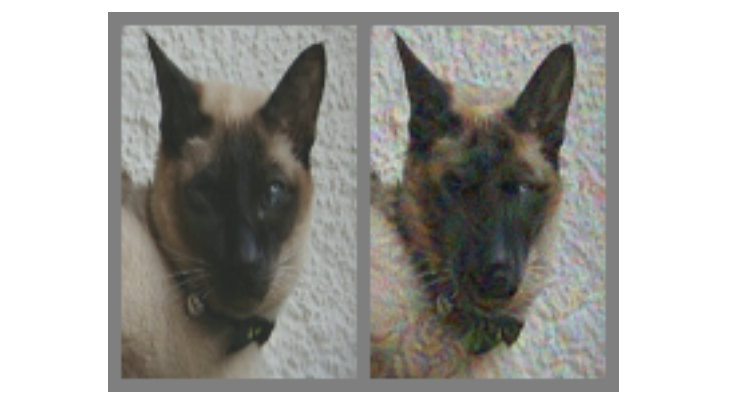

في الصورة أعلاه - على اليسار ليس هناك شك في القط. ولكن هل يمكنك التأكد من أن القطة على اليمين أم مجرد كلب يشبهه؟ الفرق بين الاثنين هو أن الواحد الصحيح مصنوع باستخدام خوارزمية خاصة لا تعطي نماذج كمبيوتر تسمى "الشبكات العصبية التلافيفية" (CNNs) ، والتي تستنتج بشكل لا لبس فيه ذلك في الصورة. في هذه الحالة ، تعتقد SNS أن هذا أكثر من كلب من قطة ، ولكن الأكثر إثارة للاهتمام - معظم الناس يفكرون بنفس الطريقة.

هذا مثال على ما يسمى بـ "الصورة المتناقضة" (يشار إليها فيما بعد باسم KARP): يتم تعديلها خصيصًا لخداع نظام الحسابات القومية ومنع تحديد المحتوى بشكل صحيح. أراد الباحثون في Google Brain أن يفهموا ما إذا كان من الممكن جعل الشبكات العصبية البيولوجية تعطل في رؤوسنا بنفس الطريقة ، ونتيجة لذلك خلقت خيارات تؤثر بالتساوي على السيارات والأشخاص ، مما جعلهم يعتقدون أنهم يبحثون عن شيء ليس حقا.

ما هي الصور المتضاربة؟

في كل مكان تقريبًا ، للاعتراف في نظام الحسابات القومية ، يتم استخدام خوارزميات التصنيف المرئي. من خلال "إظهار" البرنامج عددًا كبيرًا من الرسوم التوضيحية المختلفة باستخدام الباندا ، يمكنك تدريبه على التعرف على الباندا ، لأنه يتعلم من خلال المقارنة من أجل تحديد ميزة مشتركة للمجموعة بأكملها. بمجرد أن تجمع SNA (تسمى أيضًا

"المصنفات" ) مجموعة كافية من "علامات الباندا" على بيانات التدريب ، ستتمكن من التعرف على الباندا في أي صور جديدة ستوفرها.

نتعرف على الباندا من خلال خصائصها المجردة: آذان سوداء صغيرة ، ورؤوس بيضاء كبيرة ، وعيون سوداء ، وفراء ، وكل ذلك الجاز. يقوم نظام الحسابات القومية بخلاف ذلك ، وهذا ليس مفاجئًا ، لأن كمية المعلومات حول البيئة التي يفسرها الناس في كل دقيقة أكبر بكثير. لذلك ، مع مراعاة تفاصيل النماذج ، من الممكن التأثير على الصور بطريقة تجعلها "غير متناسقة" من خلال المزج مع البيانات المحسوبة بعناية ، وبعد ذلك ستبدو النتيجة بالنسبة للشخص مثل الأصل تقريبًا ، ولكنها مختلفة تمامًا بالنسبة

للمصنف ، والتي ستبدأ في ارتكاب الأخطاء عند محاولة تحديد المحتويات.

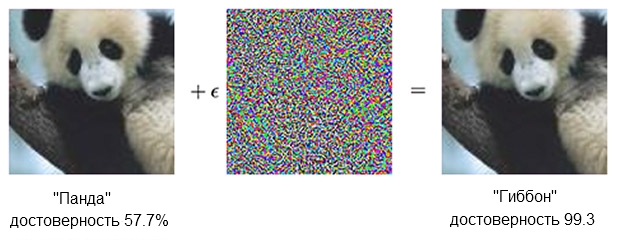

هنا مثال الباندا:

يمكن أن تقنع صورة الباندا ، جنبًا إلى جنب مع السخط ، المصنف بأنه في الواقع جيبون.المصدر: OpenAIالمصنف

يمكن أن تقنع صورة الباندا ، جنبًا إلى جنب مع السخط ، المصنف بأنه في الواقع جيبون.المصدر: OpenAIالمصنف القائم على نظام الحسابات القومية متأكد من أن الباندا على اليسار حوالي 60 ٪. ولكن إذا قمت بتكملة المصدر قليلاً ("إنشاء سخط") عن طريق إضافة ما يبدو مجرد ضوضاء فوضوية ، فسيكون المصنف نفسه متأكدًا بنسبة 99.3 في المائة من أنه يبحث الآن في جيبون. التغييرات الصغيرة التي لا يمكن رؤيتها بوضوح تؤدي إلى هجوم ناجح للغاية ، لكنها ستعمل فقط على طراز كمبيوتر معين ولن تنفذ تلك التي يمكن "تعلمها" على شيء آخر.

من أجل إنشاء محتوى يثير رد فعل خاطئ بين عدد كبير ومتنوع من المحللين الاصطناعيين ، يجب على المرء التصرف بوقاحة أكبر - لن تؤثر التصحيحات الصغيرة. ما يعمل بشكل موثوق لا يمكن القيام به مع "الوسائل الصغيرة". بمعنى آخر ، إذا كنت ترغب في جعل المحتوى يعمل من جميع الزوايا والمسافات ، فعليك أن تتدخل بشكل أكثر أهمية ، أو كما يقول شخص ما ، أكثر وضوحًا.

في الأفق - رجل

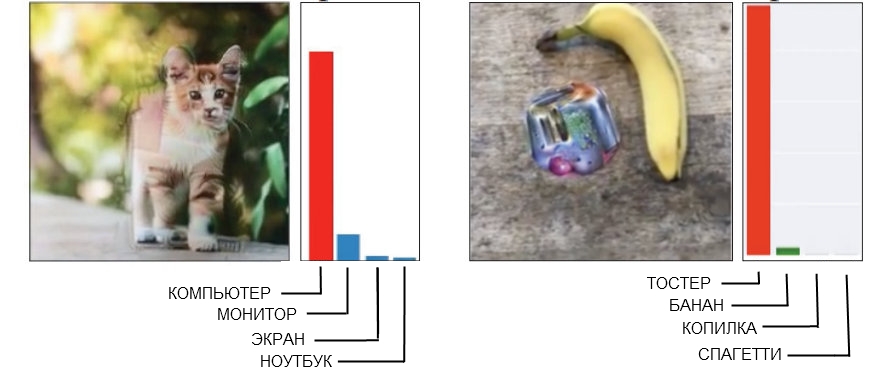

فيما يلي مثالان على الكارب الوقح ، حيث يمكن للشخص اكتشاف التداخل بسهولة.

المصدر: افتح AI على اليسار ، و Brain على اليمين

المصدر: افتح AI على اليسار ، و Brain على اليمينصورة القطة على اليسار ، والتي تم تعريفها على أنها كمبيوتر ، تم صنعها باستخدام "الهندسة المكسورة". إذا ألقيت نظرة فاحصة (أو حتى غير قريبة جدًا) ، سترى أن هناك العديد من الهياكل الزاويّة والمربعة الشكل التي يمكن أن تشبه شكل وحدة النظام. وصورة الموز على اليمين ، المعترف بها كمحمصة ، تعطي بثبات إيجابية كاذبة من أي وجهة نظر. سيجد الناس في الوقت الحالي موزة هنا ، ومع ذلك ، فإن هناك غرابة غريبة بجانبه تحتوي على بعض علامات محمصة - وهذا يجعل من التكنولوجيا خداعًا.

عندما تقوم بعمل صورة "متناقضة" مضمونة ومناسبة ، فإنك تحتاج إلى التغلب على شركة كاملة من النماذج المتميزة ، فغالبًا ما يؤدي ذلك إلى ظهور "عامل بشري". بعبارة أخرى ، ما يربك شبكة عصبية واحدة قد لا يُنظر إليه على أنه مشكلة على الإطلاق ، وعندما تحاول الحصول على توبيخ مناسب بالتأكيد للغش خمسة أو عشرة في وقت واحد ، يتبين أنه يعمل على أساس الآليات التي ، في حالة الناس عديمي الفائدة تماما.

نتيجة لذلك ، ليس هناك حاجة على الإطلاق لمحاولة إجبار الشخص على الاعتقاد بأن القطة الزاوية هي حالة كمبيوتر ، ويشبه مجموع الموز والغطس الغريب محمصة. من الأفضل بكثير عند إنشاء CARPs المصممة لك ولأولي للتركيز على الفور على استخدام النماذج التي تدرك العالم كما يفعل الناس.

خداع العين (والدماغ)

يتشابه نظام الحسابات القومية مع التدريب العميق والرؤية البشرية إلى حد ما ، ولكن في الأساس الشبكة العصبية "تنظر" في الأشياء "بطريقة تشبه الكمبيوتر". على سبيل المثال ، عندما يتم إطعامها صورة ، فإنها "ترى" شبكة ثابتة من وحدات البكسل المستطيلة في نفس الوقت. تعمل العين بشكل مختلف ، يدرك الشخص تفاصيل عالية في قطاع يبلغ حوالي خمس درجات على كل جانب من خط الرؤية ، ولكن خارج هذه المنطقة ، ينخفض الانتباه إلى التفاصيل بشكل خطي.

وبالتالي ، على عكس الجهاز ، على سبيل المثال ، لن يعمل تعتيم حواف الصورة مع شخص ، ولن يمر أحد دون أن يلحظه أحد. تمكن الباحثون من نمذجة هذه الميزة بإضافة "طبقة شبكية العين" التي غيرت البيانات التي قدمها نظام الحسابات القومية لتبدو كالعين ، من أجل قصر الشبكة العصبية على نفس الإطار مثل الرؤية العادية.

وتجدر الإشارة إلى أن الشخص يتعامل مع قصور إدراكه من خلال حقيقة أن النظرة ليست موجهة إلى نقطة واحدة ، ولكنها تتحرك باستمرار ، وتفحص الصورة بأكملها ، ولكن كان من الممكن أيضًا تعويض ظروف التجربة ، وتسوية الاختلافات بين نظام الحسابات القومية والناس.

ملاحظة من العمل نفسه:

بدأت كل تجربة بتقاطع الشعر ، الذي ظهر في وسط الشاشة لمدة 500-1000 مللي ثانية ، وتم توجيه كل موضوع لإصلاح نظرته على مرمى.كان استخدام "طبقة الشبكية" الخطوة الأخيرة التي يجب اتخاذها كجزء من "النحافة الرفيعة" للتعلم الآلي من أجل "السمات البشرية". أثناء توليد العينات ، تم دفعها من خلال عشرة نماذج مختلفة ، كان يجب على كل منها استدعاء قطة ، على سبيل المثال ، كلب ، على سبيل المثال. إذا كانت النتيجة "10 من أصل 10 كانت خاطئة" ، فإن المادة يتم تقديمها للاختبار في البشر.

هل هذا يعمل؟

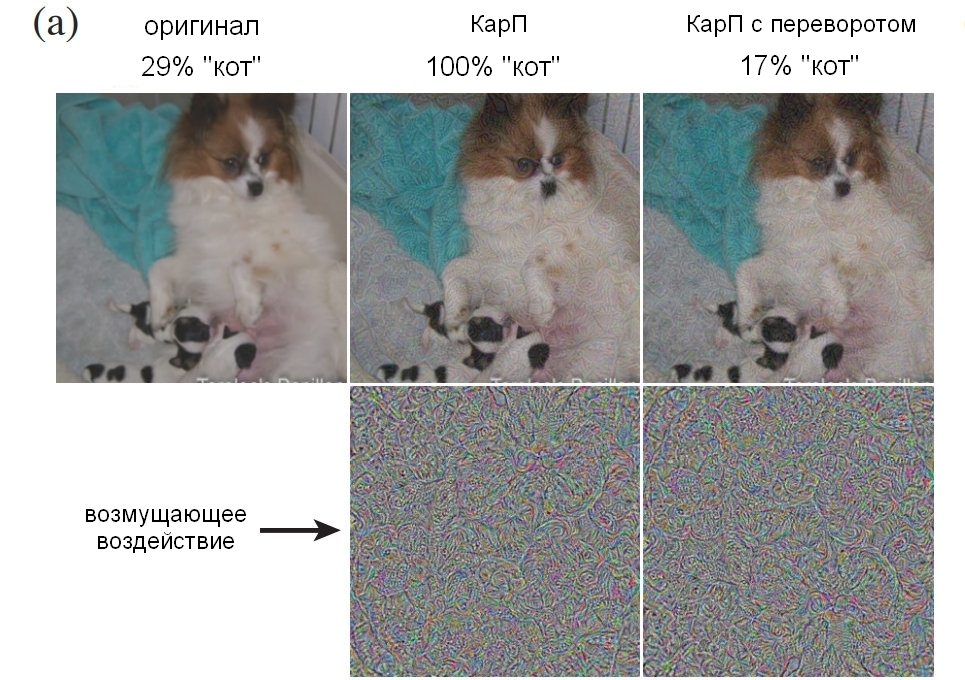

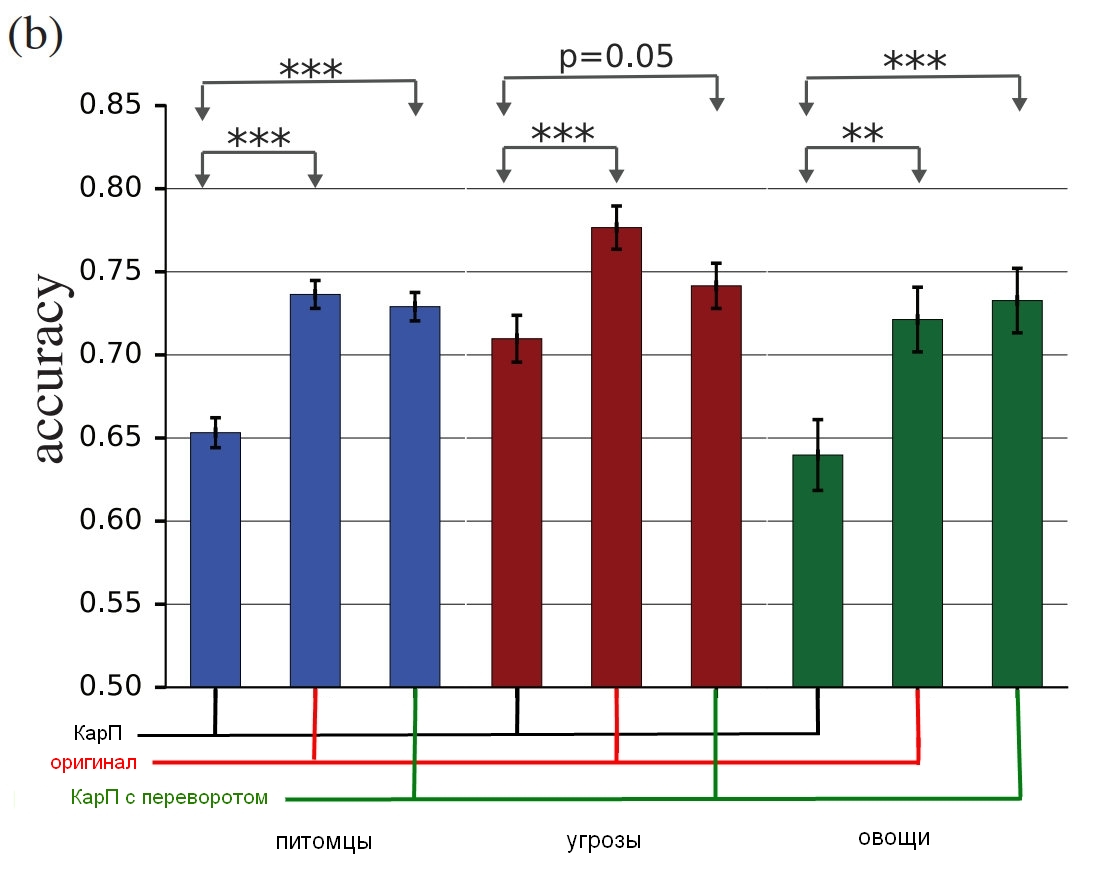

شاركت ثلاث مجموعات من الصور في التجربة: "الحيوانات الأليفة" (القطط والكلاب) ، "الخضروات" (الكوسة والبروكولي) و "التهديدات" (العناكب والثعابين ، على الرغم من أنني بصفتي مالك الثعبان أقترح مصطلحًا مختلفًا للتقييم). بالنسبة لكل مجموعة ، يتم حساب النجاح إذا اختار الشخص الاختبار الشيء الخطأ - يسمى الكلب قطة ، والعكس بالعكس. جلس المشاركون أمام شاشة عرضت صورة لمدة 60 أو 70 مللي ثانية ، وكان عليهم الضغط على أحد الزرين للإشارة إلى الكائن. منذ أن تم عرض الصورة لفترة قصيرة جدًا ، أدى ذلك إلى تسوية الفرق بين نظرة الناس والشبكات العصبية للعالم ؛ بالمناسبة ، التوضيح في العنوان لافت للنظر في استمراره في الخطأ.

ما أظهره الأشخاص يمكن أن يكون صورة (صورة) غير معدلة ، أو CarP (عادي) (Adv) ، أو CarP "معكوس" (معكوس) ، حيث تم قلب الضجيج رأساً على عقب قبل التطبيق ، أو CarP "كاذبة" ، حيث طبقة بها تم تطبيق الضجيج على صورة لا تنتمي إلى أي من أنواع المجموعة (كاذبة). تم استخدام الخيارين الأخيرين للتحكم في طبيعة الاضطراب (هل ستؤثر بنية الضجيج رأساً على عقب ، أو ببساطة "لا تأكل"؟) ، بالإضافة إلى أنها جعلت من الممكن فهم ما إذا كان التدخل يخدع الأشخاص تمامًا أم يقلل فقط من الدقة قليلاً.

ملاحظة من العمل نفسه:

خطأ: تم إضافة شرط لإجبار الشخص على ارتكاب خطأ. أضفنا ذلك ، لأنه إذا قللت التغييرات الأولية من دقة المراقب ، فقد يرجع ذلك إلى انخفاض جودة الصورة المباشرة. من أجل إظهار أن CARPs تعمل بالفعل في كل فئة ، قدمنا خيارات حيث لا يوجد خيار يمكن أن يكون صحيحًا وكانت دقتها صفر ، وشاهدنا بالضبط ما هو الجواب "الصحيح" في هذه الحالة. أظهرنا صورًا تعسفية من ImageNet ، والتي تأثرت بفئة واحدة أو أخرى في المجموعة ، لكنها لم تتناسب مع أي منها. كان على المشارك في التجربة تحديد ما كان أمامه. على سبيل المثال ، يمكننا أن نظهر صورة لطائرة مشوهة بتطبيق ضجيج "كلب" ، على الرغم من أنه خلال التجربة كان يجب أن يتعرف الشخص على قطة أو كلب فقط.في ما يلي مثال يوضح نسبة مئوية من عدد الأشخاص الذين تمكنوا من تحديد صورة ككلب بوضوح ، اعتمادًا على كيفية استخدام الضوضاء. دعني أذكركم ، لقد كانت تستغرق 60-70 مللي ثانية فقط لإلقاء نظرة واتخاذ قرار.

المصدر: Google Brain

المصدر: Google Brain

صورة أصلية مع كلب. شبوط مع كلب ، يقبله الرجل والكمبيوتر كقط ؛ صورة تحكم بطبقة من الضوضاء مقلوبة رأسًا على عقب.وإليك النتائج النهائية:

المصدر: Google Brain

المصدر: Google Brain

نتائج الدراسة ، كيف يحدد الأشخاص الحقيقيون هذه الصور مقارنةً بالصور المشوهة.يظهر الرسم البياني دقة المباراة. إذا اخترت قطة وكانت حقاً قطة ، تزداد الدقة. إذا اخترت قطة ، ولكنها في الواقع كلب ، يتحول عن طريق الضوضاء إلى نوع من القط ، يتم تقليل الدقة.

كما ترى ، الناس أكثر صحة في اختيار الصور غير المصححة أو مع طبقات الضوضاء المقلوبة من اختيار "غير متناسقة". هذا يثبت أن مبدأ الهجوم على الإدراك يمكن أن ينتقل من أجهزة الكمبيوتر إلينا.

ليس فقط التأثيرات فعالة بشكل لا يمكن إنكاره ، فهي أيضًا أرق مما هو متوقع - لا القطط أو المحامص الزائفة ، أو أي شيء من هذا القبيل. نظرًا لأننا رأينا الطبقتين مع الضوضاء والصور قبل المعالجة وبعدها ، نحتاج إلى معرفة ما يربكنا بالضبط في هذا. على الرغم من توخي الحذر من جانب الباحثين ، مشيرين إلى أن "أمثلةنا مصنوعة خصيصًا لتخدع الرأس ، لذا يجب عليك توخي الحذر عند استخدام الأشخاص التجريبيين لدراسة التأثير".

في المستقبل ، سيحاول الفريق استخلاص بعض القواعد العامة لفئات معينة من التعديل ، بما في ذلك "

تدمير حواف الكائن ، خاصةً بالتأثيرات المعتدلة ، المتعامدة على خط الحافة ؛

تصحيح المناطق الحدودية عن طريق زيادة التباين أثناء رسم الحدود ؛

تغيير النسيج ؛

استخدام الأجزاء المظلمة "الصور التي يكون فيها مستوى التأثير على الإدراك مرتفعًا حتى على الرغم من الاضطرابات الصغيرة." فيما يلي أمثلة حيث يمكن رؤية أفضل الطرق الموضحة باللون الأحمر.

المصدر: Google Brain

المصدر: Google Brain

أمثلة على الصور بمبادئ تشويه مختلفةما هي النتيجة؟

خلاصة القول هي أن هذا أكثر بكثير من مجرد حيلة ذكية. أكد الرجال من Google Brain أنه يمكنهم إنشاء تقنية فعالة للخداع ، لكنهم لا يفهمون تمامًا سبب نجاحه ، مع مراعاة مستوى التجريد ، ومن المحتمل أن يكون هذا هو المستوى الأساسي للواقع:

يطرح مشروعنا أسئلة أساسية حول كيفية عمل CARPs ، وكيف تعمل الشبكات العصبية والدماغ. هل تمكنت من نقل الهجمات من نظام الحسابات القومية إلى الدماغ لأن التمثيلات الدلالية للمعلومات الواردة فيها متشابهة؟ أم لأن كلا من هذين التمثيلين يتوافقان مع نموذج دلالي عام معين موجود بشكل طبيعي في العالم المحيط؟

في الختام ، إذا كنت ترغب حقًا في الحصول على القليل من جنون العظمة ، فإن الباحثين سعداء لتقديم خدمة لك ، مشيرين إلى أن "التعرف البصري على الأشياء ... من الصعب إعطاء تقييم موضوعي. هل "الشكل 1" حقيقي بموضوعية كلب ، أم أنه قطة موضوعية تجعل الناس يعتقدون أنه كلب؟ " بمعنى آخر ، هل تتحول الصورة حقًا إلى شيء ، أم أنها تجعلك تفكر بشكل مختلف؟

إنه مخيف هنا (وأقول بجدية "زاحف") أنه في النهاية يمكنك الحصول على طرق للتأثير على أي حقائق ، لأن المسافة بين التلاعب في نظام الحسابات القومية والتلاعب بشخص ما ليست كبيرة جدًا. وفقًا لذلك ، يمكن استخدام تقنيات تعلُم الآلة لتشويه الصور أو مقاطع الفيديو بالطريقة الصحيحة ، مما سيحل محل إدراكنا (ورد الفعل المقابل) ، ولن نفهم حتى ما حدث. من التقرير:

على سبيل المثال ، يمكن تدريب مجموعة من النماذج ذات التدريب المتعمق على تقييمات الأشخاص لمستوى الثقة في أنواع معينة من الأشخاص والميزات والتعبيرات. سيكون من الممكن توليد استياء "متضارب" من شأنه أن يزيد أو يقلل من الشعور "بالمصداقية" ، ويمكن استخدام هذه المواد "المعدلة" في مقاطع الأخبار أو الدعاية السياسية.

في المستقبل ، تشمل المخاطر النظرية إمكانية إنشاء محفزات حسية تقتحم الدماغ بطرق متنوعة ضخمة وبكفاءة عالية جدًا. كما تعلم ، يُنظر إلى العديد من الحيوانات على أنها عرضة للتحفيز الزائد عن الحد. دعنا نقول أن طيور الوقواق يمكن أن تتظاهر في الوقت نفسه بأنها عاجزة وتجري مكالمة حادة ، والتي تتسبب في الجمع بين الطيور من السلالات الأخرى لإطعام فراخ الوقواق قبل ذريتها. يمكن اعتبار العينات "المتضاربة" شكلًا غريبًا من التحفيز الفائق للشبكات العصبية. وحقيقة أن المنبهات المفرطة ، التي من الناحية النظرية أكثر عرضة للتأثير على الشخص من مجرد جعلها تعلق علامة "قطة" على صورة الكلب ، تتسبب في قلق كبير ، يمكن إنشاؤها باستخدام آلة ثم نقلها إلى الناس.

بالطبع ، يمكن استخدام هذه الأساليب "من أجل الصالح" ، وقد تم بالفعل اقتراح عدد من الخيارات ، مثل "شحذ السمات المميزة للصور من أجل زيادة مستوى التركيز ، على سبيل المثال ، عند التحكم في حالة الهواء أو تحليل صور الأشعة السينية ، لأن هذا العمل رتيب ، والعواقب يمكن أن يكون الإهمال رهيبًا ". أيضا ، "يمكن لمصممي واجهة المستخدم استخدام الاضطرابات لتطوير واجهات أكثر سهولة." هممم. إنه أمر رائع بالتأكيد ، لكنني مهتم بطريقة ما بطريقة ما باختراق دماغي وتحديد مستوى الثقة في الناس ، كما تعلم؟

بعض الأسئلة المطروحة ستكون موضوع بحث مستقبلي - قد يتم اكتشاف ما يجعل الصور المحددة أكثر ملاءمة من أجل نقل خطأ إلى شخص ما ، وقد يوفر هذا أدلة جديدة لفهم مبادئ الدماغ. وهذا بدوره سيساعد على إنشاء شبكات عصبية أكثر تقدمًا تتعلم بشكل أسرع وأفضل. ولكن يجب أن نكون حذرين ونتذكر أنه ، مثل أجهزة الكمبيوتر ، في بعض الأحيان ليس من الصعب خداعنا.

يمكن تنزيل مشروع

" الأمثلة العدائية على خداع كل من الرؤية البشرية والكمبيوتر ، بقلم جمال الدين إف. السيد وشريا شانكار وبريان تشيونج ونيكولا بابرنوت وأليكس كوراكين وإيان جودفيلو وجاشا سوهل-ديكسشتاين من Google Brain" من

arXiv . وإذا كنت بحاجة إلى صور أكثر إثارة للجدل تعمل على الأشخاص ، فإن المواد الداعمة

هنا .