سيطرت الهستيريا المحيطة بمستقبل الذكاء الاصطناعي على العالم. لا يوجد نقص في الأخبار المثيرة حول كيف يمكن للذكاء الاصطناعي

علاج الأمراض وتسريع الابتكار وتحسين إبداع الشخص. إذا قرأت عناوين وسائل الإعلام ، يمكنك أن تقرر أنك تعيش بالفعل في مستقبل اخترقت فيه منظمة العفو الدولية جميع جوانب المجتمع.

على الرغم من أنه لا يمكن إنكار أن منظمة العفو الدولية قد فتحت لنا مجموعة

غنية من الفرص الواعدة لنا ، إلا أنها أدت أيضًا إلى ظهور التفكير ، والذي يمكن وصفه بأنه إيمان بقدرة كلية الذكاء الاصطناعي. وفقًا لهذه الفلسفة ، إذا كانت هناك بيانات كافية ،

فستكون خوارزميات التعلم الآلي

قادرة على حل جميع مشاكل البشرية .

لكن هذه الفكرة لديها مشكلة كبيرة. إنه لا يدعم تقدم الذكاء الاصطناعي ، ولكنه يعرض قيمة الذكاء الآلي للخطر ، ويتجاهل مبادئ السلامة المهمة ويضع الناس لتوقعات غير واقعية حول قدرات الذكاء الاصطناعي.

الإيمان بقدرة كلية الذكاء الاصطناعي

في بضع سنوات فقط ، شق الإيمان بالقدرة الكلية للذكاء الاصطناعي طريقه من محادثات المبشرين في مجال تكنولوجيا وادي السيليكون إلى أذهان ممثلي الحكومة والمشرعين حول العالم. تأرجح البندول من المفهوم المناهض لليوتوبيا

للذكاء الاصطناعي الذي يدمر البشرية إلى الإيمان الطوباوي

بقدوم مخلصنا الخوارزمي .

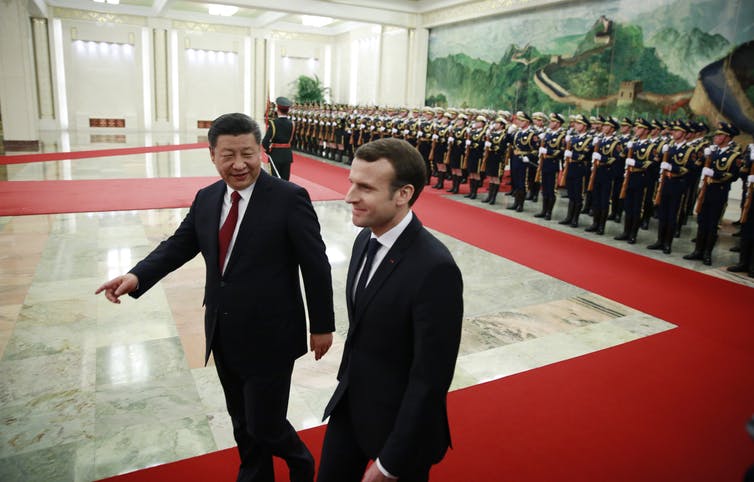

نحن نرى بالفعل كيف تقدم الحكومات الدعم لبرامج تطوير الذكاء الاصطناعي الوطنية وتتنافس في

سباق التسلح التكنولوجي والخطابي للحصول على ميزة في قطاع التعلم الآلي المزدهر. على سبيل المثال ،

وعدت الحكومة البريطانية

باستثمار 300 مليون جنيه إسترليني في أبحاث الذكاء الاصطناعي لتصبح رائدة في هذا المجال. مفتونًا بالإمكانيات التحويلية للذكاء الاصطناعي ، قرر الرئيس الفرنسي

إيمانويل ماكرون تحويل فرنسا إلى مركز دولي للذكاء الاصطناعي . تعمل الحكومة الصينية على زيادة قدراتها في مجال الذكاء الاصطناعي من خلال

خطة حكومية لإنشاء صناعة ذكاء اصطناعي صينية بقيمة 150 مليار دولار بحلول عام 2030. يكتسب الإيمان بالقدرة الكلية للذكاء الاصطناعي قوة دفع ولن يستسلم.

الشبكات العصبية - أسهل من الفعل

في حين أن العديد من البيانات السياسية تروج للآثار التحويلية لـ "

ثورة الذكاء الاصطناعي " الوشيكة

، فإنها عادة ما تقلل من تعقيد إدخال أنظمة MO المتقدمة في العالم الحقيقي.

الشبكات العصبية هي واحدة من أكثر أنواع تكنولوجيا الذكاء الواعد. يعتمد هذا النوع من التعلم الآلي على تقليد مثالي للهيكل العصبي للدماغ البشري ، ولكن على نطاق أصغر بكثير. تستخدم العديد من المنتجات القائمة على الذكاء الاصطناعي الشبكات العصبية لاستخراج الأنماط والقواعد من كميات كبيرة من البيانات. لكن العديد من السياسيين لا يفهمون أن مجرد إضافة شبكة عصبية إلى المشكلة ، لا نحصل بالضرورة على حلها على الفور. لذا ، بإضافة شبكة عصبية إلى الديمقراطية ، لن نجعلها على الفور أقل تمييزًا وأكثر صدقًا وشخصية.

تحدي بيروقراطية البيانات

تتطلب أنظمة الذكاء الاصطناعي كمية هائلة من البيانات للعمل ، ولكن في القطاع العام لا توجد عادةً

بنية تحتية مناسبة للبيانات لدعم أنظمة MO المتقدمة. يتم تخزين معظم البيانات في المحفوظات غير المتصلة بالإنترنت. هناك عدد قليل من مصادر البيانات الرقمية الحالية تغرق في البيروقراطية. غالبًا ما يتم نشر البيانات عبر مختلف الإدارات الحكومية ، والتي يتطلب كل منها إذنًا خاصًا للوصول. من بين أمور أخرى ، لا يمتلك القطاع العام عادةً ما يكفي من المواهب المجهزة بالقدرات التقنية اللازمة لجني

فوائد الذكاء الاصطناعي بالكامل.

لهذه الأسباب ، يتلقى

الإثارة المرتبطة بالذكاء الاصطناعي الكثير من الانتقادات. لطالما دعا ستيوارت راسل ، أستاذ علوم الكمبيوتر في بيركلي ، إلى اتباع نهج أكثر واقعية ، يركز على

أبسط التطبيقات اليومية للذكاء الاصطناعي ، بدلاً من الاستيلاء الافتراضي على العالم بواسطة الروبوتات فائقة الذكاء. وبالمثل ، كتب أستاذ الروبوتات من معهد ماساتشوستس للتكنولوجيا ،

رودني بروكس ، أن "جميع الابتكارات تقريبًا في مجال الروبوتات والذكاء الاصطناعي تتطلب وقتًا أطول بكثير للتنفيذ الفعلي مما يتخيله كل من المتخصصين في هذا المجال وكل شخص آخر."

أحد التحديات العديدة التي تواجه نشر أنظمة MO هي أن الذكاء الاصطناعي

عرضة بشدة

للهجمات . هذا يعني أن الذكاء الاصطناعي الخبيث يمكن أن يهاجم ذكاء اصطناعي آخر لإجباره على إصدار تنبؤات غير صحيحة أو التصرف بطريقة معينة. حذر العديد من

الباحثين من أنه من المستحيل طرح الذكاء الاصطناعي على الفور دون إعداد

معايير السلامة المناسبة

وآليات الحماية . ولكن حتى الآن ، لم يحظ موضوع أمن منظمة العفو الدولية بالاهتمام الواجب.

التعلم الآلي ليس سحرًا

إذا أردنا جني فوائد الذكاء الاصطناعي وتقليل المخاطر المحتملة ، فيجب علينا أن نبدأ في التفكير في الكيفية التي يمكننا من خلالها تطبيق عمليات الإدخال والإخراج بشكل هادف في مجالات معينة من الحكومة والأعمال والمجتمع. وهذا يعني أننا بحاجة إلى البدء في مناقشة

أخلاقيات الذكاء الاصطناعي وعدم الثقة في كثير

من الناس في MO.

الأهم من ذلك ، نحن بحاجة إلى فهم قيود الذكاء الاصطناعي والنقاط التي لا يزال يتعين على الناس السيطرة عليها. بدلاً من رسم صورة غير واقعية لقدرات الذكاء الاصطناعي ، تحتاج إلى التراجع إلى الوراء

وفصل القدرات التكنولوجية الحقيقية للذكاء الاصطناعي عن السحر.

لفترة طويلة ،

اعتقد فيسبوك أن مشاكل مثل انتشار التضليل والتحريض على الكراهية يمكن التعرف عليها وإيقافها خوارزميًا. ولكن تحت ضغط من المشرعين ، وعدت الشركة بسرعة باستبدال خوارزمياتها

بجيش من 10000 مراجع بشري .

في الطب ، يدركون أيضًا أن الذكاء الاصطناعي لا يمكن اعتباره الحل لجميع المشاكل. كان برنامج

IBM Watson for Oncology عبارة عن منظمة العفو الدولية كان من المفترض أن يساعد الأطباء في مكافحة السرطان. وعلى الرغم من أنه تم تصميمه لتقديم أفضل التوصيات ، إلا أن الخبراء يجدون

صعوبة في الوثوق بالماكينة . ونتيجة لذلك ، تم

إغلاق البرنامج في معظم المستشفيات ، حيث جرت تجربته.

تنشأ مشاكل مماثلة في المجال التشريعي عندما

تم استخدام الخوارزميات في المحاكم الأمريكية لنطق الجمل. احتسبت الخوارزميات قيم المخاطر وأعطت القضاة

توصيات بشأن الأحكام. ولكن اتضح أن النظام يعزز التمييز العنصري الهيكلي ، وبعد ذلك تم التخلي عنه.

توضح هذه الأمثلة أنه لا توجد حلول قائمة على الذكاء الاصطناعي لكل شيء. إن استخدام الذكاء الاصطناعي من أجل الذكاء الاصطناعي في حد ذاته ليس دائمًا منتجًا أو مفيدًا. ليس من الأفضل حل كل مشكلة باستخدام الذكاء الآلي. هذا هو الدرس الأهم لكل من ينوي زيادة الاستثمارات في برامج تطوير الذكاء الاصطناعي الحكومية: جميع القرارات لها سعر ، وليس كل شيء يمكن أتمتة يحتاج إلى أتمتة.