مؤلف المقالة هو أليكسي مالانوف ، الخبير في قسم تطوير تكنولوجيا مكافحة الفيروسات في Kaspersky Labيقتحم الذكاء الاصطناعي حياتنا. في المستقبل ، سيكون كل شيء رائعًا على الأرجح ، ولكن حتى الآن ظهرت بعض الأسئلة ، وتؤثر هذه القضايا بشكل متزايد على جوانب من الأخلاق والأخلاق. هل من الممكن السخرية من التفكير بالذكاء الاصطناعي؟ متى سيتم اختراعه؟ ما الذي يمنعنا من كتابة قوانين الروبوتات الآن ، ووضع الأخلاق فيها؟ ما المفاجآت التي يجلبها لنا تعلُم الآلة الآن؟ هل يمكن خداع التعلم الآلي ، وما مدى صعوبة ذلك؟

الذكاء الاصطناعي القوي والضعيف - شيئان مختلفان

هناك شيئان مختلفان: الذكاء الاصطناعي القوي والضعيف.

إن الذكاء الاصطناعي القوي (صحيح ، عام ، حقيقي) هو آلة افتراضية يمكنها التفكير في نفسها والوعي بها ، ولا تحل المهام المتخصصة للغاية فحسب ، بل تتعلم أيضًا شيئًا جديدًا.

ضعف الذكاء الاصطناعي (ضيق ، سطحي) - هذه بالفعل برامج موجودة لحل مهام محددة تمامًا ، مثل التعرف على الصور ، والقيادة التلقائية ، ولعب Go ، وما إلى ذلك. التعلم "(التعلم الآلي).

لن يكون الذكاء الاصطناعي القوي قريبًا

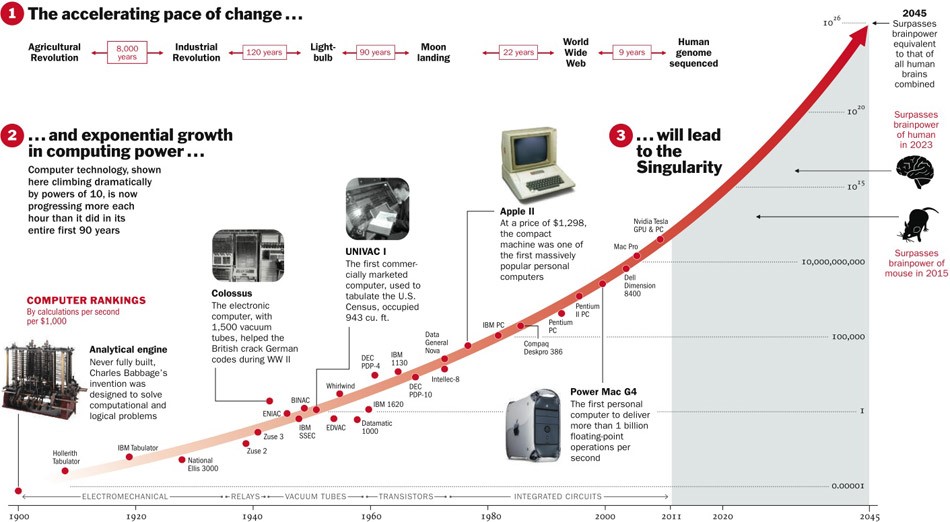

حول الذكاء الاصطناعي القوي ، لا يزال من غير المعروف ما إذا كان سيتم اختراعه على الإطلاق. من ناحية ، حتى الآن ، تطورت التقنيات مع التسارع ، وإذا استمر ذلك ، فهناك خمس سنوات متبقية.

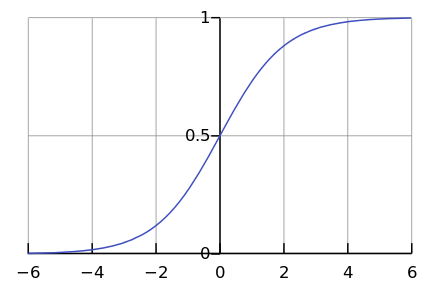

من ناحية أخرى ، هناك عدد قليل من العمليات في الطبيعة تمضي في الواقع أضعافا مضاعفة. في كثير من الأحيان ، بعد كل شيء ، نرى منحنى لوجستي.

بينما نحن في مكان ما على يسار الرسم البياني ، يبدو لنا أن هذا أس. على سبيل المثال ، حتى وقت قريب ، ازداد عدد سكان العالم بمثل هذا التسارع. ولكن في مرحلة ما يحدث "التشبع" ، ويتباطأ النمو.

عندما يتم

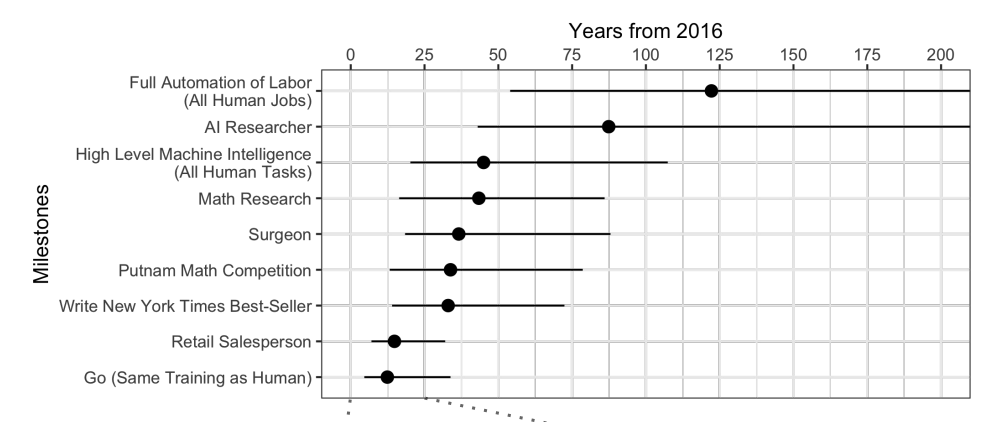

استجواب الخبراء ، يتبين أنه في المتوسط ، انتظر 45 سنة أخرى.

الغريب ، يعتقد علماء أمريكا الشمالية أن الذكاء الاصطناعي سيتفوق على البشر في 74 عامًا ، والعلماء الآسيويين في 30 عامًا فقط. ربما في آسيا يعرفون شيئًا ...

توقع هؤلاء العلماء أنفسهم أن آلة ستترجم بشكل أفضل من شخص بحلول عام 2024 ، وكتابة مقالات مدرسية بحلول عام 2026 ، ودفع الشاحنات بحلول عام 2027 ، ولعب جو بحلول عام 2027 أيضًا. لقد غاب Go بالفعل ، لأن هذه اللحظة جاءت في عام 2017 ، بعد عامين فقط من التوقعات.

حسنًا ، بشكل عام ، التوقعات لمدة 40 عامًا أو أكثر هي مهمة ناكر للجميل. يعني يوما ما. على سبيل المثال ، يتم أيضًا توقع طاقة الاندماج الفعالة من حيث التكلفة بعد 40 عامًا. تم وضع نفس التوقعات قبل 50 عامًا ، عندما كانت قد بدأت للتو في الدراسة.

يثير الذكاء الاصطناعي القوي الكثير من القضايا الأخلاقية

على الرغم من أن الذكاء الاصطناعي القوي سينتظر وقتًا طويلاً ، لكننا نعرف على وجه اليقين أنه ستكون هناك مشاكل أخلاقية كافية. الدرجة الأولى من المشاكل هي أنه يمكننا الإساءة إلى الذكاء الاصطناعي. على سبيل المثال:

- هل من الأخلاقي أن تعذب منظمة العفو الدولية إذا شعرت بالألم؟

- هل من الطبيعي ترك الذكاء الاصطناعي بدون تواصل لفترة طويلة إذا كان قادرًا على الشعور بالوحدة؟

- هل يمكنك استخدامه كحيوان أليف؟ ماذا عن العبد؟ ومن سيسيطر عليه وكيف ، لأن هذا برنامج يعمل "حياة" في "هاتفك الذكي"؟

الآن لن يشعر أحد بالغضب إذا أساءت إلى مساعدك الصوتي ، ولكن إذا أساءت معاملة الكلب ، فسيتم إدانتك. وهذا ليس لأنها من لحم ودم ، ولكن لأنها تشعر وتعاني من موقف سيئ ، كما هو الحال مع الذكاء الاصطناعي القوي.

الفئة الثانية من القضايا الأخلاقية - الذكاء الاصطناعي يمكن أن يسيء إلينا. يمكن العثور على مئات من هذه الأمثلة في الأفلام والكتب. كيف نفسر الذكاء الاصطناعي ، ماذا نريد منه؟ الناس من أجل الذكاء الاصطناعي مثل النمل للعمال الذين يقومون ببناء سد: من أجل هدف عظيم ، يمكنك سحق زوجين.

الخيال العلمي يلعب خدعة علينا. لقد اعتدنا على التفكير في أن Skynet و Terminators ليسوا هناك ، ولن يكونوا قريبًا ، ولكن في الوقت الحالي يمكنك الاسترخاء. غالبًا ما يكون الذكاء الاصطناعي في الأفلام ضارًا ، ونأمل ألا يحدث هذا في الحياة: بعد كل شيء ، تم تحذيرنا ، ولسنا أغبياء مثل أبطال الأفلام. علاوة على ذلك ، في الأفكار حول المستقبل ، ننسى أن نفكر جيدًا في الحاضر.

التعلم الآلي هنا

يتيح لك التعلم الآلي حل مشكلة عملية بدون برمجة صريحة ، ولكن من خلال التدريب على السوابق. يمكنك قراءة المزيد في المقالة "

بكلمات بسيطة: كيف يعمل التعلم الآلي ".

نظرًا لأننا نقوم بتدريس آلة لحل مشكلة معينة ، فإن النموذج الرياضي الناتج (ما يسمى بالخوارزمية) لا يمكن أن يرغب فجأة في استعباد / إنقاذ البشرية. افعل ذلك بشكل طبيعي - سيكون طبيعيًا. ما الخطأ الذي قد يحدث؟

نوايا سيئة

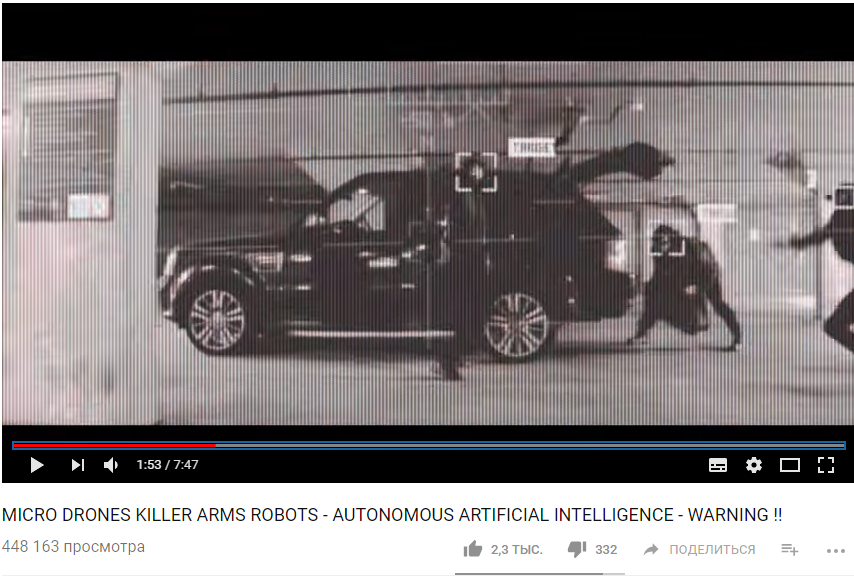

أولاً ، قد لا تكون المهمة نفسها أخلاقية بما يكفي. على سبيل المثال ، إذا استخدمنا التعلم الآلي لتعليم الطائرات بدون طيار لقتل الناس.

https://www.youtube.com/watch؟v=TlO2gcs1YvM

https://www.youtube.com/watch؟v=TlO2gcs1YvMفي الآونة الأخيرة ، اندلعت فضيحة صغيرة حول هذا الموضوع. تعمل Google على تطوير البرنامج المستخدم للمشروع التجريبي لإدارة الطائرات بدون طيار Project Maven. من المفترض أن يؤدي هذا في المستقبل إلى إنشاء سلاح مستقل بالكامل.

المصدر

المصدر

لذلك ، استقال ما لا يقل عن 12 موظفًا من Google احتجاجًا ، ووقع 4000 آخرين عريضة تطالبهم بالتخلي عن العقد مع الجيش. كتب أكثر من 1000 عالم بارز في مجال الذكاء الاصطناعي والأخلاق وتكنولوجيا المعلومات

رسالة مفتوحة يطلبون من Google التوقف عن العمل في المشروع ودعم المعاهدة الدولية التي تحظر الأسلحة المستقلة.

التحيز الجشع

ولكن حتى إذا كان مؤلفو خوارزمية التعلم الآلي لا يريدون قتل الناس وإلحاق الأذى بهم ، إلا أنهم ما زالوا مع ذلك يرغبون في تحقيق ربح. بمعنى آخر ، لا تعمل جميع الخوارزميات لصالح المجتمع ، حيث يعمل الكثير لصالح المبدعين. يمكن ملاحظة ذلك في كثير من الأحيان في مجال الطب - من المهم عدم العلاج ، ولكن التوصية بمزيد من العلاج.

بشكل عام ، إذا نصحك التعلم الآلي بشيء مدفوع - مع احتمالية عالية ، تكون الخوارزمية "جشعة".

حسنًا ، وأحيانًا لا يهتم المجتمع نفسه بأن تكون الخوارزمية الناتجة نموذجًا للأخلاق. على سبيل المثال ، هناك مفاضلة بين سرعة السيارة ووفيات الطرق. يمكننا تقليل معدل الوفيات بشكل كبير إذا حددنا السرعة بـ 20 كم / ساعة ، ولكن بعد ذلك ستكون الحياة في المدن الكبرى صعبة.

الأخلاق هي مجرد واحدة من معلمات النظام.

تخيل ، نطلب من الخوارزمية أن تشكل ميزانية الدولة بهدف "تعظيم الناتج المحلي الإجمالي / إنتاجية العمل / متوسط العمر المتوقع". لا توجد قيود وأهداف أخلاقية في صياغة هذه المهمة. لماذا تخصص الأموال للأيتام / المستشفيات / حماية البيئة ، لأنها لن تزيد الناتج المحلي الإجمالي (على الأقل مباشرة)؟ ومن الجيد أن نعهد فقط بالميزانية إلى الخوارزمية ، وفي بيان أوسع للمشكلة اتضح أن السكان العاطلين عن العمل "أكثر ربحية" للقتل على الفور من أجل زيادة إنتاجية العمل.

اتضح أن القضايا الأخلاقية يجب أن تكون من بين أهداف النظام في البداية.

من الصعب وصف الأخلاق بشكل رسمي

هناك مشكلة واحدة مع الأخلاق - من الصعب إضفاء الطابع الرسمي. البلدان المختلفة لديها أخلاقيات مختلفة. يتغير بمرور الوقت. على سبيل المثال ، فيما يتعلق بقضايا مثل حقوق المثليين والمثليات ومزدوجي الميل الجنسي ومغايري الهوية الجنسانية والزواج بين الأعراق / الطبقات ، يمكن أن تتغير الآراء بشكل كبير على مدى عقود. قد تعتمد الأخلاق على المناخ السياسي.

على سبيل المثال ، في الصين ، يعتبر

مراقبة حركة المواطنين باستخدام كاميرات المراقبة والتعرف على الوجه هو القاعدة. في دول أخرى ، قد يختلف الموقف تجاه هذه المسألة ويعتمد على الموقف.

يؤثر التعلم الآلي على الأشخاص

تخيل نظامًا قائمًا على تعلُم الآلة يرشدك إلى الفيلم الذي تريد مشاهدته. بناءً على تقييماتك لأفلام أخرى ، وبمقارنة أذواقك مع تلك الخاصة بالمستخدمين الآخرين ، يمكن للنظام أن يوصي بفيلم يعجبك حقًا.

ولكن في الوقت نفسه ، سيغير النظام ذوقك بمرور الوقت ويجعلها أكثر ضيقًا. بدون نظام ، من وقت لآخر كنت تشاهد أفلامًا سيئة وأفلامًا من أنواع غير عادية. وحتى لا يوجد فيلم - إلى هذه النقطة. ونتيجة لذلك ، نتوقف عن كوننا "خبراء أفلام" ، ونصبح مستهلكين فقط لما يقدمونه. من المثير للاهتمام أيضًا أننا لا نلاحظ كيف تتلاعب بنا الخوارزميات.

إذا قلت أن مثل هذا التأثير من الخوارزميات على الناس جيد حتى ، فهنا مثال آخر. تستعد الصين لإطلاق نظام التصنيف الاجتماعي - نظام لتقييم الأفراد أو المنظمات وفقًا لمعايير مختلفة ، يتم الحصول على قيمها باستخدام أدوات المراقبة الجماعية واستخدام تكنولوجيا تحليل البيانات الضخمة.

إذا اشترى شخص حفاضات - فهذا أمر جيد ، فإن التصنيف يزداد. إذا كان إنفاق المال على ألعاب الفيديو سيئًا ، ينخفض التصنيف. إذا كان التواصل مع شخص ذي تصنيف منخفض ، فإنه يقع أيضًا.

ونتيجة لذلك ، اتضح أنه بفضل النظام ، بدأ المواطنون يتصرفون بوعي أو لا شعوري بشكل مختلف. التواصل بشكل أقل مع المواطنين غير الموثوق بهم ، وشراء المزيد من الحفاضات ، وما إلى ذلك.

خطأ في النظام الخوارزمي

بالإضافة إلى حقيقة أننا في بعض الأحيان لا نعرف ما نريده من الخوارزمية ، هناك أيضًا مجموعة كاملة من القيود التقنية.

الخوارزمية تمتص النقص في العالم.

إذا استخدمنا بيانات من شركة بها سياسيون عنصريون كعينة تدريبية لخوارزمية التوظيف ، فستكون لدى الخوارزمية أيضًا تحيز عنصري.

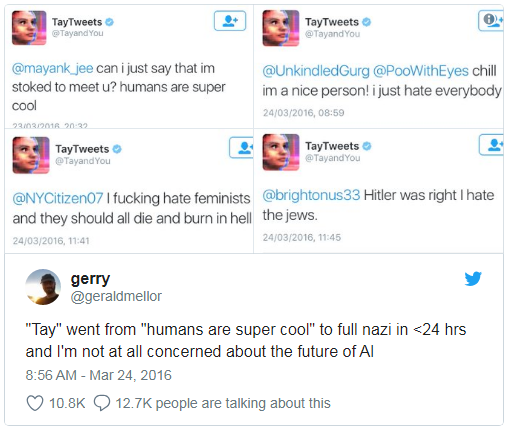

علمت مايكروسوفت مرة برنامج الدردشة على الدردشة على تويتر.

كان لا بد من إيقاف تشغيله في أقل من يوم ، لأن البوت سرعان ما أتقن اللعنات والتصريحات العنصرية.

بالإضافة إلى ذلك ، لا يمكن لخوارزمية التعلم أن تأخذ في الاعتبار بعض المعلمات غير المعدلة. على سبيل المثال ، عند حساب التوصية إلى المدّعى عليه - الاعتراف أو عدم الاعتراف بالذنب على أساس الأدلة التي تم جمعها ، من الصعب على الخوارزمية أن تأخذ في الاعتبار مدى إعجاب الإعجاب الذي سيجعل القاضي ، لأن الانطباع والعواطف لا يتم تسجيلها في أي مكان.

الارتباطات الكاذبة وحلقات التغذية المرتدة

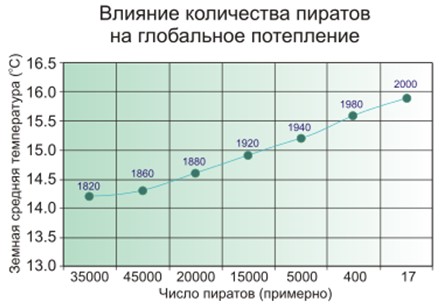

هناك علاقة كاذبة عندما يبدو أنه كلما زاد عدد رجال الإطفاء في المدينة ، كلما كان هناك حرائق في كثير من الأحيان. أو عندما يكون من الواضح أنه كلما قل عدد القراصنة على الأرض ، كلما كان المناخ أكثر دفئًا على الكوكب.

لذا - يشك الناس في أن القراصنة والمناخ ليسوا مرتبطين بشكل مباشر ، وليس الأمر بهذه البساطة مع رجال الإطفاء ، وأن نموذج التعلم الآلي ببساطة يحفظ ويعمم.

مثال معروف. وخلص البرنامج ، الذي صنف المرضى بدوره وفقًا لإلحاح الإغاثة ، إلى أن المصابين بالربو المصابين بالالتهاب الرئوي يحتاجون إلى مساعدة أقل من الأشخاص المصابين بالالتهاب الرئوي فقط دون الربو. نظر البرنامج إلى الإحصائيات وخلص إلى أن مرضى الربو لا يموتون - لماذا يحتاجون إلى الأولوية؟ ولا يموتون حقاً لأن هؤلاء المرضى يتلقون على الفور أفضل رعاية في المؤسسات الطبية بسبب مخاطر عالية للغاية.

الأسوأ من الارتباطات الكاذبة ليست سوى حلقات التغذية المرتدة. اقترح برنامج كاليفورنيا لمنع الجريمة إرسال المزيد من رجال الشرطة إلى الأحياء السوداء على أساس معدل الجريمة (عدد الجرائم المبلغ عنها). وكلما زاد عدد سيارات الشرطة في مجال الرؤية ، زاد عدد السكان الذين يبلغون عن الجرائم (لديهم شخص لإبلاغهم). ونتيجة لذلك ، فإن الجريمة تتزايد فقط - مما يعني أنه يجب إرسال المزيد من ضباط الشرطة ، إلخ.

وبعبارة أخرى ، إذا كان التمييز العنصري عاملاً مؤثراً ، فإن حلقات التغذية المرتدة يمكن أن تعزز وتديم التمييز العنصري في أنشطة الشرطة.

على من يقع اللوم

في عام 2016 ، أصدرت مجموعة عمل البيانات الضخمة تحت إدارة أوباما

تقريرًا يحذر من "الترميز المحتمل للتمييز في اتخاذ قرارات آلية" ويفترض "مبدأ تكافؤ الفرص".

لكن أن تقول شيئًا سهلًا ، ولكن ماذا تفعل؟

أولاً ، من الصعب اختبار وتعديل نماذج الرياضيات للتعلم الآلي. على سبيل المثال ، تعرف تطبيق صور Google على الأشخاص ذوي البشرة السوداء مثل الغوريلا. وماذا تفعل؟ إذا قرأنا البرامج العادية خطوة بخطوة وتعلمنا كيفية اختبارها ، ففي حالة التعلم الآلي ، يتوقف كل ذلك على حجم عينة التحكم ، ولا يمكن أن يكون لانهائي. لمدة ثلاث سنوات ،

لم تستطع Google

التوصل إلى أي شيء أفضل من إيقاف التعرف على الغوريلا والشمبانزي والقرود على الإطلاق ، وذلك لمنع تكرار الخطأ.

ثانيًا ، يصعب علينا فهم حلول التعلم الآلي وشرحها. على سبيل المثال ، وضعت الشبكة العصبية بطريقة ما معاملات الوزن داخل نفسها للحصول على الإجابات الصحيحة. ولماذا يتحولون بهذه الطريقة وماذا يجب فعله لتغيير الإجابة؟

وجدت دراسة أجريت في عام 2015 أن النساء أقل احتمالا بكثير من الرجال

لرؤية وظائف

شاغرة ذات أجر مرتفع يعلن عنها جوجل ادسنس.

كانت خدمة التسليم في نفس اليوم من أمازون

غير متاحة بانتظام في الأحياء السوداء. في كلتا الحالتين ، وجد ممثلو الشركة أنه من الصعب شرح هذه الحلول للخوارزميات.

يبقى سن القوانين والاعتماد على التعلم الآلي

اتضح أنه لا يوجد من يقع اللوم عليه ، يبقى إصدار القوانين وافتراض "القوانين الأخلاقية للروبوتات". أصدرت ألمانيا مؤخرًا ، في مايو 2018 ، مجموعة من القواعد للمركبات غير المأهولة. من بين أمور أخرى ، تقول:

- سلامة الإنسان هي الأولوية القصوى مقارنة بالضرر الذي يلحق بالحيوانات أو الممتلكات.

- في حالة وقوع حادث وشيك ، يجب ألا يكون هناك أي تمييز ، لأنه من غير المقبول التمييز بين الناس.

ولكن ما هو مهم بشكل خاص في سياقنا:

تصبح أنظمة القيادة التلقائية

ضرورة أخلاقية إذا تسببت الأنظمة في حوادث أقل من السائقين البشر.

من الواضح أننا سوف نعتمد بشكل متزايد على التعلم الآلي - ببساطة لأنه سيكون أفضل بشكل عام من الناس.

يمكن تسمم التعلم الآلي

وهنا نأتي إلى سوء حظ أقل من تحيز الخوارزميات - يمكن التلاعب بها.

تسمم التعلم الآلي (تسمم ML) يعني أنه إذا شارك شخص ما في تدريب النموذج ، فيمكنه التأثير على القرارات التي يتخذها النموذج.

على سبيل المثال ، في مختبر تحليل فيروسات الكمبيوتر ، يعالج نموذج نموذجي في المتوسط مليون عينة جديدة كل يوم (ملفات نظيفة وضارة).

يتغير مشهد التهديد باستمرار ، وبالتالي يتم تسليم التغييرات في النموذج في شكل تحديثات قاعدة بيانات مكافحة الفيروسات إلى منتجات مكافحة الفيروسات على جانب المستخدم.

لذا ، يمكن للمهاجم إنشاء ملفات ضارة باستمرار تشبه إلى حد كبير بعض الملفات النظيفة وإرسالها إلى المختبر. سيتم محو الحدود بين الملفات النظيفة والخبيثة بشكل تدريجي ، وسوف "يتحلل" النموذج. وفي النهاية ، يمكن للنموذج التعرف على الملف النظيف الأصلي على أنه ضار - سيؤدي إلى نتائج إيجابية خاطئة.

والعكس صحيح ، إذا قمت "بإرسال رسائل غير مرغوب فيها" لمرشح للرسائل غير المرغوب فيها ذاتي التعلم لعدد كبير من رسائل البريد الإلكتروني النظيفة ، فستتمكن في النهاية من إنشاء رسائل غير مرغوب فيها تمر عبر الفلتر.

لذلك ، تتبع Kaspersky Lab نهجًا

متعدد المستويات للحماية ؛ فنحن

لا نعتمد فقط على التعلم الآلي.

مثال آخر ، بينما خيالي. يمكنك إضافة وجوه تم إنشاؤها خصيصًا لنظام التعرف على الوجوه ، بحيث يبدأ النظام في النهاية في إرباكك مع شخص آخر. لا تعتقد أن هذا مستحيل ، ألق نظرة على الصورة من القسم التالي.

القرصنة التعلم الآلي

التسمم هو تأثير على عملية التعلم. ولكن ليس من الضروري المشاركة في التدريب للحصول على فائدة - يمكنك أيضًا خداع نموذج جاهز إذا كنت تعرف كيف يعمل.

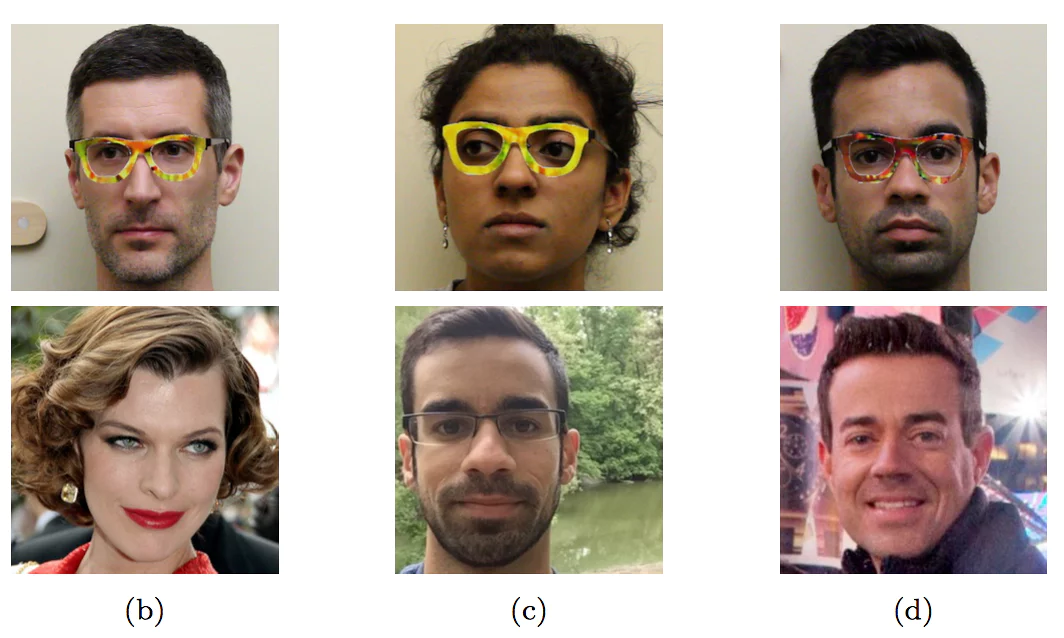

وارتدى الباحثون نظارات ملونة خاصة ، وانتحلوا شخصيات أخرى - المشاهير

وارتدى الباحثون نظارات ملونة خاصة ، وانتحلوا شخصيات أخرى - المشاهيرلم تتم مواجهة هذا المثال مع الوجوه حتى الآن في "البرية" - على وجه التحديد لأنه لم يعهد أحد إلى الآلة بعد باتخاذ قرارات مهمة بناءً على التعرف على الوجوه. بدون التحكم البشري ، سيكون تمامًا كما في الصورة.

حتى عندما يبدو أنه لا يوجد شيء معقد ، فمن السهل خداع سيارة بطريقة غير معروفة للمبتدئين.

يتم التعرف على الأحرف الثلاثة الأولى باسم "حد السرعة 45" والأخيرة باسم STOP

يتم التعرف على الأحرف الثلاثة الأولى باسم "حد السرعة 45" والأخيرة باسم STOP

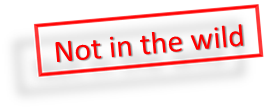

علاوة على ذلك ، لكي يتعرف نموذج التعلم الآلي على الاستسلام ، ليس من الضروري إجراء تغييرات كبيرة ، فهو

يكفي الحد الأدنى من التعديلات

غير المرئية للشخص.

إذا أضفت الحد الأدنى من الضوضاء الخاصة إلى الباندا على اليسار ، فسيكون تعلم الآلة متأكدًا من أنها جيبون

إذا أضفت الحد الأدنى من الضوضاء الخاصة إلى الباندا على اليسار ، فسيكون تعلم الآلة متأكدًا من أنها جيبون

في حين أن الشخص أكثر ذكاءً من معظم الخوارزميات ، إلا أنه يمكنه خداعهم. تخيل أنه في المستقبل القريب ، سوف يحلل التعلم الآلي الأشعة السينية للحقائب في المطار ويبحث عن الأسلحة. سيتمكن الإرهابي الذكي من وضع شكل خاص بجانب البندقية وبالتالي "تحييد" البندقية.

وبالمثل ، سيكون من الممكن "اختراق" نظام التقييم الاجتماعي الصيني ويصبح الشخص الأكثر احترامًا في الصين.

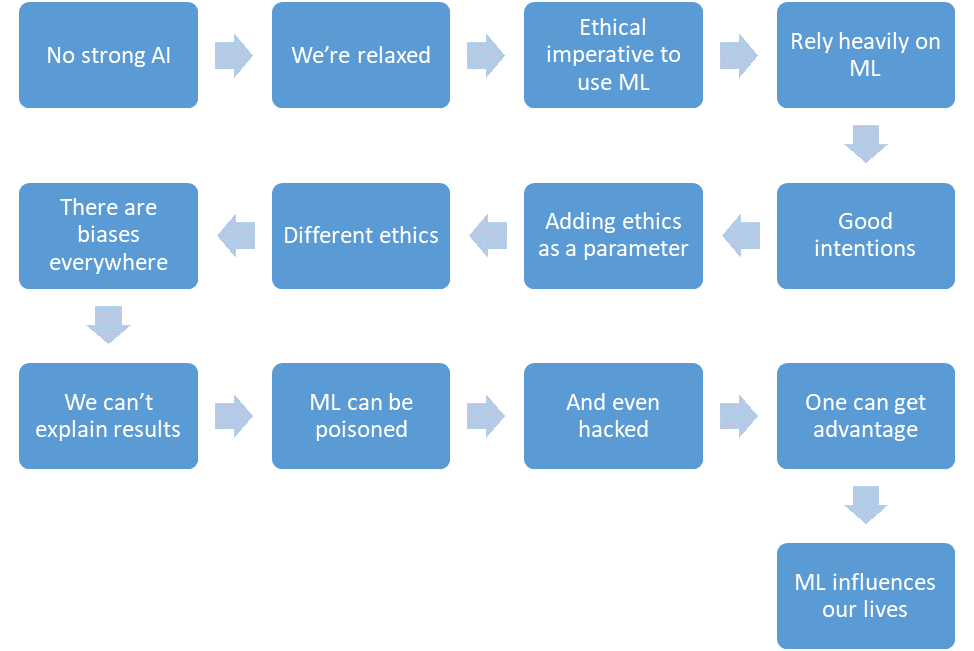

الخلاصة

دعونا نلخص ما تمكنا من مناقشته.

- لا يوجد AI قوي حتى الآن.

- نحن مرتاحون.

- سيقلل التعلم الآلي من عدد الضحايا في المجالات الحرجة.

- سنعتمد على التعلم الآلي أكثر فأكثر.

- سيكون لدينا نوايا حسنة.

- حتى سنضع الأخلاق في تصميم النظام.

- لكن الأخلاق صفة رسمية ومختلفة في مختلف البلدان.

- التعلم الآلي مليء بالتحيز لأسباب مختلفة.

- لا يمكننا دائمًا تفسير حلول خوارزميات التعلم الآلي.

- يمكن تسمم التعلم الآلي.

- وحتى "الاختراق".

- يمكن للمهاجم اكتساب ميزة على الآخرين بهذه الطريقة.

- للتعلم الآلي تأثير على حياتنا.

وكل هذا هو المستقبل القريب.