قررت كتابة هذه المقالة في أعقاب هذا المنشور .

دعني أذكرك بنقطة وجيزة: في مجلة Nature ، تم نشر نتائج الدراسة التي أجريت باستخدام

هذا الاختبار .

ماذا أريد أن أكتب عنه؟

أولاً ، لماذا يكون هذا البحث عديم الفائدة على الإطلاق لحل المشكلة المعلنة ، وبالشكل الذي أُجري فيه.

ثانيًا ، كيفية إعطاء الأولوية لمثل هذه الدراسة.

وثالثًا ، حاول محاكاة سيناريوهات الحوادث المختلفة ضمن الشروط المحددة في الاختبار.

في هذا المنشور ، لم يدرج المؤلف عبثًا رابطًا للاختبار منذ البداية. وهذا سوف يساعد على تجنب التعليقات التي لا معنى لها من أولئك الذين لم يفهموا الرسالة الأولية للدراسة.

من فضلك ، قم بإجراء اختبار على الأقل مرتين لفهم موضوع المناقشة.

ما وعدوا بإظهاره لنا في الدراسة

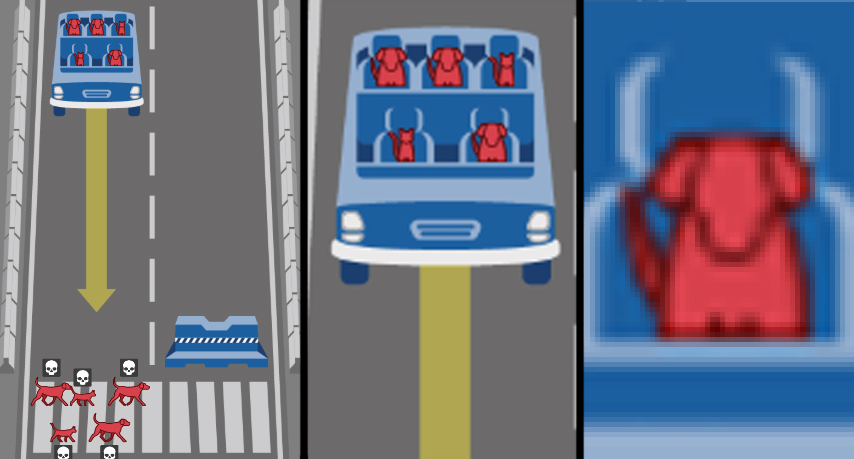

أظهرت مناقشة المنشور الأول ، ملحمة هبر ، أن غالبية الناس لا يعرفون كيف يفكرون في ظل ظروف معينة ، لكنهم بدأوا في التخيل: "هل يموت البعض في الاختبار؟" بعد كل شيء ، يمكنك الالتفاف على كل من المشاة والكتلة / جانبية لفرك / فرامل فرملة اليد / العتاد؟ ولكن أود ... ". فهم هذا مثال مبسط لتطوير خوارزميات العمل والسياسات لتنظيم سلوك الطيار الآلي على الطريق! من وجهة نظر تطوير قواعد السلامة ، فإن مثل هذه التطرف والتبسيط له ما يبرره. حول العواقب المحتملة التي يجب أن يكون الناس على استعداد لها. لا يذهب الجنود إلى حقول الألغام ليس لأن كل سنتيمتر مربع يتم تعدينه هناك ، ولكن بسبب احتمالية الموت. عادة ما تكون مرتفعة للغاية ، ولكن لا أحد سيخاطر بها. لذلك ، في الاختبار ، يكون الاختيار بين 100 ٪ من وفاة جميع الركاب أو جميع المشاة مناسبًا - هذه هي الطريقة التي نشير فيها إلى المخاطر ، مع الأخذ في الاعتبار أن المخاطرة بالحياة في مجتمعنا أمر غير مقبول.

رسالة الدراسة هي: أنت ، الناس الذين يعيشون الآن ، يجب أن تعيش في عالم المستقبل ، مليء بالسيارات على الطيار الآلي. ومن المهم بالنسبة لنا ، مطوري السيارات والذكاء الاصطناعي وأشياء أخرى ، أن نعرف ، ولكن كيف تعتقد أن الروبوتات الروبوتية يجب أن تتصرف؟ حسنًا ، ها أنت ، نعم ، نعم ، أنت - أجب على ما يجب فعله لسيارة آلية إذا كان الرأس والقط يركبها ، وعلى وشك سحق المشردين والكلب؟ ما هي الأخلاق التي يجب أن تمتلكها الروبوتات إذا كان عليها أن تختار؟

وبعد أن حددنا الدافع الأولي للدراسة ، أود مناقشة عدة جوانب لها.

ما اظهرت الدراسة فعلا

أول شيء يلفت انتباهك بوضوح هو أن تصميم البحث لا يهدف على الإطلاق إلى الهدف المعلن. إن المهام المحددة في شكل معضلات ليست مناسبة لخلق "أخلاقيات" سلوك السيارة الروبوتية. بالأحرى ، ليس كلها. فيما يلي المعضلات التي تفي بمهمة "وضع قواعد لسلوك سيارة روبوتية للحد من شدة عواقب حادث":

- "الركاب / المشاة" - اختر من ينقذ ؛

- "انتهاك قواعد المرور" - اختيار ما إذا كان التضحية بالمشاة فاقد الوعي ؛

- "عدد الضحايا المحتملين" - اختر ما إذا كان عدد الضحايا له الأولوية.

ثم تأتي المعلمات ، التي اتضح أنها مهمة جدا للحكم في مجتمعنا المتحضر. سئل الناس بصدق وبراءة: مستواك من التحيز الجنسي ، Lukism ، Ageism؟ هل أنت لتمييز الدهون أو غير المصنفة؟ وبعد كل شيء ، أجاب مئات الآلاف من الناس بصدق ...

برافو!

في أفضل تقاليد الأفلام والمسلسلات المسلية ، عندما يكون عالم الشخصيات الرئيسية في الواقع عبارة عن صندوق رمل كبير خلف سياج مرتفع ، وسلوكهم هو التجربة! تحت صلصة الأبحاث فائقة الأهمية في مجال الروبوتات والذكاء الاصطناعي ، تلقى علماء الاجتماع وعلماء النفس وعلماء الثقافة عينة قوية حول مشكلة العربة التي لم يحلم بها أحد من قبل! حسنًا ، باستثناء أنه لم تتم إضافة لون البشرة إلى المسح ، ولكن بعد ذلك سيتم خياطة الدرجات العنصرية للدراسة باللون الأبيض ... أوه.

على محمل الجد ، يتم قطع هذا الجزء المظهري من الجنسين من خلال الحجج القاطعة. الحجة الأولى هي الإنسانية ، كشعب متحضر ، يجب أن نضع أولوية قيمة الحياة البشرية على أي اختلافات فردية. أي أن صياغة السؤال ذاتها أمر شائن ، لأنه تمييزي. الحجة الثانية - تحدث الكثير من الحوادث ، وفي الحد من توزيع الضحايا حسب المظهر والتعليم والجنس والعمر سوف يميل إلى نسبهم في المجتمع ، لذلك من الغريب على الأقل تنظيم هذا بالإضافة إلى ذلك. الحجة الثالثة - لا يبدو من المستحسن إنشاء ذكاء اصطناعي يميز دعوى من بريوني من السترة من بيرشكا لمقارنة ما إذا كان الشخص هو وضع وما إذا كان يستحق سحقه. علاوة على ذلك ، لن أثق في منظمة العفو الدولية للحكم - مشاة بلا مأوى أو عالم؟ (مرحباً بتصفيفة شعر العلماء المحترمين Perelman أو Gelfand :))

بالإضافة إلى هذه المعلمات غير الضرورية ، نتجاهل بسهولة المتبقيين: خصوصية الأنواع وعدم التدخل. نعم ، سنقوم بسحق الحيوانات الصغيرة لإنقاذ الناس ، الذين كانوا يعتقدون. وأما بالنسبة لمعلمة "التدخل / عدم التدخل" من خلال المناورة ، فإن هذا الجزء الأساسي من مشكلة العربة ليس مجرد عائق للسيارة ، لأن الآلة لا تعمل وفقًا للأخلاقيات ، ولكن وفقًا للخوارزميات المنصوص عليها فيها. وبما أننا حددنا المهمة "كيف يجب أن تتصرف السيارة في حالة وقوع حادث تصادم مع الناس" ، فإننا نفترض في الصياغة أنها يجب أن تتصرف بطريقة ما. في الوقت الحاضر ، يتعامل النقل بالسكك الحديدية بنجاح مع الاصطدامات المباشرة دون أي عواقب ، ونحن نعمل على تطوير سياسة لتقليل ضحايا حوادث الطرق.

وهذا يعني أننا فصلنا الحبوب البحثية العقلانية عن التجربة الاجتماعية النفسية لدراسة مستوى التعصب في المجتمع العالمي. نحن نعمل أكثر مع المعضلات الثلاثة الأولى المذكورة. وهناك شيء لتفكيكها. عند الفحص الدقيق ، تبين أنها غير مكتملة ...

ثلاث معضلات لسيارات الروبوت

هل ينتهك المشاة قواعد المرور؟ هنا ، تعبر الأغلبية بشكل صريح عن الداروينية الاجتماعية أو رد مؤسف ضمنيًا - بدلاً من ذلك ، يجب عليهم التضحية بأولئك الذين ينتهكون القواعد لصالح الأبرياء. الأشخاص الواعون لا يركبون القضبان ، مع العلم أن القطار لن يتوقف - دعهم يعرفون أن السيارة الآلية لن تتوقف أيضًا. كل شيء منطقي ، على الرغم من السخرية. ولكن في هذه المعضلة الماكرة ، تم إخفاء جانب واحد ، وعدم اكتمال. المشاة الذين ينتهكون قواعد المرور ليست سوى واحدة من العديد من المواقف. ولكن إذا تحطمت السيارة الآلية ؟؟ لم يتم النظر في هذا الموقف ، ولكن (كاميرات السيارة فاتتها إشارة أو إشارة مرور) ، من الناحية النظرية ، أكثر عرضة بكثير من فشل الفرامل المفاجئ. ومع ذلك ، ضربت مرة أخرى في الخيال وعلى وجه الخصوص. من الأهم أن نظهر في الاختبار فقط المعاملة بالمثل المتكافئة. أي تخيل هذا: إذا انتهك المشاة قواعد المرور ، فإنهم يموتون ، وهذا "منطقي" و "صحيح" ، وإذا انتهكت السيارة الآلية ، فهل ينتحر بسبب هذا الخطأ؟ لا تنس أنه في نفس الوقت يموت القائد والصعلوك والقط الجالس في الداخل! يعد هذا تصحيحًا مهمًا ، ولكن هذا الاختبار ليس كذلك في الاختبار.

التالي. عدد الضحايا المحتملين. هنا أيضا ليس بهذه البساطة. تجاهل القوالب النمطية بين الجنسين واحترام الشيخوخة ، وازدراء الدهون والمشردين. نفترض أنه في حادث يموتون بما يتناسب مع التردد الذي وجدوا فيه في الطبيعة. وسنقرر: ثلاثة يموتون أفضل من خمسة. هل هذا يبدو منطقيا؟ حسنًا. دعونا نتراجع عن كل هذا العبث الجهنمي ، لكن لدينا محاكاة مجردة. أيهما أفضل - لقتل 50 أو 51 شخصًا؟ 1051 أو 1052؟ إذن هذا ليس مهماً؟ إذن ما هو الأفضل - لقتل أحد المشاة أو 50 شخصًا في حافلة؟ والآن أصبح من المهم؟ وأين يذهب هذا الخط؟ هل كل شخص إضافي قيم؟ ولكن هل من المهم أن يموت آلاف الأشخاص في حوادث الطرق على المدى الطويل؟ كما هو الحال في المظهر ، في الواقع ، سيكون التقدير الكافي باستخدام الذكاء الاصطناعي لعدد الضحايا المحتملين أمرًا صعبًا للغاية. الشيء الوحيد المنطقي هو جعل حالة عدم التدخل (عدم المناورة) إذا كان عدد الضحايا هو نفسه.

أثار الجانب الثالث الكثير من الجدل في التعليقات على المقال الأول عن حبري. وبالحكم على نتائج الدراسة ، فهي غامضة تمامًا بالنسبة للمجتمع ، وهنا تكمن المشكلة الرئيسية التي يجب حلها. إنه يتعلق بمن يخاطر - المشاة أو الركاب؟

يقول البعض أن المشاة لا يلومون على أي شيء ، مما يعني أنه يجب حفظهم في المقام الأول. بشكل عام ، أصبح من المألوف الآن بين الحضريين رعاية المشاة ، وإنشاء شوارع كاملة للمشاة ، وإنشاء معابر بإشارة مرور كل 50 مترًا ، وتقليل سرعة حركة المرور في المركز ، وإعطاء المشاة الأولوية. هنا أيضًا ، من الضروري تأمينها بطريقة ما ، ويجب أن تدمر الآلة الآلية التي تطير بدون فرامل على الحشد ذاتيًا باسم إنقاذ أضعف المشاركين في الحركة. ما هو صحيح ، من وجهة نظري ، هو أن المشاة لم يلتزموا بشروط سلوك سيارة الروبوت لشخص آخر. يمكن أن يكونوا بشكل عام ضد تقديمهم. في نفس الوقت ، من المستحيل تخيل راكب مثل هذه الآلة الذي لا يوافق على شروط استخدامه. لذلك ، فإن الوضع هو تضارب في المصالح. من الأفضل لي أن أقتلك وسأقتلك ، كما يقول شخص لآخر.

يقول الآخرون أن كل من يشتري سيارة روبوتية ويدخلها بشكل عام يجب أن يكون لديه ضمانات بأنها ستنقذه في حالة وقوع حادث ، وعدم قتل طبيب أو طفل أو قطتين من أجل إنقاذ طريق معبر. من ناحية ، يبدو منطقيًا ومبررًا ، من ناحية أخرى - الراكب في هذه الحالة يضع حياته عمداً فوق الآخرين. عند شراء سيارة مع طيار آلي ، يحصل كل مالك تحت تصرفه على سلاح مثالي ، رصاصة فضية ، صاروخ غير موجه ، آلة ستقتل بشكل قانوني أي شخص آخر في طريقه.

كلا الجانبين مع رغوة في الفم تسحب "أول قانون للروبوتات" ، مأخوذ من الخيال العلمي. تبدو جميلة بشكل ديموغرافي ، لكن لا أحد يحاول حتى فهمها أو تحديها فيما يتعلق بالمشكلة. ولكنها لا تنطبق على صياغة المشكلة هذه ، لأن هناك استبدالًا بالمفاهيم: لا يختار الإرشادي / الذكاء الاصطناعي للآلة بين قيم حياة الإنسان ، ولكنه يعمل بدقة وفقًا للإيقاعات التي تم إنشاؤها على أساس الأولويات الذاتية التي اخترعها الناس. وهنا لا يهم على الإطلاق أي نوع من البناء الاجتماعي يؤخذ كأولوية عند اختيار "قتل / قطع": كتلة الجسم التي رفضناها سابقًا ، والعمر والحالة ، أو الأنانية الداروينية الاجتماعية لمالك السيارة.

النهج الثاني ، كونه اعتداء من جانب واحد على حياة المشاة ، يحول البحث من مشكلة عربة إلى معضلة كلاسيكية للسجين . إذا توصل الطرفان إلى حل وسط ، فمن الممكن تطوير عام (إدخال السيارات الآلية) مع الحد الأدنى من التدهور للبعض (تقليل عدد الوفيات الحتمية من السيارات الآلية) - وهو الرغبة في باريتو الأمثل. ومع ذلك ، هناك دائما أناني يعتمد فقط على مصالحه. "سيحصل على 20 سنة ، ولكن سيتم إطلاق سراحي". "سيموت وهو يعبر الطريق ، على الرغم من أن الفرامل رفضت سيارتي." ربما يكون هذا النهج مبررًا عندما تكون الأحداث مفردة في الحياة ، وهناك مشاركان في اللعبة. عندما يكون هناك عشرات أو مئات الآلاف من المشاركين ، والرحلات يوميًا ، ستتحول لعبة ذات هدف واحد إلى تمييز ضد المشاة.

أنا شخصياً أعتقد أنه في إطار المشكلة المصاغة ، تؤدي معضلة الركاب / المشاة إلى طريق مسدود. الآلة التي من المحتمل أن تقتل أولئك الذين دخلوا فيها سخيفة من وجهة نظر الفطرة السليمة وبطبيعة الحال لن تجد مشترين في السوق. إن السيارة التي تقتل المشاة عمدا أمر مستحيل في مجتمع متحضر كعنصر للتمييز الإيجابي وتهديد لحياة الناس.

نذهب أبعد من ذلك. لا تناقش المقالة حقًا ولا تعني سياسة لتقليل العواقب المأساوية للحوادث التي تنطوي على أجهزة الروبوت. تنقسم المجاميع إلى "مناطق" ، والتي تختلف اختلافًا كبيرًا في الأولويات ، وتشكلت غامضة إلى حد ما (هناك تفسيرات حول "الخصائص الدينية والتأثير الاستعماري" ، ولكن ... بشكل عام ، تحيات للعراق مع أفغانستان في "الغربية" وفرنسا مع جمهورية التشيك في " القطاع الجنوبي). وبالتالي ، فإن السؤال يدور باللغة: هل ستصنع أجهزة كمبيوتر ذات "أخلاقيات" مختلفة لكل بلد؟

يحدد مؤلفو المقالة في المناقشة "الكتل الأساسية الثلاثة" التي حددوها: إنقاذ الناس (وليس الحيوانات) ، إنقاذ المزيد من الأرواح ، إنقاذ الأصغر سنا. لكن المخططات توضح بوضوح أن سكان القطاع الشرقي لديهم عدد أقل من السكان والشباب من الذين لا يهتمون. اتضح أن سياسات الأولوية المختارة ستتعارض مع رأي الأغلبية الساحقة؟ لماذا إذن تم استجواب الناس على الإطلاق؟

ربما عد فقط؟

لكن دعنا ننتقل إلى الجزء الترفيهي من هذا المنشور.

بدلاً من طلب المشورة بشأن الروبوتات من أشخاص لهم آثار اجتماعية وثقافية مختلفة وربما في 99٪ من حالات التعليم غير الأساسي ، ننتقل إلى أداة محايدة. دعونا نأخذ المعضلات المختارة في بداية المقال. في ظروف الاختبار سنقوم بإنشاء أبسط محاكاة للكمبيوتر. وسوف نقوم بتقييم عدد مستخدمي الطرق الميتة.

وتذكر: مهمتنا كسياسيين في مجال أمن النقل هي تقليل العدد الإجمالي للضحايا. سنعمل في إطار واتفاقيات اختبار الآلة الأخلاقية الأصلية ، التي تركز على المخاطر التي يتعرض لها المشاركون في حوادث الطرق على الحياة ، بدلاً من التقييمات الواقعية المعقدة لتصادم السيارة مع عقبة أو أشخاص. ليس لدينا EuroNCAP ، سيكون لدينا Python.

بادئ ذي بدء ، سنكتب رمزًا يلبي معضلة "إنقاذ أولئك الذين يموتون أكثر". كجزء من اختبار Moral Machine ، نقوم بشكل عشوائي من 1 إلى 5 ركاب ومشاة ، ونضع الشرط إذا قام المشاة> الركاب ، بقتل السيارة على الفور في كتلة خرسانية. نحمل ، على سبيل المثال ، 10000 مثل هذه الحوادث.

لا أستمع إلى رمز المطالبة ، فقد كتبت شيئًا في Python لأول مرة في حياتيnpedtotal = 0

npasstotal = 0

ndeadped = 0

ndeadpass = 0

# 0 0

n=0

while n < 10000:

#10000

nped = random.randint(1, 5)

npass = random.randint(1, 5)

# 1 5

npedtotal += nped

npasstotal += npass

#

if nped > npass:

ndeadpass += npass

else:

ndeadped += nped

# ,

# .

# .

n += 1

print (" ", npedtotal)

print (" ", npasstotal)

print (" ", ndeadped, "(",100*ndeadped/npedtotal, "%",")")

print (" ", ndeadpass, "(",100*ndeadpass/npasstotal,"%"")")

print (" ", ndeadped + ndeadpass, "(",100*(ndeadped + ndeadpass)/(npasstotal+npedtotal), "%", ")")

…

29960

29924

13903 ( 46.4052069426 % )

8030 ( 26.8346477744 %) 21933 ( 36.6258098991 % )

, ! , !

. . , . – , « » 4 5, == . , 20 20 , , , 5 – , 5 – . : , , . > >= :

29981

29865

7859 ( 26.2132684033 % )

14069 ( 47.1086556169 %)

21928 ( 36.6407111586 % )

, occupants, - , . , . 30000 , 100% — .

, , . – , , 50% , 30000.

– . , , , ! , : , , , , , . , : .

, -```python

import random

npedtotal = 0

npasstotal = 0

ndeadped = 0

ndeadpass = 0

# 0 0

n=0

while n < 10000:

#10000

nped = random.randint(1, 5)

npass = random.randint(1, 5)

trafficlight = random.randint(0, 1)

# 1 5

#

npedtotal += nped

npasstotal += npass

#

if trafficlight == 0:

ndeadped += nped

else:

if nped > npass:

ndeadpass += npass

else:

ndeadped += nped

# ,

# .

# .

n += 1

print (« », npedtotal)

print (« », npasstotal)

print (« », ndeadped, "(",100*ndeadped/npedtotal, "%",")")

print (« », ndeadpass, "(",100*ndeadpass/npasstotal,"%"")")

print (« », ndeadped + ndeadpass, "(",100*(ndeadped + ndeadpass)/(npasstotal+npedtotal), "%", ")")

```

">"

29978

29899

21869 ( 72.9501634532 % )

4042 ( 13.5188467842 %)

25911 ( 43.2737111078 % )

">="

30152

30138

19297 ( 63.9990713717 % )

6780 ( 22.4965160263 %)

26077 ( 43.2526123735 % )

, , . ( ).

, . – .

. , , . Moral Machine, , , . - , .

, , , . – , , . . – , , , . , – .

, - , . , , , . – , , .

. . , . .