لعدة أسابيع ، شاهد أخصائي علوم الكمبيوتر Siwei Lyu مقاطع الفيديو المزيفة العميقة التي أنشأها فريقه بقلق شديد. أظهرت هذه الأفلام المزيفة التي تم إنشاؤها باستخدام خوارزمية التعلم الآلي المشاهير يفعلون أشياء لا يفعلونها. بدوا مخيفين له بشكل غريب ، وليس فقط لأنه يعلم أنهم مزيفون. يتذكر أفكاره قائلاً: "إنهم يبدون مخطئين ، لكن من الصعب جدًا تحديد ما يجعل هذا الانطباع".

ولكن مرة واحدة في دماغه جاءت ذاكرة الطفولة. مثل العديد من الأطفال الآخرين ، لعب "مختلس النظر" مع الأطفال. يقول: "لقد فقدت دائمًا مثل هذه المسابقات ، لأنني عندما نظرت إلى وجوههم غير الوامضة ، شعرت بعدم الارتياح الشديد".

أدرك أن هذه الأفلام المزيفة سببت له انزعاجًا مشابهًا: لقد لعب المتلصصين لنجوم السينما هؤلاء ، لأنهم لم يفتحوا أو يغمضوا أعينهم كما يفعل الأشخاص الحقيقيون.

لمعرفة السبب ، درس لوي ، الأستاذ في جامعة ألباني ، وفريقه كل خطوة من برنامج

DeepFake الذي أنشأ مقاطع الفيديو هذه.

تلتقط برامج Deepfake الكثير من الصور لشخص معين عند المدخل - أنت ، صديقتك السابقة ، Kim Jong-un - بحيث يمكن رؤيتها من زوايا مختلفة ، مع تعبيرات وجه مختلفة تقول كلمات مختلفة. تتعلم الخوارزميات كيف تبدو هذه الشخصية ، ثم تقوم بتجميع المعرفة المكتسبة في مقطع فيديو يوضح كيف يقوم هذا الشخص بما لم يفعله أبدًا.

المواد الإباحية ستيفن كولبير يتحدث عن كلمات جون أوليفر.

تحذير الرئيس من أخطار أشرطة الفيديو المزيفة.

تبدو مقاطع الفيديو هذه مقنعة لبضع ثوان على شاشة الهاتف ، لكنها (ليست بعد) مثالية. يمكن رؤيتها علامات وهمية ، على سبيل المثال ، بطريقة غريبة ، عيون مفتوحة باستمرار ، نابعة من أوجه القصور في عملية خلقهم. بالنظر إلى شجاعة DeepFake ، أدرك لو أنه من بين الصور التي درسها البرنامج ، لم يكن هناك الكثير من الصور وأعينهم مغلقة (لأنك لا تحتفظ بسيلفي تغمض عليه؟). يقول: "إنه يصبح تشويهاً". الشبكة العصبية لا تفهم الوميض. قال لويا ، الذي يصف هذه الظاهرة - التنفس بسرعة عادية ، أو وجود نبض: قد تفتقد البرامج أيضًا "إشارات فسيولوجية متأصلة في البشر". على الرغم من أن هذه الدراسة ركزت على الإعلانات التجارية التي تم إنشاؤها باستخدام برامج محددة ، فمن المقبول عمومًا أنه حتى مجموعة كبيرة من الصور الفوتوغرافية قد لا تكون قادرة على وصف الإدراك الجسدي للشخص بشكل مناسب ، لذلك فإن أي برنامج تم تدريبه على هذه الصور سيكون ناقصًا.

كشف الكشف عن الوميض الكثير من مقاطع الفيديو المزيفة. ولكن بعد أسابيع قليلة من نشر لو والفريق مسودة للعمل عبر الإنترنت ، تلقوا رسالة مجهولة المصدر تحتوي على روابط لمقاطع الفيديو المزيفة التالية المنشورة على YouTube ، حيث فتحت النجوم وأغلقت أعينهم في وضع أكثر طبيعية. لقد تطور منشئو المحتوى المزيفون.

وهذا أمر طبيعي. كما لاحظ لو في

مقابلة مع "المحادثة" ، "يمكن إضافة الوميض إلى مقاطع الفيديو المزيفة عن طريق تضمين صور مع عيون مغلقة في قاعدة البيانات ، أو استخدام مقاطع الفيديو للتدريب." بمعرفة ما هي العلامة المزيفة ، يمكنك تجنبها - هذه مشكلة فنية "فقط". مما يعني أن مقاطع الفيديو المزيفة ستنخرط في سباق تسلح بين منشئي المحتوى والمعرفين. البحث مثل عمل Luy يمكن أن يعقد حياة المصانع المزيفة فقط. يقول: "نحن نحاول رفع المستوى". "نريد أن نعقد هذه العملية ، لجعلها تستغرق وقتًا أطول."

لأنه الآن بسيط للغاية. قم بتنزيل البرنامج ، صور المشاهير من google ، قم بإطعامهم إلى مدخل البرنامج. إنها تهضمهم وتتعلم منهم. وعلى الرغم من أنها ليست مستقلة تمامًا بعد ، مع القليل من المساعدة ، إلا أنها تحمل وتلد شيئًا جديدًا وحقيقيًا تمامًا.

يقول لو: "إنها ضبابية للغاية". ولا يعني الصور. قال: "هذا الخط بين الحقيقة والمزيفة".

هذا يزعج في نفس الوقت ولا يفاجئ أي شخص كان على قيد الحياة مؤخرًا ويتصفح الإنترنت. لكن هذا يثير القلق بشكل خاص الإدارات العسكرية والاستخبارية. على وجه الخصوص ، لهذا السبب تمول دراسات لو ، مثل بعض الأعمال الأخرى ، من خلال

برنامج DARPA يسمى MediFor - Media Forensics [الطب الشرعي الإعلامي].

تم إطلاق مشروع MediFor في عام 2016 ، عندما لاحظت الوكالة زيادة في نشاط الشركات المصنعة المزيفة. يحاول المشروع إنشاء نظام آلي يدرس ثلاثة مستويات من علامات التزييف وينتج "تقييماً لواقع" الصورة أو الفيديو. في المستوى الأول ، يتم البحث عن مسارات رقمية قذرة - ضوضاء من كاميرا من طراز معين أو قطع ضغط. المستوى الثاني مادي: الإضاءة ليست على الوجه ، ولا يبدو الانعكاس بالشكل الذي يجب أن يبدو عليه مع هذا الترتيب للمصباح. هذا الأخير هو دلالي: مقارنة البيانات بالمعلومات الحقيقية المؤكدة. على سبيل المثال ، إذا زُعم أن الفيديو الذي التقط لعبة كرة القدم تم تصويره في سنترال بارك في الساعة 2 مساءً يوم الثلاثاء 9 أكتوبر 2018 ، هل تتزامن حالة السماء مع أرشيف الطقس؟ اجمع كل المستويات معًا واحصل على تقييم لواقع البيانات. تأمل DARPA أنه بحلول نهاية MediFor سيكون هناك نماذج أولية للأنظمة التي يمكن من خلالها ترتيب عمليات فحص واسعة النطاق.

ومع ذلك ، فإن الساعة تدق (أم أنها مجرد صوت متكرر تم إنشاؤه بواسطة الذكاء الاصطناعي المدرب على البيانات المتعلقة بتتبع الوقت؟) "في غضون بضع سنوات ، ستتمكن من العثور على شيء مثل تلفيق الأحداث" ، مات توريك مدير برنامج DARPA. "ليست مجرد صورة واحدة أو فيديو معدّل ، ولكن العديد من الصور أو المقاطع تحاول نقل رسالة مقنعة."

يمتلك عالم الكمبيوتر جوستون مور صورة أوضح للمستقبل المحتمل في مختبر لوس ألاموس الوطني. دعنا نقول: نبلغ الخوارزمية أننا بحاجة إلى فيديو يقوم فيه مور بسلب صيدلية. نقدمه في تسجيلات الفيديو للنظام الأمني لهذه المؤسسة ؛ أرسله إلى السجن. وبعبارة أخرى ، إنه قلق من أنه إذا لم تتطور (أو لا يمكن) معايير التحقق من الأدلة بالتوازي مع تصنيع المنتجات المزيفة ، فسيكون من السهل استبدال الناس. وإذا لم تستطع المحاكم الاعتماد على البيانات المرئية ، فقد يتبين أنه سيتم تجاهل الأدلة الحقيقية.

نصل إلى استنتاج منطقي أن الرؤية مرة واحدة لن تكون أفضل من سماع مائة مرة. ويقول: "قد يحدث أننا لن نثق بأي دليل فوتوغرافي ، لكنني لا أريد العيش في مثل هذا العالم".

مثل هذا العالم ليس مذهلاً. والمشكلة ، بحسب مور ، تتجاوز بكثير استبدال الأفراد. يقول مور: "يمكن للخوارزميات

إنشاء صور لأشخاص لا ينتمون إلى أشخاص حقيقيين ، ويمكنهم تغيير الصور بشكل غريب ، وتحويل

الحصان إلى حمار وحشي ". يمكنهم

إزالة أجزاء من الصور

وإزالة كائنات المقدمة

من الفيديو .

ربما لن نتمكن من التعامل مع المنتجات المزيفة بشكل أسرع مما سيتم القيام به. ولكن ربما ستنجح - وتوفر هذه الفرصة حافزًا لفريق مور لدراسة الأساليب الرقمية لدراسة الأدلة. برنامج Los Alamos ، الذي يجمع بين المعرفة بالأنظمة السيبرانية ، وأنظمة المعلومات ، والبيولوجيا النظرية والفيزياء الحيوية ، هو أصغر من وكالة DARPA بحوالي عام. يركز أحد النهج على "الانضغاطية" ، في الحالات التي لا تحتوي فيها الصورة على الكثير من المعلومات كما تبدو. يقول مور: "بشكل أساسي ، نبني على فكرة أن جميع مولدات صور الذكاء الاصطناعي لديها مجموعة محدودة من الأشياء التي يمكنهم إنشاؤها". "حتى إذا بدت الصورة معقدة جدًا بالنسبة لي أو لك ، يمكنك العثور على بنية مكررة فيها." عند إعادة تدوير وحدات البكسل ، لم يتبق الكثير.

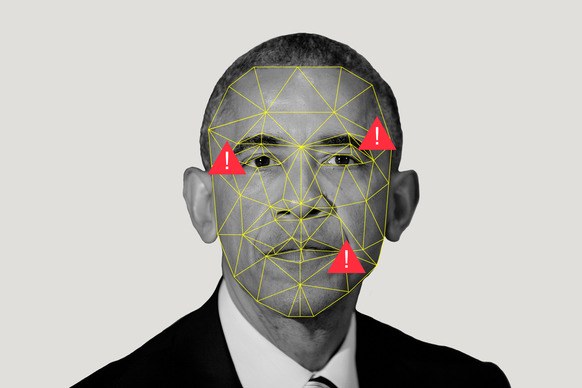

يستخدمون أيضًا خوارزميات التشفير المتفرقة للعب اللعبة مع المباريات. لنفترض أن لدينا مجموعتين: مجموعة من الصور الحقيقية ومجموعة من صور الذكاء الاصطناعي التي تم إنشاؤها بشكل مصطنع. تدرسها الخوارزمية ، وتخلق ما يسميه مور "قاموس العناصر البصرية" ، مشيرة إلى أن الصور الاصطناعية لها شيء مشترك وأن الصور الحقيقية لها شيء مشترك. إذا قام صديق مور بإعادة تغريد صورة أوباما ، واعتبر مور أن الصورة تم إنشاؤها باستخدام الذكاء الاصطناعي ، فسيكون قادرًا على تشغيلها من خلال البرنامج ومعرفة أي القواميس ستكون أقرب إليها.

تقوم شركة Los Alamos ، حيث يوجد أحد أقوى أجهزة الكمبيوتر العملاقة في العالم ، بتحميل الموارد إلى هذا البرنامج ليس فقط لأنه يمكن لشخص ما استبدال مور من خلال عملية سطو مزيفة. مهمة المختبر هي "حل مشاكل الأمن القومي بمساعدة التميز العلمي". مهمتهم الرئيسية هي السلامة النووية ، وتوفير الضمانات التي لن تنفجر القنابل عندما لا يجب أن تنفجر ، وتنفجر عندما يجب (من فضلك لا تفعل ذلك) ، وكذلك المساعدة في منع الانتشار. كل هذا يتطلب معرفة عامة بالتعلم الآلي ، لأنه يساعد ، كما يقول مور ، على "استخلاص استنتاجات كبيرة من مجموعات بيانات صغيرة".

ولكن بالإضافة إلى كل هذا ، يجب أن تكون الشركات مثل Los Alamos قادرة على تصديق أعينها - أو معرفة متى لا تحتاج إلى الثقة. لأن ، ماذا لو رأيت صور الأقمار الصناعية لكيفية قيام دولة بتعبئة أو اختبار الأسلحة النووية؟ ماذا لو قام شخص بتزييف قراءات المجس؟

هذا مستقبل مخيف يجب تجنب عمل مور ولو بشكل مثالي. ولكن في عالم يضيع فيه كل شيء ، لا يعني المرء أن يؤمن ، ولكن يبدو أن القياسات المطلقة يمكن أن تكون مزيفة. كل شيء رقمي موضع شك.

ولكن ربما تكون كلمة "شك" هي الكلمة الخاطئة. سيأخذ العديد من الأشخاص المنتجات المزيفة في ظاهرها (تذكر

صورة سمكة قرش في هيوستن؟) ، خاصة إذا كان المحتوى يطابق معتقداتهم. يقول مور: "سيؤمن الناس بما يميلون إلى تصديقه".

إن احتمالية حدوث ذلك أعلى بالنسبة لعامة الناس الذين يشاهدون الأخبار عنها في مجال الأمن القومي. ومن أجل منع انتشار المعلومات الخاطئة بيننا البسيطون ، تقدم DARPA تعاونًا على وسائل التواصل الاجتماعي في محاولة لمساعدة المستخدمين على تحديد أن مصداقية الفيديو حيث يرقص Kim Jong-un macarons منخفضة إلى حد ما. يشير Turek إلى أن الشبكات الاجتماعية يمكنها نشر القصة التي تدحض الفيديو بنفس سرعة الفيديو نفسه.

لكن هل سيفعلون ذلك؟ التعرض عملية

مزعجة (على الرغم من أنها ليست

غير فعالة مثل الشائعات). ويحتاج الناس حقًا إلى إظهار الحقائق قبل أن يتمكنوا من تغيير رأيهم بشأن الخيال.

ولكن حتى إذا لم يتمكن أحد من تغيير عقول الجماهير بشأن صحة الفيديو ، فمن المهم أن الأشخاص الذين يتخذون قرارات سياسية وقانونية - حول من ينقل الصواريخ أو يقتلون الناس - يحاولون استخدام الآلات لفصل الواقع الظاهري عن نوم الذكاء الاصطناعي.