datacenterknowledge.com

datacenterknowledge.comفي العام الماضي ، تم تنفيذ أكبر تثبيت للتخزين قائم على RAIDIX في الوقت الحالي. تم نشر نظام من 11 مجموعة تجاوز الفشل في معهد RIKEN لعلوم الحوسبة (اليابان). الغرض الرئيسي من النظام هو تخزين البنية التحتية HPC (HPCI) ، والتي يتم تنفيذها كجزء من التبادل الأكاديمي واسع النطاق للمعلومات الأكاديمية Cloud Academic (استنادًا إلى شبكة SINET).

من السمات الهامة لهذا المشروع حجمه الإجمالي 65 PB ، حيث يبلغ الحجم القابل للاستخدام للنظام 51.4 PB. لفهم هذه القيمة بشكل أفضل ، نضيف أن هذه هي 6512 قرصًا بسعة 10 تيرابايت لكل منها (الأحدث في وقت التثبيت). هذا كثير.

استمر العمل في المشروع على مدار العام ، وبعد ذلك استمر رصد استقرار النظام لمدة عام تقريبًا. استوفت المؤشرات التي تم الحصول عليها المتطلبات المذكورة ، والآن يمكننا التحدث عن نجاح هذا السجل ومشروع كبير بالنسبة لنا.

الكمبيوتر العملاق في مركز RIKEN Institute للحوسبة

بالنسبة لصناعة تكنولوجيا المعلومات والاتصالات ، يُعرف معهد RIKEN في المقام الأول باسمه "K-computer" الأسطوري (من "kei" الياباني ، والذي يعني 10 كوادريليون) ، والذي كان يعتبر وقت إطلاقه (يونيو 2011) أقوى حاسوب عملاق في العالم.

يساعد الكمبيوتر العملاق مركز العلوم الحاسوبية في تنفيذ البحوث المعقدة واسعة النطاق: فهو يسمح بنمذجة المناخ وظروف الطقس والسلوك الجزيئي وحساب وتحليل التفاعلات في الفيزياء النووية والتنبؤ بالزلازل وغير ذلك الكثير. تُستخدم أيضًا قدرات الحواسيب العملاقة لإجراء المزيد من البحوث "اليومية" والتطبيقية - للبحث عن حقول النفط واتجاهات الاتجاهات في أسواق الأسهم.

مثل هذه الحسابات والتجارب تولد كمية هائلة من البيانات التي لا يمكن المبالغة في قيمتها وأهميتها. لتحقيق أقصى استفادة من ذلك ، طور العلماء اليابانيون مفهوم مساحة معلومات واحدة حيث سيتمكن محترفو HPC من مراكز البحث المختلفة من الوصول إلى موارد HPC المستلمة.

البنية التحتية للحوسبة عالية الأداء (HPCI)

تعمل HPCI على أساس SINET (شبكة المعلومات العلمية) ، وهي شبكة أساسية لتبادل البيانات العلمية بين الجامعات اليابانية ومراكز البحث. يجمع SINET حاليًا حوالي 850 معهدًا وجامعة ، مما يخلق فرصًا هائلة لتبادل المعلومات في البحوث التي تؤثر على الفيزياء النووية وعلم الفلك والجيوديسيا وعلم الزلازل وعلوم الكمبيوتر.

HPCI هو مشروع بنية تحتية فريد يشكل نظامًا موحدًا لتبادل المعلومات في مجال الحوسبة عالية الأداء بين الجامعات ومراكز البحث في اليابان.

من خلال الجمع بين قدرات الكمبيوتر العملاق "K" ومراكز البحث الأخرى في شكل يمكن الوصول إليه ، يتلقى المجتمع العلمي فوائد واضحة للعمل مع البيانات القيمة التي تم إنشاؤها بواسطة حوسبة الكمبيوتر العملاق.

من أجل توفير وصول مشترك فعال لبيئة HPCI ، تم فرض متطلبات عالية على التخزين لسرعة الوصول. وبفضل "الإنتاجية المفرطة" للكمبيوتر K ، تم حساب مجموعة التخزين في مركز العلوم الحاسوبية لمعهد RIKEN ليتم إنشاؤها باستخدام حجم عمل لا يقل عن 50 PB.

تم بناء البنية التحتية لمشروع HPCI على رأس نظام ملفات Gfarm ، والذي سمح بمستوى عالٍ من الأداء ودمج مجموعات التخزين المتباينة في مساحة مشتركة واحدة.

نظام ملفات Gfarm

Gfarm هو نظام ملفات موزع مفتوح المصدر تم تطويره من قبل المهندسين اليابانيين. Gfarm هي ثمرة تطوير معهد العلوم والتكنولوجيا الصناعية المتقدمة (AIST) ، ويشير اسم النظام إلى الهندسة المعمارية التي تستخدمها Grid Data Farm.

يجمع نظام الملفات هذا بين عدد من الخصائص التي تبدو غير متوافقة:

- قابلية عالية في الحجم والأداء

- توزيع شبكة المسافات الطويلة مع دعم مساحة اسم واحدة للعديد من مراكز البحوث المتنوعة

- POSIX API Support

- الأداء العالي المطلوب للحوسبة المتوازية

- أمن تخزين البيانات

ينشئ Gfarm نظام ملفات افتراضي باستخدام موارد التخزين من خوادم متعددة. يتم توزيع البيانات بواسطة خادم بيانات التعريف ، ويتم إخفاء مخطط التوزيع نفسه عن المستخدمين. يجب أن أقول أن Gfarm لا يتألف فقط من مجموعة تخزين ، ولكن أيضًا شبكة حسابية تستخدم موارد نفس الخوادم. يشبه مبدأ تشغيل النظام Hadoop: يتم "تخفيض" العمل المقدم إلى العقدة حيث توجد البيانات.

بنية نظام الملفات غير متماثلة. يتم تخصيص الأدوار بوضوح: خادم التخزين ، خادم البيانات الوصفية ، العميل. ولكن في نفس الوقت ، يمكن أداء جميع الأدوار الثلاثة بواسطة نفس الجهاز. تخزن خوادم التخزين العديد من نسخ الملفات ، وتعمل خوادم البيانات الوصفية في وضع العبد الرئيسي.

عمل المشروع

نفذت Core Micro Systems ، الشريك الاستراتيجي والمورد الحصري لـ RAIDIX في اليابان ، التنفيذ في معهد RIKEN Institute of Computing Science Center. لتنفيذ المشروع ، استغرق الأمر حوالي 12 شهرًا من العمل الشاق ، حيث لم يكن فقط موظفو Core Micro Systems ، ولكن أيضًا المتخصصين التقنيين في فريق Reydix يشاركون بنشاط.

في الوقت نفسه ، بدا من غير المحتمل الانتقال إلى نظام تخزين آخر: كان لدى النظام الحالي الكثير من الارتباطات التقنية ، مما أدى إلى تعقيد الانتقال إلى أي علامة تجارية جديدة.

أثناء الاختبارات والفحوصات والتحسينات الطويلة ، أظهر RAIDIX أداء وكفاءة عالية باستمرار عند العمل مع مثل هذه الكمية الرائعة من البيانات.

حول التحسينات ، يجدر بنا أن نقول المزيد. كان من الضروري ليس فقط إنشاء تكامل أنظمة التخزين مع نظام ملفات Gfarm ، ولكن لتوسيع بعض الخصائص الوظيفية للبرنامج. على سبيل المثال ، من أجل تلبية المتطلبات المحددة للمواصفات الفنية ، كان من الضروري تطوير وتنفيذ تقنية الكتابة التلقائية في أقرب وقت ممكن.

كان نشر النظام نفسه منهجيا. أجرى المهندسون من Core Micro Systems بعناية ودقة كل مرحلة من مراحل الاختبار ، مما زاد تدريجياً من حجم النظام.

في أغسطس 2017 ، اكتملت مرحلة النشر الأولى عندما وصل حجم النظام إلى 18 بيتابايت. في أكتوبر من نفس العام ، تم تنفيذ المرحلة الثانية ، حيث ارتفع الحجم إلى مستوى قياسي 51 PB.

هندسة الحلول

تم إنشاء الحل من خلال دمج أنظمة تخزين RAIDIX ونظام الملفات الموزعة Gfarm. بالاشتراك مع Gfarm ، البعد عن إنشاء تخزين قابلة للتطوير باستخدام 11 أنظمة RAIDIX ذات وحدة تحكم مزدوجة.

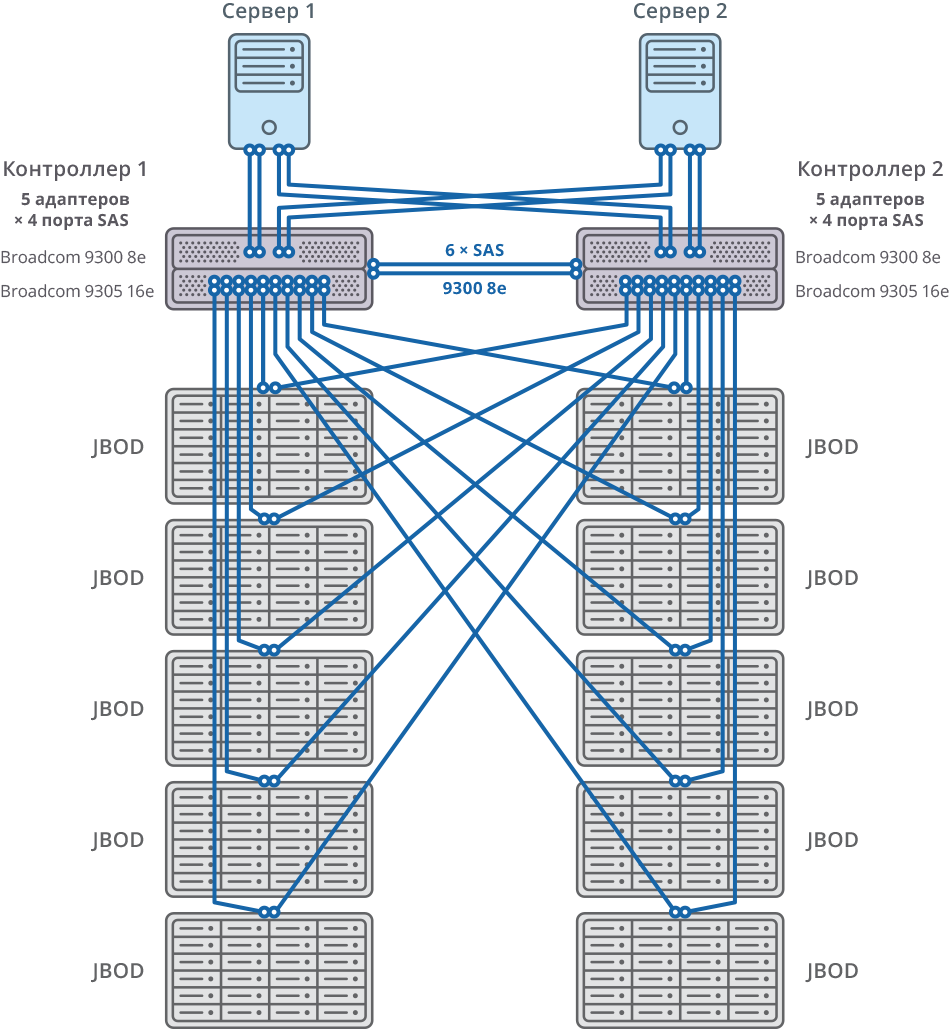

يتم الاتصال بخوادم Gfarm من خلال 8 x SAS 12G.

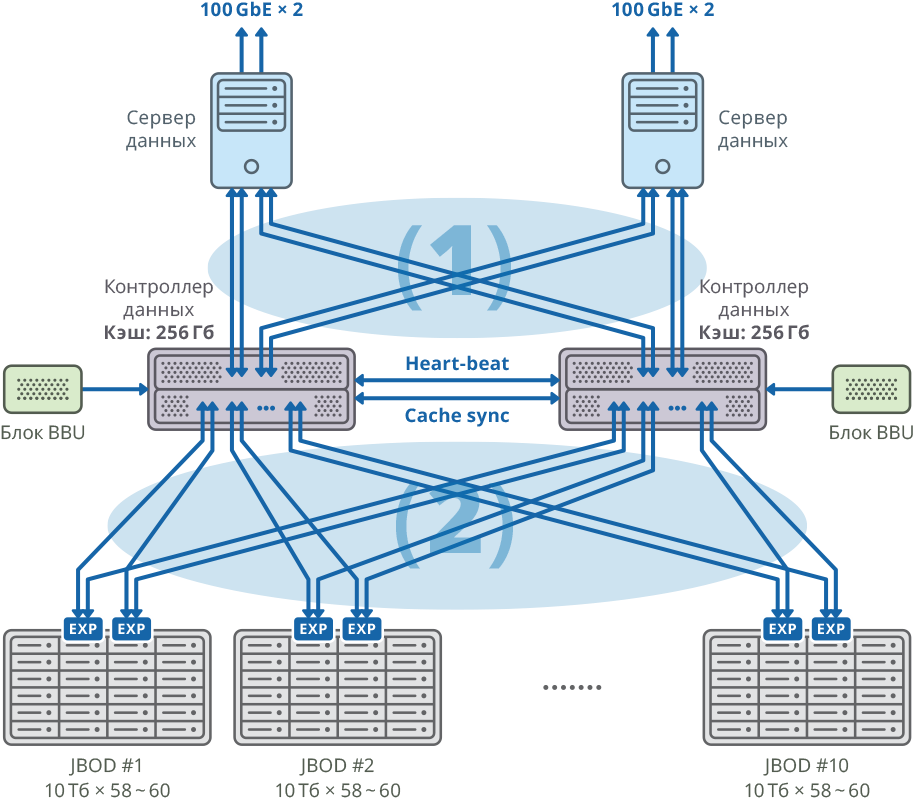

التين. 1. صورة لكتلة بها خادم بيانات منفصل لكل عقدة

التين. 1. صورة لكتلة بها خادم بيانات منفصل لكل عقدة(1) وصلات شبكة SAN بسرعة 48 جيجابت في الثانية × 8 ؛ عرض النطاق الترددي: 384Gbps

(2) وصلات شبكة بسرعة 48 جيجابت في الثانية × 40 شبكة ؛ عرض النطاق الترددي: 1920Gbps

تكوين منصة تحكم مزدوجة

| وحدة المعالجة المركزية | انتل زيون E5-2637 - 4 قطع |

| اللوحة الأم | متوافق مع طراز المعالج الذي يدعم PCI Express 3.0 x8 / x16 |

| ذاكرة التخزين المؤقت الداخلية | 256 جيجابايت لكل عقدة |

| الهيكل | 2U |

| وحدات تحكم SAS لتوصيل أرفف الأقراص والخوادم وكتابة مزامنة التخزين المؤقت | Broadcom 9305 16e و 9300 8e |

| الأقراص الصلبة | HGST Helium 10TB SAS HDD |

| مزامنة نبضات القلب | إيثرنت 1 جيجابت |

| مزامنة CacheSync | 6 × SAS 12G |

كلا العقدين من مجموعة تجاوز الفشل متصلان بـ 10 وحدات JBOD (60 قرصًا لكل منها 10 تيرابايت) من خلال 20 منفذ SAS 12G لكل عقدة. على أرفف الأقراص هذه ، تم إنشاء 58 صفائف RAID6 سعة 10 تيرابايت (8 أقراص بيانات (D) + 2 قرص تعادلي (P)) وتم تخصيص 12 قرصًا لـ "التبديل السريع".

10 JBOD => 58 × RAID6 (8 أقراص بيانات (D) + 2 قرص تعادل (P)) ، LUN من 580 HDD + 12 HDD من أجل "التبديل السريع" (2.06٪ من إجمالي الحجم)

592 محرك أقراص صلبة (10 تيرابايت SAS / 7.2 كيلو قرص صلب) لكل مجموعة * HDD: HGST (MTBF: 2500000 ساعة)

التين. 2. مجموعة تجاوز الفشل مع مخطط اتصال JBOD 10

التين. 2. مجموعة تجاوز الفشل مع مخطط اتصال JBOD 10النظام العام ومخطط الاتصال

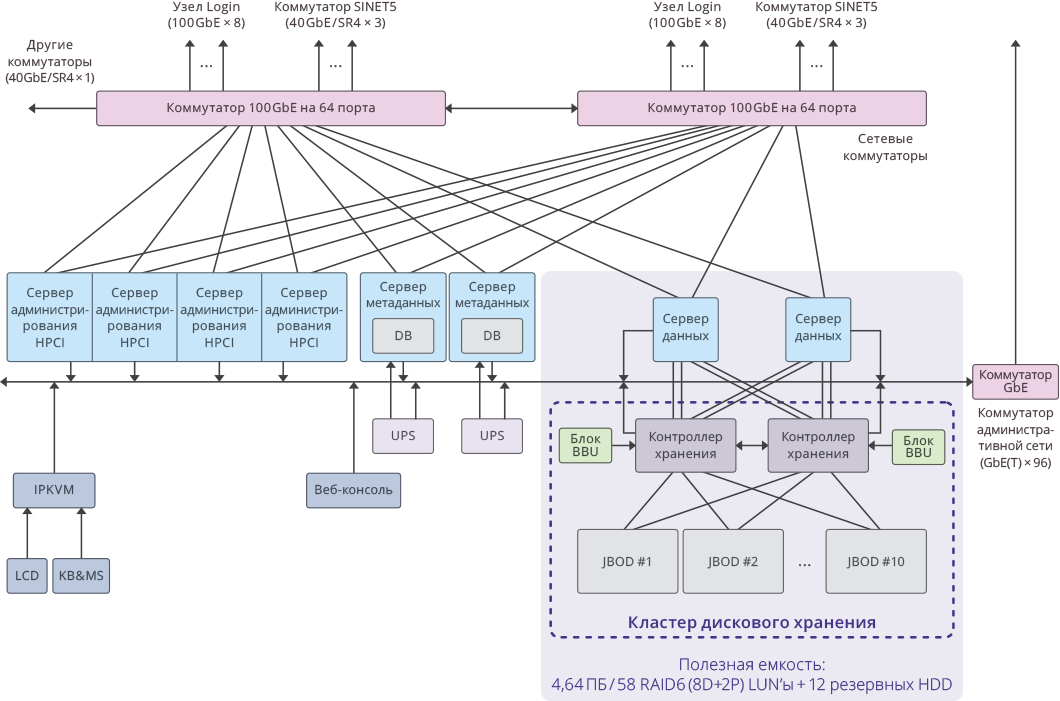

التين. 3. صورة عنقود واحد داخل نظام HPCI

التين. 3. صورة عنقود واحد داخل نظام HPCIمؤشرات المشروع الرئيسية

السعة القابلة للاستخدام لكل مجموعة: 4.64 PB ((RAID6 / 8D + 2P) LUN × 58)

السعة الإجمالية القابلة للاستخدام للنظام بأكمله: 51.04 PB (4.64 PB × 11 مجموعات).

إجمالي سعة النظام: 65 PB .

كان أداء النظام: 17 جيجابايت / ثانية للكتابة ، 22 جيجابايت / ثانية للقراءة.

الأداء الكلي للنظام الفرعي للكتلة على 11 نظام تخزين RAIDIX: 250 جيجابايت / ثانية .