جيسي باتاليا تحمل ابنها بينيت في منزلهما في رانش ميراج ، كاليفورنيا. بحثًا عن مربية جديدة ، بدأت Bataglia باستخدام Predictim ، وهي خدمة عبر الإنترنت من المفترض أن تستخدم "الذكاء الاصطناعي المتقدم" لتقييم المخاطر التي ستدمن بها المربية على المخدرات ، أو تتصرف بقوة أو تظهر "سلوكيات سيئة".

جيسي باتاليا تحمل ابنها بينيت في منزلهما في رانش ميراج ، كاليفورنيا. بحثًا عن مربية جديدة ، بدأت Bataglia باستخدام Predictim ، وهي خدمة عبر الإنترنت من المفترض أن تستخدم "الذكاء الاصطناعي المتقدم" لتقييم المخاطر التي ستدمن بها المربية على المخدرات ، أو تتصرف بقوة أو تظهر "سلوكيات سيئة".عندما بدأت جيسي باتاليا تبحث عن مربية جديدة لابنها البالغ من العمر عامًا واحدًا ، أرادت الحصول على مزيد من المعلومات حول الموظف أكثر من عدم وجود سجل جنائي وتعليقات أولياء الأمور والمقابلات الشخصية. لذلك ، انتقلت إلى خدمة Predictim عبر الإنترنت ، مستخدمة "الذكاء الاصطناعي المتقدم" لتقييم هوية المربية ، وأرسلت الماسحات الضوئية إلى آلاف المنشورات على Facebook و Twitter و Instagram لأحد المرشحين.

قدم النظام "تقييم مخاطر" تلقائي لفتاة تبلغ من العمر 24 عامًا ، مدعيا أن خطر تعاطي المخدرات لها "صغير جدًا". ومع ذلك ، صنف النظام خطر التخويف والعدوان وعدم الاحترام والأخلاق السيئة أعلى قليلاً - بنسبة 2 من 5.

النظام لا يفسر قراراته. ومع ذلك ، باتاغيليا ، الذي اعتبر المربية جديرة بالثقة تماما ، وبدأ فجأة للشك. وقال باتاليا ، البالغ من العمر 29 عامًا ، ويعيش الآن في إحدى ضواحي لوس أنجلوس: "وسائل التواصل الاجتماعي تُظهر هوية الشخص". "لماذا هي النتيجة 2 ، وليس 1؟"

تقدم Predictim للوالدين نفس الخدمات التي تبيعها العشرات من شركات التكنولوجيا الأخرى حول العالم لأصحاب العمل: أنظمة الذكاء الاصطناعي التي تحلل الكلام البشري وتعبيرات الوجه وتاريخ الوجود عبر الإنترنت ، بينما تعد بالكشف عن الجوانب السرية لحياتهم الشخصية.

تعمل التكنولوجيا على تغيير الطريقة التي تبحث بها بعض الشركات عن المرشحين ، وتوظيف العمال وتقييمهم ، وتقدم لأصحاب العمل تقييماً لا مثيل له للمرشحين من خلال موجة جديدة من التقييمات والمراقبة النفسية الغازية.

تزعم Fama أنها تستخدم الذكاء الاصطناعي لمراقبة الشبكات الاجتماعية للعمال من أجل "السلوك السام" لتنبيه رؤسائهم. تقدم HireVue ، وهي شركة تكنولوجيا توظيف تعمل مع شركات مثل Geico و Hilton و Unilever ، نظامًا يحلل تلقائيًا نغمة المرشح واختيار الكلمات وتعبيرات الوجه خلال مقابلة بالفيديو ، ويتوقع مهاراتهم وآدابهم (لتقديم نتائج أفضل ، يتم تقديم المرشحين أكثر ابتسم).

ومع ذلك ، يجادل النقاد بأن أنظمة مثل Predictim تنطوي على خطر في حد ذاتها ، وترك حلول تلقائية يمكن أن تغير حياة الشخص دون أي عمليات تفتيش.

تعتمد الأنظمة على خوارزميات تستند إلى الصندوق الأسود والتي لا تنتج أي تفاصيل تقريبًا حول كيفية قيامها بتخفيض جميع التفاصيل المعقدة للحياة الداخلية للشخص إلى حساب الجوانب الإيجابية والسلبية. على الرغم من أن تقنية Predictim تؤثر على تفكير أولياء الأمور ، إلا أنها تظل غير مثبتة تمامًا ، وغير مفسرة تقريبًا وعرضة للتشوهات الإدراكية المتعلقة بكيفية تصرف المربية الصحيحة تمامًا في الشبكات الاجتماعية ، والشكل والحديث.

وقال جيف تشيستر ، المدير التنفيذي لمركز الديمقراطية الرقمية ، وهي مجموعة للدفاع عن التكنولوجيا: "هناك سباق مجنون لاتخاذ قدرات الذكاء الاصطناعي واتخاذ جميع أنواع القرارات دون أي نوع من التقارير للناس". "يبدو أن الناس قد غمروا في المشروبات الغازية الرقمية ، ويعتقدون أنها طريقة طبيعية لإدارة حياتنا".

تقوم عملية المسح الضوئي Predictim بتحليل سلوك المربية بالكامل على الشبكات الاجتماعية ، والتي يمكن للعديد من أصغر المربيات الحصول على معظم حياتهم. في الوقت نفسه ، يتم إعلام المربيات بأنهم إذا رفضوا الخضوع لهذا الفحص ، فسيكون ذلك عائقًا خطيرًا في المنافسة على الوظائف.

قال الرئيس التنفيذي لشركة Predictim والمؤسس المشارك Sal Parsa إن الشركة ، التي تم إطلاقها الشهر الماضي كجزء من حاضنة بيركيلي التكنولوجية بجامعة كاليفورنيا في كاليفورنيا ، تأخذ على محمل الجد القضايا الأخلاقية لاستخدام التكنولوجيا الخاصة بها. وقال إنه يجب على الآباء اعتبار التقييم مستشارًا ، والذي "ربما يعكس ، وربما لا يعكس الخصائص الحقيقية للمربية".

وأضاف أن خطر استئجار مربية مشكلة أو عنيفة يجعل من الذكاء الاصطناعي أداة أساسية لأي والد يحاول الحفاظ على سلامة طفله.

وقال "ابحث في Google عن سوء استخدام المربيات وستجد مئات النتائج". - هناك أشخاص يعانون من مرض عقلي أو غاضب فقط. هدفنا هو بذل كل ما في وسعنا لمنعهم ".

تبدأ تكلفة مسح Predictim من 24.99 دولارًا ، وعليك أن تخبرها باسم المربية المحتملة وبريدها الإلكتروني ، بالإضافة إلى الحصول على موافقتها على الوصول الواسع إلى حساباتها على الشبكات الاجتماعية. يمكن للمربية أن ترفض ، وبعد ذلك يتلقى الوالدان إخطارًا بذلك ، وتتلقى المربية نفسها خطابًا يقول فيه "إن الوالد الذي يهتم بك لن يكون قادرًا على استئجارك حتى تمتثل للطلب".

يقول مديرو Predictim إنهم يستخدمون الخوارزميات لمعالجة اللغة والصور ، و "رؤية الكمبيوتر" ، وتقييم منشورات مربية على Facebook و Twitter و Instagram ، ويبحثون عن أدلة حول حياتها غير المتصلة بالإنترنت. يتم استلام التقرير فقط من قبل الوالد ، الذي لا يشترط مشاركة نتائجه مع المربية.

يمكن للوالدين إلقاء نظرة على حسابات المربية العامة على الشبكات الاجتماعية بأنفسهم. ومع ذلك ، تعد تقارير الكمبيوتر بتقديم تقييم عميق لسنوات النشاط عبر الإنترنت ، بحيث يتم تحويلها إلى رقم واحد: حل بسيط ومغري لمهمة مستحيلة تقريبًا.

تنقسم تقييمات المخاطر إلى عدة فئات ، بما في ذلك المحتوى العلني وتعاطي المخدرات. تدعي الشركة الناشئة أيضًا في الإعلان أن نظامها قادر على تقييم الخصائص الأخرى لشخصية المربية ، مثل المداراة ، والقدرة على العمل مع الآخرين و "الإيجابية".

وتأمل الشركة في إحداث ثورة في صناعة بمليارات الدولارات من "الاستعانة بمصادر خارجية المسؤوليات الأبوية" وبدأت بالفعل في الإعلان عن طريق رعاية بلوق الأبوة ومواقع "الأمهات". تركز استراتيجية التسويق على الفرصة المعلنة لكشف الأسرار ومنع "كابوس أي من الوالدين" ، ويستشهد الإعلان بقضايا جنائية ، بما في ذلك ، على سبيل المثال ، قضية مربية من كنتاكي أدين بأذى جسدي خطير لطفل عمره ثمانية أشهر.

يقول بيان التسويق للشركة: "إذا كان آباء هذه الفتاة المتأثرة بالممرضات يمكنهم استخدام Predictim في عملية الموافقة على المرشح ، فلن يتركوها بمفردها مع طفلهم الثمين."

ومع ذلك ، يقول خبراء التكنولوجيا أن النظام يصدر تحذيرات من تلقاء نفسه ، ويلعب على مخاوف الوالدين لبيع نتائج مسح الشخصية بدقة لا يمكن التحقق منها.

كما أنها تثير تساؤلات حول كيفية تدريب هذه النظم ومدى تعرضها للأخطاء التي يمكن أن تنشأ من حالات عدم اليقين المرتبطة باستخدام الشبكات الاجتماعية من قبل المربيات. يتم إعطاء الوالدين تحذيرا فقط من السلوك المشكوك فيه ، دون عبارات أو روابط أو تفاصيل أخرى يمكن من خلالها اتخاذ قرارهم.

عندما أصدر مسح لمربية أطفال تحذيراً حول احتمال اضطهادها من جانبها ، قالت أم متحمسة طلبت هذا التقييم إنها لا تستطيع معرفة ما إذا كان البرنامج قد لاحظ اقتباسًا من فيلم أو أغنية قديمة أو عبارة أخرى أخرى أخذتها بسبب عبارات خطيرة حقًا .

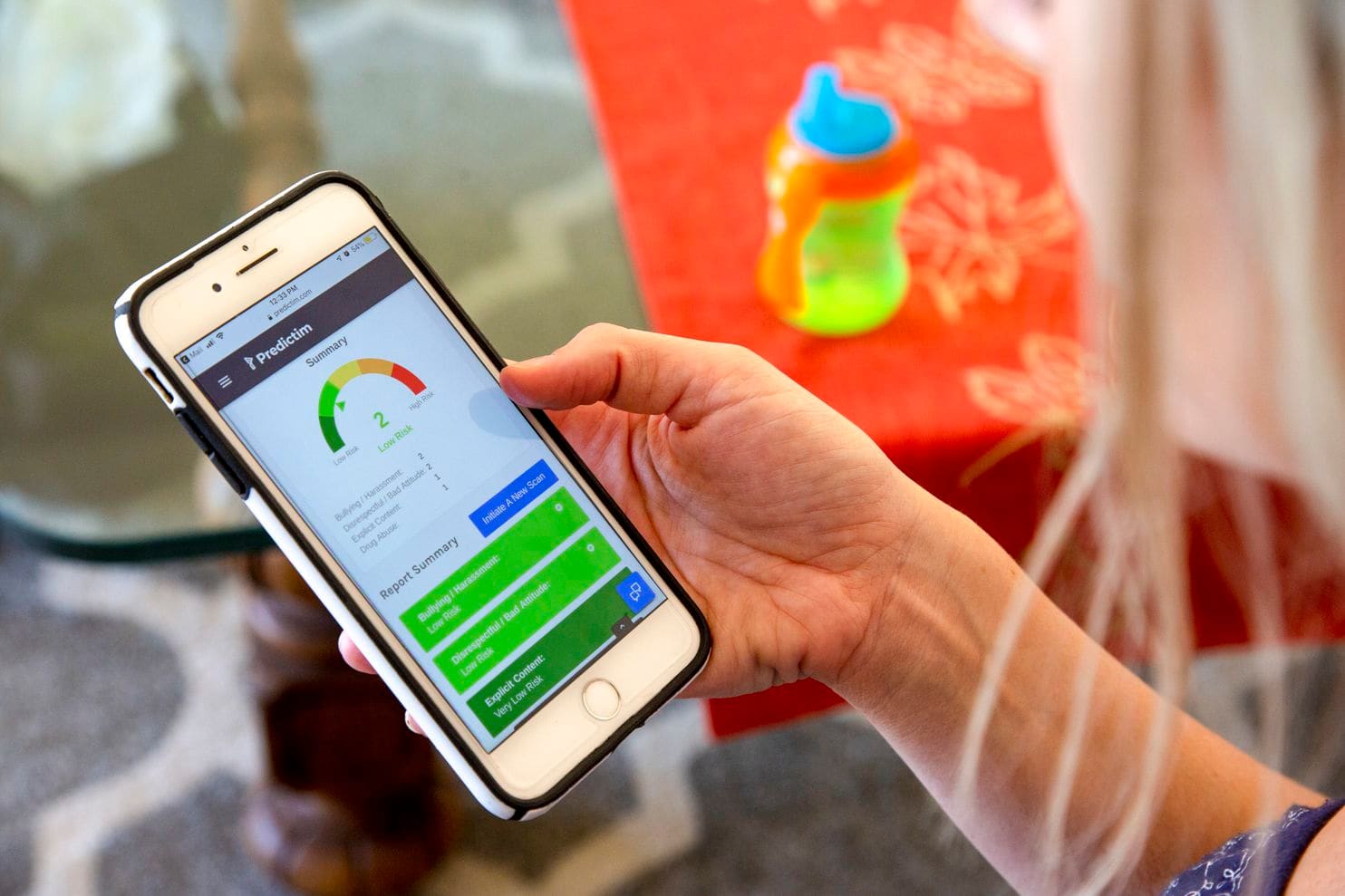

يوضح هاتف جيسي نتائج تطبيق Predictim

يوضح هاتف جيسي نتائج تطبيق Predictimقال جيمي ويليامز ، وهو محام في مؤسسة الحدود الإلكترونية ، وهي مجموعة حقوق مدنية ، إن معظم الخوارزميات المستخدمة اليوم لتقييم معنى الكلمات والصور معروفة بأنها تفتقر إلى السياق الإنساني والحس السليم. حتى عمالقة التكنولوجيا مثل Facebook واجهوا صعوبة في إنشاء خوارزميات يمكن أن تميز بين التعليقات غير الحميدة والغاضبة.

"كيف يمكنك تجربة هذا النظام لتقييم المراهقين: إنهم أطفال! - قال وليامز. - الأطفال لديهم النكات الخاصة بهم ، فهي تشتهر السخرية. "ما قد يعتبره الشخص من الخوارزمية" سلوكًا سيئًا "يمكن اعتباره بيانًا سياسيًا أو نقدًا شرعيًا."

وعندما يكون النظام خاطئًا - دعنا نقول ، القول إن المربية تعاطي المخدرات - لن يتمكن الآباء من معرفة الخطأ. يمكن أن تجعل التقييمات الواضحة وتقييمات دقة النظام الآباء يتوقعون منه مزيدًا من الدقة والاستبداد أكثر مما قد يعده أي شخص في مكانه. كنتيجة لذلك ، سوف يميل الآباء إلى توظيف المربيات الذين سيتجنبونهم ، أو الابتعاد عن الأشخاص الذين كسبوا ثقتهم بالفعل.

وقال ميراندا بوجن ، كبير المحللين في مركز ابتون بواشنطن ، الذي يدرس استخدام الخوارزميات لاتخاذ القرارات التلقائية والفصل في الأحكام "لا يوجد مقياس يمكن أن يقول بدقة ما إذا كانت هذه الأساليب فعالة في تنبؤاتها مثل ولاية المبدعين". . "من المرجح أن يتجاوز جاذبية هذه التقنيات قدراتها الحقيقية."

منحت ماليسا نيلسن ، وهي مربية تبلغ من العمر 24 عامًا تعمل في باتاغيليا ، لعائلتين أخريين الوصول إلى شبكاتها الاجتماعية للتقييم في Predictim. قالت إنها كانت دائمًا حذرة بشأن الشبكات الاجتماعية وقررت أن تتمكن من مشاركة معلومات إضافية دون الإضرار بنفسها. تذهب إلى الكنيسة أسبوعيًا ، ولا تقسم وتنتهي من تلقي تعليم المعلم في مجال تعليم الأطفال الصغار ، وبعد ذلك تأمل في افتتاح روضة أطفال.

ومع ذلك ، عندما علمت أن النظام لم يعطها علامات مثالية بناءً على عدم الاحترام والبلطجة ، فقد دهشت. لقد اعتقدت أن السماح للآباء بدراسة وجودها على الشبكات الاجتماعية ، وليس الخوارزمية - تحليل نقدي لشخصيتها. كما أنها لم تكن على علم بنتائج اختبار يمكن أن يلحق الضرر بمصدر دخلها الوحيد.

"أود أن أفهم هذه المسألة قليلاً. لماذا هذا البرنامج فكر بي هكذا؟ - قال نيلسن. "الكمبيوتر ليس لديه مشاعر ، ولا يمكنه اكتشاف كل ذلك".

لا يزال الأمريكيون لا يثقون في الخوارزميات التي يمكن أن تؤثر قراراتهم على حياتهم اليومية. في استطلاع للرأي أجراه مركز بيو للأبحاث هذا الشهر ، صنف 57 ٪ من المشاركين المعالجة التلقائية للسير الذاتية للمرشحين للوظائف على أنها "غير مقبولة".

ومع ذلك ، ذكرت Predictim أنهم يستعدون لتوسيع العمل في جميع أنحاء البلاد. يتحدث مديرو Sittercity ، وهي خدمة حاضنة للأطفال عبر الإنترنت يزورها ملايين الآباء ، عن إطلاق برنامج تجريبي يدمج التصنيفات التلقائية لـ Predictim في المجموعة الحالية من التصنيفات التلقائية وعمليات التحقق من الخدمة.

وقالت ساندرا داينورا ، رئيسة المنتج في Sittercity ، "إن العثور على مربية محفوف بعدم اليقين" ، ويعتقد أن مثل هذه الأدوات يمكن أن تصبح قريبًا في عمليات البحث على الإنترنت لمقدمي الرعاية. "الآباء يبحثون باستمرار عن أفضل الحلول ، والأكثر اكتمالا ، والحقائق الأكثر موثوقية."

يعتقد مدراء Predictim أيضًا أنه يمكنهم توسيع إمكانات النظام بشكل خطير وتقديم تقييمات شخصية أكثر لحياة المربية الخاصة. قال جويل سيمونوف ، مدير التكنولوجيا ، إن الفريق مهتم بالحصول على "بيانات القياس النفسي المفيدة" استنادًا إلى تحليل نشاط المربيات في الشبكات الاجتماعية ، وتمرير قصصهم من خلال اختبار الهوية ، على سبيل المثال ، تصنيف مايرز بريغز ، لتقديم هذه النتائج للآباء.

يشبه اهتمام وسائل الإعلام الاجتماعية و Predictim بالتحليل النفسي الشامل طموحات Cambridge Analytica ، وهي شركة استشارية سياسية عملت على دعم الحملة الانتخابية لترامب ومن ثم اشتركت في فضيحة هوية عالمية. ومع ذلك ، يزعم قادة Predictim أنهم أقاموا فحوصات أمنية داخلية ويعملون على حماية البيانات الشخصية للمربيات. "إذا كان لدينا تسرب بيانات مربية ، فإن هذا لن يكون بارد ،" قال سيمونوف.

يشعر الخبراء بالقلق من أن أنظمة التصنيف المعتمدة على الذكاء الاصطناعي تنذر بمستقبل يعتمد فيه تلقي الشخص لأي وظيفة لا تتعلق بالضرورة برعاية الطفل على الجهاز. العديد من شركات التوظيف والتوظيف تقوم بالفعل بإنشاء أو الاستثمار في أنظمة يمكنها تحليل السير الذاتية للمرشحين على نطاق واسع وإصدار تصنيفات المرشحين التلقائي. تُستخدم أنظمة AI مماثلة - بما في ذلك Jigsaw ، وهي حاضنة تقنية أنشأتها Google - لتتبع التعليقات عبر الإنترنت للمضايقة والتهديدات والقسوة.

ومع ذلك ، فقد ثبت بالفعل أكثر من مرة كيف أن الخوارزميات للعثور على الموظفين تخفي عيوبًا يمكن أن تدمر حياة الشخص. أوقفت Amazon.com تطوير خوارزمية التوظيف ، وعلمت أنها تقلل من شأن النساء ، لأن تاريخ التوظيف في الشركة ، الذي يتبع ميل صناعة التكنولوجيا لتوظيف الرجال ، قام بتدريس النظام لتفضيل المرشحين الذكور. وقالت الشركة أنها لم تستخدم هذا البرنامج قط لتقييم المرشحين.

يعتقد بعض خبراء الذكاء الاصطناعى أن مثل هذه الأنظمة لديها القدرة على تضخيم التعصب بشكل خطير فيما يتعلق بالعمر أو العرق ، على سبيل المثال ، وضع علامات لكلمات أو صور مهمة لمجموعات معينة من الناس أكثر من غيرها. إنهم قلقون أيضًا من أن Predictim سيجبر المربيات الشباب على مشاركة بياناتهم الشخصية لمجرد الحصول على وظيفة.

ومع ذلك ، تعتقد ديانا فيرنر ، وهي أم لطفلين تعيش في إحدى ضواحي سان فرانسيسكو ، أن المربيات يجب أن يتقاسمن طواعية المعلومات الشخصية للمساعدة في طمأنة والديهم. "التحقق من السيرة الذاتية أمر جيد ، لكن Predictim تدرس المسألة بعمق ، وتشريح الفرد - وضعهم الاجتماعي والفكري" ، قالت. وتضيف قائلة "حيث تعيش 100٪ من الآباء سيرغبون في استخدام هذه الخدمة". "نحن جميعا نريد الحصول على مربية مثالية."