الناس في سن مبكرة بشكل مفاجئ قادرون بالفعل على التعرف على الأشياء المفضلة لديهم والتقاطها ، على الرغم من أنهم لم يتعلموا هذا على وجه التحديد. وفقًا

لدراسات تطوير القدرات المعرفية ، تلعب إمكانية التفاعل مع كائنات العالم من حولنا دورًا حاسمًا في تطوير قدرات مثل الاستشعار عن الأشياء ومعالجتها - على سبيل المثال ، الالتقاط المستهدف. بالتفاعل مع العالم الخارجي ، يمكن للناس أن يتعلموا بتصحيح أخطائهم: نعرف ما فعلناه ونتعلم من النتائج. في علم الروبوتات ، تتم دراسة هذا النوع من التدريب مع التصحيح الذاتي للأخطاء بفعالية ، لأنه يسمح للأنظمة الآلية بالتعلم دون قدر كبير من بيانات التدريب أو الضبط اليدوي.

نحن في Google ، مستوحى من

مفهوم ثبات الأجسام ، نقدم نظام

Grasp2Vec - خوارزمية بسيطة ولكنها فعالة لبناء تمثيل الكائنات. يعتمد Grasp2Vec على فهم حدسي مفاده أن محاولة رفع أي كائن ستمنحنا بعض المعلومات - إذا كان الروبوت يلتقط الكائن ويلتقطه ، فيجب أن يكون الكائن في هذا المكان قبل التقاطه. بالإضافة إلى ذلك ، يعرف الروبوت أنه إذا كان الكائن الملتقط قيد الالتقاط ، فهذا يعني أن الكائن لم يعد في المكان الذي كان فيه. باستخدام هذا النوع من التعلم الذاتي ، يمكن أن يتعلم الروبوت التعرف على كائن ما بسبب التغيير المرئي في المشهد بعد التقاطه.

استنادًا إلى تعاوننا

مع X Robotics ، حيث تم تدريب العديد من الروبوتات في وقت واحد على التقاط الأشياء المنزلية باستخدام كاميرا واحدة فقط كمصدر لبيانات المدخلات ، فإننا نستخدم الالتقاط الآلي لأشياء الالتقاط "عن غير قصد" ، وهذه التجربة تتيح لنا الحصول على فكرة غنية عن الكائن. يمكن بالفعل استخدام هذه الفكرة لاكتساب قدرة "الالتقاط المتعمد" ، عندما يستطيع ذراع الروبوت رفع الأشياء عند الطلب.

خلق وظيفة مكافأة الإدراك الحسي

على منصة

تعلم التعزيز ، يتم قياس نجاح المهمة من خلال وظيفة المكافأة. من خلال تعظيم المكافآت ، تتعلم الروبوتات مهارات الالتقاط المختلفة

من الصفر . من السهل إنشاء وظيفة مكافأة عندما يمكن قياس النجاح من خلال قراءات أجهزة الاستشعار البسيطة. مثال بسيط هو زر ينقل المكافأة

مباشرةً إلى مدخلات الروبوت بالنقر عليه.

ومع ذلك ، فإن إنشاء وظيفة المكافأة يكون أكثر تعقيدًا عندما يعتمد معيار النجاح على الفهم الإدراكي للمهمة. ضع في اعتبارك مشكلة الالتقاط في مثال حيث يتم إعطاء الروبوت صورة للكائن المطلوب الموجود في الالتقاط. بعد محاولة الروبوت التقاط الكائن ، يفحص محتويات الالتقاط. تعتمد وظيفة المكافأة لهذه المهمة على إجابة سؤال التعرف على الأنماط: هل تتزامن الكائنات؟

على اليسار ، تمسك الفرشاة بالفرشاة ، وتظهر العديد من الأشياء في الخلفية (كوب أصفر ، كتلة بلاستيكية زرقاء). على اليمين ، تمسك القبضة بالكأس ، وتكون الفرشاة في الخلفية. إذا كانت الصورة اليسرى تمثل النتيجة المرغوبة ، فإن وظيفة المكافأة الجيدة تتمثل في "فهم" أن هاتين الصورتين تتوافقان مع كائنين مختلفين.

على اليسار ، تمسك الفرشاة بالفرشاة ، وتظهر العديد من الأشياء في الخلفية (كوب أصفر ، كتلة بلاستيكية زرقاء). على اليمين ، تمسك القبضة بالكأس ، وتكون الفرشاة في الخلفية. إذا كانت الصورة اليسرى تمثل النتيجة المرغوبة ، فإن وظيفة المكافأة الجيدة تتمثل في "فهم" أن هاتين الصورتين تتوافقان مع كائنين مختلفين.لحل مشكلة التعرُّف ، نحتاج إلى نظام إدراكي يستخلص مفاهيم ذات معنى من الكائنات من صور غير منظمة (لا يوقعها الأشخاص) ، ويتعلم تصوُّر الأشياء بدون معلم. تعمل خوارزميات التعلم بدون معلم أساسًا من خلال إنشاء افتراضات هيكلية حول البيانات. غالبًا ما يُفترض أنه يمكن

ضغط الصور

إلى مساحة ذات أبعاد أقل ، ويمكن

التنبؤ بإطارات الفيديو

من تلك السابقة . ومع ذلك ، دون افتراضات إضافية حول محتويات البيانات ، فإن هذا لا يكفي عادة للتعلم من تمثيلات غير مرتبطة بالكائنات.

ماذا لو استخدمنا الروبوت لفصل الأشياء فعليًا أثناء جمع البيانات؟ يوفر Robotics فرصة ممتازة لتعلم كيفية تمثيل الكائنات ، حيث يمكن للروبوتات معالجتها ، مما سيعطي عوامل الاختلاف اللازمة. تعتمد طريقة عملنا على فكرة أن التقاط كائن يزيله من المشهد. والنتيجة هي 1) صورة للمشهد قبل الالتقاط ، 2) صورة للمشهد بعد الالتقاط ، و 3) رؤية منفصلة للكائن الملتقط.

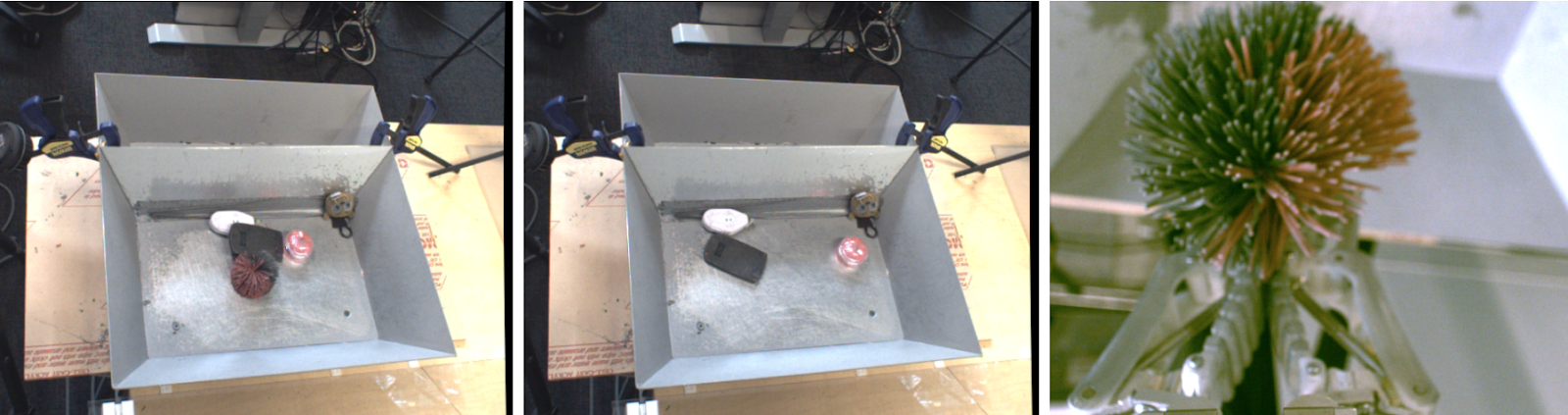

اليسار - كائنات لالتقاط. في الوسط - بعد القبض. على اليمين هو الكائن الذي تم التقاطه.

اليسار - كائنات لالتقاط. في الوسط - بعد القبض. على اليمين هو الكائن الذي تم التقاطه.إذا أخذنا في الاعتبار وظيفة مضمّنة تستخرج "مجموعة من الكائنات" من الصور ، فيجب أن تحافظ على علاقة الطرح التالية:

كائنات قبل الالتقاط - كائنات بعد الالتقاط = كائن تم التقاطه

كائنات قبل الالتقاط - كائنات بعد الالتقاط = كائن تم التقاطهنحقق هذه المساواة مع الهندسة المعمارية التلافيفية وخوارزمية التعلم متري بسيطة. أثناء التدريب ، تضم البنية الموضحة أدناه الصور قبل الالتقاط وبعده في

خريطة كثيفة

للخواص المكانية . تتحول هذه الخرائط إلى متجهات من خلال اتحاد متوسط ، ويمثل الفرق بين متجهات "قبل الالتقاط" و "بعد الالتقاط" مجموعة من الكائنات. تتم مقارنة هذا المتجه والتمثيل المقابل لمتجه هذا الكائن المدروس من خلال وظيفة أزواج N.

بعد التدريب ، يتميز نموذجنا بطبيعة الحال بخاصيتين مفيدتين.

1. تشابه الأشياء

يسمح لنا

معامل جيب التمام بالمسافة بين زخارف المتجهات بمقارنة الأشياء وتحديد ما إذا كانت متطابقة أم لا. يمكن استخدام هذا لتنفيذ وظيفة المكافأة للتعلم المعزز ، ويسمح للروبوتات بتعلم كيفية التقاطها بأمثلة دون ترميز البيانات من قبل البشر.

2. العثور على الأهداف

يمكننا الجمع بين الخرائط المكانية للمشهد ودمج الكائنات لتوطين "الكائن المرغوب" في مساحة الصورة. عند تنفيذ عمليات الضرب على أساس العناصر لخرائط الميزات المكانية ومراسلات المتجهات الخاصة بالكائن المرغوب فيه ، يمكننا العثور على جميع وحدات البكسل في الخريطة المكانية التي تتوافق مع الكائن الهدف.

استخدام تطعيمات Grasp2Vec لتوطين الكائنات في المشهد. أعلى اليسار كائنات في السلة. أسفل اليسار - الكائن المطلوب التقاطه. يمنحنا المنتج العددي الخاص بموجه الكائن الهدف والميزات المكانية للصورة "خريطة تنشيط" لكل بكسل (أعلى اليمين) لتشابه قسم معين من الصورة مع الهدف. يمكن استخدام هذه الخريطة للاقتراب من الهدف.

استخدام تطعيمات Grasp2Vec لتوطين الكائنات في المشهد. أعلى اليسار كائنات في السلة. أسفل اليسار - الكائن المطلوب التقاطه. يمنحنا المنتج العددي الخاص بموجه الكائن الهدف والميزات المكانية للصورة "خريطة تنشيط" لكل بكسل (أعلى اليمين) لتشابه قسم معين من الصورة مع الهدف. يمكن استخدام هذه الخريطة للاقتراب من الهدف.تعمل طريقة عملنا أيضًا عندما تتوافق عدة كائنات مع الهدف ، أو حتى عندما يتألف الهدف من عدة كائنات (متوسط متجهين). على سبيل المثال ، في هذا السيناريو ، يحدد الروبوت عدة كتل برتقالية في المشهد.

يمكن استخدام "خريطة الحرارة" الناتجة للتخطيط لنهج الروبوت إلى الكائن (الكائنات) الهدف. نحن نجمع بين الترجمة من Grasp2Vec والتعرف على الأنماط وسياسة "التقاط أي شيء" الخاصة بنا وتحقيق النجاح في 80 ٪ من الحالات أثناء جمع البيانات وفي 59 ٪ مع كائنات جديدة لم يصادفها الروبوت سابقًا.

يمكن استخدام "خريطة الحرارة" الناتجة للتخطيط لنهج الروبوت إلى الكائن (الكائنات) الهدف. نحن نجمع بين الترجمة من Grasp2Vec والتعرف على الأنماط وسياسة "التقاط أي شيء" الخاصة بنا وتحقيق النجاح في 80 ٪ من الحالات أثناء جمع البيانات وفي 59 ٪ مع كائنات جديدة لم يصادفها الروبوت سابقًا.الخاتمة

في عملنا

، أظهرنا كيف يمكن لمهارات القابض الآلي إنشاء بيانات تستخدم لتعليم تمثيل الكائنات. ثم يمكننا استخدام التدريب على العرض التقديمي لاكتساب مهارات أكثر تعقيدًا بسرعة ، مثل الالتقاط وفقًا لمثال ، مع الحفاظ على جميع خصائص التدريس بدون معلم في نظام الالتقاط المستقل.

بالإضافة إلى عملنا ، درست أيضًا العديد من الأعمال الحديثة الأخرى كيف يمكن استخدام التفاعل دون وجود معلم للحصول على تمثيلات للكائنات ، من خلال

الالتقاط والدفع وأنواع أخرى من

التفاعلات مع الكائنات في البيئة. إننا نتوقع بسعادة ليس فقط ما يمكن أن يقدمه التعلم الآلي من الروبوتات من حيث تحسين الإدراك والسيطرة ، ولكن أيضًا ما يمكن أن يقدمه الروبوتات من خلال التعلم الآلي من خلال نماذج جديدة للتعلم الذاتي.