مرحبا يا هبر!

هذا العام ، عند كتابة المستند النهائي عن أعمال الشركة لهذا العام ، قررنا رفض إعادة سرد الأخبار ، وعلى الرغم من أننا لم نتمكن من التخلص تمامًا من ذكريات ما حدث ، نود أن نشارك معك ما تمكنا من فعله - لجمع الأفكار وتوجيه أعيننا إلى إلى أين سنجد أنفسنا بالتأكيد في المستقبل القريب جدًا - في الوقت الحالي.

دون مزيد من اللغط ، والنتائج الرئيسية من العام الماضي:

- انخفض متوسط مدة هجمات DDoS إلى 2.5 ساعة ؛

- أظهر عام 2018 وجود قوة حوسبية قادرة على توليد هجمات بكثافة مئات الجيجابت في الثانية داخل بلد أو منطقة واحدة ، مما أدى بنا إلى حافة "نظرية الكم لنسبية عرض النطاق الترددي" ؛

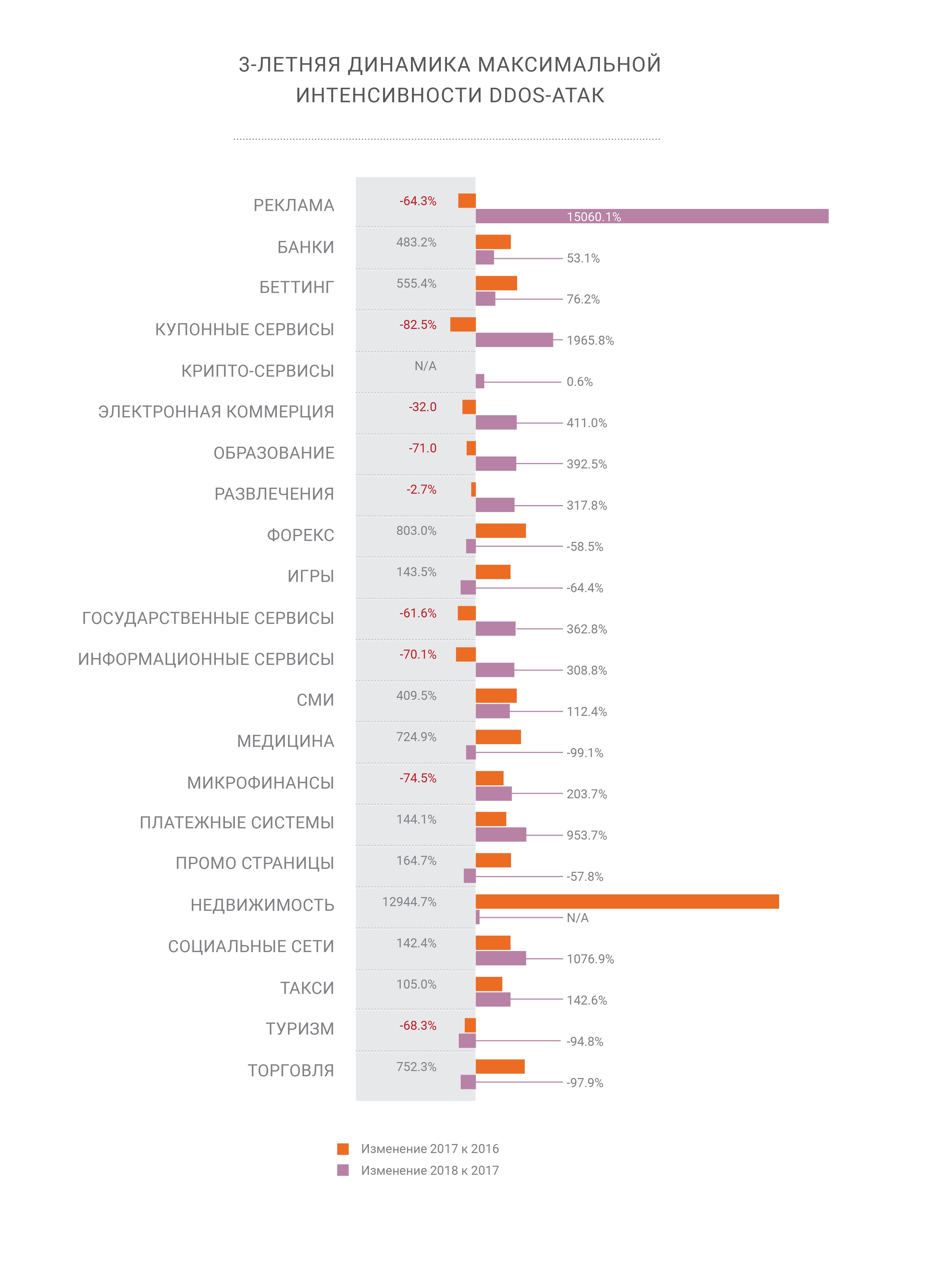

- تستمر شدة هجمات DDoS في النمو.

- إلى جانب الزيادة المتزامنة في حصة الهجمات باستخدام HTTPS (SSL) ؛

- أجهزة الكمبيوتر الشخصية ميتة - يتم إنشاء معظم حركة المرور الحديثة على الأجهزة المحمولة ، مما يمثل تحديًا لمنظمي DDoS والتحدي التالي لشركات أمان الشبكات ؛

- أصبحت BGP أخيرًا متجهًا للهجوم ، بعد سنتين من توقعنا ؛

- لا يزال التعامل مع DNS هو ناقل الهجوم الأكثر اضطرابًا ؛

- نتوقع مكبرات صوت جديدة في المستقبل ، مثل memcached و CoAP ؛

- لم تعد هناك "ملاذات آمنة" على الإنترنت ، وجميع الصناعات معرضة بنفس القدر للهجمات الإلكترونية من أي نوع.

تحت الخفض ، قمنا بجمع الأجزاء الأكثر إثارة للاهتمام من التقرير في مكان واحد ، يمكنك العثور على النسخة الكاملة

هنا هل لديك قراءة جيدة.

بأثر رجعي

توقف التشفير عن إثارة اهتمام المهاجم

توقف التشفير عن إثارة اهتمام المهاجمفي عام 2018 ، "لاحظت" شركتنا هجومين قياسيين على شبكتها الخاصة. بلغت هجمات تضخيم memcached ، التي وصفناها بالتفصيل في نهاية فبراير 2018 ، نظام الدفع Qiwi 500 جيجا بايت / ثانية ، ولكن تم بنجاح تحييدها بواسطة شبكة التصفية. في نهاية شهر أكتوبر ، شاهدنا هجومًا تاريخيًا آخر - تضخيم نظام أسماء النطاقات (DNS) بمصادر محلية داخل بلد واحد ، ولكن قوة غير مسبوقة.

لقد كان تضخيم DNS ولا يزال أحد أشهر متجهات هجوم DDoS على مستوى الارتباط ولا يزال يطرح سؤالين حادين. في حالة حدوث هجوم بكثافة مئات غيغا بايت في الثانية الواحدة ، هناك احتمال كبير من التحميل الزائد الاتصال بموفر أعلى. كيف تتعامل معها؟ من الواضح ، من الضروري توزيع مثل هذا الحمل عبر أكبر عدد ممكن من القنوات - الأمر الذي يقودنا إلى المشكلة الثانية - تأخير الشبكة المضافة نتيجة للتغييرات في مسارات حركة المرور إلى أماكن معالجتها. لحسن الحظ ، تمكنا أيضًا من الهجوم الثاني بفضل خيارات موازنة التحميل المرنة داخل شبكة Qrator.

هذه هي الطريقة التي أوضحت لنا بها الموازنة أعلى قيمة لها - نظرًا لأننا ندير شبكة anycast BGP ، يقوم رادارنا بتوزيع توزيع حركة المرور عبر الشبكة بعد تغيير نموذج الموازنة. BGP هو بروتوكول متجه المسافات ونحن نفهم الحالات جيدًا ، لأن الرسم البياني للمسافة يظل ثابتًا تقريبًا. من خلال تحليل هذه المسافات مع الأخذ في الاعتبار LCP و Equal-Cost Multipath ، يمكننا تقييم AS_path مسبقًا من النقطة A إلى النقطة B بدرجة عالية من الدقة.

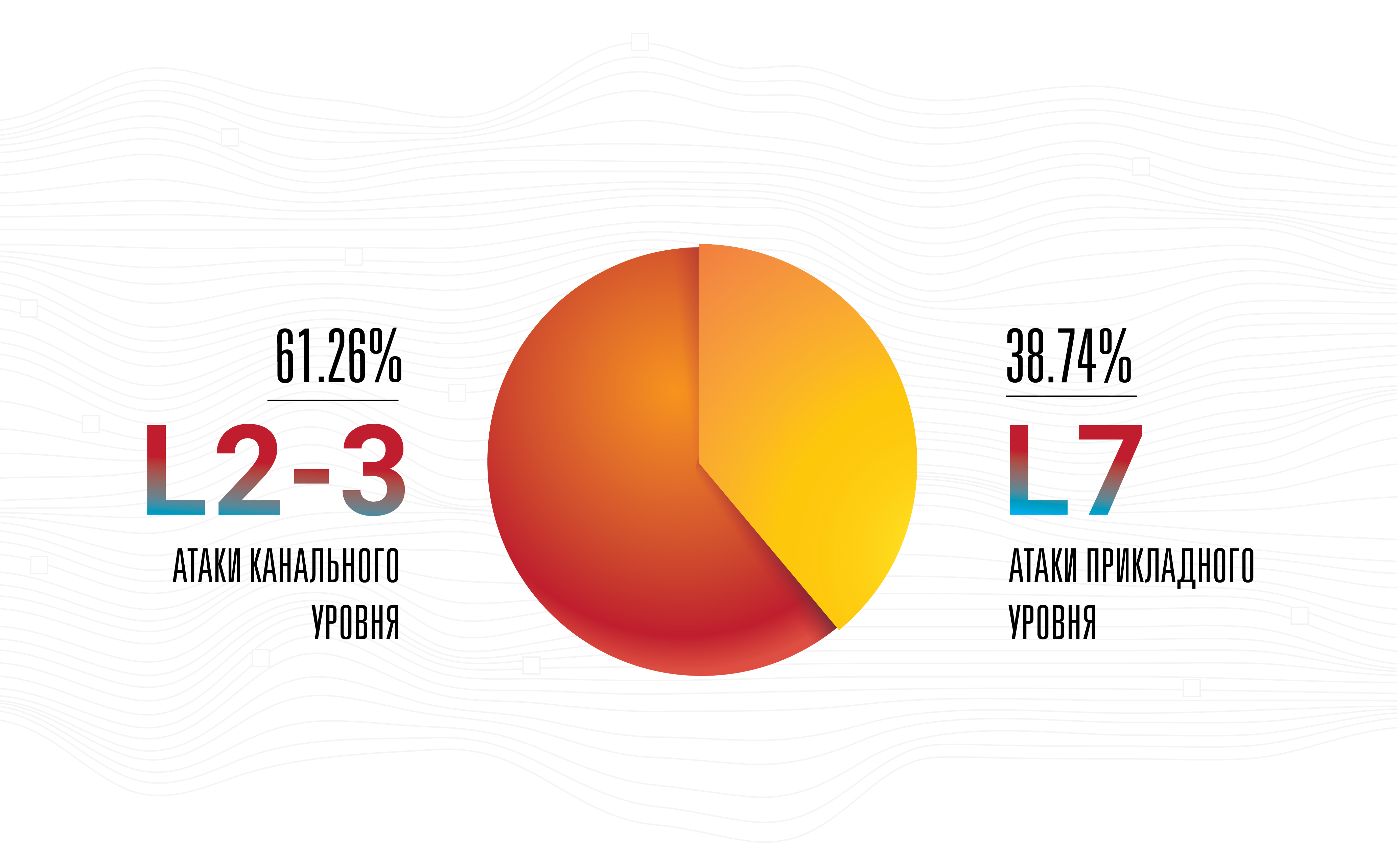

هذا لا يعني أن التضخيم هو أخطر تهديد - لا ، لا تزال الهجمات على مستوى التطبيق هي الأكثر نجاحًا وغير مرئية وفعالة ، حيث يتم تنفيذ معظمها بكثافة منخفضة في النطاق المستخدم.

هذا هو السبب الرئيسي وراء قيام شركتنا بتحسين الاتصالات مع المشغلين في نقاط التواجد بشكل لا هوادة فيه ، مع زيادة عددهم. تعتبر هذه الخطوة منطقية لأي مشغل شبكة في الوقت الحالي ، شريطة أن تنمو الأعمال. لكننا ما زلنا نعتقد أن معظم المهاجمين يجمعون في البداية شبكة روبوت وفقط بعد ذلك يبدأ الاختيار من قائمة أوسع من مكبرات الصوت المتاحة التي يمكن ضربها من جميع الأسلحة الممكنة في سرعة إعادة التحميل القصوى. لقد حدثت مثل هذه الهجمات الهجينة لفترة طويلة ، ولكن في الآونة الأخيرة فقط بدأت شدتها ، سواء من حيث عدد الحزم في الثانية وعرض النطاق الترددي للشبكة المعنية ، في النمو.

أصبحت الهجمات التي تزيد شدتها عن 100 جيجابت / ثانية مرئية بوضوح في الإحصائيات - لم تعد هذه الضوضاء

أصبحت الهجمات التي تزيد شدتها عن 100 جيجابت / ثانية مرئية بوضوح في الإحصائيات - لم تعد هذه الضوضاءتطورت Botnets بشكل كبير في عام 2018 ، وتوصل أصحابها إلى نشاط جديد -

clickfraud . مع تحسين تقنيات التعلم الآلي والدخول في أيدي المتصفحات بدون رأس التي تعمل بدون واجهة المستخدم الرسومية ، أصبح clickfraud أسهل وأرخص بكثير - في غضون عامين فقط.

اليوم ، يتلقى موقع الويب المتوسط من 50 ٪ إلى 65 ٪ من حركة المرور من الأجهزة المحمولة والمتصفحات والتطبيقات. بالنسبة إلى بعض خدمات الشبكة ، يمكن أن تصل هذه المشاركة إلى 90٪ أو حتى 100٪ ، في حين أن مواقع الويب "المكتبية" حصريًا لم تعد موجودة ، إلا في بيئات الشركة ، أو في حالات متخصصة للغاية.

في الواقع ، اختفت أجهزة الكمبيوتر الشخصية من ذروة المشهد الطبيعي للشبكة بحلول عام 2019 ، مما جعل بعض التقنيات الناجحة في الماضي ، مثل تتبع موقع الماوس ، غير صالحة تمامًا لتصفية حركة المرور والحماية من الروبوتات. في الواقع ، ليس فقط أجهزة الكمبيوتر الشخصية ، ولكن معظم أجهزة الكمبيوتر المحمولة وصناديق الكل في واحد نادراً ما تكون مصدر حصة كبيرة من زيارات الصفحات ، بينما تصبح بسهولة سلاحًا. في وقت واحد ، كان الحرمان البسيط من الوصول إلى أي شيء يمثل متصفح الجوال بشكل غير صحيح حتى وقت قريب كافيًا لتحييد الهجمات من شبكات الروبوت تمامًا تقريبًا ، مما أدى إلى تسوية التأثير السلبي للمقاييس التجارية الرئيسية إلى الصفر.

يتم استخدام منشئي ومديري شبكات الروبوت بالفعل في تنفيذ الممارسات التي تحاكي سلوك زوار الصفحة الحقيقية في التعليمات البرمجية الضارة الخاصة بهم ، تمامًا مثل مستخدمو صفحات الويب معتادون على حقيقة أن المتصفحات على أجهزة الكمبيوتر الشخصية مهمة. يتم تعديل كلاهما ، في حين أن السابق أسرع من الأخير.

لقد ذكرنا بالفعل أنه لم يتغير شيء في عام 2018 ، ولكن التقدم والتغييرات ذاتها شهدت تطوراً ملحوظاً. أحد الأمثلة الأكثر بروزًا هو التعلم الآلي ، حيث كانت التحسينات والتقدم واضحة للعيان ، خاصة في مجال الشبكات التنافسية التوليدية. ببطء ولكن بثبات ، تصل ML إلى السوق الشامل. أصبح التعلم الآلي بالفعل ميسور التكلفة تمامًا ، وكما أظهرت حدود 2018-2019 ، لم تعد صناعة تقتصر على الأكاديميين.

على الرغم من أننا توقعنا ظهور هجمات DDoS الأولى التي تستند إلى ML بحلول بداية عام 2019 ، إلا أن هذا لم يحدث حتى الآن. ومع ذلك ، فإن هذا لا يغير توقعاتنا ، ولكنه يعمل فقط على تأجيجها ، خاصة بالنظر إلى انخفاض تكلفة إدارة الشبكات العصبية والدقة المتزايدة لتحليلاتها.

من ناحية أخرى ، إذا أخذنا في الاعتبار الوضع الحالي لصناعة "الأفراد المؤتمتة للإنسان" ، يصبح من الواضح أن تنفيذ شبكة عصبية في هذا التصميم هو فكرة محتملة. يمكن أن تتعلم مثل هذه الشبكة من سلوك الأشخاص الحقيقيين في سياق إدارة صفحات الويب. سيطلق على هذا الشيء "تجربة مستخدم الذكاء الاصطناعي" ، وبالطبع ، يمكن لشبكة مماثلة مسلحة بمستعرض ويب أن توسع ترسانة الجانبين: الهجوم والدفاع.

يعد تدريب الشبكة العصبية عملية باهظة الثمن ، لكن توزيع هذا النظام والاستعانة بمصادر خارجية له يمكن أن يكون رخيصًا وفعالًا ويمكن أن يكون مجانيًا - في حالة إخفاء الكود الضار داخل التطبيقات والإضافات المخترقة وغير ذلك الكثير. يحتمل أن يؤدي هذا التغيير إلى تغيير الصناعة بأكملها بنفس الطريقة التي حولت بها الشبكات التنافسية التوليدية فهمنا لـ "الواقع المرئي" و "الأصالة".

بالنظر إلى السباق المستمر بين محركات البحث - غوغل في المقام الأول وأي شخص آخر يحاول عكس هندسة هذه الآلات ، يمكن للأمور أن تذهب إلى أبعد من الأشياء الرائعة مثل تقليد شخص واحد محدد بواسطة الروبوت. يجلس عادة على جهاز كمبيوتر عرضة للخطر. يمكن أن تعمل إصدارات مشروع Captcha و ReCaptcha كمثال على مدى سرعة وقوة الجانب المهاجم في تطوير وتحسين أدوات وتقنيات الهجوم الخاصة به.

بعد الاختلاط ، كان هناك الكثير من الحديث حول احتمال (أو عدم احتمال) وجود فئة جديدة تمامًا من الأسلحة لـ DDoS - ثغرة أمنية أو روبوت أو خدمة تمت تهيئتها بشكل غير صحيح أو أي شيء آخر من شأنه أن يرسل البيانات إلى هدف محدد لا يختاره المهاجم. يؤدي أمر واحد من المهاجم إلى استمرار تدفق حركة المرور ، مثل أي من الفيضانات ، أو إرسال syslog. في هذه اللحظة ، هذه هي النظرية. ما زلنا لا نستطيع أن نقول ما إذا كانت هناك مثل هذه الخوادم والأجهزة ، ولكن إذا كانت الإجابة على هذا السؤال بنعم ، فسيكون تقدير هذا الموقف هو التقليل من شأن هذا الشيء يمكن أن يصبح سلاحًا خطيرًا جدًا في أيادي الشر.

في عام 2018 ، شهدنا أيضًا اهتمامًا متزايدًا بما يسمى "إدارة الإنترنت" والخدمات ذات الصلة من الدول والمنظمات غير الربحية في جميع أنحاء العالم. نحن محايدون بشأن هذا التطور للأحداث حتى اللحظة التي يبدأ فيها قمع الحريات المدنية والفردية الأساسية ، والتي نأمل ألا تحدث في البلدان المتقدمة.

أخيرًا ، بعد سنوات من جمع وتحليل حركة المرور في جميع أنحاء العالم ، أصبحت Qrator Labs جاهزة لتطبيق الحظر على طلب الشبكة الأول. تتيح لنا النماذج التي نستخدمها للتنبؤ بالسلوك الضار تحديد شرعية المستخدم بدقة لكل صفحة معينة. نواصل الإصرار على فلسفتنا الخاصة بتسجيل الدخول الخالي من العوائق للمستخدم وتجربة المستخدم التي لا تنفصم ، من دون اختبارات JavaScript أو captcha ، والتي من عام 2019 ستبدأ العمل بشكل أسرع ، مما يوفر أعلى مستوى من إمكانية الوصول إلى الخدمات المحمية.

يستمر الحد الأقصى لشدة فرقة الهجوم في الزيادة المطردة.

يستمر الحد الأقصى لشدة فرقة الهجوم في الزيادة المطردة.ميلانوكس

اختارت شركتنا مبدلات 100G Mellanox كنتيجة للاختبارات الداخلية التي أجريت على مدار عدة سنوات. ما زلنا نختار المعدات التي تلبي متطلباتنا المحددة في ظروف معينة بأفضل طريقة. على سبيل المثال ، يجب ألا يسقط المحول الحزم الصغيرة بمعدل خط - الحد الأقصى للسرعة ، وحتى الحد الأدنى من التدهور غير مقبول. بالإضافة إلى ذلك ، فإن مفاتيح Mellanox لها سعر جيد. ومع ذلك ، هذا ليس كل شيء - يتم تأكيد نزاهة السعر بالطريقة التي يستجيب بها بائع معين لطلباتك.

تعمل مفاتيح Mellanox على Switchdev ، والتي تحول منافذها إلى واجهات بسيطة داخل Linux. كونه جزءًا من نواة Linux الرئيسية ، يوفر Switchdev طريقة ملائمة لإدارة الجهاز باستخدام واجهات واضحة ومألوفة ، تحت واجهة برمجة تطبيقات واحدة ، وهو مألوف تمامًا لأي مبرمج ومطور ومهندس شبكة حديث. يمكن تشغيل أي برنامج يستخدم API لشبكة Linux القياسية على أحد المحولات. يمكن بسهولة الوصول إلى جميع أنشطة مراقبة وإدارة الشبكة التي تم إنشاؤها لخوادم Linux ، بما في ذلك حلول الملكية المحتملة. لتوضيح التغييرات التي حدثت مع التطوير النشط لـ Switchdev ، نلاحظ أن تعديل جداول التوجيه أصبح أسرع عدة مرات وأكثر ملاءمة مع Switchdev. حتى مستوى شريحة الشبكة ، تكون جميع الشفرات مرئية وشفافة ، مما يسمح لك بالتعلم وإجراء التعديلات حتى تحتاج إلى معرفة كيفية بناء الشريحة نفسها أو على الأقل الواجهة الخارجية لها.

تبين أن جهاز Mellanox الذي يشغل Switchdev هو المجموعة التي طال انتظارها والتي كنا ننتظرها لفترة طويلة ، ولكن بشكل أفضل - حققت الشركة الصناعية كل التوقعات والمتطلبات ، ليس فقط فيما يتعلق بالدعم الكامل لنظام تشغيل مجاني خارج الصندوق.

عند اختبار الجهاز قبل تشغيله ، اكتشفنا أن جزءًا من حركة المرور المعاد توجيهها قد فقد. أظهر تحقيقنا أن هذا يرجع إلى حقيقة أن حركة المرور إلى واحدة من واجهات تم إرسالها باستخدام معالج التحكم الذي لا يستطيع التعامل مع حجمها الكبير. غير قادر على تحديد السبب الدقيق لهذا السلوك ، ومع ذلك ، اقترحنا أن هذا كان بسبب معالجة عمليات إعادة توجيه ICMP. أكد Mellanox مصدر المشكلة ، وبالتالي طلبنا القيام بشيء ما مع هذا السلوك للجهاز ، والتي استجابت الشركة على الفور من خلال توفير حل عملي في وقت قصير.

عمل عظيم ، ميلانوكس!

البروتوكولات والمصدر المفتوح

DNS-over-HTTPS هي تقنية أكثر شمولية من DNS-over-TLS. نلاحظ كيف يزدهر الأول ، في حين أن الثاني ينسى ببطء. هذا المثال جيد لأنه في هذه الحالة بالذات ، يعني "التعقيد" "الكفاءة" ، لأن حركة مرور DoH لا يمكن تمييزها عن أي HTTPS آخر. لقد رأينا بالفعل نفس الشيء مع تكامل بيانات RPKI ، والذي تم وضعه مبدئيًا كحل مضاد للاعتراض ، ونتيجة لذلك ، لم يحدث شيء جيد له. بعد مرور بعض الوقت ، عادت RPKI إلى الظهور كأداة فعالة ضد الحالات الشاذة مثل تسرب المسارات وإعدادات التوجيه غير الصحيحة. والآن تحولت الضوضاء إلى إشارة ، وبدأ دعم RPKI في أكبر نقاط تبادل حركة المرور ، وهو خبر سار.

وصل و TLS 1.3. راقبت مختبرات Qrator ، مثل صناعة تكنولوجيا المعلومات بأكملها ، عن كثب عملية تطوير معيار تشفير جديد في كل مرحلة ، من المسودة الأولية في IETF إلى بروتوكول يمكن فهمه ويمكن التحكم فيه ونحن على استعداد لدعمه بدءًا من عام 2019. كان رد فعل السوق بالمثل ، واعدا بتنفيذ أسرع لبروتوكول أمان موثوق. من المحتمل ألا تكون جميع الشركات المصنعة لحلول تحييد DDoS قادرة على التكيف مع الواقع المتغير بسرعة متساوية ، لأنه بسبب التعقيد التقني لدعم البروتوكول ، قد يكون هناك تأخير ممكن في الأجهزة.

نحن نتابع أيضًا التطوير المستمر لـ HTTP / 2. في الوقت الحالي ، لا ندعم الإصدار الجديد من بروتوكول HTTP ، ويعزى ذلك بشكل أساسي إلى النقص في قاعدة الشفرة الحالية. لا تزال الأخطاء ونقاط الضعف موجودة غالبًا في التعليمات البرمجية الجديدة ؛ كمزود للحلول الأمنية ، لسنا مستعدين بعد لدعم هذا البروتوكول بموجب اتفاقية مستوى الخدمة ، والتي وافق عليها المستهلكون لدينا.

في عام 2018 ، سألنا أنفسنا في كثير من الأحيان السؤال: "لماذا يريد الناس HTTP / 2 أكثر من اللازم؟" ، والذي كان سبب العديد من النقاشات الشرسة. لا يزال الناس يميلون إلى التفكير في الأشياء التي تحتوي على البادئة "2" كإصدارات "أفضل" من أي شيء ، وهذا صحيح بشكل خاص في حالة بعض جوانب تنفيذ هذا البروتوكول. ومع ذلك ، توصي وزارة الصحة باستخدام HTTP / 2 ، ومن الممكن تمامًا أن يولد هذا التآزر درجة عالية من قبول السوق لكلا البروتوكولين.

أحد المخاوف عند النظر في تطوير بروتوكولات الجيل القادم وقدراتها المخططة هو حقيقة أن التطورات في كثير من الأحيان لا تتجاوز المستوى الأكاديمي البحت ، ناهيك عن النظر في الحالات القصوى لمنشئي البروتوكول ، مثل تحييد هجمات DDoS. ربما هذا هو السبب في أن الشركات العاملة في مجال الأمن السيبراني والمعلوماتي تبذل القليل من الجهد لتطوير مثل هذه المعايير.

يعتبر القسم 4.4 من مسودة IETF ، المعنون "قابلية الإدارة السريعة" ، والذي يعد جزءًا من حزمة بروتوكول QUIC المستقبلية ، مجرد مثال مثالي لهذا النهج: فهو ينص على أن "الممارسات الحالية في اكتشاف وتحييد [هجمات DDoS] تتضمن في الغالب قياسًا سلبيًا باستخدام بيانات طبقة الشبكة. " نادراً ما يتم استخدام هذا الأخير في الممارسة العملية ، باستثناء ربما لشبكات مزودي الإنترنت وليس بالكاد "حالة شائعة" في الممارسة العملية. ومع ذلك ، في ورقة البحث الأكاديمي ، يتم تشكيل "الحالات العامة" على هذا النحو ، ونتيجة لذلك فإن معايير البروتوكول النهائي ببساطة لا تنطبق في الإنتاج ، بعد إجراء مثل هذه التلاعب البسيطة قبل التكليف ، مثل الاختبار تحت الحمل ومحاكاة الهجمات على مستوى التطبيق على التطبيق ، باستخدام. مع الأخذ في الاعتبار العملية المستمرة لإدخال TLS في البنية التحتية للإنترنت العالمية ، فإن التأكيد على أي مراقبة سلبية يتم بشكل عام طرح تساؤلات خطيرة. بناء البحوث الأكاديمية الصحيحة هو اختبار آخر لموفري الحلول الأمنية في عام 2019.

في الوقت نفسه ، استوفى Switchdev تمامًا التوقعات التي وضعت فيه قبل عام. نأمل أن يؤدي استمرار العمل على Switchdev إلى دفع المجتمع وثمرة العمل المشتركة إلى نتائج ممتازة في المستقبل القريب.

سيساعد تطوير وتنفيذ Linux XDP الصناعة على تحقيق كفاءة معالجة حزم شبكة عالية. تبدو شحنة بعض أنماط التصفية لحركة المرور غير المشروعة من المعالج المركزي إلى معالج الشبكة ، وحتى في بعض الحالات حتى التبديل ، واعدة بالفعل وتواصل شركتنا بحثها وتطويرها في هذا المجال.

الغوص العميق مع السير

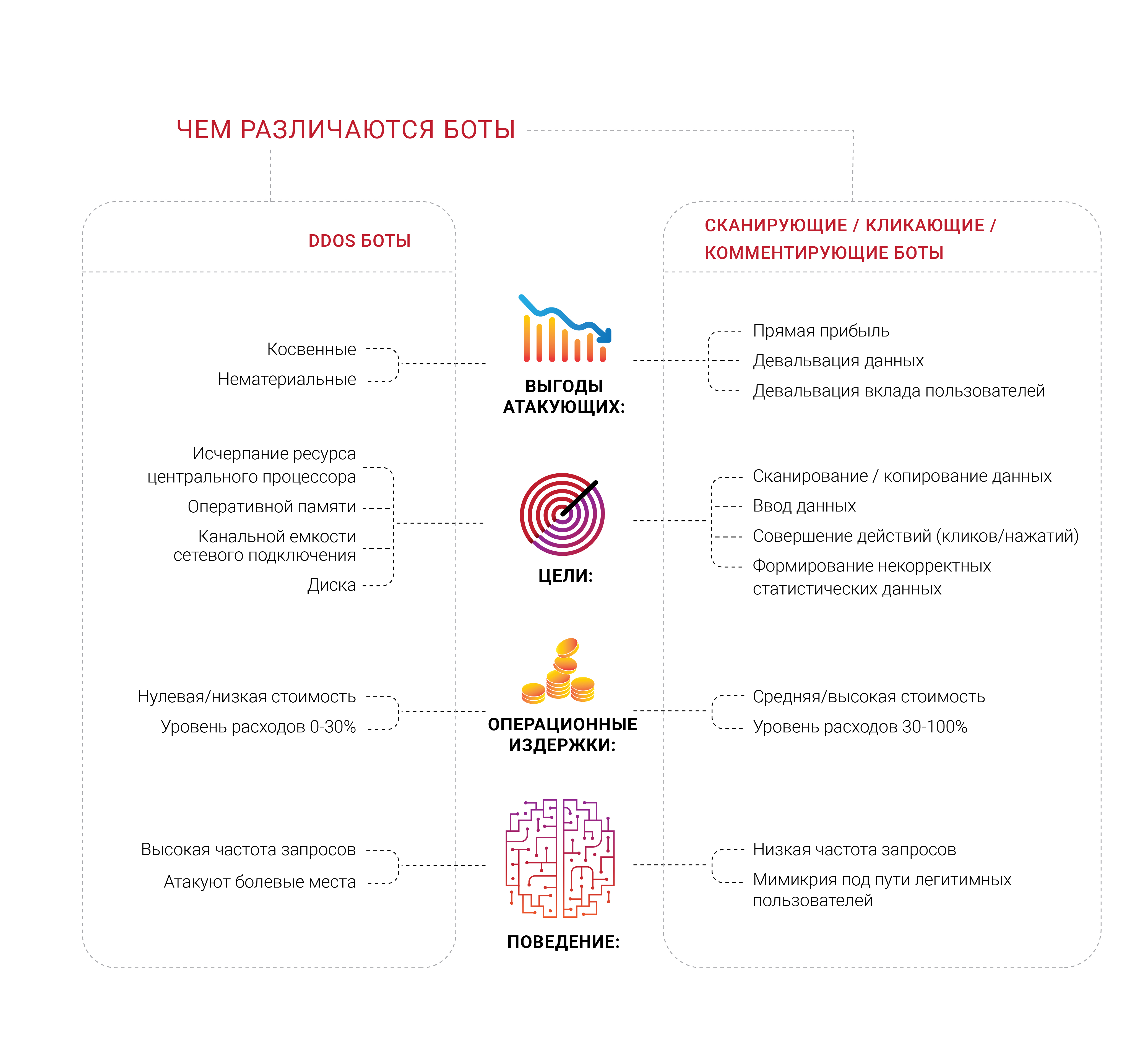

العديد من الشركات حريصة على الحصول على الحماية من الروبوتات ، وليس من المستغرب ، رأينا عددًا كبيرًا من مجموعات متنوعة من المهنيين العاملين في مجالات مختلفة من هذه المسألة في عام 2018. ما يبدو مثيراً للاهتمام بالنسبة لنا هو أن معظم الشركات التي تولد مثل هذا الطلب لم تشهد أبدًا هجومًا مستهدفًا على DDoS ، على الأقل نموذجيًا ، يهدف إلى استنفاد الموارد المحدودة ، مثل الذاكرة أو المعالج أو قناة اتصال الشبكة. إنهم يخشون السير ، لكنهم لا يستطيعون تمييزهم عن المستخدمين الشرعيين أو تحديد ما يفعلونه بالضبط. ترغب معظم مصادر هذه النداءات في التخلص من الشعور بأن الأشخاص غير الأحياء يأتون إلى صفحاتهم.

مشكلة الماسحات الضوئية الروبوت والعديد من الأنواع الفرعية الأخرى هي عنصر اقتصادي مهم للغاية. إذا كان 30 ٪ من حركة المرور غير شرعية وتأتي من مصادر غير مرغوب فيها ، ثم يتم طرح 30 ٪ من تكاليف دعم هذه الحركة في سلة المهملات ، وفقا لمنطق النفقات. اليوم ، يمكن للمرء اعتبار هذا بمثابة "ضريبة الإنترنت" لا مفر منه على الأعمال التجارية. يكاد يكون هذا الرقم مستحيلًا إلى الصفر ، لكن أصحاب الأعمال يرغبون في رؤية هذه النسبة منخفضة قدر الإمكان.

أصبحت عملية تحديد الهوية مشكلة وتحدي خطير للغاية على شبكة الإنترنت الحديثة ، حيث أن أكثر برامج الروبوت المتقدمة لا تحاول حتى تصوير شخص ما - فهم يديرونها ويوجدون في نفس المكان مع الطفيليات. لقد كررنا منذ فترة طويلة أن أي معلومات متاحة للجمهور ، دون المصادقة والترخيص موجودة ، وفي نهاية المطاف ، ستنهي وجودها في شكل المجال العام - لا يمكن لأحد منع ذلك.

النظر في هذه المسألة ، ركزنا على قضايا تحديد وإدارة الروبوتات. ومع ذلك ، في رأينا ، هناك مجموعة واسعة من العمل أكثر إثارة للاهتمام - فنحن نعيش في عصر أصبح من المستحيل فيه بالفعل معرفة سبب طلب عميل معين شيئًا ما من الخادم. تقرأ كل شيء بشكل صحيح - في النهاية ، يريد أي عمل أن يعرف أن المستهلك قد حان للشراء ، لأن هذا هو هدف عمله ووجوده. لذلك ، تريد بعض الشركات أن تفكر بعمق في من وما الذي يطلبه من خوادمها - هل هناك شخص حقيقي وراء الطلب.ليس من المستغرب ، في النهاية ، أن يكتشف أصحاب الأعمال في كثير من الأحيان أن جزءًا كبيرًا من حركة المرور إلى موقع الويب الخاص بهم يتم إنشاؤه بواسطة الروبوتات ، وليس بواسطة أي مشترين.يمكن أن تستهدف الكائنات الآلية ، التي ذكرناها بالفعل في سياق مختلف ، موارد شبكة محددة أكثر بكثير باستخدام أشياء غير محسوسة تقريبًا ، مثل امتدادات المتصفح. نحن نعلم بالفعل أن الكثير من الملحقات التي يصعب تسميتها "ضارة" موجودة فقط بغرض جمع وتحليل سلوك المستخدم الحقيقي. ولكن هناك أشياء مختلفة تمامًا - حيث يتعذر على الأتمتة تجاوز السياج المحدد أمامه ، فإن الأشخاص الذين لديهم تعديلات على المتصفح يظهرون ويقومون بجميع الإجراءات البسيطة نفسها ، وربما يكون ذلك أغلى قليلاً للمنظمين. بالإضافة إلى ذلك ، يتم تنفيذ عدد من المهام ، مثل التلاعب بالإعلانات والاحتيال على النقرات ، بكفاءة أكبر مع شخص حقيقي أمام الشاشة. فقط تخيل ما قد يحدثإذا وجد شخص ما طريقة جيدة لتعزيزه بالتعلم الآلي ، في الجزء الأيمن من السلسلة.لقد وصل المحللون والماسحات الضوئية ، التي تعد جزءًا من مشكلة الروبوتات الأوسع نطاقًا ، إلى أفقنا فقط في عام 2018 ، وقبل كل شيء ، وذلك بفضل مستهلكينا الذين أبلغونا بتجربتهم الخاصة وأتاحوا الفرصة لدراسة وتحليل ما كان يحدث على موارد شبكتهم. قد لا تكون هذه الروبوتات مرئية على مستوى المقاييس القياسية ، مثل متوسط عرض النطاق الترددي للشبكة المستخدم أو استخدام وحدة المعالجة المركزية للخادم. في الوقت الحالي ، يقوم Qrator Labs باختبار مجموعة متنوعة من الطرق ، ولكن هناك شيئًا واحدًا واضحًا - يريد عملاؤنا حظر برامج الروبوت الضارة في رأيهم عند الطلب الأول على الخادم.خلال انتشار الوباء الذي لاحظناه في روسيا ورابطة الدول المستقلة خلال النصف الثاني من عام 2018 ، أصبح من الواضح أن الروبوتات قطعت شوطًا طويلاً في قضايا التشفير. طلب واحد في الدقيقة هو كثافة طبيعية للغاية بالنسبة للبوت ، وهو أمر يصعب للغاية ملاحظته دون تحليل الطلبات وحركة المرور الصادرة. في رأينا المتواضع ، يحق للمستهلك فقط أن يقرر ما يجب القيام به مع أي مصدر غير مرغوب فيه للطلبات بعد تحليل وتمييز حركة المرور. كتلة ، تخطي أو الغش - ليس بالنسبة لنا لاتخاذ قرار. ومع ذلك ، فإن الحلول الآلية البحتة ، أو كما اعتدنا على تسميتها "برامج الروبوت" ، تواجه بعض الصعوبات في التفاعل. إذا كنت متأكدًا من أنه الروبوت الذي أنشأ الطلب غير المرغوب فيه والمحدّد تمامًا ، فإن أول شيء يريد معظم الناس فعله هو حظره دون الاستجابة من الخادم. ومع ذلك ، توصلنا إلى استنتاج مفاده أن مثل هذا النهج لا معنى له ، لأنه يقدم الكثير من الملاحظات لكل من الروبوت ومبدعه ، ويشجعك على البحث عن حل بديل. إذا كانت برامج الروبوت لا تحاول إيقاف تشغيل الخدمة ، بشكل عام ، فإننا ننصحك بعدم الوعظ بهذا النهج - كنتيجة للعب القط والفأر ، فإن المهاجم المصمم بشكل معقول سيتجاوزك دائمًا في السعي لتحقيق هدف ، أيا كان.هذا هو السبب في أن Qrator Labs اعتمدت نهج تصنيف البرامج الضارة ، وكذلك كل حركة المرور بشكل عام ، من أجل تزويد مالك التطبيق بأقصى قدر من البيانات والفرص لاتخاذ قرار مستنير ، مع الأخذ في الاعتبار العواقب المحتملة على المستخدمين وأهداف العمل. ومن الأمثلة الجيدة التي توضح العواقب المحتملة حاصرات الإعلانات. يتم تقديم معظم الإعلانات الحديثة على شبكة الإنترنت في شكل نصوص برمجية ، وهي عبارة عن حظر لا تمنعه بالضرورة الإعلان ، وليس ، على سبيل المثال ، التحقق من جافا سكريبت لخدمة حماية DDoS. من السهل تخيل أين يمكن أن يؤدي هذا المسار ، مما يؤدي في النهاية إلى انخفاض أرباح أعمال الإنترنت.عندما يتم حظر المهاجمين والحصول على الملاحظات التي يحتاجون إليها ، لا شيء يمنعهم من التكيف والتعلم والهجوم مرة أخرى. تعتمد تقنياتنا على فلسفة بسيطة وهي أن تزويد الروبوتات بملاحظات غير ضرورية - تحتاج إلى حظرها أو تخطيها ، ولكن ببساطة اكتشافها ووضع علامات عليها. بعد الانتهاء من وضع العلامات ، ونحن متأكدون من دقتها ، من الصواب طرح السؤال التالي: "ماذا يحتاجون؟" و "لماذا يهتمون بهذا؟" ربما يكفي تغيير محتوى صفحة الويب بشكل طفيف حتى لا يشعر أي شخص حي بالفرق ، لكن واقع الروبوت سينقلب رأسًا على عقب؟ إذا كانت هذه موزعات ، فمن الممكن أن تكون نسبة مئوية معينة من البيانات غير صحيحة وكاذبة ، ولكن على أي حال ستزيل الحماية من البحث عن ثنائي صفري أو واحد وتعطي شيئًا ماما هو مطلوب حقا هو الوقت.مناقشة هذه المشكلة طوال عام 2018 ، أطلقنا عليها هجمات مماثلة لتلك التي توصف بأنها هجمات على مقاييس العمل. يمكن أن يعمل موقع الويب والتطبيق والخادم بشكل جيد ، ولن يشتكي أي مستخدم ، لكنك لا تزال تشعر بشيء ... مثل انخفاض تكلفة الاكتساب من الإعلانات التي تجريها على النظام الأساسي للبرامج ، مما يدفع المعلنين نحو ذلك ، ولا حتى منافسيك.الحد من مكافأة المهاجم هو الطريقة الوحيدة لمواجهتها. محاولة لإيقاف السير لن تجلب سوى الوقت والمال الذي تنفقه. إذا نقر أي شيء على ما يجعلك تربح - قم بإلغاء هذه النقرات ؛ إذا تم تحليلك ، فيمكنك تضمين طبقة من المعلومات "المزيفة" يمكن من خلالها للمستخدم العادي والفضولي المرور بسهولة بحثًا عن المعلومات الصحيحة والموثوقة.

ومع ذلك ، فإن الحلول الآلية البحتة ، أو كما اعتدنا على تسميتها "برامج الروبوت" ، تواجه بعض الصعوبات في التفاعل. إذا كنت متأكدًا من أنه الروبوت الذي أنشأ الطلب غير المرغوب فيه والمحدّد تمامًا ، فإن أول شيء يريد معظم الناس فعله هو حظره دون الاستجابة من الخادم. ومع ذلك ، توصلنا إلى استنتاج مفاده أن مثل هذا النهج لا معنى له ، لأنه يقدم الكثير من الملاحظات لكل من الروبوت ومبدعه ، ويشجعك على البحث عن حل بديل. إذا كانت برامج الروبوت لا تحاول إيقاف تشغيل الخدمة ، بشكل عام ، فإننا ننصحك بعدم الوعظ بهذا النهج - كنتيجة للعب القط والفأر ، فإن المهاجم المصمم بشكل معقول سيتجاوزك دائمًا في السعي لتحقيق هدف ، أيا كان.هذا هو السبب في أن Qrator Labs اعتمدت نهج تصنيف البرامج الضارة ، وكذلك كل حركة المرور بشكل عام ، من أجل تزويد مالك التطبيق بأقصى قدر من البيانات والفرص لاتخاذ قرار مستنير ، مع الأخذ في الاعتبار العواقب المحتملة على المستخدمين وأهداف العمل. ومن الأمثلة الجيدة التي توضح العواقب المحتملة حاصرات الإعلانات. يتم تقديم معظم الإعلانات الحديثة على شبكة الإنترنت في شكل نصوص برمجية ، وهي عبارة عن حظر لا تمنعه بالضرورة الإعلان ، وليس ، على سبيل المثال ، التحقق من جافا سكريبت لخدمة حماية DDoS. من السهل تخيل أين يمكن أن يؤدي هذا المسار ، مما يؤدي في النهاية إلى انخفاض أرباح أعمال الإنترنت.عندما يتم حظر المهاجمين والحصول على الملاحظات التي يحتاجون إليها ، لا شيء يمنعهم من التكيف والتعلم والهجوم مرة أخرى. تعتمد تقنياتنا على فلسفة بسيطة وهي أن تزويد الروبوتات بملاحظات غير ضرورية - تحتاج إلى حظرها أو تخطيها ، ولكن ببساطة اكتشافها ووضع علامات عليها. بعد الانتهاء من وضع العلامات ، ونحن متأكدون من دقتها ، من الصواب طرح السؤال التالي: "ماذا يحتاجون؟" و "لماذا يهتمون بهذا؟" ربما يكفي تغيير محتوى صفحة الويب بشكل طفيف حتى لا يشعر أي شخص حي بالفرق ، لكن واقع الروبوت سينقلب رأسًا على عقب؟ إذا كانت هذه موزعات ، فمن الممكن أن تكون نسبة مئوية معينة من البيانات غير صحيحة وكاذبة ، ولكن على أي حال ستزيل الحماية من البحث عن ثنائي صفري أو واحد وتعطي شيئًا ماما هو مطلوب حقا هو الوقت.مناقشة هذه المشكلة طوال عام 2018 ، أطلقنا عليها هجمات مماثلة لتلك التي توصف بأنها هجمات على مقاييس العمل. يمكن أن يعمل موقع الويب والتطبيق والخادم بشكل جيد ، ولن يشتكي أي مستخدم ، لكنك لا تزال تشعر بشيء ... مثل انخفاض تكلفة الاكتساب من الإعلانات التي تجريها على النظام الأساسي للبرامج ، مما يدفع المعلنين نحو ذلك ، ولا حتى منافسيك.الحد من مكافأة المهاجم هو الطريقة الوحيدة لمواجهتها. محاولة لإيقاف السير لن تجلب سوى الوقت والمال الذي تنفقه. إذا نقر أي شيء على ما يجعلك تربح - قم بإلغاء هذه النقرات ؛ إذا تم تحليلك ، فيمكنك تضمين طبقة من المعلومات "المزيفة" يمكن من خلالها للمستخدم العادي والفضولي المرور بسهولة بحثًا عن المعلومات الصحيحة والموثوقة.كليك هاوس

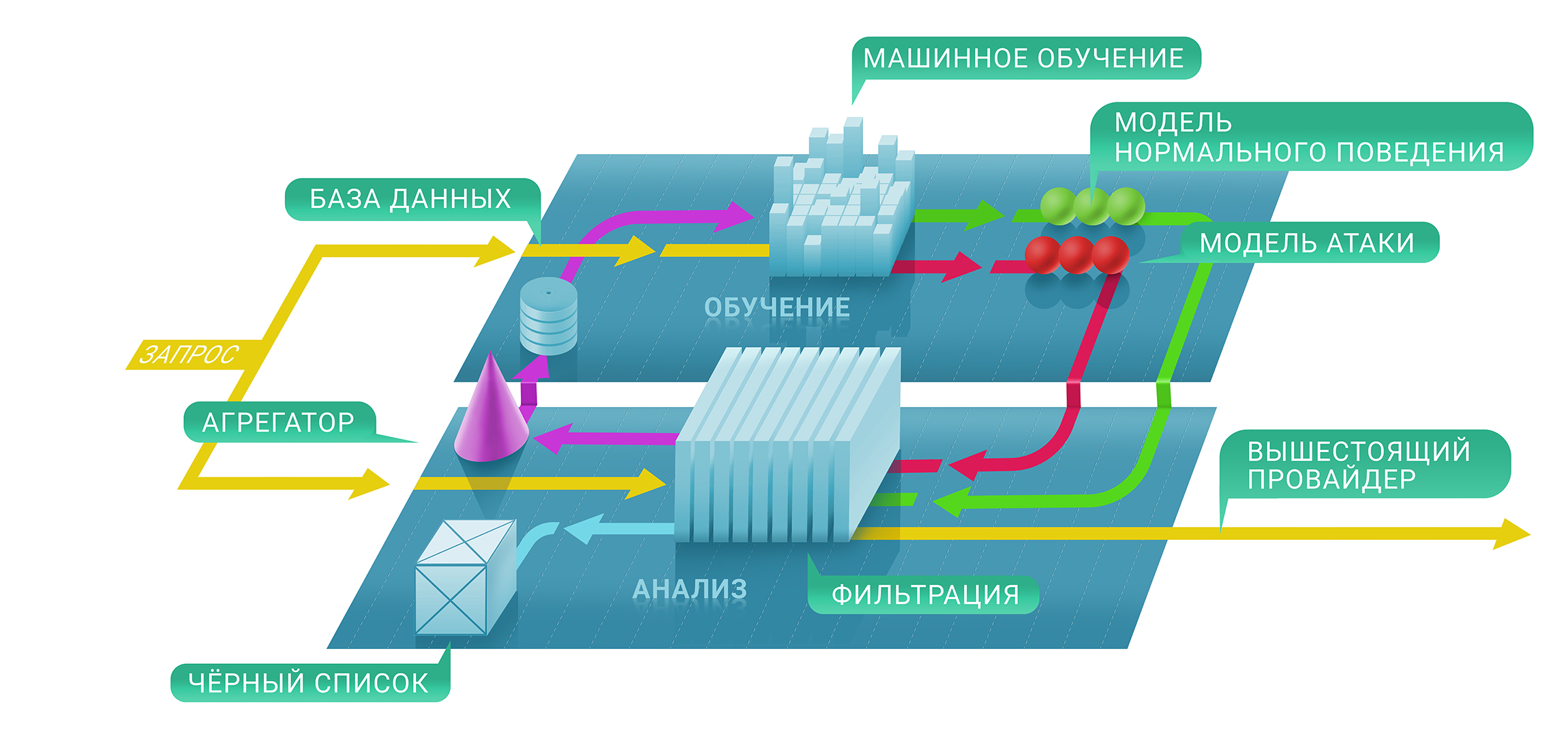

على مستوى عالٍ ، تتكون خدمة تصفية Qrator من مستويين: على المستوى الأول ، نقوم على الفور بتقييم ما إذا كان هناك طلب معين ضار باستخدام عمليات تحقق مع وبدون حالة ، وفي الثاني ، نقرر ما إذا كان سيتم الاحتفاظ بالمصدر في القائمة السوداء وإلى متى . يمكن تمثيل القائمة السوداء الناتجة كجدول فريد لعناوين IP.في المرحلة الأولى من هذه العملية ، نستخدم تقنيات التعلم الآلي من أجل فهم أفضل للمستويات والخصائص الطبيعية لحركة المرور لكل مورد على حدة ، حيث يتم تكوين كل معلمة حماية لكل خدمة فردية على أساس المقاييس التي نجمعها.هذا هو المكان الذي يأتي Clickhouse في. لفهم سبب منع عنوان IP معين من الاتصال بالمورد بشكل أفضل ، نحتاج إلى تتبع الطريقة الكاملة للتعلم الآلي على طول الطريق إلى قاعدة بيانات Clickhouse. إنه يعمل بسرعة كبيرة مع مجموعات كبيرة من البيانات (تخيل هجوم DDoS بسرعة 500 جيجابت / ثانية ويستغرق عدة ساعات من الوقت الخالص خارج فترات الإيقاف المؤقت) ويخزنها في شكل مناسب لإطار التعلم الآلي المستخدم في Qrator Labs. يؤدي المزيد من السجلات وحركة المرور المحفوظة لهجمات DDoS إلى نتائج دقيقة من النماذج الخاصة بنا ، والتي تساعد في تحسين خدمة التصفية في الوقت الفعلي ، في ظل أكثر الهجمات خطورة.نستخدم Clickhouse DB لتخزين جميع سجلات حركة المرور غير المشروعة وأنماط سلوك الروبوت. لقد تم اختيار هذا الحل المتخصص من قِبلنا بسبب الإمكانات الكبيرة لتخزين مجموعات البيانات الضخمة بأسلوب قاعدة بيانات كلاسيكية بغرض المعالجة اللاحقة. يستخدم تحليل هذه البيانات أيضًا لإنشاء أنماط من هجمات DDoS ، مما يساعد على تعلم الآلة لتحسين خوارزميات تصفية حركة المرور الخاصة بنا باستمرار.من الميزات المهمة لبرنامج Clickhouse ، مقارنة بقواعد البيانات الأخرى ، أنه لا يحتاج إلى قراءة متغير بيانات سلسلة بالكامل - فقد يستغرق شريحة أصغر بكثير ، وهي ضرورية للغاية إذا قمت بتخزين كل شيء وفقًا للتوصيات. وهي تعمل بسرعة!

على مستوى عالٍ ، تتكون خدمة تصفية Qrator من مستويين: على المستوى الأول ، نقوم على الفور بتقييم ما إذا كان هناك طلب معين ضار باستخدام عمليات تحقق مع وبدون حالة ، وفي الثاني ، نقرر ما إذا كان سيتم الاحتفاظ بالمصدر في القائمة السوداء وإلى متى . يمكن تمثيل القائمة السوداء الناتجة كجدول فريد لعناوين IP.في المرحلة الأولى من هذه العملية ، نستخدم تقنيات التعلم الآلي من أجل فهم أفضل للمستويات والخصائص الطبيعية لحركة المرور لكل مورد على حدة ، حيث يتم تكوين كل معلمة حماية لكل خدمة فردية على أساس المقاييس التي نجمعها.هذا هو المكان الذي يأتي Clickhouse في. لفهم سبب منع عنوان IP معين من الاتصال بالمورد بشكل أفضل ، نحتاج إلى تتبع الطريقة الكاملة للتعلم الآلي على طول الطريق إلى قاعدة بيانات Clickhouse. إنه يعمل بسرعة كبيرة مع مجموعات كبيرة من البيانات (تخيل هجوم DDoS بسرعة 500 جيجابت / ثانية ويستغرق عدة ساعات من الوقت الخالص خارج فترات الإيقاف المؤقت) ويخزنها في شكل مناسب لإطار التعلم الآلي المستخدم في Qrator Labs. يؤدي المزيد من السجلات وحركة المرور المحفوظة لهجمات DDoS إلى نتائج دقيقة من النماذج الخاصة بنا ، والتي تساعد في تحسين خدمة التصفية في الوقت الفعلي ، في ظل أكثر الهجمات خطورة.نستخدم Clickhouse DB لتخزين جميع سجلات حركة المرور غير المشروعة وأنماط سلوك الروبوت. لقد تم اختيار هذا الحل المتخصص من قِبلنا بسبب الإمكانات الكبيرة لتخزين مجموعات البيانات الضخمة بأسلوب قاعدة بيانات كلاسيكية بغرض المعالجة اللاحقة. يستخدم تحليل هذه البيانات أيضًا لإنشاء أنماط من هجمات DDoS ، مما يساعد على تعلم الآلة لتحسين خوارزميات تصفية حركة المرور الخاصة بنا باستمرار.من الميزات المهمة لبرنامج Clickhouse ، مقارنة بقواعد البيانات الأخرى ، أنه لا يحتاج إلى قراءة متغير بيانات سلسلة بالكامل - فقد يستغرق شريحة أصغر بكثير ، وهي ضرورية للغاية إذا قمت بتخزين كل شيء وفقًا للتوصيات. وهي تعمل بسرعة!الخاتمة

لفترة طويلة ، كنا نعيش في عالم من الهجمات متعددة العوامل التي تستغل قدرات الهجوم من العديد من البروتوكولات في وقت واحد لإخراج الهدف من حالة صحية.

يجب أن تغطي النظافة الرقمية والإجراءات الأمنية ذات الصلة ، في الواقع ، حوالي 99٪ من المخاطر الحالية التي قد يواجهها المستخدم العادي ، باستثناء ربما هجمات شديدة التخصص على أهداف محددة.

من ناحية أخرى ، على شبكة الإنترنت الحديثة هناك أسماك قرش يمكن أن تعض على وصول جميع الدول. لا ينطبق هذا على BGP ، حيث يكون من الممكن سداد بعض النقاط فقط على أي خريطة يريد المهاجم رسمها.

يستمر مستوى المعرفة بأمان الشبكة في النمو. ومع ذلك ، إذا نظرت إلى الأرقام المرتبطة بعدد مكبرات الصوت في الشبكات أو بحثت عن احتمال وجود طلبات وهمية - لا ينخفض عدد الخدمات والخوادم المعرضة للخطر. المعدل اليومي الذي يكتسب فيه الشباب المعرفة فيما يتعلق بمهارات البرمجة وإدارة شبكات الكمبيوتر لا يتوافق مع الوقت اللازم لاكتساب الخبرة ذات الصلة في الحياة الحقيقية. إن الثقة في عدم ظهور ثغرات أمنية جديدة مع منتجات جديدة تستغرق وقتًا طويلاً ، والأهم من ذلك - إنها مؤلمة.

كان أحد أكثر الاكتشافات إثارة للدهشة في العام الماضي هو أن معظم الناس يتوقعون أكثر بكثير من التقنيات الجديدة مما يمكنهم تقديمه. لم يكن هذا هو الحال دائمًا ، ولكن في الوقت الحالي نشهد ميلًا متزايدًا للناس "للمطالبة بالمزيد" بغض النظر عن قدرات البرنامج ، وخاصة الأجهزة. هذا يقودنا إلى عالم من الحملات التسويقية الضارة إلى حد ما. لكن الناس ، مع ذلك ، يواصلون "شراء الوعود" والشركات ، بدورها ، تشعر بأنها مضطرة للوفاء بها.

ربما هذا هو جوهر التقدم والتطور. الآن كثيرون منزعجون من حقيقة عدم الحصول على "مضمونة" والتي دفعت من أجلها. نظرًا لاستحالة شراء "جهاز" تمامًا من الشركة المُصنّعة ، فإن العديد من مشكلات اليوم آخذة في الازدياد ، لكن تكلفة الخدمات "المجانية" يمكن أن تكون رائعة إذا نظرت إلى التكلفة التراكمية للبيانات الواردة من مستخدم عبر شبكة اجتماعية كبيرة لا تتطلب الدفع.

تخبرنا النزعة الاستهلاكية أننا إذا كنا نريد حقًا شيئًا ما ، فسوف ندفع بحياتنا في النهاية. هل نحتاج حقًا إلى منتجات وخدمات مماثلة تعمل على تحسين نفسها فقط من أجل تقديم "عروض محسنة" لنا استنادًا إلى البيانات التي جمعناها عنا ، سواء أحببنا ذلك أم لا؟ ومع ذلك ، يبدو أن هذا هو المستقبل القريب ، كما أظهرت لنا حالات Equifax و Cambridge Analytica مؤخرًا. ليس من المستغرب إذا كان هناك "فرقعة كبيرة" أمامنا لاستخدام البيانات الشخصية وغيرها من البيانات المتعلقة بالحياة الفردية للجميع.

بعد عشر سنوات من العمل ، لم نغير الأسس الرئيسية حول بنية الإنترنت. هذا هو السبب في أننا نواصل تطوير شبكة تصفية أي بث BGP مع القدرة على معالجة حركة المرور المشفرة في هذا النموذج ، وتجنب captcha والعقبات الأخرى غير المتوقعة للمستخدم الشرعي.

بمراقبة ما يحدث للخبراء في مجال الأمن السيبراني ، فضلاً عن الشركات في هذا المجال ، نريد مرة أخرى تكرار ما هو واضح: نهج ساذج وبسيط وسريع لا ينطبق.

لذلك ، ليس لدى Qrator Labs المئات أو حتى العشرات من نقاط التواجد المماثلة لـ CDNs. من خلال إدارة عدد أقل من مراكز التصفية ، يرتبط كل منها بموفري خدمات الإنترنت من فئة لا تقل عن المستوى 1 ، نحقق اللامركزية الحقيقية. للسبب نفسه ، نحن لا نحاول بناء جدار الحماية الخاص بنا ، وهي مهمة بمستوى مختلف تمامًا عن المستوى الذي نعمل عليه - الاتصال.

على مر السنين ، قلنا أنه في النهاية ، لن ينجح التحقق من captcha أو جافا سكريبت ، وهنا نحن في عام 2019 ، عندما أصبحت الشبكات العصبية فعالة للغاية في حل الأول ، ولم تشكل الأخيرة مشكلة للمهاجم مع الدماغ.

أود أن أشير إلى تغيير أكثر إثارة للاهتمام على الحدود الزمنية: هجمات DDoS لطالما كانت مشكلة خطيرة فقط لعدد محدود من قطاعات الأعمال ، عادةً تلك التي يتأرجح فيها المال: التجارة الإلكترونية ، التبادل التجاري ، أنظمة البنوك والدفع. ولكن مع التطوير المستمر للإنترنت ، نشهد هجمات DDoS تزداد شدتها وتواترها في جميع أنحاء الإنترنت. بدأ عصر DDoS مع عتبة معينة لسرعة أجهزة التوجيه المنزلية ، وليس من المستغرب أنه مع ظهور رقاقة في كل شيء مادي حول المشهد الهجوم بدأ يتغير بسرعة.

أي شخص يتوقع نهاية تطور هذا الاتجاه هو على الأرجح خطأ. تماما كما نحن مخطئون ، بعد أن كتبت الكثير من التنبؤات. لا يمكن لأحد أن يقول على وجه اليقين كيف ستطور شبكة الإنترنت وتنفذ نفوذها في السنوات القادمة بالضبط ، ولكن بالنظر إلى ما رأيناه ، هناك شيء واحد واضح - كل شيء سيتضاعف. في عام 2020 ، يجب أن يتجاوز عدد الأجهزة المتصلة بالشبكة 30 مليار ، ناهيك عن الحقيقة البسيطة المتمثلة في أن الروبوتات تولد حركة مرور أكثر بكثير من البشر. قريبًا ، سيتعين علينا أن نقرر ما يجب فعله بكل هذه "الذكاء" ، سواء كان مصطنعًا أم لا ، حيث أننا لا نزال نعيش في عالم يكون فيه الفرد البشري مسؤولاً عن أفعاله ، سواء أكانت صحيحة أم خاطئة

كان عام 2018 عام الفرصة للجانب المظلم. لقد شهدنا زيادة في الهجمات ، وفي الوقت نفسه تعقيدها وزيادة حجمها من حيث الشبكة والتردد. حصل الأشرار على أدوات قوية وأمضوا الكثير من الوقت في دراستهم ، بينما لم يفعل الأهل الخير أكثر من مجرد مشاهدة تقدمهم. نأمل مخلصين أن يتغير هذا العام على الأقل ، على الأقل في أكثر الأماكن إيلاما.

→

رابط إلى النسخة الكاملة من التقرير باللغة الروسية.