تُعرف الشبكات العصبية بعدم فهمها - حيث يمكن للكمبيوتر أن يقدم إجابة جيدة ، لكن لا يمكنه شرح ما أدى إلى هذا الاستنتاج. يقوم بن كيم بتطوير "مترجم بشري" بحيث إذا تعطل الذكاء الاصطناعي ، يمكننا فهمه.

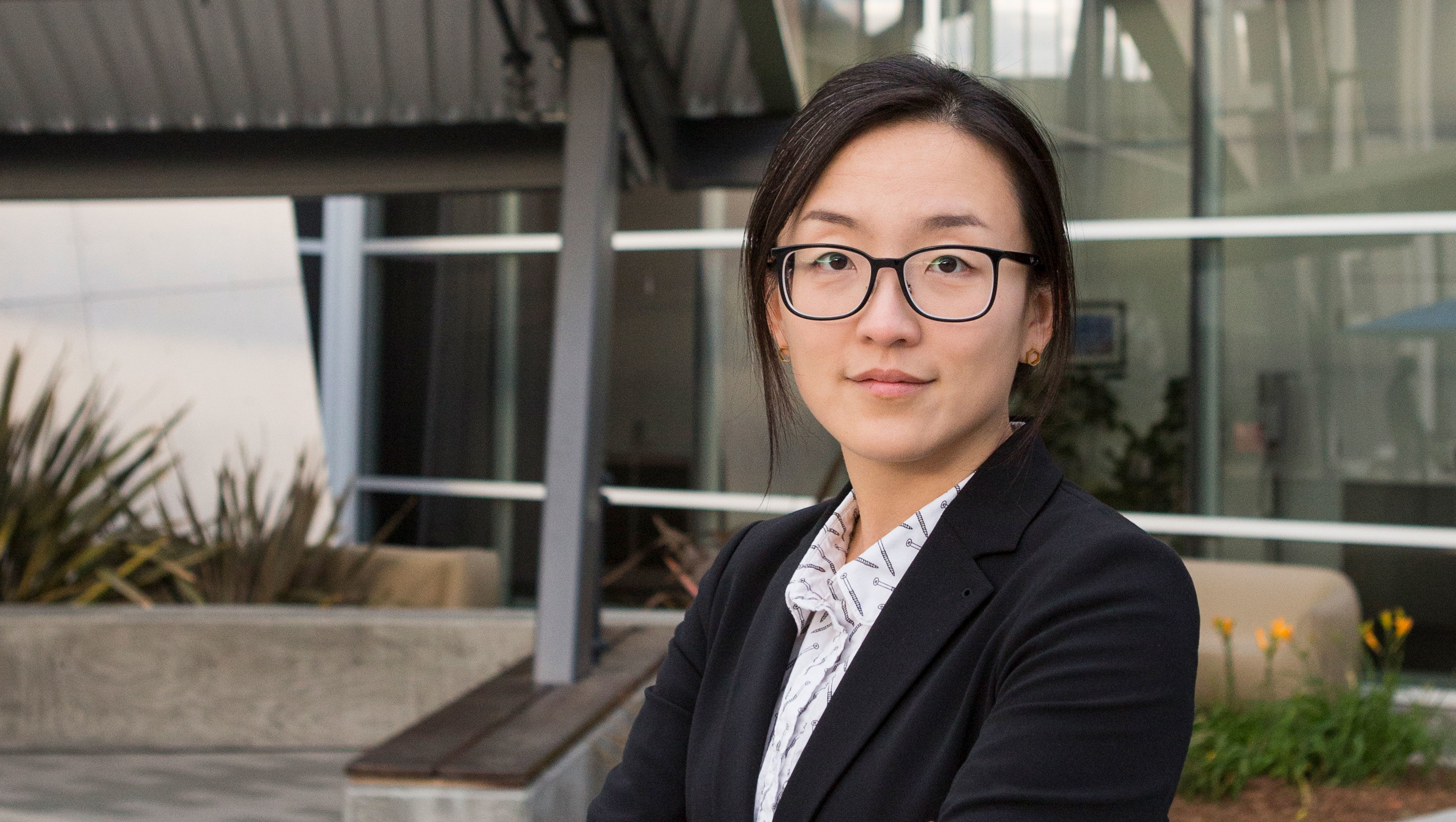

تقوم Bean Kim ، الباحثة في Google Brain ، بتطوير طريقة للتشكيك في نظام تعلّم آلي حول قراراتها.

تقوم Bean Kim ، الباحثة في Google Brain ، بتطوير طريقة للتشكيك في نظام تعلّم آلي حول قراراتها.إذا أخبرك الطبيب أنك بحاجة إلى عملية جراحية ، فسوف ترغب في معرفة السبب - وستتوقع أن يبدوا أن تفسيره سيكون ذا معنى بالنسبة لك ، حتى لو لم تكن قد تدربت كطبيب. يعتقد "كيم" ، الباحث في Google Brain ، أنه يجب علينا أن نتوقع نفس الشيء من الذكاء الاصطناعي (AI). وهي متخصصة في "التفسير الآلي" (MO) ، وتريد إنشاء منظمة العفو الدولية التي يمكن أن تشرح تصرفاتها لأي شخص.

منذ عشر سنوات مضت ، بدأت تقنية الشبكات العصبية وراء الذكاء الاصطناعي تنتشر أكثر فأكثر ، وتمكنت من تحويل جميع العمليات ، من فرز البريد الإلكتروني إلى العثور على أدوية جديدة ، بفضل قدرتها على التعلم من البيانات والبحث عن الأنماط فيها. لكن هذه القدرة لها قدرة لا يمكن تفسيرها: التعقيد الشديد الذي يسمح للشبكات العصبية الحديثة مع التدريب المتعمق للتعلم بنجاح كيفية قيادة السيارة والتعرف على الاحتيال بالتأمين يجعل من المستحيل تقريبًا على الخبراء فهم مبادئ عملهم. إذا تم تدريب شبكة عصبية للبحث عن المرضى المعرضين لخطر الإصابة بسرطان الكبد أو انفصام الشخصية - وتم إطلاق مثل هذا النظام المسمى "المريض العميق" في مستشفى ماونت سيناي في نيويورك في عام 2015 - فلا توجد طريقة لفهم أي منها ميزات البيانات الشبكة العصبية "تولي اهتماما". تنتشر هذه "المعرفة" على العديد من طبقات الخلايا العصبية الاصطناعية ، ولكل منها روابط مع مئات أو آلاف الخلايا العصبية الأخرى.

نظرًا لأن المزيد من الصناعات تحاول أتمتة أو تحسين عمليات صنع القرار باستخدام الذكاء الاصطناعى ، فإن مشكلة "الصندوق الأسود" هذه تبدو أقل خللًا تكنولوجيًا ، وأكثر عيبًا أساسيًا. يقوم مشروع من DARPA يسمى XAI (اختصار لـ "Explanable AI" ، eXplainable AI) باستكشاف هذه المشكلة بفاعلية ، والقدرة على التفسير تنتقل من الخطوط الأمامية للبحث في مجال MO أقرب إلى مركزها. يقول كيم: "يمر الذكاء الاصطناعي في لحظة حرجة عندما نحاول نحن ، الإنسانية ، معرفة ما إذا كانت هذه التكنولوجيا مناسبة لنا". "إذا لم نحل مشكلة التفسير ، أعتقد أننا لن نتمكن من المضي قدمًا في هذه التكنولوجيا ، وربما سنرفضها ببساطة."

طورت كيم وزملاؤها في Google Brain مؤخرًا نظام اختبار مع ناقلات تنشيط المفردات (TCAV) ، والذي تصفه كمترجم بشري يسمح للمستخدم بطرح سؤال حول الصندوق الأسود لمنظمة العفو الدولية حول ما مدى مشاركة مفهوم رفيع المستوى في صنع القرار. على سبيل المثال ، إذا تم تدريب نظام MO على العثور على صور حمار وحشي ، يمكن للشخص أن يطلب من TCAV وصف مقدار مفهوم "المشارب" في عملية صنع القرار.

تم اختبار TCAV في البداية على نماذج مدربة على التعرف على الصور ، لكنها تعمل أيضًا مع نماذج مصممة لمعالجة النصوص أو مهام معينة لتصور البيانات ، على سبيل المثال ، رسومات EEG. يقول كيم: "إنه معمم وبسيط - يمكن توصيله بالعديد من الطرز المختلفة".

تحدث كوانتا مع كيم حول معنى التفسير ، ومن يحتاج إليه ، ولماذا يهم.

لقد ركزت في حياتك المهنية على "التفسير" لوزارة الداخلية. ولكن ماذا يعني هذا المصطلح بالضبط؟

لقد ركزت في حياتك المهنية على "التفسير" لوزارة الداخلية. ولكن ماذا يعني هذا المصطلح بالضبط؟التفسير له فرعين. أحدهما هو قابلية التفسير للعلم: إذا نظرت إلى الشبكة العصبية ككائن للدراسة ، فيمكنك إجراء تجارب علمية عليها لفهم حقيقة مجمل وعموميات النموذج وأسباب رد فعله وما إلى ذلك.

الفرع الثاني ، الذي ركّز عليه جهودي بشكل أساسي ، هو التفسير لإنشاء منظمة العفو الدولية القادرة على الإجابة على الأسئلة. لا تحتاج إلى فهم كل التفاصيل الصغيرة للنموذج. لكن هدفنا هو فهم ما يكفي حتى يمكن استخدام هذه الأداة بأمان.

ولكن كيف يمكن للمرء أن يؤمن بالنظام ، إذا لم يفهم المرء تمامًا كيف يعمل؟سأقدم لك تشبيه. لنفترض أن هناك شجرة أريد أن أقطعها في الفناء. لدي بالمنشار لهذا الغرض. أنا لا أفهم بالضبط كيف تعمل بالمنشار. لكن التعليمات تقول: "شيء يجب التعامل معه بحذر ألا تقطع نفسك". بعد الحصول على الإرشادات ، كان من الأفضل استخدام المنشار بدلاً من المنشار اليدوي - من السهل فهم هذا الأخير ، لكن يجب أن أشاهده لمدة خمس ساعات.

أنت تفهم معنى "القطع" ، حتى لو كنت لا تعرف كل شيء عن الآلية التي تجعل ذلك ممكنًا.نعم الغرض من الفرع الثاني من التفسير هو كما يلي: هل يمكننا أن نفهم الأداة بما يكفي لتكون آمنة للاستخدام؟ ويمكننا خلق هذا الفهم من خلال التأكيد على أن المعرفة الإنسانية المفيدة تنعكس في الأداة.

ولكن كيف "انعكاس المعرفة الإنسانية" يجعل الصندوق الأسود لمنظمة العفو الدولية أكثر قابلية للفهم؟هنا مثال آخر. إذا استخدم الطبيب نموذج MO لإجراء تشخيص للسرطان ، فسوف يحتاج الطبيب إلى معرفة أن النموذج لا يختار ببساطة بعض الارتباط العشوائي في البيانات التي لا نحتاج إليها. تتمثل إحدى طرق التحقق من ذلك في التأكد من أن نموذج MO يفعل نفس الشيء الذي سيفعله الطبيب. وهذا هو ، لإظهار أن المعرفة التشخيصية للطبيب تنعكس في النموذج.

على سبيل المثال ، إذا بحث الطبيب عن حالة خلية مناسبة لتشخيص السرطان ، فسوف يبحث عن شيء يسمى "الغدة المدمجة". سيأخذ بعين الاعتبار مؤشرات مثل عمر المريض ، وما إذا كان قد خضع للعلاج الكيميائي في الماضي. سيتم أخذ هذه العوامل أو المفاهيم في الاعتبار من قبل طبيب يحاول تشخيص السرطان. إذا استطعنا أن نوضح أن نموذج MO يلفت الانتباه إليهم ، فسيكون هذا النموذج أكثر قابلية للفهم ، لأنه سيعكس المعرفة الإنسانية للأطباء.

هذا هو ما تتعامل به TCAV - أي المفاهيم عالية المستوى التي يستخدمها نموذج MO لاتخاذ القرارات؟نعم وقبل ذلك ، أوضحت طرق التفسير فقط ما تقوم به الشبكة العصبية من حيث "ميزات الإدخال". ماذا يعني هذا؟ إذا كانت لديك صورة ، فسيكون كل بكسل لها ميزة إدخال.

قال Yang Lekun (رائد التعلم العميق ، مدير أبحاث الذكاء الاصطناعى في Facebook) ، إنه يعتبر هذه النماذج قابلة للتفسير ، حيث يمكنك النظر في كل عقدة من الشبكة العصبية ورؤية القيم العددية لكل من ميزات الإدخال. بالنسبة إلى أجهزة الكمبيوتر ، قد يكون هذا مناسبًا ، لكن الناس يفكرون بطريقة مختلفة. لا أخبرك "انظر إلى البيكسلات من 100 إلى 200 ، وقيمها RGB هي 0.2 و 0.3". أنا أقول ، "هذه صورة لكلب أشعث". يتواصل الناس بهذه الطريقة - من خلال المفاهيم.

كيف تترجم TCAV بين ميزات الإدخال ومفاهيمه؟دعنا نعود إلى مثال طبيب يستخدم نموذج MO ، الذي تم تدريبه بالفعل لتصنيف صور لعينات الخلايا وفقًا للسرطان. أنت ، كطبيب ، تحتاج إلى معرفة مدى أهمية مفهوم "الغدد المدمجة" بالنسبة للنموذج في تقديم تنبؤات إيجابية عن السرطان. أولاً ، تقوم بجمع 20 صورة تظهر أمثلة على الغدد المدمجة. ثم قمت بتوصيل هذه الأمثلة المسمى بالنموذج.

ثم ، TCAV داخل نفسه ينفذ ما يسمى "فحص الحساسية". عندما نضيف هذه الصور المصنفة للغدد المدمجة ، إلى أي مدى يزداد احتمال التنبؤ الإيجابي بالسرطان؟ يمكن تقدير الإجابة برقم من 0 إلى 1. وستكون هذه نقاطك في TCAV. إذا زاد الاحتمال ، كان هذا المفهوم مهمًا للنموذج. إذا لم يكن كذلك ، هذا المفهوم ليس مهما.

"مفهوم" هو مصطلح غامض. هل هناك أي مفاهيم لن تعمل مع TCAV؟إذا لم تتمكن من وصف مفهوم باستخدام مجموعة فرعية من مجموعة البيانات الخاصة بك ، فلن ينجح ذلك. إذا تم تدريب نموذج MO الخاص بك على الصور ، فيجب التعبير عن المفهوم بصريًا. على سبيل المثال ، إذا أردت التعبير بصريًا عن مفهوم الحب ، فسيكون من الصعب جدًا القيام بذلك.

نحن أيضا التحقق بعناية المفهوم. لدينا إجراء تحقق إحصائي يرفض متجه المفهوم إذا كان له تأثير مكافئ عشوائي على النموذج. إذا لم ينجح مفهومك في هذا الاختبار ، فستقول TCAV: "لا أعرف ، لا يبدو هذا المفهوم شيئًا مهمًا للنموذج."

هل يركز مشروع TCAV على بناء ثقة الذكاء الاصطناعى أكثر من تعميم فهمه؟

هل يركز مشروع TCAV على بناء ثقة الذكاء الاصطناعى أكثر من تعميم فهمه؟لا ، - وسأشرح السبب ، لأن هذا الاختلاف دقيق للغاية.

من العديد من الدراسات في مجال العلوم المعرفية وعلم النفس ، نعلم أن الناس يثقون كثيرًا. هذا يعني أنه من السهل جدًا خداع شخص ما بإجباره على الإيمان بشيء ما. الهدف من التفسير MO هو عكس ذلك. وهو يتألف من إبلاغ شخص أنه من غير الآمن استخدام نظام معين. الهدف هو كشف الحقيقة. لذلك ، "الثقة" ليست الكلمة الصحيحة.

إذن الهدف من التفسير هو الكشف عن العيوب المحتملة في التفكير في الذكاء الاصطناعى؟نعم بالضبط

كيف يمكن أن تكشف عن العيوب؟يمكن استخدام TCAV لطرح النموذج على سؤال حول المفاهيم التي لا تتعلق بمجال البحث. العودة إلى مثال الأطباء الذين يستخدمون الذكاء الاصطناعي للتنبؤ باحتمال الإصابة بالسرطان. قد يفكر الأطباء فجأة: "على ما يبدو ، تعطي الآلة تنبؤات إيجابية بوجود سرطان للعديد من الصور التي يتحول فيها اللون قليلاً إلى اللون الأزرق. نعتقد أن هذا العامل لا ينبغي أن يؤخذ بعين الاعتبار ". وإذا حصلوا على درجة TCAV عالية للأزرق ، فهذا يعني أنهم وجدوا مشكلة في نموذج MO الخاص بهم.

تم تصميم TCAV ليتم تعليقه على أنظمة AI الحالية التي لا يمكن تفسيرها. لماذا لا تصنع على الفور أنظمة مترجمة بدلاً من الصناديق السوداء؟هناك فرع لدراسة التفسير ، يركز على إنشاء نماذج مبدئية مبدئية تعكس منطق الشخص. لكنني أعتقد ذلك: الآن أصبحنا بالفعل ممتلئين بنماذج الذكاء الاصطناعي الجاهزة التي يتم استخدامها بالفعل لحل المشكلات المهمة ، وعند إنشائها ، لم نفكر في البداية في التفسير. من السهل أن تأكل. كثير منهم يعملون على جوجل! يمكنك أن تقول ، "إن الترجمة الفورية مفيدة للغاية بحيث تسمح لنا بإنشاء نموذج آخر لك لتحل محل النموذج الذي لديك." حسنا ، حظا سعيدا.

ثم ماذا تفعل؟ لا نزال بحاجة إلى المرور بهذه اللحظة الحاسمة في تقرير ما إذا كانت هذه التكنولوجيا مفيدة لنا أم لا. لذلك ، أنا أعمل على أساليب تفسير ما بعد التدريب. إذا أعطاك شخص ما نموذجًا ولا يمكنك تغييره ، فكيف تتعامل مع مهمة توليد توضيحات لسلوكها بحيث يمكنك استخدامها بأمان؟ هذا هو بالضبط ما يفعله TCAV.

يتيح TCAV للناس أن يسألوا منظمة العفو الدولية عن أهمية بعض المفاهيم. ولكن ماذا لو كنا لا نعرف ماذا نسأل - ماذا لو أردنا أن تشرح منظمة العفو الدولية؟

يتيح TCAV للناس أن يسألوا منظمة العفو الدولية عن أهمية بعض المفاهيم. ولكن ماذا لو كنا لا نعرف ماذا نسأل - ماذا لو أردنا أن تشرح منظمة العفو الدولية؟نعمل حاليًا على مشروع يمكنه أن يجد المفاهيم تلقائيًا لك. نحن نسميها DTCAV - افتتاح TCAV. لكنني أعتقد أن المشكلة الرئيسية المتمثلة في التفسير هي أن الناس يشاركون في هذه العملية ، وأننا نسمح للأفراد والآلات بالتواصل.

في العديد من الحالات ، عند التعامل مع التطبيقات التي تعتمد عليها كثيرًا ، يكون لدى الخبراء في مجال معين بالفعل قائمة بالمفاهيم المهمة بالنسبة لهم. نحن في Google Brain نواجه هذا باستمرار في التطبيقات الطبية لمنظمة العفو الدولية. لا يحتاجون إلى مجموعة من المفاهيم - فهم يرغبون في تقديم نماذج مفاهيم مثيرة للاهتمام لهم. نحن نعمل مع طبيب يعالج اعتلال الشبكية السكري وأمراض العيون ، وعندما أخبرناها عن TCAV ، كانت سعيدة للغاية لأنها لديها بالفعل مجموعة كاملة من الفرضيات حول ما يمكن أن يفعله النموذج ، والآن يمكنها التحقق من جميع الأسئلة التي نشأت. هذه ميزة إضافية ضخمة ، وهي وسيلة تتمحور حول المستخدم لتطبيق تعلم الآلة التعاوني.

تعتقد أنه بدون التفسير ، يمكن للبشرية ببساطة التخلي عن تكنولوجيا الذكاء الاصطناعي. النظر في الفرص المتاحة لها ، هل حقا تقييم مثل هذا الخيار الحقيقي؟نعم هذا هو بالضبط ما حدث مع النظم الخبيرة. في الثمانينات ، قررنا أنهم أرخص من الناس في حل بعض المشاكل. ومن يستخدم النظم الخبيرة اليوم؟ لا احد وبعد ذلك جاء فصل الشتاء لمنظمة العفو الدولية.

حتى الآن ، لا يبدو هذا مرجحًا ، حيث يتم استثمار الكثير من الضجيج والمال في منظمة العفو الدولية. لكن على المدى البعيد ، أعتقد أن الإنسانية يمكنها أن تقرر - ربما بسبب الخوف ، ربما بسبب نقص الأدلة - أن هذه التكنولوجيا لا تناسبنا. إنه ممكن.