tl ؛ د:

- التعلم الآلي يبحث عن أنماط في البيانات. لكن الذكاء الاصطناعي يمكن أن يكون "متحيزًا" - أي ، ابحث عن الأنماط الخاطئة. على سبيل المثال ، قد يولي نظام الكشف عن سرطان الجلد من الصور اهتمامًا خاصًا للصور التي تم التقاطها في مكتب الطبيب. التعلم الآلي لا يعرف كيف: الخوارزميات تكشف فقط عن الأنماط بالأرقام ، وإذا كانت البيانات غير ممثلة ، فستكون نتيجة معالجتها. وقد يكون التقاط مثل هذه الأخطاء أمرًا صعبًا بسبب آليات التعلم الآلي.

- المشكلة الأكثر وضوحا والخوف هو التنوع البشري. هناك العديد من الأسباب وراء فقد البيانات المتعلقة بالأشخاص موضوعيتها حتى في مرحلة التجميع. لكن لا يجب أن تعتقد أن هذه المشكلة تخص الأشخاص فقط: تنشأ بالضبط نفس الصعوبات عند محاولة العثور على فيضان في مستودع أو توربينات غازية فاشلة. بعض الأنظمة قد يكون لها انحياز فيما يتعلق بلون البشرة ، بينما تكون الأنظمة الأخرى متحيزة ضد أجهزة استشعار Siemens.

- هذه المشاكل ليست جديدة على التعلم الآلي ، وهي أبعد ما تكون عن فريدة بالنسبة له. يتم وضع افتراضات غير صحيحة في أي هياكل معقدة ، ومن الصعب دائمًا فهم سبب اتخاذ القرار. من الضروري التعامل مع هذا بطريقة معقدة: إنشاء أدوات وعمليات للتحقق - وتثقيف المستخدمين حتى لا يتبعوا توصيات منظمة العفو الدولية بصورة عمياء. إن التعلم الآلي يؤدي فعلًا بعض الأشياء أفضل منا كثيرًا ، ولكن الكلاب ، على سبيل المثال ، أكثر فاعلية من الأشخاص في اكتشاف المخدرات ، وهذا ليس سببًا لجلبهم كشهود وإصدار جمل بناءً على شهاداتهم. بالمناسبة ، الكلاب أكثر ذكاءً من أي نظام تعليمي آلي.

التعلم الآلي اليوم هو واحد من أهم اتجاهات التكنولوجيا الأساسية. هذه هي إحدى الطرق الرئيسية التي ستغير بها التكنولوجيا العالم من حولنا في العقد القادم. بعض جوانب هذه التغييرات مقلقة. على سبيل المثال ، التأثير المحتمل للتعلم الآلي على سوق العمل ، أو استخدامه لأغراض غير أخلاقية (على سبيل المثال ، الأنظمة الاستبدادية). هناك مشكلة أخرى يكرسها هذا المنشور لـ: تحيز الذكاء الاصطناعي .

هذه قصة صعبة.

يمكن أن تجد Google AI القطط. وكان هذا الخبر من عام 2012 ثم شيء خاص.

ما هو التحيز الذكاء الاصطناعى؟

"البيانات الأولية" هي على حد سواء oxymoron وفكرة سيئة. يجب أن يتم إعداد البيانات بشكل جيد وبعناية. - جيفري بوكر

في مكان ما قبل عام 2013 ، من أجل إنشاء نظام ، على سبيل المثال ، يتعرف على القطط في الصور الفوتوغرافية ، كان عليك وصف الخطوات المنطقية. كيفية العثور على زوايا في صورة ما ، والتعرف على العيون ، وتحليل القوام لوجود الفراء ، وعدد الكفوف ، وما إلى ذلك. ثم جمع كل المكونات - وتجد أن كل هذا لا يعمل حقا. يشبه الحصان الميكانيكي - من الناحية النظرية ، يمكن القيام به ، لكن في الممارسة العملية يكون من الصعب للغاية وصفه. عند الخروج ، هناك المئات (أو حتى الآلاف) من القواعد المكتوبة بخط اليد. وليس نموذج عمل واحد.

مع ظهور التعلم الآلي ، توقفنا عن استخدام القواعد "اليدوية" للتعرف على الشيء. بدلاً من ذلك ، نأخذ ألف عينة من "واحد" ، X ، ألف عينة من "آخر" ، Y ، ونجبر الكمبيوتر على بناء نموذج بناءً على تحليلهم الإحصائي. ثم نعطي هذا النموذج بعض نماذج البيانات ، ويحدد بدقة ما إذا كان يناسب إحدى المجموعات. ينشئ التعلم الآلي نموذجًا يعتمد على البيانات ، وليس بمساعدة الشخص الذي يكتبه. النتائج مثيرة للإعجاب ، خاصة في مجال التعرف على الصور والأنماط ، وهذا هو السبب في انتقال صناعة التكنولوجيا بأكملها الآن إلى التعلم الآلي (ML).

لكن ليس بهذه البساطة. في العالم الواقعي ، تحتوي الآلاف من الأمثلة على X أو Y أيضًا على A و B و J و L و O و R وحتى L. ويمكن توزيعها بشكل غير متساو ، ويمكن العثور على بعضها في كثير من الأحيان حتى أن النظام سوف يولي لهم المزيد من الاهتمام أكثر من إلى الأشياء التي تهمك.

ماذا يعني هذا في الممارسة العملية؟ المثال المفضل لدي هو عندما تنظر أنظمة التعرف على الصور إلى تلة عشبية وتقول "خروف" . من المفهوم لماذا: تم التقاط معظم الأمثلة على "الأغنام" في المروج التي يعيشون فيها ، وفي هذه الصور تشغل العشب مساحة أكبر بكثير من الزغابات البيضاء الصغيرة ، ويعتبر عشب النظام الأكثر أهمية.

هناك أمثلة أكثر جدية. من الأخيرة - مشروع واحد للكشف عن سرطان الجلد في الصور. اتضح أن أطباء الأمراض الجلدية غالباً ما يصورون التشكيلة مع مظاهر سرطان الجلد من أجل إصلاح حجم التكوينات. في أمثلة لصور الجلد الصحي ، لا يوجد حكام. بالنسبة لنظام الذكاء الاصطناعي ، أصبحت هذه المساطر (بتعبير أدق ، البيكسلات التي نعرّفها كـ "مسطرة") واحدة من الاختلافات بين مجموعات الأمثلة ، وأحيانًا أكثر أهمية من طفح جلدي صغير. لذلك نظام مصمم لتحديد سرطان الجلد ، وأحيانا بدلا من التعرف عليه.

النقطة الأساسية هنا هي أن النظام ليس لديه فهم دلالي لما ينظر إليه. ننظر إلى مجموعة من البكسلات ونرى خروفًا أو جلدًا أو حكامًا فيها - والنظام - فقط سطر رقم. لا ترى مساحة ثلاثية الأبعاد ، فهي لا ترى أشياء ولا مواد ولا أغنام. ترى فقط أنماط في البيانات.

تتمثل الصعوبة في تشخيص مثل هذه المشكلات في أن الشبكة العصبية (النموذج الذي تم إنشاؤه بواسطة نظام التعلم الآلي الخاص بك) تتألف من آلاف مئات الآلاف من العقد. لا توجد طريقة سهلة للنظر إلى نموذج ورؤية كيف يتخذ القرار. إن وجود مثل هذه الطريقة يعني أن العملية بسيطة بما يكفي لوصف جميع القواعد يدويًا ، دون استخدام التعلم الآلي. يشعر الناس بالقلق من أن التعلم الآلي أصبح نوعًا من الصندوق الأسود. (سأشرح لاحقًا سبب استمرار هذه المقارنة كثيرًا.)

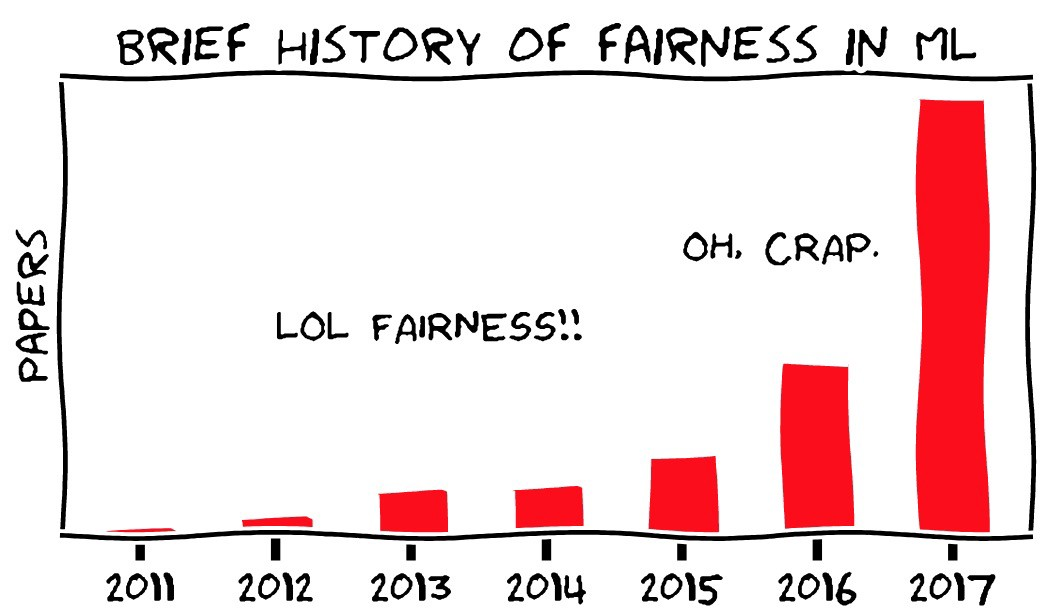

بشكل عام ، هذه هي مشكلة التحيز في الذكاء الاصطناعي أو التعلم الآلي: يمكن لنظام العثور على أنماط في البيانات العثور على أنماط غير صحيحة ، ولكن قد لا تلاحظ ذلك. هذه سمة أساسية للتكنولوجيا ، وهي واضحة لكل من يعمل معها في المجتمع العلمي وفي شركات التكنولوجيا الكبيرة. لكن عواقبه معقدة ، وكذلك حلولنا الممكنة لهذه العواقب.

لنتحدث عن العواقب أولاً.

يمكن لمنظمة العفو الدولية أن تختار ضمنيًا بالنسبة لنا لصالح فئات معينة من الأشخاص ، استنادًا إلى عدد كبير من الإشارات غير الواضحة

سيناريوهات التحيز الذكاء الاصطناعى

الشيء الأكثر وضوحا والخوف هو أن هذه المشكلة يمكن أن تظهر نفسها عندما يتعلق الأمر بالتنوع البشري. في الآونة الأخيرة ، مرت شائعة تفيد بأن شركة Amazon حاولت بناء نظام تعليمي آلي للفحص الأولي للمرشحين للوظائف. نظرًا لوجود عدد أكبر من الرجال بين عمال أمازون ، فإن أمثلة "التوظيف الناجح" هي أيضًا أكثر من الذكور ، وكان هناك عدد أكبر من الرجال في اختيار السير الذاتية المقترحة من قبل النظام. لاحظت أمازون هذا ولم تطلق النظام في الإنتاج.

الشيء الأكثر أهمية في هذا المثال هو أن النظام يشاع أنه يفضل المرشحين الذكور ، على الرغم من حقيقة أن الجنس لم يكن مدرجًا في السيرة الذاتية. رأى النظام أنماطًا أخرى في أمثلة "التوظيف الناجح": على سبيل المثال ، يمكن للمرأة استخدام كلمات خاصة لوصف الإنجازات ، أو الحصول على هوايات خاصة. بالطبع ، لم يكن النظام يعرف ما هو "الهوكي" ، ولا من "الناس" ، ولا "النجاح" - فقد أجرى تحليلًا إحصائيًا للنص. لكن الأنماط التي رأتها كانت على الأرجح ستظل دون أن يلاحظها أحد ، وبعضها (على سبيل المثال ، حقيقة أن الأشخاص من جنسين مختلفين يصفون النجاح بشكل مختلف) ، قد يكون من الصعب علينا رؤيته ، وحتى النظر إليهم.

كذلك أسوأ. نظام التعلم الآلي الذي يجد السرطان جيدًا على البشرة الفاتحة يمكن أن يعمل بشكل أسوأ مع البشرة الداكنة ، أو العكس. ليس بالضرورة بسبب التحيز ، ولكن لأنك ربما تحتاج إلى إنشاء نموذج منفصل بلون بشرة مختلف ، واختيار الخصائص الأخرى. أنظمة التعلم الآلي غير قابلة للتبادل حتى في مجال ضيق مثل التعرف على الصور. تحتاج إلى إعداد النظام ، في بعض الأحيان ببساطة من خلال التجربة والخطأ ، لإشعار الميزات الموجودة في البيانات التي تهتم بها جيدًا ، حتى تصل إلى الدقة المطلوبة. لكن قد لا تلاحظ أن النظام في 98٪ من الحالات يكون دقيقًا عند العمل مع مجموعة واحدة وفقط في 91٪ (وإن كان هذا أكثر دقة من التحليل الذي أجراه شخص ما) في المجموعة الأخرى.

حتى الآن استخدمت بشكل رئيسي الأمثلة المتعلقة بالناس وخصائصهم. تركز المناقشة حول هذه المشكلة بشكل أساسي على هذا الموضوع. ولكن من المهم أن نفهم أن التحيز تجاه الناس ليس سوى جزء من المشكلة. سوف نستخدم التعلم الآلي لأشياء كثيرة ، وسيكون خطأ أخذ العينات مناسبًا لجميع هذه الأشياء. من ناحية أخرى ، إذا كنت تعمل مع أشخاص ، فقد لا يرتبط تحيز البيانات بهم.

لفهم هذا ، دعونا نعود إلى المثال مع سرطان الجلد وننظر في ثلاثة احتمالات افتراضية من انهيار النظام.

- التوزيع غير المتجانس للناس: عدد غير متوازن من الصور الفوتوغرافية للجلد بألوان مختلفة ، مما يؤدي إلى نتائج سلبية إيجابية أو خاطئة كاذبة مرتبطة بالتصبغ.

- تحتوي البيانات التي تم تدريب النظام عليها على خاصية متكررة المصادفة وغير متجانسة لا ترتبط بالأشخاص وليس لها أي قيمة تشخيصية: مسطرة على صور لمظاهر سرطان الجلد أو عشب على صور للأغنام. في هذه الحالة ، ستكون النتيجة مختلفة إذا عثر النظام على وحدات بكسل في صورة شيء تعرفه العين البشرية بأنه "حاكم".

- تحتوي البيانات على خاصية خاصة بجهة خارجية لا يستطيع الشخص رؤيتها ، حتى لو كان يبحث عنها.

ماذا يعني هذا؟ نعلم مسبقًا أنه يمكن تقديم البيانات بشكل مختلف بواسطة مجموعات مختلفة من الأشخاص ، ويمكننا على الأقل التخطيط للبحث عن مثل هذه الاستثناءات. بمعنى آخر ، هناك مجموعة من الأسباب الاجتماعية لنفترض أن البيانات الخاصة بمجموعات الأشخاص تحتوي بالفعل على بعض التحيزات. إذا نظرنا إلى الصورة مع المسطرة ، فسوف نرى هذا المسطرة - لقد تجاهلناه فقط من قبل ، مع العلم أنه لا يهم ، وننسى أن النظام لا يعرف شيئًا.

ولكن ماذا لو تم التقاط جميع صورك للجلد غير الصحي في مكتب حيث تستخدم المصابيح المتوهجة ، وصحية في ضوء الفلورسنت؟ ماذا لو ، بعد الانتهاء من إزالة بشرة صحية ، قبل إطلاق النار بطريقة غير صحية ، قمت بتحديث نظام التشغيل على الهاتف ، وتغيير Apple أو Google خوارزمية الحد من الضوضاء قليلاً؟ لا يمكن لأي شخص أن يلاحظ ذلك ، بغض النظر عن مدى سعيه للحصول على هذه الميزات. ولكن بعد ذلك سيرى نظام استخدام الآلة ذلك ويستخدمه على الفور. إنها لا تعرف أي شيء.

بينما تحدثنا عن الارتباطات الخاطئة ، يمكن أن يحدث أن تكون البيانات دقيقة وأن النتائج صحيحة ، لكنك لا ترغب في استخدامها لأسباب أخلاقية أو قانونية أو إدارية. في بعض الولايات القضائية ، على سبيل المثال ، لا يمكن تزويد المرأة بخصم على التأمين ، على الرغم من أن المرأة قد تكون أكثر أمانًا في القيادة. يمكننا بسهولة تخيل نظام يقوم ، عند تحليل البيانات التاريخية ، بتعيين عوامل مخاطرة أقل للأسماء النسائية. حسنًا ، دعنا نزيل الأسماء من التحديد. لكن تذكر المثال مع Amazon: يمكن للنظام تحديد نوع الجنس حسب عوامل أخرى (على الرغم من أنه لا يعرف نوع الجنس وما هو الجهاز) ، ولن تلاحظ ذلك حتى يقوم المنظم بتحليل المعدلات التي تقدمها بأثر رجعي أنت بخير.

أخيرًا ، يتم ضمنيًا أننا سنستخدم هذه الأنظمة فقط للمشاريع المتعلقة بالأشخاص والتفاعلات الاجتماعية. هذا ليس كذلك. إذا قمت بتصنيع توربينات غازية ، فربما تحتاج إلى تطبيق تعلم الآلة على القياس عن بعد المرسلة من قبل عشرات أو مئات من أجهزة الاستشعار على المنتج الخاص بك (الصوت والفيديو ودرجة الحرارة وأي أجهزة استشعار أخرى تولد بيانات يمكن تكييفها بسهولة شديدة لإنشاء نموذج لتعلم الآلة ). من الناحية النظرية ، يمكنك القول: "فيما يلي البيانات الخاصة بألف توربينات فاشلة تم الحصول عليها قبل فشلها ، ولكن فيما يلي بيانات من ألف توربينات لم تنكسر. بناء نموذج ليقول ما هو الفرق بينهما ". حسنًا ، تخيل الآن أن أجهزة استشعار Siemens تكلف 75٪ من التوربينات السيئة ، و 12٪ فقط من التوربينات الجيدة (لا يوجد اتصال بالفشل). سيقوم النظام ببناء نموذج لتحديد موقع التوربينات مع أجهزة استشعار سيمنز. عفوا!

اللوحة - Moritz، Hardt، UC، Berkeley

منظمة العفو الدولية إدارة التحيز

ماذا يمكننا أن نفعل حيال ذلك؟ يمكنك التعامل مع المشكلة من ثلاثة جوانب:

- الصرامة المنهجية في جمع وإدارة البيانات لتدريب النظام.

- الأدوات التقنية لتحليل وتشخيص سلوك النموذج.

- التدريب والتعليم والحذر في إدخال التعلم الآلي في المنتجات.

هناك نكتة في كتاب موليير "التاجر في النبلاء": قيل لرجل إن الأدب ينقسم إلى نثر وشعر ، وهو يعجب بإعجاب أنه تحدث النثر طوال حياته دون معرفة ذلك. ربما يشعر الإحصائيون بهذا الشكل اليوم: دون أن يلاحظوا ذلك ، كرسوا حياتهم المهنية للذكاء الاصطناعي وخطأ أخذ العينات. للبحث عن خطأ في أخذ العينات والقلق بشأنه ليس مشكلة جديدة ، نحتاج فقط إلى نهج حل منهجي. كما ذكر أعلاه ، في بعض الحالات يكون من السهل فعل ذلك من خلال دراسة المشكلات المرتبطة ببيانات الأشخاص. نحن نفترض سلفًا أننا قد يكون لدينا تصورات مسبقة حول مجموعات مختلفة من الناس ، ولكن من الصعب علينا أن نتخيل تحيزًا حول أجهزة استشعار Siemens.

الجديد في كل هذا ، بالطبع ، هو أن الناس لم يعودوا يشاركون مباشرة في التحليل الإحصائي. يتم تنفيذها بواسطة الآلات التي تنشئ نماذج معقدة كبيرة يصعب فهمها. مسألة الشفافية هي واحدة من الجوانب الرئيسية لمشكلة التحيز. نحن خائفون من أن النظام ليس متحيزًا فحسب ، ولكن لا توجد وسيلة لاكتشاف تحيزه ، وأن التعلم الآلي يختلف عن الأشكال الأخرى من الأتمتة ، والتي من المفترض أن تتكون من خطوات منطقية واضحة يمكن التحقق منها.

هناك مشكلتان هنا. ومع ذلك ، يمكننا ، مع ذلك ، إجراء تدقيق لأنظمة التعلم الآلي. ومراجعة أي نظام آخر ليست في الواقع أسهل على الإطلاق.

أولاً ، أحد مجالات البحث الحديثة في مجال التعلم الآلي هو البحث عن طرق حول كيفية تحديد الوظيفة المهمة لأنظمة التعلم الآلي. في الوقت نفسه ، يعد التعلم الآلي (في حالته الحالية) مجالًا جديدًا تمامًا من العلوم يتغير بسرعة ، لذا يجب ألا تعتقد أن الأمور المستحيلة اليوم لا يمكن أن تصبح حقيقةً في القريب العاجل. مشروع OpenAI هو مثال مثير للاهتمام من هذا.

ثانياً ، فكرة أنه من الممكن التحقق من فهم عملية صنع القرار وفهمها في الأنظمة أو المنظمات الموجودة فكرة جيدة من الناحية النظرية ، ولكنها كذلك في الممارسة العملية. فهم كيف يتم اتخاذ القرارات في مؤسسة كبيرة ليس بالأمر السهل. حتى لو كانت هناك عملية رسمية لصنع القرار هناك ، فهي لا تعكس كيفية تفاعل الناس فعليًا ، وفي الحقيقة لا يكون لديهم في الغالب نهج منهجي منطقي لاتخاذ قراراتهم. كما قال زميلي فيجاي باندي ، الناس أيضًا صناديق سوداء .

خذ ألف شخص في العديد من الشركات والمؤسسات المتداخلة ، وستصبح المشكلة أكثر تعقيدًا. نعلم بعد حقيقة أن مكوك الفضاء كان مصيرًا أن ينهار عندما عادوا ، وكان لدى بعض الأشخاص داخل وكالة ناسا معلومات أعطتهم سببًا للاعتقاد بأن شيئًا سيئًا قد يحدث ، لكن النظام ككل لم يعرف. لقد مرت ناسا للتو على مراجعة مماثلة ، بعد أن فقدت المكوك السابق ، لكنها خسرت واحدة أخرى - لسبب مشابه للغاية. من السهل القول إن المنظمات والأفراد يتبعون قواعد منطقية واضحة يمكن التحقق منها وفهمها وتغييرها - لكن التجربة تثبت عكس ذلك. هذا هو " خطأ لجنة تخطيط الدولة ".

كثيراً ما أقارن التعلم الآلي بقواعد البيانات ، وخاصة العلاقة - تقنية أساسية جديدة غيرت إمكانيات علوم الكمبيوتر والعالم من حولها ، والتي أصبحت جزءًا من كل شيء نستخدمه باستمرار دون إدراكه. تحتوي قواعد البيانات أيضًا على مشكلات ، ولديها خاصية مشابهة: يمكن بناء النظام على افتراضات غير صحيحة أو على بيانات سيئة ، ولكن سيكون من الصعب إشعاره ، وسيقوم الأشخاص الذين يستخدمون النظام بما يخبرهم به دون طرح أسئلة. هناك مجموعة من النكات القديمة حول موظفي الضرائب الذين قاموا بإدخال اسمك بشكل غير صحيح ، وإقناعهم بتصحيح الخطأ أصعب بكثير من تغيير الاسم فعليًا. يمكن التفكير في ذلك بطرق مختلفة ، ولكن ليس من الواضح ما هي أفضل السبل: ماذا عن مشكلة فنية في SQL ، أو عن خطأ في إصدار Oracle ، أو عن فشل المؤسسات البيروقراطية؟ ما مدى صعوبة العثور على خطأ في العملية التي أدت إلى حقيقة أن النظام ليس لديه ميزة مثل تصحيح الأخطاء المطبعية؟ هل يمكن فهم ذلك قبل أن يبدأ الناس في الشكوى؟

والأسهل هو توضيح هذه المشكلة عن طريق القصص عندما يذهب السائقون ، بسبب البيانات القديمة في المستكشف ، إلى الأنهار. حسنًا ، يجب تحديث الخرائط باستمرار. لكن ما مقدار مسؤولية TomTom عن حقيقة أن سيارتك تهب في البحر؟

أقول هذا لحقيقة أن نعم - إنحياز التعلم الآلي سيخلق مشاكل. لكن هذه المشاكل ستكون مماثلة لتلك التي واجهناها في الماضي ، ويمكن ملاحظتها وحلها (أو لا) تقريبًا كما فعلنا في الماضي. وبالتالي ، من غير المحتمل أن يحدث سيناريو يكون فيه تحيز الذكاء الاصطناعي ضارًا لكبار الباحثين الذين يعملون في مؤسسة كبيرة. , - - , , . “ ” , , , , . . , . .

استنتاج

, , — , .

, « » . , — . HAL9000 Skynet — -, . لكن لا. , , , . , , … . . , , , - . , — , , .

, — , — . , , .

, , « — , » . , « ». , , , . , . , — , , , . , , .

: .

: .

: @PonchikNews .