اليوم ، أعلنت Google عن

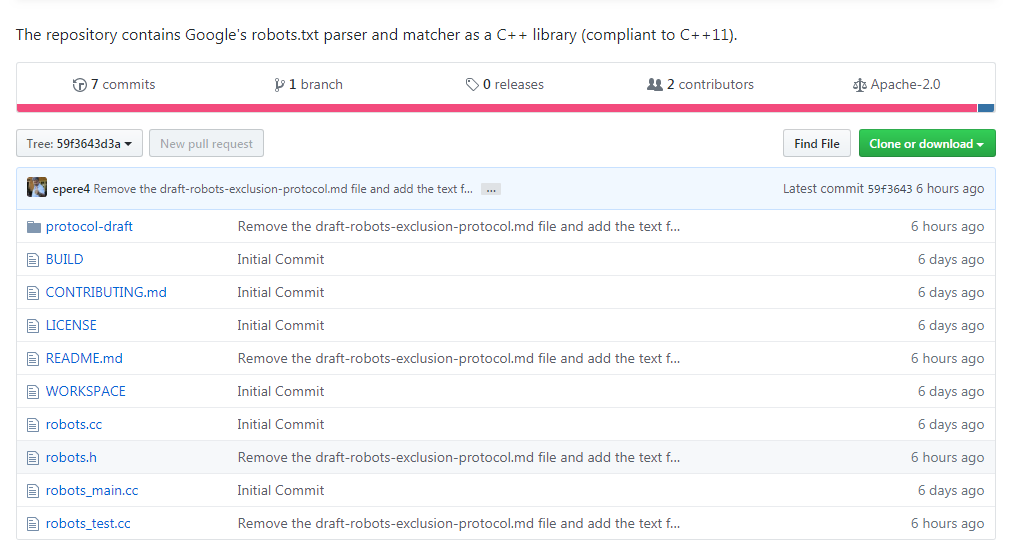

مشروع RFC لمعيار بروتوكول استبعاد الروبوت (REP) ، مما يجعل محلل ملفات robots.txt الخاص به متاحًا بموجب رخصة أباتشي 2.0. حتى اليوم ، لم يكن هناك معيار رسمي لبروتوكول استبعاد الروبوت (REP) و robots.txt (كان هذا هو الأقرب إليه) ، مما سمح للمطورين والمستخدمين بتفسيره بطريقتهم الخاصة. تهدف مبادرة الشركة إلى تقليل الاختلافات بين التطبيقات.

يمكن الاطلاع

على مسودة المعيار الجديد

على موقع IETF على الويب ، والمستودع متاح على Github على

https://github.com/google/robotstxt .

المحلل اللغوي هو الكود المصدري الذي تستخدمه Google كجزء من أنظمة الإنتاج الخاصة بها (باستثناء التعديلات الطفيفة - مثل ملفات رؤوس التنظيف التي يتم استخدامها داخل الشركة فقط) - يتم تحليل ملفات robots.txt تمامًا مثلما يفعل Googlebot (بما في ذلك Googlebot) كيف يعامل أحرف يونيكود في الأنماط). المحلل اللغوي مكتوب بلغة C ++ ويتكون بشكل أساسي من ملفين - أنت بحاجة إلى برنامج التحويل البرمجي المتوافق مع C ++ 11 ، على الرغم من أن رمز المكتبة يعود إلى التسعينيات ، وستجد مؤشرات أولية و

strbrk فيه . من أجل تجميعها ، يوصى باستخدام

Bazel (يتم دعم دعم CMake في المستقبل القريب).

تنتمي فكرة ملف robots.txt والمعيار إلى Martain Coster ، الذي أنشأها في عام 1994 -

وفقًا للأسطورة ، كان السبب هو البحث عنكبوت تشارلز شتراوس ، الذي "أسقط" خادم Bonfire باستخدام هجوم DoS. تم اختيار فكرته من قبل الآخرين وأصبح بسرعة المعيار الفعلي لأولئك المشاركين في تطوير محركات البحث. أولئك الذين أرادوا القيام بتحليلها كان عليهم أحيانًا عكس مهندس Googlebot ، بما في ذلك Blekko ، الذي كتب

المحلل اللغوي الخاص به لـ Perl لمحرك البحث الخاص به.

كان المحلل اللغوي لا يخلو من اللحظات الممتعة: ألقِ نظرة ، على سبيل المثال ، على

مقدار العمل الذي تمت معالجته .