أحد الأحداث الرئيسية في مجال اللغويات الحاسوبية والتعلم الآلي في عام 2018 كان

إصدار BERT من Google AI ، والذي تم الاعتراف به كأفضل تقرير في السنة وفقًا لفرع أمريكا الشمالية لجمعية اللغويات الحاسوبية (NACL). في هذه المقالة سوف نتحدث عن هذا النموذج اللغوي وقدراته.

بالنسبة لأولئك الذين لم يسمعوا من قبل ، فإن BERT عبارة عن شبكة عصبية تعتمد على طريقة الإعداد الأولي للبيانات السياقية للكلمات ، أي أنها تستخدم نموذج لغة ثنائي الاتجاه ، كما تتيح لك تحليل جمل كاملة. في هذه الحالة ، يتم أخذ الكلمات التي تأتي بعد ما يتم من خلاله وأيضًا في الاعتبار. تتيح هذه الطريقة الحصول على نتائج بهامش واسع من أحدث التقنيات في مجموعة واسعة من مهام معالجة اللغة الطبيعية (NLP) ، ولكنها تتطلب طاقة حوسبية كبيرة.

من خطاب رسمي للمحادثة

تم تدريس بيرت في الأصل في 104 لغات ويكيبيديا (متعدد اللغات). بالإضافة إلى الإصدار متعدد اللغات ، أصدرت Google BERT بناءً على ويكيبيديا الإنجليزية و BERT باللغة الصينية.

في النظم العصبية ومختبر التعلم العميق ، استخدمنا بيرت لتحسين مكونات البرمجة اللغوية العصبية في ديب بافلوف ، وهي مكتبة تفاعلية مفتوحة المصدر لتطوير مساعد تفاعلي افتراضي وتحليل النص على أساس TensorFlow و Keras. قمنا بتدريب نموذج بيرت على ويكيبيديا الروسية - روبيرت ، مما أدى إلى تحسين كبير في جودة النماذج الروسية. وإلى جانب ذلك ، تم دمج BERT في حلول ثلاث مهام NLP شائعة: تصنيف النص ، ووضع علامات على التسلسل ، والإجابات على الأسئلة. يمكنك قراءة المزيد عن نماذج BERT من DeepPavlov في أحدث المنشورات من مدونتنا:

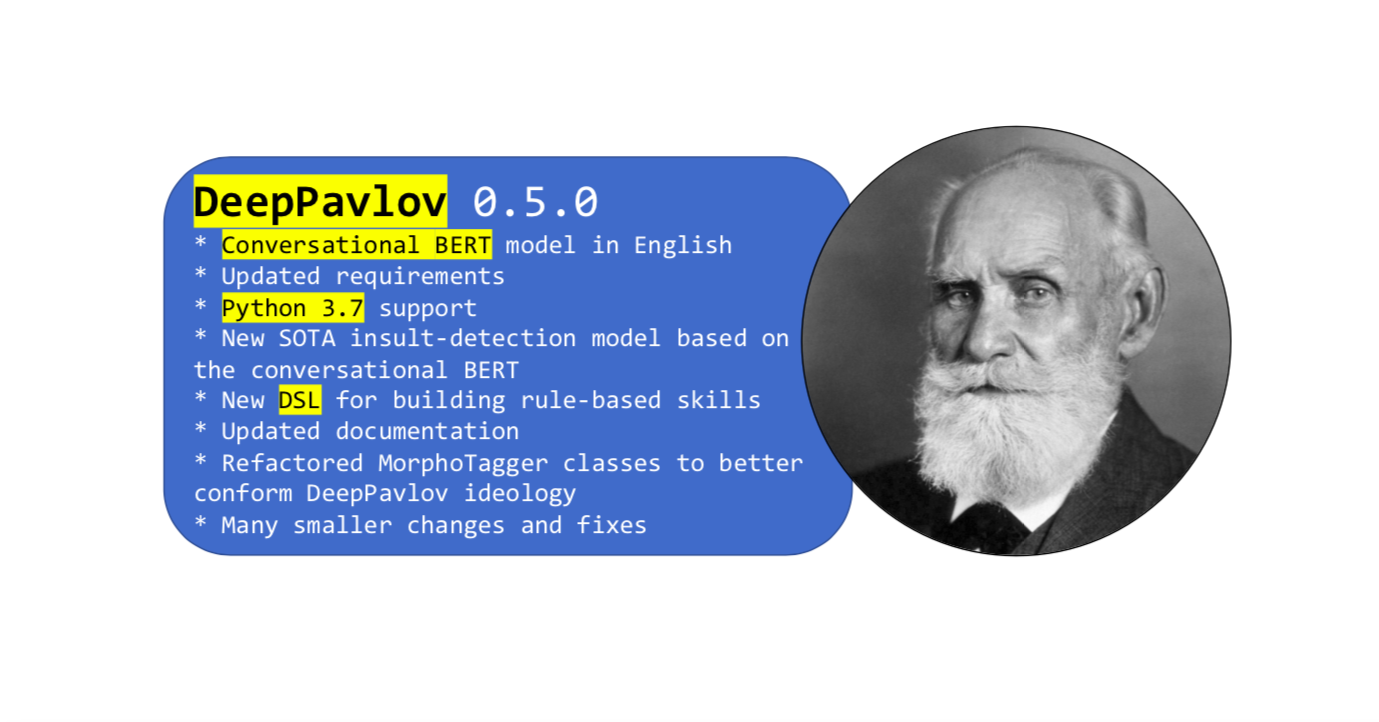

في الآونة الأخيرة ، إصدار جديد من المكتبة

كانت الميزة الرئيسية لهذا التحديث هي بيرت ، الذي تم تدريبه على مفردات الشبكات الاجتماعية باللغة الإنجليزية. تختلف لغة ويكيبيديا الرسمية عن اللغة العامية العادية ، بينما لحل بعض المشكلات ، تحتاج فقط إلى الحصول على واحدة منها.

تم تدريب

BERT للمحادثة باللغة الإنجليزية باستخدام البيانات المفتوحة من Twitter و Reddit و DailyDialogues و OpenSubtitles والمناقشات والمدونات والتعليقات على أخبار Facebook. تم استخدام هذه البيانات لإنشاء مفردات اللغة الإنجليزية الفرعية في النسخة الإنجليزية من BERT كتهيئة للغة الإنجليزية المنطوقة BERT. نتيجة لذلك ، أظهر BERT المنطوقة أحدث النتائج في المهام التي تضمنت بيانات اجتماعية.

كيفية استخدام بيرت المحادثة في DeepPavlov

يمكنك استخدام نموذج

الكشف عن الإهانة الجديد استنادًا إلى BERT المنطوقة باللغة الإنجليزية. أو أي نموذج آخر يستند إلى BERT باستخدام

دليل بسيط من الوثائق.

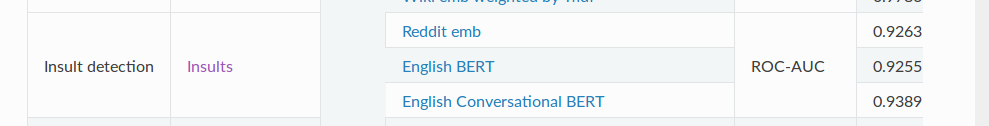

يحتوي نموذج

اكتشاف SOTA

Insult على مهمة تصنيف ثنائية للكشف عن إساءة الاستخدام. بالنسبة إلى قياس ROC-AUC (قياس الأداء لمهمة التصنيف في مختلف إعدادات العتبة) ، يُظهر هذا النموذج قيمة 93.89 على البيانات مقارنةً بـ BERT - 92.55 المعتاد.

وأخيرا

هذا كل ما نود إخبارك به عن بيرت للمحادثة. ولا تنس أن DeepPavlov لديه

منتدى - اطرح أسئلتك بخصوص المكتبة والموديلات. كن في العمل!