مرحبا بالجميع. قبل بدء دورة التعلم الآلي ، لا يزال هناك أكثر من أسبوع بقليل. تحسبا لبداية الفصول الدراسية ، قمنا بإعداد ترجمة مفيدة من شأنها أن تهم طلابنا وجميع قراء المدونات. لنبدأ.

حان الوقت للتخلص من الصناديق السوداء وبناء الثقة في التعلم الآلي!في كتابه

"Interpretable Machine Learning" ، يبرز Christoph Molnar تمامًا تفسير Learning Machine باستخدام المثال التالي: تخيل أنك خبير في علوم البيانات وفي وقت فراغك تحاول التنبؤ بالمكان الذي سيذهب إليه أصدقاؤك في إجازة صيفية استنادًا إلى بياناتهم من facebook و تويتر. لذا ، إذا كانت التوقعات صحيحة ، فسوف يعتبرك أصدقاؤك ساحرًا يمكنه رؤية المستقبل. إذا كانت التوقعات خاطئة ، فلن تلحق الضرر بأي شيء آخر غير سمعتك كمحلل. الآن تخيل أنه لم يكن مجرد مشروع ممتع ، ولكن تم جذب الاستثمارات إليه. دعنا نقول أنك تريد الاستثمار في العقارات حيث من المرجح أن يسترخي أصدقائك. ماذا يحدث إذا فشلت تنبؤات النماذج؟ سوف تخسر المال. طالما أن النموذج ليس له تأثير كبير ، فإن أهميته في التفسير لا تهم كثيرًا ، ولكن عندما تكون هناك عواقب مالية أو اجتماعية مرتبطة بتنبؤات النموذج ، فإن تفسيره له معنى مختلف تمامًا.

شرح تعلم الآلة

التفسير هو شرح أو إظهار بعبارات مفهومة. في سياق نظام ML ، فإن التفسير هو القدرة على شرح عمله أو إظهاره في

شكل قابل للقراءة من قبل الإنسان .

كثير من الناس يطلق عليهم اسم نماذج التعلم الآلي "الصناديق السوداء". هذا يعني أنه على الرغم من حقيقة أنه يمكننا الحصول على تنبؤات دقيقة منهم ، لا يمكننا شرح أو فهم منطق تجميعها بشكل واضح. ولكن كيف يمكنك استخراج رؤى من النموذج؟ ما الأشياء التي يجب وضعها في الاعتبار وما هي الأدوات التي نحتاجها للقيام بذلك؟ هذه أسئلة مهمة تتبادر إلى الذهن عندما يتعلق الأمر بنموذج التفسير.

أهمية التفسير

والسؤال الذي يطرحه بعض الناس هو ،

لماذا لا نكون سعداء فقط بأننا نحصل على نتيجة ملموسة لعمل النموذج ، لماذا من المهم للغاية معرفة كيف تم اتخاذ هذا القرار أو ذاك؟ تكمن الإجابة في حقيقة أن النموذج يمكن أن يكون له تأثير معين على الأحداث اللاحقة في العالم الحقيقي. بالنسبة للنماذج المصممة للتوصية بالأفلام ، ستكون التفسير أقل أهمية من النماذج المستخدمة للتنبؤ بتأثير الدواء.

"المشكلة هي أن مجرد مقياس واحد ، مثل دقة التصنيف ، هو وصف غير مناسب لمعظم المهام الواقعية." (

دوشي فيليس وكيم 2017 )

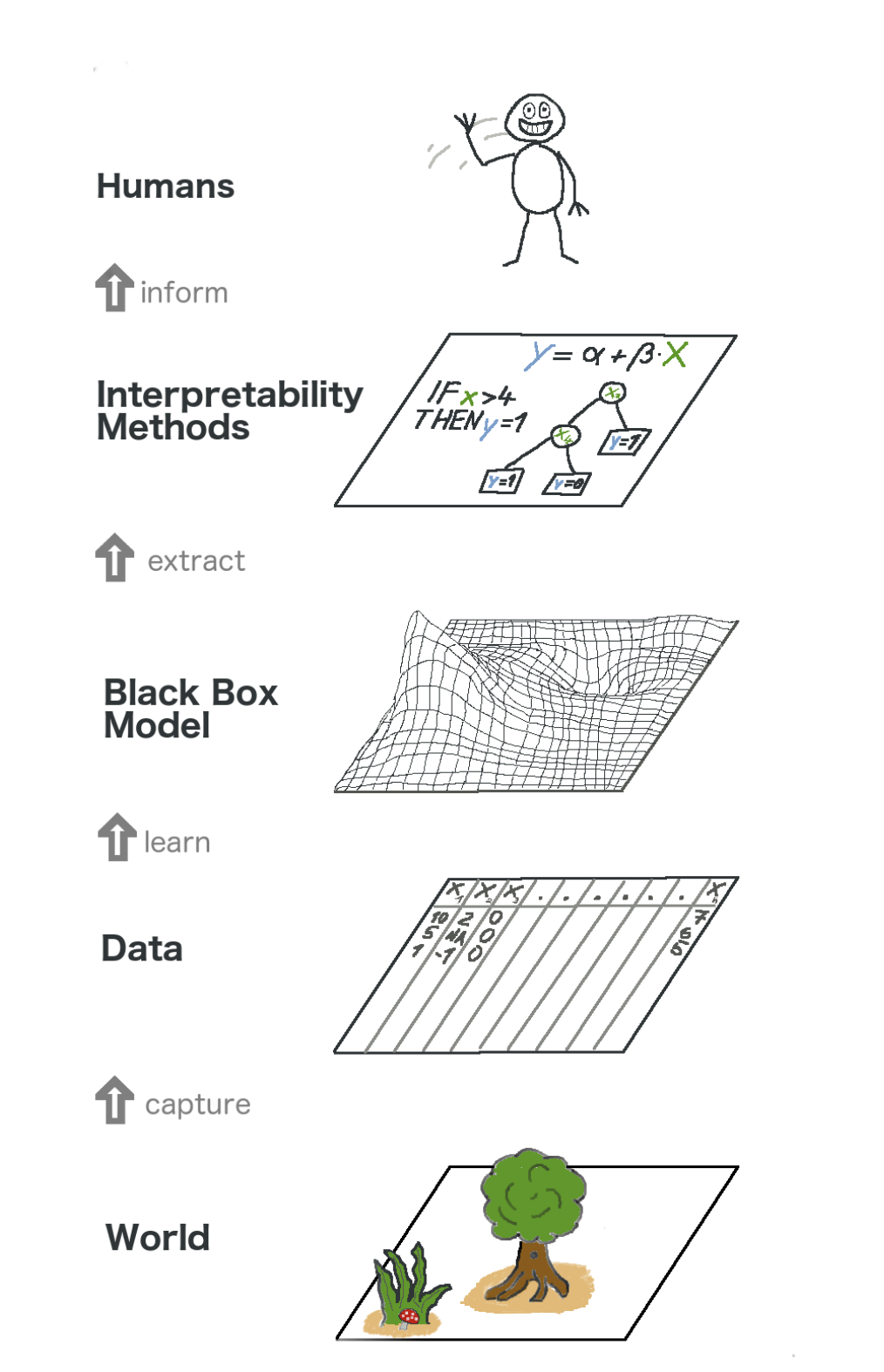

إليكم صورة كبيرة حول التعلم الآلي القابل للشرح. بمعنى ما ، نلتقط العالم (أو بالأحرى ، معلومات منه) ، ونجمع البيانات الأولية ونستخدمها لمزيد من التوقعات. في جوهرها ، فإن التفسير هو مجرد طبقة أخرى من النموذج تساعد الناس على فهم العملية برمتها.

النص الموجود في الصورة من الأسفل إلى الأعلى: العالم -> الحصول على المعلومات -> البيانات -> التدريب -> Black Box model -> Extract -> أساليب الترجمة الفورية -> الأشخاص

النص الموجود في الصورة من الأسفل إلى الأعلى: العالم -> الحصول على المعلومات -> البيانات -> التدريب -> Black Box model -> Extract -> أساليب الترجمة الفورية -> الأشخاصبعض

الفوائد التي يجلبها التفسير هي:

- الموثوقية.

- راحة تصحيح الأخطاء ؛

- معلومات عن الميزات الهندسية ؛

- إدارة جمع البيانات للخصائص

- معلومات عن صنع القرار ؛

- بناء الثقة.

أساليب التفسير النموذجي

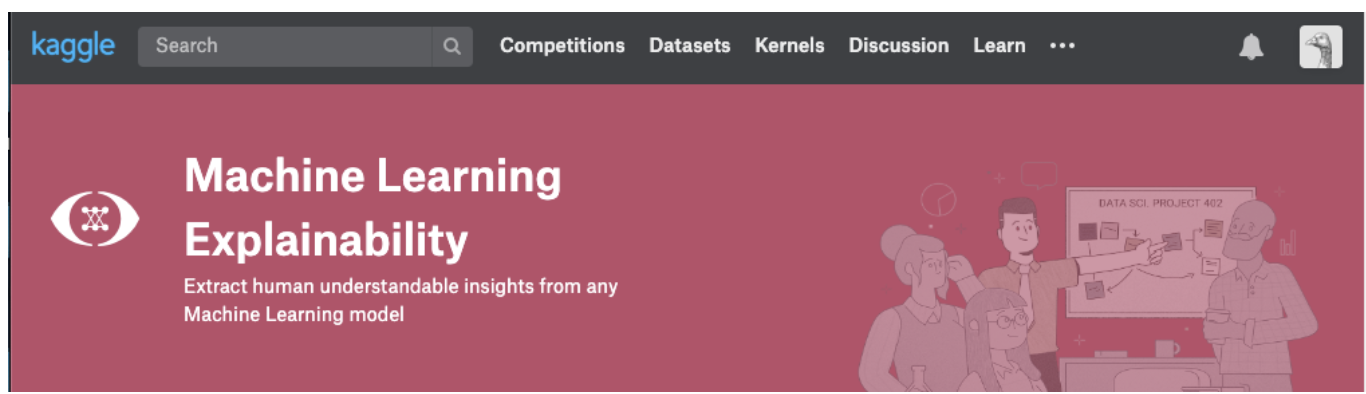

النظرية منطقية فقط طالما أننا نستطيع وضعها موضع التنفيذ. في حال كنت ترغب حقًا في التعامل مع هذا الموضوع ، يمكنك محاولة أخذ دورة تعلم التفسير الآلي من Kaggle. ستجد فيه العلاقة الصحيحة بين النظرية والكود من أجل فهم المفاهيم وتكون قادرًا على تطبيق مفاهيم التفسير (التفسير) للنماذج على الحالات الحقيقية.

انقر على الصورة أدناه للانتقال مباشرة إلى صفحة الدورة. إذا كنت ترغب في الحصول على نظرة عامة على الموضوع أولاً ، فتابع القراءة.

رؤى يمكن استخلاصها من النماذج

لفهم النموذج ، نحتاج إلى الأفكار التالية:

- أهم الميزات في النموذج ؛

- لأي توقعات محددة للنموذج ، يكون تأثير كل سمة فردية على تنبؤ محدد.

- تأثير كل ميزة على عدد كبير من التوقعات المحتملة.

دعنا نناقش بعض الطرق التي تساعد في استخراج الرؤى أعلاه من النموذج:

أهمية التقليب

ما الميزات التي يعتبرها النموذج مهمة؟ ما الأعراض لها التأثير الأكبر؟ يُطلق على هذا المفهوم أهمية الميزة ، وأهمية التقليب هي طريقة تستخدم على نطاق واسع لحساب أهمية الميزات. يساعدنا ذلك في معرفة النقطة التي ينتج عنها النموذج نتائج غير متوقعة ، ويساعدنا في إظهار للآخرين أن نموذجنا يعمل تمامًا كما ينبغي.

تعمل ميزة التقليب في العديد من تقييمات scikit-learn. الفكرة بسيطة: إعادة ترتيب أو تعديل عمود واحد في مجموعة بيانات التحقق من الصحة ، وترك جميع الأعمدة الأخرى سليمة. تعتبر العلامة "مهمة" إذا انخفضت دقة النموذج وتسبب تغييره في زيادة الأخطاء. من ناحية أخرى ، تعتبر الميزة "غير مهمة" إذا كان خلط قيمها لا يؤثر على دقة النموذج.

كيف يعمل؟

فكر في نموذج يتنبأ بما إذا كان فريق كرة القدم سيحصل على جائزة "رجل اللعبة" أم لا ، بناءً على معايير معينة. تُمنح هذه الجائزة للاعب الذي يوضح أفضل مهارات اللعبة.

يتم احتساب أهمية التقليب بعد تدريب النموذج. لذلك ، دعونا ندرب

RandomForestClassifier نموذج

RandomForestClassifier ، المعين كـ

my_model ، على بيانات التدريب.

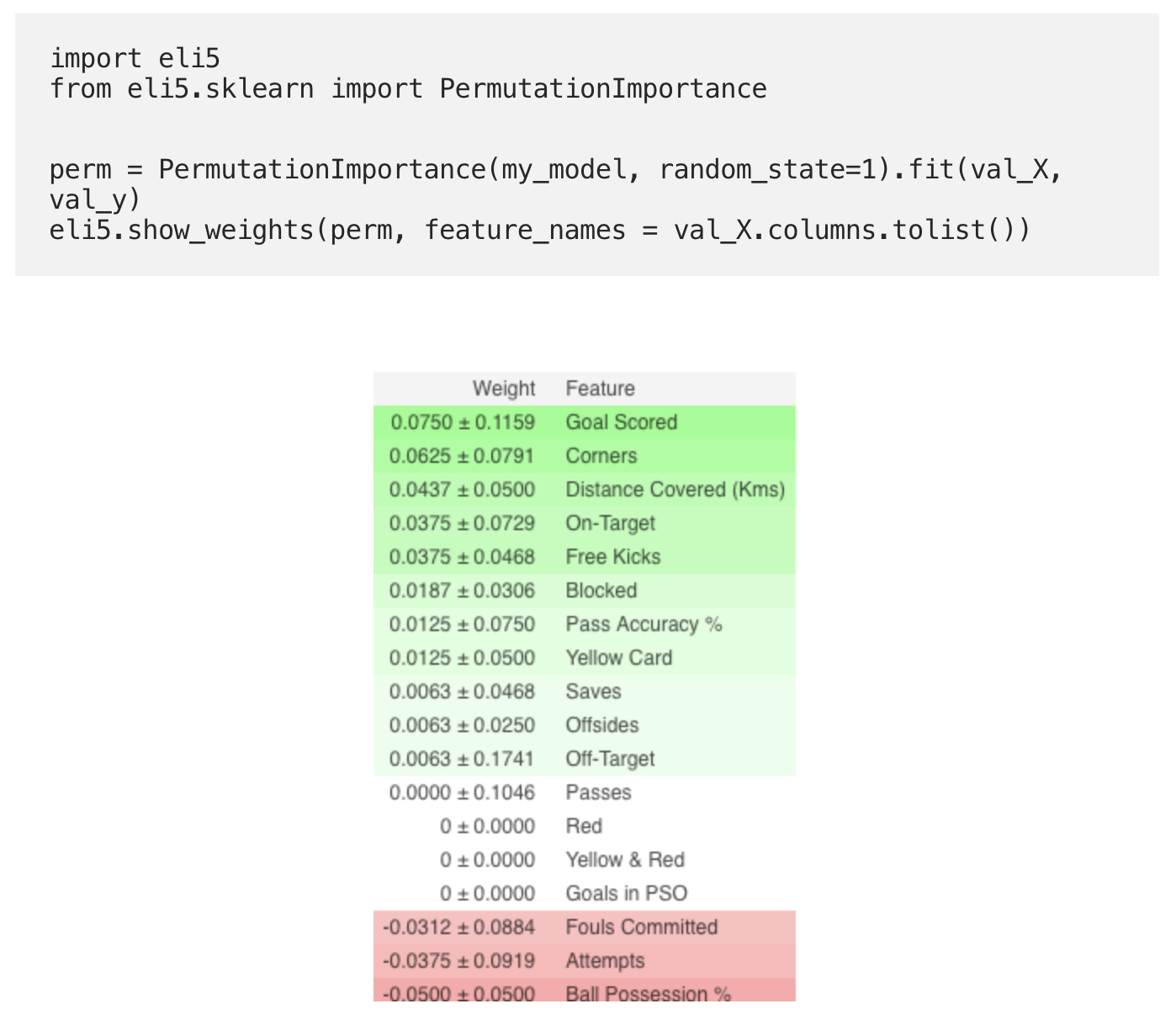

يتم احتساب أهمية التقليب باستخدام مكتبة

ELI5 . ELI5 هي مكتبة في Python تتيح لك تصور وتصحيح نماذج التعلم الآلي المختلفة باستخدام واجهة برمجة تطبيقات موحدة. يحتوي على دعم مدمج لعدة أطر عمل ML ويوفر طرقًا لتفسير نموذج الصندوق الأسود.

حساب وتصور الأهمية باستخدام مكتبة ELI5:

(هنا

val_X ، يشير

val_y إلى مجموعات التحقق من الصحة ، على التوالي)

ترجمة

- العلامات أعلاه هي الأكثر أهمية ، أدناه هي الأقل. في هذا المثال ، كانت أهم علامة هي تسجيل الأهداف.

- يعكس الرقم بعد how كيف تغيرت الإنتاجية من التقليب إلى الآخر.

- بعض الأوزان سالبة. هذا يرجع إلى حقيقة أنه في هذه الحالات ، تبين أن تنبؤات البيانات المختلطة كانت أكثر دقة من البيانات الحقيقية.

ممارسة

والآن ، لإلقاء نظرة على المثال الكامل والتحقق مما إذا كنت قد فهمت كل شيء بشكل صحيح ، انتقل إلى صفحة Kaggle باستخدام

الرابط .

لذلك انتهى الجزء الأول من الترجمة. اكتب تعليقاتك وتلتقي في الدورة!

اقرأ الجزء الثاني .