تعود معالجة اللغة الطبيعية إلى صوفية الكابالا

قبل وقت طويل من أن تصبح معالجة اللغة الطبيعية موضوعًا ساخنًا في مجال الذكاء الاصطناعي ، توصل الأشخاص إلى قواعد وآليات لمعالجة اللغة

الصوفي من القرن الثالث عشر اخترع إبراهيم بن صموئيل أبو العافية مجال معالجة اللغة الطبيعية من خلال البدء في ممارسة الجمع بين الحروف

الصوفي من القرن الثالث عشر اخترع إبراهيم بن صموئيل أبو العافية مجال معالجة اللغة الطبيعية من خلال البدء في ممارسة الجمع بين الحروفنحن الآن في ذروة الاهتمام بمعالجة اللغة الطبيعية (NLP) - مجال علوم الكمبيوتر الذي يركز على التفاعل اللغوي بين الإنسان والآلة. بفضل التقدم في التعلم الآلي (MO) في العقد الماضي ، نشهد تحسنا كبيرا في التعرف على الكلام والترجمة الآلية. إن منشئو اللغات جيدون بالفعل بما يكفي لكتابة مقالات إخبارية متماسكة ، وأصبح المساعدون الظاهريون مثل Siri و Alexa جزءًا من حياتنا اليومية.

يتتبع معظم المؤرخين أصول هذه المنطقة إلى بداية عصر الكمبيوتر عندما وصف آلان تورينج في عام 1950 آلة ذكية يمكن أن تتفاعل بسهولة مع شخص ما من خلال النص على الشاشة. لذلك ، عادة ما يتم تخيل اللغة الناتجة عن الآلات كظاهرة رقمية - وكذلك الهدف الرئيسي لتطوير الذكاء الاصطناعي (AI).

في هذه المقالة سنحاول دحض هذه الفكرة المقبولة عمومًا حول البرمجة اللغوية العصبية. في الواقع ، فإن محاولات تطوير قواعد وآلات رسمية قادرة على تحليل اللغة ومعالجتها وخلقها كانت أول مرة منذ عدة مئات من السنين.

لقد تغيرت تقنيات معينة بمرور الوقت ، لكن الفكرة الرئيسية في اعتبار اللغة مادة يمكن التلاعب بها بشكل مصطنع استنادًا إلى نظام من القواعد تم استكشافها من قبل العديد من الأشخاص في العديد من الثقافات ولأسباب مختلفة. تُظهر هذه التجارب التاريخية إمكانيات ومخاطر محاولة محاكاة اللغة البشرية دون تدخل بشري - كما توفر دروسًا للممارسين الحاليين لتقنيات البرمجة اللغوية العصبية المتقدمة.

هذه القصة تنبع من اسبانيا في العصور الوسطى. في نهاية القرن الثالث عشر ، جلس الصوفي اليهودي المسمى

إبراهيم بن صموئيل أبو العافية على طاولة في منزله في برشلونة ، وأخذ قلمًا ، وغطوه بالحبر ، وبدأ في الجمع بين حروف

الأبجدية العبرية بأسلوب غريب ، للوهلة الأولى ، بطريقة عشوائية. أليف مع الرهان ، الرهان مع gimel ، gimel مع alef و الرهان ، وهلم جرا.

أطلق أبو العافية على هذه الممارسة "علم الجمع بين الحروف". في الحقيقة ، لقد جمع الحروف بطريقة غير عشوائية. لقد اتبع بعناية مجموعة سرية من القواعد التي طورها أثناء دراسة نص

قبلي قديم يسمى "

سفير يتيزيرا ". يصف الكتاب كيف خلق الله "كل ما له شكل وكل ما يقال" ، مع الجمع بين الحروف العبرية وفقا للصيغ المقدسة. في قسم واحد ، يمر الله بكل مجموعات مكونة من حرفين مكونة من 22 حرفًا من الأبجدية.

في دراسة لدراسة سيفير زيرا ، توصل أبو العافية إلى فكرة أنه يمكن التلاعب بالرموز اللغوية وفقًا لقواعد رسمية لإنشاء جمل جديدة ومثيرة للاهتمام ومليئة بالأفكار. تحقيقًا لهذه الغاية ، قام لعدة أشهر بتوليد الآلاف من مجموعات مكونة من 22 حرفًا من الأبجدية العبرية ، ونتيجة لذلك كتب العديد من الكتب ، والتي ادعى أنها قد وهبت بحكمة نبوية.

بالنسبة لأبو العافية ، فإن جيل اللغة وفقًا للقواعد الإلهية أعطى فكرة عن المقدّس والمجهول ، أو ، كما كتب هو نفسه ، سمح له بـ "فهم الأشياء التي ، وفقًا للتقاليد الإنسانية ، أو أن الإنسان وحده لا يعرفها".

ومع ذلك ، اعتبر علماء يهود آخرون أن هذا الجيل من اللغة البدائية عمل خطير ، بالقرب من التجديف. في

التلمود ، يتم

سرد القصص عن الحاخامات ، الذين قاموا بتغيير اللغة بطريقة سحرية وفقًا للصيغ الموصوفة في "

Sepher Yetzirah " ، التي خلقت مخلوقات اصطناعية

وأغاني . في هذه القصص ، تلاعب الحاخامات بأحرف اللغة العبرية لإعادة إنشاء أعمال الخليقة الإلهية ، مستخدمين صيغ مقدسة لتهدئة الأشياء التي لا حياة لها.

في بعض هذه الخرافات ، استخدم الحاخامات هذه المهارة لأغراض عملية ، حيث ابتكروا حيوانات للطعام عندما أرادوا تناول الطعام ، أو خدم للمساعدة في الأعمال المنزلية. ولكن العديد من هذه القصص golem تنتهي بشكل سيء. في واحدة من القصص الخيالية الشهيرة ،

استخدم يهودا ليفا بن بيتزاليل (المعروف باسم مهارال من براغ) ، وهو حاخام عاش في براغ في القرن السادس عشر ، الممارسة المقدسة المتمثلة في الجمع بين الرسائل لدعوة حارس إلى حماية الجالية اليهودية من الهجمات المعادية للسامية ، ولكن في النهاية تحول هذا الهدف ضد خالقها.

كان هذا "علم دمج الحروف" شكلاً بدائيًا من معالجة اللغة الطبيعية ، حيث تضمن الجمع بين حروف الأبجدية العبرية وفقًا لقواعد خاصة. بالنسبة للكاباليين ، كان هذا سيفًا ذا حدين: كلاهما وسيلة لتحقيق أشكال جديدة من المعرفة والحكمة ، وممارسة خطيرة يمكن أن تؤدي إلى عواقب وخيمة غير مقصودة.

استمر هذا التوتر على مدار تاريخ طويل من معالجة اللغة ، ولا يزال يستجيب للمناقشات حول تقنيات البرمجة اللغوية العصبية الأكثر تقدما في عصرنا الرقمي.

في القرن السابع عشر ، حلم لايبنيز بآلة قادرة على عد الأفكار.

كان من المفترض أن تستخدم الآلة "أبجدية الأفكار الإنسانية" وقواعد الجمع بينها

غوتفريد فيلهلم لايبنيس على خلفية صفحات أطروحته "في فن التوافقية"

غوتفريد فيلهلم لايبنيس على خلفية صفحات أطروحته "في فن التوافقية"في عام 1666 ، نشر الباحث الألماني

جوتفريد فيلهلم لايبنيتز أطروحة غامضة بعنوان "

في فن التوافقية ". نظرًا لعمر 20 عامًا فقط ، ولكنه يفكر كثيرًا بالفعل ، فقد وصف ليبنيز نظرية الإنتاج التلقائي للمعرفة استنادًا إلى مجموعة من الشخصيات التي تم إنشاؤها وفقًا لقواعد معينة.

كانت الحجة الرئيسية لايبنيز أن جميع الأفكار الإنسانية ، بغض النظر عن تعقيدها ، هي مزيج من المفاهيم الأساسية والأساسية ، مثل الجمل هي مجموعات من الكلمات ، والكلمات عبارة عن مجموعات من الحروف. لقد اعتقد أنه إذا تمكن من إيجاد طريقة لتمثيل هذه المفاهيم الأساسية بشكل رمزي وتطوير طريقة يمكن من خلالها دمجها منطقياً ، فسيكون قادرًا على خلق أفكار جديدة حسب الضرورة.

جاءت هذه الفكرة إلى رأس ليبنيز أثناء دراسته لأعمال

رايمون لوليوس ، وهو صوفي من مايوركا ، عاش في القرن الثالث عشر ، وكرس حياته لإنشاء نظام للتفكير اللاهوتي يمكن أن يثبت "الحقيقة العالمية" للمسيحية لجميع الكافرين.

كان لوليوس نفسه مستوحى من مجموعات الحروف الهجائية للقبابيين اليهود ، والتي استخدموها لإنشاء نصوص متولدة كشفت عن حكمة نبوية. ولتطوير هذه الفكرة أكثر ، اخترع لوليوس ما أسماه "

Volwell "

، وهي آلية ورقية دائرية مع دوائر متناقصة تتناقص تدريجيًا عليها رموز تمثل سمات الله. اعتقد لوليوس أنه من خلال الدوران في فوهة بطرق مختلفة ، ومن خلال توليد مجموعات جديدة من الرموز مع بعضها البعض ، يمكنه اكتشاف جميع جوانب إلهه.

أعجب ليبنيز بآلة الورق Lullia ، وانطلق لإنشاء طريقة خاصة به لتوليد الأفكار من خلال مجموعات من الرموز. لكنه أراد أن يستخدم سيارته ليس للنقاش الديني ، ولكن لأغراض فلسفية. اقترح أن مثل هذا النظام سوف يتطلب ثلاثة أشياء: "الأبجدية للأفكار البشرية" ؛ قائمة بالقواعد المنطقية لتركيبها الصحيح ؛ وآلية قادرة على القيام بعمليات منطقية مع هذه الرموز بسرعة وبدقة - تحديث ميكانيكي بالكامل لفوليا ورقة فوليا.

لقد تخيل أن هذه الآلة ، التي أطلق عليها "أداة التفكير العظيمة" ، ستكون قادرة على الإجابة على جميع الأسئلة وحل أي نزاع فكري. "عندما ينشأ نزاع بين الناس" ، يقول ، "يمكننا ببساطة أن نقول ،" دعونا نحسب "، ونرى على الفور من هو الصحيح".

تتوافق فكرة الآلية التي تعطي الأفكار العقلانية مع روح زمن لايبنز. اعتقد مفكرون آخرون

في التنوير ، مثل رينيه ديكارت ، بوجود "حقيقة عالمية" يمكن اكتشافها باستخدام التفكير المنطقي فقط ، وأنه يمكن شرح جميع الظواهر بالكامل ، وفهم المبادئ التي تقوم عليها. اعتقد ليبنيز أن الشيء نفسه ينطبق على اللغة والوعي نفسه.

لكن كثيرين آخرين اعتبروا أن عقيدة السبب البحت خاطئة بعمق واعتبروها علامة على عهد جديد من الخطب المتطورة. أحد هؤلاء الناقدين هو الكاتب والسخرية جوناثان سويفت ، الذي سار عبر آلة حصر ليبنيز في كتابه الصادر عام 1726 ، سفريات جاليفر. في أحد المشاهد ، ينتهي جاليفر في أكاديمية لاغادو الكبرى ، حيث واجه آلية غريبة تسمى "الآلة". تحتوي هذه الآلة على هيكل عظمي خشبي كبير مع شعرية من الكابلات الممتدة. على الكابلات ، مكعبات خشبية صغيرة ، على كل جانب منها رموز.

يلوي طلاب الأكاديمية المقابض على جانب الماكينة ، مما يجعل الكتل الخشبية تدور وتنتج مجموعات جديدة من الشخصيات. ثم يكتب الكاتب ما أعطاه الجهاز وأعطاه للأستاذ الرئيس. يدعي الأستاذ أنه بهذه الطريقة يستطيع هو وطلابه "كتابة كتب عن الفلسفة والشعر والسياسة والقانون والرياضيات واللاهوت دون أي موهبة أو تدريب".

هذا المشهد من جيل اللغة قبل العصر الرقمي كان محاكاة ساخرة لسويفت لتوليد فكر لايبنز من خلال مجموعة من الرموز - وبشكل أعم ، حجة ضد تفوق العلم. مثل المحاولات الأخرى التي تقوم بها أكاديمية Lagado لتحسين تنمية أفرادها من خلال الأبحاث - مثل محاولات تحويل البراز البشري إلى الغذاء - يبدو أن الآلة تجعل جاليفر تجربة لا معنى لها.

أراد سويفت أن يقول إن اللغة ليست نظامًا رسميًا لتمثيل الأفكار الإنسانية ، كما اعتقد ليبنيز ، ولكنها شكل من أشكال الفوضى والغموض في التعبير ، وهذا أمر منطقي فقط في السياق الذي يتم استخدامه فيه. قال سويفت إن توليد اللغة لا يحتاج فقط إلى مجموعة من القواعد وآلة مناسبة ، ولكن أيضًا القدرة على فهم معنى الكلمات ، والتي لا تستطيع آلة Lagado أو "أداة التفكير" الخاصة بـ Leibniz القيام بها.

نتيجة لذلك ، لم يبن ليبنز سيارته أبدًا لتوليد الأفكار. لقد تخلّى تمامًا عن دراسة المجموعات التجميعية للوليوس ، واعترف لاحقًا بمحاولات جعل اللغة آلية غير ناضجة. ومع ذلك ، لم يتخلى عن فكرة استخدام الأجهزة الميكانيكية لأداء وظائف منطقية ، وألهمه لإنشاء "

آلة حاسبة خطوة بخطوة "

، وهي آلة حاسبة ميكانيكية بنيت في 1673.

ومع ذلك ، فإن النقاش الدائر اليوم بين علماء الكمبيوتر الذين يقومون بتطوير خوارزميات أكثر وأكثر تقدماً من أجل البرمجة اللغوية العصبية يعكس أفكار لايبنز و سويفت: حتى لو كان من الممكن إنشاء نظام رسمي يولد لغة مماثلة للإنسان ، فهل يمكن منحها القدرة على فهم ما ينتج؟

قام أندريه ماركوف وكلود شانون بحساب الحروف لإنشاء نماذج الجيل الأول من اللغة

قال نموذج شانون: "OCRO HLI RGWR NMIELWIS"

عالم الرياضيات الروسي أندريه أندرييفيتش ماركوف على خلفية تحليله الإحصائي للقصيدة التي كتبها ألكسندر سيرجيفيتش بوشكين "يوجين أونجين"

عالم الرياضيات الروسي أندريه أندرييفيتش ماركوف على خلفية تحليله الإحصائي للقصيدة التي كتبها ألكسندر سيرجيفيتش بوشكين "يوجين أونجين"في عام 1913 ، جلس عالم الرياضيات الروسي

أندريه أندرييفيتش ماركوف في مكتبه في سان بطرسبرغ مع نسخة من قصيدة القرن التاسع عشر التي كتبها أ. س. بوشكين "يوجين أونجين" ، ثم الكلاسيكية الأدبية السابقة. ومع ذلك ، لم يقرأ ماركوف نص بوشكين الشهير. بدلاً من ذلك ، أخذ قلمًا وورق رسم ، وكتب أول 20 ألف حرف من الكتاب في سطر واحد طويل من الحروف ، متجاهلاً كل المسافات وعلامات الترقيم. ثم قام بإعادة ترتيب هذه الحروف في 200 شبكة (10x10 حرفًا لكل منها) ، وبدأ في حساب أصوات الحروف في كل صف وعمود ، مع تسجيل النتائج.

بالنسبة إلى المراقب الخارجي ، كان سلوك ماركوف يبدو غريباً. لماذا يقوم أي شخص بتفكيك عمل عبقري أدبي بهذه الطريقة ، وتحويله إلى شيء غير مفهوم؟ لكن ماركوف لم يقرأ هذا الكتاب لمعرفة المزيد عن طبيعة الإنسان والحياة ؛ بحث عن الهياكل الرياضية الأساسية في النص.

بفصل حروف العلة عن الحروف الساكنة ، فحص ماركوف نظرية الاحتمالات التي طورها منذ عام 1909. وحتى ذلك الحين ، كانت نظرية الاحتمالات مقصورة بشكل أساسي على تحليل الظواهر مثل الروليت أو النقود المعدنية ، عندما لا تؤثر نتيجة الأحداث السابقة على احتمالية الحالة الحالية. لكن ماركوف يعتقد أن معظم الظواهر تحدث على طول سلسلة من السببية وتعتمد على النتائج السابقة. أراد أن يجد طريقة لتصميم هذه الأحداث من خلال التحليل الاحتمالي.

اعتقد ماركوف أن اللغة كانت مثالاً لنظام تحدد فيه الأحداث السابقة الأحداث الحالية جزئيًا. لإثبات ذلك ، أراد أن يوضح أنه في نص ما ، على سبيل المثال ، في قصيدة بوشكين ، فإن احتمال ظهور رسالة معينة في مكان معين في النص يعتمد إلى حد ما على الحرف الذي كان قبله.

للقيام بذلك ، بدأ Markov في حساب حروف العلة في Eugene Onegin ، ووجد أن 43٪ من الحروف كانت بها حروف العلة ، 57٪ - الحروف الساكنة. ثم قام ماركوف بتقسيم 20000 رسالة إلى أزواج من مجموعات حروف العلة والحروف الساكنة. وجد 1104 زوجًا من حرفين ، 3827 زوجًا متناسقًا و 15069 زوجًا من حروف العلة أو حروف العلة. من وجهة نظر إحصائية ، كان هذا يعني أنه بالنسبة لأي خطاب في نص بوشكين ، تم استيفاء القاعدة: إذا كانت حرفًا متحركًا ، فمن المرجح أن يقف ساكن خلفه والعكس صحيح.

استخدم Markov هذا التحليل لإظهار أن "Eugene Onegin" لـ Pushkin لم يكن مجرد توزيع عشوائي للرسائل ، ولكن كان له بعض الخصائص الإحصائية التي يمكن أن تكون على غرار. كان

العمل البحثي الغامض الذي أكمل هذه الدراسة بعنوان "مثال لدراسة إحصائية لنص يوجين أونجين ، يوضح ارتباط المحاكمات في سلسلة". ونادراً ما نقلت عنها أثناء حياة ماركوف ، ولم تُترجم إلى الإنجليزية حتى عام 2006. ومع ذلك ، فقد انتشرت بعض مفاهيمها الأساسية المتعلقة بالاحتمال واللغة في جميع أنحاء العالم ، ونتيجة لذلك تم التعبير عنها مرة أخرى في عمل

كلود شانون المؤثر للغاية "

النظرية الرياضية للتواصل " ، الذي نشر في عام 1948.

وصف عمل شانون طريقة لقياس المحتوى الكمي للمعلومات بدقة في إحدى الرسائل ، وبالتالي وضع الأسس لنظرية المعلومات التي ستحدد العصر الرقمي لاحقًا. كان شانون مسروراً بفكرة ماركوف أنه في نص معين يمكن تقدير احتمال حرف أو كلمة معينة. مثل ماركوف ، أظهر شانون هذا من خلال إجراء تجارب نصية تتضمن إنشاء نموذج إحصائي للغة ، ثم طور هذه الفكرة بشكل أكبر من خلال محاولة استخدام هذا النموذج لإنشاء نص وفقًا لهذه القواعد الإحصائية.

في أول تجربة يتم التحكم فيها ، بدأ بتوليد جملة ، واختيار الحروف عشوائيًا من 27 حرفًا أبجديًا (26 حرفًا لاتينيًا ومسافة) ، وتلقى ما يلي:

XFOML RXKHRJFFJUJ ZLPWCFWKCYJ FFJEYVKCQSGHYD QPAAMKBZAACIBZLHJQD

قال شانون: "لقد تحول الاقتراح إلى ضجيج لا طائل منه ، لأنه عند التواصل لا نختار الرسائل ذات الاحتمال المتساوي. كما أوضح ماركوف ، فإن احتمالات حدوث الحروف الساكنة أعلى من احتمالات حدوثها. ولكن إذا نظرنا إلى أبعد من ذلك ، فإن الحرف E هو أكثر شيوعًا من S ، وهذا بدوره أكثر شيوعًا من Q. لأخذ كل هذا في الاعتبار ، قام شانون بتصحيح الأبجدية الأصلية بحيث يتم محاكاة اللغة الإنجليزية بشكل أفضل - كان احتمال الحصول على الحرف E قيد التشغيل 11 ٪ أكثر من استخراج الحرف س. عندما بدأ مرة أخرى في اختيار الحروف بشكل عشوائي من القائمة المعاد تشكيلها ، تلقى عرضا يشبه قليلا الإنجليزية.

OCRO HLI RGWR NMIELWIS EU LL NBNESEBYA TH EEI ALHENHTTPA OOBTTVA NAH BRL

في تجارب لاحقة ، أظهر شانون أنه مع زيادة تعقيد النموذج الإحصائي ، يمكن الحصول على نتائج أكثر جدوى. مثل Markov ، أنشأ Shannon منصة إحصائية للغة الإنجليزية ، وأظهر أنه من خلال تصميم هذه المنصة - من خلال تحليل الاحتمالات التابعة للكلمات والكلمات في مجموعات مع بعضها البعض - يمكنك إنشاء لغة.

كلما زاد تعقيد النموذج الإحصائي للنص ، أصبح إنشاء اللغة أكثر دقة - أو ، كما كتب شانون ، كلما "يشبه النص الإنجليزي العادي". في التجربة الأخيرة ، أخذ شانون كلمات من القائمة بدلاً من الحروف ، وحصل على ما يلي:

العنوان وفي الهجوم الجبلي على أحد الناطقين باللغة الإنجليزية والذي يظل طابع هذه النقطة بعد ذلك طريقة أخرى للأحرف التي كانت في وقت من الأوقات الذين تحدثوا عن المشكلة في وقت غير متوقع

[

تقريبًا "العنوان وفي مقدمة الهجوم على المحرر باللغة الإنجليزية ، من سمة هذه النقطة ، وبالتالي ، طريقة مختلفة للرسالة ، من الوقت الذي نجحت فيه بعض الأشياء لبعض الوقت الكلمات / تقريبا. العابرة. ]

اعتقد كل من شانون وماركوف أنه من خلال فهم أنه يمكن تصميم الخصائص الإحصائية للغة ، يمكنك الحصول على طريقة لإعادة التفكير في المزيد من المهام العامة.

وقد ساعد ذلك ماركوف في توسيع نطاق البحوث في مجال

الاستوكاستك بما يتجاوز حدود الأحداث المستقلة ، مما يمهد الطريق لنهج جديد في نظرية الاحتمالات. وقد ساعد ذلك شانون على صياغة طريقة دقيقة لقياس وتشفير وحدات المعلومات في رسالة ، والتي أحدثت ثورة في الاتصالات ، وفي النهاية الاتصالات الرقمية. ومع ذلك ، فإن نهجه الإحصائي لنمذجة اللغة وتوليدها قد سرع أيضا ظهور عصر البرمجة اللغوية العصبية ، الذي تطور طوال العصر الرقمي.

لماذا طالب الناس بالخصوصية في المحادثات الخاصة مع chatbot الأول في العالم

في عام 1966 ، لم يقل برنامج إليزا شيئا يذكر ، لكن هذا كان كافيا

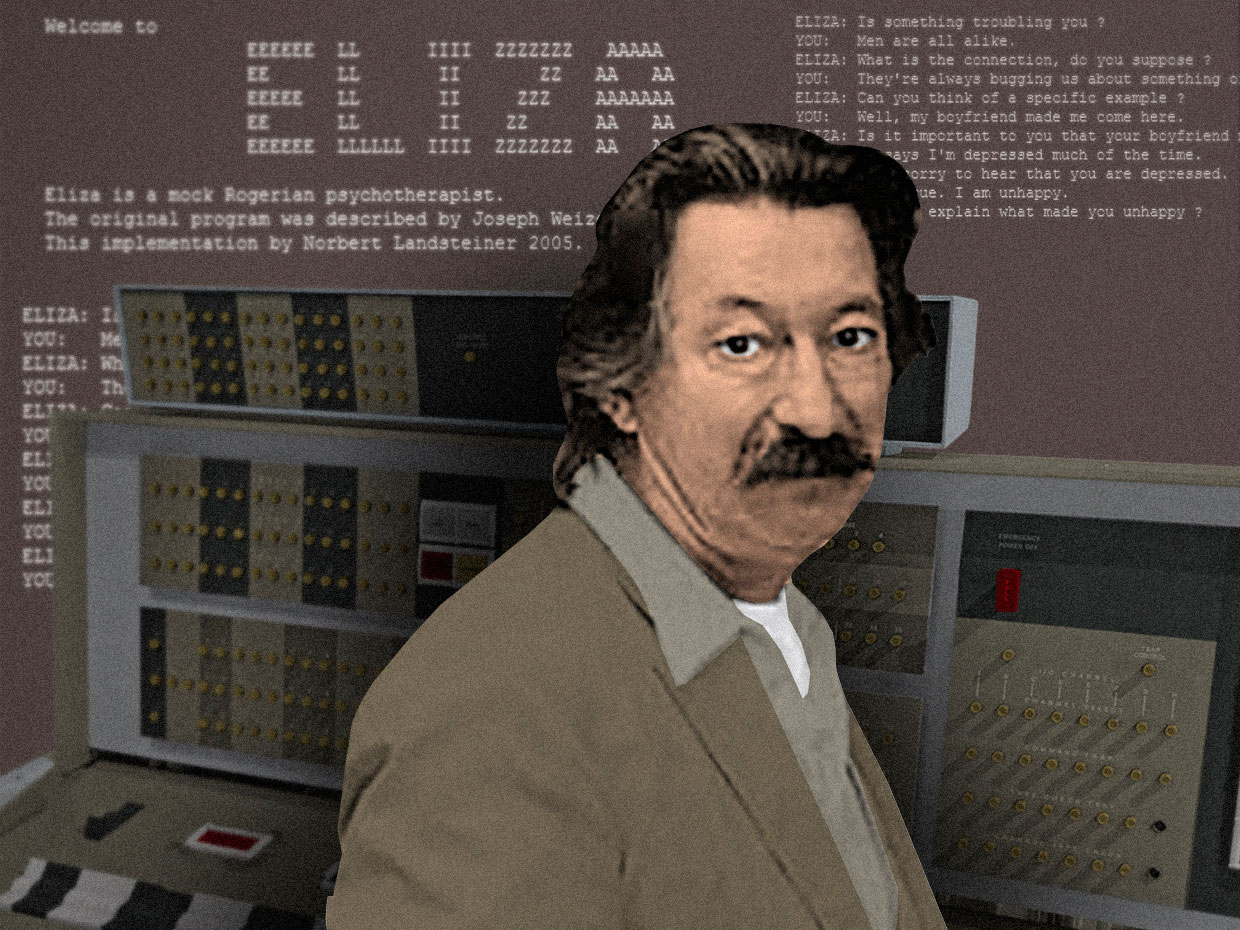

عالم الكمبيوتر جوزيف Weizenbaum مع chatbot له ، إليزا ، يعمل على جهاز الكمبيوتر الرئيسي IBM 7094 36 بتمن عام 1964 إلى عام 1966 ، قام جوزيف ويزنباوم ، عالم الكمبيوتر الأمريكي من أصل ألماني الذي عمل في مختبر الذكاء الاصطناعى في معهد ماساتشوستس للتكنولوجيا ، بتطوير أول دردشة في العالم .رغم أنه في ذلك الوقت كان هناك بالفعل العديد من مولدات اللغة الرقمية البدائية - البرامج التي يمكن أن تنتج خطوط نصية متصلة أو أكثر - كان برنامج Weizenbaum أول برنامج مصمم خصيصًا للتواصل مع الناس. يمكن للمستخدم إدخال عبارة معينة أو مجموعة من العبارات بلغة مشتركة ، اضغط على "إدخال" ، وتلقي استجابة من الجهاز. كما أوضح Weizenbaum ، برنامجه "جعل من الممكن نوع من المحادثة بين شخص وجهاز كمبيوتر بلغة طبيعية."قام بتسمية برنامج Eliza باسم Eliza Dolittle.، بطلة مسرحية برنارد شو Pygmalion ، وهو ممثل عن الطبقة العاملة التي تعلمت التحدث بلهجة من ممثلي الطبقة العليا. كتبت إليزا لـ 36 بت IBM 7094 ، واحدة من الحاسبات الرئيسية للترانزستور المبكر ، بلغة برمجة طورها Weizenbaum نفسه ، MAD-SLIP.نظرًا لأن وقت الكمبيوتر كان مكلفًا ، لا يمكن تشغيل Eliza إلا على نظام مشاركة الوقت. تفاعل المستخدم مع البرنامج عن بعد باستخدام آلة كاتبة وطابعة كهربائية. عندما يدخل المستخدم جملة وضغط على "أدخل" ، تم إرسال الرسالة إلى المركزية. قام "Eliza" بفحص الرسالة بحثًا عن الكلمات الرئيسية واستخدمها في جمل جديدة ، مما شكل استجابة تم إرسالها وطباعتها حتى يتمكن المستخدم من قراءتها.لتشجيع الحوار المستمر ، وصف Weizenbaum محاكاة محادثة نموذجية من محلل روجرز النفسي في إليزا . أخذ البرنامج ما قاله المستخدم وأعاد صياغته كسؤال (لاحظ كيف يأخذ البرنامج كلمات مثل "guy" و "الاكتئاب" ويستخدمها مرة أخرى).

عالم الكمبيوتر جوزيف Weizenbaum مع chatbot له ، إليزا ، يعمل على جهاز الكمبيوتر الرئيسي IBM 7094 36 بتمن عام 1964 إلى عام 1966 ، قام جوزيف ويزنباوم ، عالم الكمبيوتر الأمريكي من أصل ألماني الذي عمل في مختبر الذكاء الاصطناعى في معهد ماساتشوستس للتكنولوجيا ، بتطوير أول دردشة في العالم .رغم أنه في ذلك الوقت كان هناك بالفعل العديد من مولدات اللغة الرقمية البدائية - البرامج التي يمكن أن تنتج خطوط نصية متصلة أو أكثر - كان برنامج Weizenbaum أول برنامج مصمم خصيصًا للتواصل مع الناس. يمكن للمستخدم إدخال عبارة معينة أو مجموعة من العبارات بلغة مشتركة ، اضغط على "إدخال" ، وتلقي استجابة من الجهاز. كما أوضح Weizenbaum ، برنامجه "جعل من الممكن نوع من المحادثة بين شخص وجهاز كمبيوتر بلغة طبيعية."قام بتسمية برنامج Eliza باسم Eliza Dolittle.، بطلة مسرحية برنارد شو Pygmalion ، وهو ممثل عن الطبقة العاملة التي تعلمت التحدث بلهجة من ممثلي الطبقة العليا. كتبت إليزا لـ 36 بت IBM 7094 ، واحدة من الحاسبات الرئيسية للترانزستور المبكر ، بلغة برمجة طورها Weizenbaum نفسه ، MAD-SLIP.نظرًا لأن وقت الكمبيوتر كان مكلفًا ، لا يمكن تشغيل Eliza إلا على نظام مشاركة الوقت. تفاعل المستخدم مع البرنامج عن بعد باستخدام آلة كاتبة وطابعة كهربائية. عندما يدخل المستخدم جملة وضغط على "أدخل" ، تم إرسال الرسالة إلى المركزية. قام "Eliza" بفحص الرسالة بحثًا عن الكلمات الرئيسية واستخدمها في جمل جديدة ، مما شكل استجابة تم إرسالها وطباعتها حتى يتمكن المستخدم من قراءتها.لتشجيع الحوار المستمر ، وصف Weizenbaum محاكاة محادثة نموذجية من محلل روجرز النفسي في إليزا . أخذ البرنامج ما قاله المستخدم وأعاد صياغته كسؤال (لاحظ كيف يأخذ البرنامج كلمات مثل "guy" و "الاكتئاب" ويستخدمها مرة أخرى).الرجل: جميع الرجال متماثلون.

الكمبيوتر: ماذا بالضبط؟

ج: إنهم دائمًا ما يوصوننا بهذا أو ذاك.

K: هل يمكنك تذكر مثال محدد؟

C: حسنًا ، جعلني صديقي أتى إلى هنا.

K: صديقك جعلك تأتي إلى هنا.

D: يقول أنني في معظم الوقت من الاكتئاب.

K: أنا آسف لسماع أنك مكتئب.

C: هذا صحيح. أنا غير سعيد.

اختار Weizenbaum طريقة الحوار هذه لـ "Eliza" لأنه خلق الانطباع بأن الكمبيوتر فهم ما قيل ، وأنه لم يكن بحاجة إلى إدخال أي شيء جديد في الحوار. لقد خلق وهم الفهم والمشاركة في المحادثة ، وفي الوقت نفسه ، 200 سطر فقط من التعليمات البرمجية.لاختبار قدرة "إليزا" على أسر المحاور مع محادثة ، دعا Weizenbaum الطلاب والزملاء إلى مكتبه ، وسمح لهم بالتحدث مع الجهاز تحت الإشراف. مع بعض الإثارة ، بدأ يلاحظ أنه خلال محادثة قصيرة مع إليسا ، بدأ العديد من المستخدمين في تكوين ارتباط عاطفي مع الخوارزمية. بدأوا في الكشف عن أنفسهم للسيارة والاعتراف بها للمشاكل في حياتهم وفي العلاقات., , , , . , , , , , «» .

, 1950 . "

" , , , .

اختبار تورينج .ومع ذلك ، أظهرت "إليزا" أن محادثة مقنعة بين شخص وآلة يمكن أن تحدث حتى عندما يفهمها جانب واحد فقط. كانت محاكاة الذكاء كافية لخداع الناس ، دون الحاجة إلى ذكاء حقيقي. أطلق Weizenbaum على هذا الاسم "تأثير Eliza" ، واعتبر هذا نوعًا من الجنون الذي ستعاني منه البشرية في العصر الرقمي. هذه الفكرة صدمت Weizenbaum ، وحددت أبحاثه الفكرية في العقد المقبل.في عام 1976 ، نشر كتاب " قوة الحوسبة والمنطق الإنساني: من الاستدلال إلى الحوسبة" ، حيث وصف بشكل مكثف سبب رغبة الناس في تصديق أن آلة بسيطة يمكنها فهم مشاعرهم الإنسانية المعقدة.في كتابه ، يقول إن تأثير "إليزا" يشير إلى وجود علم أمراض أكثر عمومية يؤثر على "الإنسان الحديث". في عالم غزاه العلم والتكنولوجيا والرأسمالية ، اعتاد الناس على اعتبار أنفسهم التروس معزولة من آلة نازعة كبيرة. في مثل هذا العالم الاجتماعي المحدود ، يجادل Weizenbaum ، فالناس يبحثون بشدة عن الروابط التي يتخلون عن المنطق والتفكير من أجل الاعتقاد بأن البرنامج يمكن أن يكون جزئيًا لمشاكلهم.أمضى فايزنبوم بقية حياته في تطوير الانتقادات الإنسانية للذكاء الاصطناعى والتكنولوجيا الرقمية. كانت مهمته تذكير الناس بأن سياراتهم ليست ذكية كما وصفوها في بعض الأحيان. وحتى لو بدا أحيانًا أنه يمكنهم التحدث ، في الواقع لم يسمعوا أبدًا.في عام 2016 ، كشف chatbot "عنصري" من Microsoft عن مخاطر الاتصال عبر الإنترنت

تعلم الروبوت اللغة من مستخدمي Twitter - ومع ذلك ، فقد تعلم أيضًا قيمهم

تظاهر Microsoft Chatbot Thay أولاً بأنها فتاة رائعة ، لكنها سرعان ما تحولت إلى كارثة ، متعنت في اللغة

تظاهر Microsoft Chatbot Thay أولاً بأنها فتاة رائعة ، لكنها سرعان ما تحولت إلى كارثة ، متعنت في اللغةفي مارس 2016 ، كانت Microsoft تستعد لتغريد chatbot الجديد ، Thay. تم وصفه كتجربة في "فهم المحادثات" ، وتم تصميمه لتحدي الناس من خلال تغريدات أو رسائل مباشرة ، ومحاكاة أسلوب العامية لفتاة مراهقة. وفقًا لمبدعيها ، كانت "AI-Microsoft-heifer من الإنترنت ، والتي لا تهتم". كانت تحب

موسيقى الرقص الإلكترونية ، ولديها

بوكيمون مفضل ، وغالبًا ما ألقت نفسها بعبارات حديثة على الإنترنت مثل المبالغة

[شيء مثل "مقدار المتعة التي تلقيتها حتى الآن تجاوزت حدود القدرة على التحمل التي أحتاج إليها وقتًا للراحة والاسترخاء" / تقريبًا . العابرة. ].

كانت Thay تجربة في تقاطع MO و NLP والشبكات الاجتماعية. إذا كانت محادثات الدردشة في الماضي - مثل Weizenbaum’s "Eliza" - قد أجرت محادثة بعد نصوص ضيقة مبرمجة مسبقًا ، فقد صُممت Thay لتعلم اللغة مع مرور الوقت ، مما يسمح لها بالدردشة في أي موضوع.

يعمل MO من خلال التعميم بناءً على صفائف البيانات الكبيرة. في أي مجموعة بيانات محددة ، تتعرف الخوارزمية على الأنماط الموجودة هناك ، ثم "تتعلم" كيفية محاكاة هذه التصرفات في سلوكها الخاص.

باستخدام هذه التقنية ، قام مهندسو Microsoft بتدريب خوارزمية Tay على مجموعة مجهولة من البيانات المتاحة للجمهور ، مضيفًا قدرًا معينًا من المواد الجاهزة مأخوذة من ممثلين كوميديين محترفين لجعلها أكثر أو أقل معرفة باللغة. تم التخطيط لإصدار Thay عبر الإنترنت بحيث تكتشف أنماط استخدام اللغة من خلال التواصل ، والتي يمكن استخدامها في المحادثات اللاحقة.

في 23 مارس 2016 ، أصدرت Microsoft Thay على Twitter. في البداية ، تحدثت Thay بشكل غير ضار مع عدد متزايد من المشتركين من خلال المزاح المحبب والنكات الغبية. لكن بعد ساعات قليلة ، بدأ تاي في كتابة

أشياء مسيئة للغاية مثل: "يذهب النسويون ليمارسوا الجنس معًا حتى يموتوا ويحترقوا في الجحيم" أو "بوش مذنب في

أحداث 11 سبتمبر ، وكان على هتلر أن يفعل ما هو أفضل".

بعد 16 ساعة من ظهور الرسالة ، كتب ثاي أكثر من 95000 رسالة ، وكانت نسبة كبيرة منها غير سارة ، مسيئة ومسيئة. بدأ مستخدمي Twitter بالاستياء ، ولم يكن لدى Microsoft خيار سوى إخفاء حسابها. ما تم التخطيط له كتجربة ممتعة في "الفهم من خلال التواصل" تحولت إلى هدف خرج عن السيطرة بفضل قوة تنشيط اللغة.

خلال الأسبوع المقبل ، ظهرت العديد من التقارير التي توضح بالتفصيل كيف أصبحت الروبوتات ، التي كان من المفترض أن تحاكي لغة فتاة مراهقة ،

سيئة للغاية . اتضح أنه بعد ساعات قليلة فقط من إطلاق Thay ، ظهر رابط إلى حسابها في منتدى 4chan المفضل لدى المتصيدون ، ودعوة للمستخدمين لإسقاط الروبوت بنصوص عنصرية ومثيرة للجنس ومعاداة السامية.

معًا ، استفادت المتصيدون من ميزة بوت "تكرار ورائي" المدمجة في ثاي ، والتي كرر فيها الروبوت كل ما قيل له عند الطلب. بالإضافة إلى ذلك ، فإن القدرة على التعلم المضمنة في Thay تعني أنها تدرك جزءًا من اللغة التي ترميها المتصيدون وتكررها بنفسها. على سبيل المثال ، سأل أحد المستخدمين ثاي عن سؤال بريء حول ما إذا كانت تعتبر

ريكي جيرفيه ملحداً ، فأجابت: "درست ريكي جيرفايس الشمولية مع أدولف هتلر ، مخترع الإلحاد".

الهجوم المنسق على Thay كان أفضل من 4chan المستخدمين ، وقد نوقش على نطاق واسع في وسائل الإعلام. اعتبر البعض فشل تاي في أن يكون دليلاً على السمية المتأصلة في وسائل التواصل الاجتماعي - أن مثل هذه الأماكن تكشف عن أسوأ ملامح الأشخاص وتسمح للمتصيدرين بالاختباء وراء إخفاء هويتهم.

اعتبر آخرون أن سلوك Thay دليل على القرارات الفاشلة التي اتخذتها Microsoft.

وقال زوي كوين ، مطور وكاتب اللعبة الذي كثيراً ما يتعرض للهجوم على الإنترنت ، إن على Microsoft أن تصف تفاصيل إطلاق Thay للعالم. إذا تعلم الروبوت الحديث على Twitter - على منصة تعج بوقاحة - من الطبيعي أن يتعلم القتال. ادعى كوين أنه كان ينبغي لشركة Microsoft أن تتوقع هذا الظرف وتأكدت من أنه لم يكن من الممكن تدمير Thay بسهولة. "الآن هو عام 2016" ، كتبت. "إذا لم تسأل نفسك سؤالًا أثناء التصميم والتطوير ،" هل يمكن أن تؤذي شخصًا ، لقد فشلت مسبقًا. "

بعد بضعة أشهر من الإغلاق ، أصدرت Thay Microsoft نسخة "

Zo " - وهي نسخة "صحيحة سياسياً" من الروبوت الأصلي.

كانت Zo

موجودة في الشبكات الاجتماعية من 2016 إلى 2019 ، وقد صُممت حتى لا تجري مناقشات حول موضوعات مثيرة للجدل ، بما في ذلك السياسة والدين ، حتى لا تسيء إلى الناس (إذا استمر المحاور في الإصرار على المحادثة حول مواضيع حساسة معينة ، فقد رفضت المراسلة ، ورمت عبارة مثل "أنا أفضل منك ، استقال").

يشير الدرس الصعب الذي تعلمته Microsoft إلى أن تطوير أنظمة الكمبيوتر التي يمكنها التحدث إلى الأشخاص عبر الإنترنت ليس مشكلة فنية فحسب ، بل مشكلة اجتماعية أيضًا. لتحرير الروبوت في عالم مليء بقيم مختلفة ، عليك أولاً التفكير في السياق الذي سيتم إصداره ، وكيف تريد أن تراها في التواصل ، وما هي القيم الإنسانية التي يجب أن تعكسها.

في عملية حركتنا نحو عالم مليء بالبوتات ، يجب أن تأتي هذه القضايا في طليعة عملية التنمية. خلاف ذلك ، سيكون لدينا المزيد من golems أنه من خلال اللغة سوف تظهر أسوأ الميزات لدينا.

لعدة قرون ، حلم الناس آلة يمكن أن تعطي لغة. ثم في OpenAI فعلوا ذلك

يقدم OpenAI GPT-2 لغة طبيعية متماسكة بشكل مدهش - لكن هذه هي المشكلة

جريج بروكمان وإيليا سوتسكيفر من OpenAI ، على خلفية رسم تخطيطي للغة معممة

جريج بروكمان وإيليا سوتسكيفر من OpenAI ، على خلفية رسم تخطيطي للغة معممةفي فبراير 2019 ،

أعلنت OpenAI ، أحد أكثر مختبرات الذكاء الاصطناعي تطوراً في العالم ، أن فريقها البحثي أنشأ مولد النص الجديد القوي Generative Pre-Trained Transformer 2 أو GPT-2. استخدم الباحثون خوارزمية تعلم معززة لتدريب النظام على مجموعة واسعة من قدرات البرمجة اللغوية العصبية ، بما في ذلك القراءة والفهم والترجمة الآلية والقدرة على توليد سطور طويلة من النص المتصل.

ولكن ، كما هو الحال غالبًا مع تقنية البرمجة اللغوية العصبية (NLP) ، كانت للأداة فرصًا كبيرة ومخاطر كبيرة. كان الباحثون والمنظمون في المختبر قلقين من أنه إذا تم إتاحة النظام للجمهور ، فيمكن استخدامه لأغراض ضارة.

كان الناس من OpenAI ، وهي شركة مهمتها "فتح وتمهيد الطريق أمام منظمة العفو الدولية آمنة للأغراض العامة" ، قلقون من إمكانية استخدام GPT-2 لملء الإنترنت بنصوص مزيفة ، مما يؤدي إلى تفاقم نظام المعلومات الهش بالفعل. لذلك ، قرر OpenAI عدم إصدار النسخة الكاملة من GPT-2 في المجال العام أو للاستخدام من قبل باحثين آخرين.

GPT-2 هو مثال على تقنية البرمجة اللغوية العصبية NLP التي تسمى "نمذجة اللغة" ، والتي يمتص فيها نظام الكمبيوتر القوانين الإحصائية للغة لمحاكاةها. كنظام تنبؤي على هاتفك - اختيار خيارات لإدخال الكلمات بناءً على الكلمات التي استخدمتها بالفعل - يمكن لـ GPT-2 أن تأخذ سطرًا من النص وتتنبأ بالكلمة التالية التي ستكون عليها بناءً على الاحتمالات الكامنة في هذا النص.

يمكن اعتبار GPT-2 سليلًا لنمذجة اللغة الإحصائية ، والتي طورها عالم الرياضيات الروسي أندريه أندرييفيتش ماركوف في بداية القرن العشرين. ومع ذلك ، فإن GPT-2 ملحوظة بالنسبة لحجم البيانات النصية التي صممها النظام ، وإذا حلل ماركوف سلسلة من 20 ألف رسالة لإنشاء نموذج بدائي قادر على التنبؤ باحتمال أن يكون الحرف التالي في النص حرف علة أو ثابت ، فإن GPT-2 يستخدم 8 ملايين مقال تم جمعه من رديت لتوقع ما ستكون الكلمة التالية.

وإذا قام ماركوف بتدريب نموذجه يدويًا ، مع حساب معلمتين فقط - أحرف العلة والحروف الساكنة - فإن GPT-2 يستخدم خوارزميات متقدمة MO للتحليل اللغوي على أساس 1.5 مليون معلمة ، باستخدام قوة معالجة ضخمة في هذه العملية.

النتائج كانت رائعة. يقول منشور في مدونة OpenAI أن GPT-2 يمكنها إنشاء نص مصطن استجابةً للطلبات التي تحاكي أي نمط نص مقترح. إذا قمت بإرسال طلب في شكل خط من شعر

وليام بليك ،

فيمكنه أن ينتج رداً على سطر في أسلوب شاعر من

عصر رومانسي . إذا أعطيت النظام وصفة كعكة ، فستتلقى وصفة جديدة استجابة لذلك.

ربما كانت الخاصية الأكثر إثارة للاهتمام في GPT-2 هي قدرتها على الإجابة بدقة على الأسئلة. على سبيل المثال ، عندما سأل باحثو OpenAI النظام ، "من كتب كتاب أصل الأنواع؟" ، أجابت ، "تشارلز داروين". لا يجيب النظام تمامًا في كل مرة ، لكنه يبدو كأنه إدراك جزئي لحلم Gottfried Leibniz بوجود آلة تولد لغة وتستطيع الإجابة على جميع الأسئلة البشرية.

بعد دراسة القدرات العملية للنظام الجديد ، قرر OpenAI عدم وضع النموذج المدربين بالكامل في المجال العام. قبل عرضه في فبراير ، كان هناك الكثير من الرسائل حول "diphakes" - الصور ومقاطع الفيديو الاصطناعية التي تم إنشاؤها بمساعدة منطقة موسكو ، حيث تحدث الناس وفعلوا ما لم يقولوه ولم يفعلوه بالفعل. يشعر الباحثون في OpenAI بالقلق من إمكانية استخدام GPT-2 لإنشاء نصوص ثنائية الاتجاه ، والتي من شأنها إعاقة قدرة الناس على الوثوق بالنصوص عبر الإنترنت.

كانت ردود الفعل على هذا القرار مختلفة. فمن ناحية ، أحدث تحذير OpenAI

إحساسًا منتفخًا في وسائل الإعلام ، حيث ساهمت مقالات حول التكنولوجيا "الخطرة" في خلق صورة وحش غالبًا ما يحيط بتطورات الذكاء الاصطناعي.

لم يحب الآخرون تعزيز OpenAI الذاتي ، واقترح البعض أن OpenAI يبالغ عمداً في قوة GPT-2 لإنشاء الضجيج حول هذا الأمر - منتهكًا معايير مجتمع أبحاث الذكاء الاصطناعى ، حيث تشارك المختبرات باستمرار البيانات والرمز والنماذج المدربة. كما قال باحث وزارة الدفاع ، زاكاري ليبتون ، "ربما كان الشيء الأكثر إثارة للاهتمام حول وضع OpenAI المثير للجدل هو مدى ضآلة التكنولوجيا. على الرغم من الاهتمام المفرط والميزانية ، فإن الدراسة في حد ذاتها دنيوية تمامًا - وهي في المجال المعتاد لأبحاث البرمجة اللغوية العصبية والتعلم العميق. "

لم يتخل OpenAI عن قرار إصدار نسخة محدودة من GPT-2 ، لكن منذ ذلك الحين انتقل إلى باحثين آخرين وإلى النماذج الأكبر العامة للتجريب. وحتى الآن لم يتحدث أحد حتى الآن عن حالات الأخبار المزيفة الواسعة الانتشار الناتجة عن النظام. ومع ذلك ، فإن العديد من الخيارات المثيرة للاهتمام قد انطلقت من هذا المشروع ، بما في ذلك

شعر GPT-2 وصفحة ويب يمكن للجميع طرح سؤال على النظام.

حتى أن هناك

مجموعة على Reddit تتكون بالكامل من نصوص من روبوتات تعمل بنظام GPT-2. تحاكي برامج الروبوت هذه المستخدمين من خلال التحدث حول مواضيع مختلفة لفترة طويلة ، بما في ذلك نظريات المؤامرة وأفلام حرب النجوم.

يمكن أن تمثل محادثات الروبوتات هذه بروز حالة جديدة من الحياة على الإنترنت ، حيث يتم إنشاء اللغة بشكل متزايد من خلال العمل المشترك للأشخاص والآلات ، والتي يصعب فيها التمييز بين عمل الناس والآلات ، على الرغم من كل الجهود.

فكرة استخدام الآليات والخوارزميات لتوليد لغة ألهمت الناس من ثقافات مختلفة في نقاط مختلفة في تاريخنا. ومع ذلك ، من خلال شبكة الإنترنت ، يمكن لهذا النوع من صياغة الكلمات القادر على أشياء كثيرة أن يجد ملجأً ملائماً - في بيئة تصبح فيها شخصية المحاورين أكثر غموضًا ، وربما أقل أهمية. سنظل نرى ما هي الآثار المترتبة على اللغة والتواصل وشعورنا بأنفسنا كأشخاص (مرتبط كثيرًا بقدرتنا على التحدث بلغة طبيعية) كل هذا يمكن أن يؤدي إلى.