مرحبا يا هبر! أقدم لكم ترجمة المقال "تصور نموذجًا للترجمة الآلية العصبية (ميكانيكا نماذج Seq2seq باهتمام)" لجي العمار.

نماذج التسلسل إلى التسلسل (seq2seq) هي نماذج تعليمية عميقة حققت نجاحًا كبيرًا في مهام مثل الترجمة الآلية وتلخيص النص وتعليق الصورة ، إلخ. على سبيل المثال ، في نهاية عام 2016 ، تم تصميم نموذج مماثل في Google Translate. تم وضع أسس نماذج seq2seq في عام 2014 مع إصدار مقالتين - Sutskever et al. ، 2014 ، Cho et al. ، 2014 .

من أجل فهم هذه النماذج واستخدامها بشكل كافٍ ، يجب أولاً توضيح بعض المفاهيم. ستكون التصورات المقترحة في هذه المقالة مكملاً جيدًا للمقالات المذكورة أعلاه.

نموذج التسلسل إلى التسلسل هو نموذج يقبل تسلسل إدخال العناصر (الكلمات والحروف وسمات الصورة ، وما إلى ذلك) ويعيد سلسلة أخرى من العناصر. النموذج المدربين يعمل على النحو التالي:

في الترجمة الآلية العصبية ، يمثل تسلسل العناصر مجموعة من الكلمات التي تتم معالجتها بدورها. الاستنتاج هو أيضا مجموعة من الكلمات:

نلقي نظرة تحت غطاء محرك السيارة

تحت غطاء محرك السيارة ، يحتوي النموذج على وحدة فك ترميز وفك تشفير.

يعالج المشفر كل عنصر من عناصر تسلسل الإدخال ، ويقوم بترجمة المعلومات المستلمة إلى متجه يسمى السياق. بعد معالجة تسلسل الإدخال بالكامل ، يرسل المشفر السياق إلى وحدة فك الترميز ، والذي يبدأ بعد ذلك في إنشاء عنصر تسلسل الإخراج حسب العنصر.

يحدث الشيء نفسه مع الترجمة الآلية.

بالنسبة للترجمة الآلية ، يكون السياق عبارة عن ناقل (مجموعة من الأرقام) ، وغالبًا ما يكون المشفر وفك الشفرة عبارة عن شبكات عصبية متكررة (راجع مقدمة RNN - مقدمة سهلة للشبكات العصبية المتكررة ).

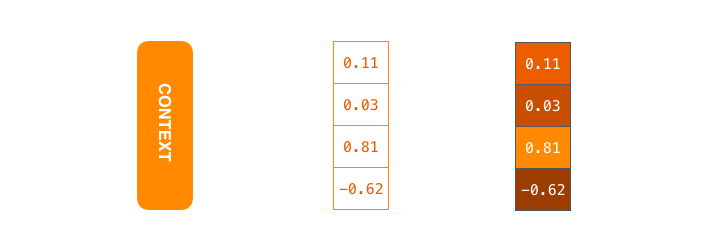

السياق عبارة عن ناقل لأرقام النقاط العائمة. علاوة على ذلك ، سيتم عرض المتجهات بالألوان بحيث يتوافق اللون الأخف مع الخلايا ذات القيم الكبيرة.

عند تدريب النموذج ، يمكنك ضبط حجم متجه السياق - عدد الخلايا العصبية المخفية (الوحدات المخفية) في مشفر RNN. تُظهر بيانات التصور متجهًا رباعي الأبعاد ، ولكن في التطبيقات الحقيقية ، سيكون لمتجه السياق بعدًا بترتيب 256 أو 512 أو 1024.

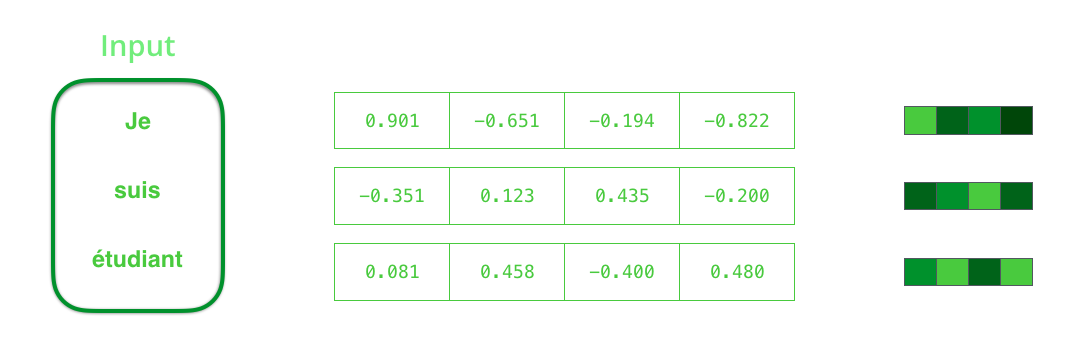

بشكل افتراضي ، في كل فترة زمنية ، يستقبل RNN عنصرين للإدخال: عنصر الإدخال نفسه (في حالة جهاز تشفير ، كلمة واحدة من الجملة الأصلية) والحالة المخفية. الكلمة ، ومع ذلك ، يجب أن يمثلها ناقل. لتحويل كلمة إلى متجه ، يلجأون إلى سلسلة من الخوارزميات تدعى embeddings word. تترجم الزينة الكلمات إلى مسافات متجهة تحتوي على معلومات الدلالية والدلالية عنها (على سبيل المثال ، "ملك" - "رجل" + "امرأة" = "ملكة" ).

قبل معالجة الكلمات ، يجب عليك تحويلها إلى متجهات. ويتم هذا التحول باستخدام كلمة تضمين خوارزمية. يمكنك استخدام كل من حفلات الزفاف المدربة مسبقًا وتدريب حفلات الزفاف على مجموعة البيانات الخاصة بك. 200-300 - البعد النموذجي لمتجه التضمين ؛ يستخدم هذا المقال البعد 4 للبساطة.

الآن وقد تعرفنا على المتجهات / الموانع الرئيسية لدينا ، دعنا نتذكر آلية RNN وقمنا بإنشاء تصورات لوصفها:

في الخطوة التالية ، يأخذ RNN ناقل الإدخال الثاني والحالة الكامنة رقم 1 لتشكيل الإخراج في هذا الفاصل الزمني. في وقت لاحق من هذا المقال ، يتم استخدام الرسوم المتحركة المماثلة لوصف المتجهات داخل نموذج الترجمة الآلية العصبية.

في التصور التالي ، يصف كل رتل معالجة المدخلات بواسطة مشفر وتوليد النواتج بواسطة مفكك التشفير في فترة زمنية واحدة. نظرًا لأن كلا من التشفير وفك الشفرة هما RNN ، في كل فترة زمنية ، فإن الشبكة العصبية مشغولة بمعالجة وتحديث حالاتها المخفية بناءً على المدخلات الحالية وجميع المدخلات السابقة. في هذه الحالة ، يكون آخر الحالات المخفية لجهاز التشفير هو السياق ذاته الذي يتم إرساله إلى وحدة فك الترميز.

يحتوي فك الترميز أيضًا على حالات مخفية يقوم بنقلها من فتحة زمنية إلى أخرى. (هذا ليس في التصور ، يصور فقط الأجزاء الرئيسية من النموذج.)

ننتقل الآن إلى نوع آخر من التصور لنماذج التسلسل إلى التسلسل. ستساعد هذه الرسوم المتحركة في فهم الرسومات الثابتة التي تصف هذه النماذج - ما يسمى طريقة عرض غير منضبطة ، حيث نعرض نسخة منها لكل فاصل زمني بدلاً من إظهار وحدة فك ترميز واحدة. لذلك يمكننا أن ننظر إلى عناصر المدخلات والمخرجات في كل الفاصل الزمني.

انتبه!

ناقل السياق هو عنق الزجاجة لهذا النوع من النماذج ، مما يجعل من الصعب عليهم التعامل مع جمل طويلة. تم اقتراح الحل في مقالات من قبل Bahdanau et al.، 2014 و Luong et al.، 2015 ، والتي قدمت تقنية تسمى آلية الاهتمام. تعمل هذه الآلية على تحسين جودة أنظمة الترجمة الآلية بشكل كبير ، مما يسمح للنماذج بالتركيز على الأجزاء ذات الصلة من تسلسل الإدخال.

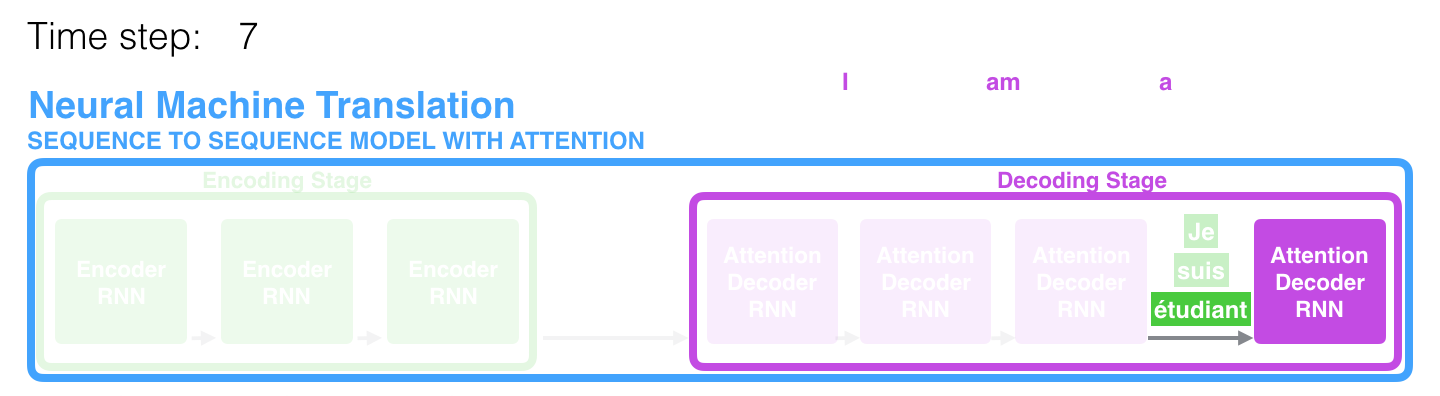

في الفترة الزمنية السابعة ، تسمح آلية الانتباه لوحدة فك الترميز بالتركيز على كلمة étudiant (طالب باللغة الفرنسية) قبل إنشاء ترجمة إلى اللغة الإنجليزية. تتيح هذه القدرة على تضخيم الإشارة من الجزء ذي الصلة من تسلسل الإدخال للطرز القائمة على آلية الانتباه الحصول على نتيجة أفضل مقارنةً بالطرز الأخرى.

عند النظر في نموذج يحتوي على آلية من الاهتمام على مستوى عالٍ من التجريد ، يمكن التمييز بين اختلافين رئيسيين من نموذج التسلسل الكلاسيكي إلى التسلسل.

أولاً ، يقوم المشفر بنقل المزيد من البيانات إلى وحدة فك الترميز: بدلاً من إرسال الحالة المخفية الأخيرة فقط بعد مرحلة التشفير ، يرسل المشفر جميع حالاته المخفية إليه:

ثانياً ، تمر وحدة فك الترميز بخطوة إضافية قبل توليد الإخراج. من أجل التركيز على تلك الأجزاء من تسلسل المدخلات ذات الصلة بالفترة الزمنية المقابلة ، تقوم وحدة فك الترميز بما يلي:

- ينظر إلى مجموعة من الحالات الكامنة المستلمة من جهاز تشفير - ترتبط كل حالة من الحالات الكامنة بشكل أفضل مع إحدى الكلمات في تسلسل الإدخال ؛

- يعين تقييمًا معينًا لكل حالة كامنة (دعنا نتجاهل الآن كيف يحدث إجراء التقدير) ؛

- يضاعف كل حالة مخفية بواسطة وظيفة تقييم تم تحويلها بواسطة softmax ، ومن ثم تسليط الضوء على الحالات المخفية مع تصنيف كبير وإحالة الحالات المخفية مع حالة صغيرة إلى الخلفية.

يتم تنفيذ "تمرين التقدير" هذا على مفكك التشفير في كل فترة زمنية.

لذلك ، لخص كل ما سبق ، فإننا نعتبر عملية النموذج مع آلية الاهتمام:

- في وحدة فك الترميز ، يتلقى RNN تضمين <END> الرمز المميز والحالة المخفية الأولية.

- يعالج RNN عنصر الإدخال ، ويقوم بإنشاء الإخراج ، ومتجه الحالة المخفية الجديد (h4). يتم تجاهل الإخراج.

- تستخدم آلية الانتباه الحالات المخفية للتشفير والمتجه h4 لحساب متجه السياق (C4) في فترة زمنية محددة.

- المتجهات h4 و C4 متسلسلة في متجه واحد.

- يتم تمرير هذا المتجه من خلال شبكة عصبية (FFN) feedforward ، المدربين مع النموذج.

- يشير إخراج شبكة FFN إلى كلمة الإخراج في فترة زمنية محددة.

- يتم تكرار الخوارزمية للفاصل الزمني التالي.

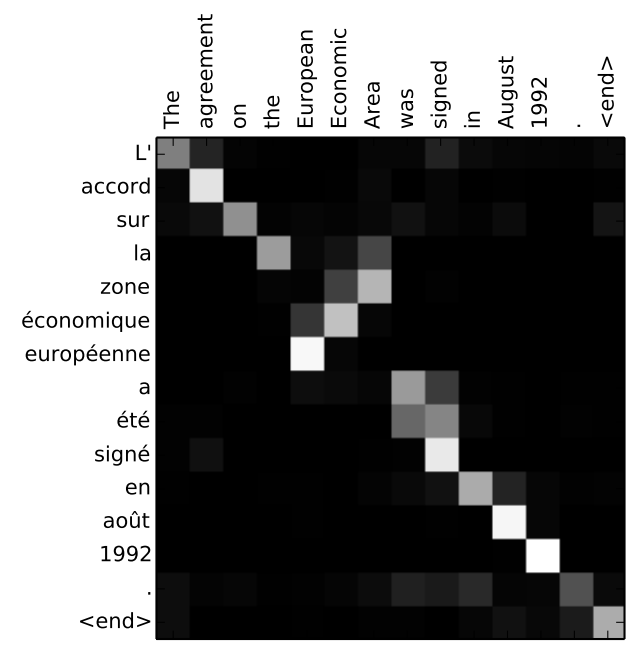

هناك طريقة أخرى لإلقاء نظرة على جزء الجملة الأصلية الذي يركز عليه النموذج في كل مرحلة من وحدات فك التشفير:

لاحظ أن النموذج لا يربط فقط الكلمة الأولى في الإدخال بالكلمة الأولى في الإخراج. لقد فهمت بالفعل أثناء عملية التدريب كيفية مطابقة الكلمات في هذا الزوج اللغوي المدروس (في حالتنا ، الفرنسية والإنجليزية). يمكن العثور على مثال عن مدى دقة هذه الآلية في المقالات في آلية الاهتمام المذكورة أعلاه.

إذا كنت تشعر بأنك مستعد لتعلم كيفية تطبيق هذا النموذج ، فراجع دليل الترجمة العصبية (seq2seq) على TensorFlow.

المؤلفون