Intel IoT Roadshow oder Virtual Reality in der realen Welt

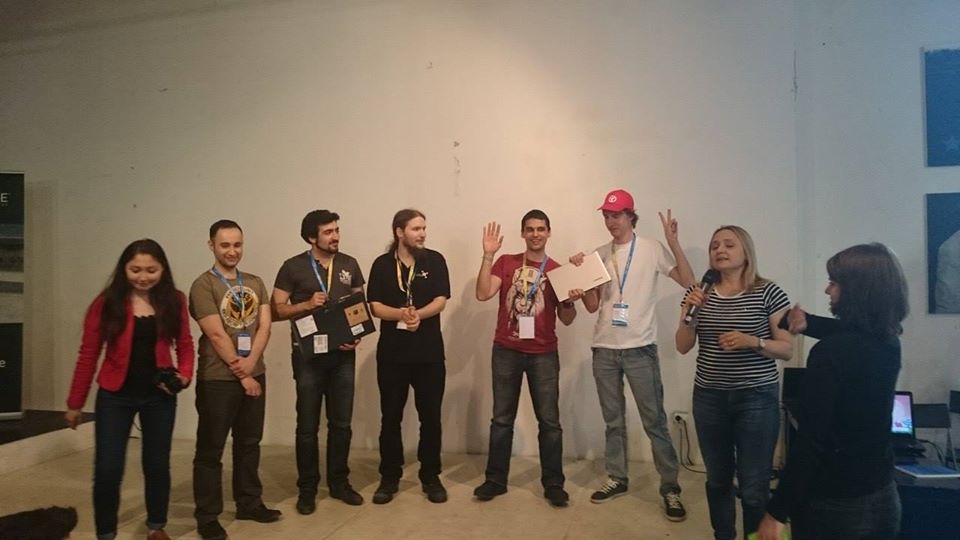

Vom 27. bis 28. Juni 2015 wurde von Intel ein Hackathon organisiert, bei dem das SenseDrive- Projekt den zweiten Platz belegte. Während der Präsentation blickte unser Team ein wenig in die Zukunft und zeigte, wie man die menschlichen Fähigkeiten erweitern kann, indem man in einen virtuellen Raum eintaucht, der mit dem Internet der Dinge verbunden ist.

Ein kleiner Hintergrund

Alles begann mit der DevCon 2015-Konferenz , auf der ich mich erstmals mit den Funktionen der RealSense-Technologie vertraut machte. Beim nächtlichen Hackathon hatte ich das Glück, die Funktionen der Kamera und des RealSense SDK zu bewerten. Mein erster Wunsch war es, die Kamera mit einer Virtual-Reality-Brille zu verbinden, um meine „virtuellen“ Hände zu sehen. Bei diesem Hackathon konnte ich jedoch keine freien Unity-Programmierer und 3D-Designer finden. In Zusammenarbeit mit einem Mann aus Vietnam haben wir es daher geschafft, das SDK und die Funktionen der Arbeit mit der Kamera gut genug zu studieren, um ein einfaches Programm zu demonstrieren, das Programmierern beim Aufladen der Augen hilft und sicherstellt, dass der Programmierer nicht „herumalbert“. Ich habe auch erfahren, dass es in einer Woche in St. Petersburg einen weiteren Hackathon mit dieser Technologie geben wird.Jetzt hatte ich also schon eine Woche Zeit, mich vorzubereiten. Ich war an meiner Idee von Kollege Dmitry Postilgu interessiert, der eine dreidimensionale Freisprechoberfläche für Windows Phone in Unity entwarf. Zu dieser Zeit entwickelte ich die Fähigkeit, Daten über die Position der Hände in einem Smartphone zu übertragen.Diese Aufgabe war nicht trivial, da RealSense einen sehr leistungsstarken Prozessor und USB 3.0 benötigt, die aus offensichtlichen Gründen in unserem Smartphone nicht vorhanden waren. Ich musste ein Plug-In für Unity schreiben, das einen Server auf dem Telefon und eine Client-Anwendung für den PC bereitstellt, die verarbeitete Datenpakete auf das Telefon überträgt. Dadurch konnten wir mehrere Kameras gleichzeitig an zukünftige virtuelle Brillen anschließen, um die Position der Hände genauer zu bestimmen.Das Ergebnis war eine ziemlich flexible Architektur, bei der es für Unity keinen merklichen Unterschied gab: ob die Daten von der Kamera direkt (für den Fall, dass die Anwendung auf einem PC bereitgestellt wird) oder über WLAN (für den Fall, dass die Anwendung auf einem Smartphone bereitgestellt wird) übertragen werden. Mit Blick auf die Zukunft war es diese Architektur, die uns während der Präsentation beim letzten Hackathon gerettet hat.Es stellte sich heraus, dass die Woche sehr kurz war, um Zeit für die Erstellung eines Prototyps virtueller Hände zu haben, da wir in unserer Freizeit von der Hauptarbeit an dem Projekt beteiligt waren. Sie schrieben das Projekt sogar nachts, während sie mit dem Zug von Minsk nach St. Petersburg fuhren. Damit haben wir den ersten Platz belegt .

Ebenfalls beim zweiten Hackathon erfuhr ich von der bevorstehenden Intel IoT Roadshow in einem Monat und traf Maxim Massalsky von Robot Kitchen- Minsker Labor für Robotik. Mit ihm haben wir beschlossen, endlich die virtuelle und die reale Welt zu vereinen.Um diese Fähigkeiten zu demonstrieren, baute Maxim einen Roboter mit einer sich bewegenden Kamera zusammen, die wir am Hackoton mit dem Intel Edison-Board verbanden. Maxim startete WiFi und sendete einen Videostream von der Kamera des Roboters an das Netzwerk. Wir haben ein System von Steuerbefehlen entwickelt und uns als Roboter herausgestellt, in den Sie sich aus der virtuellen Realität "hineinbewegen" können.Der Roboter sendet das, was er sieht, über die Videokamera: Der von Intel Edison gestartete Stream von der Kamera wird direkt in eine virtuelle Brille übertragen, und die virtuelle Realität überträgt die Position des Kopfes und des Befehls von den virtuellen „Steuerhebeln“ auf den Roboter. Es ist uns gelungen, einen „Präsenz-Effekt“ in der Brille des Benutzers in der Steuerkabine des Roboter-Avatars zu erzeugen. Gleichzeitig konnte der Benutzer nicht nur mit den Händen (ohne Maus, Tastatur oder Kabel) angeben, wohin der Roboter gehen soll, sondern auch den Kopf zur Seite drehen, während der Roboter gehorsam dasselbe durch Drehen seiner Kamera ausführte.Ein Roboter-Avatar ist natürlich großartig, aber es ist nicht ganz klar, was gut ist. Daher hat uns ein Roboter nicht gereicht. Noch vor dem Hackathon hatten wir eine kleine Brainstorming-Sitzung, um herauszufinden, wie wir der Jury den Nutzen der Technologie besser und klarer vermitteln können. Lange war es nicht nötig, Beispiele zu suchen, es gab viele davon (einige davon finden Sie in der Projektbeschreibung), aber innerhalb von 24 Stunden kann nicht viel getan werden, daher wurde entschieden, zwei Typen zu wählen:

Ebenfalls beim zweiten Hackathon erfuhr ich von der bevorstehenden Intel IoT Roadshow in einem Monat und traf Maxim Massalsky von Robot Kitchen- Minsker Labor für Robotik. Mit ihm haben wir beschlossen, endlich die virtuelle und die reale Welt zu vereinen.Um diese Fähigkeiten zu demonstrieren, baute Maxim einen Roboter mit einer sich bewegenden Kamera zusammen, die wir am Hackoton mit dem Intel Edison-Board verbanden. Maxim startete WiFi und sendete einen Videostream von der Kamera des Roboters an das Netzwerk. Wir haben ein System von Steuerbefehlen entwickelt und uns als Roboter herausgestellt, in den Sie sich aus der virtuellen Realität "hineinbewegen" können.Der Roboter sendet das, was er sieht, über die Videokamera: Der von Intel Edison gestartete Stream von der Kamera wird direkt in eine virtuelle Brille übertragen, und die virtuelle Realität überträgt die Position des Kopfes und des Befehls von den virtuellen „Steuerhebeln“ auf den Roboter. Es ist uns gelungen, einen „Präsenz-Effekt“ in der Brille des Benutzers in der Steuerkabine des Roboter-Avatars zu erzeugen. Gleichzeitig konnte der Benutzer nicht nur mit den Händen (ohne Maus, Tastatur oder Kabel) angeben, wohin der Roboter gehen soll, sondern auch den Kopf zur Seite drehen, während der Roboter gehorsam dasselbe durch Drehen seiner Kamera ausführte.Ein Roboter-Avatar ist natürlich großartig, aber es ist nicht ganz klar, was gut ist. Daher hat uns ein Roboter nicht gereicht. Noch vor dem Hackathon hatten wir eine kleine Brainstorming-Sitzung, um herauszufinden, wie wir der Jury den Nutzen der Technologie besser und klarer vermitteln können. Lange war es nicht nötig, Beispiele zu suchen, es gab viele davon (einige davon finden Sie in der Projektbeschreibung), aber innerhalb von 24 Stunden kann nicht viel getan werden, daher wurde entschieden, zwei Typen zu wählen:- Ausschalten eines Elektrogeräts (schließlich möchte niemand, dass sein Haus ausbrennt, weil das Bügeleisen oder der Ofen beim Einschalten in Eile angehalten wurden);

- . , , , :) , , … , - .

Der sparsame Maxim brachte mehrere Servos und Staffeln mit, der Rest war entschlossen, vor Ort nachzuschauen.Als Elektrogerät, das eine Wohnung verbrennen kann, haben wir einen Wasserkocher benutzt. Dabei half uns Evgeny Tkachevsky, ein Mann von Video Wings, der sich für unser Projekt interessierte und am Morgen des zweiten Tages einen Wasserkocher von zu Hause mitbrachte.Der Katzenfutterautomat wurde in einem Zug auf dem Weg nach St. Petersburg auf Papier entworfen, ein Computermodell wurde gezeichnet und auf einem 3D-Drucker gedruckt, sobald es ankam. Aber mit der Suche nach der Katze war alles komplizierter. Da sich in der Nähe des Veranstaltungsortes keine Katzen befanden, liehen wir uns einen Spielzeug-Teddybär von einem Intel-Experten aus. Ich muss sagen, dass das Projekt bereits in der Testphase großes Interesse geweckt hat. Trotzdem sieht man nicht jeden Tag einen Programmierer mit geschlossenen Augen in einer weißen Box, der seine Hände vor einem Laptop schwenkt und neben einem Roboter auf einem Ständer steht, Räder hin und her dreht und seinen Kopf schwenkt ... Einige Zuschauer hatten sogar das Glück, sich als Roboterfahrer zu testen.

Ich muss sagen, dass das Projekt bereits in der Testphase großes Interesse geweckt hat. Trotzdem sieht man nicht jeden Tag einen Programmierer mit geschlossenen Augen in einer weißen Box, der seine Hände vor einem Laptop schwenkt und neben einem Roboter auf einem Ständer steht, Räder hin und her dreht und seinen Kopf schwenkt ... Einige Zuschauer hatten sogar das Glück, sich als Roboterfahrer zu testen.

Präsentation

Leider war das Internet zum Zeitpunkt der Präsentation vollständig überlastet, es war nicht mehr möglich, über eine Datenübertragung über die Position der Hände zu sprechen, und noch mehr über die Übertragung von Streaming-Videos von der Kamera des Roboters. In den letzten Sekunden vor der Veröffentlichung wurde beschlossen, den Datenstrom so weit wie möglich zu entladen, wobei nur die Robotersteuerbefehle übrig blieben und die virtuelle Brille vollständig gelöst wurde. Wir mussten die PC-Version des Projekts demonstrieren, in der es unmöglich war, den Kopf zu drehen und mit den Augen eines Roboters zu sehen. Wir konnten den Roboter, die Teekanne und den Feeder nur mit Hilfe virtueller Hände steuern und über die Schulter die Bewegungen des Roboters beobachten, den Wasserkocher ausschalten und das Futter lief aus. Und schließlich haben wir für diejenigen, die es wünschen, angeboten, die Brille zu messen und uns zumindest für einen Moment in der virtuellen Welt zu fühlen.

Warum virtuelle Realität?

Leider aufgrund technischer Schwierigkeiten, waren wir nicht in der Lage die Hauptidee des Projekts zu vermitteln - wie ist die Steuerung aus der virtuellen Welt unterscheidet sich von einfach mit der Maus auf dem Bildschirm auf den Button klicken . Und alles ist wirklich einfach: Es ist bequemer für jemanden, mit der Maus zu klicken, jemanden, der einen Finger auf den Bildschirm steckt, jemanden, der in die Konsole schreibt. Die virtuelle Realität ermöglicht die Interaktion mit der realen Welt mithilfe von Aktionen und Gesten, die dem menschlichen Körper vertraut sind und die Sie ausführen können mehrere Handlungen gleichzeitig einer Person vertraut. In der aktuellen Implementierung können Sie beispielsweise den Roboter mit einer Hand gerade fahren lassen, mit der anderen leicht nach rechts drehen und den Kopf drehen, um zu sehen, was links passiert. Sicherlich mussten viele Autofahrer das Lenkrad mit einer Hand halten, mit der anderen telefonieren und regelmäßig zur Seite schauen, um festzustellen, ob sich in der Kurve ein klaffender Fußgänger befand. Hier ist es genauso. Nun, als Bonus in der virtuellen Welt kann eine Person wie Superhelden „jenseits aller Fähigkeiten“ sein. Um zum Beispiel von einem Roboter zu einem Wasserkocher oder einem Feeder zu wechseln, machte ich Pässe mit meinen Händen, was zur Bewegung dreidimensionaler Objekte in dieser Welt führte, wie der Jedi ... Es gab eine Idee, den Feuerball aus meiner Hand zu lösen und dadurch den Roboter auszuschalten, entschied aber, dass es zu viel war.Ist das nicht Freiheit? Bewegungsfreiheit, Gedankenfreiheit, Handlungsfreiheit, Freiheit der Fantasie ...Aber das ist noch nicht alles. Es ist für eine Person nicht immer bequem, ein komplexes Objekt allein zu steuern. Die aktuelle Projektimplementierung ermöglicht es mehreren Personen, mehrere Teile desselben Geräts gleichzeitig zu verwalten. Sie müssen für Beispiele nicht weit gehen. Zwei Benutzer können eine Verbindung zum Robotertank herstellen, einer steuert die Bewegung des Tanks auf der Oberfläche und der zweite dreht zu diesem Zeitpunkt den Turm des Tanks und hat Zugriff auf die Steuerung der Mündung. Stellen Sie sich vor, wie ein Panzerschlachtspiel mit seiner Implementierung aussehen würde ?!Aus produktionstechnischer Sicht muss jetzt nicht mehr viel Geld für die Herstellung geeigneter Tastaturen, Mäuse, Joysticks oder anderer Manipulatoren ausgegeben werden. Zeichnen Sie einfach ein Bedienfeld und laden Sie es in die virtuelle Welt. Und wie es aussehen wird, hängt nur von der Vorstellungskraft und den spezifischen Bedürfnissen ab.

In der aktuellen Implementierung können Sie beispielsweise den Roboter mit einer Hand gerade fahren lassen, mit der anderen leicht nach rechts drehen und den Kopf drehen, um zu sehen, was links passiert. Sicherlich mussten viele Autofahrer das Lenkrad mit einer Hand halten, mit der anderen telefonieren und regelmäßig zur Seite schauen, um festzustellen, ob sich in der Kurve ein klaffender Fußgänger befand. Hier ist es genauso. Nun, als Bonus in der virtuellen Welt kann eine Person wie Superhelden „jenseits aller Fähigkeiten“ sein. Um zum Beispiel von einem Roboter zu einem Wasserkocher oder einem Feeder zu wechseln, machte ich Pässe mit meinen Händen, was zur Bewegung dreidimensionaler Objekte in dieser Welt führte, wie der Jedi ... Es gab eine Idee, den Feuerball aus meiner Hand zu lösen und dadurch den Roboter auszuschalten, entschied aber, dass es zu viel war.Ist das nicht Freiheit? Bewegungsfreiheit, Gedankenfreiheit, Handlungsfreiheit, Freiheit der Fantasie ...Aber das ist noch nicht alles. Es ist für eine Person nicht immer bequem, ein komplexes Objekt allein zu steuern. Die aktuelle Projektimplementierung ermöglicht es mehreren Personen, mehrere Teile desselben Geräts gleichzeitig zu verwalten. Sie müssen für Beispiele nicht weit gehen. Zwei Benutzer können eine Verbindung zum Robotertank herstellen, einer steuert die Bewegung des Tanks auf der Oberfläche und der zweite dreht zu diesem Zeitpunkt den Turm des Tanks und hat Zugriff auf die Steuerung der Mündung. Stellen Sie sich vor, wie ein Panzerschlachtspiel mit seiner Implementierung aussehen würde ?!Aus produktionstechnischer Sicht muss jetzt nicht mehr viel Geld für die Herstellung geeigneter Tastaturen, Mäuse, Joysticks oder anderer Manipulatoren ausgegeben werden. Zeichnen Sie einfach ein Bedienfeld und laden Sie es in die virtuelle Welt. Und wie es aussehen wird, hängt nur von der Vorstellungskraft und den spezifischen Bedürfnissen ab.Was weiter?

Unser Ziel beim Hackathon war es, die Möglichkeiten aufzuzeigen, die die Symbiose aus Internet, Dingen, Robotern und virtueller Realität bietet. Jetzt sind wir in der Phase der Ausrichtung des Projekts und während sich folgende Bereiche abzeichnen:- Entwicklung eines Roboters, der gleichzeitig von mehreren Personen gesteuert wird, Prototyp eines Panzerroboters;

- Hinzufügen von Unterstützung für Android- und IOS-Plattformen im aktuellen Projekt;

- Entwicklung eines vollwertigen Roboter-Avatars, der in der Lage ist, Gegenstände aufzunehmen und ein Stereobild aus zwei Augen zu senden;

- Entwicklung eines vollständigen Protokolls und eines SDK für die Verbindung zum Internet der Dinge und zur virtuellen Realität. Dies ermöglicht jedem, der seine elektronischen Geräte einfach mit der virtuellen Realität verbinden möchte, und erweitert dadurch das Brillensortiment.

- Entwicklung Ihrer eigenen virtuellen Brille;

- Hinzufügen einer neuronalen Schnittstelle, die es Menschen ermöglicht, Dinge nicht nur mit Hilfe von Körperbewegungen, sondern auch durch die Kraft des Denkens zu steuern. Beim letzten Hackathon gab es mehrere Projekte, die eine ähnliche Schnittstelle verwendeten, und vielleicht können wir unsere Bemühungen zum Wohle der Menschheit kombinieren.

Source: https://habr.com/ru/post/de382109/

All Articles