Peak Computing vor Peak Oil?

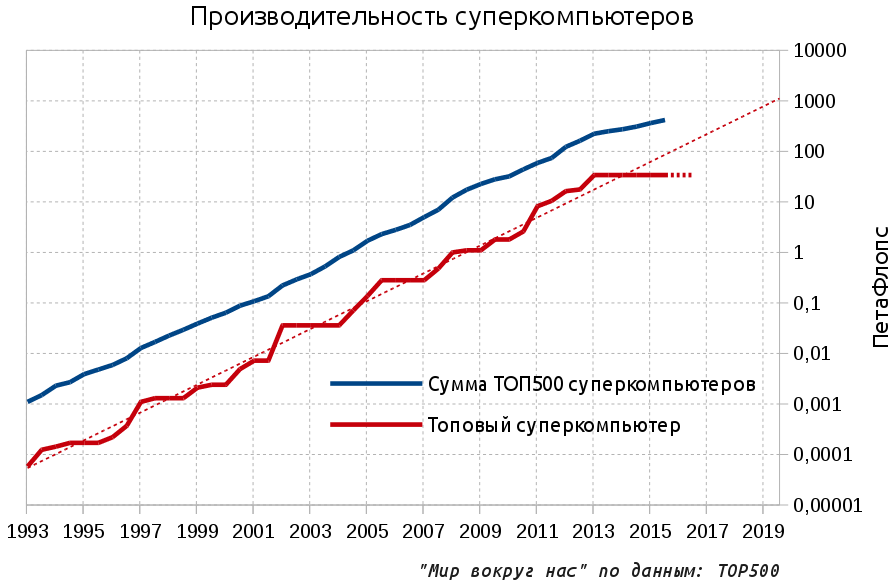

Heute werden wir das Genre von Cassandra ausprobieren, das in der Blogosphäre beliebt ist - negative Prophezeiungen. Es ist also „bekannt“, dass der Winter nahe ist, die Menschheit in allem an die Grenzen des Wachstums gestoßen ist und wir die letzten ruhigen Tage vor dem unvermeidlichen Einrollen in neue dunkle Jahrhunderte ausleben. Die letzte Quelle des Techno-Optimismus und das auffälligste Symbol des Fortschritts, das sich in den letzten 20 Jahren vielen stagnierenden Prozessen auf dem Planeten widersetzt hat, war die rasante Entwicklung der Mikroelektronik. Es ist an der Zeit, die Decken aus diesem Bereich abzureißen.Es scheint, dass der Fortschritt jetzt schneller als je zuvor ist und jeder Smartphone-Benutzer Sie über immer schnellere Prozessoren informiert, die in neuen Modellen erscheinen. Aber im hohen Norden kühlte es bereits gegen die Wand, die uns vor dem Rückgriff schützte. Wo die maximale Leistung der Mikroelektronik wirklich benötigt wird - im Bereich der Supercomputer an den fortschrittlichsten Grenzen - hat der Fortschritt aufgehört.Wie Sie der Grafik entnehmen können, ist die Leistung des Top-Supercomputers (ausgedrückt in Gleitkommaoperationen pro Sekunde - FLOPS) seit drei Jahren nicht mehr gestiegen. Wenn Sie sich die angekündigten Pläne ansehen, können Sie außerdem zuversichtlich sagen, dass sich die Situation zumindest im kommenden Jahr nicht ändern wird. Die Stagnation der Leistung des Top-Supercomputers wird sich also bis 2016 erstrecken: Gepunktete Linien geben den exponentiellen Entwicklungstrend und die Prognose für den Supercomputer der Spitzenklasse für 2016 an (Stagnation). Kurz zum Material: Im Artikel werden die Präfixe Pet und Axe verwendet. PetaFlops - 10 ^ 15 Operationen pro Sekunde und die notwendige und diskutierte tausendfache Zukunft - ExaFlops, 10 ^ 18.Um den exponentiellen Trend fortzusetzen, sollten Supercomputer 2019 die ExFlops-Skala erreichen, und jetzt sind von Aurora nur noch etwa 100 PetFlops für 2018 geplant. Aber was genau ist das Problem?Nach meiner Erfahrung können selbst viele professionelle Software- und Hardwareentwickler Ihnen nicht sagen, wie wichtig Supercomputer sind. In der modernen Welt, im Jahrhundert des allgegenwärtigen Internets, scheinen riesige Hallen voller Eisenregale, die der Verarbeitung einer komplexen Rechenaufgabe gewidmet sind, das Schicksal der romantischen Vergangenheit zu Beginn des Computerzeitalters der 1960er bis 70er Jahre zu sein. In der Tat reichen heutzutage die Ressourcen eines einzigen PCs aus, um viele komplexe Probleme zu lösen, und mit handelsüblichen Servern können Sie die Anforderungen großer Unternehmen erfüllen. Es gibt aber auch beliebte Cloud-Computing-Dienste, die Ihnen endlose Computerressourcen für eine bescheidene Belohnung versprechen.Tatsächlich sind Supercomputer das einzige, was der heutigen siebenmilliardsten Menschheit die Möglichkeit gibt, sich weiterzuentwickeln und ohne Angst vor dem malthusianischen Fluch zu leben.Alle fortgeschrittenen Aufgaben können nur mit Hilfe einer sehr großen Rechenleistung und eines Supercomputers gelöst werden, bei dem alle Komponenten der Computertechnologie so weit wie möglich optimiert sind. Dies ist das am besten geeignete Werkzeug zur Lösung dieser Probleme. Darüber hinaus kann die direkte Computersimulation neben der theoretischen und experimentellen Forschung als dritte wissenschaftliche Erkenntnismethode interpretiert werden. Um nicht unbegründet zu sein, geben wir einige Beispiele.Über Mutteröl, das ohne leistungsstarke Computer lange Zeit kaum zu finden war, haben wir bereits geschriebenund die Schlussfolgerung war kategorisch: am Morgen ein Supercomputer im Abendöl, am Abend ein Supercomputer im Morgenöl. Sehen wir uns andere Themen an.LuftfahrtBei der Entwicklung neuer Flugzeuge hat die Computersimulation die Anzahl der physikalischen Tests in einem Windkanal von 77 Einheiten im Jahr 1979 auf 11 im Jahr 1995 reduziert, und seitdem ist der Wert auf dem gleichen Niveau geblieben. Etwas aus diesem Grund, unsere Flugzeuge und blieben ungefähr gleich, wo sie waren. Der Übergang zu einer grundlegend genaueren physikalischen Simulation, die auf der direkten Anwendung der Navier-Stokes-Gleichungen basiert, erfordert Rechenfähigkeiten in der Größenordnung von 50 Exaflops, dh 1000-mal mehr als der derzeitige Marktführer - der chinesische Tianhe-2 von 33 PetaFlops. Gleichzeitig ist die Berechnung der externen Aerodynamik noch relativ einfach. Beispielsweise besteht ein typischer Motor aus Tausenden von beweglichen Teilen, und die Modellierung interner Strömungen erfordert eine noch höhere Rechenleistung.

Gepunktete Linien geben den exponentiellen Entwicklungstrend und die Prognose für den Supercomputer der Spitzenklasse für 2016 an (Stagnation). Kurz zum Material: Im Artikel werden die Präfixe Pet und Axe verwendet. PetaFlops - 10 ^ 15 Operationen pro Sekunde und die notwendige und diskutierte tausendfache Zukunft - ExaFlops, 10 ^ 18.Um den exponentiellen Trend fortzusetzen, sollten Supercomputer 2019 die ExFlops-Skala erreichen, und jetzt sind von Aurora nur noch etwa 100 PetFlops für 2018 geplant. Aber was genau ist das Problem?Nach meiner Erfahrung können selbst viele professionelle Software- und Hardwareentwickler Ihnen nicht sagen, wie wichtig Supercomputer sind. In der modernen Welt, im Jahrhundert des allgegenwärtigen Internets, scheinen riesige Hallen voller Eisenregale, die der Verarbeitung einer komplexen Rechenaufgabe gewidmet sind, das Schicksal der romantischen Vergangenheit zu Beginn des Computerzeitalters der 1960er bis 70er Jahre zu sein. In der Tat reichen heutzutage die Ressourcen eines einzigen PCs aus, um viele komplexe Probleme zu lösen, und mit handelsüblichen Servern können Sie die Anforderungen großer Unternehmen erfüllen. Es gibt aber auch beliebte Cloud-Computing-Dienste, die Ihnen endlose Computerressourcen für eine bescheidene Belohnung versprechen.Tatsächlich sind Supercomputer das einzige, was der heutigen siebenmilliardsten Menschheit die Möglichkeit gibt, sich weiterzuentwickeln und ohne Angst vor dem malthusianischen Fluch zu leben.Alle fortgeschrittenen Aufgaben können nur mit Hilfe einer sehr großen Rechenleistung und eines Supercomputers gelöst werden, bei dem alle Komponenten der Computertechnologie so weit wie möglich optimiert sind. Dies ist das am besten geeignete Werkzeug zur Lösung dieser Probleme. Darüber hinaus kann die direkte Computersimulation neben der theoretischen und experimentellen Forschung als dritte wissenschaftliche Erkenntnismethode interpretiert werden. Um nicht unbegründet zu sein, geben wir einige Beispiele.Über Mutteröl, das ohne leistungsstarke Computer lange Zeit kaum zu finden war, haben wir bereits geschriebenund die Schlussfolgerung war kategorisch: am Morgen ein Supercomputer im Abendöl, am Abend ein Supercomputer im Morgenöl. Sehen wir uns andere Themen an.LuftfahrtBei der Entwicklung neuer Flugzeuge hat die Computersimulation die Anzahl der physikalischen Tests in einem Windkanal von 77 Einheiten im Jahr 1979 auf 11 im Jahr 1995 reduziert, und seitdem ist der Wert auf dem gleichen Niveau geblieben. Etwas aus diesem Grund, unsere Flugzeuge und blieben ungefähr gleich, wo sie waren. Der Übergang zu einer grundlegend genaueren physikalischen Simulation, die auf der direkten Anwendung der Navier-Stokes-Gleichungen basiert, erfordert Rechenfähigkeiten in der Größenordnung von 50 Exaflops, dh 1000-mal mehr als der derzeitige Marktführer - der chinesische Tianhe-2 von 33 PetaFlops. Gleichzeitig ist die Berechnung der externen Aerodynamik noch relativ einfach. Beispielsweise besteht ein typischer Motor aus Tausenden von beweglichen Teilen, und die Modellierung interner Strömungen erfordert eine noch höhere Rechenleistung. Computergestützte Hydrodynamik für Turbinenschaufeln (links) und das X-43-Flugzeug mit einer Machzahl = 7Thermonukleare EnergieAuf dem Gebiet der thermonuklearen Physik, die interessanterweise von einem Kollegen von tnenergy geschrieben wurdeDas Design der nächsten Generation von Tokamaks ist ohne Fortschritte bei der Modellierung von Hochtemperaturplasma in einer Magnetfalle nicht möglich. Bereits mehrere Milliarden Teilchen im Weltraum mit einer Auflösung von 131 Millionen Punkten sind an den Modellen beteiligt. Für solche Skalen werden die leistungsstärksten PetFlops-Ordnungssysteme verwendet und gute Ergebnisse erzielt. Es ist jedoch klar, dass eine ausreichende Genauigkeit der vollständigen Simulation nach Grundprinzipien auf bescheidene 13 Millionen Mal skaliert werden muss.

Computergestützte Hydrodynamik für Turbinenschaufeln (links) und das X-43-Flugzeug mit einer Machzahl = 7Thermonukleare EnergieAuf dem Gebiet der thermonuklearen Physik, die interessanterweise von einem Kollegen von tnenergy geschrieben wurdeDas Design der nächsten Generation von Tokamaks ist ohne Fortschritte bei der Modellierung von Hochtemperaturplasma in einer Magnetfalle nicht möglich. Bereits mehrere Milliarden Teilchen im Weltraum mit einer Auflösung von 131 Millionen Punkten sind an den Modellen beteiligt. Für solche Skalen werden die leistungsstärksten PetFlops-Ordnungssysteme verwendet und gute Ergebnisse erzielt. Es ist jedoch klar, dass eine ausreichende Genauigkeit der vollständigen Simulation nach Grundprinzipien auf bescheidene 13 Millionen Mal skaliert werden muss. Modellierung des Plasmaverhaltens in einem TokamakKlima und WetterKlimamodelle und genaue Wettervorhersagen ermöglichen es uns, unsere Aktionen optimal zu planen - die Genauigkeit von Vorhersagen wächst mit dem Wachstum der Supercomputerleistung. In Zukunft wird es möglich sein, Niederschläge und dementsprechend Überschwemmungen und Schlammströme vorherzusagen. Dürre und Ernteausfall.

Modellierung des Plasmaverhaltens in einem TokamakKlima und WetterKlimamodelle und genaue Wettervorhersagen ermöglichen es uns, unsere Aktionen optimal zu planen - die Genauigkeit von Vorhersagen wächst mit dem Wachstum der Supercomputerleistung. In Zukunft wird es möglich sein, Niederschläge und dementsprechend Überschwemmungen und Schlammströme vorherzusagen. Dürre und Ernteausfall. Heute ist eine 4-Tage-Wettervorhersage genauso genau wie eine Ein-Tage-Wettervorhersage von 1980Zunehmend genaue Vorhersagen erfordern ein detaillierteres Modell im Planetenmaßstab, und eine konstante Abnahme der Simulationszelle ist erforderlich. Derzeit haben Modellzellen für kurzfristige regionale Vorhersagen Abmessungen von 10 x 10 km, und langfristige Klimamodelle verwenden ein Raster mit Zellen von Hunderten von km, während eine Skala von 1 x 1 km auf der Oberfläche (10.000-mal größer als jetzt) und 100 m vertikal erforderlich ist. Ja, mit einer Periodisierung von 1 Sekunde, was für zwei Monate 5 Millionen Sekunden bedeutet.Ein Beispiel für ein modernes Modell mit einer Zelle von 300 x 300 km.

Heute ist eine 4-Tage-Wettervorhersage genauso genau wie eine Ein-Tage-Wettervorhersage von 1980Zunehmend genaue Vorhersagen erfordern ein detaillierteres Modell im Planetenmaßstab, und eine konstante Abnahme der Simulationszelle ist erforderlich. Derzeit haben Modellzellen für kurzfristige regionale Vorhersagen Abmessungen von 10 x 10 km, und langfristige Klimamodelle verwenden ein Raster mit Zellen von Hunderten von km, während eine Skala von 1 x 1 km auf der Oberfläche (10.000-mal größer als jetzt) und 100 m vertikal erforderlich ist. Ja, mit einer Periodisierung von 1 Sekunde, was für zwei Monate 5 Millionen Sekunden bedeutet.Ein Beispiel für ein modernes Modell mit einer Zelle von 300 x 300 km. Medizin und Biologie.Medizin ist keine Ausnahme. Heutzutage können Supercomputer der Spitzenklasse nur einzelne ultrakleine Teile von Zellen simulieren:

Medizin und Biologie.Medizin ist keine Ausnahme. Heutzutage können Supercomputer der Spitzenklasse nur einzelne ultrakleine Teile von Zellen simulieren: In der Abbildung ist das Ergebnis der Modellierung des Betriebs von Ionenkanälen in der Zellmembran auf Top-End-Supercomputern - und nur etwa 100.000 Moleküle sind beteiligt. Darüber hinaus beträgt die Gesamtzahl der Moleküle in einer menschlichen Zelle Milliarden, und die Zellen selbst sind fast Billiarden (10 ^ 14). Der Prozess, neue Medikamente zu erhalten und auf den Markt zu bringen, dauert 5 bis 15 Jahre. Jetzt wird über neue Konzepte im Drag-Design gesprochen. Stellen Sie sich vor, wie viel Sie den Prozess beschleunigen und die Wirksamkeit von Arzneimitteln steigern können, wenn Sie die Situation umfassend modellieren - ausgehend von der Pathogen-DNA, die tatsächlich alle Informationen darüber enthält und mit dem Modell des menschlichen Körpers endet, unter Berücksichtigung individueller genetischer Merkmale.Die reale Liste ist viel, viel größer: die Suche nach grundlegend neuen Materialien mit gewünschten Eigenschaften, Astrophysik, Kernenergie und vielem mehr.AusstellerbuchhaltungDie Frage stellt sich: Wenn die Vorteile so groß sind, warum investieren wir dann nicht wirklich viel Geld in leistungsstarke Supercomputer? Tatsache ist, dass es bisher einen Exponenten auf unserer Seite gab, nämlich den Moore-Exponenten - die Dichte der Transistoren verdoppelt sich alle 18 bis 24 Monate, und bis vor kurzem bedeutete dies, dass sich auch die Produktivität verdoppelte.Daher wurden Schüler von Spielern von der ständigen Frage gequält: "Muss ich heute einen Computer für 2000 Dollar kaufen oder etwas Einfacheres für 1000 Dollar nehmen?" In der Tat wird es für die verbleibenden 1000 US-Dollar in drei bis vier Jahren möglich sein, einen Computer zu kaufen, der ein paar Mal leistungsstärker ist. Dies ist nicht überraschend, da eine lineare Funktion immer exponentiell verliert und die Kostenmultiplikation bestenfalls die gleiche lineare Multiplikation der Leistung anstelle einer Potenzgesetzabhängigkeit im Fall eines Exponenten ergibt. In der Regel war das Budget der Studenten nicht aus Gummi und die Wahl fiel auf die zweite Option, aber manchmal wollten sie sich engagieren, sie entschieden sich für die Spread-Option und nach ein paar Jahren sahen sie diesen alten Müll böse an.Ein ähnlicher Prozess, jedoch in einem viel ernsteren Umfeld, fand während der Diskussionen über neue Supercomputer statt. In den meisten Fällen wurde ein moderaterer, aber produktiverer Weg gewählt. Es ist bezeichnend, dass in den letzten 20 Jahren nur drei Computer mehr als 300 Millionen US-Dollar gekostet haben und alle drei außerhalb der USA gebaut wurden: zwei in Japan und einer heute in China, in Ländern mit Anspruch auf weltweite Führungsrolle. Zusätzlich zu den tatsächlichen Vorteilen ist es in der Tat eine Frage des Nationalstolzes, die Existenz einer nationalen fortgeschrittenen Wissenschaft zu beweisen, einen eigenen Supercomputer in der ersten Zeile der Bewertung zu haben.Das Ende des AusstellersVon Jahr zu Jahr hört man Ausrufe, dass Moores Gesetz kurz vor dem Ende steht und es sich bisher anscheinend nur um Horrorgeschichten handelt. Aber wenn Sie möchten, können Sie bereits die einzelnen Reiter der Apokalypse erkennen:

In der Abbildung ist das Ergebnis der Modellierung des Betriebs von Ionenkanälen in der Zellmembran auf Top-End-Supercomputern - und nur etwa 100.000 Moleküle sind beteiligt. Darüber hinaus beträgt die Gesamtzahl der Moleküle in einer menschlichen Zelle Milliarden, und die Zellen selbst sind fast Billiarden (10 ^ 14). Der Prozess, neue Medikamente zu erhalten und auf den Markt zu bringen, dauert 5 bis 15 Jahre. Jetzt wird über neue Konzepte im Drag-Design gesprochen. Stellen Sie sich vor, wie viel Sie den Prozess beschleunigen und die Wirksamkeit von Arzneimitteln steigern können, wenn Sie die Situation umfassend modellieren - ausgehend von der Pathogen-DNA, die tatsächlich alle Informationen darüber enthält und mit dem Modell des menschlichen Körpers endet, unter Berücksichtigung individueller genetischer Merkmale.Die reale Liste ist viel, viel größer: die Suche nach grundlegend neuen Materialien mit gewünschten Eigenschaften, Astrophysik, Kernenergie und vielem mehr.AusstellerbuchhaltungDie Frage stellt sich: Wenn die Vorteile so groß sind, warum investieren wir dann nicht wirklich viel Geld in leistungsstarke Supercomputer? Tatsache ist, dass es bisher einen Exponenten auf unserer Seite gab, nämlich den Moore-Exponenten - die Dichte der Transistoren verdoppelt sich alle 18 bis 24 Monate, und bis vor kurzem bedeutete dies, dass sich auch die Produktivität verdoppelte.Daher wurden Schüler von Spielern von der ständigen Frage gequält: "Muss ich heute einen Computer für 2000 Dollar kaufen oder etwas Einfacheres für 1000 Dollar nehmen?" In der Tat wird es für die verbleibenden 1000 US-Dollar in drei bis vier Jahren möglich sein, einen Computer zu kaufen, der ein paar Mal leistungsstärker ist. Dies ist nicht überraschend, da eine lineare Funktion immer exponentiell verliert und die Kostenmultiplikation bestenfalls die gleiche lineare Multiplikation der Leistung anstelle einer Potenzgesetzabhängigkeit im Fall eines Exponenten ergibt. In der Regel war das Budget der Studenten nicht aus Gummi und die Wahl fiel auf die zweite Option, aber manchmal wollten sie sich engagieren, sie entschieden sich für die Spread-Option und nach ein paar Jahren sahen sie diesen alten Müll böse an.Ein ähnlicher Prozess, jedoch in einem viel ernsteren Umfeld, fand während der Diskussionen über neue Supercomputer statt. In den meisten Fällen wurde ein moderaterer, aber produktiverer Weg gewählt. Es ist bezeichnend, dass in den letzten 20 Jahren nur drei Computer mehr als 300 Millionen US-Dollar gekostet haben und alle drei außerhalb der USA gebaut wurden: zwei in Japan und einer heute in China, in Ländern mit Anspruch auf weltweite Führungsrolle. Zusätzlich zu den tatsächlichen Vorteilen ist es in der Tat eine Frage des Nationalstolzes, die Existenz einer nationalen fortgeschrittenen Wissenschaft zu beweisen, einen eigenen Supercomputer in der ersten Zeile der Bewertung zu haben.Das Ende des AusstellersVon Jahr zu Jahr hört man Ausrufe, dass Moores Gesetz kurz vor dem Ende steht und es sich bisher anscheinend nur um Horrorgeschichten handelt. Aber wenn Sie möchten, können Sie bereits die einzelnen Reiter der Apokalypse erkennen: Oben sind fünf Trends für verschiedene Mikroprozessorspezifikationen aufgeführt. Moores Gesetz scheint fortzufahren: Orange gibt die Anzahl der Transistoren pro Flächeneinheit an, wobei sich alle 18 bis 24 Monate eine Verdoppelung ergibt. Seit 2005 ist der Parameter 100-mal gewachsen, aber es macht nicht so viel Freude - die Leistung eines Kerns ist blau markiert und das Wachstum im gleichen Zeitraum beträgt bereits weniger als das 10-fache. Der Rest der Transistoren erhöhte die Anzahl der Kerne, die parallele Verarbeitungsaufgaben ermöglichen (schwarz).Im Jahr 2005 war es möglich, einen Prozessor mit einer Taktrate von 3,8 GHz zu kaufen, aber jetzt Intel-Prozessor mit einer Taktfrequenz über 4 GHz nicht zu kaufen. Dies bezieht sich direkt auf die Grafik: Die Prozessorfrequenz, die zuvor für die Hälfte des Produktivitätswachstums verantwortlich war, hat sich seit 2004 nicht wesentlich geändert (grün), ebenso wie der Energieverbrauch (rot), der auf der Möglichkeit der Wärmeableitung beruhte.Diese Trends sind in der Architektur von Supercomputern absolut symmetrisch. Wenn wir den heutigen chinesischen Meister nehmen, sehen wir einen der höchsten Energieverbrauchsindikatoren (18 MW), eine große Anzahl von Rechenkernen und sogar eine Regression zum Preis von PetaFlops. All dies ermöglichte es, einen Supercomputer zu bauen, der nur doppelt so produktiv war wie der vorherige Konkurrent.Lehnen Sie den bürgerlichen Exponenten für die kommunistische Linie ab!

Oben sind fünf Trends für verschiedene Mikroprozessorspezifikationen aufgeführt. Moores Gesetz scheint fortzufahren: Orange gibt die Anzahl der Transistoren pro Flächeneinheit an, wobei sich alle 18 bis 24 Monate eine Verdoppelung ergibt. Seit 2005 ist der Parameter 100-mal gewachsen, aber es macht nicht so viel Freude - die Leistung eines Kerns ist blau markiert und das Wachstum im gleichen Zeitraum beträgt bereits weniger als das 10-fache. Der Rest der Transistoren erhöhte die Anzahl der Kerne, die parallele Verarbeitungsaufgaben ermöglichen (schwarz).Im Jahr 2005 war es möglich, einen Prozessor mit einer Taktrate von 3,8 GHz zu kaufen, aber jetzt Intel-Prozessor mit einer Taktfrequenz über 4 GHz nicht zu kaufen. Dies bezieht sich direkt auf die Grafik: Die Prozessorfrequenz, die zuvor für die Hälfte des Produktivitätswachstums verantwortlich war, hat sich seit 2004 nicht wesentlich geändert (grün), ebenso wie der Energieverbrauch (rot), der auf der Möglichkeit der Wärmeableitung beruhte.Diese Trends sind in der Architektur von Supercomputern absolut symmetrisch. Wenn wir den heutigen chinesischen Meister nehmen, sehen wir einen der höchsten Energieverbrauchsindikatoren (18 MW), eine große Anzahl von Rechenkernen und sogar eine Regression zum Preis von PetaFlops. All dies ermöglichte es, einen Supercomputer zu bauen, der nur doppelt so produktiv war wie der vorherige Konkurrent.Lehnen Sie den bürgerlichen Exponenten für die kommunistische Linie ab! Chinesische kybernetische Truppen entfernen Lesezeichen von Intel Xeon-Prozessoren.Wenn Computer so wichtig sind, warum nicht einfach den chinesischen Weg fortsetzen und den Supercomputer größer und dann noch größer machen? Sie müssen verstehen, dass jede Steigerung der Produktivität aufgrund einer linearen Erhöhung des Maßstabs nicht nur eine Erhöhung des Dollarpreises ist, sondern auch dieselbe lineare Erhöhung des Energieverbrauchs. Wenn Sie ein chinesisches Monster mit drei Millionen Kernen nehmen und versuchen, es von PetaFlops der Stufe 33 auf ExaFlops der Stufe 30 zu skalieren, müssen Sie zwei Dutzend brandneue Kernreaktoren für die ausschließliche Verwendung reservieren. Dies entspricht allen Reaktoren, die derzeit in China gebaut werden. Wenn es immer noch möglich ist, den Riemen zum Ziehen irgendwie festzuziehen, ist das Niveau von 30 ZettaFlops mit seinen 20'000 Reaktoren für immer für uns geschlossen.Gibt es einen Ausweg?Ist es möglich, den Aussteller fortzusetzen? Für die kommenden Jahre - ja, noch möglich. In zwei bis drei Jahren werden Supercomputer etwa dreimal so leistungsstark sein wie die chinesischen Top-End-Computer und die besten Parameter für Energieverbrauch und PetAflops-Kosten aufweisen. Und was wird als nächstes passieren?Persönlich weiß ich es nicht genau, aber Experten sind nicht sehr optimistisch. Beispielsweise besuchte ein Microsoft-Direktor Ende Oktober ein offizielles Forum zur Entwicklung des zukünftigen ExFlops-Systems in den USA. An dem Forum nahmen alle führenden Eisenhersteller sowie Vertreter verschiedener staatlicher Behörden teil, die Supercomputer entwickelten und verwendeten.Um es zu zitieren :Es ist für alle Forumsteilnehmer offensichtlich: Die

Chinesische kybernetische Truppen entfernen Lesezeichen von Intel Xeon-Prozessoren.Wenn Computer so wichtig sind, warum nicht einfach den chinesischen Weg fortsetzen und den Supercomputer größer und dann noch größer machen? Sie müssen verstehen, dass jede Steigerung der Produktivität aufgrund einer linearen Erhöhung des Maßstabs nicht nur eine Erhöhung des Dollarpreises ist, sondern auch dieselbe lineare Erhöhung des Energieverbrauchs. Wenn Sie ein chinesisches Monster mit drei Millionen Kernen nehmen und versuchen, es von PetaFlops der Stufe 33 auf ExaFlops der Stufe 30 zu skalieren, müssen Sie zwei Dutzend brandneue Kernreaktoren für die ausschließliche Verwendung reservieren. Dies entspricht allen Reaktoren, die derzeit in China gebaut werden. Wenn es immer noch möglich ist, den Riemen zum Ziehen irgendwie festzuziehen, ist das Niveau von 30 ZettaFlops mit seinen 20'000 Reaktoren für immer für uns geschlossen.Gibt es einen Ausweg?Ist es möglich, den Aussteller fortzusetzen? Für die kommenden Jahre - ja, noch möglich. In zwei bis drei Jahren werden Supercomputer etwa dreimal so leistungsstark sein wie die chinesischen Top-End-Computer und die besten Parameter für Energieverbrauch und PetAflops-Kosten aufweisen. Und was wird als nächstes passieren?Persönlich weiß ich es nicht genau, aber Experten sind nicht sehr optimistisch. Beispielsweise besuchte ein Microsoft-Direktor Ende Oktober ein offizielles Forum zur Entwicklung des zukünftigen ExFlops-Systems in den USA. An dem Forum nahmen alle führenden Eisenhersteller sowie Vertreter verschiedener staatlicher Behörden teil, die Supercomputer entwickelten und verwendeten.Um es zu zitieren :Es ist für alle Forumsteilnehmer offensichtlich: Die

moderne Mikroelektronik auf Basis der CMOS-Technologie nähert sich dem Ende ihrer Möglichkeiten.

Es gibt keine alternative Technologie, die in den nächsten zehn Jahren verfügbar sein wird.Einfach ausgedrückt, in den nächsten 10 Jahren wird das bestehende Paradigma enden, und wir haben kein anderes Paradigma für Sie . Source: https://habr.com/ru/post/de387109/

All Articles