Die Entwicklung von Grafikkarten in den 2000er Jahren

Fortsetzung der Geschichte der Entwicklung von Grafikkarten aus den vorherigen Artikeln - Videoadaptern der 2000er Jahre.VSA-100 und die neue Generation von Voodoo

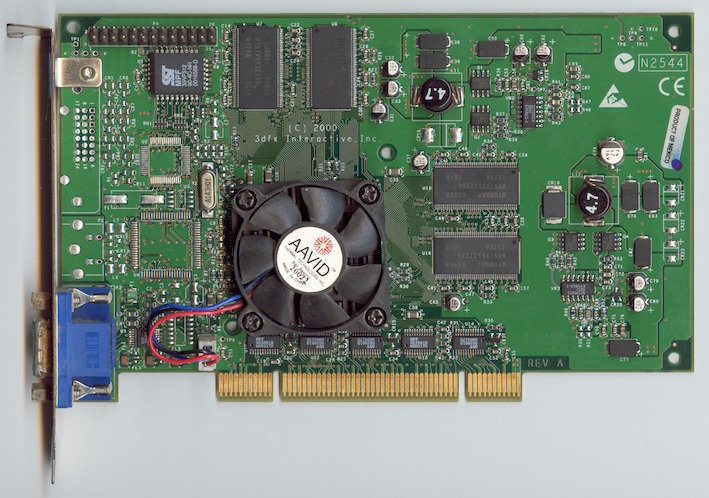

Der VSA-100-Chipsatz (Voodoo Scalable Architecture - Voodoo Scalable Architecture) wurde im Juni 2000 von 3dfx veröffentlicht. Die erste Grafikkarte, die diesen Chip (VSA-100x2) verwendete, war der Voodoo5 5500. Hergestellt unter Verwendung einer 250-nm-Prozesstechnologie mit 14 Millionen Transistoren. Der SDRAM-Speicher erreichte 64 MB mit einem 128-Bit-Bus. Die Frequenz der GPU und des Speichers betrug 166 MHz. Zum ersten Mal unterstützten Voodoo-Grafikkarten 32-Bit-Farben in 3D sowie Texturen mit einer hohen Auflösung von 2048 x 2048 Pixel. Zur Komprimierung wurden die Algorithmen FXT1 und DXTC verwendet. Ein Merkmal des Voodoo5 5500 war seine hohe Leistung bei der Verwendung von Anti-Aliasing.Die Grafikkarte wurde mit verschiedenen Schnittstellen wie AGP, PCI usw. hergestellt. Eine Version für den Macintosh war ebenfalls erhältlich, die über zwei Anschlüsse (DVI und VGA) verfügt.

Der VSA-100-Chipsatz (Voodoo Scalable Architecture - Voodoo Scalable Architecture) wurde im Juni 2000 von 3dfx veröffentlicht. Die erste Grafikkarte, die diesen Chip (VSA-100x2) verwendete, war der Voodoo5 5500. Hergestellt unter Verwendung einer 250-nm-Prozesstechnologie mit 14 Millionen Transistoren. Der SDRAM-Speicher erreichte 64 MB mit einem 128-Bit-Bus. Die Frequenz der GPU und des Speichers betrug 166 MHz. Zum ersten Mal unterstützten Voodoo-Grafikkarten 32-Bit-Farben in 3D sowie Texturen mit einer hohen Auflösung von 2048 x 2048 Pixel. Zur Komprimierung wurden die Algorithmen FXT1 und DXTC verwendet. Ein Merkmal des Voodoo5 5500 war seine hohe Leistung bei der Verwendung von Anti-Aliasing.Die Grafikkarte wurde mit verschiedenen Schnittstellen wie AGP, PCI usw. hergestellt. Eine Version für den Macintosh war ebenfalls erhältlich, die über zwei Anschlüsse (DVI und VGA) verfügt. Im Herbst desselben Jahres brachte 3dfx den Voodoo4 4500 mit 32 MB Speicher und einem VSA-100-Chip auf den Markt. Das Modell erwies sich als ziemlich langsam und dem GeForce 2 MX und Radeon SDR deutlich unterlegen.Das Unternehmen 3Dfx kündigte die Veröffentlichung einer produktiven Voodoo5 6000-Grafikkarte mit 4 VSA-100-Chips und 128 MB Speicher an. Es war jedoch nicht möglich, das Projekt endgültig umzusetzen - schwerwiegende finanzielle Schwierigkeiten machten 3Dfx bankrott.

Im Herbst desselben Jahres brachte 3dfx den Voodoo4 4500 mit 32 MB Speicher und einem VSA-100-Chip auf den Markt. Das Modell erwies sich als ziemlich langsam und dem GeForce 2 MX und Radeon SDR deutlich unterlegen.Das Unternehmen 3Dfx kündigte die Veröffentlichung einer produktiven Voodoo5 6000-Grafikkarte mit 4 VSA-100-Chips und 128 MB Speicher an. Es war jedoch nicht möglich, das Projekt endgültig umzusetzen - schwerwiegende finanzielle Schwierigkeiten machten 3Dfx bankrott.GeForce 2

In den Jahren 2000-2001 veröffentlichte NVIDIA eine Reihe von GeForce 2-Grafikkarten (GTS, Ultra, Pro, MX usw.). Diese Videoadapter hatten einen 256-Bit-Kern - einen der produktivsten Kerne der Zeit.Das Basismodell ist die GeForce 2 GTS (GigaTexel Shading) mit dem Codenamen NV15. Diese Grafikkarte wurde unter Verwendung einer 180-nm-Prozesstechnologie hergestellt und enthielt 25 Millionen Transistoren. Der DDR-SGRAM-Speicher war 32 MB oder 64 MB mit einer Frequenz von 200 MHz und einem 128-Bit-Bus. Der Adapter hatte 4-Pixel-Pipelines. NV15 bot volle Unterstützung für DirectX 7, OpenGL 1.2 sowie Hardware-Verarbeitung von Geometrie und Beleuchtung (T & L).

In den Jahren 2000-2001 veröffentlichte NVIDIA eine Reihe von GeForce 2-Grafikkarten (GTS, Ultra, Pro, MX usw.). Diese Videoadapter hatten einen 256-Bit-Kern - einen der produktivsten Kerne der Zeit.Das Basismodell ist die GeForce 2 GTS (GigaTexel Shading) mit dem Codenamen NV15. Diese Grafikkarte wurde unter Verwendung einer 180-nm-Prozesstechnologie hergestellt und enthielt 25 Millionen Transistoren. Der DDR-SGRAM-Speicher war 32 MB oder 64 MB mit einer Frequenz von 200 MHz und einem 128-Bit-Bus. Der Adapter hatte 4-Pixel-Pipelines. NV15 bot volle Unterstützung für DirectX 7, OpenGL 1.2 sowie Hardware-Verarbeitung von Geometrie und Beleuchtung (T & L).Radeon DDR und SDR

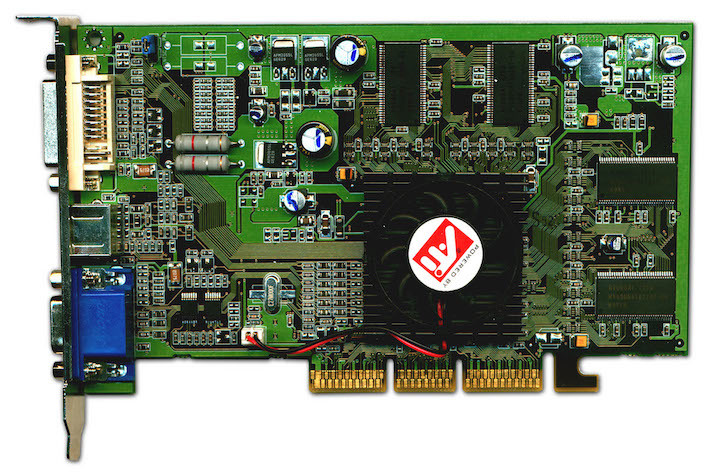

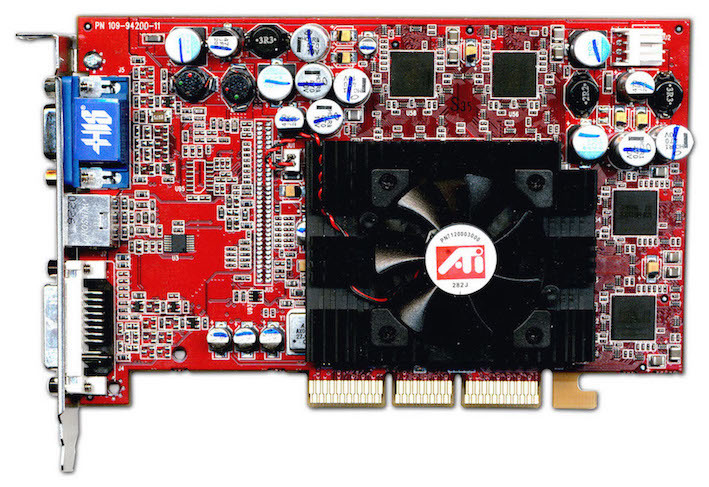

ATI hielt mit dem Fortschritt Schritt und veröffentlichte im Jahr 2000 den Radeon R100-Prozessor (ursprünglich Rage 6 genannt). Es wurde mit einer 180-nm-Prozesstechnologie hergestellt und unterstützt die ATI HyperZ-Technologie.Basierend auf dem R100 wurden Radeon DDR- und SDR-Grafikkarten veröffentlicht. Radeon DDR wurde mit 32 MB oder 64 MB Videospeicher geliefert. Die Kern- und Speicherfrequenzen betrugen 183 MHz, es wurde ein 128-Bit-Bus verwendet. Die Schnittstelle war AGP 4x. Die Grafikkarte hatte 2-Pixel-Pipelines.Eine vereinfachte Version von SDR unterschied sich von Radeon DDR in der Art des verwendeten Speichers und den niedrigeren Frequenzen (166 MHz). Die Speicherkapazität des Radeon SDR betrug nur 32 MB.

Radeon DDR wurde mit 32 MB oder 64 MB Videospeicher geliefert. Die Kern- und Speicherfrequenzen betrugen 183 MHz, es wurde ein 128-Bit-Bus verwendet. Die Schnittstelle war AGP 4x. Die Grafikkarte hatte 2-Pixel-Pipelines.Eine vereinfachte Version von SDR unterschied sich von Radeon DDR in der Art des verwendeten Speichers und den niedrigeren Frequenzen (166 MHz). Die Speicherkapazität des Radeon SDR betrug nur 32 MB.Radeon 8500 und Radeon 7500

Im Jahr 2001 wurden zwei Radeon 8500- und Radeon 7500-Chips auf Basis des RV200 veröffentlicht. Die Radeon 8500 sammelte die neuesten ATI-Entwicklungen und erwies sich als sehr schnell. Es wurde mit einer 150-nm-Prozesstechnologie hergestellt und enthielt 60 Millionen Transistoren. Die Kern- und Speicherfrequenzen betrugen 275 MHz. Ein 128-Bit-Bus wurde verwendet. Der DDR-SDRAM-Speicher wurde in zwei Versionen angeboten: 64 MB und 128 MB. Es gab 4-Pixel-Pipelines. Die

Die Radeon 8500 sammelte die neuesten ATI-Entwicklungen und erwies sich als sehr schnell. Es wurde mit einer 150-nm-Prozesstechnologie hergestellt und enthielt 60 Millionen Transistoren. Die Kern- und Speicherfrequenzen betrugen 275 MHz. Ein 128-Bit-Bus wurde verwendet. Der DDR-SDRAM-Speicher wurde in zwei Versionen angeboten: 64 MB und 128 MB. Es gab 4-Pixel-Pipelines. Die Radeon 7500 wurde mit derselben 150-nm-Prozesstechnologie hergestellt, jedoch mit 30 Millionen Transistoren. Der Kern arbeitete mit einer Frequenz von 290 MHz und der Speicher mit 230 MHz. Es gab 2 Pixelförderer.

Radeon 7500 wurde mit derselben 150-nm-Prozesstechnologie hergestellt, jedoch mit 30 Millionen Transistoren. Der Kern arbeitete mit einer Frequenz von 290 MHz und der Speicher mit 230 MHz. Es gab 2 Pixelförderer.GeForce 3

Im Jahr 2001 wurden GeForce 3-GPUs mit dem Codenamen NV20 veröffentlicht. Der Prozessor wurde nach der 150-nm-Prozesstechnologie hergestellt. Die auf 64 MB und 128 MB angebotene Speichermenge. Der Bus war 128-Bit und bestand aus vier 32-Bit-Controllern. Der Kern arbeitete mit einer Frequenz von 200 MHz und der Speicher mit einer Frequenz von 230 MHz. Es gab 4-Pixel-Förderer. Die Produktivität betrug 800 Milliarden Operationen / Sek. Die Speicherbandbreite betrug 7,36 Gbit / s.Das Gerät unterstützte die nFinite FX Engine, sodass Sie eine Vielzahl verschiedener Spezialeffekte erstellen können. Es gab eine verbesserte LMA-Architektur (Lightspeed Memory Architecture).Die Grafikkartenreihe bestand aus Modifikationen der GeForce 3, GeForce 3 Ti 200 und Ti 500. Sie unterschieden sich in Taktrate, Leistung und Speicherbandbreite.

Im Jahr 2001 wurden GeForce 3-GPUs mit dem Codenamen NV20 veröffentlicht. Der Prozessor wurde nach der 150-nm-Prozesstechnologie hergestellt. Die auf 64 MB und 128 MB angebotene Speichermenge. Der Bus war 128-Bit und bestand aus vier 32-Bit-Controllern. Der Kern arbeitete mit einer Frequenz von 200 MHz und der Speicher mit einer Frequenz von 230 MHz. Es gab 4-Pixel-Förderer. Die Produktivität betrug 800 Milliarden Operationen / Sek. Die Speicherbandbreite betrug 7,36 Gbit / s.Das Gerät unterstützte die nFinite FX Engine, sodass Sie eine Vielzahl verschiedener Spezialeffekte erstellen können. Es gab eine verbesserte LMA-Architektur (Lightspeed Memory Architecture).Die Grafikkartenreihe bestand aus Modifikationen der GeForce 3, GeForce 3 Ti 200 und Ti 500. Sie unterschieden sich in Taktrate, Leistung und Speicherbandbreite. GeForce 3 Ti 200: 175 MHz Kern, 200 MHz Speicher; 700 Milliarden Operationen / Sek.; 6,4 Gbit / s Bandbreite.

GeForce 3 Ti 200: 175 MHz Kern, 200 MHz Speicher; 700 Milliarden Operationen / Sek.; 6,4 Gbit / s Bandbreite. GeForce 3 Ti 500: 240 MHz Kern und 250 MHz Speicher; 960 Milliarden Operationen / Sek.; 8,0 Gbit / s Bandbreite.

GeForce 3 Ti 500: 240 MHz Kern und 250 MHz Speicher; 960 Milliarden Operationen / Sek.; 8,0 Gbit / s Bandbreite.GeForce 4

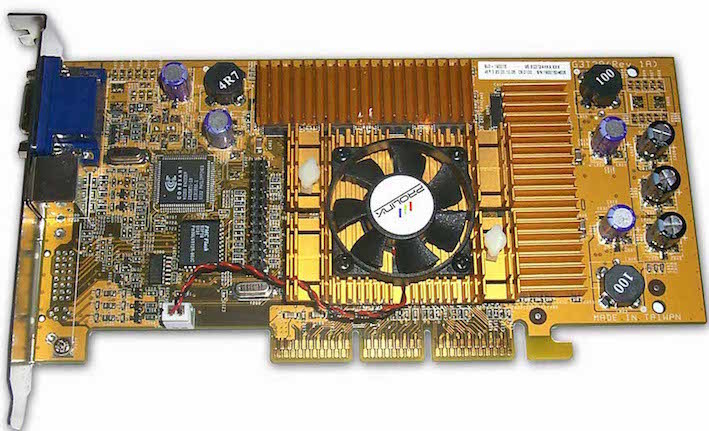

Die nächste NVIDIA-Grafikkarte war GeForce 4, die 2002 veröffentlicht wurde. Unter diesem Namen wurden zwei Arten von Grafikkarten herausgegeben: Hochleistungs-Ti (Titan) und Budget-MX. Die GeForce 4 Ti-Linie wurde von den Modellen Ti 4400, Ti 4600 und Ti 4200 vorgestellt. Die Grafikkarten unterschieden sich in den Kern- und Speichertaktgeschwindigkeiten. Der Videospeicher betrug 128 MB (der Ti 4200 bot auch eine Option für 64 MB). Titan verwendete einen 128-Bit-4-Kanal-Speichercontroller mit LightSpeed Memory Architecture II, 4 Rendering-Einheiten, 8 Textureinheiten, 2 T & L, ein Accuview-Anti-Aliasing-Subsystem und die Shader-Engine nFiniteFX II, die DirectX 8.1 und OpenGL 1.3 vollständig unterstützt. Das GeForce 4 Ti 4200-Modell war aufgrund seiner hohen Leistung zu einem erschwinglichen Preis das am weitesten verbreitete.

Die GeForce 4 Ti-Linie wurde von den Modellen Ti 4400, Ti 4600 und Ti 4200 vorgestellt. Die Grafikkarten unterschieden sich in den Kern- und Speichertaktgeschwindigkeiten. Der Videospeicher betrug 128 MB (der Ti 4200 bot auch eine Option für 64 MB). Titan verwendete einen 128-Bit-4-Kanal-Speichercontroller mit LightSpeed Memory Architecture II, 4 Rendering-Einheiten, 8 Textureinheiten, 2 T & L, ein Accuview-Anti-Aliasing-Subsystem und die Shader-Engine nFiniteFX II, die DirectX 8.1 und OpenGL 1.3 vollständig unterstützt. Das GeForce 4 Ti 4200-Modell war aufgrund seiner hohen Leistung zu einem erschwinglichen Preis das am weitesten verbreitete. Die GeForce 4 MX hat die GeForce 2-Architektur geerbt (mit höherer Geschwindigkeit). Sie basierten auf dem NV17-Chip, der mit der 150-nm-Prozesstechnologie hergestellt wurde und aus 27 Millionen Transistoren besteht. Der Videospeicher betrug 64 MB. Die GPU hatte 2 Rendering-Einheiten, 4 Textureinheiten, 1 T & L-Einheit und einen 128-Bit-2-Kanal-Speichercontroller mit LightSpeed Memory Architecture II. Der Chip hatte auch ein Accuview-Anti-Aliasing-Subsystem.

Die GeForce 4 MX hat die GeForce 2-Architektur geerbt (mit höherer Geschwindigkeit). Sie basierten auf dem NV17-Chip, der mit der 150-nm-Prozesstechnologie hergestellt wurde und aus 27 Millionen Transistoren besteht. Der Videospeicher betrug 64 MB. Die GPU hatte 2 Rendering-Einheiten, 4 Textureinheiten, 1 T & L-Einheit und einen 128-Bit-2-Kanal-Speichercontroller mit LightSpeed Memory Architecture II. Der Chip hatte auch ein Accuview-Anti-Aliasing-Subsystem.Radeon 9700 Pro

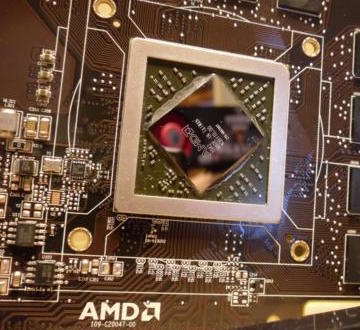

Im Sommer 2002 brachte ATI den R300-Chip auf den Markt, der mit der 150-nm-Prozesstechnologie hergestellt wurde und etwa 110 Millionen Transistoren enthielt. Er hatte 8 Pixel Pipelines. Der Chip unterstützte auch verbesserte Anti-Aliasing-Techniken.Basierend auf dem R300 wurde eine Radeon 9700-Grafikkarte mit Taktraten des 325-MHz-Kerns und 310-MHz-Speichers veröffentlicht. Die Speicherkapazität betrug 128 MB. Der Speicherbus war eine 256-Bit-DDR.Anfang 2003 wurde die Radeon 9700 durch die Radeon 9800-Grafikkarte ersetzt. Auf dem R350-Chip wurden neue Lösungen entwickelt, mit einer Erhöhung der Taktraten und der Fertigstellung von Shader-Einheiten, einem Speichercontroller.

Im Sommer 2002 brachte ATI den R300-Chip auf den Markt, der mit der 150-nm-Prozesstechnologie hergestellt wurde und etwa 110 Millionen Transistoren enthielt. Er hatte 8 Pixel Pipelines. Der Chip unterstützte auch verbesserte Anti-Aliasing-Techniken.Basierend auf dem R300 wurde eine Radeon 9700-Grafikkarte mit Taktraten des 325-MHz-Kerns und 310-MHz-Speichers veröffentlicht. Die Speicherkapazität betrug 128 MB. Der Speicherbus war eine 256-Bit-DDR.Anfang 2003 wurde die Radeon 9700 durch die Radeon 9800-Grafikkarte ersetzt. Auf dem R350-Chip wurden neue Lösungen entwickelt, mit einer Erhöhung der Taktraten und der Fertigstellung von Shader-Einheiten, einem Speichercontroller.GeForce FX

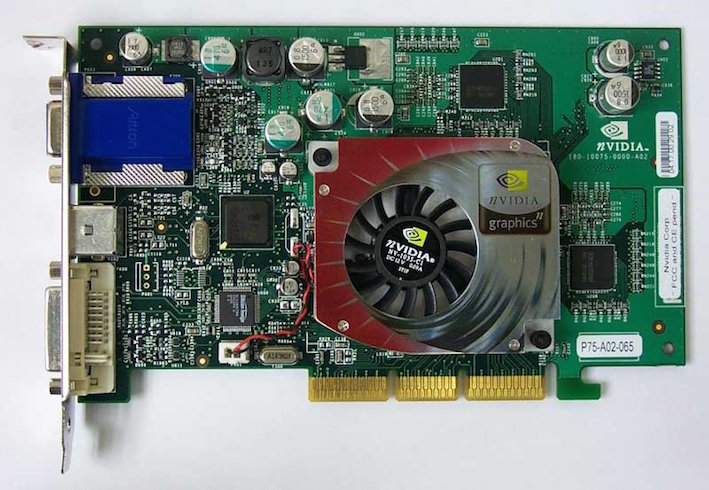

GeForce FX ist die fünfte Generation von GPUs, die von NVIDIA von Ende 2002 bis 2004 entwickelt und veröffentlicht wurden. Eine der ersten Grafikkarten der GeForce FX-Serie verfügte über fortschrittliche Anti-Aliasing- und anisotrope Filtermethoden. Es unterstützt Vertex- und Pixel-Shader Version 2.0. Dank der 64-Bit- und 128-Bit-Farbdarstellung hat sich die Qualität lebendiger Bilder verbessert. Der NV30-Chip wurde unter Verwendung einer 130-nm-Prozesstechnologie hergestellt und arbeitete mit einem 128-Bit-AGP-8x-Bus, der DDR2-Speicher unterstützt.GeForce FX wurde in verschiedenen Modifikationen vorgestellt: Einstiegsmodell (5200, 5300, 5500), Mittelklasse (5600, 5700, 5750), High-End (5800, 5900, 5950), Enthusiast (5800 Ultra, 5900 Ultra, 5950) Ultra). Der verwendete Bus war 126-Bit und 256-Bit.

GeForce FX ist die fünfte Generation von GPUs, die von NVIDIA von Ende 2002 bis 2004 entwickelt und veröffentlicht wurden. Eine der ersten Grafikkarten der GeForce FX-Serie verfügte über fortschrittliche Anti-Aliasing- und anisotrope Filtermethoden. Es unterstützt Vertex- und Pixel-Shader Version 2.0. Dank der 64-Bit- und 128-Bit-Farbdarstellung hat sich die Qualität lebendiger Bilder verbessert. Der NV30-Chip wurde unter Verwendung einer 130-nm-Prozesstechnologie hergestellt und arbeitete mit einem 128-Bit-AGP-8x-Bus, der DDR2-Speicher unterstützt.GeForce FX wurde in verschiedenen Modifikationen vorgestellt: Einstiegsmodell (5200, 5300, 5500), Mittelklasse (5600, 5700, 5750), High-End (5800, 5900, 5950), Enthusiast (5800 Ultra, 5900 Ultra, 5950) Ultra). Der verwendete Bus war 126-Bit und 256-Bit. Basierend auf dem NV30 wurde eine neue Generation von Top-End-Geräten entwickelt - die GeForce FX 5800-Grafikkarte. Der Videospeicher erreichte 256 MB, die Kernfrequenz betrug 400 MHz und der Speicher betrug 800 MHz. Beim 5800 Ultra stieg die Kernfrequenz auf 500 MHz und der Speicher auf 1000 MHz. Die ersten NV30-basierten Karten verfügten über ein innovatives Kühlsystem.

Basierend auf dem NV30 wurde eine neue Generation von Top-End-Geräten entwickelt - die GeForce FX 5800-Grafikkarte. Der Videospeicher erreichte 256 MB, die Kernfrequenz betrug 400 MHz und der Speicher betrug 800 MHz. Beim 5800 Ultra stieg die Kernfrequenz auf 500 MHz und der Speicher auf 1000 MHz. Die ersten NV30-basierten Karten verfügten über ein innovatives Kühlsystem.GeForce 6 Serie

Die Entwicklung von Grafikkarten wurde aktiv fortgesetzt und 2004 wurde das nächste Produkt des Unternehmens veröffentlicht - die GeForce 6-Serie (Codename NV40).Der NV40-Chip wurde ebenfalls mit der 130-nm-Prozesstechnologie hergestellt, was nicht verhinderte, dass er wirtschaftlicher wurde. Durch die Änderung von Pixel-Pipelines konnten bis zu 16 Pixel pro Zyklus verarbeitet werden. Insgesamt gab es 16-Pixel-Pipelines. Grafikkarten unterstützen Pixel- und Vertex-Shader Version 3.0, UltraShadow-Technologie (Rendern von Schatten). Darüber hinaus decodierte die GeForce 6-Serie die Videoformate H.264, VC-1 und MPEG-2 mithilfe der PureVideo-Technologie. Der NV40 arbeitete über einen 256-Bit-Bus und verwendete dabei sehr schnelle Speichermodule wie GDDR3.Als eines der ersten Modelle war die GeForce 6800-Grafikkarte sehr produktiv und zog die neuesten Spiele der Zeit. Es funktionierte sowohl über die AGP-Schnittstelle als auch über den PCI Express-Bus. Die Kernfrequenz betrug 325 MHz und die Speicherfrequenz betrug 700 MHz. Die Speichermenge erreichte 256 MB oder 512 MB.

Die Entwicklung von Grafikkarten wurde aktiv fortgesetzt und 2004 wurde das nächste Produkt des Unternehmens veröffentlicht - die GeForce 6-Serie (Codename NV40).Der NV40-Chip wurde ebenfalls mit der 130-nm-Prozesstechnologie hergestellt, was nicht verhinderte, dass er wirtschaftlicher wurde. Durch die Änderung von Pixel-Pipelines konnten bis zu 16 Pixel pro Zyklus verarbeitet werden. Insgesamt gab es 16-Pixel-Pipelines. Grafikkarten unterstützen Pixel- und Vertex-Shader Version 3.0, UltraShadow-Technologie (Rendern von Schatten). Darüber hinaus decodierte die GeForce 6-Serie die Videoformate H.264, VC-1 und MPEG-2 mithilfe der PureVideo-Technologie. Der NV40 arbeitete über einen 256-Bit-Bus und verwendete dabei sehr schnelle Speichermodule wie GDDR3.Als eines der ersten Modelle war die GeForce 6800-Grafikkarte sehr produktiv und zog die neuesten Spiele der Zeit. Es funktionierte sowohl über die AGP-Schnittstelle als auch über den PCI Express-Bus. Die Kernfrequenz betrug 325 MHz und die Speicherfrequenz betrug 700 MHz. Die Speichermenge erreichte 256 MB oder 512 MB.Radeon X800 XT

ATI war in einer besseren Position. Im Jahr 2004 stellte das Unternehmen den 130-nm-R420-Chip vor (eine erweiterte Version des R300). Pixel-Pipelines wurden in vier Blöcke mit jeweils vier Pipelines unterteilt (insgesamt 16 Pixel-Pipelines). Die Anzahl der Vertex-Pipelines wurde auf 6 erhöht. Da der R420 die Arbeit von Shadern der dritten Generation nicht unterstützte, arbeitete er mit der aktualisierten HyperZ HD-Technologie.Die leistungsstärkste und produktivste Grafikkarte der neuen Radeon-Reihe war die X800 XT. Die Karte war mit 256 MB GDDR3-Speicher und 256-Bit-Buskapazität ausgestattet. Die Betriebsfrequenz erreichte im Kern 520 MHz und im Speicher 560 MHz. Die Radeon X800 XT wurde in zwei Versionen verkauft: AGP und PCI Express. Zusätzlich zur regulären Version gab es eine Radeon X800 XT Platinum Edition mit höheren Chip- und Speicherfrequenzen.

ATI war in einer besseren Position. Im Jahr 2004 stellte das Unternehmen den 130-nm-R420-Chip vor (eine erweiterte Version des R300). Pixel-Pipelines wurden in vier Blöcke mit jeweils vier Pipelines unterteilt (insgesamt 16 Pixel-Pipelines). Die Anzahl der Vertex-Pipelines wurde auf 6 erhöht. Da der R420 die Arbeit von Shadern der dritten Generation nicht unterstützte, arbeitete er mit der aktualisierten HyperZ HD-Technologie.Die leistungsstärkste und produktivste Grafikkarte der neuen Radeon-Reihe war die X800 XT. Die Karte war mit 256 MB GDDR3-Speicher und 256-Bit-Buskapazität ausgestattet. Die Betriebsfrequenz erreichte im Kern 520 MHz und im Speicher 560 MHz. Die Radeon X800 XT wurde in zwei Versionen verkauft: AGP und PCI Express. Zusätzlich zur regulären Version gab es eine Radeon X800 XT Platinum Edition mit höheren Chip- und Speicherfrequenzen.GeForce 7800 GTX

Im Jahr 2005 wurde der G70-Chip veröffentlicht, der die Grundlage für die Grafikkarten der GeForce 7800-Serie bildete. Die Anzahl der Transistoren stieg auf 302 Millionen.Die Anzahl der Pixel-Pipelines hat sich verdoppelt - bis zu 24 Stück. Jeder Pipeline wurden zusätzliche ALUs hinzugefügt, die für die Verarbeitung der beliebtesten Pixel-Shader verantwortlich sind. Erhöhte Chipleistung in Spielen, die sich auf die Leistung von Pixelprozessoren konzentrieren.Die GeForce 7800 GTX war die erste G70-basierte Grafikkarte. Die Kernfrequenz betrug 430 MHz, Speicher - 600 MHz. Es wurde Fast GDDR3 sowie ein 256-Bit-Bus verwendet. Die Speicherkapazität betrug 256 MB oder 512 MB. Die GeForce 7800 GTX arbeitete ausschließlich über die PCI Express x16-Schnittstelle, die schließlich begann, das alternde AGP zu verdrängen.

Im Jahr 2005 wurde der G70-Chip veröffentlicht, der die Grundlage für die Grafikkarten der GeForce 7800-Serie bildete. Die Anzahl der Transistoren stieg auf 302 Millionen.Die Anzahl der Pixel-Pipelines hat sich verdoppelt - bis zu 24 Stück. Jeder Pipeline wurden zusätzliche ALUs hinzugefügt, die für die Verarbeitung der beliebtesten Pixel-Shader verantwortlich sind. Erhöhte Chipleistung in Spielen, die sich auf die Leistung von Pixelprozessoren konzentrieren.Die GeForce 7800 GTX war die erste G70-basierte Grafikkarte. Die Kernfrequenz betrug 430 MHz, Speicher - 600 MHz. Es wurde Fast GDDR3 sowie ein 256-Bit-Bus verwendet. Die Speicherkapazität betrug 256 MB oder 512 MB. Die GeForce 7800 GTX arbeitete ausschließlich über die PCI Express x16-Schnittstelle, die schließlich begann, das alternde AGP zu verdrängen.GeForce 7950 GX2

Die Veranstaltung 2006 für NVIDIA war die Einführung der ersten Dual-Chip-GeForce 7950-Grafikkarte, die mit der 90-nm-Prozesstechnologie erstellt wurde. Die NVidia 7950 GX2 hatte auf jeder Platine einen G71-Chip. Der Kern der Grafikkarte arbeitete mit einer Frequenz von 500 MHz, der Speicher mit einer Frequenz von 600 MHz. Die Menge des Videospeichers Typ GDDR3 betrug 1 GB (512 MB pro Chip), ein 256-Bit-Bus.Die neue Karte hat den Stromverbrauch optimiert und das Kühlsystem verbessert. Die Veröffentlichung des 7950 GX2 markiert den Beginn der Quad SLI-Technologie, die die gleichzeitige Nutzung der Leistung mehrerer Grafikkarten zur Verarbeitung von 3D-Bildern ermöglicht.

Die Veranstaltung 2006 für NVIDIA war die Einführung der ersten Dual-Chip-GeForce 7950-Grafikkarte, die mit der 90-nm-Prozesstechnologie erstellt wurde. Die NVidia 7950 GX2 hatte auf jeder Platine einen G71-Chip. Der Kern der Grafikkarte arbeitete mit einer Frequenz von 500 MHz, der Speicher mit einer Frequenz von 600 MHz. Die Menge des Videospeichers Typ GDDR3 betrug 1 GB (512 MB pro Chip), ein 256-Bit-Bus.Die neue Karte hat den Stromverbrauch optimiert und das Kühlsystem verbessert. Die Veröffentlichung des 7950 GX2 markiert den Beginn der Quad SLI-Technologie, die die gleichzeitige Nutzung der Leistung mehrerer Grafikkarten zur Verarbeitung von 3D-Bildern ermöglicht.Radeon X1800 XT, X1900

Basierend auf dem R520 wurde die Radeon X1800 XT-Grafikkarte entwickelt. Die Karte war mit einem 256 MB oder 512 MB GDDR3-Speicher ausgestattet, der mit einer Frequenz von 750 MHz betrieben wurde. Ein 256-Bit-Bus wurde verwendet.

Basierend auf dem R520 wurde die Radeon X1800 XT-Grafikkarte entwickelt. Die Karte war mit einem 256 MB oder 512 MB GDDR3-Speicher ausgestattet, der mit einer Frequenz von 750 MHz betrieben wurde. Ein 256-Bit-Bus wurde verwendet. Die Radeon X1800 XT-Grafikkarten sind noch nicht lange auf dem Markt. Bald wurden sie durch Adapter der Radeon X1900 XTX-Serie ersetzt, die auf dem R580-Chip basierten. Der Prozessor unterstützt die Hardware-Spezifikationen SM 3.0 (DirectX 9.0c) und HDR-Blending im FP16-Format vollständig und kann MSAA gemeinsam nutzen. Die Anzahl der Pixel-Pipelines wurde im neuen Chip auf 48 erhöht. Die Kernfrequenz betrug 650 MHz und der Speicher 775 MHz.Sechs Monate später brachte der R580 + -Chip einen neuen Speichercontroller heraus, der mit dem GDDR4-Standard funktioniert. Die Speicherfrequenz wurde auf 2000 MHz erhöht, während der Bus 256 Bit blieb. Die Hauptmerkmale des Chips bleiben gleich: 48-Pixel-Pipelines, 16 Textur-Pipelines und 8 Vertex-Pipelines. Die Kernfrequenz betrug 625 MHz, der Speicher mehr - 900 MHz.

Die Radeon X1800 XT-Grafikkarten sind noch nicht lange auf dem Markt. Bald wurden sie durch Adapter der Radeon X1900 XTX-Serie ersetzt, die auf dem R580-Chip basierten. Der Prozessor unterstützt die Hardware-Spezifikationen SM 3.0 (DirectX 9.0c) und HDR-Blending im FP16-Format vollständig und kann MSAA gemeinsam nutzen. Die Anzahl der Pixel-Pipelines wurde im neuen Chip auf 48 erhöht. Die Kernfrequenz betrug 650 MHz und der Speicher 775 MHz.Sechs Monate später brachte der R580 + -Chip einen neuen Speichercontroller heraus, der mit dem GDDR4-Standard funktioniert. Die Speicherfrequenz wurde auf 2000 MHz erhöht, während der Bus 256 Bit blieb. Die Hauptmerkmale des Chips bleiben gleich: 48-Pixel-Pipelines, 16 Textur-Pipelines und 8 Vertex-Pipelines. Die Kernfrequenz betrug 625 MHz, der Speicher mehr - 900 MHz.GeForce 8800 GTX

Im Jahr 2006 wurden mehrere Grafikkarten auf Basis des G80-Prozessors veröffentlicht, von denen die leistungsstärkste die GeForce 8800 GTX war. Der G80 war einer der komplexesten existierenden Chips der Zeit. Es wurde mit der 90-nm-Prozesstechnologie hergestellt und enthielt 681 Millionen Transistoren. Der Kern arbeitete mit einer Frequenz von 575 MHz, der Speicher mit einer Frequenz von 900 MHz. Die Frequenz der einheitlichen Shader-Einheiten betrug 1350 MHz. Die GeForce 8800 GTX verfügte über 768 MB GDDR3-Videospeicher und eine Busbreite von 384 Bit. Es wurden neue Anti-Aliasing-Methoden unterstützt, mit denen die ROP-Einheiten im MSAA-Modus (Multisample Anti-Aliasing) mit HDR-Licht arbeiten konnten. Die PureVideo-Technologie wurde entwickelt.Die GeForce 8800 GTX-Architektur erwies sich als besonders effizient und ist seit mehreren Jahren eine der schnellsten Grafikkarten.

Im Jahr 2006 wurden mehrere Grafikkarten auf Basis des G80-Prozessors veröffentlicht, von denen die leistungsstärkste die GeForce 8800 GTX war. Der G80 war einer der komplexesten existierenden Chips der Zeit. Es wurde mit der 90-nm-Prozesstechnologie hergestellt und enthielt 681 Millionen Transistoren. Der Kern arbeitete mit einer Frequenz von 575 MHz, der Speicher mit einer Frequenz von 900 MHz. Die Frequenz der einheitlichen Shader-Einheiten betrug 1350 MHz. Die GeForce 8800 GTX verfügte über 768 MB GDDR3-Videospeicher und eine Busbreite von 384 Bit. Es wurden neue Anti-Aliasing-Methoden unterstützt, mit denen die ROP-Einheiten im MSAA-Modus (Multisample Anti-Aliasing) mit HDR-Licht arbeiten konnten. Die PureVideo-Technologie wurde entwickelt.Die GeForce 8800 GTX-Architektur erwies sich als besonders effizient und ist seit mehreren Jahren eine der schnellsten Grafikkarten.Radeon HD2900 XT, HD 3870 und HD 3850

2007 wurde das Flaggschiff Radeon HD2900 XT auf Basis des R600-Chips eingeführt. Die Kernfrequenz der Grafikkarte betrug 740 MHz, GDDR4-Speicher - 825 MHz. Ein 512-Bit-Speicherbus wurde verwendet. Der Videospeicher erreichte 512 MB und 1 GB.Eine erfolgreichere Entwicklung war der im selben Jahr veröffentlichte RV670-Prozessor. Es unterschied sich in der Architektur fast nicht von seinem Vorgänger, wurde jedoch nach der 55-nm-Prozesstechnologie und mit einem 256-Bit-Speicherbus hergestellt. Unterstützung für DirectX 10.1 und Shader Model 4.1 wurde angezeigt. Basierend auf dem Prozessor wurden Grafikkarten Radeon HD 3870 (Kernfrequenz 775 MHz, Speicher 1125 MHz) und Radeon HD 3850 (Kernfrequenz 670 MHz, Speicher 828 MHz) mit einer Videospeicherkapazität von 256 MB und 512 MB und einem 256-Bit-Bus hergestellt.

2007 wurde das Flaggschiff Radeon HD2900 XT auf Basis des R600-Chips eingeführt. Die Kernfrequenz der Grafikkarte betrug 740 MHz, GDDR4-Speicher - 825 MHz. Ein 512-Bit-Speicherbus wurde verwendet. Der Videospeicher erreichte 512 MB und 1 GB.Eine erfolgreichere Entwicklung war der im selben Jahr veröffentlichte RV670-Prozessor. Es unterschied sich in der Architektur fast nicht von seinem Vorgänger, wurde jedoch nach der 55-nm-Prozesstechnologie und mit einem 256-Bit-Speicherbus hergestellt. Unterstützung für DirectX 10.1 und Shader Model 4.1 wurde angezeigt. Basierend auf dem Prozessor wurden Grafikkarten Radeon HD 3870 (Kernfrequenz 775 MHz, Speicher 1125 MHz) und Radeon HD 3850 (Kernfrequenz 670 MHz, Speicher 828 MHz) mit einer Videospeicherkapazität von 256 MB und 512 MB und einem 256-Bit-Bus hergestellt.GeForce 9800

Der G92-Chip bildete die Basis der GeForce 9800 GTX - einer der schnellsten und günstigsten Grafikkarten. Es wurde nach der 65-nm-Prozesstechnologie hergestellt. Die Kernfrequenz betrug 675 MHz, die Speicherfrequenz 1100 MHz und der Bus 256 Bit. Die Speicherkapazität wurde in zwei Versionen angeboten: 512 MB und 1 GB. Etwas später erschien das GTX + -Modell, das sich durch eine 55-nm-Prozesstechnologie und eine Kernfrequenz von 738 MHz auszeichnete.Eine weitere Zwei-Chip-Grafikkarte GeForce 9800 GX2 erschien ebenfalls in dieser Reihe. Jeder der Prozessoren hatte Spezifikationen wie die GeForce 8800 GTS 512 MB nur mit unterschiedlichen Frequenzen.

Der G92-Chip bildete die Basis der GeForce 9800 GTX - einer der schnellsten und günstigsten Grafikkarten. Es wurde nach der 65-nm-Prozesstechnologie hergestellt. Die Kernfrequenz betrug 675 MHz, die Speicherfrequenz 1100 MHz und der Bus 256 Bit. Die Speicherkapazität wurde in zwei Versionen angeboten: 512 MB und 1 GB. Etwas später erschien das GTX + -Modell, das sich durch eine 55-nm-Prozesstechnologie und eine Kernfrequenz von 738 MHz auszeichnete.Eine weitere Zwei-Chip-Grafikkarte GeForce 9800 GX2 erschien ebenfalls in dieser Reihe. Jeder der Prozessoren hatte Spezifikationen wie die GeForce 8800 GTS 512 MB nur mit unterschiedlichen Frequenzen.GeForce GTX 280 und GTX 260

Im Jahr 2008 veröffentlichte NVIDIA den GT200-Chip, der in den Grafikkarten GeForce GTX 280 und GTX 260 verwendet wurde. Der Chip wurde mit der 65-nm-Prozesstechnologie hergestellt und enthielt 1,4 Milliarden Transistoren, 32 ROPs und 80 Textureinheiten. Der Speicherbus wurde auf 512 Bit erhöht. Unterstützung wurde auch für die PhysX-Physik-Engine und die CUDA-Plattform hinzugefügt. Die Kernfrequenz der Grafikkarte betrug 602 MHz und der Speichertyp GDDR3 - 1107 MHz.

Im Jahr 2008 veröffentlichte NVIDIA den GT200-Chip, der in den Grafikkarten GeForce GTX 280 und GTX 260 verwendet wurde. Der Chip wurde mit der 65-nm-Prozesstechnologie hergestellt und enthielt 1,4 Milliarden Transistoren, 32 ROPs und 80 Textureinheiten. Der Speicherbus wurde auf 512 Bit erhöht. Unterstützung wurde auch für die PhysX-Physik-Engine und die CUDA-Plattform hinzugefügt. Die Kernfrequenz der Grafikkarte betrug 602 MHz und der Speichertyp GDDR3 - 1107 MHz. Die Grafikkarte GeForce GTX 260 verwendete den Bus GDDR3 448-Bit. Die Kernfrequenz erreichte 576 MHz und der Speicher 999 MHz.

Die Grafikkarte GeForce GTX 260 verwendete den Bus GDDR3 448-Bit. Die Kernfrequenz erreichte 576 MHz und der Speicher 999 MHz.Radeon HD 4870

Die ältere Grafikkarte der neuen Leitung hieß Radeon HD 4870. Die Kernfrequenz betrug 750 MHz, und der Speicher arbeitete mit einer effektiven Frequenz von 3600 MHz. Mit der neuen Reihe von Grafikkarten setzte das Unternehmen seine neue Richtlinie für die Veröffentlichung von Geräten fort, die im Middle-End-Segment erfolgreich bestehen könnten. So wurde die Radeon HD 4870 zu einem würdigen Konkurrenten der GeForce GTX 260-Grafikkarte. Und der Marktführer der HD 4000-Reihe wurde bald von der nächsten Dual-Chip-Lösung Radeon HD 4870X2 übernommen. Die Architektur der Grafikkarte selbst entsprach der der Radeon HD 3870X2, mit Ausnahme der Sideport-Schnittstelle, die die beiden Kerne für den schnellsten Informationsaustausch direkt miteinander verband.

Die ältere Grafikkarte der neuen Leitung hieß Radeon HD 4870. Die Kernfrequenz betrug 750 MHz, und der Speicher arbeitete mit einer effektiven Frequenz von 3600 MHz. Mit der neuen Reihe von Grafikkarten setzte das Unternehmen seine neue Richtlinie für die Veröffentlichung von Geräten fort, die im Middle-End-Segment erfolgreich bestehen könnten. So wurde die Radeon HD 4870 zu einem würdigen Konkurrenten der GeForce GTX 260-Grafikkarte. Und der Marktführer der HD 4000-Reihe wurde bald von der nächsten Dual-Chip-Lösung Radeon HD 4870X2 übernommen. Die Architektur der Grafikkarte selbst entsprach der der Radeon HD 3870X2, mit Ausnahme der Sideport-Schnittstelle, die die beiden Kerne für den schnellsten Informationsaustausch direkt miteinander verband.GeForce GTX 480

2010 führte NVIDIA den GF100 mit der Fermi-Architektur ein, die die Grundlage für die GeForce GTX 480-Grafikkarte bildete. Der GF100 wurde mit der 40-nm-Prozesstechnologie hergestellt und erhielt 512 Stream-Prozessoren. Die Kernfrequenz betrug 700 MHz und der Speicher 1848 MHz. Die Busbreite betrug 384 Bit. Die Größe des Videospeichers GDDR5 erreichte 1,5 GB.Der GF100-Chip unterstützt DirectX 11 und Shader Model 5.0 sowie die neue NVIDIA Surround-Technologie, mit der Sie Anwendungen auf drei Bildschirmen bereitstellen und so den Effekt eines vollständigen Eintauchens erzielen können.

2010 führte NVIDIA den GF100 mit der Fermi-Architektur ein, die die Grundlage für die GeForce GTX 480-Grafikkarte bildete. Der GF100 wurde mit der 40-nm-Prozesstechnologie hergestellt und erhielt 512 Stream-Prozessoren. Die Kernfrequenz betrug 700 MHz und der Speicher 1848 MHz. Die Busbreite betrug 384 Bit. Die Größe des Videospeichers GDDR5 erreichte 1,5 GB.Der GF100-Chip unterstützt DirectX 11 und Shader Model 5.0 sowie die neue NVIDIA Surround-Technologie, mit der Sie Anwendungen auf drei Bildschirmen bereitstellen und so den Effekt eines vollständigen Eintauchens erzielen können.Chips Cypress und Cayman

AMD hat einen 40-nm-Cypress-Chip herausgebracht. Die Entwickler des Unternehmens haben beschlossen, den Ansatz zu ändern und nicht ausschließlich alphanumerische Werte zu verwenden. Einer Generation von Chips wurden eigene Namen zugewiesen. Das Prinzip der Cypress-Architektur setzte die Ideen des RV770 fort, aber das Design wurde neu gestaltet. Die Anzahl der Stream-Prozessoren, Textureinheiten und ROPs hat sich verdoppelt. Unterstützung für DirectX 11 und Shader Model 5.0 wurde angezeigt. Cypress führte neue Texturkomprimierungsmethoden ein, mit denen Entwickler große Texturen verwenden konnten. AMD führte auch die neue Eyefinity-Technologie ein, später wurde die NVIDIA Surround-Technologie zum vollständigen Gegenstück.Der Cypress-Chip wurde in die Grafikkarten der Radeon HD 5000-Serie implementiert. Bald veröffentlichte AMD auch die Dual-Chip-Lösung Radeon HD 5970. Im Allgemeinen war Cypress sehr erfolgreich.

AMD hat einen 40-nm-Cypress-Chip herausgebracht. Die Entwickler des Unternehmens haben beschlossen, den Ansatz zu ändern und nicht ausschließlich alphanumerische Werte zu verwenden. Einer Generation von Chips wurden eigene Namen zugewiesen. Das Prinzip der Cypress-Architektur setzte die Ideen des RV770 fort, aber das Design wurde neu gestaltet. Die Anzahl der Stream-Prozessoren, Textureinheiten und ROPs hat sich verdoppelt. Unterstützung für DirectX 11 und Shader Model 5.0 wurde angezeigt. Cypress führte neue Texturkomprimierungsmethoden ein, mit denen Entwickler große Texturen verwenden konnten. AMD führte auch die neue Eyefinity-Technologie ein, später wurde die NVIDIA Surround-Technologie zum vollständigen Gegenstück.Der Cypress-Chip wurde in die Grafikkarten der Radeon HD 5000-Serie implementiert. Bald veröffentlichte AMD auch die Dual-Chip-Lösung Radeon HD 5970. Im Allgemeinen war Cypress sehr erfolgreich. Die Ende 2010 erschienene Grafikkarte der Radeon HD 6000-Serie wurde entwickelt, um mit den GeForce GTX 500-Beschleunigern zu konkurrieren. Die Grafikkarten basierten auf dem Cayman-Chip. Es wurde eine etwas andere VLIW4-Architektur verwendet. Die Anzahl der Stream-Prozessoren betrug 1536 Stück. Die Anzahl der Texturmodule stieg - es gab 96 davon. Cayman konnte auch mit dem neuen AA-Glättungsalgorithmus von Enhanced Quality arbeiten. Die Speicherbusbreite des Chips betrug 256 Bit. Grafikkarten verwendeten GDDR5-Speicher.

Die Ende 2010 erschienene Grafikkarte der Radeon HD 6000-Serie wurde entwickelt, um mit den GeForce GTX 500-Beschleunigern zu konkurrieren. Die Grafikkarten basierten auf dem Cayman-Chip. Es wurde eine etwas andere VLIW4-Architektur verwendet. Die Anzahl der Stream-Prozessoren betrug 1536 Stück. Die Anzahl der Texturmodule stieg - es gab 96 davon. Cayman konnte auch mit dem neuen AA-Glättungsalgorithmus von Enhanced Quality arbeiten. Die Speicherbusbreite des Chips betrug 256 Bit. Grafikkarten verwendeten GDDR5-Speicher.GeForce GTX 680

Seit 2011 hat NVIDIA eine Generation von Grafikbeschleunigern veröffentlicht. Eines der bemerkenswerten Modelle war die GeForce GTX 680, die auf dem GK104-Chip basiert und mit der 28-nm-Prozesstechnologie hergestellt wurde. Die Kernfrequenz beträgt 1006 MHz, die Speicherfrequenz 6008 MHz, der 256-Bit-GDDR5-Bus.2013 stellte das Unternehmen den GK110-Chip vor, der auf dem Flaggschiff GeForce GTX 780 und GeForce GTX Titan basiert. Ein 384-Bit-GDDR5-Bus wurde verwendet, und die Speichermenge wurde auf 6 GB erhöht.

Seit 2011 hat NVIDIA eine Generation von Grafikbeschleunigern veröffentlicht. Eines der bemerkenswerten Modelle war die GeForce GTX 680, die auf dem GK104-Chip basiert und mit der 28-nm-Prozesstechnologie hergestellt wurde. Die Kernfrequenz beträgt 1006 MHz, die Speicherfrequenz 6008 MHz, der 256-Bit-GDDR5-Bus.2013 stellte das Unternehmen den GK110-Chip vor, der auf dem Flaggschiff GeForce GTX 780 und GeForce GTX Titan basiert. Ein 384-Bit-GDDR5-Bus wurde verwendet, und die Speichermenge wurde auf 6 GB erhöht. Source: https://habr.com/ru/post/de389989/

All Articles