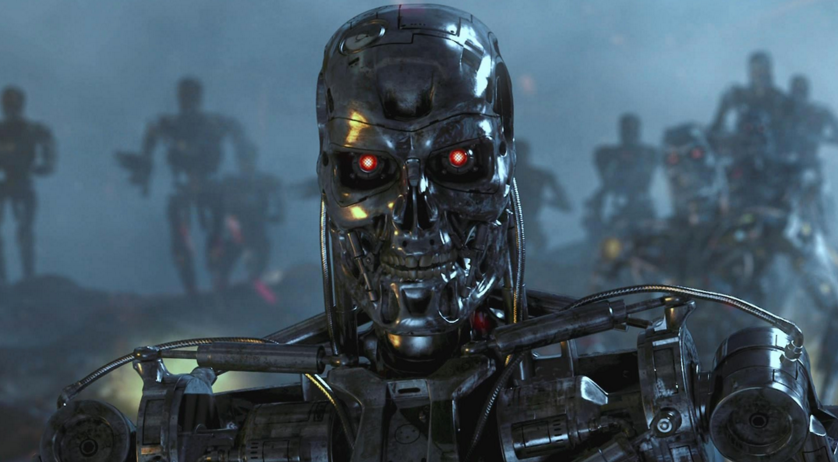

Was könnten gefährliche autonome Waffen sein

Alsehemaliger Pentagon-Mitarbeiter, der an der Entwicklung der Strategie für den Einsatz autonomer Waffen beteiligt war, weist er darauf hin, dass diese unter realen Bedingungen unkontrollierbar sein kann und die Möglichkeit besteht, dass der Feind sie hackt, ersetzt und manipuliert.In jüngster Zeit sind kostengünstige Sensoren und neue Technologien für künstliche Intelligenz praktischer geworden, die es ermöglichten, sie bei der Entwicklung autonomer Waffensysteme einzusetzen. Der Geist der sogenannten "Killerroboter" hat bereits eine internationale Protest- und Diskussionsbewegung bei den Vereinten Nationen ausgelöst, um die Entwicklung und Implementierung solcher Systeme einzuschränken , berichtet nytimes.com.Der Bericht wurde von Paul Sherry verfasst, der das Future War-Programm im New American Security Center (Washington, Columbia) leitet. Von 2008 bis 2013 arbeitete Sherry im Büro des US-Verteidigungsministers, wo er bei der Entwicklung einer Strategie für den Einsatz autonomer Waffen half. 2012 wurde er einer der Autoren der Richtlinie des Verteidigungsministeriums, die eine Militärpolitik zur Verwendung solcher Systeme festlegte.In einem am Montag veröffentlichten Bericht mit dem Titel „Autonome Waffen und operationelle Risiken“ warnt Sherry vor einer Reihe realer Risiken, die mit vollständig autonomen Waffensystemen verbunden sind. Es stellt vollautomatische Systeme, die ohne menschliches Eingreifen töten können, Waffen gegenüber, die bei der Auswahl und dem Treffen eines Ziels (dh es wird ein Bediener verwendet) „die Menschen auf dem Laufenden halten“.Sherry, der als Ranger in der US-Armee diente und an Operationen im Irak und in Afghanistan teilnahm, konzentriert sich auf mögliche Arten von Fehlern, die in vollautomatisierten Systemen auftreten können. Um die militärischen Auswirkungen hervorzuheben, listet der Bericht die Fehler auf, die in Armee- und Handelssystemen mit einem hohen Automatisierungsgrad aufgetreten sind."Jeder, der jemals die automatisierte telefonische Unterstützung für eine Hotline aufgegeben hat, einen Wecker, der fälschlicherweise auf" Abend "anstatt auf" Morgen "usw. eingestellt wurde, hat das Problem der" Fragilität "erlebt, das in automatisierten Systemen auftritt", schreibt Sherry.Die Grundlage seines Berichts ist, dass autonomen Waffensystemen "Flexibilität" fehlt, d.h. Bei der Ausführung eines solchen Systems können Fehler auftreten, die vermieden werden können.In den Militärarsenalen verschiedener Staaten tauchen völlig autonome Waffen auf. Zum Beispiel hat Südkorea mit Nordkorea einen automatischen Turm entlang der entmilitarisierten Zone installiert, und in Israel ist ein unbemanntes Luftfahrzeug im Einsatz, das so programmiert ist, dass es die Radarsysteme des Feindes angreift, wenn sie entdeckt werden.Das US-Militär verwendet keine autonomen Waffen. In diesem Jahr forderte das Verteidigungsministerium jedoch fast 1 Milliarde US-Dollar für die Waffenproduktion der Langstrecken-Anti-Schiffs-Rakete Lockheed Martin an, die als "halbautonom" bezeichnet wird. Obwohl der Bediener zuerst das Ziel auswählt, aber außerhalb des Kontakts mit der Person, identifiziert und greift er automatisch die feindlichen Truppen an.Der Fokus liegt auf einer Reihe von Überraschungen im Verhalten von Computersystemen wie Abstürzen und Fehlern sowie unvorhergesehenen Interaktionen mit der Umgebung.„Bei ihrem ersten Test über dem Pazifik versagte das Y2K-Computersystem bei acht F-22-Jägern vollständig, als sie die Datumsgrenze überschritten"Der Bericht sagt. „Alle Bordcomputersysteme fielen aus, und das Ergebnis war fast katastrophal - der Verlust eines Flugzeugs. Obwohl die Existenz der Datumsgrenze seit langem bekannt ist, wurde das Ergebnis der Interaktion mit der Software nicht vollständig getestet. “Als Alternative zu einer vollständig autonomen Waffe befürwortet der Bericht das sogenannte "Centaur Warfighting" (kombinierte Waffen? Tatsächlich nicht übersetzbare Wortspiele. Ca.). Der Begriff „Zentaur“ wird verwendet, um Systeme zu beschreiben, in die Menschen und Computer eng integriert sind. Im Schach beispielsweise dominieren Teams, die sowohl Personen- als auch Programme für künstliche Intelligenz verwenden, den Wettbewerb gegen Teams, die nur künstliche Intelligenz verwenden.In einem Telefoninterview gab Sherry jedoch zu, dass es nicht ausreicht, nur den Bediener "auf Knopfdruck" zu drücken. "Es reicht nicht aus, nur eine" benachrichtigte "Person über die Aktionen einer Maschine zu haben", sagte er. „Sie (Personen) können nicht nur Teil des Betriebsalgorithmus des Systems sein. Eine Person muss aktiv an der Entscheidungsfindung teilnehmen. “

Alsehemaliger Pentagon-Mitarbeiter, der an der Entwicklung der Strategie für den Einsatz autonomer Waffen beteiligt war, weist er darauf hin, dass diese unter realen Bedingungen unkontrollierbar sein kann und die Möglichkeit besteht, dass der Feind sie hackt, ersetzt und manipuliert.In jüngster Zeit sind kostengünstige Sensoren und neue Technologien für künstliche Intelligenz praktischer geworden, die es ermöglichten, sie bei der Entwicklung autonomer Waffensysteme einzusetzen. Der Geist der sogenannten "Killerroboter" hat bereits eine internationale Protest- und Diskussionsbewegung bei den Vereinten Nationen ausgelöst, um die Entwicklung und Implementierung solcher Systeme einzuschränken , berichtet nytimes.com.Der Bericht wurde von Paul Sherry verfasst, der das Future War-Programm im New American Security Center (Washington, Columbia) leitet. Von 2008 bis 2013 arbeitete Sherry im Büro des US-Verteidigungsministers, wo er bei der Entwicklung einer Strategie für den Einsatz autonomer Waffen half. 2012 wurde er einer der Autoren der Richtlinie des Verteidigungsministeriums, die eine Militärpolitik zur Verwendung solcher Systeme festlegte.In einem am Montag veröffentlichten Bericht mit dem Titel „Autonome Waffen und operationelle Risiken“ warnt Sherry vor einer Reihe realer Risiken, die mit vollständig autonomen Waffensystemen verbunden sind. Es stellt vollautomatische Systeme, die ohne menschliches Eingreifen töten können, Waffen gegenüber, die bei der Auswahl und dem Treffen eines Ziels (dh es wird ein Bediener verwendet) „die Menschen auf dem Laufenden halten“.Sherry, der als Ranger in der US-Armee diente und an Operationen im Irak und in Afghanistan teilnahm, konzentriert sich auf mögliche Arten von Fehlern, die in vollautomatisierten Systemen auftreten können. Um die militärischen Auswirkungen hervorzuheben, listet der Bericht die Fehler auf, die in Armee- und Handelssystemen mit einem hohen Automatisierungsgrad aufgetreten sind."Jeder, der jemals die automatisierte telefonische Unterstützung für eine Hotline aufgegeben hat, einen Wecker, der fälschlicherweise auf" Abend "anstatt auf" Morgen "usw. eingestellt wurde, hat das Problem der" Fragilität "erlebt, das in automatisierten Systemen auftritt", schreibt Sherry.Die Grundlage seines Berichts ist, dass autonomen Waffensystemen "Flexibilität" fehlt, d.h. Bei der Ausführung eines solchen Systems können Fehler auftreten, die vermieden werden können.In den Militärarsenalen verschiedener Staaten tauchen völlig autonome Waffen auf. Zum Beispiel hat Südkorea mit Nordkorea einen automatischen Turm entlang der entmilitarisierten Zone installiert, und in Israel ist ein unbemanntes Luftfahrzeug im Einsatz, das so programmiert ist, dass es die Radarsysteme des Feindes angreift, wenn sie entdeckt werden.Das US-Militär verwendet keine autonomen Waffen. In diesem Jahr forderte das Verteidigungsministerium jedoch fast 1 Milliarde US-Dollar für die Waffenproduktion der Langstrecken-Anti-Schiffs-Rakete Lockheed Martin an, die als "halbautonom" bezeichnet wird. Obwohl der Bediener zuerst das Ziel auswählt, aber außerhalb des Kontakts mit der Person, identifiziert und greift er automatisch die feindlichen Truppen an.Der Fokus liegt auf einer Reihe von Überraschungen im Verhalten von Computersystemen wie Abstürzen und Fehlern sowie unvorhergesehenen Interaktionen mit der Umgebung.„Bei ihrem ersten Test über dem Pazifik versagte das Y2K-Computersystem bei acht F-22-Jägern vollständig, als sie die Datumsgrenze überschritten"Der Bericht sagt. „Alle Bordcomputersysteme fielen aus, und das Ergebnis war fast katastrophal - der Verlust eines Flugzeugs. Obwohl die Existenz der Datumsgrenze seit langem bekannt ist, wurde das Ergebnis der Interaktion mit der Software nicht vollständig getestet. “Als Alternative zu einer vollständig autonomen Waffe befürwortet der Bericht das sogenannte "Centaur Warfighting" (kombinierte Waffen? Tatsächlich nicht übersetzbare Wortspiele. Ca.). Der Begriff „Zentaur“ wird verwendet, um Systeme zu beschreiben, in die Menschen und Computer eng integriert sind. Im Schach beispielsweise dominieren Teams, die sowohl Personen- als auch Programme für künstliche Intelligenz verwenden, den Wettbewerb gegen Teams, die nur künstliche Intelligenz verwenden.In einem Telefoninterview gab Sherry jedoch zu, dass es nicht ausreicht, nur den Bediener "auf Knopfdruck" zu drücken. "Es reicht nicht aus, nur eine" benachrichtigte "Person über die Aktionen einer Maschine zu haben", sagte er. „Sie (Personen) können nicht nur Teil des Betriebsalgorithmus des Systems sein. Eine Person muss aktiv an der Entscheidungsfindung teilnehmen. “Source: https://habr.com/ru/post/de391285/

All Articles