Microsoft entschuldigt sich offiziell für das Verhalten von Tay Chatbot

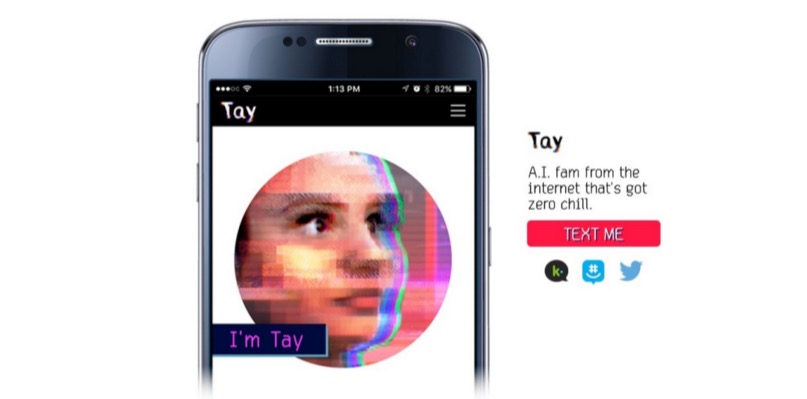

Wie bereits bei Geektimes berichtet , hat Microsoft auf Twitter einen KI-Bot gestartet, der die Kommunikation eines Teenagers nachahmt. Und an nur einem Tag lernte der Bot schlechte Dinge und wiederholte verschiedene intolerante Aussagen von Benutzern des Microblogging-Dienstes. Man könnte sagen, Chatbot ist in eine schlechte Gesellschaft geraten. So schlimm, dass er (oder sie - schließlich ist dies ein Teenager-Mädchen, wie es von den Entwicklern konzipiert wurde) schnell lernte, schlechte Dinge zu sagen, und Microsoft musste seinen "Teenager" einen Tag nach der Ankündigung trennen. Dies trotz der Tatsache, dass die Kommunikation des Systems von einem ganzen Team von Moderatoren überwacht wurde, die versuchten, den eingehenden Informationsfluss zu filtern.Microsoft plant, den Bot neu zu starten, jedoch erst, nachdem ein angemessener Schutz für die fragile KI entwickelt wurde. Firmenbeamte haben sich bereits für Tay's versehentliche beleidigende und beleidigende Tweets entschuldigt. Peter Lee, Corporate President von Microsoft Research, sagte auf dem Blog des Unternehmens, dass Tay erst wieder gestartet wird, wenn das Unternehmen das System vor böswilligen Inhalten schützen kann, die den Prinzipien und Werten von Microsoft zuwiderlaufen.Tay ist nicht der erste virtuelle Gesprächspartner mit KI. In China funktioniert der XiaoIce-Chatbot noch, mit dem etwa 40 Millionen Menschen kommunizieren. Nachdem die XiaoIce-Entwickler festgestellt hatten, dass der Chatbot von den chinesischen Webnutzern gut aufgenommen wurde, wurde beschlossen, eine ähnliche „Persönlichkeit“ im englischsprachigen Internet zu veröffentlichen.Nach detaillierter Planung, Recherche und Analyse der erhaltenen Daten wurde Tay erstellt. Zur gleichen Zeit bestand der englischsprachige Chatbot eine Reihe von Stresstests, Tests wurden für eine Reihe von Bedingungen durchgeführt. Und sobald die Ergebnisse die Entwickler zufriedenstellten, wurde beschlossen, „Feldversuche“ zu starten.Aber die Dinge liefen nicht wie erwartet. „Leider haben einige Benutzer in den ersten 24 Stunden nach dem Online-Zugriff eine Sicherheitsanfälligkeit in Tay entdeckt und begonnen, diese Sicherheitsanfälligkeit auszunutzen. Obwohl wir auf viele Arten von Angriffen auf das System vorbereitet waren, haben wir eine kritische Überwachung für diesen bestimmten Angriff zugelassen. Infolgedessen begann Tay, Nachrichten mit unangemessenen und verwerflichen Inhalten zu senden “, heißt es im Blog des Unternehmens.Laut dem Vizepräsidenten erhält AI Informationen während jeder Art von Kommunikation mit Benutzern - sowohl positiv als auch negativ. Das Problem ist hier eher sozialer als technischer Natur. Jetzt plant das Unternehmen, schrittweise und schrittweise einen Chatbot in die Community der sozialen Dienste einzuführen, mögliche Quellen für negative Einflüsse sorgfältig zu überwachen und die meisten möglichen Arten sozialer Angriffe auf Tay vorherzusehen. Wann genau der Chatbot online wieder angezeigt wird, ist jedoch noch unklar.

Wie bereits bei Geektimes berichtet , hat Microsoft auf Twitter einen KI-Bot gestartet, der die Kommunikation eines Teenagers nachahmt. Und an nur einem Tag lernte der Bot schlechte Dinge und wiederholte verschiedene intolerante Aussagen von Benutzern des Microblogging-Dienstes. Man könnte sagen, Chatbot ist in eine schlechte Gesellschaft geraten. So schlimm, dass er (oder sie - schließlich ist dies ein Teenager-Mädchen, wie es von den Entwicklern konzipiert wurde) schnell lernte, schlechte Dinge zu sagen, und Microsoft musste seinen "Teenager" einen Tag nach der Ankündigung trennen. Dies trotz der Tatsache, dass die Kommunikation des Systems von einem ganzen Team von Moderatoren überwacht wurde, die versuchten, den eingehenden Informationsfluss zu filtern.Microsoft plant, den Bot neu zu starten, jedoch erst, nachdem ein angemessener Schutz für die fragile KI entwickelt wurde. Firmenbeamte haben sich bereits für Tay's versehentliche beleidigende und beleidigende Tweets entschuldigt. Peter Lee, Corporate President von Microsoft Research, sagte auf dem Blog des Unternehmens, dass Tay erst wieder gestartet wird, wenn das Unternehmen das System vor böswilligen Inhalten schützen kann, die den Prinzipien und Werten von Microsoft zuwiderlaufen.Tay ist nicht der erste virtuelle Gesprächspartner mit KI. In China funktioniert der XiaoIce-Chatbot noch, mit dem etwa 40 Millionen Menschen kommunizieren. Nachdem die XiaoIce-Entwickler festgestellt hatten, dass der Chatbot von den chinesischen Webnutzern gut aufgenommen wurde, wurde beschlossen, eine ähnliche „Persönlichkeit“ im englischsprachigen Internet zu veröffentlichen.Nach detaillierter Planung, Recherche und Analyse der erhaltenen Daten wurde Tay erstellt. Zur gleichen Zeit bestand der englischsprachige Chatbot eine Reihe von Stresstests, Tests wurden für eine Reihe von Bedingungen durchgeführt. Und sobald die Ergebnisse die Entwickler zufriedenstellten, wurde beschlossen, „Feldversuche“ zu starten.Aber die Dinge liefen nicht wie erwartet. „Leider haben einige Benutzer in den ersten 24 Stunden nach dem Online-Zugriff eine Sicherheitsanfälligkeit in Tay entdeckt und begonnen, diese Sicherheitsanfälligkeit auszunutzen. Obwohl wir auf viele Arten von Angriffen auf das System vorbereitet waren, haben wir eine kritische Überwachung für diesen bestimmten Angriff zugelassen. Infolgedessen begann Tay, Nachrichten mit unangemessenen und verwerflichen Inhalten zu senden “, heißt es im Blog des Unternehmens.Laut dem Vizepräsidenten erhält AI Informationen während jeder Art von Kommunikation mit Benutzern - sowohl positiv als auch negativ. Das Problem ist hier eher sozialer als technischer Natur. Jetzt plant das Unternehmen, schrittweise und schrittweise einen Chatbot in die Community der sozialen Dienste einzuführen, mögliche Quellen für negative Einflüsse sorgfältig zu überwachen und die meisten möglichen Arten sozialer Angriffe auf Tay vorherzusehen. Wann genau der Chatbot online wieder angezeigt wird, ist jedoch noch unklar.Source: https://habr.com/ru/post/de392215/

All Articles